Webpagina's staan vol met relevante gegevens, maar gegevens extraheren van meerdere webpagina's per dag voor meerdere doeleinden, zoals concurrentieanalyse, onderzoek of meer, kan hectisch zijn.

Webscraping-tools vereenvoudigen het extraheren van gegevens van websites.

In vergelijking met het handmatig schrapen van webpagina's, helpen webscraping-tools veel tijd en moeite te besparen, die kunnen worden gebruikt om andere belangrijke taken van de organisatie uit te voeren. Tijdens het extraheren van de gegevens van websites bestaat natuurlijk het risico dat IP wordt verbannen of dat de gegevens in een compatibel formaat worden geëxtraheerd. Daarom wordt het selecteren van een geweldige tool voor webschrapen belangrijk.

Deze blog toont de top 10 webscraping-tools voor het eenvoudig en efficiënt schrapen van gegevens van webpagina's.

Extraheer tekst van elke webpagina met slechts één klik. Ga naar Nanonets website scraper, voeg de URL toe en klik op "Scrape" en download de webpagina-tekst direct als een bestand. Probeer het nu gratis.

Wat is webscraping?

Webscraping is een methode om gegevens van een website te verzamelen of te extraheren. Webscraper extraheert de HTML-structuur, tabellen, afbeeldingen en tekst van de website en slaat deze op in het gewenste formaat.

Web Scraping kan voor meerdere use-cases worden gebruikt, zoals competitieve informatie, het maken van een database, het onderhouden van realtime updates en meer. Webscraping-tools helpen bedrijven en individuen het hele webscrapingproces te automatiseren terwijl ze geavanceerde functies gebruiken zoals IP-proxyrotatie, geautomatiseerde gegevensverbetering en integraties.

Schraap elke webpagina binnen enkele seconden met behulp van de Nanonets-tool voor het schrapen van websites. Het is gratis. Probeer nu.

Hieronder zijn de beste webschraperhulpmiddelen:

#1. Slimme proxy

Smartproxy is een van de beste webschrapertools die direct en moeiteloos gegevens en inhoud van websites extraheren. Het levert de gegevens in de vorm van onbewerkte HTML van websites. Het volbrengt deze taak door een API-verzoek te verzenden. Niet alleen dit, maar deze tool blijft ook verzoeken verzenden, zodat de door het bedrijf vereiste gegevens of inhoud met de grootst mogelijke nauwkeurigheid kunnen worden geëxtraheerd.

Belangrijkste kenmerken van Smartproxy:

- Biedt realtime gegevensverzameling

- Biedt real-time proxy-achtige integratie

- Gegevens geëxtraheerd in onbewerkte HTML

Voordelen van Smartproxy:

- Wereldwijde proxy's maken deze tool mogelijk.

- Biedt live klantenondersteuning aan de gebruikers

- Geen CAPTCHA's omdat het wordt geleverd met geavanceerde proxyrotatie

Nadelen van Smartproxy:

- Soms is e-mailondersteuning traag

- Het staat niet toe dat webelementen worden weergegeven

- Duur abonnement

- Zou meer automatische extractors moeten bevatten

- Verzoeken kunnen een time-out krijgen

#2. Nanonets webscraping-tool

Nanonets heeft een krachtige OCR API die webpagina's met 100% nauwkeurigheid kan schrapen. Het kan afbeeldingen, tabellen, tekst en tekens met de hoogste nauwkeurigheid detecteren. Wat Nanonets onderscheidt van andere tools, is de mogelijkheid om webscraping te automatiseren met behulp van geautomatiseerde workflows.

Gebruikers kunnen workflows instellen om webpagina's automatisch te schrapen, de geëxtraheerde gegevens op te maken en de geschraapte gegevens vervolgens met één klik op de knop te exporteren naar meer dan 500 integraties.

Belangrijkste kenmerken van nanonetten:

- Biedt realtime gegevensextractie van elk type webpagina

- Extraheert HTML-tabellen met hoge nauwkeurigheid

- Formatteer gegevens automatisch

Voordelen van Nanonetten:

- 24 × 7 live ondersteuning

- Kan gegevens extraheren van alle soorten webpagina's - Java, Headless of Static Pages

- Gebruikersinterface zonder code

- Workflow automatisering is mogelijk

Nadelen van Nanonetten:

- Kan geen afbeeldingen en video's schrapen

#3. Schraper-API

Scraper API maakt eenvoudige integratie mogelijk; je hoeft alleen maar een verzoek en een URL te krijgen. Bovendien kunnen gebruikers meer geavanceerde use cases vinden in de documentatie. Het biedt ook geo-gelokaliseerde roterende proxy's, die helpen bij het routeren van het verzoek via de proxy's.

Kenmerken van Scraper-API:

- Maakt eenvoudige integratie mogelijk

- Hiermee kunnen gebruikers ook JavaScript-gerenderde pagina's schrapen

Voordelen van Scraper API:

- Makkelijk te gebruiken

- Volledig aanpasbaar

- Het is snel en betrouwbaar

Nadelen van Scraper API:

- Er zijn enkele websites waar deze tool niet werkt

- Het is een beetje duur

- Sommige functies, zoals javascript-scraping, zijn erg duur

- Zou de mogelijkheid moeten vergroten om de oproepen van het plan te schalen

- Tijdens het aanroepen van de API zijn de headers van het antwoord er niet

#4. Webschraper

Web Scraper is een webscraping die een cloudgebaseerd platform biedt voor toegang tot de geëxtraheerde gegevens. Het heeft een gebruiksvriendelijke interface, dus het kan ook door beginners worden gebruikt. Het maakt het ook mogelijk om gegevens of inhoud te extraheren, zelfs van dynamische websites.

Kenmerken van Webschraper:

- Het maakt gegevensextractie mogelijk van websites met categorieën en subcategorieën

- Wijzigt gegevensextractie wanneer de structuur van de site verandert

Voordelen van Web Scraper:

- Het is een cloudgebaseerde webschraper

- Geëxtraheerde gegevens zijn toegankelijk via de API

Nadelen van Web Scraper:

- Moet extra credits opleveren in het proefplan

- Hoge prijzen voor kleine gebruikers

- Verschillende interne serverfouten

- De reactie van de website is soms erg traag

- Het zou meer videodocumentatie moeten bevatten.

#5. Grepsr

Met Grepsr kunnen gebruikers de gegevens vastleggen, wijzigen en in de pc plaatsen. Het kan door gebruikers persoonlijk, marketeers en investeerders professioneel worden gebruikt.

Voordelen van Grepsr:

- Het ondersteunt meerdere uitvoerformaten.

- Biedt de service van onbeperkte bandbreedte

Nadelen van Grepsr:

- Soms kan het onhandig zijn om gegevens te extraheren

- Als u zich in een andere tijdzone bevindt, kan dit tot latentie leiden

- Er zijn fouten tijdens het extraheren van de gegevens

- Soms krijgt het verzoek een time-out

- Soms moeten gegevens opnieuw worden verwerkt vanwege inconsistentie.

#5. ParseHub

ParseHub is een beroemde tool voor webschrapen met een gebruiksvriendelijke interface. Het biedt een gemakkelijke manier om gegevens van websites te extraheren. Bovendien kan het de gegevens van meerdere pagina's extraheren en communiceren met AJAX, dropdown, enz.

Kenmerken van ParseHub:

- Maakt gegevensaggregatie van meerdere websites mogelijk

- REST API voor het bouwen van mobiele en webapps

Voordelen van ParseHub:

- Het heeft een gebruiksvriendelijke interface

- Beginners kunnen het ook gebruiken

Nadelen van ParseHub:

- Het is een desktop-app

- Gebruikers worden geconfronteerd met problemen met bugs

- Kostbare tool voor webschrapen

- De limiet van het aantal te extraheren pagina's in de gratis versie is erg laag

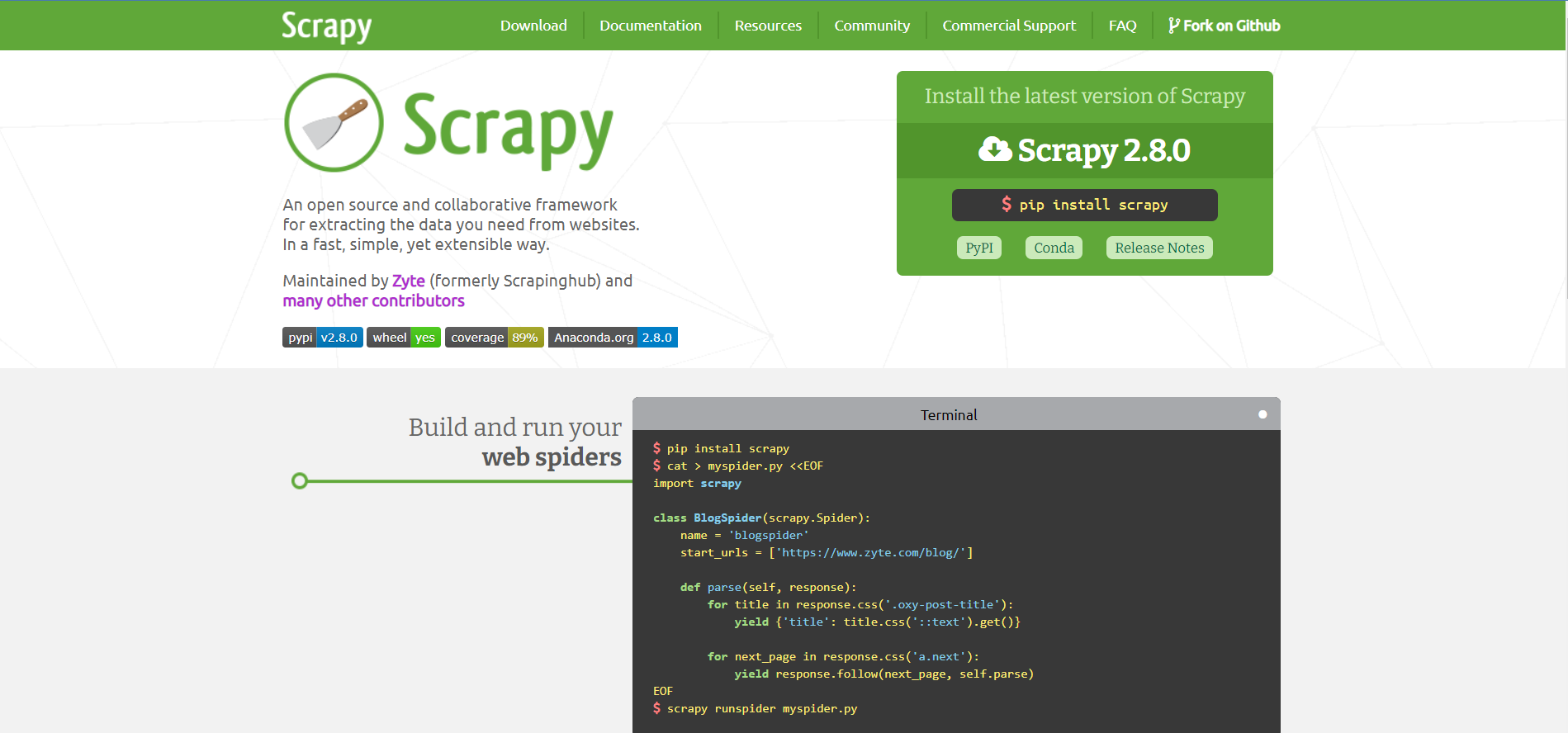

#7. Schraperig

Scrapy is een andere tool voor webschrapen die fungeert als een open-sourceplatform en waarmee gebruikers gegevens van verschillende websites kunnen extraheren. Deze webscraping-tool is geschreven in Python en werkt als een samenwerkingskader. Bovendien ondersteunt de tool Mac, Windows, Linux en BSD.

Kenmerken van Scrapy:

- Deze tool is gemakkelijk uitbreidbaar en draagbaar.

- Helpt bij het maken van eigen webspiders.

- Deze webspiders kunnen worden ingezet in de Scrapy-cloud of servers.

Voordelen van Scrapy:

- Dit hulpmiddel is zeer betrouwbaar

- Het biedt snelle schaalbaarheid

- Biedt uitstekende ondersteuning aan de gebruikers

Nadelen van Scrapy:

- Duur

- Uitdagend om te gebruiken door een niet-professional

- Moeilijk om een eenvoudige en duidelijke gebruikersinterface voor beginners te creëren

- Gebrek aan monitoring en alarmering,

- Het heeft een onhandig logsysteem

#8. Mozenda

Mozenda is een andere webscraping-tool die gegevensverzamelings- en wrangling-services biedt. Deze services zijn toegankelijk voor gebruikers in de cloud en on-premises. Bovendien stelt het gebruikers ook in staat om gegevens voor te bereiden voor veel operaties, zoals marketing en financiën.

Kenmerken van Mozenda:

- Deze tool helpt om gelijktijdige verwerking te bereiken

- Gegevensverzameling kan worden beheerd via API

- Hiermee kunnen gegevens worden geschrapt voor websites van verschillende geografische locaties.

- Biedt de mogelijkheid van e-mailmeldingen.

Voordelen van Mozenda:

- Het bood zowel cloudgebaseerde als on-premises oplossingen voor gegevensextractie

- Hiermee kunnen gebruikers bestanden en afbeeldingen downloaden

- Biedt uitstekende API-functies

Nadelen van Mozenda:

- Het heeft gecompliceerde schraapvereisten die moeilijk te bereiken zijn

- Het kan moeilijk zijn om relevante documentatie te vinden

- Moeilijk te begrijpen en programmeertermen te gebruiken

- Biedt onvoldoende testfunctionaliteit.

- Gebruikers kunnen RAM-problemen ondervinden bij het omgaan met grote websites.

#9. Dexi

Dexi is een populaire tool voor webschrapen die gebruikers nauwkeurige gegevensextractie biedt. Behalve bij het extraheren van gegevens, helpt deze webscraping-tool ook bij monitoring, interactie en gegevensverwerking. Bovendien biedt het data-inzicht in de inhoud, waardoor de organisatie betere bedrijfsbeslissingen kan nemen en haar functioneren kan verbeteren.

Kenmerken van Dexi:

- Het maakt gegevensextractie van elke site mogelijk

- Deze tool heeft functies voor het aggregeren, transformeren, manipuleren en combineren van gegevens.

- Het heeft tools om te debuggen.

Voordelen van Dexi:

- Deze tool is eenvoudig schaalbaar

- Het ondersteunt veel services van derden.

Nadelen van Dexi:

- Deze tool is erg ingewikkeld om te begrijpen

- Het mist een aantal geavanceerde functies

- Documentatie kan worden verbeterd

- API-eindpunten zijn niet beschikbaar

- Niet-intuïtieve UI UX

#10. Gemeenschappelijke kruip

Common Crawl is een webscraping-tool die is ontwikkeld voor iedereen die gegevens wil analyseren en op zoek wil gaan naar zinvolle inzichten. Het stelt ook iedereen in staat om deze webscraping-tool gratis te gebruiken, aangezien het een geregistreerd non-profitplatform is dat werkt met donaties om de functies soepel te laten werken.

Belangrijkste kenmerken van Common Crawl:

- Ondersteuning voor niet op code gebaseerde use cases

- Het biedt bronnen voor docenten om gegevens te onderwijzen en te analyseren

- Open datasets van onbewerkte webpaginagegevens

Voordelen van gemeenschappelijke crawl:

- Goed voor beginners

- Het heeft een gebruiksvriendelijk dashboard

- Documentatie is eenvoudig beschikbaar

- Biedt gegevensnauwkeurigheid

Nadelen van Common Crawl:

- Ondersteuning voor live data is niet beschikbaar

- Ondersteuning voor op AJAX gebaseerde sites is ook niet beschikbaar

- De gegevens die beschikbaar zijn in deze tool zijn niet gestructureerd

- Gegevens kunnen niet worden gefilterd.

Hier is een vergelijkingstabel om de hierboven genoemde webscraping-tools te vergelijken:

Conclusie

Ik heb hier de belangrijkste tools voor webschrapen vermeld om webschrapen eenvoudig te automatiseren. Webscraping is een juridisch grijs gebied en u moet de juridische implicaties ervan overwegen voordat u een webscraping-tool gebruikt.

De hierboven genoemde webscraping-tools kunnen het schrapen van gegevens van webpagina's eenvoudig vereenvoudigen. Als u webscraping voor grotere projecten moet automatiseren, kunt u contact opnemen met Nanonets.

We hebben ook een gratis tool voor het schrapen van websites om webpagina's direct te schrapen.

Veelgestelde vragen

Hoe werken webschrapers?

De functie van webschrapers is om snel en nauwkeurig gegevens van websites te extraheren. Het proces van gegevensextractie is als volgt:

Een HTTP-verzoek doen aan een server

De eerste stap in het webscrapingproces is het doen van een HTTP-verzoek wanneer een persoon een website bezoekt. Dit betekent vragen om toegang tot een bepaalde site die de gegevens bevat. Om toegang te krijgen tot een site, heeft webschraper toestemming nodig. Daarom is het eerste wat u moet doen een HTTP-verzoek sturen naar de site van waaruit de inhoud nodig is.

De code van de website extraheren en parseren

Nadat ze toestemming hebben gekregen om toegang te krijgen tot de website, is het werk van webschrapers het lezen en extraheren van de HTML-code van die website. Hierna splitsen de webscrapingtools de inhoud op in kleine delen, ook wel parsing genoemd. Het helpt bij het identificeren en extraheren van elementen zoals tekst-ID's, tags, enz.

Het lokaal opslaan van de relevante gegevens

Na toegang tot de HTML-code en het extraheren en ontleden ervan, is de volgende stap het opslaan van de gegevens in een lokaal bestand. De gegevens worden gestructureerd opgeslagen in een Excel-bestand.

Verschillende soorten webschrapers

Web Scrapers kunnen worden onderverdeeld op basis van verschillende criteria, zoals:

Zelfgebouwde of vooraf gebouwde webschrapers

Om een zelfgebouwde webschraper te programmeren, heb je geavanceerde kennis van programmeren nodig. Dus om een geavanceerdere webschrapertool te bouwen, hebt u meer geavanceerde kennis nodig om te functioneren volgens de vereisten van het bedrijf.

Terwijl vooraf gebouwde webschrapers worden ontwikkeld en onderweg kunnen worden gedownload en gebruikt, bevat het ook geavanceerde functies die kunnen worden aangepast aan de behoeften.

Browserextensie of Software Web Scrapers

Browserextensies webschrapers zijn eenvoudig te gebruiken omdat ze aan uw webbrowser kunnen worden toegevoegd. Omdat deze webschrapers echter kunnen worden geïntegreerd met de webbrowser, zijn ze beperkt omdat functies die niet in de webbrowser staan, niet op deze webschraper kunnen worden gebruikt.

Aan de andere kant zijn software-webschrapers niet beperkt tot alleen webbrowsers. Dat betekent dat ze op uw pc kunnen worden gedownload. Bovendien hebben deze webschrapers meer geavanceerde functies; dat wil zeggen dat elke functie buiten uw webbrowser toegankelijk is.

Cloud- of lokale webschrapers

Cloud Web Scrapers werken in de cloud. Het is in feite een off-site server die het webschraperbedrijf zelf levert. Het helpt de pc om zijn bronnen niet te gebruiken om gegevens te extraheren en zo andere functies van de pc uit te voeren.

Hoewel lokale webschrapers op uw pc werken en de lokale bronnen gebruiken om gegevens te extraheren, hebben de webschrapers in dit geval meer RAM nodig, waardoor uw pc traag wordt.

Waar wordt webscraping voor gebruikt?

Web Scraping kan in tal van organisaties worden gebruikt. Enkele van de toepassingen van webscraping-tools zijn als volgt:

Prijsbewaking

Veel organisaties en bedrijven gebruiken webschraptechnieken om de gegevens en prijs met betrekking tot bepaalde producten te extraheren en deze vervolgens te vergelijken met andere producten om prijsstrategieën te maken. Dit helpt het bedrijf de productprijs vast te stellen om de verkoop te verhogen en de winst te maximaliseren.

Nieuwsbewaking

Webschrapende nieuwssites helpen bij het extraheren van de gegevens en inhoud over de nieuwste trends van de organisatie. De gegevens en rapporten van de bedrijven die recent in trend zijn, zijn beschikbaar en dit helpt de organisatie bij het plannen van haar marketingmethoden.

Sentiment analyse

Om de kwaliteit van de producten te verbeteren, is het nodig om de meningen en feedback van de klanten te begrijpen. Hierdoor wordt sentimentanalyse gedaan. Webscraping wordt gebruikt om deze analyse te maken door gegevens van verschillende sociale mediasites over bepaalde producten te verzamelen. Dit helpt het bedrijf om wijzigingen in hun producten aan te brengen volgens de wensen van de klanten.

Marktonderzoek

Marktonderzoek is een ander gebruik van tools voor webschrapen. Het omvat het verzamelen van geëxtraheerde gegevens in enorme hoeveelheden om klanttrends te analyseren. Dit helpt hen dergelijke producten te maken om de populariteit van de klanten te vergroten.

E-mailmarketing

Webscraping-tools worden ook gebruikt voor e-mailmarketing. Dit proces omvat het verzamelen van de e-mail-ID's van de mensen van websites. Vervolgens sturen de bedrijven de promotionele advertenties naar deze e-mail-ID's. Dit is de afgelopen jaren een uitstekende markeertechniek gebleken.

- Door SEO aangedreven content en PR-distributie. Word vandaag nog versterkt.

- Platoblockchain. Web3 Metaverse Intelligentie. Kennis versterkt. Toegang hier.

- Bron: https://nanonets.com/blog/top-web-scraping-tools/