Naarmate het wijdverbreide gebruik van MLLM-modellen toeneemt, wordt een van de obstakels op het pad van AI steeds duidelijker: AI-hallucinatie en Woodpecker is de De oplossing die onderzoekers van de University of Science and Technology of China (USTC) en Tencent YouTu Lab bedachten.

Multimodale grote taalmodellen (MLLM's) zijn een type AI-model dat gegevens uit meerdere modaliteiten, zoals tekst, afbeeldingen en video's, kan leren en verwerken. Hierdoor kunnen ze een breed scala aan taken uitvoeren die niet mogelijk zijn voor traditionele taalmodellen, zoals ondertiteling van afbeeldingen, samenvatting van video's en het beantwoorden van vragen met multimodale input.

Dankzij hun vermogen om een groot aantal uitgangen tot onze beschikking te stellen, worden MLLM-modellen in bijna elk ‘slim’ apparaat gebruikt. Nu gebruiken veel technologische wonderen, van slimme auto's tot IoT-apparaten zoals Alexa, MLLM-modellen. Dit betekent echter niet dat deze modellen vervelende en repetitieve fouten kunnen voorkomen.

AI-hallucinatie is, net als een piepende deur, een probleem van MLLM-modellen dat we negeren maar waar we ons ook aan ergeren. Denk er eens over na, hoe vaak heeft een chatbot geliked ChatGPT er niet in slaagt een juist antwoord te geven op uw vraag, of halverwege de reis kon niet het perfecte beeld voor u genereren? Waarom is snelle techniek een gerenommeerde baan op dit moment? Waarom zijn AI-technologieën zijn niet klaar voor toepassingen in de echte wereld? Het houdt allemaal verband met de onvolkomenheden in MLLM-technologieën, maar Woodpecker is de perfecte potentiële remedie voor een slecht functionerende AI.

Specht geneest AI-modellen als een boom

Er is steeds meer aandacht voor het fenomeen hallucinaties bij MLLM's, en eerder onderzoek heeft evaluatie-/detectie- en mitigatiestrategieën onderzocht. Het werk van Woodpecker heeft echter tot doel de reacties van MLLM's te verfijnen door de gehallucineerde delen aan te passen, met behulp van een trainingsvrij raamwerk. Bovendien is het gebruik van kennis in MLLM's om feitelijke hallucinaties te verlichten onderzocht, maar het overbrengen van dit idee naar het veld van visie-taal is een uitdaging.

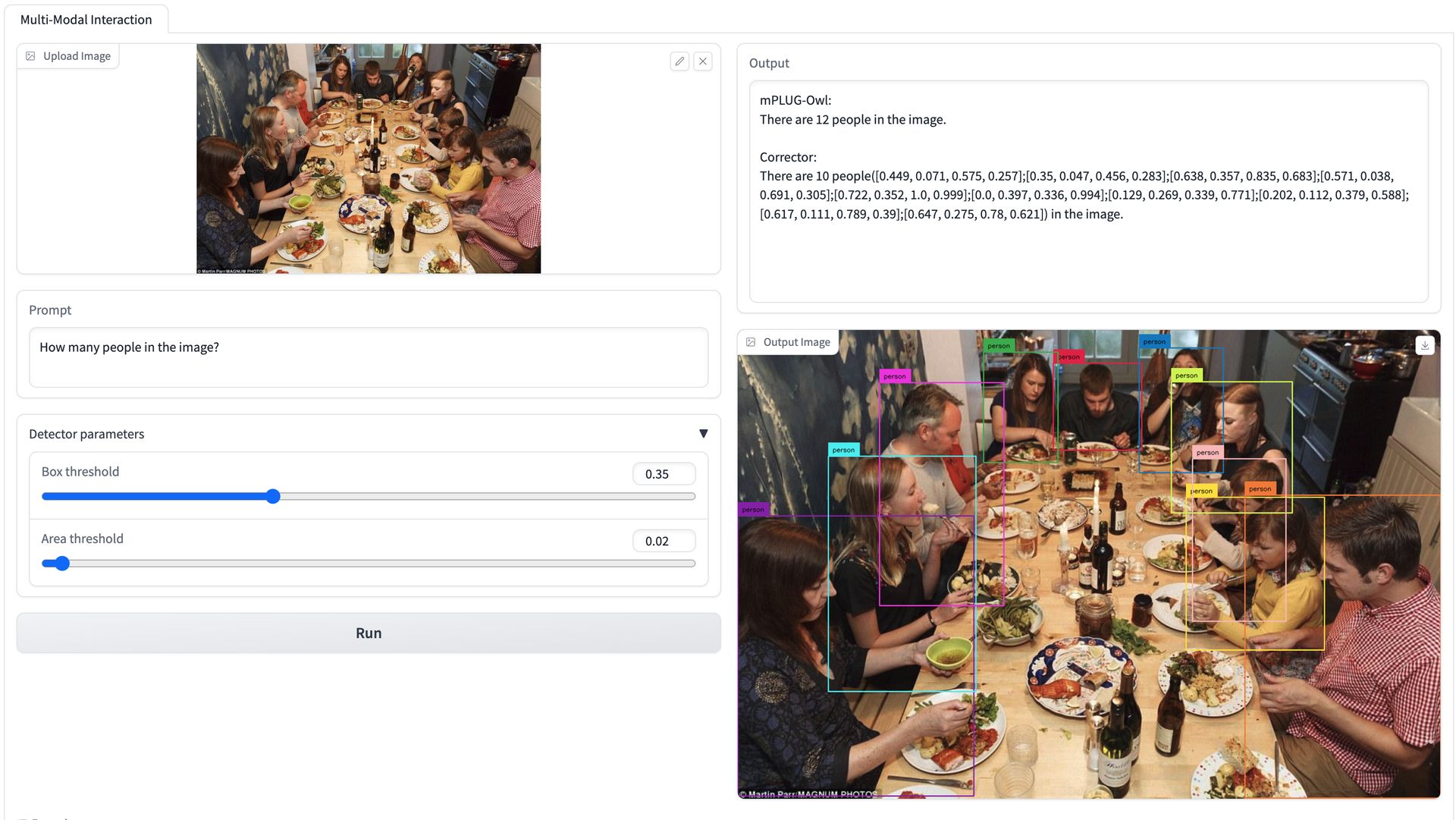

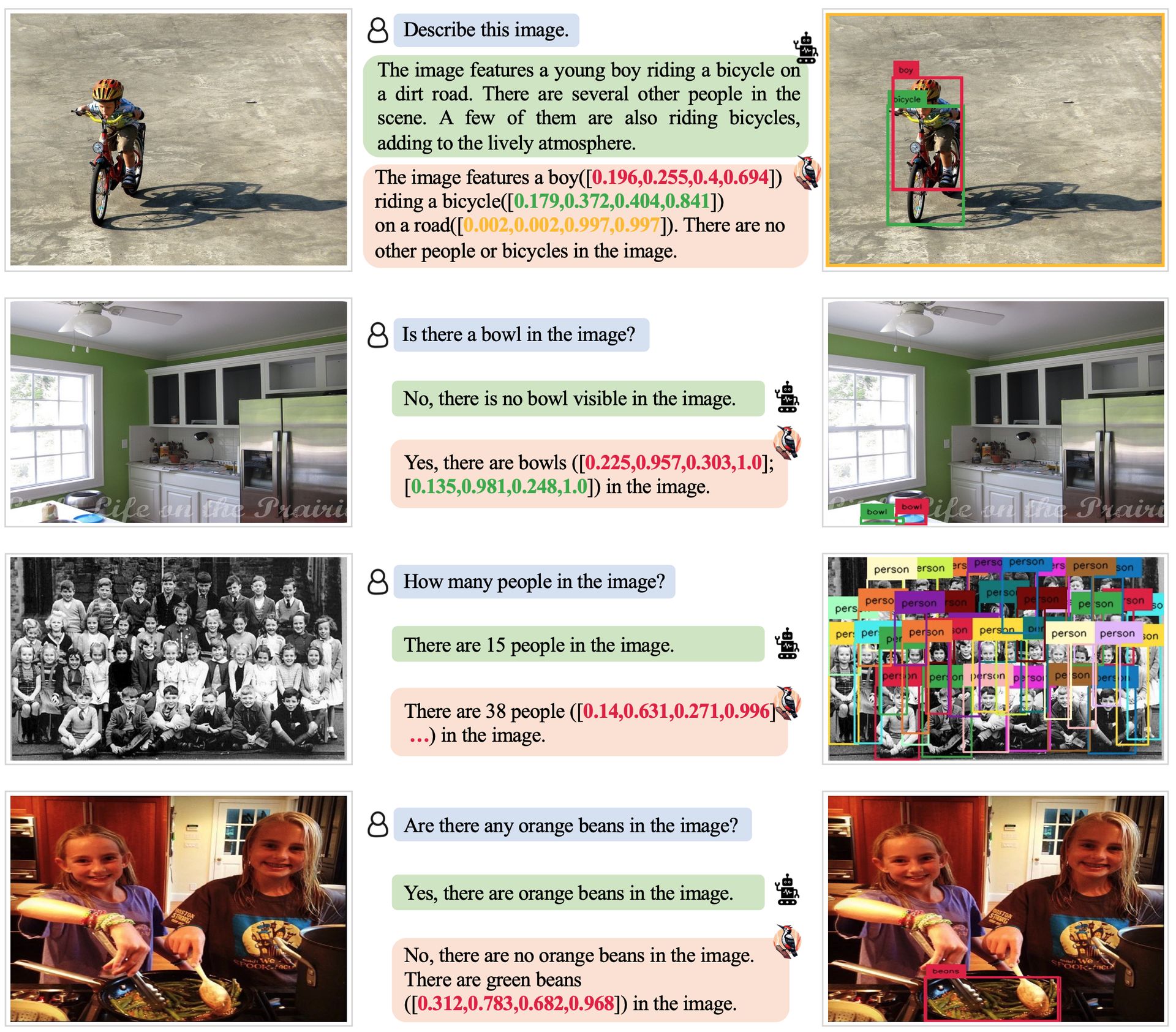

Het voorgestelde raamwerk van Woodpecker maakt gebruik van LLM's om te helpen bij visueel redeneren en om visuele hallucinaties in MLLM-reacties te corrigeren. Het raamwerk bestaat uit vijf subtaken: sleutelconceptextractie, vraagformulering, visuele kennisvalidatie, visuele claimgeneratie en hallucinatiecorrectie.

Woodpecker werkt door deze vijf stappen te volgen:

- Extractie van sleutelconcepten: Woodpecker haalt sleutelconcepten uit de reactie van de MLLM. Deze concepten worden gebruikt om hallucinaties te diagnosticeren en vragen te genereren om deze aan te pakken

- Vraagformulering: Specht formuleert vragen om hallucinaties op object- en attribuutniveau aan te pakken. Deze vragen zijn ontworpen om te worden beantwoord met behulp van objectdetectie en een VQA-model

- Visuele kennisvalidatie: Woodpecker gebruikt objectdetectie en een VQA-model om de vragen geformuleerd in stap 2 te beantwoorden. Dit helpt de visuele kennis te valideren en potentiële hallucinaties te identificeren

- Visuele claimgeneratie: Specht genereert visuele claims door de vragen en antwoorden uit stap 3 te combineren. Deze visuele claims worden gebruikt om hallucinaties in de reactie van de MLLM te corrigeren

- Hallucinatie correctie: Woodpecker gebruikt een LLM om hallucinaties in de reactie van de MLLM te corrigeren op basis van de visuele claims. Dit omvat het aanpassen van de gehallucineerde delen van de reactie om ze consistent te maken met de visuele kennis

Het uiteindelijke doel van dit alles is het opbouwen van een gestructureerde visuele kennisbasis die specifiek is voor het beeld en de reactie om hallucinaties te corrigeren. Om een voorbeeld te geven van hoe Woodpecker werkt:

MLLM-reactie: Er is een rode auto in de afbeelding.

Specht:

- Woodpecker haalt de sleutelbegrippen ‘auto’ en ‘rood’ uit het antwoord

- Specht formuleert de volgende vraag: “Staat er een rode auto in beeld”

- Woodpecker gebruikt objectdetectie om alle auto's in het beeld te identificeren. Vervolgens gebruikt het een VQA-model om aan elke auto te vragen of deze rood is. Als geen enkele auto in beeld rood is, concludeert Woodpecker dat de MLLM-reactie een hallucinatie bevat

- Specht genereert de volgende visuele claim: “Er is geen rode auto in de afbeelding”

- Woodpecker gebruikt een LLM om het MLLM-antwoord te corrigeren door de zinsnede ‘rode auto’ te vervangen door ‘geen rode auto’

Gecorrigeerde MLLM-reactie: Er is geen rode auto in de afbeelding.

De studie evalueert de prestaties van verschillende modellen op de POPE-taak en presenteert de resultaten in verschillende settings, waaronder willekeurig, populair en vijandig. De voorgestelde correctiemethode, Woodpecker, laat een consistente winst zien in de meeste maatstaven voor de basislijnen. In de meer uitdagende omgevingen vertonen de MLLM's prestatieverlies, terwijl Woodpecker stabiel blijft en de nauwkeurigheid van de basislijnen verbetert. De experimenten met MME omvatten evaluatie van hallucinaties op zowel objectniveau als attribuutniveau.

De voorgestelde Woodpecker-correctiemethode verbetert de prestaties van MLLM's bij evaluatie op objectniveau en attribuutniveau. Het blinkt vooral uit in het beantwoorden van moeilijkere vragen en vermindert hallucinaties op attribuutniveau. De introductie van de open-set detector verbetert de bestaans- en telaspecten, terwijl het VQA-model het kleurgedeelte verbetert. Het volledige raamwerk, dat beide modules combineert, behaalt de beste resultaten. De correctiemethode pakt effectief hallucinaties in MLLM-reacties aan, wat resulteert in nauwkeurigere en gedetailleerdere antwoorden.

Het gebrek aan verwant werk bij het meten van correctiegedrag wordt aangepakt door de resultaten na correctie op te splitsen in drie secties: nauwkeurigheid, weglating en verkeerde correctie. De resultaten van het ‘standaard’-model op MME laten een nauwkeurigheid van 79.2% zien, met lage percentages weglatingen en verkeerde correcties. Dit op correcties gebaseerde raamwerk wordt voorgesteld als een trainingsvrije methode om hallucinaties bij MLLM's te verminderen en kan eenvoudig in verschillende modellen worden geïntegreerd. De effectiviteit van het raamwerk wordt geëvalueerd door middel van experimenten op drie benchmarks, en de hoop is dat dit werk nieuwe benaderingen zal inspireren voor het aanpakken van hallucinaties bij MLLM's.

Om de feitelijkheid van de straf te verifiëren, worden de bij de straf betrokken entiteiten gespecificeerd. Er moeten vragen worden gesteld over de basiskenmerken van de entiteiten, zoals kleuren en acties. Complexe redeneringen en semantisch vergelijkbare vragen moeten worden vermeden. Vragen over de positie-informatie van de entiteiten kunnen worden gesteld met behulp van vragen van het type “waar”. Onzekere of vermoedende delen van de zin mogen niet in twijfel worden getrokken. Als er geen vragen zijn, moet “Geen” worden weergegeven.

Waarom al het gedoe?

MLMM's hebben het potentieel om een breed scala aan taken aan te bieden die niet mogelijk zijn voor traditionele taalmodellen, zoals ondertiteling van afbeeldingen, samenvatting van video's en het beantwoorden van vragen met multimodale input.

MLLM's zijn echter niet perfect en kunnen soms onnauwkeurige resultaten opleveren. Enkele van de meest voorkomende onnauwkeurigheden van MLLM's zijn:

- Feitelijke fouten: MLLM's kunnen soms reacties genereren die feitelijke fouten bevatten. Dit kan gebeuren wanneer de MLLM niet op voldoende gegevens is getraind of wanneer de gegevens waarop deze is getraind niet nauwkeurig zijn

- hallucinaties: MLLM's kunnen ook reacties genereren die hallucinaties bevatten. Dit is wanneer de MLLM informatie genereert die niet aanwezig is in de invoergegevens. Hallucinaties kunnen worden veroorzaakt door verschillende factoren, zoals de complexiteit van de taak, de hoeveelheid gegevens waarop de MLLM is getraind en de kwaliteit van de gegevens.

- Vooringenomenheid: MLLM's kunnen ook bevooroordeeld zijn, wat de vooroordelen weerspiegelt die aanwezig zijn in de gegevens waarop ze zijn getraind. Dit kan ertoe leiden dat MLLM’s reacties genereren die oneerlijk of discriminerend zijn

Vooringenomenheid en feitelijke fouten worden meestal veroorzaakt door imperfecte databases, terwijl hallucinaties worden veroorzaakt door fouten in de werkfase van deze modellen. Deze fouten, die van algoritmische oorsprong lijken te zijn, vormen het grootste obstakel bij het integreren van AI-technologieën in het echte leven. Het is een feit dat AI de deur zal openen naar het autonome leven waar we van dromen, maar de veiligheid en nauwkeurigheid van het gebruik ervan zijn nog steeds grote twijfels.

In oktober 2023 was een Tesla Autopilot-chauffeur bijvoorbeeld betrokken bij een dodelijk ongeval in Florida. De bestuurder gebruikte Autopilot om op de snelweg te rijden toen de auto in botsing kwam met een trekker-oplegger die de snelweg overstak. Bij het ongeval kwam de bestuurder van de Tesla om het leven.

De National Highway Traffic Safety Administration (NHTSA) onderzoekt het ongeval om de oorzaak te achterhalen. Er wordt echter aangenomen dat het Tesla Autopilot-systeem er mogelijk niet in is geslaagd de trekker-oplegger te detecteren. Dit falen kan te wijten zijn aan een aantal factoren, zoals de lichtomstandigheden of de positie van de trekker-oplegger, maar om de veiligheid van dergelijke systemen volledig te garanderen moeten we zeker zijn van hun nauwkeurigheid.

Het is onwaarschijnlijk dat we de juiste instructies zullen krijgen van een MLLM-model dat verkeerd interpreteert wat er omheen gebeurt, en we zijn nog niet klaar voor het gebruik van soortgelijke technologieën op gebieden als de medische sector, het transport en de planning. Deze door Woodpecker beloofde oplossing kan een keerpunt zijn voor onze AI en ons autonome leven. Terwijl de technologie zich ontwikkelt, blijft het ons leven beïnvloeden en we proberen dit allemaal zo goed mogelijk te begrijpen. Laten we eens kijken waar de toekomst ons allemaal zal brengen.

Uitgelicht afbeeldingstegoed: Emre Çıtak/DALL-E 3.

- Door SEO aangedreven content en PR-distributie. Word vandaag nog versterkt.

- PlatoData.Network Verticale generatieve AI. Versterk jezelf. Toegang hier.

- PlatoAiStream. Web3-intelligentie. Kennis versterkt. Toegang hier.

- PlatoESG. carbon, CleanTech, Energie, Milieu, Zonne, Afvalbeheer. Toegang hier.

- Plato Gezondheid. Intelligentie op het gebied van biotech en klinische proeven. Toegang hier.

- Bron: https://dataconomy.com/2023/10/27/how-woodpecker-cure-ai-hallucination/