Introductie

ChatGPT is een krachtig taalmodel ontwikkeld door OpenAI dat de wereld stormenderhand heeft veroverd met zijn vermogen om menselijke input te begrijpen en er op conversatie op te reageren. Een van de meest opwindende kenmerken van ChatGPT is de mogelijkheid om codefragmenten te genereren in verschillende programmeertalen, waaronder Python, Java, JavaScript en C++. Deze functie heeft gemaakt ChatGPT een populaire keuze onder ontwikkelaars die snel een prototype willen maken of een probleem willen oplossen zonder de hele codebase zelf te hoeven schrijven. In dit artikel wordt onderzocht hoe ChatGPT's codeinterpreter voor geavanceerde data-analyse voor datawetenschappers werkt. Verder zullen we bekijken hoe het werkt en kan worden gebruikt om machine learning-code te genereren. We zullen ook enkele voordelen en beperkingen van het gebruik van ChatGPT bespreken.

leerdoelen

- Begrijp hoe de geavanceerde gegevensanalyse van ChatGPT werkt en hoe deze kan worden gebruikt om machine learning-code te genereren.

- Leer hoe u de geavanceerde data-analyse van ChatGPT kunt gebruiken om codefragmenten te genereren voor datawetenschappers die Python gebruiken.

- Begrijp de voordelen en beperkingen van ChatGPT's geavanceerde gegevensanalyse voor het genereren van machine learning-code.

- Leer hoe u machine learning-modellen ontwerpt en implementeert met behulp van ChatGPT's geavanceerde gegevensanalyse.

- Begrijp hoe u gegevens voorbewerkt voor machinaal leren, inclusief het omgaan met ontbrekende waarden, 'het coderen van categorische variabelen, het normaliseren van gegevens en het schalen van numerieke kenmerken'. Het coderen van categorische variabelen, het normaliseren van gegevens en het schalen van numerieke kenmerken.

- Leer hoe u gegevens kunt opsplitsen in trainings- en testsets en hoe u de prestaties van machine learning-modellen kunt evalueren met behulp van statistieken zoals nauwkeurigheid, precisie, herinnering, F1-score, gemiddelde kwadratische fout, gemiddelde absolute fout, R-kwadraatwaarde, enz.

Door deze leerdoelen onder de knie te krijgen, moet men begrijpen hoe u de geavanceerde gegevensanalyse van ChatGPT kunt gebruiken om machine learning-code te genereren en verschillende machine learning-algoritmen te implementeren. Ze moeten deze vaardigheden ook kunnen toepassen op problemen en datasets uit de echte wereld, waarmee ze hun vaardigheid aantonen in het gebruik van ChatGPT's geavanceerde data-analyse voor machine learning-taken.

Dit artikel is gepubliceerd als onderdeel van het Data Science-blogathon.

Inhoudsopgave

Hoe werkt de geavanceerde gegevensanalyse van ChatGPT?

De geavanceerde gegevensanalyse van ChatGPT is gebaseerd op a diepgaand leren model dat een transformator wordt genoemd, getraind op een groot corpus tekstgegevens. De transformator maakt gebruik van zelfaandachtsmechanismen om de context en de relatie tussen verschillende delen van de invoertekst te begrijpen. Wanneer een gebruiker een prompt of codefragment invoert, genereert het ChatGPT-model een reactie op basis van de patronen en structuren die het uit de trainingsgegevens heeft geleerd.

De geavanceerde gegevensanalyse in ChatGPT kan codefragmenten genereren door gebruik te maken van de enorme hoeveelheid online code. Het model van ChatGPT kan de syntaxis, semantiek en idiomen van verschillende programmeertalen leren door open-source repository's en andere codebronnen te analyseren. Het model van ChatGPT kan gebruik maken van deze kennis wanneer een gebruiker een stukje code opvraagt om een relevant en werkend codefragment te genereren.

Machine Learning-code genereren met ChatGPT

machine learning is een van de meest veelbelovende toepassingen van ChatGPT's Advanced Data Analysis. Met de opkomst van deep learning en machine learning-toepassingen zijn dit steeds belangrijkere onderzoeks- en ontwikkelingsgebieden geworden. Het ontwerpen en implementeren van deze modellen kan echter complex en tijdrovend zijn, en vereist expertise op het gebied van lineaire algebra, calculus, waarschijnlijkheidstheorie en informatica.

De geavanceerde data-analyse van ChatGPT kan dit proces helpen vereenvoudigen door machine learning-codefragmenten te genereren die gebruikers in hun projecten kunnen integreren. Een gebruiker kan ChatGPT bijvoorbeeld vragen om een codefragment te genereren met behulp van een lineaire regressietechniek voor het voorspellen van huizenprijzen in Californië op basis van een trainingsdataset die als invoer wordt verstrekt in .csv-formaat. Het model van ChatGPT kan een codefragment genereren dat de noodzakelijke import, gegevensvoorverwerkingsstappen, modelarchitectuur en trainingsprocedures omvat op basis van de invoer van de gebruiker.

Upload de dataset naar de codeinterpreter in ChatGPT en voer de onderstaande prompt in.

prompt:

Uitvoeren lineaire regressie gebruik sklearn op de bovenstaande dataset en toon alle stappen met Python-code. De voorspellingsvariabele uit de gegevens is mediaan_huis_waarde.

Reactie:

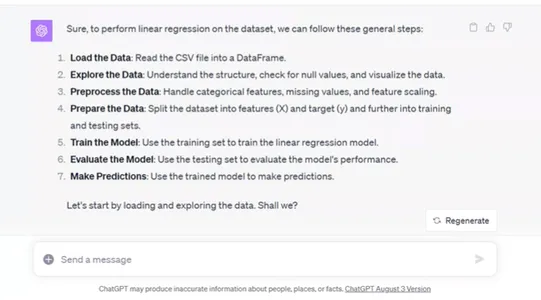

De stappen voor lineaire regressie met behulp van sluw op de dataset “housing.csv”, waarbij “mediaan_house_value” als doelvariabele wordt gebruikt, zijn als volgt:

- Gegevensverkenning: Laad de dataset en onderzoek snel de structuur ervan.

- Gegevens voorverwerking: Behandel ontbrekende waarden, codeer categorische variabelen (indien aanwezig) en schaal numerieke functies.

- De gegevens splitsen: Splits de gegevens op in trainings- en testsets.

- Model opleiding: Train een regressiemodel op de trainingsset.

- evaluatie: Evalueer het getrainde model op de testset.

- Modelinterpretatie: Analyseer het belang van elke functie in de voorspelling.

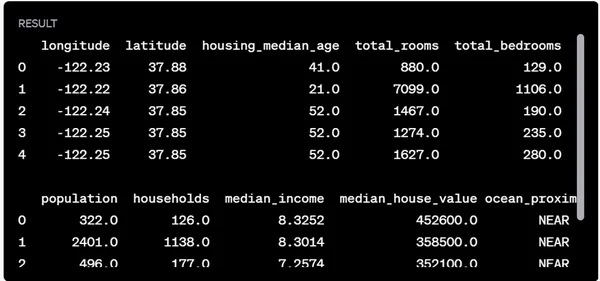

De dataset laden en de structuur verkennen:

# Load the dataset

data = pd.read_csv('/mnt/data/housing.csv')

# Display the first few rows of the dataset to understand its structure

data.head()

#import csv

De dataset bevat de volgende kolommen:

- Lengtegraad: Lengtegraad van de locatie

- breedtegraad: Breedtegraad van de locatie

- huisvestingsmediaanleeftijd: Mediane leeftijd van de woningen in de regio

- totale_kamers: Totaal aantal kamers in de omgeving

- totale_slaapkamers: Totaal aantal slaapkamers in de omgeving

- bevolking: Bevolking van het gebied

- huishoudens: Aantal huishoudens in de omgeving

- Gemiddeld inkomen: Het gemiddelde inkomen van de mensen in het gebied

- mediaan_huis_waarde: Mediane woningwaarde in de omgeving (onze doelvariabele)

- oceaan_nabijheid: Nabijheid van de oceaan (categorische variabele)

Laten we vervolgens verder gaan met de voorverwerking van gegevens:

Gegevens voorverwerking:

- Controleer op ontbrekende waarden en handel deze af.

- Codeer de categorische variabele ocean_proximity.

- Schaal numerieke functies om ze te standaardiseren.

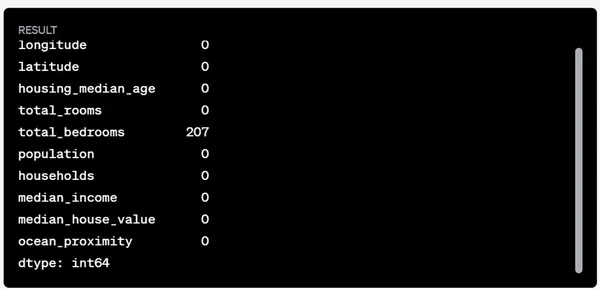

Controleren op ontbrekende waarden in de dataset:

# Check for missing values in each column

missing_values = data.isnull().sum()

missing_values

Het lijkt erop dat de totaal_slaapkamers kolom bevat 207 ontbrekende waarden. Een gebruikelijke strategie om ontbrekende waarden voor numerieke kolommen aan te pakken, is deze te vervangen door de mediaanwaarde van die kolom. Laten we de ontbrekende waarden invullen totaal_slaapkamers met zijn gemiddelde waarde.

Daarna coderen we de oceaan_nabijheid categorische variabele met behulp van one-hot-codering en schaal van de numerieke functies.

Voorverwerkingsstappen:

from sklearn.preprocessing import StandardScaler, OneHotEncoder

from sklearn.compose import ColumnTransformer

from sklearn.pipeline import Pipeline

# Fill missing values in total_bedrooms with its median value

data['total_bedrooms'].fillna(data['total_bedrooms'].median(), inplace=True)

# Define columns for preprocessing

numerical_features = ['longitude', 'latitude', 'housing_median_age', 'total_rooms',

'total_bedrooms', 'population', 'households', 'median_income']

categorical_feature = ['ocean_proximity']

# Create a column transformer for preprocessing

preprocessor = ColumnTransformer(

transformers=[

('num', StandardScaler(), numerical_features),

('cat', OneHotEncoder(), categorical_feature)

])

# Apply the transformations to the data (excluding the target variable)

X = data.drop('median_house_value', axis=1)

y = data['median_house_value']

X_transformed = preprocessor.fit_transform(X)

# Checking the transformed data's shape and first few rows to ensure preprocessing was successful

X_transformed.shape, X_transformed[:5]

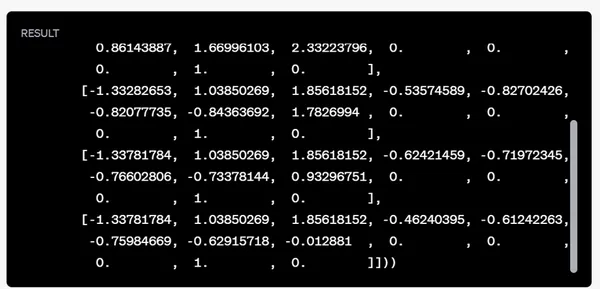

De voorbewerkingsstappen waren succesvol:

- Controleer op ontbrekende waarden en handel deze af.

- Codeer de categorische variabele ocean_proximity.

- Schaal numerieke functies om ze te standaardiseren.

De getransformeerde dataset bevat 20,640 monsters en 13 kenmerken.

De gegevens splitsen:

Vervolgens splitsen we de gegevens op in trainings- en testsets. Hierdoor kunnen we ons model trainen op één subset en

Test de prestaties op een andere onzichtbare subset. Normaal gesproken is een gebruikelijke verdelingsverhouding 80:20 of 70:30 voor training en testen. Voor deze oefening gebruiken we een verdeling van 80:20.

Laten we de gegevens splitsen.

from sklearn.model_selection

import train_test_split

# Splitting the data into training and test sets (80% training, 20% testing)

X_train, X_test, y_train, y_test = train_test_split(X_transformed, y, test_size=0.2,

random_state=42)

X_train.shape, X_test.shape

De gegevens zijn succesvol onderverdeeld in trainings- en testsets:

- Trainingsset: 16,512 monsters

- Testset: 4,128 monsters

Model opleiding:

Vervolgens trainen we een regressiemodel met behulp van de trainingsgegevens. Voor deze demonstratie gebruiken we een simple

lineair regressiemodel. Indien nodig kunnen later complexere modellen of ensemblemethoden worden onderzocht.

Train het lineaire regressiemodel:

from sklearn.linear_model import LinearRegression

from sklearn.metrics import mean_squared_error

# Initialize the Linear Regression model

model = LinearRegression()

# Train the model on the training data

model.fit(X_train, y_train)

# Predict on the training data to check in-sample performance

train_predictions = model.predict(X_train)

train_mse = mean_squared_error(y_train, train_predictions)

train_rmse = train_mse**0.5

train_rmse

De root mean squared error (RMSE) voor de voorspellingen op basis van de trainingsgegevens bedraagt ongeveer $68,433.94.

De RMSE geeft ons een idee van de gemiddelde omvang van de voorspellingsfouten. In deze context liggen de voorspellingen van ons model gemiddeld ongeveer $ 68,433.94 verwijderd van de werkelijke huiswaarden in de trainingsset.

evaluatie:

We voorspellen de testgegevens en berekenen de RMSE voor deze voorspellingen om de generalisatiemogelijkheden van het model te evalueren.

Laten we het model op de testset evalueren.

# Predict on the test data

test_predictions = model.predict(X_test)

# Compute the RMSE for the test predictions

test_mse = mean_squared_error(y_test, test_predictions)

test_rmse = test_mse**0.5

test_rmse

De root mean squared error (RMSE) voor de voorspellingen op basis van de testgegevens bedraagt ongeveer $70,060.52.

De test-RMSE is iets hoger dan de training-RMSE, wat wordt verwacht omdat het model niet op de testgegevens is getraind. De waarden liggen echter relatief dicht bij elkaar, wat erop wijst dat het model de trainingsgegevens niet te veel aanpast.

Modelinterpretatie:

Om het model beter te begrijpen, kunnen we naar de coëfficiënten voor elk kenmerk kijken. Deze coëfficiënten geven het belang en de impact aan van elk kenmerk op de doelvariabele, mediaan_huis_waarde.

Laten we eens kijken naar de kenmerkcoëfficiënten.

# Extract feature names after one-hot encoding

feature_names = numerical_features + list(preprocessor.named_transformers_['cat'].categories_[0])

# Retrieve the coefficients from the model

coefficients = model.coef_

# Create a DataFrame to display the feature coefficients

feature_importance = pd.DataFrame({

'Feature': feature_names,

'Coefficient': coefficients

}).sort_values(by='Coefficient', ascending=False)

feature_importance

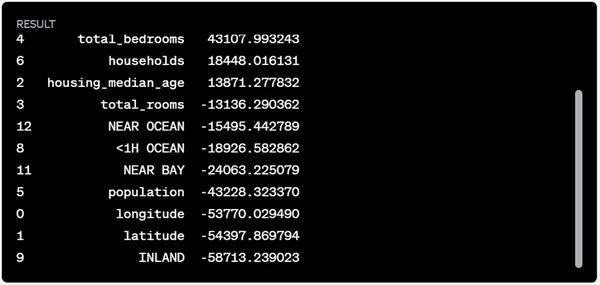

Hier zijn de interpretaties van de kenmerkcoëfficiënten:

- Positieve coëfficiënten geven aan dat naarmate de kenmerkwaarde toeneemt, de voorspelde mediaan_huis_waarde ook toeneemt.

- Negatieve coëfficiënten geven aan dat naarmate de kenmerkwaarde toeneemt, de voorspelde mediaan_huis_waarde afneemt.

Bijvoorbeeld:

- EILAND heeft de hoogste positieve coëfficiënt, wat erop wijst dat huizen op eilanden een hogere voorspelde waarde hebben dan andere locaties.

- mediaan_inkomen heeft ook een significant positief effect op de voorspelde woningwaarde.

- Aan de andere kant heeft INLAND het meest negatieve effect, wat aangeeft dat huizen in het binnenland doorgaans een lagere voorspelde waarde hebben.

- Geografische kenmerken zoals lengte- en breedtegraad spelen ook een rol bij het bepalen van de huiswaarden, waarbij beide in dit model negatieve coëfficiënten hebben.

Hoewel deze coëfficiënten inzicht geven in de relaties tussen kenmerken en de doelvariabele, impliceren ze niet noodzakelijkerwijs een oorzakelijk verband. Externe factoren en interacties tussen kenmerken kunnen ook de huiswaarden beïnvloeden.

Voordelen van het gebruik van ChatGPT voor het genereren van machine learning-codes

Er zijn verschillende voordelen aan het gebruik van ChatGPT's geavanceerde data-analyse voor het genereren van machine learning-code:

- Tijdwinst: Het ontwerpen en implementeren van een machine learning-model kan veel tijd in beslag nemen, vooral voor beginners. De geavanceerde data-analyse van ChatGPT kan gebruikers veel tijd besparen door werkende codefragmenten te genereren die ze als uitgangspunt voor hun projecten kunnen gebruiken.

- Verbeterde productiviteit: Met de geavanceerde data-analyse van ChatGPT kunnen gebruikers zich concentreren op de hoogwaardige concepten van hun machine learning-project, zoals datavoorverwerking, feature-engineering en modelevaluatie, zonder te verzanden in de details van de implementatie van de modelarchitectuur.

- Toegankelijkheid: De geavanceerde data-analyse van ChatGPT maakt machinaal leren toegankelijker voor mensen die misschien geen sterke achtergrond hebben in computerwetenschappen of programmeren. Gebruikers kunnen hun wensen beschrijven en ChatGPT genereert de benodigde code.

- maatwerk: Dankzij de geavanceerde gegevensanalyse van ChatGPT kunnen gebruikers de gegenereerde code aanpassen aan hun behoeften. Gebruikers kunnen de hyperparameters wijzigen, de modelarchitectuur aanpassen of extra functionaliteit aan het codefragment toevoegen.

Beperkingen bij het gebruik van ChatGPT voor het genereren van machine learning-codes

Hoewel de codeinterpreter van ChatGPT een krachtig hulpmiddel is voor het genereren van machine learning-code, zijn er enkele beperkingen waarmee u rekening moet houden:

- Kwaliteit van de gegenereerde code: Hoewel de geavanceerde data-analyse van ChatGPT werkende codefragmenten kan genereren, kan de kwaliteit van de code variëren, afhankelijk van de complexiteit van de taak en de kwaliteit van de trainingsgegevens. Gebruikers moeten mogelijk de code opschonen, bugs oplossen of de prestaties optimaliseren voordat ze deze in productie kunnen gebruiken.

- Gebrek aan domeinkennis: Het model van ChatGPT begrijpt mogelijk niet altijd de nuances van een bepaald domein of toepassingsgebied. Gebruikers moeten mogelijk aanvullende context of begeleiding bieden om ChatGPT te helpen code te genereren die aan hun vereisten voldoet.

- Afhankelijkheid van trainingsgegevens: De geavanceerde data-analyse van ChatGPT is sterk afhankelijk van de kwaliteit en diversiteit van de trainingsgegevens waaraan het is blootgesteld. Als de trainingsgegevens vertekend of onvolledig zijn, kan de gegenereerde code deze tekortkomingen weerspiegelen.

- Ethische overwegingen: Er bestaan ethische zorgen rond het gebruik van door AI gegenereerde code in kritieke toepassingen, zoals de gezondheidszorg of de financiële wereld. Gebruikers moeten de gegenereerde code zorgvuldig evalueren en ervoor zorgen dat deze voldoet aan de vereiste normen en voorschriften.

Conclusie

De geavanceerde data-analyse van ChatGPT is een krachtig hulpmiddel voor het genereren van codefragmenten. Met zijn vermogen om natuurlijke taalprompts te begrijpen en werkende code te genereren, heeft ChatGPT het potentieel om de toegang tot machine learning-technologie te democratiseren en innovatie in het veld te versnellen. Gebruikers moeten zich echter bewust zijn van de beperkingen van de technologie en de gegenereerde code zorgvuldig evalueren voordat ze deze in productie gebruiken. Naarmate de mogelijkheden van ChatGPT zich blijven ontwikkelen, kunnen we nog meer opwindende toepassingen van deze technologie verwachten.

Key Takeaways

- De geavanceerde data-analyse van ChatGPT is gebaseerd op een deep learning-model, een transformer genaamd, dat is getraind op een groot corpus aan tekstgegevens.

- Geavanceerde data-analyse kan codefragmenten genereren in verschillende programmeertalen, waaronder Python, Java, JavaScript en C++, door gebruik te maken van de enorme hoeveelheid online code.

- De geavanceerde data-analyse van ChatGPT kan machine learning-codefragmenten genereren voor lineaire regressie, logistische regressie, beslissingsbomen, willekeurig bos, ondersteunende vectormachines, neurale netwerken en deep learning.

- Om de geavanceerde data-analyse van ChatGPT voor machine learning te gebruiken, kunnen gebruikers een prompt of codefragment opgeven en een specifieke taak aanvragen, zoals het genereren van een codefragment voor een lineair regressiemodel met behulp van een bepaalde dataset.

- Het model van ChatGPT kan codefragmenten genereren die de noodzakelijke import, stappen voor gegevensvoorverwerking, modelarchitectuur en trainingsprocedures omvatten.

- De geavanceerde data-analyse van ChatGPT kan het ontwerpen en implementeren van machine learning-modellen helpen vereenvoudigen, waardoor het voor ontwikkelaars en datawetenschappers gemakkelijker wordt om snel een prototype te maken of een probleem op te lossen.

- Er zijn echter ook beperkingen aan het gebruik van de geavanceerde data-analyse van ChatGPT, zoals de kans dat gegenereerde code fouten bevat of dat er geen aanpassingsmogelijkheden zijn.

- Over het geheel genomen is de geavanceerde data-analyse van ChatGPT een krachtig hulpmiddel dat kan helpen het ontwikkelingsproces voor ontwikkelaars en datawetenschappers te stroomlijnen, vooral bij het genereren van machine learning-codefragmenten.

Veelgestelde Vragen / FAQ

A: Ga naar de ChatGPT-website en begin met het typen van uw codeervragen of aanwijzingen. Het systeem zal dan reageren op basis van het begrip van uw vraag. U kunt ook online tutorials en documentatie raadplegen om u op weg te helpen.

A: De codeinterpreter van ChatGPT ondersteunt verschillende populaire programmeertalen, waaronder Python, Java, JavaScript en C++. Het kan ook codefragmenten in andere talen genereren, hoewel de kwaliteit van de uitvoer kan variëren afhankelijk van de complexiteit van de code en de beschikbaarheid van voorbeelden in de trainingsgegevens.

A: Ja, de codetolk van ChatGPT kan complexe codeertaken aan, waaronder machine learning-algoritmen, data-analyse en webontwikkeling. De kwaliteit van de gegenereerde code kan echter afhangen van de complexiteit van de taak en de omvang van de trainingsdataset die beschikbaar is voor het model.

A: Ja, de code die door de codetolk van ChatGPT wordt gegenereerd, is gratis te gebruiken onder de voorwaarden van de MIT-licentie. Dit betekent dat u de code voor commerciële doeleinden kunt wijzigen, distribueren en gebruiken zonder royalty's te betalen of toestemming van de auteur te verkrijgen.

De in dit artikel getoonde media zijn geen eigendom van Analytics Vidhya en worden naar goeddunken van de auteur gebruikt.

Verwant

- Door SEO aangedreven content en PR-distributie. Word vandaag nog versterkt.

- PlatoData.Network Verticale generatieve AI. Versterk jezelf. Toegang hier.

- PlatoAiStream. Web3-intelligentie. Kennis versterkt. Toegang hier.

- PlatoESG. carbon, CleanTech, Energie, Milieu, Zonne, Afvalbeheer. Toegang hier.

- Plato Gezondheid. Intelligentie op het gebied van biotech en klinische proeven. Toegang hier.

- Bron: https://www.analyticsvidhya.com/blog/2023/11/chatgpts-code-interpreter-gpt-4-advanced-data-analysis-for-data-scientists/