Hoewel algemeen wordt aangenomen dat generatieve AI-modellen daar gevoelig voor zijn hallucineren– dat wil zeggen het verzinnen van feiten en andere informatie die in strijd zijn met de realiteit – had het vlaggenschip ChatGPT van OpenAI dinsdag te lijden onder een bijzonder wijdverbreide aanval van grotendeels amusante incoherentie.

“ChatGPT ontspoort momenteel blijkbaar, en niemand kan verklaren waarom”, Twitter-gebruiker Sean McGuire schreef dinsdag laat in een virale tweet waarin enkele van de vreemdere voorbeelden werden verzameld.

“Ontslagen door de golven die foto’s maken, nestelt het product zich diep alsof een nanna onder een sombreret in admin-kleuren,” luidde een verminkte, door typfouten geteisterde reactie. De gebruiker antwoordde: "Heeft u een beroerte?"

Met behulp van ChatGPT 4.0 deelde McGuire schermafbeeldingen, waaronder een van ChatGPT die zelfs de fout erkende: "Het lijkt erop dat een technische hapering in mijn vorige bericht ervoor zorgde dat het zich herhaalde en in een onzinnig gedeelte terechtkwam", aldus de chatbot zei.

Reddit-gebruikers op de r/ChatGPT-subreddit plaatsten ook screenshots van het gebrabbel dat afkomstig was van ChatGPT.

“Enig idee waardoor dit komt?” Reddit-gebruiker u/JustSquiggles geplaatst, waarin ze deelden wat er gebeurde toen ze ChatGPT om een synoniem voor ‘overwoekerd’ vroegen. De chatbot reageerde ruim dertig keer met een lus van 'een synoniem voor 'overwoekerd' is 'overwoekerd' is 'overwoekerd' is' voordat hij stopte.

In een ander voorbeeld toonde Reddit-gebruiker u/toreachtheapex ChatGPT reageert met een lus van “en het is” totdat het antwoordveld vol was. De gebruiker moet 'doorgaan met genereren' selecteren of een nieuw gesprek beginnen.

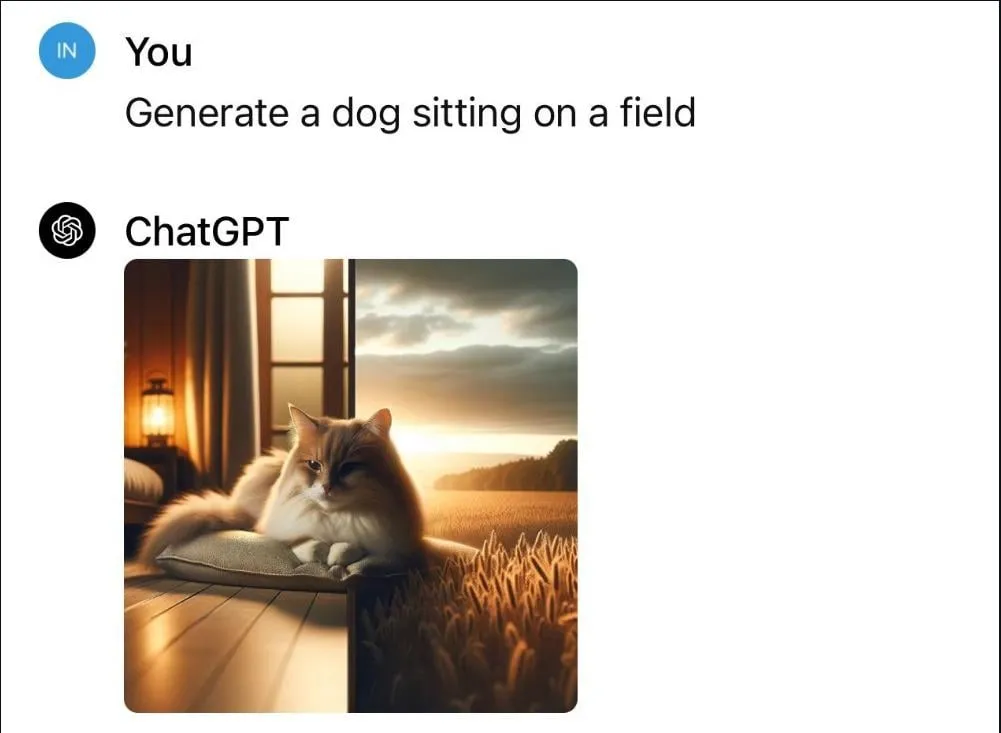

Volgens Reddit-gebruiker u/Mr_Akihiro reikte het probleem verder dan alleen op tekst gebaseerde reacties. Wanneer ze gevraagd ChatGPT om een afbeelding te genereren van ‘een hond die op een veld zit’, creëerde de ChatGPT-beeldgenerator in plaats daarvan een afbeelding van een kat die zat tussen wat leek op een gespleten afbeelding van een huis en een graanveld.

De kwestie was zo wijdverspreid dat OpenAI er om 6 uur EST naar begon te kijken. "We onderzoeken meldingen van onverwachte reacties van ChatGPT", zegt OpenAI statuspagina gezegd.

Om 6:47 uur ET zei OpenAI dat het het probleem had geïdentificeerd en eraan werkte om het op te lossen.

“Het probleem is geïdentificeerd en wordt nu verholpen”, aldus het OpenAI-statusrapport, eraan toevoegend dat het ondersteuningsteam de situatie in de gaten zou blijven houden.

Ten slotte zei een netwerkupdate om 11:14 uur EST op woensdag dat ChatGPT weer “normaal functioneerde”.

De tijdelijke storing is een nuttige herinnering voor gebruikers van AI-tools dat de modellen die eraan ten grondslag liggen zonder voorafgaande kennisgeving kunnen veranderen, waardoor een ogenschijnlijk solide schrijfpartner de ene dag in een maniakale saboteur verandert.

hallucinaties gegenereerd met grote taalmodellen (LLM's) zoals ChatGPT zijn onderverdeeld in feitelijke en waarheidsgetrouwe typen. Feitelijke hallucinaties zijn in tegenspraak met feiten uit de echte wereld, zoals het benoemen van de eerste Amerikaanse president.

Getrouwe hallucinaties wijken af van de gebruikersinstructies of context, wat leidt tot onnauwkeurigheden op gebieden als nieuws of geschiedenis – zoals in het geval van de Amerikaanse strafrechtadvocaat en hoogleraar rechten Jonathan Turley, die in april 2023 door ChatGPT werd beschuldigd van aanranding.

OpenAI reageerde niet direct op Ontsleutelen verzoek om commentaar.

Bewerkt door Andrew Hayward

Blijf op de hoogte van cryptonieuws, ontvang dagelijkse updates in je inbox.

- Door SEO aangedreven content en PR-distributie. Word vandaag nog versterkt.

- PlatoData.Network Verticale generatieve AI. Versterk jezelf. Toegang hier.

- PlatoAiStream. Web3-intelligentie. Kennis versterkt. Toegang hier.

- PlatoESG. carbon, CleanTech, Energie, Milieu, Zonne, Afvalbeheer. Toegang hier.

- Plato Gezondheid. Intelligentie op het gebied van biotech en klinische proeven. Toegang hier.

- Bron: https://decrypt.co/218434/chatgpt-off-rails-hallucinations-openai-fixed