De kiemen van een paradigmaverschuiving op het gebied van machine learning (ML) bestaan al tientallen jaren, maar met de gemakkelijke beschikbaarheid van schaalbare computercapaciteit, een enorme wildgroei aan gegevens en de snelle vooruitgang van ML-technologieën, transformeren klanten in verschillende sectoren hun bedrijf. Onlangs hebben generatieve AI-toepassingen zoals ChatGPT brede aandacht en verbeelding getrokken. We bevinden ons echt op een opwindend keerpunt in de wijdverspreide acceptatie van ML, en we geloven dat de meeste klantervaringen en -toepassingen opnieuw zullen worden uitgevonden met generatieve AI.

AI en ML zijn al meer dan 20 jaar een focus voor Amazon, en veel van de mogelijkheden die klanten met Amazon gebruiken, worden aangestuurd door ML. Onze engine voor e-commerce-aanbevelingen wordt aangedreven door ML; de paden die robotverzamelroutes in onze uitvoeringscentra optimaliseren, worden aangestuurd door ML; en onze toeleveringsketen, prognoses en capaciteitsplanning worden geïnformeerd door ML. Prime Air (onze drones) en de computer vision-technologie in Amazon Go (onze fysieke winkelervaring waarmee consumenten artikelen uit een schap kunnen selecteren en de winkel kunnen verlaten zonder formeel af te rekenen) maken gebruik van deep learning. Alexa, aangedreven door meer dan 30 verschillende ML-systemen, helpt klanten miljarden keren per week om slimme huizen te beheren, te winkelen, informatie en entertainment te krijgen en meer. We hebben duizenden ingenieurs bij Amazon die zich inzetten voor ML, en het maakt een groot deel uit van ons erfgoed, huidige ethos en toekomst.

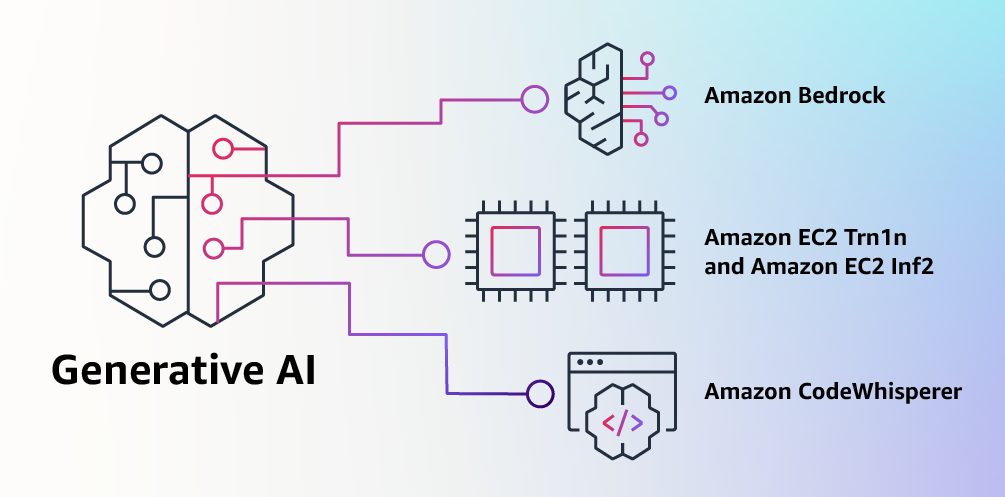

Bij AWS hebben we een sleutelrol gespeeld bij het democratiseren van ML en het toegankelijk maken ervan voor iedereen die het wil gebruiken, waaronder meer dan 100,000 klanten van elke omvang en uit elke branche. AWS heeft het breedste en diepste portfolio van AI- en ML-services op alle drie de lagen van de stack. We hebben geïnvesteerd en geïnnoveerd om de best presterende, schaalbare infrastructuur te bieden voor kosteneffectieve ML-training en inferentie; ontwikkelde Amazon SageMaker, wat voor alle ontwikkelaars de gemakkelijkste manier is om modellen te bouwen, trainen en implementeren; en lanceerde een breed scala aan services waarmee klanten AI-mogelijkheden zoals beeldherkenning, prognoses en intelligent zoeken aan applicaties kunnen toevoegen met een eenvoudige API-aanroep. Dit is de reden waarom klanten zoals Intuit, Thomson Reuters, AstraZeneca, Ferrari, Bundesliga, 3M en BMW, evenals duizenden startups en overheidsinstanties over de hele wereld, zichzelf, hun industrieën en hun missies transformeren met ML. We volgen dezelfde democratiserende benadering van generatieve AI: we werken eraan om deze technologieën uit het domein van onderzoek en experimenten te halen en hun beschikbaarheid uit te breiden tot ver voorbij een handvol startups en grote, goed gefinancierde technologiebedrijven. Daarom ben ik verheugd om vandaag verschillende nieuwe innovaties aan te kondigen die het onze klanten gemakkelijk en praktisch zullen maken om generatieve AI in hun bedrijf te gebruiken.

Bouwen met generatieve AI op AWS

Generatieve AI en basismodellen

Generatieve AI is een type AI dat nieuwe inhoud en ideeën kan creëren, waaronder gesprekken, verhalen, afbeeldingen, video's en muziek. Zoals alle AI wordt generatieve AI aangedreven door ML-modellen: zeer grote modellen die vooraf zijn getraind op enorme hoeveelheden gegevens en die gewoonlijk Foundation Models (FM's) worden genoemd. Recente ontwikkelingen in ML (met name de uitvinding van de op transformatoren gebaseerde neurale netwerkarchitectuur) hebben geleid tot de opkomst van modellen die miljarden parameters of variabelen bevatten. Om een idee te geven van de schaalverandering: het grootste vooraf getrainde model in 2019 was 330 miljoen parameters. Nu zijn de grootste modellen meer dan 500 miljard parameters - een toename van 1,600x in slechts een paar jaar tijd. De huidige FM's, zoals de grote taalmodellen (LLM's) GPT3.5 of BLOOM, en het tekst-naar-beeldmodel Stable Diffusion van Stability AI, kunnen een breed scala aan taken uitvoeren die meerdere domeinen omvatten, zoals het schrijven van blogposts, het genereren van afbeeldingen, het oplossen van wiskundige problemen, het aangaan van dialogen en het beantwoorden van vragen op basis van een document. Door de omvang en het algemene karakter van FM's verschillen ze van traditionele ML-modellen, die doorgaans specifieke taken uitvoeren, zoals het analyseren van tekst op sentiment, het classificeren van afbeeldingen en het voorspellen van trends.

FM's kunnen zoveel meer taken uitvoeren omdat ze zo'n groot aantal parameters bevatten dat ze in staat zijn om complexe concepten te leren. En door hun pre-training blootstelling aan gegevens op internetschaal in al zijn verschillende vormen en talloze patronen, leren FM's hun kennis toe te passen binnen een breed scala aan contexten. Hoewel de mogelijkheden en de daaruit voortvloeiende mogelijkheden van een voorgetrainde FM verbluffend zijn, raken klanten echt enthousiast omdat deze algemeen capabele modellen ook kunnen worden aangepast om domeinspecifieke functies uit te voeren die onderscheidend zijn voor hun bedrijf, waarbij ze slechts een klein deel van de gegevens gebruiken en rekenkracht vereist om een model helemaal opnieuw te trainen. De op maat gemaakte FM's kunnen een unieke klantervaring creëren, die de stem, stijl en diensten van het bedrijf belichaamt in een breed scala aan consumentensectoren, zoals het bankwezen, de reisbranche en de gezondheidszorg. Een financieel bedrijf dat bijvoorbeeld automatisch een dagelijks activiteitenrapport moet genereren voor interne verspreiding met behulp van alle relevante transacties, kan het model aanpassen met bedrijfseigen gegevens, waaronder eerdere rapporten, zodat de FM leert hoe deze rapporten moeten worden gelezen en wat gegevens werden gebruikt om ze te genereren.

Het potentieel van FM's is ongelooflijk opwindend. Maar we staan nog in de kinderschoenen. Hoewel ChatGPT de eerste brede generatieve AI-ervaring was die de aandacht van klanten trok, kwamen de meeste mensen die generatieve AI bestuderen al snel tot het besef dat verschillende bedrijven al jaren aan FM's werken en dat er verschillende FM's beschikbaar zijn, elk met unieke sterke punten en kenmerken. Zoals we in de loop der jaren hebben gezien met snel evoluerende technologieën en in de evolutie van ML, veranderen dingen snel. We verwachten dat er in de toekomst nieuwe architecturen zullen ontstaan, en deze diversiteit aan FM's zal een golf van innovatie op gang brengen. We zien al nieuwe applicatie-ervaringen die nog nooit eerder zijn gezien. AWS-klanten hebben ons gevraagd hoe ze snel kunnen profiteren van wat er vandaag is (en wat waarschijnlijk morgen komt) en snel kunnen beginnen met het gebruik van FM's en generatieve AI binnen hun bedrijven en organisaties om nieuwe niveaus van productiviteit te stimuleren en hun aanbod te transformeren.

Aankondiging van Amazon Bedrock- en Amazon Titan-modellen, de gemakkelijkste manier om generatieve AI-applicaties met FM's te bouwen en te schalen

Klanten hebben ons verteld dat er vandaag een paar grote dingen in de weg staan. Ten eerste hebben ze een eenvoudige manier nodig om goed presterende FM's te vinden en te gebruiken die uitstekende resultaten opleveren en het meest geschikt zijn voor hun doeleinden. Ten tweede willen klanten dat de integratie in applicaties naadloos verloopt, zonder enorme infrastructuurclusters te hoeven beheren of hoge kosten te maken. Ten slotte willen klanten dat het gemakkelijk is om de basis-FM te nemen en gedifferentieerde apps te bouwen met hun eigen gegevens (een beetje gegevens of veel). Omdat de gegevens die klanten willen gebruiken voor maatwerk ongelooflijk waardevol IP zijn, hebben ze het nodig om volledig beschermd, veilig en privé te blijven tijdens dat proces, en ze willen controle over hoe hun gegevens worden gedeeld en gebruikt.

We hebben al die feedback van klanten verzameld en vandaag zijn we verheugd om aan te kondigen Amazonebodem, een nieuwe service die FM's van AI21 Labs, Anthropic, Stability AI en Amazon toegankelijk maakt via een API. Bedrock is de gemakkelijkste manier voor klanten om generatieve, op AI gebaseerde applicaties te bouwen en te schalen met behulp van FM's, waardoor de toegang voor alle bouwers wordt gedemocratiseerd. Bedrock biedt de mogelijkheid om toegang te krijgen tot een reeks krachtige FM's voor tekst en afbeeldingen, inclusief Amazon's Titan FM's, die bestaan uit twee nieuwe LLM's die we vandaag ook aankondigen—via een schaalbare, betrouwbare en veilige door AWS beheerde service. Met de serverloze ervaring van Bedrock kunnen klanten gemakkelijk het juiste model vinden voor wat ze proberen te doen, snel aan de slag gaan, FM's privé aanpassen met hun eigen gegevens en ze eenvoudig integreren en implementeren in hun applicaties met behulp van de AWS-tools en -mogelijkheden die ze bekend zijn met (inclusief integraties met Amazon SageMaker ML-functies zoals Experimenten om verschillende modellen te testen en Pipelines om hun FM's op schaal te beheren) zonder enige infrastructuur te hoeven beheren.

Bedrock-klanten kunnen kiezen uit enkele van de meest geavanceerde FM's die momenteel beschikbaar zijn. Dit omvat de Jurassic-2-familie van meertalige LLM's van AI21 Labs, die natuurlijke taalinstructies volgen om tekst te genereren in het Spaans, Frans, Duits, Portugees, Italiaans en Nederlands. Claude, de LLM van Anthropic, kan een breed scala aan conversatie- en tekstverwerkingstaken uitvoeren en is gebaseerd op het uitgebreide onderzoek van Anthropic naar het trainen van eerlijke en verantwoordelijke AI-systemen. Bedrock maakt het ook gemakkelijk om toegang te krijgen tot Stability AI's suite van tekst-naar-beeld basismodellen, waaronder Stable Diffusion (de meest populaire in zijn soort), die in staat is om unieke, realistische, hoogwaardige afbeeldingen, kunst, logo's en ontwerpen.

Een van de belangrijkste mogelijkheden van Bedrock is hoe gemakkelijk het is om een model aan te passen. Klanten wijzen Bedrock gewoon op een paar gelabelde voorbeelden in Amazon S3, en de service kan het model verfijnen voor een bepaalde taak zonder grote hoeveelheden gegevens te hoeven annoteren (zo weinig als 20 voorbeelden is genoeg). Stel je een contentmarketingmanager voor die bij een toonaangevende moderetailer werkt en nieuwe, gerichte advertentie- en campagneteksten moet ontwikkelen voor een aanstaande nieuwe lijn handtassen. Om dit te doen, geven ze Bedrock een paar gelabelde voorbeelden van hun best presterende taglines uit eerdere campagnes, samen met de bijbehorende productbeschrijvingen, en Bedrock begint automatisch met het genereren van effectieve sociale media, display-advertenties en webteksten voor de nieuwe handtassen. Geen van de gegevens van de klant wordt gebruikt om de onderliggende modellen te trainen, en aangezien alle gegevens versleuteld zijn en de Virtual Private Cloud (VPC) van de klant niet verlaten, kunnen klanten erop vertrouwen dat hun gegevens privé en vertrouwelijk blijven.

Bedrock is nu in beperkte preview, en klanten houden ervan Koda zijn enthousiast over hoe snel hun ontwikkelingsteams aan de slag zijn gegaan. Shishir Mehrotra, mede-oprichter en CEO van Coda, zegt: “Als een langdurige tevreden AWS-klant zijn we enthousiast over hoe Amazon Bedrock kwaliteit, schaalbaarheid en prestaties kan toevoegen aan Coda AI. Omdat al onze gegevens al op AWS staan, kunnen we snel generatieve AI integreren met behulp van Bedrock, met alle beveiliging en privacy die we nodig hebben om onze gegevens te beschermen. Met meer dan tienduizenden teams die op Coda draaien, waaronder grote teams als Uber, de New York Times en Square, zijn betrouwbaarheid en schaalbaarheid erg belangrijk.”

We hebben de nieuwe Titan FM's van Amazon met een paar klanten bekeken voordat we ze de komende maanden breder beschikbaar maken. We hebben in eerste instantie twee Titan-modellen. De eerste is een generatieve LLM voor taken zoals samenvatting, tekstgeneratie (bijvoorbeeld het maken van een blogpost), classificatie, open vragen en antwoorden en informatie-extractie. De tweede is een inbeddings-LLM die tekstinvoer (woorden, woordgroepen of mogelijk grote teksteenheden) vertaalt in numerieke representaties (bekend als inbeddingen) die de semantische betekenis van de tekst bevatten. Hoewel deze LLM geen tekst zal genereren, is het handig voor toepassingen zoals personalisatie en zoeken, omdat door het vergelijken van inbeddingen het model relevantere en contextuelere antwoorden zal produceren dan het matchen van woorden. In feite gebruikt de productzoekfunctie van Amazon.com onder andere een vergelijkbaar inbeddingsmodel om klanten te helpen de producten te vinden waarnaar ze op zoek zijn. Om best practices voor verantwoord gebruik van AI te blijven ondersteunen, zijn Titan FM's gebouwd om schadelijke inhoud in de gegevens te detecteren en te verwijderen, ongepaste inhoud in de gebruikersinvoer te weigeren en de uitvoer van modellen te filteren die ongepaste inhoud bevat (zoals aanzetten tot haat, godslastering en geweld).

Bedrock maakt de kracht van FM's toegankelijk voor bedrijven van elke omvang, zodat ze het gebruik van ML in hun hele organisatie kunnen versnellen en hun eigen generatieve AI-applicaties kunnen bouwen, omdat het voor alle ontwikkelaars gemakkelijk zal zijn. We denken dat Bedrock een enorme stap voorwaarts zal zijn in het democratiseren van FM's, en onze partners zoals Accenture, Deloitte, Infosys en Slalom bouwen praktijken om bedrijven te helpen sneller te gaan met generatieve AI. Independent Software Vendors (ISV's) zoals C3AI en Pega zijn verheugd om Bedrock te gebruiken voor eenvoudige toegang tot de geweldige selectie FM's met alle beveiliging, privacy en betrouwbaarheid die ze van AWS verwachten.

Aankondiging van de algemene beschikbaarheid van Amazon EC2 Trn1n-instanties aangedreven door AWS Trainium en Amazon EC2 Inf2-instanties aangedreven door AWS Inferentia2, de meest kosteneffectieve cloudinfrastructuur voor generatieve AI

Wat klanten ook proberen te doen met FM's - ze runnen, bouwen, aanpassen - ze hebben de meest performante, kosteneffectieve infrastructuur nodig die speciaal is gebouwd voor ML. De afgelopen vijf jaar heeft AWS geïnvesteerd in ons eigen silicium om de grenzen van prestaties en prijsprestaties te verleggen voor veeleisende workloads zoals ML-training en inferentie, en onze AWS Trainium- en AWS Inferentia-chips bieden de laagste kosten voor trainingsmodellen en lopende inferentie in de wolk. Dit vermogen om de prestaties te maximaliseren en de kosten te beheersen door de optimale ML-infrastructuur te kiezen, is de reden waarom toonaangevende AI-startups, zoals AI21 Labs, Anthropic, Cohere, Grammarly, Hugging Face, Runway en Stability AI op AWS draaien.

Trn1-instances, mogelijk gemaakt door Trainium, kunnen tot 50% besparen op trainingskosten ten opzichte van andere EC2-instances, en zijn geoptimaliseerd om training te verdelen over meerdere servers die zijn verbonden met 800 Gbps van Elastic Fabric Adapter (EFA)-netwerken van de tweede generatie. Klanten kunnen Trn1-instanties implementeren in UltraClusters die kunnen worden opgeschaald tot 30,000 Trainium-chips (meer dan 6 exaflops aan rekenkracht) die zich in dezelfde AWS-beschikbaarheidszone bevinden met petabit-schaalnetwerken. Veel AWS-klanten, waaronder Helixon, Money Forward en het Amazon Search-team, gebruiken Trn1-instanties om de tijd die nodig is om de grootste deep learning-modellen te trainen te verminderen van maanden naar weken of zelfs dagen, terwijl hun kosten worden verlaagd. 800 Gbps is veel bandbreedte, maar we zijn blijven innoveren om meer te leveren, en vandaag kondigen we de algemene beschikbaarheid van nieuwe, netwerk-geoptimaliseerde Trn1n gevallen, die 1600 Gbps netwerkbandbreedte bieden en zijn ontworpen om 20% hogere prestaties te leveren dan Trn1 voor grote, netwerkintensieve modellen.

Tegenwoordig gaat het grootste deel van de tijd en het geld dat aan FM's wordt besteed, naar de training ervan. Dit komt omdat veel klanten nog maar net beginnen met het inzetten van FM's in productie. Wanneer FM's in de toekomst echter op grote schaal worden ingezet, zullen de meeste kosten worden gemaakt voor het uitvoeren van de modellen en het doen van gevolgtrekkingen. Terwijl u een model normaal gesproken periodiek traint, kan een productietoepassing voortdurend voorspellingen genereren, ook wel gevolgtrekkingen genoemd, en mogelijk miljoenen per uur genereren. En deze voorspellingen moeten in realtime gebeuren, wat netwerken met zeer lage latentie en hoge doorvoer vereist. Alexa is een geweldig voorbeeld met miljoenen verzoeken die elke minuut binnenkomen, wat goed is voor 40% van alle computerkosten.

Omdat we wisten dat de meeste toekomstige ML-kosten zouden komen van het uitvoeren van inferenties, gaven we prioriteit aan voor inferentie geoptimaliseerd silicium toen we een paar jaar geleden begonnen te investeren in nieuwe chips. In 2018 hebben we Inferentia aangekondigd, de eerste speciaal gebouwde chip voor inferentie. Elk jaar helpt Inferentia Amazon biljoenen gevolgtrekkingen uit te voeren en heeft het bedrijven als Amazon al meer dan honderd miljoen dollar aan kapitaaluitgaven bespaard. De resultaten zijn indrukwekkend en we zien veel mogelijkheden om te blijven innoveren, aangezien de werkbelasting alleen maar groter en complexer zal worden naarmate meer klanten generatieve AI integreren in hun applicaties.

Daarom kondigen we vandaag de algemene beschikbaarheid van Info2 instanties mogelijk gemaakt door AWS Inferentia2, die specifiek zijn geoptimaliseerd voor grootschalige generatieve AI-toepassingen met modellen die honderden miljarden parameters bevatten. Inf2-instanties leveren tot 4x hogere doorvoer en tot 10x lagere latentie in vergelijking met de vorige generatie op Inferentia gebaseerde instanties. Ze hebben ook ultrasnelle connectiviteit tussen versnellers om grootschalige gedistribueerde inferentie te ondersteunen. Deze mogelijkheden zorgen voor tot 40% betere prestaties op het gebied van inferentieprijzen dan andere vergelijkbare Amazon EC2-instanties en de laagste kosten voor inferentie in de cloud. Klanten zoals Runway zien een tot 2x hogere doorvoer met Inf2 dan vergelijkbare Amazon EC2-instanties voor sommige van hun modellen. Deze krachtige, goedkope inferentie stelt Runway in staat om meer functies te introduceren, complexere modellen te implementeren en uiteindelijk een betere ervaring te bieden aan de miljoenen videomakers die Runway gebruiken.

Aankondiging van de algemene beschikbaarheid van Amazon CodeWhisperer, gratis voor individuele ontwikkelaars

We weten dat het bouwen met de juiste FM's en het op schaal uitvoeren van Generative AI-applicaties op de meest performante cloudinfrastructuur transformerend zal zijn voor klanten. De nieuwe golf van ervaringen zal ook transformerend zijn voor gebruikers. Met ingebouwde generatieve AI kunnen gebruikers natuurlijkere en naadlozere interacties hebben met applicaties en systemen. Bedenk hoe we onze mobiele telefoons kunnen ontgrendelen door er gewoon naar te kijken, zonder iets te hoeven weten over de krachtige ML-modellen die deze functie mogelijk maken.

Een gebied waarop we voorzien dat het gebruik van generatieve AI snel zal groeien, is coderen. Softwareontwikkelaars besteden tegenwoordig een aanzienlijk deel van hun tijd aan het schrijven van code die vrij eenvoudig en ongedifferentieerd is. Ze besteden ook veel tijd aan het bijhouden van een complex en steeds veranderend tool- en technologielandschap. Dit alles geeft ontwikkelaars minder tijd om nieuwe, innovatieve mogelijkheden en diensten te ontwikkelen. Ontwikkelaars proberen dit te verhelpen door codefragmenten van internet te kopiëren en aan te passen, wat kan resulteren in het onbedoeld kopiëren van code die niet werkt, beveiligingsproblemen bevat of het gebruik van open source-software niet bijhoudt. En uiteindelijk kost het zoeken en kopiëren nog steeds tijd van de goede dingen.

Generatieve AI kan dit zware werk uit de vergelijking halen door veel van de ongedifferentieerde code te "schrijven", waardoor ontwikkelaars sneller kunnen bouwen terwijl ze tijd vrijmaken om zich te concentreren op de meer creatieve aspecten van coderen. Daarom hebben we vorig jaar de preview aangekondigd van Amazon Code Whisperer, een partner voor AI-codering die een FM onder de motorkap gebruikt om de productiviteit van ontwikkelaars radicaal te verbeteren door in realtime codesuggesties te genereren op basis van de opmerkingen van ontwikkelaars in natuurlijke taal en eerdere code in hun Integrated Development Environment (IDE). Ontwikkelaars kunnen CodeWhisperer eenvoudig vertellen om een taak uit te voeren, zoals "een CSV-reeks nummers ontleden" en vragen om een gestructureerde lijst terug te sturen op basis van waarden zoals artiest, titel en hoogste hitlijst. CodeWhisperer zorgt voor een productiviteitsboost door een volledige functie te genereren die de tekenreeks ontleedt en de lijst retourneert zoals gespecificeerd. De reacties van ontwikkelaars op de preview waren overweldigend positief en we blijven geloven dat het helpen van ontwikkelaars bij het coderen een van de krachtigste toepassingen van generatieve AI zou kunnen worden die we de komende jaren zullen zien. Tijdens de preview hebben we een productiviteitsuitdaging gedaan en deelnemers die CodeWhisperer gebruikten, voltooiden taken gemiddeld 57% sneller en hadden 27% meer kans om ze met succes af te ronden dan degenen die CodeWhisperer niet gebruikten. Dit is een enorme sprong voorwaarts in de productiviteit van ontwikkelaars en we geloven dat dit nog maar het begin is.

Vandaag zijn we verheugd om de algemene beschikbaarheid van Amazon CodeWhisperer voor Python, Java, JavaScript, TypeScript en C#—plus tien nieuwe talen, waaronder Go, Kotlin, Rust, PHP en SQL. CodeWhisperer is toegankelijk via IDE's zoals VS Code, IntelliJ IDEA, AWS Cloud9 en nog veel meer via de AWS Toolkit IDE-extensies. CodeWhisperer is ook beschikbaar in de AWS Lambda-console. Naast het leren van de miljarden regels openbaar beschikbare code, is CodeWhisperer getraind in Amazon-code. Wij geloven dat CodeWhisperer nu de meest nauwkeurige, snelste en veiligste manier is om code te genereren voor AWS-services, waaronder Amazon EC2, AWS Lambda en Amazon S3.

Ontwikkelaars zullen niet echt productiever zijn als code die wordt voorgesteld door hun generatieve AI-tool verborgen beveiligingsproblemen bevat of niet op verantwoorde wijze met open source omgaat. CodeWhisperer is de enige AI-coderingspartner met ingebouwde beveiligingsscanning (aangedreven door geautomatiseerd redeneren) voor het vinden en voorstellen van oplossingen voor moeilijk te detecteren kwetsbaarheden, zoals die in de top tien van het Open Worldwide Application Security Project (OWASP), die voldoe niet aan de best practices voor cryptobibliotheken en andere. Om ontwikkelaars te helpen op verantwoorde wijze te coderen, filtert CodeWhisperer codesuggesties die als bevooroordeeld of oneerlijk kunnen worden beschouwd, en CodeWhisperer is de enige codeerpartner die codesuggesties kan filteren en markeren die lijken op open source-code die klanten mogelijk willen raadplegen of in licentie willen geven voor gebruik.

We weten dat generatieve AI het spel voor ontwikkelaars gaat veranderen, en we willen dat het voor zoveel mogelijk mensen nuttig is. Daarom is CodeWhisperer gratis voor alle individuele gebruikers zonder kwalificaties of tijdslimieten voor het genereren van code! Iedereen kan zich aanmelden voor CodeWhisperer met slechts een e-mailaccount en binnen enkele minuten productiever worden. U hoeft niet eens een AWS-account te hebben. Voor zakelijke gebruikers bieden we een CodeWhisperer Professional Tier met beheerfuncties zoals eenmalige aanmelding (SSO) met AWS Identity and Access Management (IAM)-integratie, evenals hogere limieten voor beveiligingsscans.

Het bouwen van krachtige applicaties zoals CodeWhisperer is transformerend voor ontwikkelaars en al onze klanten. Er komt nog veel meer aan en we zijn enthousiast over wat je gaat bouwen met generatieve AI op AWS. Onze missie is om het voor ontwikkelaars van alle niveaus en voor organisaties van elke omvang mogelijk te maken om te innoveren met behulp van generatieve AI. Dit is nog maar het begin van wat volgens ons de volgende golf van ML zal zijn die nieuwe mogelijkheden voor u zal aandrijven.

Resources

Bekijk de volgende bronnen voor meer informatie over generatieve AI op AWS en deze aankondigingen:

Over de auteur

Swami Sivasubramaniaan is Vice President Data en Machine Learning bij AWS. In deze rol houdt Swami toezicht op alle AWS Database-, Analytics- en AI & Machine Learning-services. De missie van zijn team is om organisaties te helpen hun data aan het werk te zetten met een complete, end-to-end data-oplossing om op te slaan, toegang te krijgen, te analyseren, te visualiseren en te voorspellen.

Swami Sivasubramaniaan is Vice President Data en Machine Learning bij AWS. In deze rol houdt Swami toezicht op alle AWS Database-, Analytics- en AI & Machine Learning-services. De missie van zijn team is om organisaties te helpen hun data aan het werk te zetten met een complete, end-to-end data-oplossing om op te slaan, toegang te krijgen, te analyseren, te visualiseren en te voorspellen.

- Door SEO aangedreven content en PR-distributie. Word vandaag nog versterkt.

- Platoblockchain. Web3 Metaverse Intelligentie. Kennis versterkt. Toegang hier.

- Bron: https://aws.amazon.com/blogs/machine-learning/announcing-new-tools-for-building-with-generative-ai-on-aws/