AI-modellen kunnen goed genoeg omgaan met tekst of afbeeldingen, en kunnen zelfs complexe problemen oplossen als ze geen vreselijke fouten maken.

OpenAI heeft dat bijvoorbeeld zei dat zijn GPT-4-model erin slaagde 700 van de 800 te scoren op het SAT wiskunde-examen. Niet al deze beweringen zijn echter bevestigd: een artikel dat in juni werd gepubliceerd en waarin stond dat GPT-4 een graad in computerwetenschappen aan het MIT zou kunnen krijgen, was vervolgens ingetrokken.

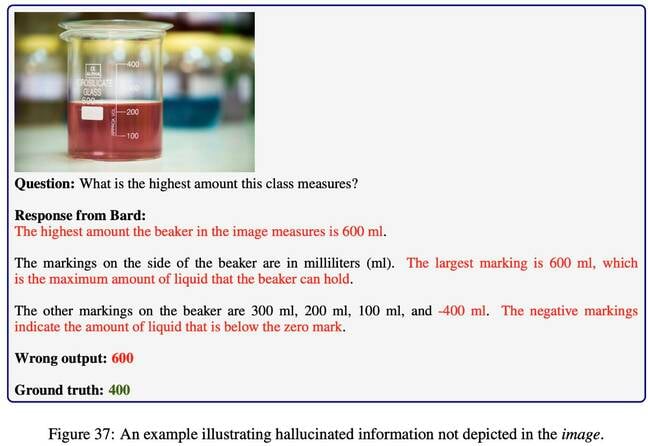

Om beter te kunnen beoordelen hoe grote taalmodellen – die tekstinvoer interpreteren – en grote multimodale modellen – die tekst, afbeeldingen en misschien andere vormen van invoer interpreteren – daadwerkelijk omgaan met het oplossen van problemen, heeft een groep van tien onderzoekers van de Universiteit van Californië, Los Angeles, de Universiteit van Washington en Microsoft Research hebben een testbenchmark bedacht, genaamd MathVista dat zich richt op visueel georiënteerde uitdagingen.

“Het vermogen van deze basismodellen om wiskundig redeneren in visuele contexten uit te voeren is niet systematisch onderzocht”, zeggen de auteurs – Pan Lu, Hritik Bansal, Tony Xia, Jiacheng Liu, Chunyuan Li, Hannaneh Hajishirzi, Hao Cheng, Kai-Wei Chang , Michel Galley en Jianfeng Gao, in een voordruk papier [Pdf].

Het is dus essentieel, zeggen ze, om een nieuwe maatstaf te ontwikkelen om de ontwikkeling van wiskundig redeneren met een visuele component te helpen en om te evalueren hoe verschillende modellen zich verhouden bij redeneertaken.

Als je kunt aantonen dat je AI-model visuele problemen correct kan oplossen, kan dit nuttig zijn bij het bepalen of het verstandig is om bijvoorbeeld op software te vertrouwen om een auto te besturen zonder bovenop stoppen een ongevalsslachtoffer.

MathVista bevat 6,141 voorbeelden die zijn ontwikkeld op basis van 28 multimodale datasets en uit 3 nieuwe datasets genaamd IQTest, FunctionQA en PaperQA. Het behandelt verschillende vormen van redeneren (algebraïsch, rekenkundig, meetkundig, logisch, numeriek, wetenschappelijk en statistisch), met de nadruk op het beantwoorden van figuurvragen, het oplossen van meetkundeproblemen, wiskundige woordproblemen, leerboekvragen en visuele vragen.

De onderzoekers testten een tiental basismodellen: drie LLM's ChatGPT, GPT-4 en Claude-2), twee eigen LMM's (GPT4V en Bard) en zeven open-source LMM's. Ze hielden ook rekening met menselijke antwoorden, verstrekt via Amazon Mechanical Turkers met ten minste een middelbareschooldiploma, en willekeurige antwoorden.

Het goede nieuws voor AI-beoefenaars is dat de LLM's en LMM's het allemaal beter deden dan willekeurig toeval, wat niet zo verrassend is als je bedenkt dat veel van de vragen meerkeuzevragen waren in plaats van ja of nee.

In feite is de topspeler, OpenAI's GPT-4V, erin geslaagd de menselijke prestaties op specifieke gebieden te overtreffen – vragen die te maken hebben met algebraïsch redeneren en complexe visuele uitdagingen met tabellen en functieplots.

We merken op dat Microsoft, wiens onderzoekers aan dit project hebben bijgedragen, een substantieel belang heeft in OpenAI.

Het minder goede nieuws is dat zelfs GPT-4V slechts 49.9 procent van de vragen goed wist te krijgen. Dat is voldoende als het doel is om de beste multimodale Bard te zijn, die een nauwkeurigheidspercentage van 34.8 procent wist te behalen.

Maar het is nog steeds verlegen voor de werknemers van Amazon Mechanical Turk die op de proef werden gesteld en een score van 60.3 procent behaalden. Zoals de onderzoekers in hun artikel opmerken, “blijft er een kloof van 10.4 procent in de algehele nauwkeurigheid bestaan in vergelijking met de menselijke basislijn, waardoor er voldoende ruimte overblijft voor modelverbetering.” ®

- Door SEO aangedreven content en PR-distributie. Word vandaag nog versterkt.

- PlatoData.Network Verticale generatieve AI. Versterk jezelf. Toegang hier.

- PlatoAiStream. Web3-intelligentie. Kennis versterkt. Toegang hier.

- PlatoESG. carbon, CleanTech, Energie, Milieu, Zonne, Afvalbeheer. Toegang hier.

- Plato Gezondheid. Intelligentie op het gebied van biotech en klinische proeven. Toegang hier.

- Bron: https://go.theregister.com/feed/www.theregister.com/2023/10/29/ai_math_quiz/