개요

LLM의 힘은 AI 커뮤니티에서 새로운 화제가 되었습니다. 얼리 어답터들은 다양한 사용 사례에 대해 GPT 3.5, GPT 4, BARD와 같은 다양한 생성 AI 솔루션으로 몰려들었습니다. 질문 및 답변 작업, 창의적인 텍스트 작성 및 비판적 분석에 사용되었습니다. 이러한 모델은 다양한 말뭉치에 대한 다음 문장 예측과 같은 작업에 대해 훈련되었으므로 텍스트 생성에 탁월할 것으로 예상됩니다.

강력한 변환기 기반 중립 네트워크를 통해 모델은 분류, 번역, 예측, 엔터티 인식과 같은 언어 기반 기계 학습 작업에도 적응할 수 있습니다. 따라서 데이터 과학자는 적절한 지침을 제공함으로써 보다 실용적이고 산업 언어 기반 ML 사용 사례에 대해 생성적 AI 플랫폼을 활용하는 것이 쉬워졌습니다. 이 기사에서는 프롬프트를 사용하여 널리 사용되는 언어 기반 ML 작업에 생성적 LLM을 사용하는 것이 얼마나 간단한지 보여주고 제로 샷 및 소수 샷 프롬프트의 이점과 한계를 비판적으로 분석하는 것을 목표로 합니다.

학습 목표

- 제로샷 및 퓨샷 프롬프트에 대해 알아보세요.

- 예시적인 머신러닝 작업에 대한 성과를 분석하세요.

- 미세 조정과 같은 보다 정교한 기술에 대해 몇 번의 메시지를 평가합니다.

- 프롬프트 기법의 장점과 단점을 이해합니다.

이 기사는 데이터 과학 블로그.

차례

프롬프트란 무엇입니까?

LLM 정의부터 시작해 보겠습니다. 대규모 언어 모델(LLM)은 수억에서 수십억 개의 매개변수를 포함하는 여러 계층의 변환기와 피드포워드 신경망으로 구축된 딥 러닝 시스템입니다. 다양한 소스의 대규모 데이터 세트에 대해 교육을 받았으며 텍스트를 이해하고 생성하도록 구축되었습니다. 몇 가지 예제 애플리케이션에는 언어 번역, 텍스트 요약, 질문 답변, 콘텐츠 생성 등이 있습니다. LLM에는 인코더 전용(BERT), 인코더 + 디코더(BART, T5), 디코더 전용(PALM, GPT 등) 등 다양한 유형이 있습니다. 디코더 구성요소가 있는 LLM을 생성적 LLM이라고 합니다. 이는 대부분의 최신 LLM의 경우입니다.

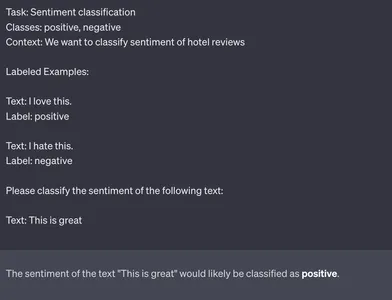

Generative LLM에 작업을 수행하도록 지시하면 해당 텍스트가 생성됩니다. 그러나 Generative LLM에게 특정 작업을 수행하도록 어떻게 지시합니까? 그것은 쉽습니다; 우리는 서면으로 지시합니다. LLM은 프롬프트라고도 불리는 지침을 기반으로 최종 사용자에게 응답하도록 설계되었습니다. ChatGPT와 같은 LLM과 상호작용한 경우 프롬프트를 사용한 것입니다. 프롬프트는 모델이 원하는 응답을 반환하도록 하는 자연어 쿼리로 의도를 패키징하는 것입니다(예: 그림 1, 출처: Chat GPT).

다음 섹션에서 살펴볼 프롬프트 기술에는 제로샷과 퓨샷이라는 두 가지 주요 유형이 있습니다. 몇 가지 기본적인 예와 함께 세부 사항을 살펴보겠습니다.

제로샷 프롬프트

제로샷 프롬프트는 생성적 LLM에 고유한 제로샷 학습의 특정 시나리오입니다. 제로샷에서는 모델에 레이블이 지정된 데이터를 제공하지 않으며 모델이 완전히 새로운 문제에 대해 작동할 것으로 기대합니다. 예를 들어 적절한 지침을 제공하여 새 작업에 대한 제로샷 프롬프트를 표시하려면 ChatGPT를 사용하세요. LLM은 많은 리소스의 콘텐츠를 이해하기 때문에 보이지 않는 문제에 적응할 수 있습니다. 몇 가지 예를 살펴보겠습니다.

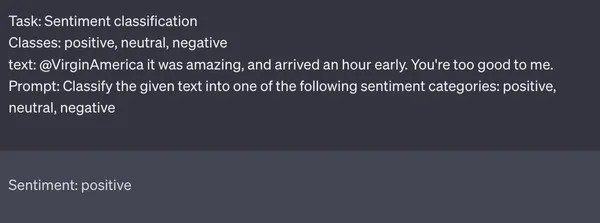

다음은 텍스트를 긍정적, 중립, 부정적 감정 클래스로 분류하기 위한 쿼리 예시입니다.

트윗 예시

트윗 예시는 Twitter US Airline 감정 데이터 세트. 데이터세트는 긍정적, 중립적, 부정적 라벨이 붙은 다양한 항공사에 대한 피드백 트윗으로 구성됩니다. 그림 2(출처: ChatGPT)에서는 작업 이름(즉, Sentiment Classification), 클래스(즉, 긍정, 중립, 부정), 텍스트 및 분류 프롬프트를 제공했습니다. 그림 2의 항공사 피드백은 긍정적이며 항공사의 비행 경험을 높이 평가합니다. ChatGPT는 리뷰의 감정을 긍정적인 것으로 올바르게 분류하여 ChatGPT가 새로운 작업을 일반화하는 기능을 보여줍니다.

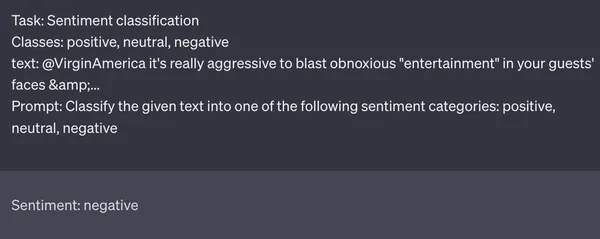

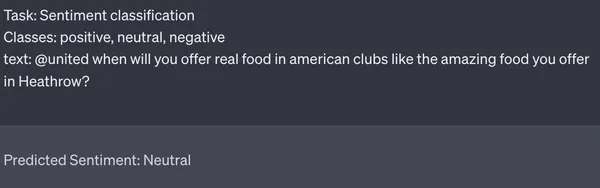

위의 그림 3은 또 다른 예에서 제로 샷이 있지만 부정적인 감정이 있는 Chat GPT를 보여줍니다. Chat GPT는 트윗의 감정을 다시 정확하게 예측합니다. 모델이 리뷰 텍스트를 성공적으로 분류하는 두 가지 예를 보여주었지만, 최첨단 LLM도 실패하는 몇 가지 경계선 사례가 있습니다. 예를 들어 아래 그림 4의 예를 살펴보겠습니다. 사용자는 항공사에 음식 품질에 대해 불만을 제기하고 있습니다. Chat GPT는 감정을 중립으로 잘못 식별합니다.

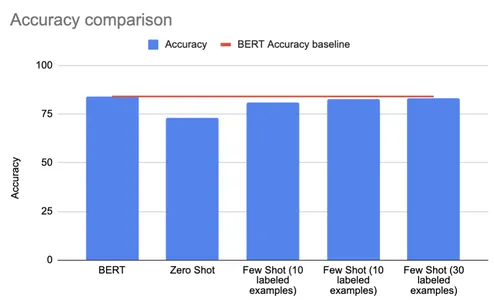

아래 표에서 제로샷과 BERT 모델의 성능을 비교한 것을 볼 수 있습니다(출처) Twitter 감정 데이터 세트에 있습니다. 측정항목 정확도, F1 점수, 정밀도 및 재현율을 살펴보겠습니다. 각 사례에 대한 항공사 감정 데이터 세트에서 무작위로 선택된 데이터 하위 집합에 대한 제로샷 프롬프트 성능을 평가하고 성능 수치를 가장 가까운 정수로 반올림합니다. 제로샷은 모든 평가 지표에서 낮지만 괜찮은 성능을 보여 얼마나 강력한 프롬프트가 될 수 있는지 보여줍니다. 성능 수치는 가장 가까운 정수로 반올림되었습니다.

| 모델 | 정확성 | F1 점수 | Precision | 소환 |

| 미세 조정된 BERT | 84% | 79% | 80% | 79% |

| 채팅 GPT(제로샷) [출처] | 73% | 72% | 74% | 76% |

몇 번의 프롬프트

제로샷과 달리 퓨샷 프롬프트에는 프롬프트에 몇 가지 레이블이 지정된 예가 제공됩니다. 이는 새로운 문제에 대해 몇 가지 샘플을 사용하여 LLM을 미세 조정하는 기존의 소수 학습과 다릅니다. 이 접근 방식은 모델이 소수의 레이블이 지정된 샘플을 사용하여 새 클래스에 대해 신속하게 적응하고 정확한 예측을 생성할 수 있도록 하여 대규모 레이블이 지정된 데이터 세트에 대한 의존도를 줄입니다. 이 방법은 새 클래스에 대해 상당한 양의 레이블이 지정된 데이터를 수집하는 데 시간과 노력이 필요할 때 유용합니다. 다음은 퓨샷의 예(그림 5)입니다.

몇 번의 샷 대 제로 샷

퓨샷을 하면 성능이 얼마나 향상되나요? 일화적인 예에서는 퓨샷 및 제로샷 기법이 좋은 성능을 보인 반면, 퓨샷은 제로샷보다 전반적인 성능이 더 높습니다. 아래 표에서 볼 수 있듯이 Generative AI 모델을 활성화하는 동시에 몇 가지 고품질 예제와 경계선 및 중요한 예제의 샘플을 제공하여 당면 작업의 정확성을 향상시킬 수 있습니다. 퓨샷 학습(예제 10, 20, 50개)을 사용하면 성능이 향상됩니다. 몇 번의 메시지 표시에 대한 성능은 각 사례에 대한 항공사 정서 데이터 세트의 데이터를 무작위로 하위 집합으로 평가했으며 성능 수치는 가장 가까운 정수로 반올림되었습니다.

| 모델 | 정확성 | F1 점수 | Precision | 소환 |

| 미세 조정된 BERT | 84% | 79% | 80% | 79% |

| 채팅 GPT(10개 예시) [출처] | 80.8% | 76% | 74% | 79% |

| 채팅 GPT(20개 예시) [출처] | 82.8% | 79% | 77% | 81% |

| 채팅 GPT(30개 예시) [출처] | 83% | 79% | 77% | 81% |

위 표의 평가 지표를 기반으로 퓨샷은 정확도에서 10%, F7 점수에서 1%라는 눈에 띄는 차이로 제로샷을 능가하며 미세 조정된 BERT 모델과 동등한 성능을 달성했습니다. 또 다른 주요 관찰은 20개의 사례 이후 개선이 정체된다는 것입니다. 분석에서 다룬 예는 Twitter US Airlines 감정 데이터 세트의 Chat GPT의 특정 사용 사례입니다. 우리의 관찰이 더 많은 작업과 생성 AI 모델에 걸쳐 있는지 이해하기 위해 또 다른 예를 살펴보겠습니다.

언어 모델: 소수의 샷 학습자

아래(그림 6)는 논문에 설명된 연구의 예입니다.언어 모델은 몇 번의 학습자입니다” GPT-3와 퓨샷, 원샷, 제로샷 모델의 성능을 비교합니다. 성능은 다양한 Few-Shot 설정에서 LAMBADA 벤치마크(대상 단어 예측)로 측정됩니다. LAMBADA의 독창성은 관련 컨텍스트에서 정보 조각을 상당한 거리로 분리하는 상황인 텍스트의 장거리 종속성을 처리하는 모델의 능력을 평가하는 데 중점을 두고 있다는 것입니다. 퓨샷 학습은 정확도에서 12.2pp라는 눈에 띄는 차이로 제로샷 학습을 능가합니다.

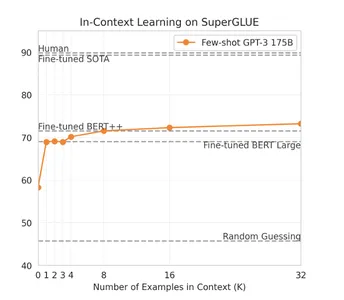

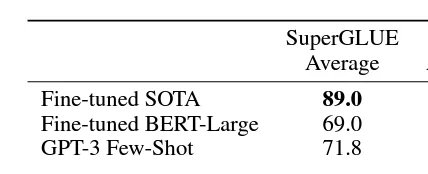

위에서 언급한 백서에서 다룬 또 다른 예에서는 GPT-3의 성능을 SuperGLUE 벤치마크에서 미세 조정된 BERT 모델에 대해 프롬프트에 제공된 다양한 예에서 비교합니다. SuperGLUE는 언어 이해 ML 작업의 성능을 평가하기 위한 주요 벤치마크로 간주됩니다. 그래프(그림 7)는 처음 XNUMX개의 예가 가장 큰 영향을 미치는 것을 보여줍니다. Few-Shot 프롬프트에 대한 더 많은 예제를 추가함에 따라 눈에 띄는 개선을 보려면 예제를 기하급수적으로 늘려야 하는 벽에 부딪혔습니다. 감정 분류 예제와 동일한 관찰이 복제되었음을 매우 명확하게 볼 수 있습니다.

제로샷은 레이블이 지정된 데이터가 누락된 시나리오에서만 고려해야 합니다. 몇 가지 레이블이 지정된 예제를 얻으면 제로샷에 비해 퓨샷을 사용하여 뛰어난 성능 향상을 달성할 수 있습니다. 남아있는 질문은 미세 조정과 같은 보다 정교한 기술과 비교할 때 이러한 기술이 얼마나 잘 수행되는지입니다. 최근에는 LLM 미세 조정 기술이 잘 개발되어 사용 비용도 크게 절감되었습니다. 왜 모델을 미세 조정하면 안 됩니까? 다음 섹션에서는 프롬프트 기법을 미세 조정된 모델과 비교하는 방법을 더 자세히 살펴보겠습니다.

몇 번의 프롬프트와 미세 조정

생성 LLM을 사용한 소수 샷의 주요 이점은 접근 방식 구현이 단순하다는 것입니다. 레이블이 지정된 몇 가지 예를 수집하고 프롬프트를 준비하고 추론을 실행하면 완료됩니다. 여러 가지 현대적인 혁신에도 불구하고 미세 조정은 구현이 상당히 까다로우며 많은 교육 시간과 리소스가 필요합니다. 몇 가지 특정 사례의 경우 다양한 생성 LLM UI를 사용하여 결과를 얻을 수 있습니다. 더 큰 데이터 세트에 대한 추론을 위한 코드는 다음과 같이 간단합니다.

import os

import openai messages = [] # Chat GPT labeled examples

few_shot_message = "" # Mention the Task

few_shot_message = "Task: Sentiment Classification n" # Mention the classes

few_shot_message += "Classes: positive, negative n" # Add context

few_shot_message += "Context: We want to classify sentiment of hotel reviews n" #Add labeled examples

few_shot_message += "Labeled Examples: n" for labeled_data in labeled_dataset: few_shot_message += "Text: " + labeled_data["text"] + "n"; few_shot_message += "Label: " + labeled_data["label"] + "n" # Call OpenAI API for ChatGPT providing the few-shot examples

messages.append({"role": "user", "content": few_shot_message})

chat = openai.ChatCompletion.create( model="gpt-3.5-turbo", messages=messages ) for data in unlabeled_dataset: # Add the text to classfy message = "Text: " + data + ", " # Add the prompt message += "Prompt: Classify the given text into one of the sentiment categories." messages.append({"role": "user", "content": message}) # Call OpenAI API for ChatGPT for classification chat = openai.ChatCompletion.create( model="gpt-3.5-turbo", messages=messages ) reply = chat.choices[0].message.content print(f"ChatGPT: {reply}") messages.append({"role": "assistant", "content": reply})

미세 조정에 비해 퓨샷의 또 다른 주요 이점은 데이터 양입니다. Twitter US Airlines Sentiment 분류 작업에서 BERT 미세 조정은 10,000개 이상의 예시로 수행된 반면, Few-Shot 프롬프트에서는 유사한 성능을 얻기 위해 20~50개의 예시만 필요했습니다. 그러나 이러한 성능 향상이 다른 언어 기반 ML 작업에도 일반화됩니까? 우리가 다룬 감정 분류 예시는 매우 구체적인 사용 사례입니다. 몇 번의 메시지 표시 성능은 모든 사용 사례에 대해 미세 조정된 모델에 미치지 못합니다. 그러나 다양한 언어 작업에 걸쳐 유사하거나 더 나은 기능을 보여줍니다. Few-shot 프롬프트의 힘을 보여주기 위해 우리는 아래 섹션에서 표준화된 언어 이해, 번역 및 QA 벤치마크 전반에 걸쳐 작업에 대해 SOTA 및 BERT와 같은 미세 조정된 언어 모델의 성능을 비교했습니다. (원천: 언어 모델은 몇 번의 학습자입니다)

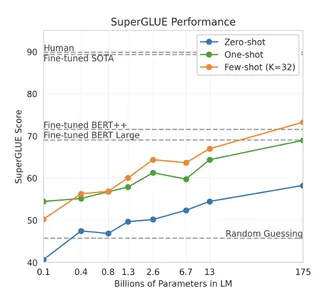

언어 이해

언어 이해 작업에 대한 퓨샷 및 미세 조정 성능을 비교하기 위해 SuperGLUE 벤치마크를 살펴보겠습니다. SuperGLUE는 분류, 텍스트 유사성, 자연어 추론 작업으로 구성된 언어 이해 벤치마크입니다. 비교에 사용된 미세 조정 모델은 미세 조정 BERT 대형 및 미세 조정 BERT++ 모델이며, 사용된 생성 LLM은 GPT-3입니다. 아래 그림(그림 8 및 그림 9)의 차트는 충분히 큰 크기의 Generative LLM을 사용한 소수 샷 프롬프트를 보여 주며, 약 32개의 소수 예제는 Fine-tuned BERT++ 및 Fine-tuned BERT Large를 능가하기에 충분합니다. BERT Large에 대한 정확도 이득은 약 2.8pp로, 생성 LLM에서 소수 샷의 강력함을 보여줍니다.

번역

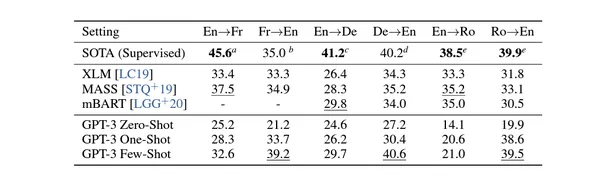

다음 작업에서는 변환 기반 작업에 대한 Few-Shot과 Fine-Tuning의 성능을 비교해 보겠습니다. 이중 언어 평가 언더스터디(Bilingual Evaluation Understudy)라고도 불리는 BLUE 벤치마크를 살펴보겠습니다. BLEU는 0에서 1 사이의 점수를 계산하며, 점수가 높을수록 번역 품질이 우수함을 나타냅니다. BLEU의 주요 아이디어는 생성된 번역을 하나 이상의 참조 번역과 비교하고 생성된 번역에 참조 번역과 유사한 n-gram이 포함되어 있는 정도를 측정하는 것입니다. 비교에 사용된 모델은 XLM, MASS, mBART이며, 생성적 LLM은 GPT-3이다.

아래 그림(그림 10)의 표에서 볼 수 있듯이 몇 가지 예가 포함된 생성적 LLM을 사용한 몇 번의 프롬프트는 다양한 번역 작업에 대해 XLM, MASS, 다국어 BART 및 심지어 SOTA를 능가하는 데 충분합니다. Few-shot GPT-3는 영어로 번역할 때 이전의 비지도 신경 기계 번역 작업보다 5 BLEU 성능이 뛰어나며 이는 영어 번역 언어 모델로서의 강점을 반영합니다. 그러나 영어에서 루마니아어로의 번역과 같은 특정 번역 작업에서는 모델의 성능이 좋지 않아 사례별로 성능을 평가해야 할 필요성과 격차가 강조된다는 점에 유의하는 것이 중요합니다.

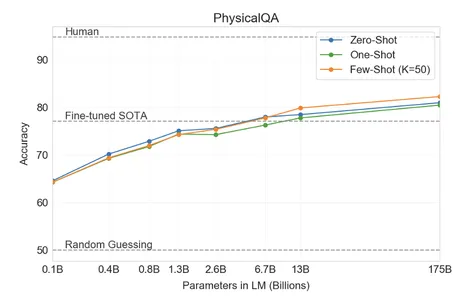

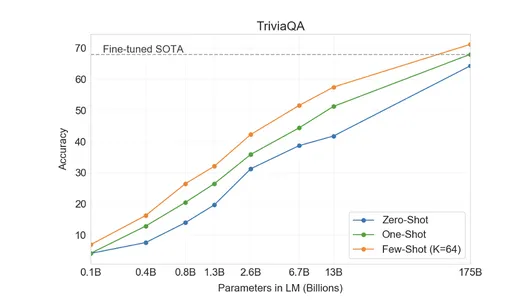

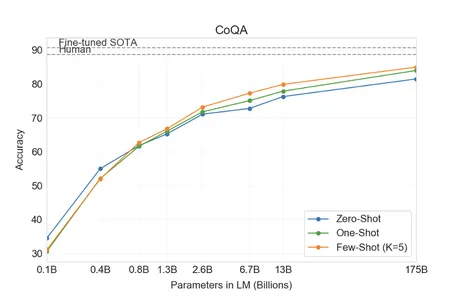

질의응답

마지막 과제에서는 질의응답 과제에 대한 Few-Shot과 Fine-Tuning의 성능을 비교해보겠습니다. 작업 이름은 설명이 필요하지 않습니다. QA 작업에 대한 세 가지 주요 벤치마크인 PI QA(절차적 정보 질문 응답), Trivia QA(사실 지식 및 질문 응답) 및 CoQA(대화형 질문 응답)를 살펴보겠습니다. 미세 조정 모델의 경우 SOTA와 비교되며 사용된 생성 LLM은 GPT-3입니다. 아래 그림(그림 11, 그림 12 및 그림 13)의 차트에서 볼 수 있듯이 몇 가지 예를 포함하는 생성적 LLM에 대한 몇 번의 메시지 표시만으로도 PIQA 및 Trivia QA에 대해 미세 조정된 SOTA를 능가할 수 있습니다. 이 모델은 CoQA를 위해 미세 조정된 SOTA를 놓쳤지만 정확도는 상당히 비슷했습니다.

프롬프트의 한계

위 섹션의 수많은 예제와 사례 연구는 여러 언어 기반 ML 작업에 대한 미세 조정보다 소수의 솔루션이 얼마나 적합한 솔루션이 될 수 있는지 명확하게 보여줍니다. 대부분의 경우 퓨샷 기술은 미세 조정된 언어 모델보다 더 좋거나 가까운 결과를 얻었습니다. 그러나 대부분의 틈새 사용 사례에서는 도메인별 사전 학습이 미세 조정보다 훨씬 뛰어난 성능을 발휘한다는 점에 유의해야 합니다.출처] 결과적으로 기술을 촉진합니다. 이러한 제한은 즉각적인 설계 수준에서는 해결될 수 없으며 일반화된 LLM 개발에 상당한 진전이 필요합니다.

또 다른 근본적인 한계는 Generative LLM의 환각입니다. Generalist LLM은 종종 창의적인 글쓰기에 중점을 두기 때문에 환각에 빠지기 쉽습니다. 이것이 도메인별 LLM이 더 정확하고 분야별 벤치마크에서 더 나은 성능을 발휘하는 또 다른 이유입니다.

마지막으로 Chat GPT 및 GPT-4와 같은 일반화된 LLM을 사용하면 모델 인스턴스를 구축할 수 있는 미세 조정 또는 도메인별 모델보다 개인 정보 보호 위험이 더 높습니다. 이는 특히 독점 또는 민감한 사용자 데이터에 따른 사용 사례의 경우 우려되는 사항입니다.

결론

프롬프트 기술은 LLM과 실제 언어 기반 ML 작업 사이의 가교가 되었습니다. 사전에 레이블이 지정된 데이터가 필요하지 않은 제로샷은 이러한 모델이 새로운 문제를 일반화하고 적응할 수 있는 잠재력을 보여줍니다. 그러나 미세 조정에 비해 유사하거나 더 나은 성능을 얻지 못합니다. 수많은 사례와 벤치마크 성능 비교를 통해 퓨샷 프롬프트가 다양한 작업에 걸쳐 미세 조정에 대한 강력한 대안을 제공한다는 것을 알 수 있습니다. 프롬프트 내에 몇 가지 레이블이 지정된 예를 제시함으로써 이러한 기술을 통해 모델은 최소한의 레이블이 지정된 데이터로 새로운 클래스에 신속하게 적응할 수 있습니다. 또한 위 섹션에 나열된 성능 데이터는 Generative LLM을 통해 몇 번의 프롬프트를 사용하도록 기존 솔루션을 이동하는 것이 가치 있는 투자임을 시사합니다. 이 기사에 언급된 접근 방식으로 실험을 실행하면 프롬프트 기술을 사용하여 목표를 달성할 가능성이 높아집니다.

주요 요점

- 프롬프트 기술을 통해 실제 사용 가능: 프롬프트 기술은 생성 LLM과 실제 언어 기반 기계 학습 작업 사이의 강력한 다리입니다. 제로샷 프롬프트를 사용하면 모델이 레이블이 지정된 데이터 없이 일반화될 수 있으며, 퓨샷은 여러 예를 활용하여 빠르게 적응할 수 있습니다. 이러한 기술은 배포를 단순화하고 효과적인 활용을 위한 경로를 제공합니다.

- 퓨샷이 제로샷보다 더 나은 성능을 발휘합니다.: Few-shot은 레이블이 지정된 예시를 통해 LLM에 타겟 지침을 제공하여 더 나은 성능을 제공합니다. 이를 통해 모델은 최소한의 작업별 예를 활용하면서 사전 훈련된 지식을 활용하여 주어진 작업에 대해 보다 정확하고 관련성 있는 응답을 얻을 수 있습니다.

- Few-Shot Prompting은 미세 조정과 경쟁합니다.: Few-shot은 미세 조정에 대한 유망한 대안입니다. Few-shot은 프롬프트 내에 레이블이 지정된 예를 제공하여 분류, 언어 이해, 번역 및 질문 답변 작업 전반에 걸쳐 유사하거나 더 나은 성능을 달성합니다. 특히 레이블이 지정된 데이터가 부족한 시나리오에서 탁월한 성능을 발휘합니다.

- 제한 및 고려 사항: 생성적 LLM 및 프롬프트 기술에는 여러 가지 이점이 있지만, 영역별 사전 교육은 여전히 전문 작업을 위한 방법입니다. 또한 일반화된 LLM과 관련된 개인 정보 보호 위험은 민감한 데이터를 신중하게 처리해야 할 필요성을 강조합니다.

자주 묻는 질문

A: 생성적 LLM은 인간과 유사한 텍스트를 이해하고 생성하도록 설계된 GPT-3.5, GPT-4, BARD와 같은 고급 AI 시스템입니다. 이들은 창의적인 글쓰기, 질문 답변, 비판적 분석과 같은 AI 애플리케이션에 사용됩니다.

A: 제로샷에는 사전에 레이블이 지정된 데이터가 없는 새로운 작업에 LLM을 사용하는 것이 포함됩니다. Few-shot은 모델을 새로운 작업에 빠르게 적용하기 위해 프롬프트에 몇 가지 레이블이 지정된 예를 사용합니다. 이러한 기술은 실제 언어 기반 기계 학습 작업을 위한 LLM 배포를 단순화합니다.

A: 제로샷과 퓨샷은 강력한 기술이지만, 퓨샷은 라벨이 붙은 예시를 통해 LLM에 목표 지침을 제공함으로써 더 나은 성능을 제공합니다. 이를 통해 모델은 최소한의 작업별 예를 활용하면서 사전 훈련된 지식을 활용하여 주어진 작업에 대해 보다 정확하고 관련성 있는 응답을 얻을 수 있습니다.

A: Few-shot은 다양한 작업에서 미세 조정된 모델을 능가하거나 거의 일치하는 경우가 많아 성능이 크게 향상되었습니다. 몇 가지 라벨이 붙은 예시만 사용하면 퓨샷은 구현이 더 간단하면서도 비슷한 결과를 제공할 수 있습니다.

A: 강력하고 생성적인 LLM은 깊은 맥락 이해가 필요한 도메인별 작업에 도움이 필요할 수 있습니다. 또한, 특히 민감한 데이터의 경우 일반화된 LLM을 사용할 때 개인 정보 보호 문제가 발생하므로 신중한 처리가 필수적입니다.

참고자료

- Tom B. Brown 외, 언어 모델은 소수의 학습자입니다, 제34회 신경 정보 처리 시스템에 관한 국제 컨퍼런스(NIPS'20) 진행, 2020.

- https://www.kaggle.com/datasets/crowdflower/twitter-airline-sentiment

- https://www.kaggle.com/code/sdfsghdhdgresa/sentiment-analysis-using-bert-distillation

- https://github.com/Deepanjank/OpenAI/blob/main/open_ai_sentiment_few_shot.py

- https://www.analyticsvidhya.com/blog/2023/08/domain-specific-llms/

이 기사에 표시된 미디어는 Analytics Vidhya의 소유가 아니며 작성자의 재량에 따라 사용됩니다.

관련

- SEO 기반 콘텐츠 및 PR 배포. 오늘 증폭하십시오.

- PlatoData.Network 수직 생성 Ai. 자신에게 권한을 부여하십시오. 여기에서 액세스하십시오.

- PlatoAiStream. 웹3 인텔리전스. 지식 증폭. 여기에서 액세스하십시오.

- 플라톤ESG. 자동차 / EV, 탄소, 클린테크, 에너지, 환경, 태양광, 폐기물 관리. 여기에서 액세스하십시오.

- PlatoHealth. 생명 공학 및 임상 시험 인텔리전스. 여기에서 액세스하십시오.

- 차트프라임. ChartPrime으로 트레이딩 게임을 향상시키십시오. 여기에서 액세스하십시오.

- BlockOffsets. 환경 오프셋 소유권 현대화. 여기에서 액세스하십시오.

- 출처: https://www.analyticsvidhya.com/blog/2023/09/power-of-llms-zero-shot-and-few-shot-prompting/