著者による画像

Large Language Model (LLM) は、大量のテキスト データでトレーニングされる新しいタイプの人工知能です。彼らの主な能力は、幅広いプロンプトやリクエストに応じて人間のようなテキストを生成することです。

ChatGPT や Google Gemini などの人気のある LLM ソリューションをすでに使用した経験があると思います。

しかし、これらの強力なモデルがどのようにしてこれほど高速な応答を実現するのか疑問に思ったことはありますか?

答えはLLMOpsと呼ばれる専門分野にあります。

本題に入る前に、この分野の重要性を視覚化してみましょう。

あなたが友人と会話していると想像してください。質問するとすぐに答えが得られ、会話がスムーズに進むのが普通です。

右?

このスムーズな交換は、ユーザーが大規模言語モデル (LLM) を操作するときに期待するものでもあります。 ChatGPT でチャットし、プロンプトを送信するたびに数分間待たなければならないことを想像してみてください。誰もそれをまったく使用しないでしょう、少なくとも私はそうしないでしょう。

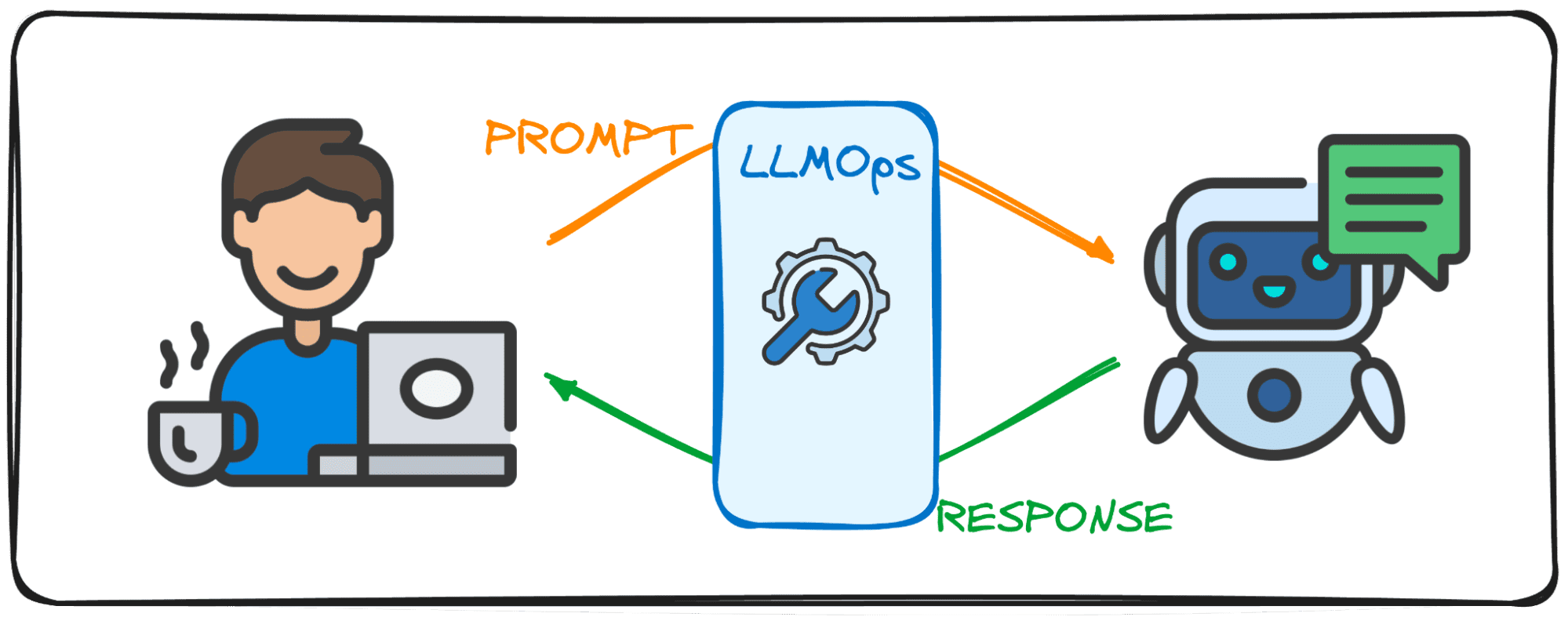

これが、LLM が LLMOps 分野を使用したデジタル ソリューションでこの会話フローと効果を実現することを目指している理由です。このガイドは、このまったく新しい分野での最初のステップのパートナーとなることを目的としています。

LLMOps (Large Language Model Operations) は、LLM が効率的かつ確実に機能することを保証する舞台裏の魔法です。これは、LLM によってもたらされる固有の課題に対処するために特別に設計された、よく知られた MLOps からの進歩を表しています。

MLOps は一般的な機械学習モデルのライフサイクルの管理に重点を置いていますが、LLMOps は特に LLM 固有の要件を扱います。

Web インターフェイスや API を介して OpenAI や Anthropic などのエンティティのモデルを使用する場合、LLMOps がバックグラウンドで動作し、これらのモデルがサービスとしてアクセスできるようになります。ただし、特殊なアプリケーション用のモデルをデプロイする場合、LLMOps の責任は私たちにあります。

したがって、討論の流れを管理するモデレーターのようなものだと考えてください。モデレーターが会話をスムーズに進行させ、議論のテーマに沿ったものにし、常に悪い言葉がないことを確認し、フェイクニュースを回避しようとするのと同じように、LLMOps は、LLM が最高のパフォーマンスで動作することを保証し、シームレスなユーザー エクスペリエンスを提供し、ユーザーの安全性をチェックします。出力。

大規模言語モデル (LLM) を使用してアプリケーションを作成すると、従来の機械学習とは異なる課題が生じます。これらを解決するために、革新的な管理ツールと方法論が考案され、LLMOps フレームワークが誕生しました。

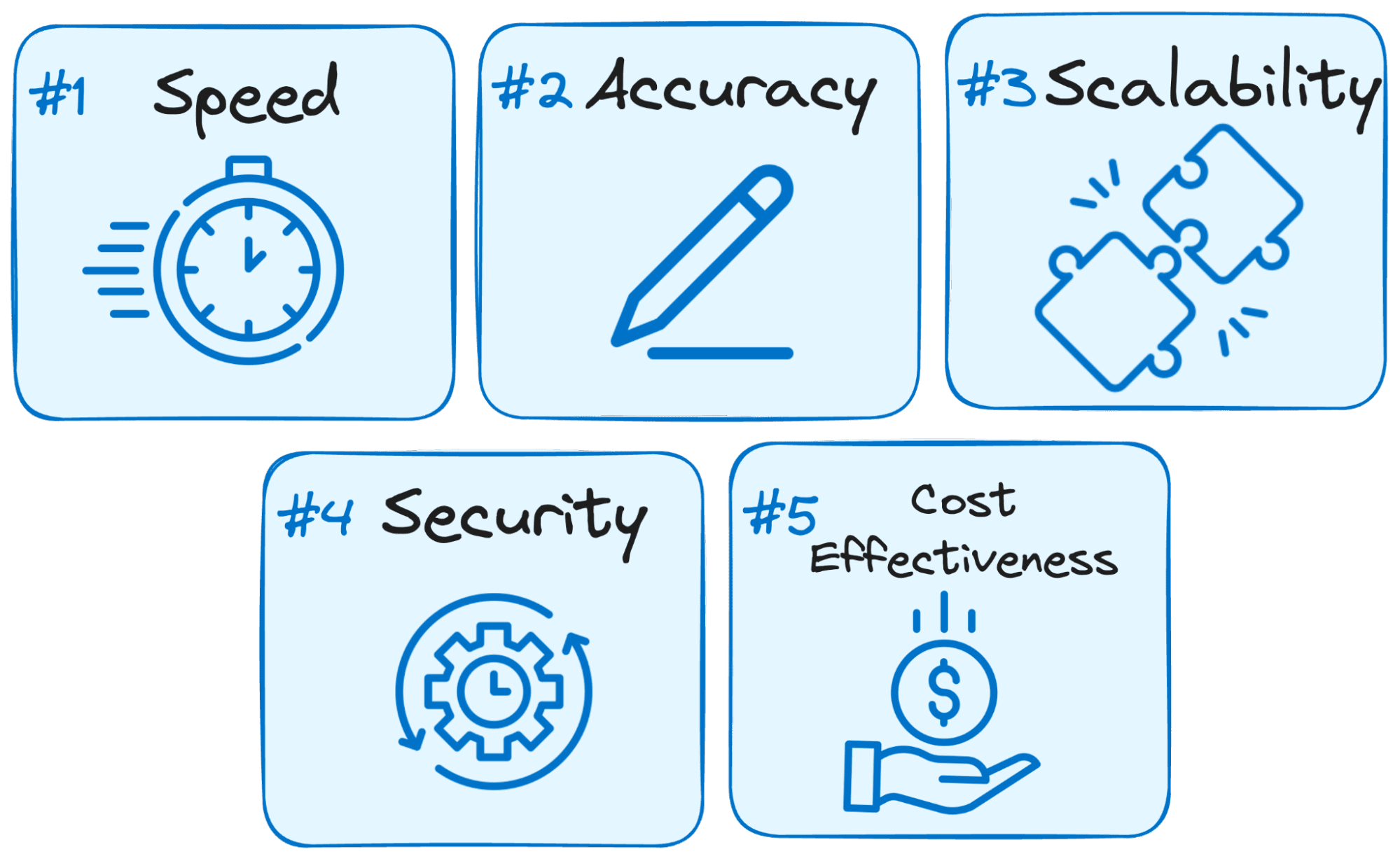

LLM を利用したアプリケーションの成功にとって LLMOps が重要である理由は次のとおりです。

著者による画像

- スピードが鍵: ユーザーは、LLM と対話するときに即時の応答を期待します。 LLMOps はプロセスを最適化して遅延を最小限に抑え、妥当な時間枠内で回答が得られるようにします。

- 精度が重要: LLMOps は、LLM の応答の精度と関連性を保証するために、さまざまなチェックと制御を実装します。

- 成長のためのスケーラビリティ: LLM アプリケーションが注目されるようになると、LLMOps は、増加するユーザー負荷に対処するためにリソースを効率的に拡張するのに役立ちます。

- セキュリティは最も重要です: LLMOps は、LLM システムの整合性を保護し、堅牢なセキュリティ対策を適用することで機密データを保護します。

- 費用対効果: LLM の運用は、大量のリソースを必要とするため、財務的に厳しい場合があります。 LLMOps は、リソース使用率を効率的に最大化するための経済的な方法を導入し、ピーク パフォーマンスが犠牲にならないようにします。

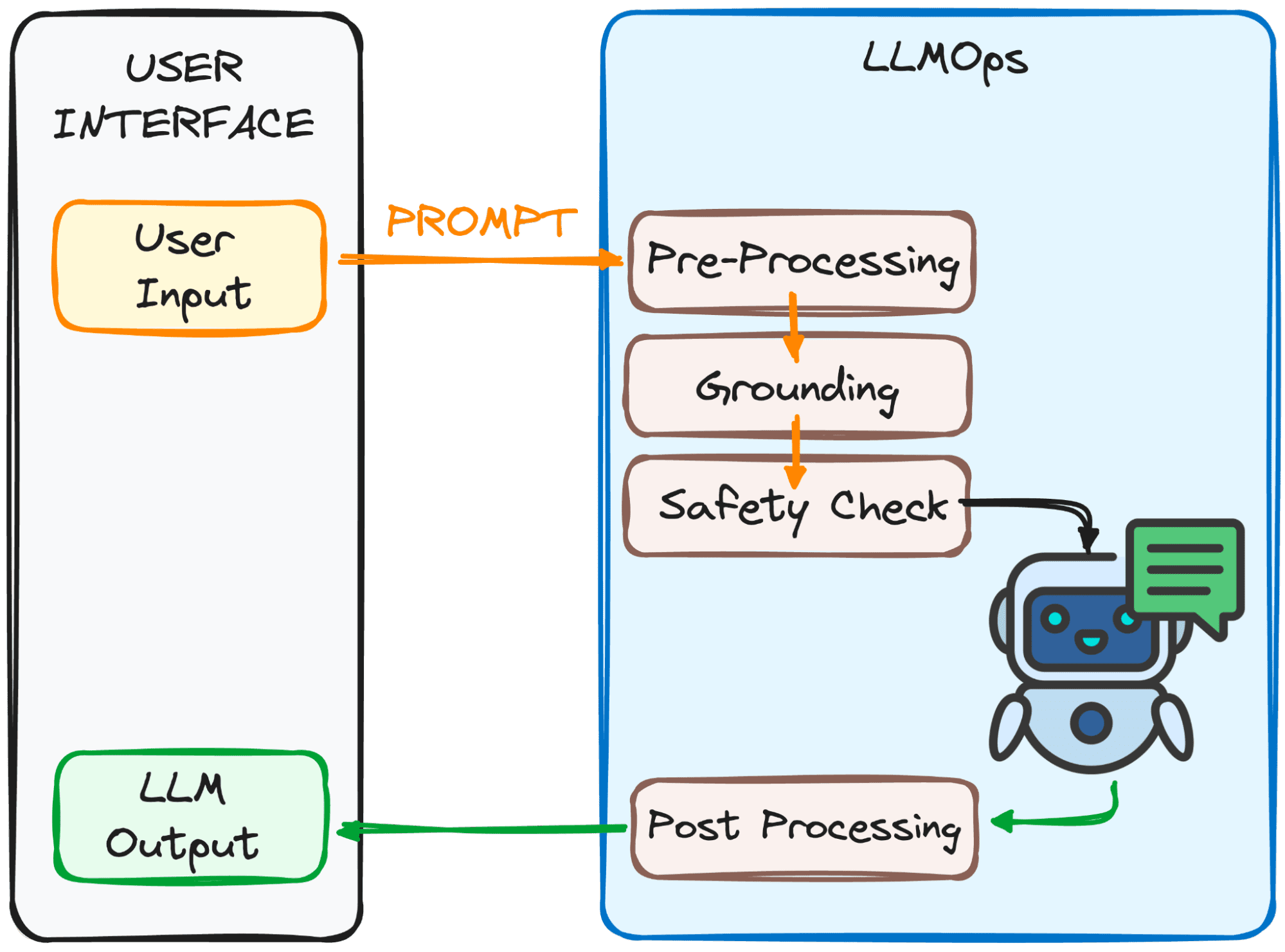

LLMOps は、プロンプトが LLM に対応できるようにし、その応答ができるだけ早く返されるようにします。しかし、これは決して簡単なことではありません。

このプロセスには、以下の図で確認できるいくつかのステップ (主に 4 つのステップ) が含まれます。

著者による画像

これらのステップの目標は何ですか?

プロンプトをモデルにとって明確で理解しやすいものにするため。

これらの手順の内訳は次のとおりです。

1.前処理

プロンプトは最初の処理ステップを通過します。まず、より小さな部分 (トークン) に分割されます。その後、タイプミスや奇妙な文字が削除され、テキストの書式が一貫して整います。

最後に、LLM が理解できるようにトークンが数値データに埋め込まれます。

2。 接地

モデルがプロンプトを処理する前に、モデルが全体像を理解していることを確認する必要があります。これには、LLM との過去の会話を参照したり、外部情報を使用したりすることが含まれる場合があります。

さらに、システムは、プロンプトで言及された重要なこと (名前や場所など) を識別し、応答をさらに関連性の高いものにします。

3. 安全性チェック:

安全ルールを設定するのと同じように、LLMOps はプロンプトが適切に使用されていることを確認します。システムは、機密情報や攻撃的な可能性のあるコンテンツなどをチェックします。

これらのチェックに合格した後にのみ、プロンプトはメインの動作である LLM の準備が整います。

これで、プロンプトを LLM で処理する準備が整いました。ただし、その出力も分析して処理する必要があります。したがって、それを確認する前に、4 番目のステップでさらにいくつかの調整が実行されます。

3. 後処理

プロンプトが変換されたコードを覚えていますか?応答は人間が読めるテキストに翻訳し直す必要があります。その後、システムは応答の文法、スタイル、明瞭さを磨きます。

これらすべての手順は、スムーズな LLM エクスペリエンスを保証する目に見えないスタッフ メンバーである LLMOps のおかげでシームレスに行われます。

印象的な、そう?

適切に設計された LLMOps セットアップの重要な構成要素の一部を以下に示します。

- 適切な LLM の選択: LLMOps は、膨大な数の LLM モデルを利用できるため、特定のニーズやリソースに最適なものを選択するのに役立ちます。

- 特異性の微調整: LLMOps を使用すると、既存のモデルを微調整したり、独自のモデルをトレーニングしたりして、独自のユースケースに合わせてカスタマイズできます。

- 迅速なエンジニアリング: LLMOps は、LLM を望ましい結果に導く効果的なプロンプトを作成するテクニックを提供します。

- 導入と監視: LLMOps は展開プロセスを合理化し、LLM のパフォーマンスを継続的に監視して、最適な機能を保証します。

- セキュリティ保護: LLMOps は、機密情報を保護するための堅牢な対策を実装することにより、データ セキュリティを優先します。

LLM テクノロジーが進化し続けるにつれて、LLMOps は今後の技術開発において重要な役割を果たすことになります。 ChatGPT や Google Gemini などの最新の人気ソリューションの成功のほとんどは、あらゆるリクエストに応えるだけでなく、優れたユーザー エクスペリエンスを提供できる能力にあります。

このため、LLMOps は、効率的で信頼性が高く安全な運用を保証することで、さまざまな業界でさらに多くの人々に提供される、さらに革新的で変革的な LLM アプリケーションへの道を切り開くことになります。

LLMOps をしっかり理解していれば、これらの LLM の能力を活用して画期的なアプリケーションを作成する準備が整います。

ジョセップ・フェレール バルセロナ出身の分析エンジニアです。彼は物理工学を卒業し、現在は人間のモビリティに適用されるデータ サイエンスの分野で働いています。彼は、データ サイエンスとテクノロジーに重点を置いたパートタイムのコンテンツ クリエイターです。 Josep は AI に関するあらゆることについて執筆しており、現場で爆発的に増加しているアプリケーションについてもカバーしています。

- SEO を活用したコンテンツと PR 配信。 今日増幅されます。

- PlatoData.Network 垂直生成 Ai。 自分自身に力を与えましょう。 こちらからアクセスしてください。

- プラトアイストリーム。 Web3 インテリジェンス。 知識増幅。 こちらからアクセスしてください。

- プラトンESG。 カーボン、 クリーンテック、 エネルギー、 環境、 太陽、 廃棄物管理。 こちらからアクセスしてください。

- プラトンヘルス。 バイオテクノロジーと臨床試験のインテリジェンス。 こちらからアクセスしてください。

- 情報源: https://www.kdnuggets.com/getting-started-with-llmops-the-secret-sauce-behind-seamless-interactions?utm_source=rss&utm_medium=rss&utm_campaign=getting-started-with-llmops-the-secret-sauce-behind-seamless-interactions