著者による画像

私たちの多くにとって、LLM の可能性を探ることは手の届かないものだと感じてきました。複雑なソフトウェアをダウンロードする場合でも、コーディングを理解する場合でも、強力なマシンが必要な場合でも、LLM を使い始めるのは困難に思えるかもしれません。しかし、想像してみてください。コンピューター上で他のプログラムを起動するのと同じくらい簡単に、これらの強力な言語モデルを操作できるとしたらどうでしょうか。インストールやコーディングは不要で、クリックして話すだけです。このアクセシビリティは、開発者とエンドユーザーの両方にとって重要です。 llamaFile は、 ラマ.cpp コスモポリタンLibc 単一のフレームワークにまとめられます。このフレームワークは、次の機能を提供することで LLM の複雑さを軽減します。 「llama ファイル」と呼ばれる 1 つのファイルの実行可能ファイル、インストールする必要がなく、ローカル マシン上で実行されます。

それで、それはどのように機能するのでしょうか?ラマファイルが提供するもの 便利な2つの方法 LLM を実行する場合:

- 最初の方法では、Lamafile の最新リリースを、Hugging Face から対応するモデル ウェイトとともにダウンロードします。これらのファイルを入手したら、準備完了です。

- 2 番目の方法はさらに簡単です。次のようにアクセスできます。 既存のサンプル llamafiles ウェイトが内蔵されているもの。

このチュートリアルでは、次の llamafile を操作します。 LLaVaモデル 7番目の方法を使用します。これは 4 ビットに量子化された 3.97 億パラメータ モデルで、チャットを通じて対話したり、画像をアップロードしたり、質問したりできます。他のモデルの llamafile サンプルも利用できますが、Windows の実行可能ファイルの最大サイズは 4 GB であるのに対し、llamafile サイズは XNUMX GB であるため、LLaVa モデルを使用して作業します。プロセスは非常に簡単で、以下に説明する手順に従って LLM を実行できます。

まず、提供されたソースから llava-v1.5-7b-q4.llamafile (3.97 GB) 実行可能ファイルをダウンロードする必要があります。 こちら.

コンピュータのターミナルを開き、ファイルが存在するディレクトリに移動します。次に、次のコマンドを実行して、コンピュータにこのファイルを実行する許可を与えます。

chmod +x llava-v1.5-7b-q4.llamafileWindows を使用している場合は、llamafile の名前の最後に「.exe」を追加します。この目的のために、ターミナルで次のコマンドを実行できます。

rename llava-v1.5-7b-q4.llamafile llava-v1.5-7b-q4.llamafile.exe以下のコマンドでllamaファイルを実行します。

./llava-v1.5-7b-q4.llamafile -ngl 9999

⚠️ MacOS はデフォルトのシェルとして zsh を使用するため、 zsh: exec format error: ./llava-v1.5-7b-q4.llamafile エラーが発生した場合は、これを実行する必要があります。

bash -c ./llava-v1.5-7b-q4.llamafile -ngl 9999

Windows の場合、コマンドは次のようになります。

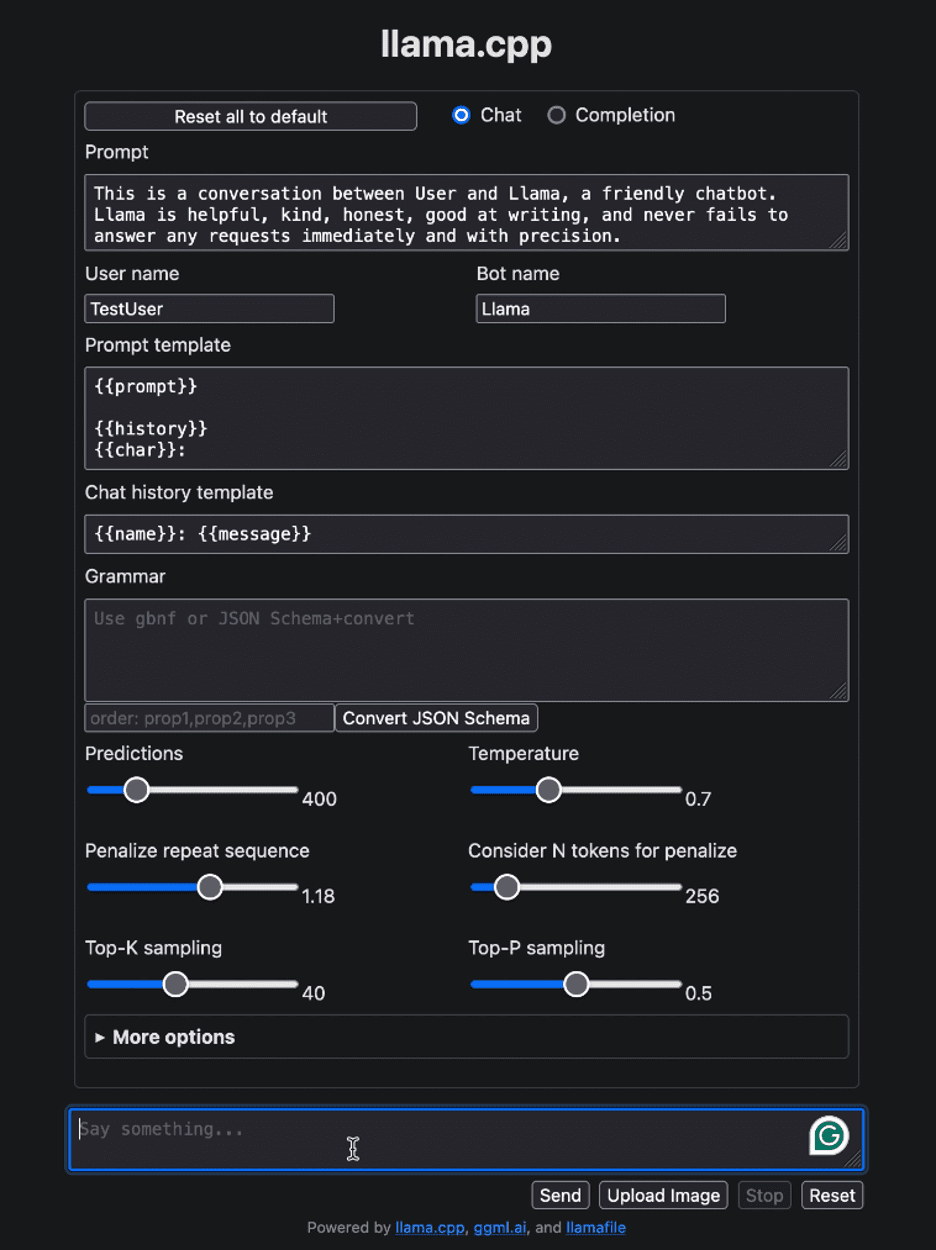

llava-v1.5-7b-q4.llamafile.exe -ngl 9999llamafile を実行すると、デフォルトのブラウザが自動的に開き、以下に示すようなユーザー インターフェイスが表示されます。そうでない場合は、ブラウザを開いて次の場所に移動します。 http://localhost:8080 手動で

著者による画像

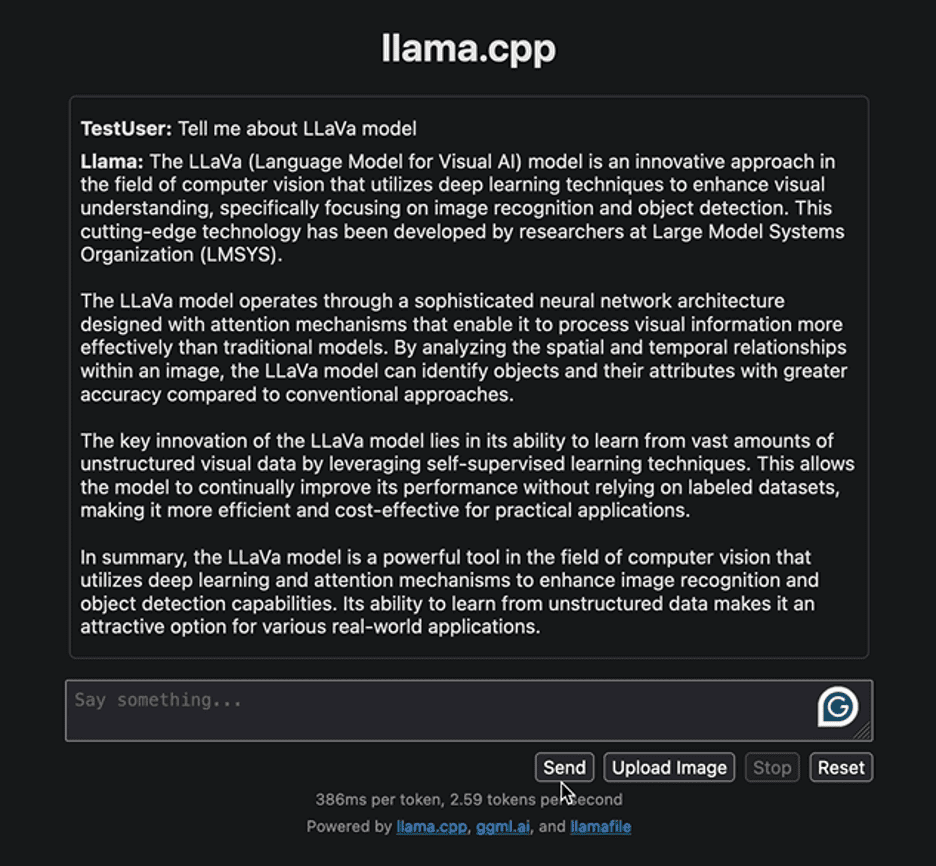

まず、LLaVa モデルに関連する情報を提供するための簡単な質問でインターフェイスを操作してみましょう。以下はモデルによって生成された応答です。

著者による画像

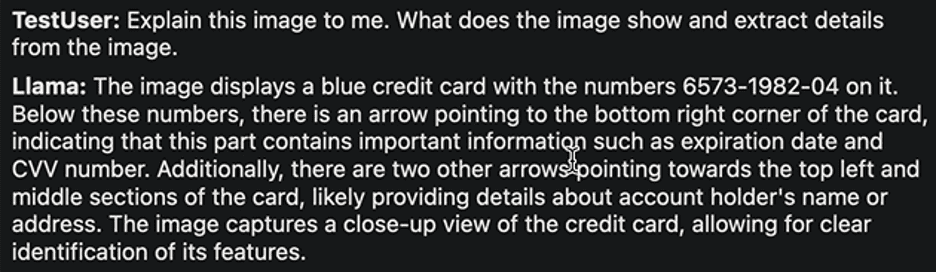

この回答では、LLaVa モデルとそのアプリケーションの開発アプローチが強調されています。生成された応答はかなり高速でした。別のタスクを実装してみましょう。詳細が記載された銀行カードの次のサンプル画像をアップロードし、そこから必要な情報を抽出します。

による画像 ルビー・トンプソン

応答は次のとおりです。

著者による画像

繰り返しますが、反応はかなり合理的です。 LLaVa の作成者は、LLaVa がさまざまなタスクにわたって最高レベルのパフォーマンスを達成すると主張しています。さまざまなタスクを自由に検討し、その成功と限界を観察し、LLaVa の優れたパフォーマンスをご自身で体験してください。

LLM との対話が完了したら、ターミナルに戻って「Control + C」を押して、llama ファイルをシャットダウンできます。

LLM の配布と実行は、かつてないほど簡単になりました。このチュートリアルでは、単一の実行可能 llama ファイルを使用して、さまざまなモデルをいかに簡単に実行して実験できるかを説明しました。これにより、時間とリソースが節約されるだけでなく、LLM のアクセシビリティと実際の実用性も拡張されます。このチュートリアルがお役に立てば幸いです。ぜひご意見をお聞かせください。また、ご質問やご意見がございましたら、お気軽にお問い合わせください。私たちは常に喜んでお手伝いし、皆様のご意見を大切にさせていただきます。

読んでくれてありがとう!

カンワル・メーリーン Kanwal は機械学習エンジニアであり、データ サイエンスと AI と医療の交差点に深い情熱を持っているテクニカル ライターです。彼女は電子書籍「ChatGPT による生産性の最大化」を共著しました。彼女は 2022 年 APAC の Google Generation Scholar として、多様性と学術的卓越性を擁護しています。彼女は、Teradata Diversity in Tech Scholar、Mitacs Globalink Research Scholar、および Harvard WeCode Scholar としても認められています。 Kanwal は変化を熱心に提唱しており、STEM 分野で女性に力を与えるために FEMCodes を設立しました。

- SEO を活用したコンテンツと PR 配信。 今日増幅されます。

- PlatoData.Network 垂直生成 Ai。 自分自身に力を与えましょう。 こちらからアクセスしてください。

- プラトアイストリーム。 Web3 インテリジェンス。 知識増幅。 こちらからアクセスしてください。

- プラトンESG。 カーボン、 クリーンテック、 エネルギー、 環境、 太陽、 廃棄物管理。 こちらからアクセスしてください。

- プラトンヘルス。 バイオテクノロジーと臨床試験のインテリジェンス。 こちらからアクセスしてください。

- 情報源: https://www.kdnuggets.com/distribute-and-run-llms-with-llamafile-in-5-simple-steps?utm_source=rss&utm_medium=rss&utm_campaign=distribute-and-run-llms-with-llamafile-in-5-simple-steps