Einleitung

In den letzten Jahren erlebte der Bereich der künstlichen Intelligenz (KI) einen bemerkenswerten Entwicklungsschub generativer KI-Modelle. Diese Modelle können Generieren Sie menschenähnlichen Text, Bilder und sogar Audio, die die Grenzen dessen überschreiten, was einst für unmöglich gehalten wurde. Unter diesen Modellen sticht der Generative Pre-trained Transformer (GPT) als bahnbrechender Durchbruch in der Verarbeitung natürlicher Sprache (NLP) hervor. Lassen Sie uns die komplexe Architektur von GPTs erkunden und herausfinden, wie sie generative KI- und NLP-Aufgaben problemlos bewältigen.

Inhaltsverzeichnis

Der Aufstieg generativer KI-Modelle

Generative KI-Modelle sind eine Klasse von Maschinelles Lernen Modelle, die von Grund auf neue Daten wie Text, Bilder oder Audio erstellen können. Diese Modelle werden auf riesigen Mengen vorhandener Daten trainiert und können so die zugrunde liegenden Muster und Strukturen erlernen. Nach dem Training können sie neue, originelle Inhalte generieren, die die Eigenschaften der Trainingsdaten nachahmen.

Der Aufstieg generativer KI-Modelle wurde durch Fortschritte bei Deep-Learning-Techniken, insbesondere bei neuronalen Netzen, vorangetrieben. Tiefes Lernen Algorithmen haben sich bei der Erfassung komplexer Muster in Daten als äußerst effektiv erwiesen und eignen sich daher gut für generative Aufgaben. Da die Rechenleistung und der Zugriff auf große Datensätze zugenommen haben, konnten Forscher immer ausgefeiltere generative Modelle trainieren.

Die Geheimnisse von GPT

GPT-Modelle sind eine Art großes Sprachmodell (LLM), das die Leistungsfähigkeit von nutzt Neuronale Netze menschenähnlichen Text verstehen und erzeugen. Diese Modelle sind „generativ“, weil sie auf der Grundlage der aus riesigen Datensätzen gelernten Muster neuen, kohärenten Text erzeugen können. Sie sind „vortrainiert“, da sie eine erste Trainingsphase mit riesigen Textdatenmengen durchlaufen. Dadurch können sie sich eine breite Wissensbasis aneignen, bevor sie auf spezifische Aufgaben zugeschnitten werden.

Die „Transformer“-Architektur ist die Kerninnovation, die GPT-Modelle auf ein beispielloses Leistungsniveau gebracht hat. Transformatoren sind eine Art neuronales Netzwerk, das darauf ausgelegt ist, sequentielle Daten wie Text effektiver zu verarbeiten als herkömmliche Modelle. Sie nutzen einen neuartigen Aufmerksamkeitsmechanismus, der es dem Modell ermöglicht, die Wichtigkeit verschiedener Teile des Inputs bei der Generierung des Outputs abzuwägen. Dies ermöglicht es, weitreichende Abhängigkeiten zu erfassen und kohärenteren und kontextbezogeneren Text zu erstellen.

Analyse der GPT-Architektur

Die GPT-Architektur ist eine leistungsstarke Kombination aus drei Schlüsselkomponenten: ihren generativen Fähigkeiten, dem Pre-Training-Ansatz und dem transformatorischen neuronalen Netzwerk. Jede dieser Säulen spielt eine entscheidende Rolle dabei, dass GPT-Modelle ihre bemerkenswerte Leistung bei NLP-Aufgaben erreichen können.

Die drei Säulen: generativ, vorab trainiert und transformatorisch

Der „generative“ Aspekt von GPT-Modellen bezieht sich auf ihre Fähigkeit, neuen, kohärenten Text basierend auf den Mustern zu generieren, die sie aus riesigen Mengen an Trainingsdaten gelernt haben. Traditionelle Sprachmodelle konzentrieren sich hauptsächlich auf das Verstehen und Analysieren von Text. Im Gegensatz zu ihnen sind GPT-Modelle darauf ausgelegt, eine menschenähnliche Textausgabe zu erzeugen, was sie für eine Vielzahl von Anwendungen äußerst vielseitig macht.

Die „vorab trainierte“ Komponente von GPT-Modellen umfasst eine anfängliche Trainingsphase, in der das Modell einem riesigen Textdatenkorpus ausgesetzt wird. Während dieser Vortrainingsphase lernt das Modell, die zugrunde liegenden Muster, Strukturen und Beziehungen innerhalb der Daten zu erfassen. Dies hilft dabei, effektiv eine breite Wissensbasis aufzubauen. Die Vortrainingsphase ist von entscheidender Bedeutung, da sie es dem Modell ermöglicht, sich vor der Feinabstimmung ein allgemeines Verständnis der Sprache anzueignen.

Die „Transformer“-Architektur ist das neuronale Netzwerk-Rückgrat von GPT-Modellen. Transformer sind Deep-Learning-Modelle, die speziell dafür entwickelt wurden, sequentielle Daten wie Text effektiver zu verarbeiten als herkömmliche Modelle. Sie nutzen einen neuartigen Aufmerksamkeitsmechanismus, der es dem Modell ermöglicht, die Wichtigkeit verschiedener Teile des Inputs bei der Generierung des Outputs abzuwägen. Dies ermöglicht es, weitreichende Abhängigkeiten zu erfassen und kohärenteren und kontextbezogeneren Text zu erstellen.

Wie GPTs kohärente Sätze produzieren

GPT-Modelle generieren Text, indem sie das nächste Wort oder Token in einer Sequenz basierend auf dem Kontext vorhersagen, der durch die vorhergehenden Wörter oder Token bereitgestellt wird. Dieser Prozess wird durch eine Reihe von Berechnungen innerhalb der Transformatorarchitektur erreicht. Es beginnt mit der Tokenisierung des Eingabetextes und seiner Umwandlung in numerische Darstellungen (Einbettungen). Diese Einbettungen durchlaufen dann mehrere Schichten des Transformators. Hier ermöglicht der Aufmerksamkeitsmechanismus dem Modell, die Beziehungen zwischen verschiedenen Teilen der Eingabe zu erfassen und kontextrelevante Ausgaben zu generieren.

Die Ausgabe des Modells ist a Wahrscheinlichkeitsverteilung über den gesamten Wortschatz und gibt die Wahrscheinlichkeit an, dass jedes Wort oder jeder Token das nächste in der Sequenz ist. Während der Inferenz entnimmt das Modell Stichproben aus dieser Verteilung, um das nächste Token zu generieren, das an die Eingabesequenz angehängt wird. Dieser Vorgang wiederholt sich, bis die gewünschte Ausgabelänge erreicht ist oder eine Stoppbedingung erfüllt ist.

Nutzung riesiger Datensätze für eine bessere Leistung

Einer der Hauptvorteile von GPT-Modellen ist ihre Fähigkeit, umfangreiche Datensätze während der Vortrainingsphase zu nutzen. Diese Datensätze können aus Milliarden von Wörtern aus verschiedenen Quellen wie Büchern, Artikeln, Websites und sozialen Medien bestehen. Dadurch erhält das Modell einen vielfältigen und umfassenden Einblick in die natürliche Sprache.

Während des Vortrainings muss das Modell das nächste Wort oder Token in der Sequenz vorhersagen, ähnlich wie beim Textgenerierungsprozess. Anstatt jedoch neuen Text zu generieren, lernt das Modell, die zugrunde liegenden Muster und Beziehungen innerhalb der Trainingsdaten zu erfassen. Diese Vortrainingsphase ist rechenintensiv, aber entscheidend. Dadurch kann das Modell ein umfassendes Sprachverständnis entwickeln, das dann für bestimmte Aufgaben feinabgestimmt werden kann.

Durch die Nutzung umfangreicher Datensätze während des Vortrainings können GPT-Modelle eine umfangreiche Wissensbasis erwerben. Sie können auch ein tiefes Verständnis für Sprachstrukturen, idiomatische Ausdrücke und kontextuelle Nuancen entwickeln. Dieses umfangreiche Vortraining bietet eine solide Grundlage für das Modell. Dadurch kann das Modell bei einer Vielzahl nachgelagerter Aufgaben mit relativ wenig aufgabenspezifischer Feinabstimmung eine gute Leistung erbringen.

Das neuronale Netzwerk hinter der Magie

Die Transformer-Architektur ist die Kerninnovation, die GPT-Modellen zugrunde liegt und den Bereich NLP revolutioniert hat. Anders als traditionell wiederkehrende neuronale Netze (RNNs), die sequentielle Daten sequentiell verarbeiten, verwenden Transformatoren einen neuartigen Aufmerksamkeitsmechanismus, der es ihnen ermöglicht, Abhängigkeiten über große Entfernungen zu erfassen und Eingabesequenzen effizient parallel zu verarbeiten.

Die Transformatorarchitektur besteht aus mehreren Schichten, die jeweils aus zwei Hauptkomponenten bestehen: dem Multi-Head-Aufmerksamkeitsmechanismus und dem Feed-Forward-Neuronalen Netzwerk. Der Aufmerksamkeitsmechanismus ist dafür verantwortlich, die Wichtigkeit verschiedener Teile der Eingabesequenz bei der Generierung der Ausgabe zu gewichten, sodass das Modell den Kontext und die Beziehungen zwischen entfernten Elementen in der Sequenz erfassen kann.

Die Feed-Forward-Schichten des neuronalen Netzwerks sind für die weitere Verarbeitung und Verfeinerung der Ausgabe des Aufmerksamkeitsmechanismus verantwortlich, sodass das Modell komplexere Darstellungen der Eingabedaten lernen kann.

Der parallelisierte Verarbeitungs- und Aufmerksamkeitsmechanismus der Transformer-Architektur hat sich als äußerst effektiv bei der Verarbeitung langer Sequenzen und der Erfassung weitreichender Abhängigkeiten erwiesen, die für NLP-Aufgaben von entscheidender Bedeutung sind. Diese Architektur hat es GPT-Modellen ermöglicht, eine Leistung auf dem neuesten Stand der Technik zu erreichen. Es hat auch die Entwicklung anderer transformatorbasierter Modelle in verschiedenen Bereichen beeinflusst, beispielsweise Computer Vision und Spracherkennung.

Im Inneren des Transformators

Die Transformer-Architektur ist die Kernkomponente, die es GPT-Modellen ermöglicht, ihre bemerkenswerte Leistung bei NLP-Aufgaben zu erreichen. Schauen wir uns die wichtigsten Schritte bei der Verarbeitung von Textdaten durch den Transformator genauer an.

Tokenisierung: Text in verdauliche Teile zerlegen

Bevor der Transformator Text verarbeiten kann, müssen die Eingabedaten in kleinere Einheiten, sogenannte Token, zerlegt werden. Tokenisierung ist der Prozess der Aufteilung des Textes in diese Token, bei denen es sich um Wörter, Unterwörter oder sogar einzelne Zeichen handeln kann. Dieser Schritt ist von entscheidender Bedeutung, da er es dem Transformator ermöglicht, Sequenzen unterschiedlicher Länge zu verarbeiten und seltene oder nicht im Vokabular vorkommende Wörter effektiv darzustellen. Der Tokenisierungsprozess umfasst typischerweise Techniken wie Wortsegmentierung, Umgang mit Satzzeichen und Umgang mit Sonderzeichen.

Worteinbettungen: Wörter numerischen Vektoren zuordnen

Sobald der Text tokenisiert wurde, wird jedes Token einer numerischen Vektordarstellung zugeordnet, die als Worteinbettung bezeichnet wird. Diese Worteinbettungen sind dichte Vektoren, die semantische und syntaktische Informationen über die Wörter erfassen, die sie darstellen. Der Transformator verwendet diese Einbettungen als Eingabe und ermöglicht so die Verarbeitung von Textdaten in einem numerischen Format, das von seiner neuronalen Netzwerkarchitektur effizient manipuliert werden kann. Worteinbettungen werden während des Trainingsprozesses erlernt, wobei Wörter mit ähnlicher Bedeutung tendenziell ähnliche Vektordarstellungen haben, wodurch das Modell semantische Beziehungen und Kontext erfassen kann.

Der Aufmerksamkeitsmechanismus: Das Herz des Transformators

Der Aufmerksamkeitsmechanismus ist die Schlüsselinnovation, die Transformatoren von herkömmlichen neuronalen Netzwerkarchitekturen unterscheidet. Dadurch kann sich das Modell bei der Ausgabegenerierung selektiv auf relevante Teile der Eingabesequenz konzentrieren und so weitreichende Abhängigkeiten und Kontexte effektiv erfassen. Der Aufmerksamkeitsmechanismus funktioniert durch die Berechnung von Aufmerksamkeitswerten, die die Wichtigkeit jedes Eingabeelements für ein bestimmtes Ausgabeelement darstellen, und verwendet diese Werte dann, um die entsprechenden Eingabedarstellungen zu gewichten. Dieser Mechanismus ermöglicht es dem Transformator, Sequenzen unterschiedlicher Länge effektiv zu verarbeiten und Beziehungen zwischen entfernten Elementen in der Eingabe zu erfassen, was für Aufgaben wie maschinelle Übersetzung und Sprachgenerierung von entscheidender Bedeutung ist.

Mehrschichtige Perzeptrone: Verbesserung der Vektordarstellung

Zusätzlich zum Aufmerksamkeitsmechanismus sind auch Transformatoren integriert mehrschichtige Perzeptronen (MLPs), bei denen es sich um Feed-Forward-Neuronale Netze handelt. Diese MLPs werden verwendet, um die vom Aufmerksamkeitsmechanismus erzeugten Vektordarstellungen weiter zu verarbeiten und zu verfeinern, sodass das Modell komplexere Muster und Beziehungen in den Daten erfassen kann. Die MLPs nehmen die Ausgabe des Aufmerksamkeitsmechanismus als Eingabe und wenden eine Reihe linearer Transformationen und nichtlinearer Aktivierungsfunktionen an, um die Vektordarstellungen zu verbessern. Dieser Schritt ist entscheidend, damit das Modell übergeordnete Funktionen und Darstellungen lernt, die für die nachgelagerte Aufgabe hilfreich sind.

Trainieren eines GPT-Modells

Das Training eines GPT-Modells ist ein komplexer und rechenintensiver Prozess, der mehrere Schlüsselkomponenten und Techniken umfasst.

Backpropagation: Der Algorithmus, der GPTs intelligenter macht

Das Herzstück des Trainings von GPT-Modellen ist der Backpropagation-Algorithmus, eine im Deep Learning weit verbreitete Technik zur Aktualisierung der Gewichte und Parameter des Modells basierend auf den Fehlern, die es während des Trainings macht. Während Backpropagation, werden die Vorhersagen des Modells mit den Ground-Truth-Labels verglichen und die Fehler werden rückwärts durch das Netzwerk weitergegeben, um die Gewichte anzupassen und den Gesamtfehler zu minimieren. Dieser Prozess umfasst die Berechnung der Gradienten der Verlustfunktion in Bezug auf die Parameter des Modells und die Aktualisierung der Parameter in die Richtung, die den Verlust minimiert. Backpropagation ist ein wesentlicher Bestandteil des Trainingsprozesses, da sie es dem Modell ermöglicht, aus seinen Fehlern zu lernen und seine Leistung schrittweise zu verbessern.

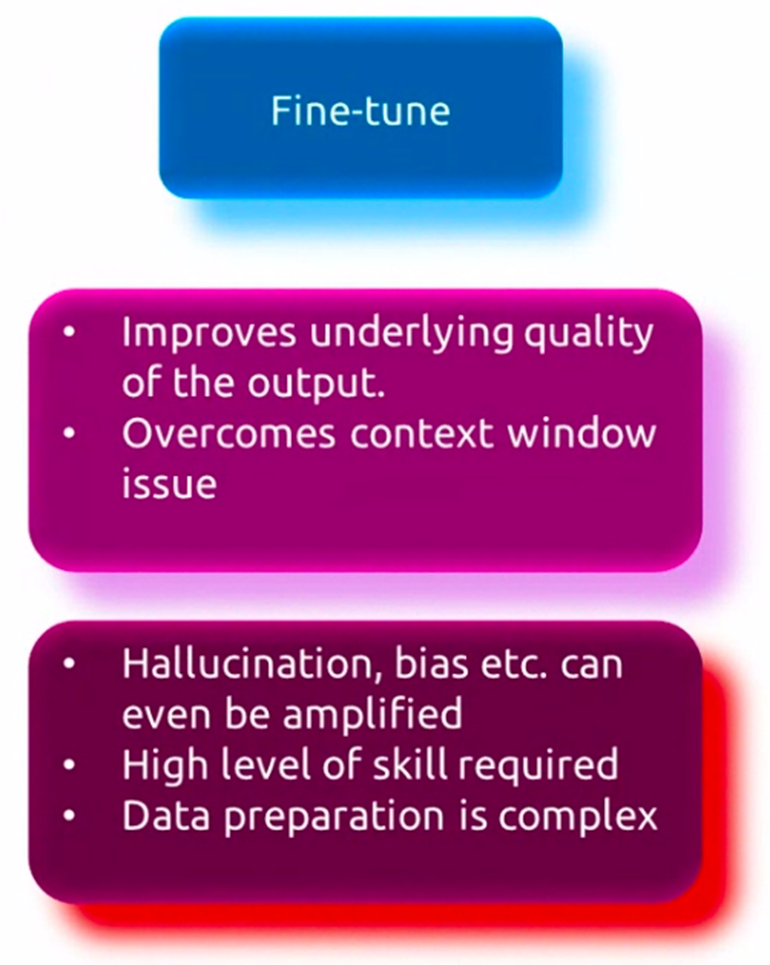

Betreutes Feintuning

Während GPT-Modelle anhand umfangreicher Datensätze vorab trainiert werden, um ein umfassendes Verständnis der Sprache zu erlangen, müssen sie häufig anhand aufgabenspezifischer Daten verfeinert werden, um bei bestimmten Anwendungen eine gute Leistung zu erbringen. Dieser Prozess, der als überwachte Feinabstimmung bezeichnet wird, umfasst das weitere Training des vorab trainierten Modells anhand eines kleineren Datensatzes, der für die Zielaufgabe relevant ist, z. B. Beantwortung von Fragen, Textzusammenfassung oder maschinelle Übersetzung. Während Feintuning, werden die Gewichte des Modells angepasst, um die für die jeweilige Aufgabe spezifischen Muster und Nuancen besser zu erfassen und gleichzeitig die allgemeinen Sprachkenntnisse, die während des Vortrainings erworben wurden, beizubehalten. Durch diesen Feinabstimmungsprozess kann sich das Modell spezialisieren und an die spezifischen Anforderungen der Zielaufgabe anpassen, was zu einer verbesserten Leistung führt.

Unbeaufsichtigtes Vortraining

Vor der Feinabstimmung durchlaufen GPT-Modelle zunächst eine unbeaufsichtigte Vortrainingsphase, in der sie riesigen Textdatenmengen aus verschiedenen Quellen wie Büchern, Artikeln und Websites ausgesetzt werden. In dieser Phase lernt das Modell, die zugrunde liegenden Muster und Beziehungen in den Daten zu erfassen, indem es das nächste Wort oder Token in einer Sequenz vorhersagt. Dieser Prozess wird als Sprachmodellierung bezeichnet. Dieses unbeaufsichtigte Vortraining ermöglicht es dem Modell, ein umfassendes Verständnis der Sprache zu entwickeln, einschließlich Syntax, Semantik und Kontext. Das Modell wird auf einem riesigen Korpus von Textdaten trainiert und kann so aus einer Vielzahl von Themen, Stilen und Bereichen lernen. Diese unbeaufsichtigte Vortrainingsphase ist rechenintensiv, aber entscheidend, da sie dem Modell eine solide Grundlage für die anschließende Feinabstimmung bestimmter Aufgaben bietet.

GPT-Anwendungen und Anwendungsfälle

GPT-Modelle haben eine bemerkenswerte Vielseitigkeit gezeigt und wurden auf eine Vielzahl von NLP-Aufgaben und -Anwendungen angewendet. Lassen Sie uns einige der wichtigsten Anwendungsfälle dieser leistungsstarken Sprachmodelle untersuchen.

Sprachbarrieren überwinden

Eine der frühesten und bekanntesten Anwendungen von GPT-Modellen liegt im Bereich der maschinellen Übersetzung. Durch die Nutzung ihrer Fähigkeit, menschenähnlichen Text zu verstehen und zu generieren, können GPT-Modelle darauf trainiert werden, mit hoher Genauigkeit und fließend zwischen verschiedenen Sprachen zu übersetzen. Diese Modelle können die Nuancen und Komplexitäten der Sprache erfassen und so Übersetzungen erstellen, die nicht nur korrekt sind, sondern auch die beabsichtigte Bedeutung und den Kontext des Originaltexts beibehalten.

Textzusammenfassung

Angesichts der ständig wachsenden Menge an verfügbaren Textdaten besteht die Möglichkeit dazu zusammenfassen Die Umwandlung langer Dokumente oder Artikel in prägnante und aussagekräftige Zusammenfassungen ist immer wichtiger geworden. GPT-Modelle haben sich bei dieser Aufgabe als effektiv erwiesen, da sie den Kontext und die Kernpunkte eines bestimmten Textes analysieren und verstehen und dann eine komprimierte Zusammenfassung erstellen können, die das Wesentliche des Originalinhalts erfasst. Diese Anwendung verfügt über zahlreiche Anwendungsfälle, die von der Zusammenfassung von Nachrichtenartikeln und Forschungsarbeiten bis hin zur Erstellung prägnanter Berichte und Zusammenfassungen reichen.

Chatbots und Konversations-KI

Eine der sichtbarsten und am weitesten verbreiteten Anwendungen von GPT-Modellen ist die Entwicklung von Chatbots und Konversations-KI Systeme. Diese Modelle können einen menschenähnlichen Dialog führen und Benutzeranfragen und -eingaben auf natürliche und kontextbezogene Weise verstehen und darauf reagieren. GPT-gestützte Chatbots werden in verschiedenen Branchen wie Kundenservice, E-Commerce und Gesundheitswesen eingesetzt, um Benutzern personalisierte und effiziente Unterstützung zu bieten.

Das fantasievolle Potenzial von GPTs

Während GPT-Modelle ursprünglich für Sprachverständnis- und Generierungsaufgaben konzipiert waren, hat ihre Fähigkeit, kohärente und fantasievolle Texte zu produzieren, neue Möglichkeiten im Bereich des kreativen Schreibens eröffnet. Diese Modelle können fein abgestimmt werden, um Geschichten, Gedichte, Skripte und sogar Liedtexte zu generieren, und bieten Schriftstellern und Künstlern ein leistungsstarkes Werkzeug, um neue kreative Wege zu erkunden. Darüber hinaus können GPT-Modelle den Schreibprozess unterstützen, indem sie Handlungsentwicklungen und Charakterbeschreibungen vorschlagen und sogar ganze Passagen auf der Grundlage von Eingabeaufforderungen oder Skizzen generieren.

Die Zukunft von GPTs und generativer KI

So vielversprechend GPT-Modelle auch waren, es gibt immer noch Einschränkungen und Herausforderungen, die es zu überwinden gilt, sowie ethische Überlegungen, die berücksichtigt werden müssen. Darüber hinaus entwickelt sich der Bereich der generativen KI rasant weiter, wobei neue Trends und Spitzenforschung die Zukunft dieser Modelle prägen.

Einschränkungen und Herausforderungen aktueller GPT-Modelle

Trotz ihrer beeindruckenden Fähigkeiten weisen aktuelle GPT-Modelle gewisse Einschränkungen auf. Eine der größten Herausforderungen ist ihre Unfähigkeit, die zugrunde liegende Bedeutung und den Kontext des von ihnen erstellten Textes wirklich zu verstehen. Obwohl sie kohärente und flüssige Texte verfassen können, können sie manchmal unsinnige oder sachlich falsche Informationen generieren, insbesondere wenn es um komplexe oder spezielle Themen geht. Darüber hinaus können diese Modelle in ihren Trainingsdaten Verzerrungen aufweisen, die Bedenken hinsichtlich der Fairness und potenziell schädlicher Ergebnisse aufkommen lassen.

Ethische Überlegungen und verantwortungsvolle KI-Entwicklung

Da GPT-Modelle immer leistungsfähiger und verbreiteter werden, ist es von entscheidender Bedeutung, ethische Überlegungen zu berücksichtigen und eine verantwortungsvolle Entwicklung und Bereitstellung dieser Technologien sicherzustellen. Themen wie Datenschutz, Sicherheit und das Potenzial für Missbrauch oder bösartige Anwendungen müssen sorgfältig geprüft werden. Forscher und Entwickler müssen auf die Entwicklung ethischer Richtlinien, Governance-Rahmenwerke und robuster Schutzmaßnahmen hinarbeiten, um potenzielle Risiken zu mindern und die sichere und vorteilhafte Nutzung von GPT-Modellen zu gewährleisten.

Neue Trends und Spitzenforschung

Der Bereich der generativen KI entwickelt sich rasant weiter und Forscher erforschen neue Architekturen, Trainingsmethoden und Anwendungen. Einer der aufkommenden Trends ist Multimodale Modelle das Daten über verschiedene Modalitäten hinweg (Text, Bilder, Audio usw.) verarbeiten und generieren kann. Eine weitere Möglichkeit sind Reinforcement-Learning-Ansätze zur Sprachgenerierung. Die Integration von GPT-Modellen mit anderen KI-Technologien, wie z Computer Vision und Robotik ist ein weiterer Trend. Darüber hinaus wird an der Verbesserung der Interpretierbarkeit, Steuerbarkeit und Robustheit dieser Modelle geforscht. Forscher erforschen ihr Potenzial auch in Bereichen wie wissenschaftliche Entdeckung, Bildung und Gesundheitswesen.

Zusammenfassung

GPT-Modelle haben den Bereich NLP revolutioniert. Sie haben bemerkenswerte Fähigkeiten bei Aufgaben wie Sprachübersetzung, Textzusammenfassung, Konversations-KI und kreativem Schreiben unter Beweis gestellt. Das Herzstück dieser Modelle ist die Transformatorarchitektur. Dabei wird ein neuartiger Aufmerksamkeitsmechanismus eingesetzt, um weitreichende Abhängigkeiten und Kontexte in Textdaten zu erfassen. Das Training von GPT-Modellen erfordert einen komplexen Prozess des unbeaufsichtigten Vortrainings auf riesigen Datensätzen, gefolgt von einer überwachten Feinabstimmung für bestimmte Aufgaben.

Obwohl GPT-Modelle beeindruckende Ergebnisse erzielt haben, gibt es immer noch Einschränkungen und Herausforderungen, die es zu überwinden gilt. Dazu gehören der Mangel an echtem Verständnis, potenzielle Vorurteile und ethische Bedenken. Darüber hinaus entwickelt sich der Bereich der generativen KI rasant weiter, wobei Forscher neue Architekturen, Anwendungen und Techniken erforschen, um die Grenzen dieser Modelle zu erweitern.

Da GPT-Modelle immer weiter voranschreiten, ist es von entscheidender Bedeutung, ethische Überlegungen anzustellen und verantwortungsvolle KI-Praktiken zu entwickeln. Es ist auch wichtig, neue Trends und Spitzenforschung zu erkunden, um das volle Potenzial dieser leistungsstarken Modelle auszuschöpfen. In der Zwischenzeit müssen wir ihre sichere und vorteilhafte Verwendung sicherstellen, indem wir potenzielle Risiken mindern.

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoData.Network Vertikale generative KI. Motiviere dich selbst. Hier zugreifen.

- PlatoAiStream. Web3-Intelligenz. Wissen verstärkt. Hier zugreifen.

- PlatoESG. Kohlenstoff, CleanTech, Energie, Umwelt, Solar, Abfallwirtschaft. Hier zugreifen.

- PlatoHealth. Informationen zu Biotechnologie und klinischen Studien. Hier zugreifen.

- Quelle: https://www.analyticsvidhya.com/blog/2024/04/what-is-gpt-you-wont-believe-whats-inside/