Dieser Beitrag wurde gemeinsam mit Sherwin Chu von Alida verfasst.

Alida hilft den größten Marken der Welt dabei, hoch engagierte Forschungsgemeinschaften aufzubauen, um Feedback zu sammeln, das zu besseren Kundenerlebnissen und Produktinnovationen führt.

Die Kunden von Alida erhalten Zehntausende engagierter Antworten für eine einzige Umfrage. Daher hat sich das Alida-Team für die Nutzung von maschinellem Lernen (ML) entschieden, um ihre Kunden in großem Umfang zu bedienen. Beim Einsatz traditioneller NLP-Modelle (Natural Language Processing) stellten sie jedoch fest, dass diese Lösungen Schwierigkeiten hatten, das differenzierte Feedback in offenen Umfrageantworten vollständig zu verstehen. Die Modelle erfassten häufig nur oberflächliche Themen und Stimmungen und ließen den entscheidenden Kontext außer Acht, der genauere und aussagekräftigere Erkenntnisse ermöglichen würde.

In diesem Beitrag erfahren wir, wie das Claude Instant-Modell von Anthropic weitergeht Amazonas Grundgestein ermöglichte es dem Alida-Team, schnell einen skalierbaren Service aufzubauen, der das Thema und die Stimmung in komplexen Umfrageantworten genauer bestimmt. Der neue Dienst erzielte eine 4- bis 6-fache Verbesserung bei der Themenbehauptung durch eine enge Clusterung auf mehrere Dutzend Schlüsselthemen im Vergleich zu Hunderten lauter NLP-Schlüsselwörter.

Amazon Bedrock ist ein vollständig verwalteter Dienst, der über eine einzige API eine Auswahl an leistungsstarken Foundation-Modellen (FMs) von führenden KI-Unternehmen wie AI21 Labs, Anthropic, Cohere, Meta, Stability AI und Amazon sowie ein breites Spektrum bietet Eine Reihe von Funktionen, die Sie zum Erstellen generativer KI-Anwendungen mit Sicherheit, Datenschutz und verantwortungsvoller KI benötigen.

Durch den Einsatz von Amazon Bedrock konnte Alida seinen Service schneller auf den Markt bringen, als wenn es andere Anbieter oder Anbieter von maschinellem Lernen (ML) genutzt hätte.

Die Herausforderung

Umfragen mit einer Kombination aus Multiple-Choice- und offenen Fragen ermöglichen Marktforschern eine ganzheitlichere Sichtweise, indem sie sowohl quantitative als auch qualitative Datenpunkte erfassen.

Multiple-Choice-Fragen sind im großen Maßstab leicht zu analysieren, es mangelt ihnen jedoch an Nuancen und Tiefe. Festgelegte Antwortoptionen können auch zu voreingenommenen oder voreingenommenen Antworten der Teilnehmer führen.

Offene Umfragefragen ermöglichen es den Befragten, Kontext und unerwartetes Feedback bereitzustellen. Diese qualitativen Datenpunkte vertiefen das Verständnis der Forscher über das hinaus, was Multiple-Choice-Fragen allein erfassen können. Die Herausforderung beim Freiformtext besteht darin, dass er zu komplexen und differenzierten Antworten führen kann, die für traditionelles NLP nur schwer vollständig zu verstehen sind. Zum Beispiel:

„Ich habe kürzlich einige der Härten des Lebens erlebt und war wirklich niedergeschlagen und enttäuscht. Als ich reinkam, war das Personal immer sehr freundlich zu mir. Es hat mir geholfen, schwierige Zeiten zu überstehen!“

Traditionelle NLP-Methoden identifizieren Themen wie „Schwierigkeiten“, „Enttäuschung“, „freundliches Personal“ und „schwere Zeiten überstehen“. Es kann nicht zwischen den insgesamt aktuellen negativen Lebenserfahrungen des Antwortenden und den spezifischen positiven Erfahrungen im Geschäft unterscheiden.

Die bestehende Lösung von Alida verarbeitet automatisch große Mengen offener Antworten, das Unternehmen wollte jedoch, dass seine Kunden ein besseres Kontextverständnis und umfassendere Schlussfolgerungen zu Themen erhalten.

Amazonas Grundgestein

Vor der Einführung von LLMs bestand die Möglichkeit für Alida, ihre bestehende Einzelmodelllösung zu verbessern, darin, eng mit Branchenexperten zusammenzuarbeiten und neue Modelle speziell für jede der Branchen, in denen die Kunden von Alida tätig waren, zu entwickeln, zu schulen und zu verfeinern. Dies war ein zeit- und kostenintensives Unterfangen.

Einer der Durchbrüche, die LLMs so wirkungsvoll machen, ist der Einsatz von Aufmerksamkeitsmechanismen. LLMs nutzen Selbstaufmerksamkeitsmechanismen, die die Beziehungen zwischen Wörtern in einer bestimmten Eingabeaufforderung analysieren. Dadurch können LLMs besser mit dem Thema und der Stimmung im vorherigen Beispiel umgehen und stellen eine aufregende neue Technologie vor, die zur Bewältigung der Herausforderung eingesetzt werden kann.

Mit Amazon Bedrock können Teams und Einzelpersonen sofort mit der Nutzung von Foundation-Modellen beginnen, ohne sich um die Bereitstellung der Infrastruktur oder die Einrichtung und Konfiguration von ML-Frameworks kümmern zu müssen. Sie können mit den folgenden Schritten beginnen:

- Stellen Sie sicher, dass Ihr Benutzer oder Ihre Rolle über die Berechtigung zum Erstellen oder Ändern von Amazon Bedrock-Ressourcen verfügt. Einzelheiten finden Sie unter Beispiele für identitätsbasierte Richtlinien für Amazon Bedrock

- Melden Sie sich an Amazonas Grundgestein Konsole.

- Auf dem Modellzugriff Seite, lesen Sie die EULA und aktivieren Sie die gewünschten FMs in Ihrem Konto.

- Beginnen Sie mit den FMs über die folgenden Methoden zu interagieren:

Das Führungsteam von Alida wollte unbedingt zu den ersten Anwendern von Amazon Bedrock gehören, weil es erkannte, dass das Unternehmen seinen Teams dabei helfen kann, neue generative KI-gestützte Lösungen schneller auf den Markt zu bringen.

Vincy William, Senior Director of Engineering bei Alida, der das Team leitet, das für den Aufbau des Themen- und Stimmungsanalysedienstes verantwortlich ist, sagt:

„LLMs bieten einen großen Sprung in der qualitativen Analyse und leisten Dinge (in einem Ausmaß, die menschlich nicht möglich sind). Amazon Bedrock ist ein Game-Changer, es ermöglicht uns, LLMs ohne die Komplexität zu nutzen.“

Das Engineering-Team erlebte, wie einfach der Einstieg in Amazon Bedrock war. Sie könnten aus verschiedenen Basismodellen auswählen und sich auf die schnelle Entwicklung konzentrieren, anstatt Zeit mit der richtigen Dimensionierung, Bereitstellung, Bereitstellung und Konfiguration von Ressourcen für die Ausführung der Modelle zu verbringen.

Lösungsüberblick

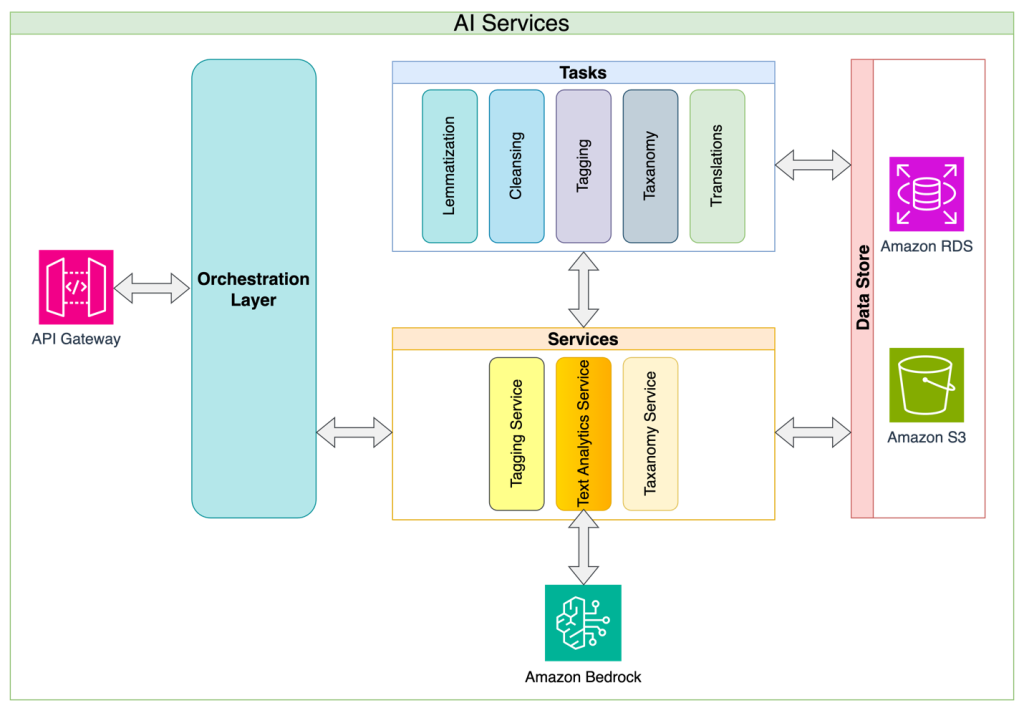

Sherwin Chu, Chefarchitekt von Alida, stellte den Ansatz der Microservices-Architektur von Alida vor. Alida hat die Themen- und Stimmungsklassifizierung als Dienst mit der Analyse der Umfrageantworten als erster Anwendung entwickelt. Mit diesem Ansatz werden häufige LLM-Implementierungsherausforderungen wie die Komplexität der Verwaltung von Eingabeaufforderungen, Token-Limits, Anforderungseinschränkungen und Wiederholungsversuchen abstrahiert, und die Lösung ermöglicht es konsumierenden Anwendungen, über eine einfache und stabile API zu verfügen, mit der sie arbeiten können. Dieser Abstraktionsschicht-Ansatz ermöglicht es den Dienstbesitzern auch, interne Implementierungsdetails kontinuierlich zu verbessern und API-brechende Änderungen zu minimieren. Schließlich ermöglicht der Service-Ansatz die Implementierung aller Daten-Governance- und Sicherheitsrichtlinien, die sich mit der Weiterentwicklung der KI-Governance im Unternehmen weiterentwickeln, von einem einzigen Punkt aus.

Das folgende Diagramm veranschaulicht die Lösungsarchitektur und den Lösungsablauf.

Alida evaluierte LLMs verschiedener Anbieter und kam zu dem Schluss, dass Claude Instant von Anthropic das richtige Gleichgewicht zwischen Kosten und Leistung bietet. In enger Zusammenarbeit mit dem Prompt-Engineering-Team plädierte Chu für die Implementierung einer Prompt-Chaining-Strategie anstelle eines einzelnen Monolith-Prompt-Ansatzes.

Durch die schnelle Verkettung können Sie Folgendes tun:

- Unterteilen Sie Ihr Ziel in kleinere, logische Schritte

- Erstellen Sie für jeden Schritt eine Eingabeaufforderung

- Geben Sie die Eingabeaufforderungen nacheinander an das LLM weiter

Dadurch entstehen zusätzliche Prüfpunkte, was folgende Vorteile mit sich bringt:

- Es ist einfach, Änderungen, die Sie an der Eingabeaufforderung vornehmen, systematisch auszuwerten

- Sie können bei jedem Schritt eine detailliertere Verfolgung und Überwachung der Genauigkeit und Leistung implementieren

Zu den wichtigsten Überlegungen bei dieser Strategie gehört die Zunahme der Anzahl der an das LLM gerichteten Anfragen und die daraus resultierende Verlängerung der Gesamtzeit, die zum Erreichen des Ziels benötigt wird. Um diese Effekte auszugleichen, haben sie sich für den Anwendungsfall von Alida entschieden, eine Sammlung offener Antworten in einer einzigen Eingabeaufforderung an das LLM zu bündeln.

NLP vs. LLM

Die bestehende NLP-Lösung von Alida basiert auf Clustering-Algorithmen und statistischer Klassifizierung, um offene Umfrageantworten zu analysieren. Bei der Anwendung auf Beispiel-Feedback für die mobile App eines Cafés wurden Themen anhand von Wortmustern extrahiert, es fehlte jedoch ein wirkliches Verständnis. Die folgende Tabelle enthält einige Beispiele zum Vergleich von NLP-Antworten mit LLM-Antworten.

| Antwort auf die Umfrage | Bestehendes traditionelles NLP | Amazon Bedrock mit Claude Instant | |

| Betreff | Betreff | Gefühl | |

| Aus Bequemlichkeitsgründen bestelle ich meine Getränke fast ausschließlich über die App und es ist weniger peinlich, superindividuelle Getränke zu bestellen, lol. Und ich liebe es, Belohnungen zu verdienen! | ['App BC Convenience', 'Drink', 'Reward'] | Bequemes mobiles Bestellen | positiv |

| Die App funktioniert ziemlich gut. Die einzige Beschwerde, die ich habe, ist, dass ich meiner Geschenkkarte nicht beliebig viel Geld hinzufügen kann. Warum muss das Nachfüllen konkret 10 $ kosten?! | ['Beschwerde', 'App', 'Geschenkkarte', 'Zahlengeld'] | Geschwindigkeit der mobilen Auftragsabwicklung | Negativ |

Die Beispielergebnisse zeigen, wie die bestehende Lösung relevante Schlüsselwörter extrahieren konnte, jedoch keine allgemeinere Themengruppenzuordnung erreichen konnte.

Im Gegensatz dazu ist der LLM mit kontextbezogenem Training mithilfe von Amazon Bedrock und Anthropic Claude Instant in der Lage, die Antworten vordefinierten Themen zuzuordnen und Stimmungen zuzuordnen.

Zusätzlich zur Bereitstellung besserer Antworten für die Kunden von Alida konnte für diesen speziellen Anwendungsfall durch die Suche nach einer Lösung, bei der ein LLM statt herkömmlicher NLP-Methoden verwendet wurde, viel Zeit und Mühe bei der Schulung und Pflege eines geeigneten Modells eingespart werden. Die folgende Tabelle vergleicht das Training eines traditionellen NLP-Modells mit dem kontextbezogenen Training eines LLM.

| . | Datenanforderung | Trainingsprozess | Modellanpassungsfähigkeit |

| Training eines traditionellen NLP-Modells | Tausende von Menschen beschriftete Beispiele |

Kombination aus automatisiertem und manuellem Feature-Engineering. Iteratives Trainieren und Auswerten von Zyklen. |

Langsamere Abwicklung aufgrund der Notwendigkeit, das Modell neu zu schulen |

| Kontextbezogenes LLM-Training | Mehrere Beispiele |

Direktes Training innerhalb der Eingabeaufforderung. Begrenzt durch die Größe des Kontextfensters. |

Schnellere Iterationen durch Ändern der Eingabeaufforderung. Begrenzte Aufbewahrung aufgrund der Größe des Kontextfensters. |

Zusammenfassung

Alidas Verwendung des Claude-Instant-Modells von Anthropic auf Amazon Bedrock demonstriert die leistungsstarken Fähigkeiten von LLMs zur Analyse offener Umfrageantworten. Alida war in der Lage, einen überlegenen Dienst aufzubauen, der im Vergleich zu ihrem NLP-basierten Dienst vier- bis sechsmal präziser bei der Themenanalyse war. Darüber hinaus verkürzte die Verwendung von In-Context-Prompt-Engineering für LLMs die Entwicklungszeit erheblich, da nicht Tausende von menschlich markierten Datenpunkten kuratiert werden mussten, um ein herkömmliches NLP-Modell zu trainieren. Dies ermöglicht es Alida letztendlich, seinen Kunden früher umfassendere Einblicke zu geben!

Wenn Sie bereit sind, mit Amazon Bedrock Ihre eigene Fundamentmodellinnovation zu entwickeln, schauen Sie sich diesen Link an Richten Sie Amazon Bedrock ein. Wenn Sie mehr über andere interessante Amazon Bedrock-Anwendungen erfahren möchten, lesen Sie den Amazon Bedrock-spezifischen Abschnitt des AWS Machine Learning Blog.

Über die Autoren

Kinman Lam ist ein ISV/DNB-Lösungsarchitekt für AWS. Er verfügt über 17 Jahre Erfahrung im Aufbau und Wachstum von Technologieunternehmen in den Bereichen Smartphone, Geolokalisierung, IoT und Open-Source-Software. Bei AWS nutzt er seine Erfahrung, um Unternehmen beim Aufbau einer robusten Infrastruktur zu unterstützen, um den steigenden Anforderungen wachsender Unternehmen gerecht zu werden, neue Produkte und Dienstleistungen auf den Markt zu bringen, neue Märkte zu erschließen und ihre Kunden zu begeistern.

Kinman Lam ist ein ISV/DNB-Lösungsarchitekt für AWS. Er verfügt über 17 Jahre Erfahrung im Aufbau und Wachstum von Technologieunternehmen in den Bereichen Smartphone, Geolokalisierung, IoT und Open-Source-Software. Bei AWS nutzt er seine Erfahrung, um Unternehmen beim Aufbau einer robusten Infrastruktur zu unterstützen, um den steigenden Anforderungen wachsender Unternehmen gerecht zu werden, neue Produkte und Dienstleistungen auf den Markt zu bringen, neue Märkte zu erschließen und ihre Kunden zu begeistern.

Sherwin Chu ist Chefarchitekt bei Alida und unterstützt Produktteams bei der Architekturausrichtung, der Technologieauswahl und der Lösung komplexer Probleme. Er ist ein erfahrener Softwareentwickler, Architekt und Führungskraft mit über 20 Jahren Erfahrung im SaaS-Bereich für verschiedene Branchen. Er hat zahlreiche B2B- und B2C-Systeme auf AWS und GCP aufgebaut und verwaltet.

Sherwin Chu ist Chefarchitekt bei Alida und unterstützt Produktteams bei der Architekturausrichtung, der Technologieauswahl und der Lösung komplexer Probleme. Er ist ein erfahrener Softwareentwickler, Architekt und Führungskraft mit über 20 Jahren Erfahrung im SaaS-Bereich für verschiedene Branchen. Er hat zahlreiche B2B- und B2C-Systeme auf AWS und GCP aufgebaut und verwaltet.

Markus Roy ist Principal Machine Learning Architect für AWS und unterstützt Kunden beim Entwerfen und Erstellen von KI/ML- und generativen KI-Lösungen. Sein Schwerpunkt liegt seit Anfang 2023 auf der Leitung der Lösungsarchitekturbemühungen für die Einführung von Amazon Bedrock, dem Flaggschiff-Angebot generativer KI von AWS für Bauherren. Marks Arbeit deckt ein breites Spektrum an Anwendungsfällen ab, wobei sein Hauptinteresse an generativer KI, Agenten und der Skalierung von ML im gesamten Unternehmen liegt. Er hat Unternehmen in den Bereichen Versicherungen, Finanzdienstleistungen, Medien und Unterhaltung, Gesundheitswesen, Versorgungsunternehmen und Fertigung unterstützt. Bevor er zu AWS kam, war Mark über 25 Jahre lang als Architekt, Entwickler und Technologieführer tätig, davon 19 Jahre im Finanzdienstleistungsbereich. Mark verfügt über sechs AWS-Zertifizierungen, darunter die ML Specialty Certification.

Markus Roy ist Principal Machine Learning Architect für AWS und unterstützt Kunden beim Entwerfen und Erstellen von KI/ML- und generativen KI-Lösungen. Sein Schwerpunkt liegt seit Anfang 2023 auf der Leitung der Lösungsarchitekturbemühungen für die Einführung von Amazon Bedrock, dem Flaggschiff-Angebot generativer KI von AWS für Bauherren. Marks Arbeit deckt ein breites Spektrum an Anwendungsfällen ab, wobei sein Hauptinteresse an generativer KI, Agenten und der Skalierung von ML im gesamten Unternehmen liegt. Er hat Unternehmen in den Bereichen Versicherungen, Finanzdienstleistungen, Medien und Unterhaltung, Gesundheitswesen, Versorgungsunternehmen und Fertigung unterstützt. Bevor er zu AWS kam, war Mark über 25 Jahre lang als Architekt, Entwickler und Technologieführer tätig, davon 19 Jahre im Finanzdienstleistungsbereich. Mark verfügt über sechs AWS-Zertifizierungen, darunter die ML Specialty Certification.

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoData.Network Vertikale generative KI. Motiviere dich selbst. Hier zugreifen.

- PlatoAiStream. Web3-Intelligenz. Wissen verstärkt. Hier zugreifen.

- PlatoESG. Kohlenstoff, CleanTech, Energie, Umwelt, Solar, Abfallwirtschaft. Hier zugreifen.

- PlatoHealth. Informationen zu Biotechnologie und klinischen Studien. Hier zugreifen.

- Quelle: https://aws.amazon.com/blogs/machine-learning/alida-gains-deeper-understanding-of-customer-feedback-with-amazon-bedrock/