Darüber hinaus ist es von entscheidender Bedeutung, wie sich diese KI-Technologien an bestehende Ökosysteme in hochwertigen und stark nachgefragten Infrastrukturen wie Flughäfen, Flugzeugen und verschiedenen fortschrittlichen Mobilitätssystemen anpassen und diese revolutionieren können.

Durch den Einsatz innovativer KI-Technologien und die Nutzung der Plattformvorteile der Cranfield University ist die MSc-Kurs Angewandte Künstliche Intelligenz zielt darauf ab, zukünftige Führungskräfte in der angewandten KI in verschiedenen Ingenieurbereichen auszubilden. Ihr Hauptziel besteht darin, die Entwicklung und den Einsatz zuverlässiger KI-Technologien für sicherheitskritische Anwendungen weltweit voranzutreiben.

Das Group Design Project (GDP) ist ein problembasiertes Lernmodul. Ziel des GDP ist es, dass Studierende KI-basierte Systeme in Echtzeit entwerfen, implementieren, validieren und testen, um reale Probleme zu lösen. Das GDP zielt außerdem darauf ab, den Studierenden die Erfahrung zu vermitteln, an einem gemeinschaftlichen Ingenieurprojekt zu arbeiten, die Anforderungen eines potenziellen Kunden zu erfüllen und Fristen einzuhalten.

In den Jahren 2022 und 2023 wurde den Studierenden unseres Masterstudiengangs Angewandte Künstliche Intelligenz ein anregendes und anspruchsvolles Gruppendesignprojekt zugewiesen. Ziel war es, das im Rahmen ihrer Kursarbeit erworbene angewandte KI-Wissen zu nutzen, um innovative und sicherere Flughafenprodukte zu entwickeln. In kleinen Teams von sechs Personen wurden die Studierenden damit beauftragt, Lösungen zu entwerfen, die Software- und Hardware-Architektur, KI-Modellentwicklung und -Tests sowie Aspekte des realen Engagements umfassen.

Das Thema des Projekts war bewusst weit gefasst und erforderte von den Studierenden die Zusammenarbeit innerhalb ihrer Gruppen, um spezifische Interessengebiete auf der Grundlage ihrer kollektiven Fachkenntnisse und Interessen zu erkunden und zu verfeinern. Dieser Ansatz förderte Kreativität, Teamarbeit und ein tieferes Verständnis für die praktische Anwendung von KI-Technologien in realen Szenarien.

Jede Gruppe wurde gebeten, Echtzeit-KI-Lösungen für intelligente Flughäfen zu entwickeln, um die folgenden Funktionalitäten zu erreichen:

- Das System soll in der Lage sein, menschliche Benutzer zu erkennen und ihre Posen und Verhaltensweisen auf der Grundlage einer präzisen Posenerkennung und -verfolgung abzuschätzen.

- Das System soll in der Lage sein, unterschiedliche Verhaltensweisen von Menschenmengen zu klassifizieren und die Gründe, die Bedeutung und die Machbarkeit zu klären.

- Das KI-Modell sollte mit verschiedenen Metriken in Bezug auf Genauigkeit, Berechnung und Inferenz kreuzvalidiert werden.

- Das KI-Modell soll in Echtzeit umsetzbar sein, um die Vor- und Nachteile aktueller KI-Technologien in diesen sicherheitskritischen Anwendungen aufzuzeigen.

- Das System kann auf verschiedene Sensorquellen als Eingabe zurückgreifen, um eine Sensorfusion für eine robuste Leistung zu ermöglichen. Allerdings sind auch sehr kostengünstige, aber effiziente Lösungen willkommen.

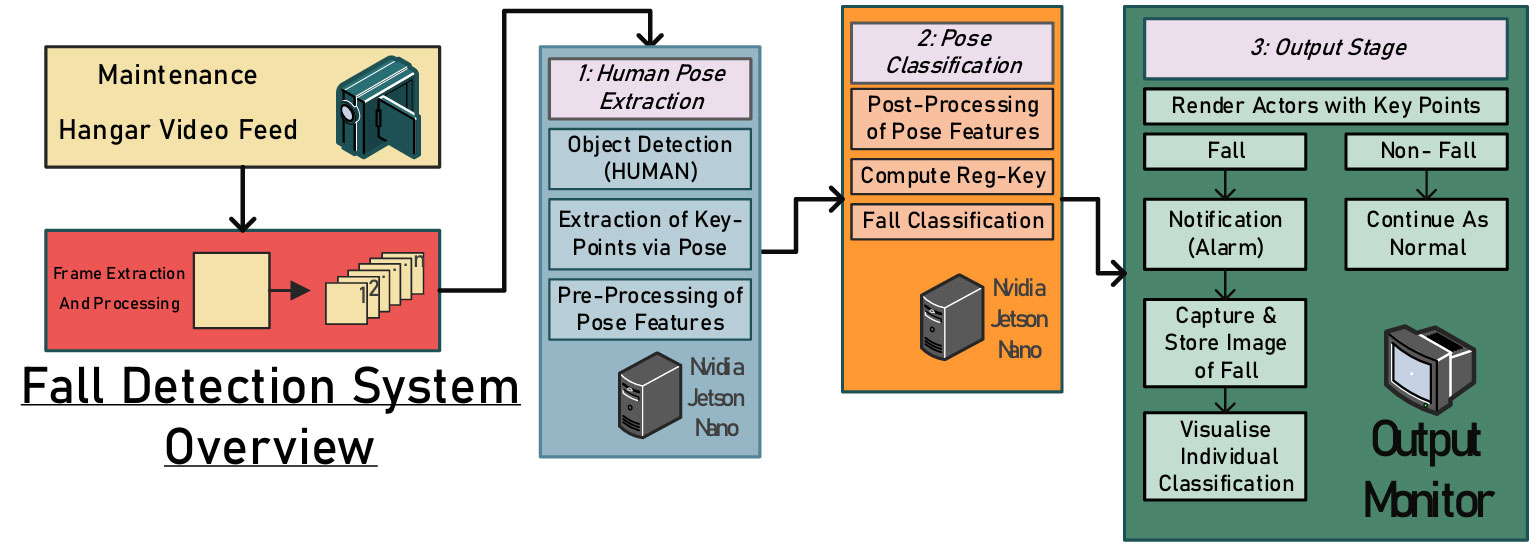

Fallstudie 1: Sturzerkennung in einer Flugzeugwartungsumgebung.

Wartungsumgebungen bergen erhebliche Gefahren, darunter unbeaufsichtigte Maschinen, unzureichende Zäune oder physische Schutzmaßnahmen in der Nähe gefährlicher Bereiche und überfüllte Arbeitsbereiche. Unter diesen Risiken sind tödliche Sturzverletzungen alarmierend häufig. Durch die rechtzeitige Erkennung und Meldung nicht tödlicher Vorfälle könnten weitere Schäden oder Todesfälle verhindert werden. Daher schlägt diese Arbeit ein integriertes visionsbasiertes System zur Überwachung von Mitarbeitern während Flugzeugwartungsaktivitäten vor, um die Sicherheit zu erhöhen und Unfälle zu verhindern (siehe Abbildung unten).

.fusion-gallery-1 .fusion-gallery-image {border:0px solid #e2e2e2;}

Aus den ersten Trainings- und Validierungsergebnissen des entworfenen Modells geht hervor, dass das offensichtliche Fehlen eines vorgefertigten Wartungsdatensatzes für Flughafenhangars die Möglichkeit einer Tendenz zu Bildern aus Videos darstellt, die aus senkrechten Kamerawinkeln aus der Nähe des Motivs aufgenommen wurden. Um die Vorteile von Cranfield zu nutzen, wurde der Wartungshangar der Cranfield University ausgewählt und für die Datenerfassung in diesem Projekt genutzt.

Insgesamt wurden etwa 50 kurze (zwei bis fünf Minuten) Videos simulierter Wartungstätigkeiten aufgezeichnet, einige mit Stürzen, andere ohne. Die aufgenommenen Videos wurden in Einzelbilder zerlegt und mithilfe der MoveNet-Softwarebibliothek zur Posenschätzung mit Anmerkungen versehen, und es wurden Vektorkarten der wichtigsten Gelenkpositionen des Probanden erstellt. Die folgende Abbildung zeigt einige Schnappschüsse der experimentellen Daten.

.fusion-gallery-2 .fusion-gallery-image {border:0px solid #e2e2e2;}

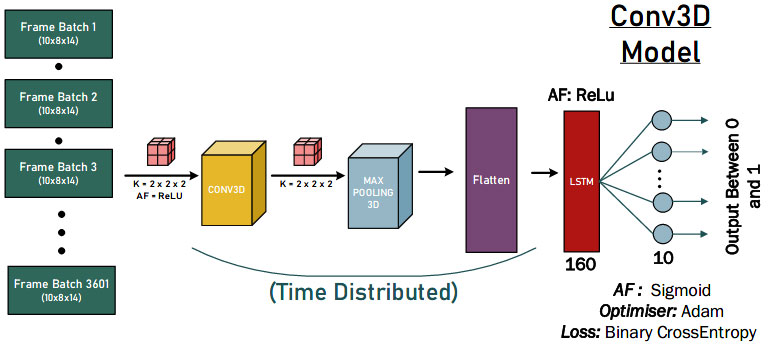

Unsere Studenten testeten die 1D-, 2D- und 3D-Faltungs-Neuronalen Netzwerkansätze, um das Design des leistungsstärksten KI-Modells quantitativ zu bewerten. Die folgende Abbildung ist eine Demonstration der 3D-Faltungslösungen.

.fusion-gallery-3 .fusion-gallery-image {border:0px solid #e2e2e2;}

Schließlich erzielten die vorgeschlagenen KI-Lösungen gute Erkennungsergebnisse für das Sturzverhalten, wie in der folgenden Abbildung dargestellt. Es lassen sich einige Schlussfolgerungen ziehen. Erstens hatte das Modell 0 FP-Klassifizierungen, was darauf hindeutet, dass das Modell einen Sturz nicht falsch klassifiziert. Zweitens gibt es 940 echte Negative für jedes Modell. Dies könnte wahrscheinlich darauf zurückzuführen sein, dass alle Testdaten einen Teil der Nicht-Stürze (klassifiziert als 0) enthalten, bevor der Akteur umfällt.

.fusion-gallery-4 .fusion-gallery-image {border:0px solid #e2e2e2;}

Fallstudie 2: Erkennung von Vitalzeichen eines Myokardinfarkts mithilfe von Computer Vision und Edge AI

Edge AI bezieht sich auf den Einsatz künstlicher Intelligenzanwendungen in Geräten, die sich in der gesamten physischen Umgebung befinden. Erschwinglichkeit und Benutzerfreundlichkeit sind Schlüsselfaktoren für die Einführung von KI-Algorithmen in Situationen, in denen Endbenutzer auf reale Herausforderungen stoßen. In diesem Projekt schlug unser Student ein kostengünstiges und leichtes Modell zur Erkennung von Herzinfarkten für eine schnelle Reaktion und Rettung am Flughafen vor. Der Prozess besteht aus vier Hauptphasen, wie in der folgenden Abbildung dargestellt.

.fusion-gallery-5 .fusion-gallery-image {border:0px solid #e2e2e2;}

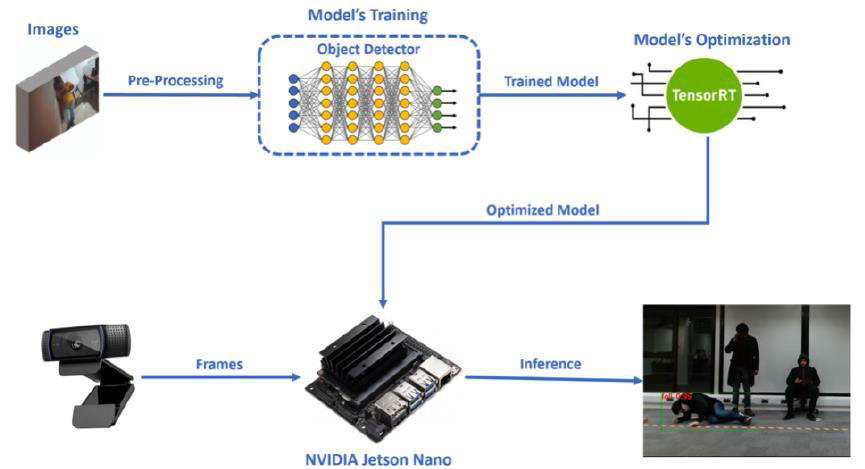

Der erste Schritt besteht aus der geeigneten Auswahl und Aufbereitung eines Bilddatensatzes sowie der notwendigen Annotationen für die Begrenzungsrahmen der Klassen (Brustschmerzen, Sturz).

Darüber hinaus folgt als zweiter Schritt das Training unseres Objektdetektormodells durch Transferlernen. Die spezifische Phase wurde in Google Colab mit PyTorch durchgeführt. Anschließend, nach Abschluss der Trainingsphase, wurde das Modell in NVIDIAs Jetson Nano eingefügt, das von uns ausgewählte eingebettete Gerät für unsere Edge AI Computer Vision-Anwendung.

Der dritte Schritt unseres Systemdesigns war die entsprechende Konvertierung und Optimierung des Modells, damit es auf Jetson Nano effizienter läuft. Die Optimierung unseres Modells wurde mit der TensorRT-Inferenz-Engine von NVIDIA durchgeführt und der spezifische Prozess wurde in Jetson Nano ausgeführt (wie in der Abbildung unten dargestellt).

.fusion-gallery-6 .fusion-gallery-image {border:0px solid #e2e2e2;}

Der letzte Schritt ist die Ausführung des optimierten Modells auf Jetson Nano, wobei die Frames, die es von einer Webcam empfängt, als Eingaben verwendet werden, um den Objekterkennungsprozess in Echtzeit durchzuführen und unsere Klassen (Brustschmerzen, Sturz) zu erkennen. Neben diesem Prozess gab es im Inferenzcode, der auf Jetson Nano läuft, zwei spezifische Szenarien. Die endgültigen Inferenzergebnisse sind in der folgenden Abbildung dargestellt.

.fusion-gallery-7 .fusion-gallery-image {border:0px solid #e2e2e2;}

Fallstudie 3: Überwachung von Menschenmengen und Analyse der sozialen Distanzierung

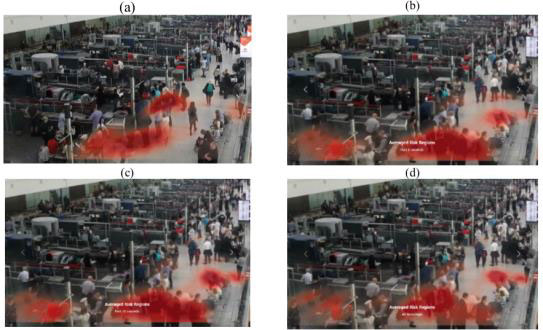

An Flughäfen herrscht täglich ein enormer Zustrom von Passagieren. Ähnlich wie an anderen überfüllten Standorten und Organisationen müssen sie die öffentliche Sicherheit gewährleisten und sicherstellen, dass angemessene Maßnahmen zur Risikominderung bei Pandemien ergriffen werden. In diesem Projekt schlugen unsere Studenten ein integriertes, auf Computer Vision basierendes System vor, das eine multifunktionale Überwachung und Analyse von Menschenmengen auf Flughäfen ermöglicht. Die Systemergebnisse sollen sowohl dem Flughafenmanagementpersonal als auch den Passagieren zugute kommen, indem sie Crowd-basierte Analysen und Informationen bereitstellen.

Das System besteht aus einer integrierten Plattform (siehe Abbildung unten), um Menschenmengen an öffentlichen Orten mithilfe von Videoüberwachungs-Feeds zu analysieren und zu überwachen. Der Schwerpunkt liegt speziell auf intelligenten Flughäfen, aber das Grundgerüst ist an jeden öffentlichen Kontext anpassbar, in dem die Analyse und Überwachung von Menschenmassen nützlich ist.

.fusion-gallery-8 .fusion-gallery-image {border:0px solid #e2e2e2;}

Die aus einer Szene extrahierten Posenmerkmale werden von nachgeschalteten Systemmodellen verwendet, um einzigartige Aufgaben auszuführen. Dazu gehören Personenzählung, Schätzung der zwischenmenschlichen Distanz, Erkennung von Maskenobjekten, Statusklassifizierung (Sitzen, Stehen, Gehen, Liegen usw.) und soziales Clustering. Die Ergebnisse werden dann zum integrierten Dashboard- und Überwachungssystem zusammengeführt. Mit Ausnahme der häufigen Verwendung von Posenfunktionen stellen diese Aufgaben bei unterschiedlichen Modellierungsansätzen einzigartige Herausforderungen dar. Glücklicherweise war es aufgrund des modularen Systemaufbaus möglich, jede Aufgabe zu abstrahieren und von verschiedenen Teammitgliedern entwickeln zu lassen.

.fusion-gallery-9 .fusion-gallery-image {border:0px solid #e2e2e2;}

Schließlich soll eine interaktive Schnittstelle alle Downstream-Ausgaben in einem einzigen Ansichtsfenster integrieren (siehe Abbildung unten). Die App lädt von den nachgeschalteten Modellen erstellte Datendateien in Echtzeit auf das Dashboard hoch, sodass eine Analyse des aktuellen Zustands der Szene durchgeführt werden kann. Das Originalmaterial der Szene kann jederzeit zusammen mit den von jeder Person extrahierten Posenmerkmalen auf einem daneben liegenden Videoplayer angesehen werden. Der Entscheidungsträger kann zwischen einer Boxplot-Ansicht und einer Heatmap-Ansicht wechseln und anschließend über zwei Dropdown-Menüs ändern, welches Filmmaterial die Daten empfangen soll. Statistiken zur Szene werden ganz rechts im Ansichtsfenster angezeigt. Bei diesen Statistiken handelt es sich um den Maskenstatus aller Personen, das Gesamtrisikoprofil, den Posenstatus aller Personen, die Gesamtzahl der Personen, den Anteil der sozialen Distanzierung und den Anteils-Boxplot.

.fusion-gallery-10 .fusion-gallery-image {border:0px solid #e2e2e2;}

Fallstudie 4: Gewalterkennung am Flughafen

Schließlich möchte eine unserer Gruppen ein Framework zur Gewalterkennung entwickeln, das menschliche Posen schätzt und gewalttätiges Verhalten in Überwachungsaufnahmen klassifiziert (wie in der Abbildung unten dargestellt). Anstatt Merkmale direkt aus Videobildern zu extrahieren, verwendet dieses Framework ViTPose, um menschliche Posen in jedem Bild zu erkennen, verarbeitet dann Merkmale vor und extrahiert sie aus den Schlüsselpunktinformationen.

.fusion-gallery-11 .fusion-gallery-image {border:0px solid #e2e2e2;}

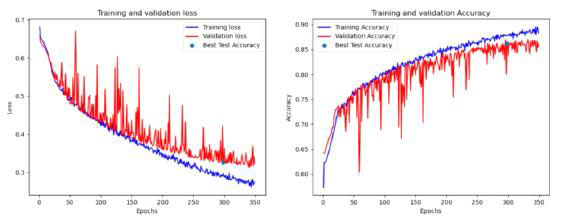

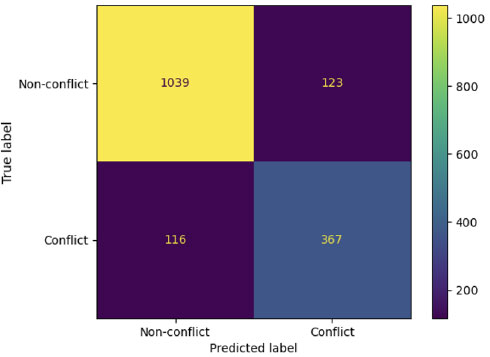

Durch eine umfassende Analyse verschiedener Modelle unter Verwendung mehrerer Datensätze (winkelbasiert, distanzbasiert, 1-Sekunden- und 2-Sekunden-Sequenzen) mit insgesamt 162 Hyperparameterkombinationen identifizierte das Team schließlich mehrere vielversprechende Modelle, die bestimmte Bewertungskriterien erfüllen. Daraus lässt sich schließen, dass Modelle wertvolle Informationen über gewalttätiges Verhalten mithilfe von Distanzmerkmalen von Körperschlüsselpunkten extrahieren können, wie in der folgenden Abbildung dargestellt.

.fusion-gallery-12 .fusion-gallery-image {border:0px solid #e2e2e2;}

Schließlich können unsere Studenten durch die Zusammenarbeit mit Saab UK ihre KI-Modelle entwickeln und in die Industrial-Level-Plattform (SAFE) integrieren, eine leistungsstarke Situationsbewusstseinsplattform, die in vielen britischen Polizeistationen zur Überwachung weit verbreitet ist. Das KAFKA-Gateway wird im Anschluss an die KI-Engine angewendet und zur weiteren Anzeige und Warnung an das Client-Terminal weitergeleitet. Wenn in dem abgefangenen Video mit Begrenzungsrahmen Gewalt festgestellt wird, wird der Alarm ausgelöst, den wir speziell für unser Modell konfiguriert haben, der das abgefangene Video im SAFE-Client-Layout zeigt und uns eine Warnmeldung mit Details sendet. Am Ende setzten unsere Studenten das KI-Modell unseres DARTeC-Zentrums erfolgreich ein und kommunizierten mit dem Saab SAFE-System zur Verbesserung des menschlichen Situationsbewusstseins.

.fusion-gallery-13 .fusion-gallery-image {border:0px solid #e2e2e2;}

Schaffung der angewandten KI-Ingenieure der Zukunft

Dies sind nur einige ausgewählte Beispiele interessanter GDP-Projekte aus dem Studiengang MSc AAI. Kürzlich wurden von unseren aktuellen Studenten anspruchsvollere BIP-Projekte in den Bereichen erklärbare Schnittstelle mit KI, kausales Denken für autonome Bewegungsplanung, physikinformierte KI für autonome Fahrzeuge und zukünftiges Luftraummanagement durchgeführt. Wir glauben, dass unsere MSc-Studenten bald weitere spannende Forschungsergebnisse liefern werden.

Sehen Sie sich die folgenden Forschungspublikationen unserer Studierenden während des GDP an, um zu sehen, wie interessant die endgültigen Lösungen und Ergebnisse aussehen:

- Osigbesan, Adeyemi, Solene Barrat, Harkeerat Singh, Dongzi Xia, Siddharth Singh, Yang Xing, Weisi Guo und Antonios Tsourdos. „Visionbasierte Sturzerkennung in der Flugzeugwartungsumgebung mit Posenschätzung.“ Im Jahr 2022 IEEE International Conference on Multisensor Fusion and Integration for Intelligent Systems (MFI), S. 1-6. IEEE, 2022.

- Fraser, Benjamin, Brendan Copp, Gurpreet Singh, Orhan Keyvan, Tongfei Bian, Valentin Sonntag, Yang Xing, Weisi Guo und Antonios Tsourdos. „Reduzierung der Virusübertragung durch KI-basierte Massenüberwachung und soziale Distanzierungsanalyse.“ Im Jahr 2022 IEEE International Conference on Multisensor Fusion and Integration for Intelligent Systems (MFI), S. 1-6. IEEE, 2022.

- Üstek, İ., Desai, J., Torrecillas, IL, Abadou, S., Wang, J., Fever, Q., Kasthuri, SR, Xing, Y., Guo, W. und Tsourdos, A., 2023, August. Zweistufige Gewalterkennung mithilfe von ViTPose- und Klassifizierungsmodellen an Smart Airports. Im Jahr 2023 IEEE Smart World Congress (SWC) (S. 797–802). IEEE.

- Benoit, Paul, Marc Bresson, Yang Xing, Weisi Guo und Antonios Tsourdos. „Sichtbasierte Erkennung gewalttätiger Handlungen in Echtzeit durch CCTV-Kameras mit Posenschätzung.“ Im Jahr 2023 IEEE Smart World Congress (SWC), S. 844–849. IEEE, 2023.

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoData.Network Vertikale generative KI. Motiviere dich selbst. Hier zugreifen.

- PlatoAiStream. Web3-Intelligenz. Wissen verstärkt. Hier zugreifen.

- PlatoESG. Kohlenstoff, CleanTech, Energie, Umwelt, Solar, Abfallwirtschaft. Hier zugreifen.

- PlatoHealth. Informationen zu Biotechnologie und klinischen Studien. Hier zugreifen.

- Quelle: https://blogs.cranfield.ac.uk/aerospace/exploring-safer-and-smarter-airports-with-the-applied-artificial-intelligence-msc-group-design-project/