Einleitung

Im dynamischen Bereich der künstlichen Intelligenz hat die Verschmelzung von Technologie und Kreativität innovative Werkzeuge hervorgebracht, die die Grenzen der menschlichen Vorstellungskraft erweitern. Zu diesen bahnbrechenden Fortschritten gehört die hochentwickelte Welt der Encoder und Decoder in der generativen KI. Diese Entwicklung revolutioniert die Art und Weise, wie wir Kunst, Sprache und sogar die Realität erschaffen, interpretieren und mit ihnen interagieren.

Lernziele

- Verstehen Sie die Rolle von Encodern und Decodern in der generativen KI und ihre Bedeutung in kreativen Anwendungen.

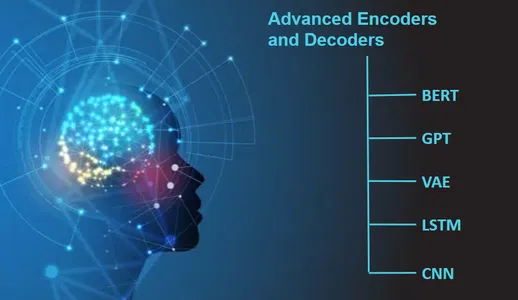

- Erfahren Sie mehr über fortschrittliche KI-Modelle wie BERT, GPT, VAE, LSTM und CNN und ihren praktischen Einsatz beim Kodieren und Dekodieren von Daten.

- Entdecken Sie Echtzeitanwendungen von Encodern und Decodern in verschiedenen Bereichen.

- Erhalten Sie Einblicke in die ethischen Überlegungen und den verantwortungsvollen Umgang mit KI-generierten Inhalten.

- Erkennen Sie das kreative Kooperations- und Innovationspotenzial durch den Einsatz fortschrittlicher Encoder und Decoder.

Dieser Artikel wurde als Teil des veröffentlicht Data Science-Blogathon.

Inhaltsverzeichnis

Der Aufstieg von Encodern und Decodern

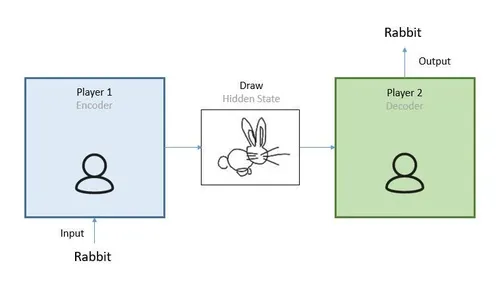

In der sich ständig weiterentwickelnden Welt der Technologie sind Encoder und Decoder zu unbesungenen Helden geworden, die der künstlichen Intelligenz (KI) und der generativen KI eine kreative Wendung verleihen. Sie sind wie die Zauberstäbe, die die KI nutzt, um Dinge wie Kunst, Text, Töne und vieles mehr auf eine Weise zu verstehen, zu interpretieren und zu erschaffen, die uns alle fasziniert.

Hier ist der Deal: Encoder sind wie die überaus aufmerksamen Detektive. Sie nehmen Dinge genau unter die Lupe, seien es Bilder, Sätze oder Töne. Sie erfassen alle winzigen Details und Muster wie ein Detektiv, der Hinweise zusammenfügt.

Nun sind Decoder die kreativen Zauberer. Sie nehmen, was Encoder gefunden haben, und verwandeln es in etwas Neues und Aufregendes. Es ist, als würde ein Zauberer Hinweise in Zaubersprüche verwandeln, die Kunstwerke, Gedichte oder sogar Sprachen erschaffen. Diese Kombination aus Encodern und Decodern öffnet die Tür zu einer Welt voller kreativer Möglichkeiten.

Einfacher ausgedrückt sind Encoder und Decoder in der KI wie Detektive und Zauberer, die zusammenarbeiten. Die Detektive verstehen die Welt und die Zauberer verwandeln dieses Verständnis in erstaunliche Kreationen. Auf diese Weise verändern sie das Spiel in Kunst, Sprache und vielem mehr und machen Technologie nicht nur innovativ, sondern auch brillant kreativ.

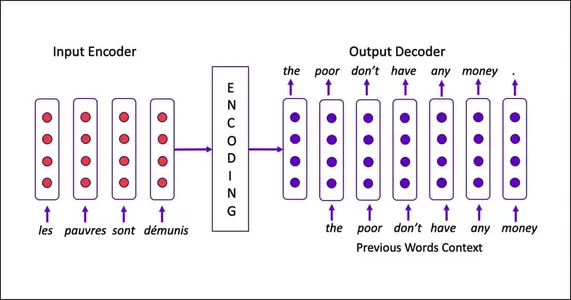

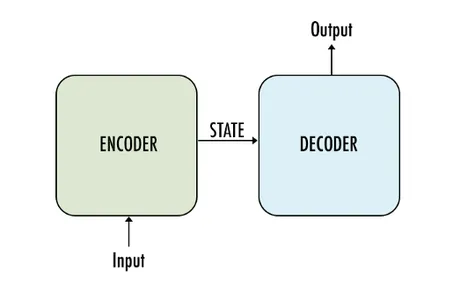

Die Bausteine: Encoder und Decoder

Im Herzen generative KI sind Encoder und Decoder, grundlegende Komponenten, die Daten von einer Form in eine andere umwandeln und sie zu einem Grundpfeiler der kreativen KI machen. Das Verständnis ihrer Rollen hilft dabei, das immense kreative Potenzial zu begreifen, das sie freisetzen.

- Der Encoder: In dieser Komponente geht es um das Verstehen. Es zerlegt Eingabedaten – ein Bild, Text oder Ton – in ihre Kernkomponenten, erfasst deren Essenz und extrahiert komplexe Muster. Stellen Sie sich einen aufmerksamen Künstler vor, der die Details, Farben und Formen einer Szene aufmerksam beobachtet.

- Der Decoder: Hier passiert die Magie. Der Decoder übersetzt die extrahierten Informationen in etwas Neues – ein Kunstwerk, einen poetischen Vers oder sogar eine ganz andere Sprache. Das kreative Genie verwandelt die Essenz des Encoders in ein Meisterwerk.

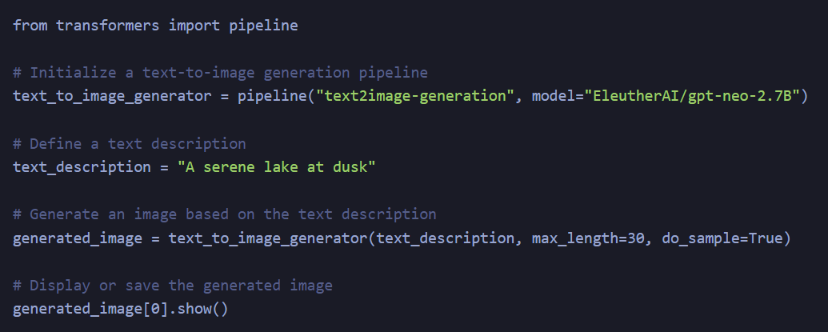

Beispiel für Echtzeitcode

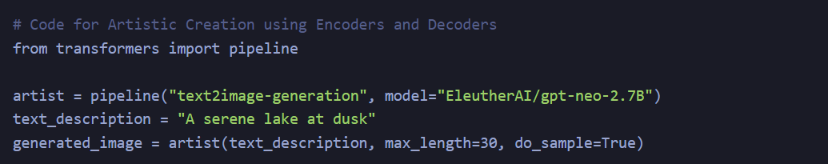

Um die Konzepte von Encodern und Decodern in der generativen KI besser zu verstehen, betrachten wir ein Echtzeit-Codebeispiel für die Text-zu-Bild-Generierung. Wir verwenden die Hugging Face Transformers-Bibliothek, die vorab trainierte Modelle für verschiedene generative Aufgaben bietet. In diesem Beispiel verwenden wir einen Encoder, um eine Textbeschreibung zu interpretieren, und einen Decoder, um ein Bild basierend auf dieser Beschreibung zu erstellen.

Erläuterung

- Wir beginnen mit dem Importieren der Pipeline-Klasse aus der Hugging Face Transformers-Bibliothek. Die Pipeline-Klasse vereinfacht die Verwendung vorab trainierter Modelle für verschiedene NLP- und generative Aufgaben.

- Wir initialisieren eine text_to_image_generator-Pipeline und geben an, dass wir eine Text-zu-Bild-Generierung durchführen möchten. Wir geben auch das zu verwendende vorab trainierte Modell an, in diesem Fall „EleutherAI/gpt-neo-2.7B“.

- Als nächstes definieren wir eine text_description. Diese Textbeschreibung dient als Eingabe für unseren Encoder. In diesem Beispiel handelt es sich um „Ein ruhiger See in der Abenddämmerung“.

- Wir verwenden den text_to_image_generator, um ein Bild basierend auf der bereitgestellten Beschreibung zu generieren. Der Parameter max_length steuert die maximale Länge der Beschreibung des generierten Bildes und do_sample=True ermöglicht das Sampling, um verschiedene Bilder zu erzeugen.

- Sie können das generierte Bild anzeigen oder speichern. Die Funktion show() zeigt das Bild im obigen Codeausschnitt an.

In diesem Codeausschnitt verarbeitet der Encoder die Textbeschreibung, während der Decoder ein Bild basierend auf dem Inhalt der genannten Textbeschreibung generiert. Dies zeigt uns, wie die Encoder und Decoder zusammenarbeiten, um Daten von einer Form (Text) in eine andere (Bild) umzuwandeln und so kreatives Potenzial freizusetzen.

Das Beispiel vereinfacht den Prozess zur Veranschaulichung des Konzepts, reale Anwendungen erfordern jedoch möglicherweise komplexere Modelle und Datenvorverarbeitung.

Erweiterte Funktionen

Der natürliche Charme davon AI Systeme liegt in ihren fortschrittlichen Fähigkeiten. Sie können mit verschiedenen Datentypen arbeiten, was sie zu vielseitigen Werkzeugen für kreative Unternehmungen macht. Schauen wir uns einige spannende Anwendungen an:

- Sprache und Übersetzung: Fortgeschrittene Encoder können einen Satz in einer Sprache aufnehmen, seine Bedeutung verstehen und dann die Decoder denselben Satz in einer anderen Sprache erzeugen lassen. Es ist, als ob Ihnen ein mehrsprachiger Dichter zur Verfügung stünde.

- Kunst und Stil: Encoder können die Essenz verschiedener Kunststile entschlüsseln, von der klassischen Renaissance bis zur modernen Abstraktion, und Decoder können diese Stile dann auf neue Kunstwerke anwenden. Es ist, als ob ein Künstler in jedem Stil malen kann, den er möchte.

- Text zum Bild: Ein Encoder kann eine Textbeschreibung verstehen und ein Decoder kann sie zum Leben erwecken, indem er ein Bild basierend auf dieser Beschreibung erstellt. Betrachten Sie es als einen KI-gestützten Illustrator.

- Stimme und Ton: Diese erweiterten Komponenten sind nicht auf den visuellen oder textuellen Bereich beschränkt. Encoder können die Emotionen einer Stimme erfassen und Decoder können Musik oder Sprache erzeugen, die diese Emotionen vermitteln. Es ist so, als hätte man einen Komponisten, der Gefühle versteht.

Ermöglichen kreativer Zusammenarbeit

Einer der aufregendsten Aspekte von Encodern und Decodern in der generativen KI ist ihr Potenzial, kreative Zusammenarbeit zu erleichtern. Diese KI-Systeme können kreative Werke über verschiedene Medien hinweg verstehen, übersetzen und transformieren und so Lücken zwischen Künstlern, Schriftstellern, Musikern und mehr schließen.

Stellen Sie sich das Gemälde eines Künstlers vor, das in Poesie verwandelt wurde, oder die Melodie eines Musikers, die in visuelle Kunst verwandelt wurde. Dies sind keine weit hergeholten Träume mehr, sondern greifbare Möglichkeiten mit fortschrittlichen Encodern und Decodern. Kooperationen, die zuvor unwahrscheinlich schienen, finden nun einen Weg durch die Sprache der KI.

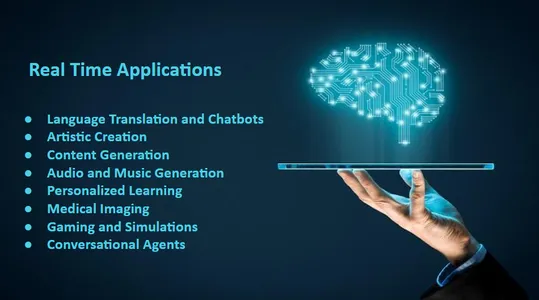

Echtzeitanwendung von Encodern und Decodern in der generativen KI

Echtzeitanwendungen von Encodern und Decodern in der generativen KI bergen ein enormes Potenzial in verschiedenen Bereichen. Diese fortschrittlichen KI-Komponenten beschränken sich nicht auf theoretische Konzepte, sondern verändern aktiv die Art und Weise, wie wir mit Technologie interagieren. Schauen wir uns einige Anwendungsfälle aus der Praxis an:

Sprachübersetzung und Chatbots

Encoder dekodieren und kodieren eine Sprache in eine andere und ermöglichen so eine Sprachübersetzung in Echtzeit. Diese Technologie unterstützt Chatbots, die nahtlos in mehreren Sprachen kommunizieren können und so die globale Kommunikation und den Kundenservice erleichtern.

Dieser Code nutzt die Hugging Face Transformers-Bibliothek, um ein Sprachübersetzungsmodell zu erstellen. Ein Encoder verarbeitet den Eingabetext (Englisch) und ein Decoder generiert den übersetzten Text (Französisch) in Echtzeit.

Künstlerisches Schaffen

Künstler verwenden Encoder, um die Essenz eines Stils oder Genres zu extrahieren, und Decoder erstellen Kunstwerke in diesem Stil neu. Diese Echtzeittransformation ermöglicht eine schnelle Kunstproduktion in verschiedenen Formen, von Renaissance-Gemälden bis hin zu modernen abstrakten Stücken.

Dieser Code nutzt ein Text-zu-Bild-Generierungsmodell aus der Hugging Face Transformers-Bibliothek. Ein Encoder entschlüsselt die Textbeschreibung und ein Decoder generiert ein Bild, das der Beschreibung entspricht, was künstlerisches Schaffen in Echtzeit ermöglicht.

Generierung von Inhalten

Encoder analysieren Textbeschreibungen und Decoder erwecken sie durch Bilder zum Leben und bieten praktische Anwendungen in der Werbung, im E-Commerce und bei der Content-Generierung. Verwandeln Sie die Immobilienangebote in immersive visuelle Erlebnisse, und Produktbeschreibungen können entsprechende visuelle Elemente generieren.

Dieser Code verwendet ein Text-zu-Text-Generierungsmodell von Hugging Face Transformers. Der Encoder verarbeitet eine Textbeschreibung und der Decoder generiert mehrere alternative Beschreibungen für die Inhaltsgenerierung in Echtzeit.

Audio- und Musikgenerierung

Encoder erfassen emotionale Signale in der Stimme und Decoder erzeugen ausdrucksstarke Sprache oder Musik in Echtzeit. Dies findet Anwendung in Sprachassistenten, bei der Erstellung von Audioinhalten und sogar bei der Unterstützung der psychischen Gesundheit, wo KI für beruhigende Gespräche sorgen kann.

Dieser Code verwendet ein Text-to-Speech-Modell, um Text in Sprache (Audio) umzuwandeln. Während die Audiogenerierung in Echtzeit komplexer ist, zeigt dieses vereinfachte Beispiel die Verwendung eines Encoders zum Interpretieren des Eingabetexts und eines Decoders zum Generieren von Audio.

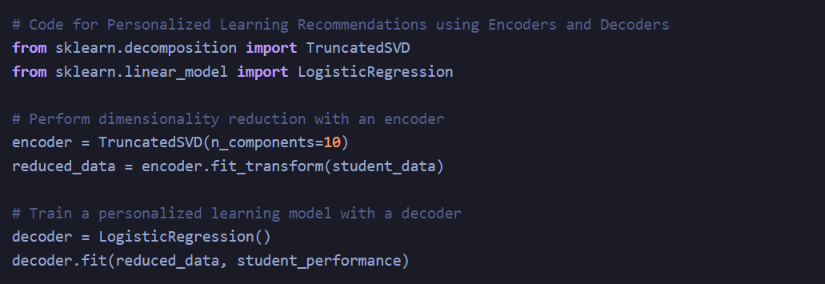

Personalisiertes Lernen

Im Bildungsbereich helfen Encoder und Decoder bei der Erstellung maßgeschneiderter Lernmaterialien. Lehrbücher können in interaktive Lektionen mit visuellen Elementen umgewandelt werden und Sprachlern-Apps können Übersetzungs- und Ausspracheunterstützung in Echtzeit bieten.

Beim personalisierten Lernen kann ein Encoder die Dimensionalität der Schülerdaten reduzieren, und ein Decoder, in diesem Fall ein logistisches Regressionsmodell, kann die Leistung der Schüler auf der Grundlage der reduzierten Daten vorhersagen. Während es sich hierbei um ein vereinfachtes Beispiel handelt, sind personalisierte Lernsysteme in der Regel viel komplexer.

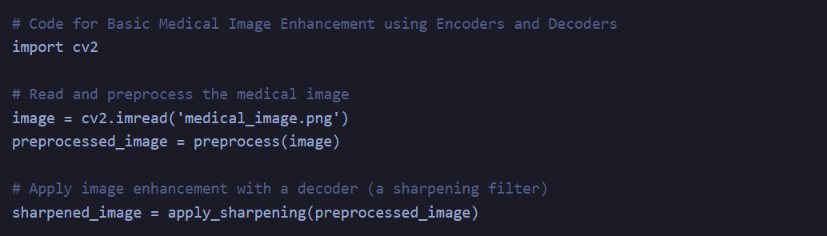

Medizinische Bildgebung

Encoder können medizinische Bilder analysieren und Decoder helfen, Bilder zu verbessern oder Echtzeit-Feedback zu geben. Dies unterstützt Ärzte bei der Diagnose und bei chirurgischen Eingriffen und liefert schnelle und genaue Erkenntnisse.

Dieser Code zeigt ein einfaches Beispiel für die medizinische Bildverbesserung, bei der ein Encoder das Bild verarbeitet und vorverarbeitet und ein Decoder (Schärfungsfilter) die Bildqualität verbessert. Echte medizinische Bildgebungsanwendungen erfordern spezielle Modelle und die sorgfältige Einhaltung von Gesundheitsstandards.

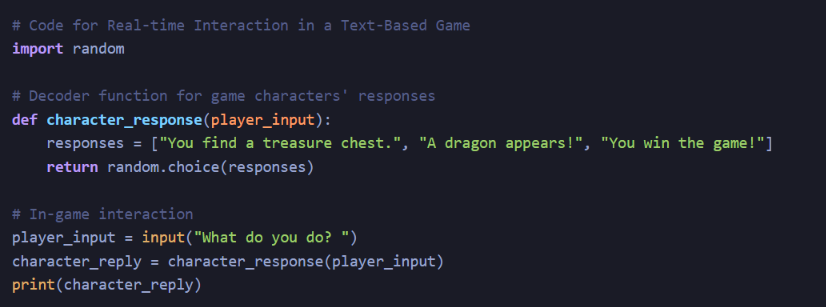

Spiele und Simulationen

Dank Encoder und Decoder ist eine Echtzeitinteraktion mit KI-gesteuerten Charakteren möglich. Diese Charaktere können sich anpassen, reagieren und Spieler realistisch in Videospiele und Trainingssimulationen einbeziehen.

Obwohl dies ein sehr vereinfachtes Beispiel ist, sind bei Spielen und Simulationen Echtzeitinteraktionen mit Charakteren häufig komplexe KI-Systeme erforderlich und Encoder und Decoder werden möglicherweise nicht direkt als eigenständige Komponenten verwendet.

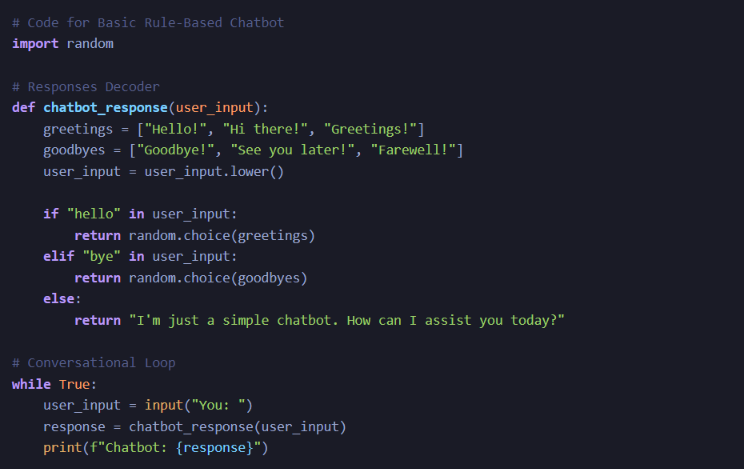

Gesprächsagenten

Encoder helfen Maschinen, menschliche Emotionen und Zusammenhänge zu verstehen, während Decoder es ihnen ermöglichen, einfühlsam zu reagieren. Dies ist für virtuelle Systeme zur Unterstützung der psychischen Gesundheit und KI-Begleiter für ältere Menschen von unschätzbarem Wert.

Hierbei handelt es sich um einen regelbasierten Chatbot, der zwar die Kodierung von Benutzereingaben und die Dekodierung von Antworten umfasst, komplexe Konversationsagenten nutzen jedoch häufig ausgefeilte Modelle zum Verständnis natürlicher Sprache für Empathie und kontextbezogene Antworten.

Diese Echtzeitanwendungen verdeutlichen die transformative Wirkung von Encodern und Decodern in der generativen KI, die über die bloße Theorie hinausgehen und unser tägliches Leben auf bemerkenswerte Weise bereichern.

Erkundung fortgeschrittener Encoder und Decoder

BERT (Bidirektionale Encoder-Darstellungen von Transformatoren)

BERT ist ein Encodermodell, das zum Verstehen von Sprache verwendet wird. Es ist bidirektional, das heißt, es berücksichtigt sowohl den linken als auch den rechten Kontext von Wörtern in einem Satz. Dieses tiefgreifende bidirektionale Training ermöglicht es BERT, den Kontext von Wörtern zu verstehen. Man kann zum Beispiel herausfinden, dass sich „Bank“ im Satz „Ich ging zur Bank“ auf ein Finanzinstitut und im Satz „Ich saß am Ufer“ auf ein Flussufer bezieht. Es wird auf einer riesigen Menge an Textdaten trainiert und lernt, fehlende Wörter in Sätzen vorherzusagen.

- Encoder: Der Encoder von BERT ist bidirektional, d. h. er berücksichtigt sowohl den linken als auch den rechten Kontext eines Wortes in einem Satz. Dieses tiefgreifende bidirektionale Training ermöglicht es ihm, den Kontext von Wörtern zu verstehen, wodurch es sich außerordentlich gut mit verschiedenen Aufgaben zum Verstehen natürlicher Sprache befassen kann.

- Decoder: Während BERT in erster Linie ein Encoder ist, wird es häufig mit anderen Decodern für Aufgaben wie Textgenerierung und Sprachübersetzung kombiniert. Decoder für BERT-basierte Modelle können autoregressive oder in manchen Fällen ein anderer Transformatordecoder sein.

Dieser Code verwendet die Hugging Face-Transformerbibliothek, um ein vorab trainiertes BERT-Modell zum Kodieren von Text zu laden. Es tokenisiert den Eingabetext, wandelt ihn in Eingabe-IDs um und leitet ihn dann durch das BERT-Modell. Der Encoder_output enthält die codierten Darstellungen des Eingabetextes.

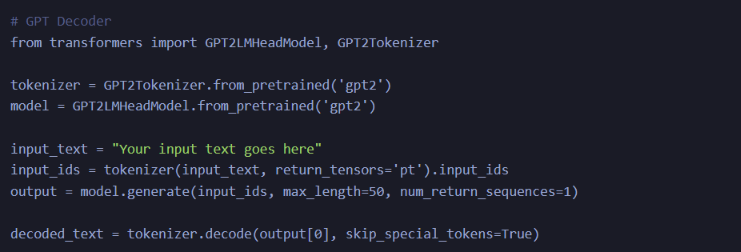

GPT (Generativer vortrainierter Transformer)

GPT-Modelle sind Decoder, die menschenähnlichen Text erzeugen. Sie funktionieren, indem sie das nächste Wort in einer Sequenz basierend auf dem Kontext vorheriger Wörter vorhersagen. Wenn die vorherigen Wörter beispielsweise „Der Himmel ist“ lauten, kann GPT vorhersagen, dass das nächste Wort möglicherweise „blau“ ist. Sie werden an großen Textkorpora geschult, um Grammatik, Stil und Kontext zu lernen.

- Encoder: GPT-Modelle konzentrieren sich auf den Decoder-Aspekt und erzeugen menschenähnlichen Text. Der Decoder von GPT kann jedoch auch als Encoder dienen, indem er sein Sprachmodell umkehrt, wodurch er Informationen effektiv aus Text extrahieren kann.

- Decoder: Der Decoder-Aspekt von GPT macht es faszinierend. Es generiert autoregressiv Text und sagt das nächste Wort basierend auf dem Kontext der vorherigen Wörter voraus. Die Ausgabe ist kohärenter und kontextrelevanter Text.

Dieser Code verwendet die Transformers-Bibliothek von Hugging Face, um ein vorab trainiertes GPT-2-Modell für die Textgenerierung zu laden. Es nimmt einen Eingabetext, tokenisiert ihn und generiert autoregressiv Text mithilfe des GPT-2-Modells.

VAE (Variativer Autoencoder)

VAEs werden zur Bild- und Textgenerierung verwendet. Der Encoder ordnet Eingabedaten einem kontinuierlichen latenten Raum zu, einer niedrigerdimensionalen Darstellung. Es kann beispielsweise Bilder von Katzen auf Punkte in diesem Raum abbilden. Der Decoder generiert dann Bilder aus diesen Punkten. Während des Trainings zielen VAEs darauf ab, diesen latenten Raum glatt und kontinuierlich zu gestalten, um vielfältige und realistische Bilder zu erzeugen.

- Encoder: VAEs werden häufig bei der Bild- und Textgenerierung verwendet. Der Encoder ordnet Eingabedaten einem kontinuierlichen latenten Raum zu, was besonders nützlich ist, um vielfältige, realistische Bilder und Texte zu erzeugen.

- Decoder: Der Decoder ordnet Punkte im latenten Raum wieder dem Datenraum zu. Es generiert Bilder oder Text aus abgetasteten Punkten im latenten Raum.

Dieser Code definiert einen Variational Autoencoder (VAE) in TensorFlow/Keras. Der Encoder nimmt ein Eingabebild, glättet es und ordnet es einem latenten Raum mit Mittelwert und logarithmischer Varianz zu. Der Decoder entnimmt einen Punkt aus dem latenten Raum und rekonstruiert das Bild.

LSTM (langes Kurzzeitgedächtnis)

LSTMs sind wiederkehrende neuronale Netze, die für sequentielle Daten verwendet werden. Sie kodieren sequentielle Daten wie Sätze, indem sie den Kontext vorheriger Elemente in der Sequenz berücksichtigen. Sie lernen Muster in Sequenzen, wodurch sie für Aufgaben wie die Verarbeitung natürlicher Sprache geeignet sind. In Autoencodern reduzieren LSTMs Sequenzen auf niedrigerdimensionale Darstellungen und dekodieren sie.

- Encoder: LSTM ist ein wiederkehrender neuronaler Netzwerktyp (RNN), der häufig für verschiedene sequentielle Datenaufgaben wie die Verarbeitung natürlicher Sprache verwendet wird. Die LSTM-Zelle codiert sequentielle Daten, indem sie den Kontext vorheriger Elemente in der Sequenz berücksichtigt.

- Decoder: Während LSTMs häufiger als Encoder verwendet werden, können sie auch mit einem anderen LSTM oder vollständig verbundenen Schichten gepaart werden, um als Decoder für die Generierung von Sequenzen zu fungieren.

Dieser Code richtet einen einfachen LSTM-Autoencoder ein. Der Encoder verarbeitet Sequenzen und reduziert sie auf eine niedrigerdimensionale Darstellung, während der Decoder Sequenzen aus der codierten Darstellung rekonstruiert.

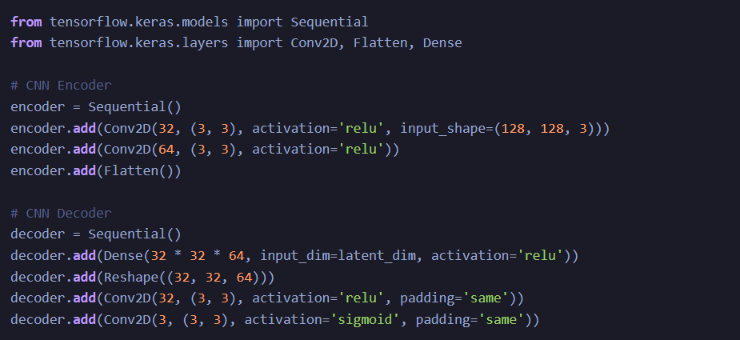

CNN (Faltungs-Neuronales Netzwerk)

CNNs werden hauptsächlich zur Bildanalyse verwendet. Sie fungieren als Encoder, indem sie Bilder über Faltungsschichten analysieren und Merkmale wie Kanten, Formen und Texturen erfassen. Diese Funktionen können an einen Decoder wie ein GAN gesendet werden, um neue Bilder zu generieren. CNNs werden darauf trainiert, Muster und Merkmale in Bildern zu erkennen.

- Encoder: CNNs werden hauptsächlich bei Computer-Vision-Aufgaben als Encoder verwendet. Sie analysieren Bilder, indem sie Filter über die Eingabe falten und so Merkmale in verschiedenen Maßstäben erfassen. Die extrahierten Merkmale können einem Decoder für Aufgaben wie die Bilderzeugung zugeführt werden.

- Decoder: Bei der Bilderzeugung kann auf CNNs ein Decoder folgen, beispielsweise ein GAN-Decoder (Generative Adversarial Network), um Bilder basierend auf erlernten Merkmalen zu synthetisieren.

Diese fortschrittlichen Encoder- und Decodermodelle bilden das Rückgrat vieler generativer KI-Anwendungen. Ihre Flexibilität und Anpassungsfähigkeit haben es Forschern und Entwicklern ermöglicht, die Grenzen des Machbaren in der Verarbeitung natürlicher Sprache, Computer Vision und verschiedenen anderen Bereichen zu erweitern. Während sich die KI weiterentwickelt, werden diese Modelle weiterhin an der Spitze der Innovation stehen.

Diese Modelle durchlaufen ein umfangreiches Training an großen Datensätzen, um die Nuancen ihrer jeweiligen Aufgaben kennenzulernen. Sie sind auf die Ausführung bestimmter Funktionen abgestimmt und stehen an der Spitze der KI-Innovation.

Fallstudien zu fortgeschrittenen Encodern und Decodern

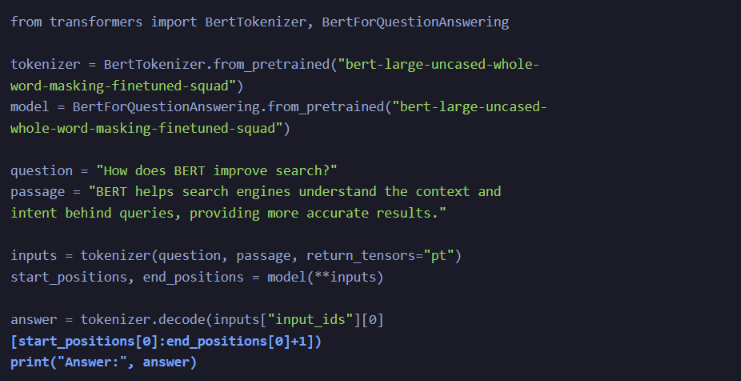

BERT in Suchmaschinen

- Google nutzt BERT, um seine Suchmaschinenergebnisse zu verbessern. BERT hilft dabei, den Kontext und die Absicht hinter Suchanfragen besser zu verstehen. Wenn Sie beispielsweise nach „2019 Brasilien-Reisender in die USA benötigen ein Visum“ suchen, haben sich herkömmliche Suchmaschinen möglicherweise auf das Schlüsselwort „Visum“ konzentriert. Mit BERT geht Google jedoch davon aus, dass der Nutzer Informationen über einen Brasilianer, der in die USA reist, und seine Visabestimmungen sucht.

- Das BERT-basierte Suchmodell von Google kann mithilfe der Hugging Face Transformers-Bibliothek demonstriert werden. Dieser Code zeigt, wie ein BERT-basiertes Modell verwendet wird, um das Verständnis von Suchanfragen zu verbessern:

Dieser Code verwendet BERT, um Suchergebnisse zu verbessern, indem er Benutzeranfragen und Dokumentkontext versteht, was zu genaueren Antworten führt.

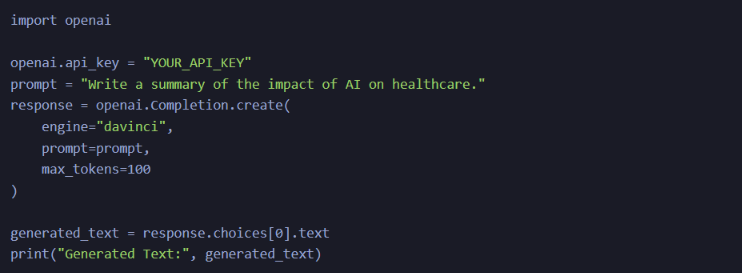

GPT-3 in der Inhaltsgenerierung

- Verwenden Sie GPT-3 von OpenAI, um Inhalte für verschiedene Anwendungen zu generieren. Es kann Artikel schreiben, Fragen beantworten und sogar Gesprächsagenten erstellen. Unternehmen nutzen GPT-3, um die Inhaltserstellung, den Kundensupport und virtuelle Assistenten zu automatisieren.

- GPT-3 von OpenAI kann Text für verschiedene Anwendungen generieren. Nachfolgend finden Sie ein Beispiel für die Verwendung der OpenAI GPT-3-API zur Inhaltsgenerierung:

Mit GPT-3 können Sie mithilfe der OpenAI-API menschenähnlichen Text für Aufgaben wie die Erstellung von Inhalten oder Chatbots generieren.

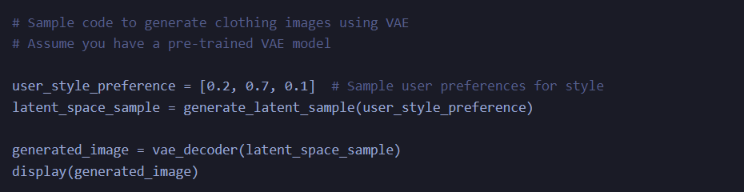

VAEs in der Bilderzeugung

- VAEs haben Anwendungen in der Bilderzeugung für Mode. Unternehmen wie Stitch Fix nutzen VAEs, um personalisierte Kleidungsempfehlungen für Benutzer zu erstellen. Indem sie die Stilpräferenzen der Benutzer kennen, können sie Bilder von Kleidungsstücken erstellen, die wahrscheinlich von Interesse sind.

- Die Verwendung von VAEs zur Bildgenerierung kann mit Code demonstriert werden, der neue Bilder basierend auf Benutzerpräferenzen generiert, ähnlich wie Stitch Fix.

Dieser Codeausschnitt veranschaulicht, wie Variational Autoencoder (VAEs) Bilder basierend auf Benutzerpräferenzen erstellen können, ähnlich wie Stitch Fix Kleidung basierend auf Stilpräferenzen vorschlägt.

LSTMs in der Spracherkennung

- Spracherkennungssysteme, wie sie von Amazons Alexa oder Apples Siri verwendet werden, nutzen häufig LSTMs. Sie verarbeiten Audiodaten und wandeln sie in Text um. Diese Modelle müssen den Kontext früherer Laute berücksichtigen, um Sprache genau zu transkribieren.

- LSTMs werden häufig bei der Spracherkennung verwendet. Nachfolgend finden Sie ein vereinfachtes Beispiel für die Verwendung eines LSTM-basierten Modells zur Spracherkennung:

Dieser Code richtet ein LSTM-basiertes Spracherkennungsmodell ein, eine grundlegende Technologie für Sprachassistenten und Transkriptionsdienste.

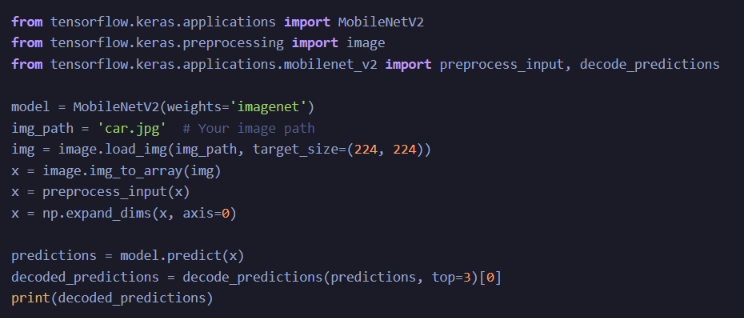

CNNs in autonomen Fahrzeugen

- Autonome Fahrzeuge sind für die Bildanalyse in Echtzeit auf CNNs angewiesen. Sie können Objekte wie Fußgänger, andere Fahrzeuge und Verkehrszeichen identifizieren. Dies ist wichtig, um beim Fahren sekundenschnelle Entscheidungen zu treffen.

- Autonome Fahrzeuge sind zur Objekterkennung auf CNNs angewiesen. Hier ist ein vereinfachtes Beispiel für die Verwendung eines vorab trainierten CNN-Modells zur Objekterkennung:

Im Zusammenhang mit autonomen Fahrzeugen können CNNs wie MobileNetV2 Objekte in Bildern erkennen, um selbstfahrenden Autos bei der Entscheidungsfindung auf der Straße zu helfen.

Diese Codeausschnitte bieten eine praktische Demonstration, wie diese KI-Techniken in verschiedenen realen Szenarien angewendet werden können. Bitte beachten Sie, dass reale Implementierungen oft komplexer sind und umfangreiche Datensätze verwenden, diese Beispiele bieten jedoch eine vereinfachte Sicht auf ihre Anwendung.

Ethischer und verantwortungsvoller Gebrauch

Wie bei jedem leistungsstarken Werkzeug ist der ethische Einsatz fortschrittlicher Encoder und Decoder von größter Bedeutung. Es ist von entscheidender Bedeutung, sicherzustellen, dass KI-generierte Inhalte das Urheberrecht respektieren, die Privatsphäre wahren und kein schädliches oder anstößiges Material verbreiten. Darüber hinaus sind Verantwortlichkeit und Transparenz im kreativen Prozess von entscheidender Bedeutung, insbesondere wenn KI eine wichtige Rolle spielt.

Zusammenfassung

Die Verschmelzung fortschrittlicher Encoder und Decoder in der generativen KI markiert eine neue Ära der Kreativität, in der die Grenzen zwischen verschiedenen Kunst- und Kommunikationsformen verschwimmen. Ob es darum geht, Sprachen zu übersetzen, Kunststile nachzubilden oder Text in Bilder umzuwandeln – diese KI-Komponenten sind der Schlüssel zur Erschließung innovativer, kollaborativer und ethisch verantwortungsvoller Kreativität. Bei verantwortungsvollem Umgang können sie die Art und Weise verändern, wie wir unsere Welt wahrnehmen und ausdrücken.

Key Take Away

- Encoder und Decoder in der generativen KI verändern die Art und Weise, wie wir Kunst, Sprache und Daten erstellen, interpretieren und mit ihnen interagieren.

- Diese KI-Komponenten spielen eine wesentliche Rolle beim Verstehen und Generieren verschiedener Datenformen, darunter Text, Bilder und Audio.

- Echtzeitanwendungen von Encodern und Decodern umfassen Sprachübersetzung, Kunstgenerierung, Inhaltserstellung, Audiogenerierung, personalisiertes Lernen, medizinische Bildgebung, Spiele und Konversationsagenten.

- Eine ethische und verantwortungsvolle Nutzung von KI-generierten Inhalten ist von entscheidender Bedeutung, wobei der Schwerpunkt auf Datenschutz, Transparenz und Verantwortlichkeit liegt.

Häufig gestellte Fragen

Q1. Was sind Encoder und Decoder in der generativen KI?

A. Encoder sind KI-Komponenten, die wichtige Informationen aus Daten verstehen und extrahieren, während Decoder auf der Grundlage dieser Informationen kreative Ergebnisse generieren.

Q2. Welchen Nutzen haben Encoder und Decoder für den kreativen Prozess?

A. Sie ermöglichen Sprachübersetzungen in Echtzeit, Kunsterstellung, Inhaltsgenerierung, Audio- und Musikgenerierung, personalisiertes Lernen und mehr.

Q3. Welche Echtzeitanwendungen von Encodern und Decodern in der KI gibt es?

A. Zu diesen Anwendungen gehören Sprachübersetzung, Kunstgenerierung, Inhaltserstellung, Audiogenerierung, medizinische Bildverbesserung, interaktive Spiele und einfühlsame Gesprächsagenten.

Q4. Wie fördern Encoder und Decoder die kreative Zusammenarbeit?

A. Sie schließen Lücken zwischen verschiedenen kreativen Medien und ermöglichen Künstlern, Schriftstellern und Musikern die Zusammenarbeit an Projekten, die mehrere Ausdrucksformen beinhalten.

Die in diesem Artikel gezeigten Medien sind nicht Eigentum von Analytics Vidhya und werden nach Ermessen des Autors verwendet.

Verbunden

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoData.Network Vertikale generative KI. Motiviere dich selbst. Hier zugreifen.

- PlatoAiStream. Web3-Intelligenz. Wissen verstärkt. Hier zugreifen.

- PlatoESG. Kohlenstoff, CleanTech, Energie, Umwelt, Solar, Abfallwirtschaft. Hier zugreifen.

- PlatoHealth. Informationen zu Biotechnologie und klinischen Studien. Hier zugreifen.

- Quelle: https://www.analyticsvidhya.com/blog/2023/10/advanced-encoders-and-decoders-in-generative-ai/