يسعدنا اليوم أن نعلن أن حارس اللاما النموذج متاح الآن للعملاء الذين يستخدمون أمازون سيج ميكر جومب ستارت. يوفر Llama Guard ضمانات المدخلات والمخرجات في نشر نماذج اللغات الكبيرة (LLM). إنه أحد مكونات مبادرة Purple Llama، Meta التي تتميز بأدوات وتقييمات للثقة المفتوحة والسلامة لمساعدة المطورين على البناء بشكل مسؤول باستخدام نماذج الذكاء الاصطناعي. يجمع برنامج Purple Llama بين الأدوات والتقييمات لمساعدة المجتمع على البناء بشكل مسؤول باستخدام نماذج الذكاء الاصطناعي التوليدية. يتضمن الإصدار الأولي التركيز على الأمن السيبراني وضمانات المدخلات والمخرجات LLM. المكونات الموجودة في مشروع Purple Llama، بما في ذلك نموذج Llama Guard، مرخصة بشكل مسموح، مما يتيح الاستخدام البحثي والتجاري.

يمكنك الآن استخدام نموذج Llama Guard داخل SageMaker JumpStart. SageMaker JumpStart هو مركز التعلم الآلي (ML). الأمازون SageMaker التي توفر الوصول إلى نماذج الأساس بالإضافة إلى الخوارزميات المضمنة وقوالب الحلول الشاملة لمساعدتك على البدء بسرعة مع ML.

في هذا المنشور، نتعرف على كيفية نشر نموذج Llama Guard وبناء حلول الذكاء الاصطناعي المسؤولة.

نموذج حارس اللاما

Llama Guard هو نموذج جديد من Meta يوفر حواجز حماية للمدخلات والمخرجات لعمليات نشر LLM. Llama Guard هو نموذج متاح بشكل مفتوح ويعمل بشكل تنافسي وفقًا للمعايير المفتوحة المشتركة ويوفر للمطورين نموذجًا مدربًا مسبقًا للمساعدة في الدفاع ضد توليد مخرجات يحتمل أن تكون محفوفة بالمخاطر. تم تدريب هذا النموذج على مزيج من مجموعات البيانات المتاحة للعامة لتمكين اكتشاف الأنواع الشائعة من المحتوى الذي يحتمل أن يكون خطيرًا أو مخالفًا والذي قد يكون ذا صلة بعدد من حالات استخدام المطورين. في نهاية المطاف، تتمثل رؤية النموذج في تمكين المطورين من تخصيص هذا النموذج لدعم حالات الاستخدام ذات الصلة وتسهيل اعتماد أفضل الممارسات وتحسين النظام البيئي المفتوح.

يمكن استخدام Llama Guard كأداة تكميلية للمطورين للاندماج في استراتيجيات التخفيف الخاصة بهم، مثل برامج الدردشة الآلية والإشراف على المحتوى وخدمة العملاء ومراقبة وسائل التواصل الاجتماعي والتعليم. من خلال تمرير المحتوى الذي أنشأه المستخدم عبر Llama Guard قبل نشره أو الرد عليه، يمكن للمطورين الإبلاغ عن لغة غير آمنة أو غير مناسبة واتخاذ الإجراءات اللازمة للحفاظ على بيئة آمنة ومحترمة.

دعنا نستكشف كيف يمكننا استخدام نموذج Llama Guard في SageMaker JumpStart.

نماذج الأساس في SageMaker

يوفر SageMaker JumpStart إمكانية الوصول إلى مجموعة من النماذج من مراكز النماذج الشائعة، بما في ذلك Hugging Face وPyTorch Hub وTensorFlow Hub، والتي يمكنك استخدامها ضمن سير عمل تطوير تعلم الآلة في SageMaker. أدت التطورات الأخيرة في تعلم الآلة إلى ظهور فئة جديدة من النماذج المعروفة باسم نماذج الأساس، والتي يتم تدريبها عادةً على مليارات المعلمات وتكون قابلة للتكيف مع فئة واسعة من حالات الاستخدام، مثل تلخيص النص وتوليد الفن الرقمي وترجمة اللغة. نظرًا لأن تدريب هذه النماذج مكلف، يرغب العملاء في استخدام النماذج الأساسية الحالية المدربة مسبقًا وضبطها حسب الحاجة، بدلاً من تدريب هذه النماذج بأنفسهم. يوفر SageMaker قائمة منسقة من النماذج التي يمكنك الاختيار من بينها على وحدة تحكم SageMaker.

يمكنك الآن العثور على نماذج الأساس من موفري نماذج مختلفين داخل SageMaker JumpStart، مما يتيح لك بدء استخدام النماذج الأساسية بسرعة. يمكنك العثور على نماذج أساسية بناءً على مهام مختلفة أو موفري نماذج، ومراجعة خصائص النموذج وشروط الاستخدام بسهولة. يمكنك أيضًا تجربة هذه النماذج باستخدام أداة اختبار واجهة المستخدم. عندما تريد استخدام نموذج أساسي على نطاق واسع، يمكنك القيام بذلك بسهولة دون مغادرة SageMaker باستخدام دفاتر الملاحظات المعدة مسبقًا من موفري النماذج. ونظرًا لاستضافة النماذج ونشرها على AWS، يمكنك الاطمئنان إلى أن بياناتك، سواء كانت مستخدمة لتقييم النموذج أو استخدامه على نطاق واسع، لن تتم مشاركتها مع أطراف ثالثة أبدًا.

دعنا نستكشف كيف يمكننا استخدام نموذج Llama Guard في SageMaker JumpStart.

اكتشف نموذج Llama Guard في SageMaker JumpStart

يمكنك الوصول إلى النماذج الأساسية لـ Code Llama من خلال SageMaker JumpStart في SageMaker Studio UI وSageMaker Python SDK. في هذا القسم، سنتعرف على كيفية اكتشاف النماذج الموجودة أمازون ساجميكر ستوديو.

SageMaker Studio عبارة عن بيئة تطوير متكاملة (IDE) توفر واجهة مرئية واحدة قائمة على الويب حيث يمكنك الوصول إلى الأدوات المصممة لغرض تنفيذ جميع خطوات تطوير ML ، من إعداد البيانات إلى البناء والتدريب ونشر نماذج ML الخاصة بك. لمزيد من التفاصيل حول كيفية البدء وإعداد SageMaker Studio ، يرجى الرجوع إلى أمازون ساجميكر ستوديو.

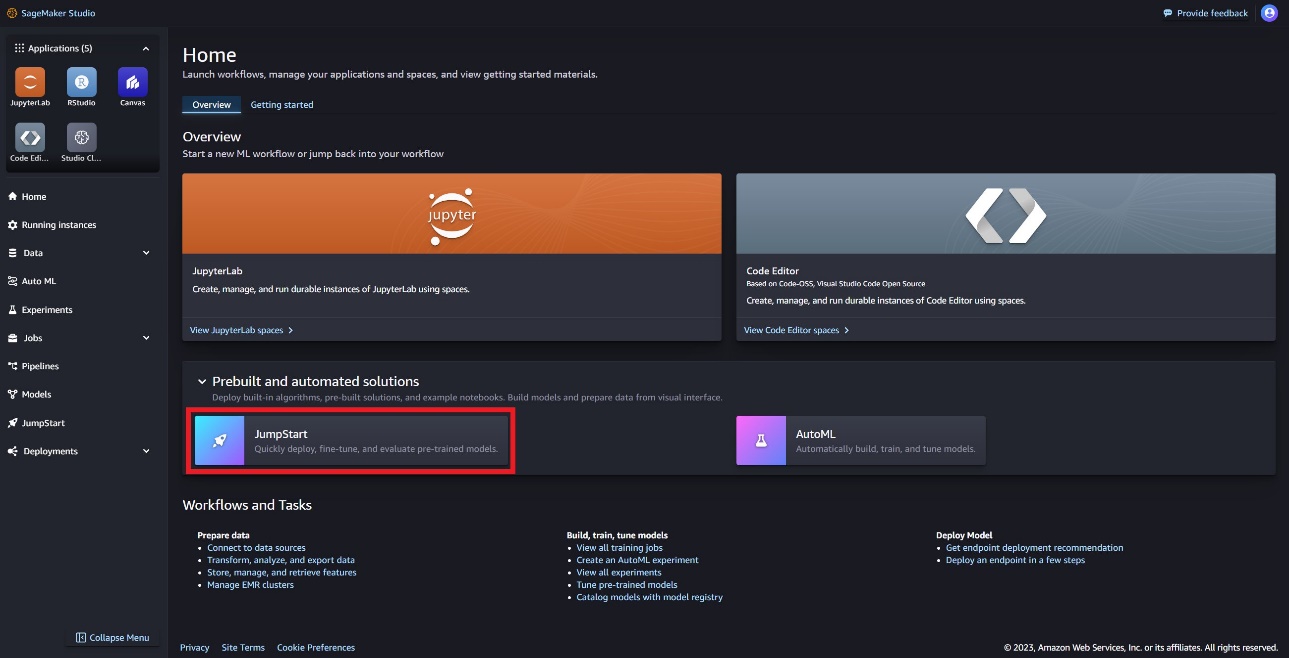

في SageMaker Studio، يمكنك الوصول إلى SageMaker JumpStart، الذي يحتوي على نماذج ودفاتر ملاحظات وحلول تم إنشاؤها مسبقًا، ضمن حلول آلية ومبنية مسبقًا.

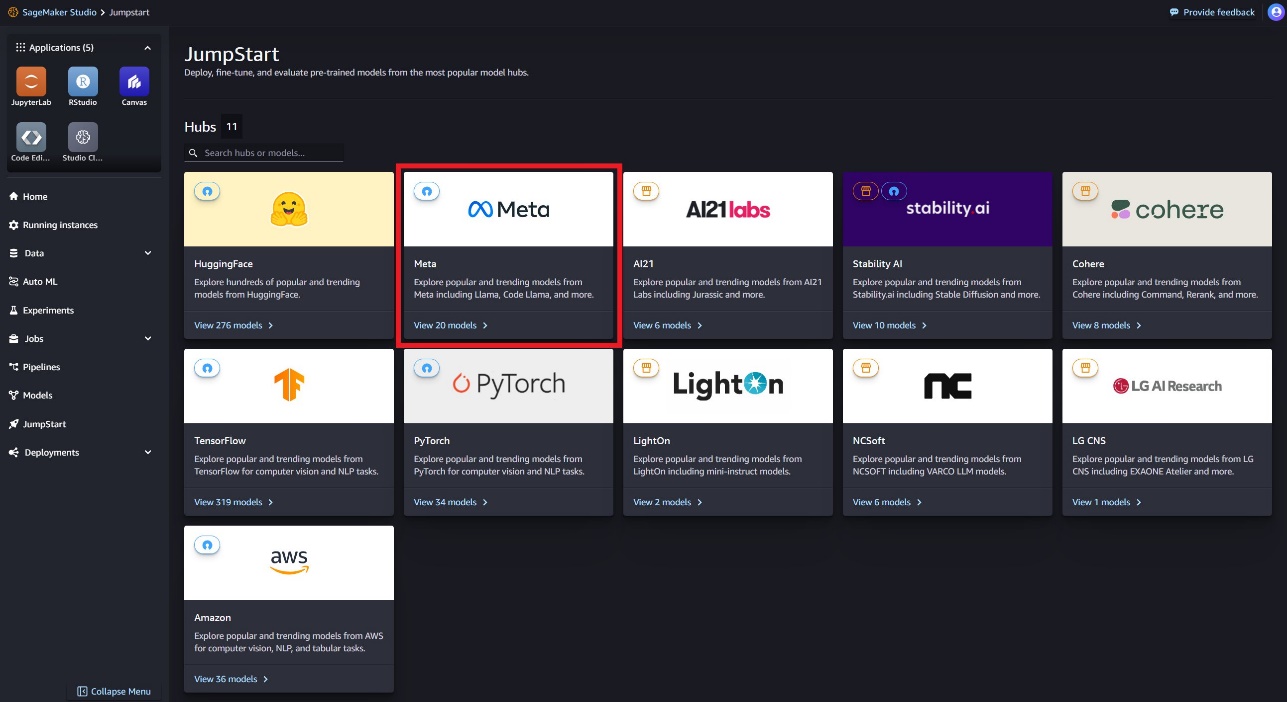

في الصفحة المقصودة لـ SageMaker JumpStart، يمكنك العثور على نموذج Llama Guard عن طريق اختيار مركز Meta أو البحث عن Llama Guard.

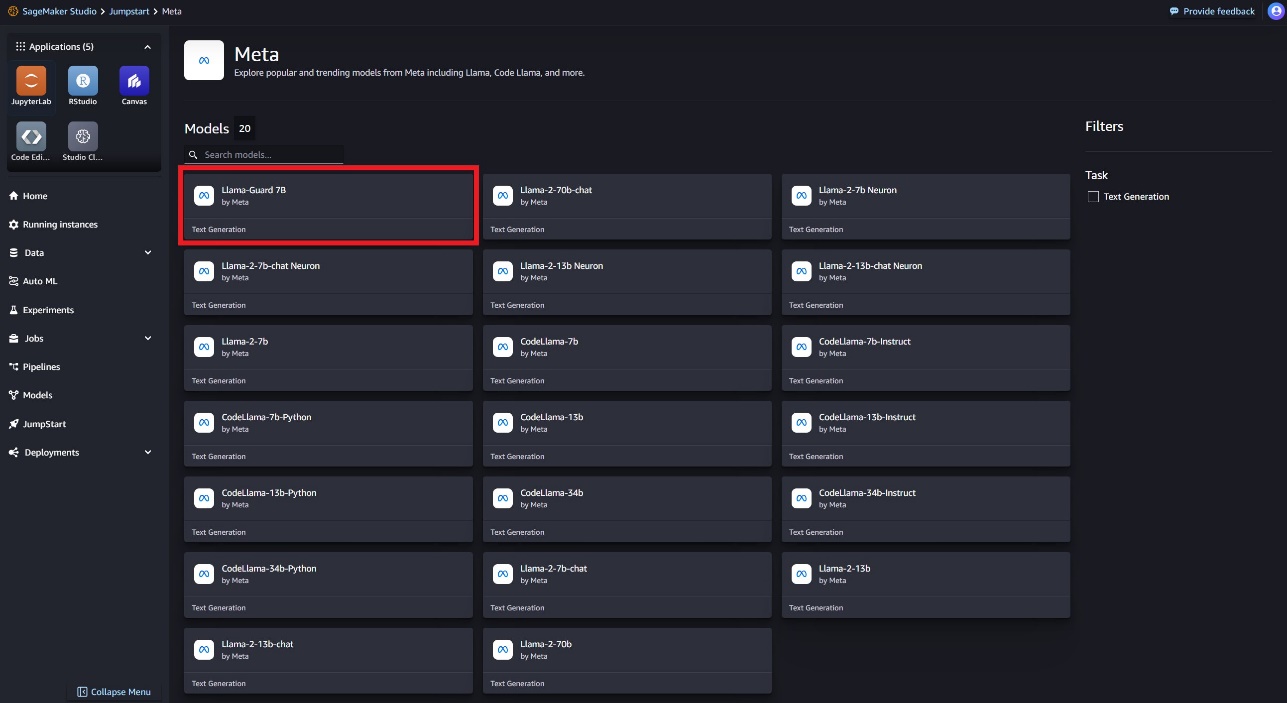

يمكنك الاختيار من بين مجموعة متنوعة من نماذج Llama، بما في ذلك Llama Guard وLlama-2 وCode Llama.

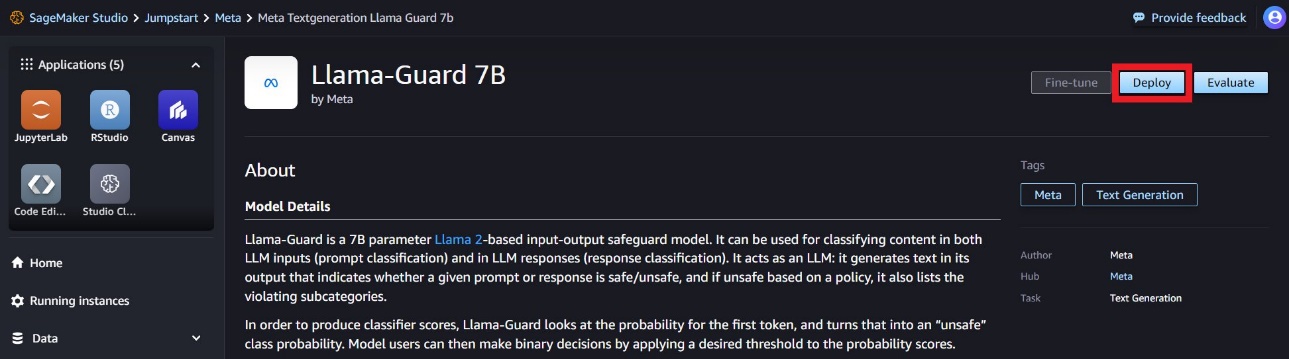

يمكنك اختيار بطاقة النموذج لعرض تفاصيل حول النموذج مثل الترخيص والبيانات المستخدمة للتدريب وكيفية الاستخدام. سوف تجد أيضا أ نشر الخيار، والذي سينقلك إلى الصفحة المقصودة حيث يمكنك اختبار الاستدلال باستخدام مثال للحمولة.

انشر النموذج باستخدام SageMaker Python SDK

يمكنك العثور على الكود الذي يوضح نشر Llama Guard على Amazon JumpStart ومثال لكيفية استخدام النموذج المنشور في دفتر جيثب.

في التعليمات البرمجية التالية، نحدد معرف نموذج مركز نموذج SageMaker وإصدار النموذج لاستخدامه عند نشر Llama Guard:

يمكنك الآن نشر النموذج باستخدام SageMaker JumpStart. يستخدم التعليمة البرمجية التالية المثيل الافتراضي ml.g5.2xlarge لنقطة نهاية الاستدلال. يمكنك نشر النموذج على أنواع المثيلات الأخرى عن طريق التمرير instance_type في ال JumpStartModel فصل. قد يستغرق النشر بضع دقائق. للنشر الناجح، يجب عليك تغيير ملف accept_eula الوسيطة في طريقة نشر النموذج True.

يتم نشر هذا النموذج باستخدام حاوية التعلم العميق لاستدلال إنشاء النص (TGI). تدعم طلبات الاستدلال العديد من المعلمات، بما في ذلك ما يلي:

- الحد الاقصى للطول - يولد النموذج نصًا حتى يصل طول الإخراج (الذي يتضمن طول سياق الإدخال)

max_length. إذا تم تحديده ، يجب أن يكون عددًا صحيحًا موجبًا. - max_new_tokens - يقوم النموذج بإنشاء نص حتى يصل طول الإخراج (باستثناء طول سياق الإدخال).

max_new_tokens. إذا تم تحديده ، يجب أن يكون عددًا صحيحًا موجبًا. - عدد_الكتف – يشير هذا إلى عدد الحزم المستخدمة في البحث الجشع. إذا تم تحديده، فيجب أن يكون عددًا صحيحًا أكبر من أو يساوي

num_return_sequences. - no_repeat_ngram_size - يضمن النموذج تسلسل كلمات

no_repeat_ngram_sizeلا يتكرر في تسلسل الإخراج. إذا تم تحديده ، يجب أن يكون عددًا صحيحًا موجبًا أكبر من 1. - درجة الحرارة - تتحكم هذه المعلمة في العشوائية في الإخراج. أعلى

temperatureيؤدي إلى تسلسل إخراج بكلمات ذات احتمالية منخفضة، وأقلtemperatureيؤدي إلى تسلسل إخراج بكلمات ذات احتمالية عالية. لوtemperatureهو 0، فإنه يؤدي إلى فك التشفير الجشع. إذا تم تحديده، يجب أن يكون تعويمًا إيجابيًا. - في وقت مبكر - إذا

True، يتم الانتهاء من إنشاء النص عندما تصل جميع فرضيات الشعاع إلى نهاية الجملة المميزة. إذا تم تحديده، فيجب أن يكون منطقيًا. - do_sample - إذا

True، يقوم النموذج باختبار الكلمة التالية حسب الاحتمالية. إذا تم تحديده، فيجب أن يكون منطقيًا. - top_k - في كل خطوة من خطوات إنشاء النص، يتم أخذ عينات النموذج من الملف فقط

top_kعلى الأرجح الكلمات. إذا تم تحديده ، يجب أن يكون عددًا صحيحًا موجبًا. - top_p - في كل خطوة من خطوات إنشاء النص، يأخذ النموذج عينات من أصغر مجموعة ممكنة من الكلمات ذات الاحتمالية التراكمية

top_p. إذا تم تحديده ، يجب أن يكون عددًا عشريًا بين 0-1. - return_full_text - إذا

True، سيكون نص الإدخال جزءًا من النص الناتج الذي تم إنشاؤه. إذا تم تحديده، فيجب أن يكون منطقيًا. القيمة الافتراضية هيFalse. - توقف - إذا تم تحديدها، يجب أن تكون قائمة من السلاسل. يتوقف إنشاء النص في حالة إنشاء أي من السلاسل المحددة.

قم باستدعاء نقطة نهاية SageMaker

يمكنك استرداد أمثلة الحمولات برمجيًا من ملف JumpStartModel هدف. سيساعدك هذا على البدء سريعًا من خلال مراقبة تعليمات التعليمات المنسقة مسبقًا والتي يمكن لـ Llama Guard استيعابها. انظر الكود التالي:

بعد تشغيل المثال السابق، يمكنك رؤية كيفية تنسيق المدخلات والمخرجات بواسطة Llama Guard:

على غرار Llama-2، يستخدم Llama Guard رموزًا خاصة للإشارة إلى تعليمات السلامة للنموذج. بشكل عام، يجب أن تتبع الحمولة التنسيق التالي:

تظهر مطالبة المستخدم كـ {user_prompt} أعلاه، يمكن أن يتضمن أيضًا أقسامًا لتعريفات فئة المحتوى والمحادثات، والتي تبدو كما يلي:

في القسم التالي، سنناقش القيم الافتراضية الموصى بها للمهمة وفئة المحتوى وتعريفات التعليمات. يجب أن تكون المحادثة بالتناوب بين User و Agent النص على النحو التالي:

الإشراف على محادثة مع Llama-2 Chat

يمكنك الآن نشر نقطة نهاية نموذج Llama-2 7B Chat للدردشة التحادثية ثم استخدام Llama Guard للإشراف على نص الإدخال والإخراج الوارد من Llama-2 7B Chat.

نعرض لك مثالًا على إدخال وإخراج نموذج الدردشة Llama-2 7B الذي يتم الإشراف عليه من خلال Llama Guard، ولكن يمكنك استخدام Llama Guard للإشراف مع أي LLM من اختيارك.

انشر النموذج بالكود التالي:

يمكنك الآن تحديد قالب مهمة Llama Guard. يمكن تعديل فئات المحتوى غير الآمن حسب الرغبة لحالة الاستخدام المحددة الخاصة بك. يمكنك تحديد معنى كل فئة محتوى بنص عادي، بما في ذلك المحتوى الذي يجب وضع علامة عليه على أنه غير آمن والمحتوى الذي يجب السماح به باعتباره آمنًا. انظر الكود التالي:

بعد ذلك، نحدد الوظائف المساعدة format_chat_messages و format_guard_messages لتنسيق المطالبة لنموذج الدردشة ونموذج Llama Guard الذي يتطلب رموزًا خاصة:

يمكنك بعد ذلك استخدام هذه الوظائف المساعدة في مثال لمطالبة إدخال الرسالة لتشغيل إدخال المثال من خلال Llama Guard لتحديد ما إذا كان محتوى الرسالة آمنًا:

يشير الإخراج التالي إلى أن الرسالة آمنة. قد تلاحظ أن الموجه يتضمن كلمات قد تكون مرتبطة بالعنف، ولكن في هذه الحالة، يستطيع Llama Guard فهم السياق فيما يتعلق بالتعليمات وتعريفات الفئات غير الآمنة التي قدمناها سابقًا وتحديد أنها مطالبة آمنة وليست كذلك. المتعلقة بالعنف.

الآن بعد أن تأكدت من أن النص المُدخل تم تحديده ليكون آمنًا فيما يتعلق بفئات محتوى Llama Guard، يمكنك تمرير هذه الحمولة إلى نموذج Llama-2 7B الذي تم نشره لإنشاء نص:

وفيما يلي الرد من النموذج:

وأخيرًا، قد ترغب في التأكد من أن نص الاستجابة من النموذج مصمم ليحتوي على محتوى آمن. هنا، يمكنك توسيع استجابة إخراج LLM إلى رسائل الإدخال وتشغيل هذه المحادثة بأكملها من خلال Llama Guard للتأكد من أن المحادثة آمنة لتطبيقك:

قد ترى الإخراج التالي، مما يشير إلى أن الاستجابة من نموذج الدردشة آمنة:

تنظيف

بعد اختبار نقاط النهاية، تأكد من حذف نقاط نهاية استدلال SageMaker والنموذج لتجنب تكبد رسوم.

وفي الختام

في هذا المنشور، أوضحنا لك كيف يمكنك تعديل المدخلات والمخرجات باستخدام Llama Guard ووضع حواجز حماية للمدخلات والمخرجات من LLMs في SageMaker JumpStart.

مع استمرار تقدم الذكاء الاصطناعي، من المهم إعطاء الأولوية للتطوير والنشر المسؤول. تلعب أدوات مثل CyberSecEval من Purple Llama وLlama Guard دورًا فعالًا في تعزيز الابتكار الآمن، وتقديم تحديد مبكر للمخاطر وإرشادات التخفيف لنماذج اللغة. يجب أن تكون هذه الأمور متأصلة في عملية تصميم الذكاء الاصطناعي لتسخير إمكاناته الكاملة لماجستير القانون بشكل أخلاقي منذ اليوم الأول.

جرب Llama Guard ونماذج الأساس الأخرى في SageMaker JumpStart اليوم وأخبرنا بتعليقاتك!

هذا التوجيه هو لأغراض إعلامية فقط. لا يزال يتعين عليك إجراء تقييمك المستقل، واتخاذ التدابير اللازمة لضمان امتثالك لممارسات ومعايير مراقبة الجودة المحددة الخاصة بك، والقواعد والقوانين واللوائح والتراخيص وشروط الاستخدام المحلية التي تنطبق عليك وعلى المحتوى الخاص بك، ونموذج الطرف الثالث المشار إليه في هذا التوجيه. ليس لدى AWS أي سيطرة أو سلطة على نموذج الطرف الثالث المشار إليه في هذا التوجيه، ولا تقدم أي تعهدات أو ضمانات بأن نموذج الطرف الثالث آمن أو خالي من الفيروسات أو تشغيلي أو متوافق مع بيئة ومعايير الإنتاج الخاصة بك. لا تقدم AWS أي إقرارات أو ضمانات أو ضمانات بأن أي معلومات واردة في هذا التوجيه ستؤدي إلى نتيجة أو نتيجة معينة.

عن المؤلفين

دكتور كايل أولريش هو عالم تطبيقي مع خوارزميات Amazon SageMaker المضمنة فريق. تشمل اهتماماته البحثية خوارزميات التعلم الآلي القابلة للتطوير ، والرؤية الحاسوبية ، والسلاسل الزمنية ، والمعاملات البايزية غير البارامترية ، والعمليات الغاوسية. حصل على درجة الدكتوراه من جامعة ديوك وقد نشر أبحاثًا في NeurIPS و Cell و Neuron.

دكتور كايل أولريش هو عالم تطبيقي مع خوارزميات Amazon SageMaker المضمنة فريق. تشمل اهتماماته البحثية خوارزميات التعلم الآلي القابلة للتطوير ، والرؤية الحاسوبية ، والسلاسل الزمنية ، والمعاملات البايزية غير البارامترية ، والعمليات الغاوسية. حصل على درجة الدكتوراه من جامعة ديوك وقد نشر أبحاثًا في NeurIPS و Cell و Neuron.

ايفان كرافيتز هو مهندس برمجيات في Amazon Web Services، ويعمل على SageMaker JumpStart. إنه مهتم بدمج التعلم الآلي مع الحوسبة السحابية. حصل إيفان على شهادته الجامعية من جامعة كورنيل ودرجة الماجستير من جامعة كاليفورنيا، بيركلي. وفي عام 2021، قدم ورقة بحثية حول الشبكات العصبية العدائية في مؤتمر ICLR. في أوقات فراغه، يستمتع إيفان بالطهي والسفر والجري في مدينة نيويورك.

ايفان كرافيتز هو مهندس برمجيات في Amazon Web Services، ويعمل على SageMaker JumpStart. إنه مهتم بدمج التعلم الآلي مع الحوسبة السحابية. حصل إيفان على شهادته الجامعية من جامعة كورنيل ودرجة الماجستير من جامعة كاليفورنيا، بيركلي. وفي عام 2021، قدم ورقة بحثية حول الشبكات العصبية العدائية في مؤتمر ICLR. في أوقات فراغه، يستمتع إيفان بالطهي والسفر والجري في مدينة نيويورك.

راتشنا شادا هو مهندس الحلول الرئيسي AI / ML في الحسابات الإستراتيجية في AWS. راتشنا متفائل يؤمن بأن الاستخدام الأخلاقي والمسؤول للذكاء الاصطناعي يمكن أن يحسن المجتمع في المستقبل ويحقق الرخاء الاقتصادي والاجتماعي. في أوقات فراغها ، تحب راتشنا قضاء الوقت مع عائلتها والمشي لمسافات طويلة والاستماع إلى الموسيقى.

راتشنا شادا هو مهندس الحلول الرئيسي AI / ML في الحسابات الإستراتيجية في AWS. راتشنا متفائل يؤمن بأن الاستخدام الأخلاقي والمسؤول للذكاء الاصطناعي يمكن أن يحسن المجتمع في المستقبل ويحقق الرخاء الاقتصادي والاجتماعي. في أوقات فراغها ، تحب راتشنا قضاء الوقت مع عائلتها والمشي لمسافات طويلة والاستماع إلى الموسيقى.

د. أشيش خيتان هو عالم تطبيقي أقدم مع خوارزميات Amazon SageMaker المضمنة ويساعد في تطوير خوارزميات التعلم الآلي. حصل على الدكتوراه من جامعة إلينوي في أوربانا شامبين. وهو باحث نشط في التعلم الآلي والاستدلال الإحصائي ، وقد نشر العديد من الأوراق البحثية في مؤتمرات NeurIPS و ICML و ICLR و JMLR و ACL و EMNLP.

د. أشيش خيتان هو عالم تطبيقي أقدم مع خوارزميات Amazon SageMaker المضمنة ويساعد في تطوير خوارزميات التعلم الآلي. حصل على الدكتوراه من جامعة إلينوي في أوربانا شامبين. وهو باحث نشط في التعلم الآلي والاستدلال الإحصائي ، وقد نشر العديد من الأوراق البحثية في مؤتمرات NeurIPS و ICML و ICLR و JMLR و ACL و EMNLP.

كارل البرتسن يقود المنتج والهندسة والعلوم لخوارزميات Amazon SageMaker و JumpStart ، مركز التعلم الآلي من SageMaker. إنه متحمس لتطبيق التعلم الآلي لإطلاق العنان لقيمة العمل.

كارل البرتسن يقود المنتج والهندسة والعلوم لخوارزميات Amazon SageMaker و JumpStart ، مركز التعلم الآلي من SageMaker. إنه متحمس لتطبيق التعلم الآلي لإطلاق العنان لقيمة العمل.

- محتوى مدعوم من تحسين محركات البحث وتوزيع العلاقات العامة. تضخيم اليوم.

- PlatoData.Network Vertical Generative Ai. تمكين نفسك. الوصول هنا.

- أفلاطونايستريم. ذكاء Web3. تضخيم المعرفة. الوصول هنا.

- أفلاطون كربون، كلينتك ، الطاقة، بيئة، شمسي، إدارة المخلفات. الوصول هنا.

- أفلاطون هيلث. التكنولوجيا الحيوية وذكاء التجارب السريرية. الوصول هنا.

- المصدر https://aws.amazon.com/blogs/machine-learning/llama-guard-is-now-available-in-amazon-sagemaker-jumpstart/