لقد استحوذ إطلاق ChatGPT وارتفاع شعبية الذكاء الاصطناعي التوليدي على خيال العملاء الذين لديهم فضول بشأن كيفية استخدام هذه التكنولوجيا لإنشاء منتجات وخدمات جديدة على AWS، مثل روبوتات الدردشة الخاصة بالمؤسسات، والتي تعد أكثر تحادثية. يوضح لك هذا المنشور كيف يمكنك إنشاء واجهة مستخدم ويب، والتي نطلق عليها اسم Chat Studio، لبدء محادثة والتفاعل مع النماذج الأساسية المتوفرة في أمازون سيج ميكر جومب ستارت مثل Llama 2 وStable Diffusion والنماذج الأخرى المتوفرة على الأمازون SageMaker. بعد نشر هذا الحل، يمكن للمستخدمين البدء بسرعة وتجربة إمكانات النماذج الأساسية المتعددة في الذكاء الاصطناعي للمحادثة من خلال واجهة الويب.

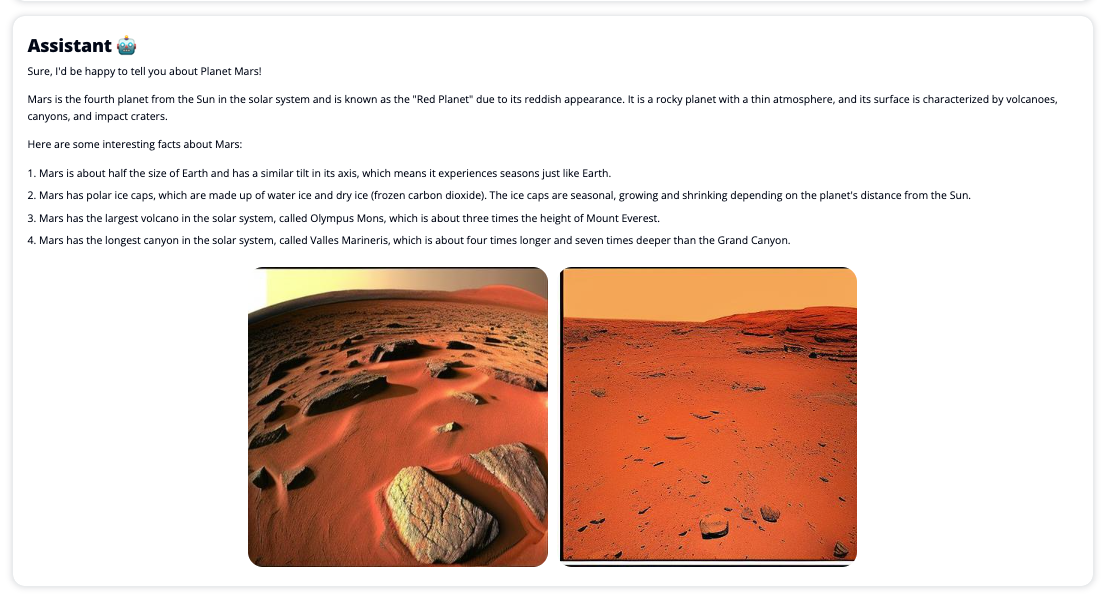

يمكن لـ Chat Studio أيضًا استدعاء نقطة نهاية نموذج Stable Diffusion بشكل اختياري لإرجاع مجموعة من الصور ومقاطع الفيديو ذات الصلة إذا طلب المستخدم عرض الوسائط. يمكن أن تساعد هذه الميزة في تحسين تجربة المستخدم باستخدام الوسائط كأصول مصاحبة للاستجابة. هذا مجرد مثال واحد لكيفية إثراء Chat Studio بعمليات تكامل إضافية لتحقيق أهدافك.

تعرض لقطات الشاشة التالية أمثلة على الشكل الذي يبدو عليه استعلام المستخدم واستجابته.

نماذج اللغات الكبيرة

يتم تشغيل روبوتات الدردشة التوليدية المستندة إلى الذكاء الاصطناعي مثل ChatGPT بواسطة نماذج لغوية كبيرة (LLMs)، والتي تعتمد على شبكة عصبية للتعلم العميق يمكن تدريبها على كميات كبيرة من النصوص غير المسماة. يتيح استخدام LLMs تجربة محادثة أفضل تشبه إلى حد كبير التفاعلات مع البشر الحقيقيين، مما يعزز الشعور بالارتباط وتحسين رضا المستخدم.

نماذج مؤسسة SageMaker

في عام 2021، أطلق معهد ستانفورد للذكاء الاصطناعي المرتكز على الإنسان على بعض ماجستير إدارة الأعمال اسم "LLM". نماذج الأساس. يتم تدريب النماذج الأساسية مسبقًا على مجموعة كبيرة وواسعة من البيانات العامة، وتهدف إلى أن تكون بمثابة أساس لمزيد من التحسينات في مجموعة واسعة من حالات الاستخدام، بدءًا من إنشاء الفن الرقمي وحتى تصنيف النص متعدد اللغات. تحظى نماذج الأساس هذه بشعبية كبيرة لدى العملاء لأن تدريب نموذج جديد من البداية يستغرق وقتًا ويمكن أن يكون مكلفًا. يوفر SageMaker JumpStart إمكانية الوصول إلى مئات النماذج الأساسية التي يتم صيانتها من موفري المصادر المفتوحة والمملوكة لجهات خارجية.

حل نظرة عامة

يتناول هذا المنشور سير عمل منخفض التعليمات البرمجية لنشر LLMs المدربة مسبقًا والمخصصة من خلال SageMaker، وإنشاء واجهة مستخدم ويب للتفاعل مع النماذج المنشورة. نحن نغطي الخطوات التالية:

- نشر النماذج الأساسية لـ SageMaker.

- نشر AWS لامدا و إدارة الهوية والوصول AWS (IAM) باستخدام أذونات تكوين سحابة AWS.

- إعداد وتشغيل واجهة المستخدم.

- اختياريًا، قم بإضافة نماذج أساس SageMaker أخرى. تعمل هذه الخطوة على توسيع قدرة Chat Studio على التفاعل مع نماذج الأساس الإضافية.

- اختياريًا، قم بنشر التطبيق باستخدام تضخيم AWS. تقوم هذه الخطوة بنشر Chat Studio على الويب.

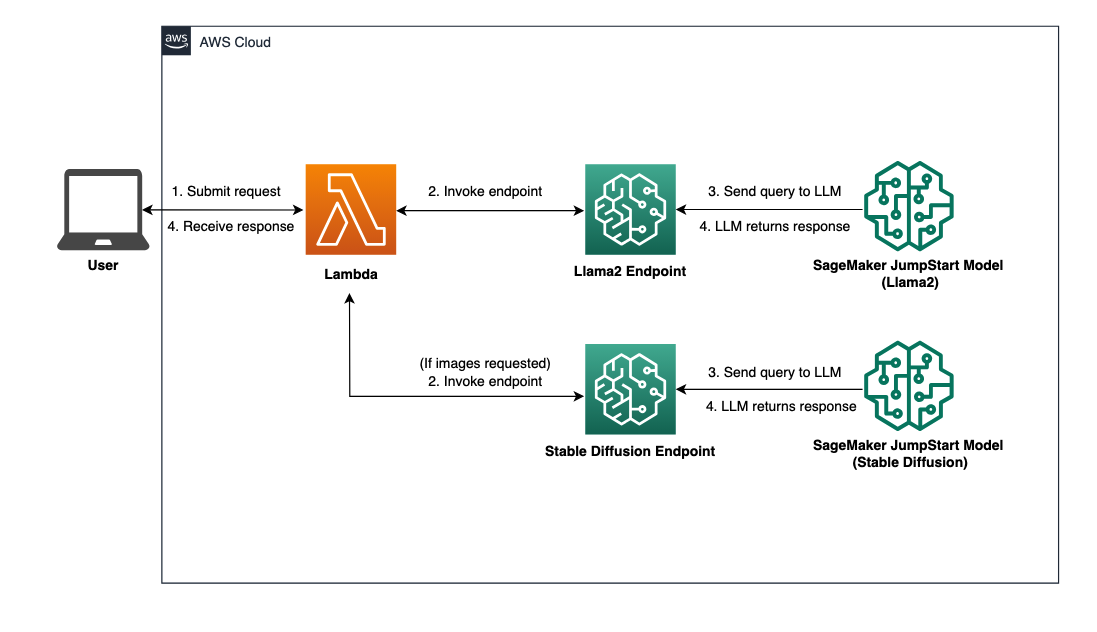

راجع الرسم البياني التالي للحصول على نظرة عامة على بنية الحل.

المتطلبات الأساسية المسبقة

لتصفح الحل ، يجب أن تكون لديك المتطلبات الأساسية التالية:

- An حساب AWS مع امتيازات مستخدم IAM كافية.

npmالمثبتة في البيئة المحلية الخاصة بك. للحصول على تعليمات حول كيفية التثبيتnpm، تشير إلى تنزيل وتثبيت Node.js وnpm.- حصة خدمة تبلغ 1 لنقاط نهاية SageMaker المقابلة. بالنسبة إلى Llama 2 13b Chat، نستخدم مثيل ml.g5.48xlarge وبالنسبة إلى Stable Diffusion 2.1، نستخدم مثيل ml.p3.2xlarge.

لطلب زيادة حصة الخدمة، على وحدة تحكم حصص خدمة AWS، انتقل إلى خدمات AWS, SageMaker، وطلب رفع حصة الخدمة إلى قيمة 1 لـ ml.g5.48xlarge لاستخدام نقطة النهاية وml.p3.2xlarge لاستخدام نقطة النهاية.

قد يستغرق طلب حصة الخدمة بضع ساعات للموافقة عليه، اعتمادًا على مدى توفر نوع المثيل.

نشر النماذج الأساسية لـ SageMaker

SageMaker هي خدمة تعلم آلي مُدارة بالكامل (ML) للمطورين لبناء نماذج تعلم الآلة وتدريبها بسرعة وسهولة. أكمل الخطوات التالية لنشر النماذج الأساسية Llama 2 13b Chat وStable Diffusion 2.1 باستخدام أمازون ساجميكر ستوديو:

- قم بإنشاء مجال SageMaker. للحصول على التعليمات، راجع الانضمام إلى Amazon SageMaker Domain باستخدام الإعداد السريع.

يقوم المجال بإعداد كل مساحة التخزين ويسمح لك بإضافة مستخدمين للوصول إلى SageMaker.

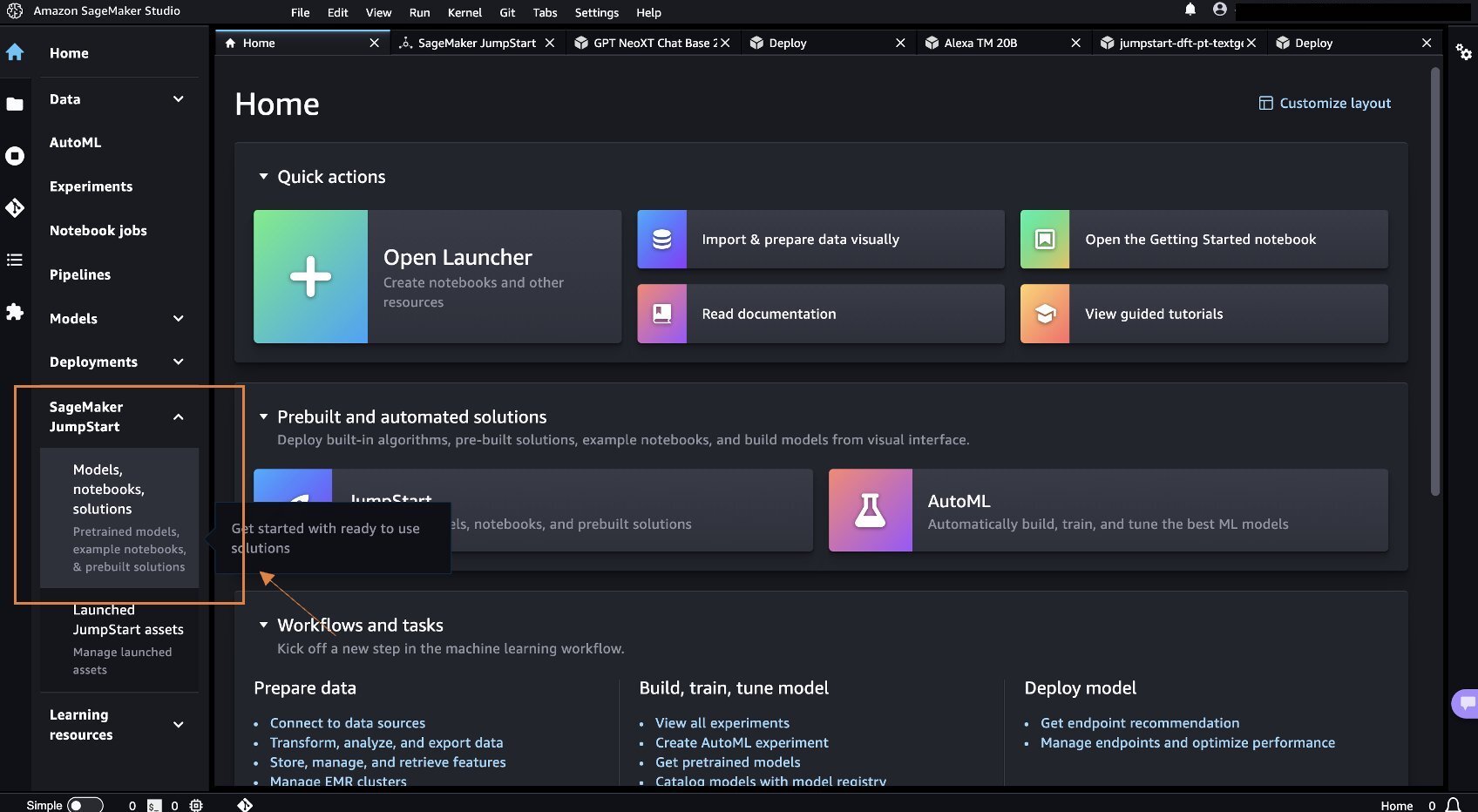

- في وحدة تحكم SageMaker ، اختر استوديو في جزء التنقل ، ثم اختر فتح ستوديو.

- عند إطلاق الاستوديو، تحت سيج ميكر جومب ستارت في جزء التنقل ، اختر النماذج والدفاتر والحلول.

- في شريط البحث، ابحث عن Llama 2 13b Chat.

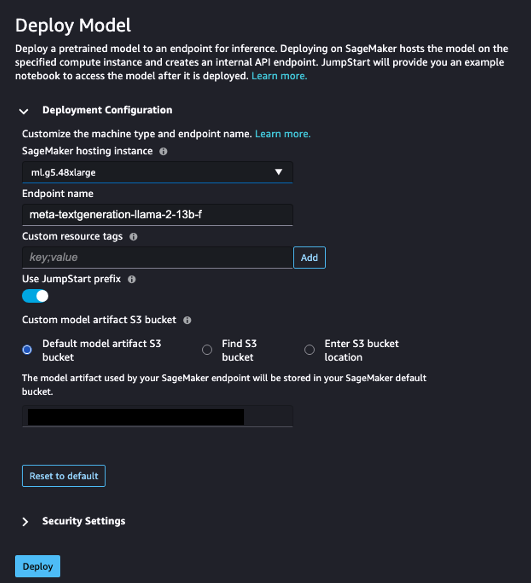

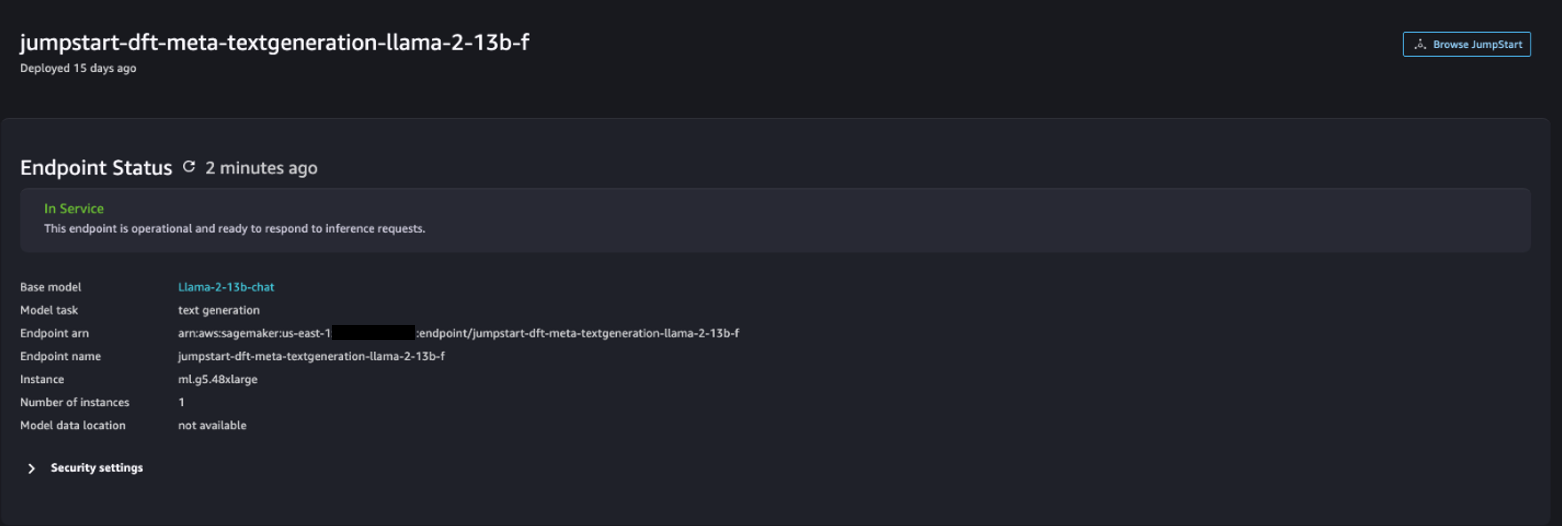

- تحت تكوين النشر، ل مثيل استضافة SageMaker، اختر ml.g5.48xlarge ولل اسم نقطة النهاية، أدخل

meta-textgeneration-llama-2-13b-f. - اختار نشر.

بعد نجاح النشر، يجب أن تكون قادرًا على رؤية In Service الحالة.

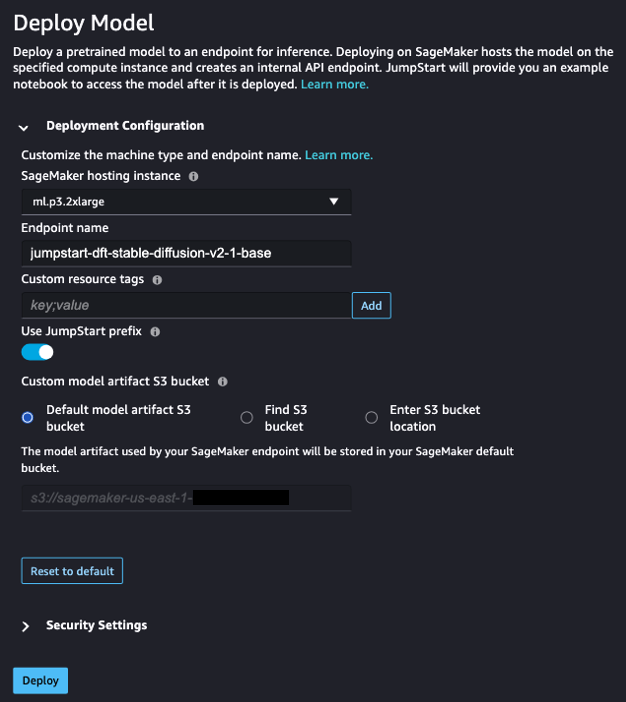

- على النماذج والدفاتر والحلول الصفحة، ابحث عن Stable Diffusion 2.1.

- تحت تكوين النشر، ل مثيل استضافة SageMaker، اختر مل. 3.2xlarge ولل اسم نقطة النهاية، أدخل

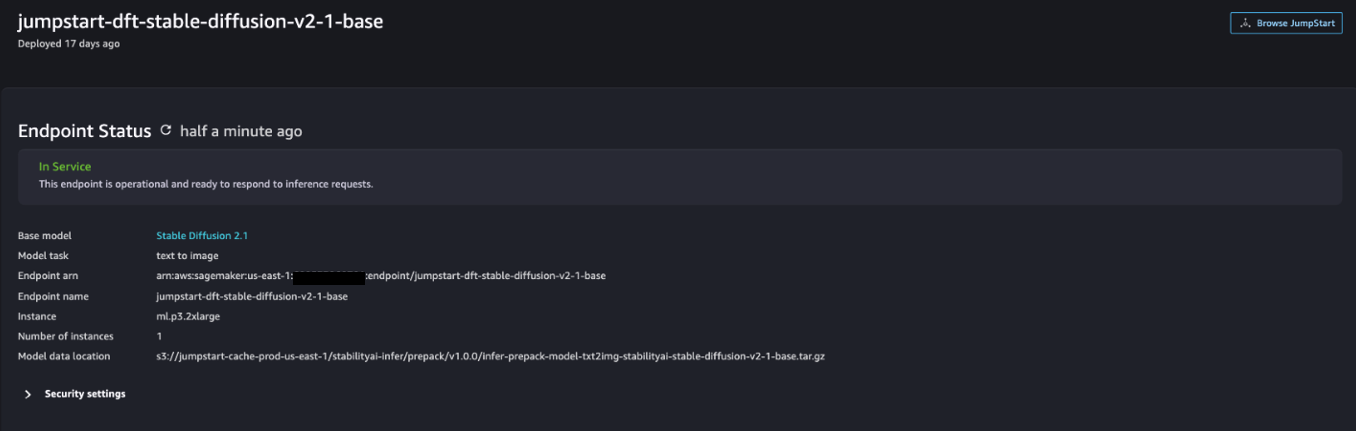

jumpstart-dft-stable-diffusion-v2-1-base. - اختار نشر.

بعد نجاح النشر، يجب أن تكون قادرًا على رؤية In Service الحالة.

انشر أذونات Lambda وIAM باستخدام AWS CloudFormation

يصف هذا القسم كيف يمكنك تشغيل مكدس CloudFormation الذي ينشر وظيفة Lambda التي تعالج طلب المستخدم الخاص بك وتستدعي نقطة نهاية SageMaker التي قمت بنشرها، وتنشر جميع أذونات IAM الضرورية. أكمل الخطوات التالية:

- انتقل إلى مستودع جيثب وقم بتنزيل قالب CloudFormation (

lambda.cfn.yaml) إلى جهازك المحلي. - في وحدة تحكم CloudFormation، اختر إنشاء مكدس القائمة المنسدلة واختر بموارد جديدة (قياسي).

- على حدد النموذج الصفحة ، حدد قم بتحميل ملف قالب و اختر ملف.

- اختيار

lambda.cfn.yamlالملف الذي قمت بتنزيله، ثم اختر التالى. - على حدد تفاصيل المكدس الصفحة، أدخل اسم المكدس ومفتاح API الذي حصلت عليه في المتطلبات الأساسية، ثم اختر التالى.

- على تكوين خيارات المكدس الصفحة ، اختر التالى.

- قم بمراجعة التغييرات والإقرار بها ثم الاختيار تقدم.

قم بإعداد واجهة مستخدم الويب

يصف هذا القسم خطوات تشغيل واجهة مستخدم الويب (التي تم إنشاؤها باستخدام نظام تصميم كلاود سكيب) على جهازك المحلي:

- في وحدة تحكم IAM، انتقل إلى المستخدم

functionUrl. - على أوراق اعتماد الأمان علامة التبويب، اختر إنشاء مفتاح الوصول.

- على الوصول إلى أفضل الممارسات والبدائل الرئيسية الصفحة ، حدد واجهة سطر الأوامر (CLI) واختر التالى.

- على تعيين علامة الوصف الصفحة ، اختر إنشاء مفتاح الوصول.

- انسخ مفتاح الوصول ومفتاح الوصول السري.

- اختار تم. .

- انتقل إلى مستودع جيثب وتحميل

react-llm-chat-studioرمز. - قم بتشغيل المجلد في IDE المفضل لديك وافتح الوحدة الطرفية.

- انتقل إلى

src/configs/aws.jsonوأدخل مفتاح الوصول ومفتاح الوصول السري الذي حصلت عليه. - أدخل الأوامر التالية في المحطة:

- ساعات العمل http://localhost:3000 في متصفحك وابدأ بالتفاعل مع نماذجك!

لاستخدام Chat Studio، اختر نموذجًا أساسيًا من القائمة المنسدلة وأدخل استعلامك في مربع النص. للحصول على صور تم إنشاؤها بواسطة الذكاء الاصطناعي مع الرد، أضف عبارة "مع الصور" إلى نهاية استعلامك.

أضف نماذج أساس SageMaker أخرى

يمكنك توسيع قدرة هذا الحل بشكل أكبر ليشمل نماذج مؤسسة SageMaker الإضافية. نظرًا لأن كل نموذج يتوقع تنسيقات إدخال وإخراج مختلفة عند استدعاء نقطة نهاية SageMaker الخاصة به، فستحتاج إلى كتابة بعض تعليمات التحويل البرمجية في وظيفة callSageMakerEndpoints Lambda للتفاعل مع النموذج.

يصف هذا القسم الخطوات العامة وتغييرات التعليمات البرمجية المطلوبة لتنفيذ نموذج إضافي من اختيارك. لاحظ أن المعرفة الأساسية بلغة بايثون مطلوبة للخطوات من 6 إلى 8.

- في SageMaker Studio، انشر النموذج الأساسي لـ SageMaker الذي تختاره.

- اختار سيج ميكر جومب ستارت و قم بتشغيل أصول JumpStart.

- اختر نقطة نهاية النموذج الذي تم نشره حديثًا واختر افتح المفكرة.

- في وحدة تحكم الكمبيوتر المحمول، ابحث عن معلمات الحمولة.

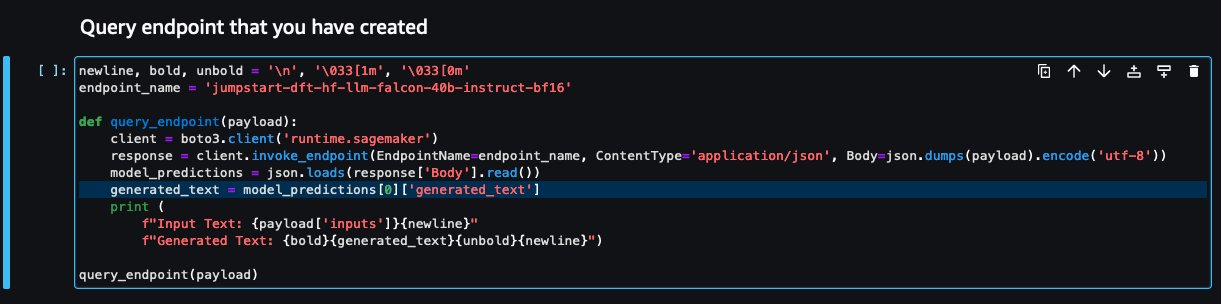

هذه هي الحقول التي يتوقعها النموذج الجديد عند استدعاء نقطة نهاية SageMaker الخاصة به. تظهر لقطة الشاشة التالية مثالا.

- على وحدة تحكم Lambda، انتقل إلى

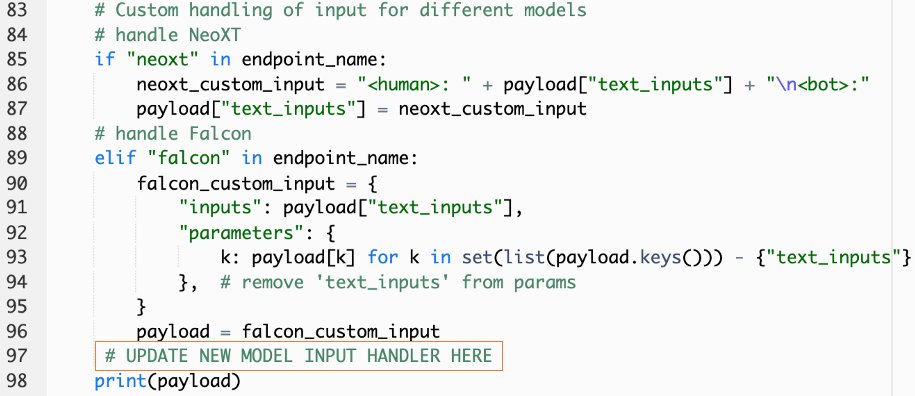

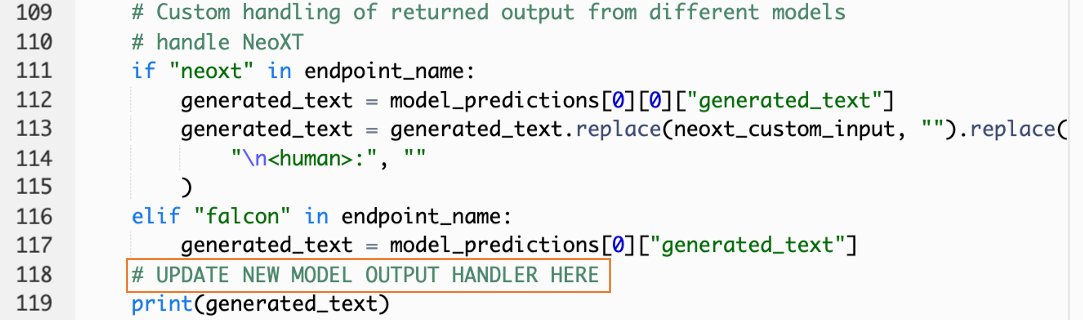

callSageMakerEndpoints. - قم بإضافة معالج إدخال مخصص لنموذجك الجديد.

في لقطة الشاشة التالية، قمنا بتحويل الإدخال لـ Falcon 40B Instruct BF16 وGPT NeoXT Chat Base 20B FP16. يمكنك إدراج منطق المعلمة المخصصة الخاص بك كما هو موضح لإضافة منطق تحويل الإدخال بالإشارة إلى معلمات الحمولة النافعة التي قمت بنسخها.

- ارجع إلى وحدة تحكم الكمبيوتر المحمول وحدد موقعه

query_endpoint.

تمنحك هذه الوظيفة فكرة عن كيفية تحويل مخرجات النماذج لاستخراج الاستجابة النصية النهائية.

- بالإشارة إلى الكود الموجود في

query_endpoint، قم بإضافة معالج إخراج مخصص لنموذجك الجديد.

- اختار نشر.

- افتح IDE الخاص بك، ثم قم بتشغيل

react-llm-chat-studioرمز، وانتقل إلىsrc/configs/models.json. - أضف اسم النموذج ونقطة نهاية النموذج، وأدخل معلمات الحمولة من الخطوة 4 أدناه

payloadباستخدام التنسيق التالي: - قم بتحديث المتصفح الخاص بك لبدء التفاعل مع النموذج الجديد الخاص بك!

نشر التطبيق باستخدام Amplify

يعد Amplify حلاً متكاملاً يتيح لك نشر تطبيقك بسرعة وكفاءة. يصف هذا القسم خطوات نشر Chat Studio على الأمازون CloudFront التوزيع باستخدام Amplify إذا كنت ترغب في مشاركة تطبيقك مع مستخدمين آخرين.

- انتقل إلى

react-llm-chat-studioمجلد التعليمات البرمجية الذي قمت بإنشائه مسبقًا. - أدخل الأوامر التالية في الجهاز واتبع تعليمات الإعداد:

- قم بتهيئة مشروع Amplify جديد باستخدام الأمر التالي. قم بتوفير اسم المشروع، وقبول التكوينات الافتراضية، ثم اختر مفاتيح وصول AWS عندما يُطلب منك تحديد طريقة المصادقة.

- قم باستضافة مشروع Amplify باستخدام الأمر التالي. يختار أمازون كلاودفرونت وS3 عندما يُطلب منك تحديد وضع البرنامج المساعد.

- وأخيرًا، قم ببناء المشروع ونشره باستخدام الأمر التالي:

- بعد نجاح النشر، افتح عنوان URL المتوفر في متصفحك وابدأ في التفاعل مع النماذج الخاصة بك!

تنظيف

لتجنب تكبد رسوم في المستقبل ، أكمل الخطوات التالية:

- احذف مكدس CloudFormation. للحصول على تعليمات ، راجع حذف مكدس على وحدة تحكم AWS CloudFormation.

- احذف نقطة نهاية SageMaker JumpStart. للحصول على التعليمات، راجع حذف نقاط النهاية والموارد.

- احذف مجال SageMaker. للحصول على التعليمات، راجع احذف مجال Amazon SageMaker.

وفي الختام

في هذا المنشور، شرحنا كيفية إنشاء واجهة مستخدم ويب للتواصل مع LLMs المنشورة على AWS.

باستخدام هذا الحل، يمكنك التفاعل مع ماجستير إدارة الأعمال الخاص بك وإجراء محادثة بطريقة سهلة الاستخدام لاختبار أو طرح أسئلة ماجستير إدارة الأعمال، والحصول على مجموعة من الصور ومقاطع الفيديو إذا لزم الأمر.

يمكنك توسيع هذا الحل بطرق مختلفة، مثل دمج نماذج الأساس الإضافية، التكامل مع أمازون كندرا لتمكين البحث الذكي المدعوم بالتعلم الآلي لفهم محتوى المؤسسة، والمزيد!

نحن ندعوك للتجربة تتوفر LLMs مختلفة مدربة مسبقًا على AWS، أو البناء فوق أو حتى إنشاء LLMs الخاصة بك في SageMaker. أخبرنا بأسئلتك ونتائجك في التعليقات، واستمتع بوقتك!

عن المؤلفين

جاريت يو شان وي هو مهندس سحابي مشارك في خدمات AWS الاحترافية التي تغطي القطاع العام عبر رابطة أمم جنوب شرق آسيا وهو مدافع عن مساعدة العملاء على التحديث والانتقال إلى السحابة. وقد حصل على خمس شهادات من AWS، كما نشر ورقة بحثية حول مجموعات آلات تعزيز التدرج في المؤتمر الدولي الثامن حول الذكاء الاصطناعي. في أوقات فراغه، يركز جاريت على مشهد الذكاء الاصطناعي التوليدي في AWS ويساهم فيه.

جاريت يو شان وي هو مهندس سحابي مشارك في خدمات AWS الاحترافية التي تغطي القطاع العام عبر رابطة أمم جنوب شرق آسيا وهو مدافع عن مساعدة العملاء على التحديث والانتقال إلى السحابة. وقد حصل على خمس شهادات من AWS، كما نشر ورقة بحثية حول مجموعات آلات تعزيز التدرج في المؤتمر الدولي الثامن حول الذكاء الاصطناعي. في أوقات فراغه، يركز جاريت على مشهد الذكاء الاصطناعي التوليدي في AWS ويساهم فيه.

تامي ليم لي شين هو مهندس سحابي مشارك في AWS. إنها تستخدم التكنولوجيا لمساعدة العملاء على تحقيق النتائج المرجوة في رحلة اعتماد السحابة الخاصة بهم وهي شغوفة بالذكاء الاصطناعي/التعلم الآلي. خارج العمل، تحب السفر والمشي لمسافات طويلة وقضاء الوقت مع العائلة والأصدقاء.

تامي ليم لي شين هو مهندس سحابي مشارك في AWS. إنها تستخدم التكنولوجيا لمساعدة العملاء على تحقيق النتائج المرجوة في رحلة اعتماد السحابة الخاصة بهم وهي شغوفة بالذكاء الاصطناعي/التعلم الآلي. خارج العمل، تحب السفر والمشي لمسافات طويلة وقضاء الوقت مع العائلة والأصدقاء.

- محتوى مدعوم من تحسين محركات البحث وتوزيع العلاقات العامة. تضخيم اليوم.

- PlatoData.Network Vertical Generative Ai. تمكين نفسك. الوصول هنا.

- أفلاطونايستريم. ذكاء Web3. تضخيم المعرفة. الوصول هنا.

- أفلاطون كربون، كلينتك ، الطاقة، بيئة، شمسي، إدارة المخلفات. الوصول هنا.

- أفلاطون هيلث. التكنولوجيا الحيوية وذكاء التجارب السريرية. الوصول هنا.

- المصدر https://aws.amazon.com/blogs/machine-learning/create-a-web-ui-to-interact-with-llms-using-amazon-sagemaker-jumpstart/