اليوم، يسعدنا أن نعلن أن نماذج أساس Code Llama، التي طورتها شركة Meta، متاحة للعملاء من خلال أمازون سيج ميكر جومب ستارت للنشر بنقرة واحدة لتشغيل الاستدلال. Code Llama هو نموذج لغة كبير متطور (LLM) قادر على إنشاء تعليمات برمجية ولغة طبيعية حول التعليمات البرمجية من كل من التعليمات البرمجية واللغة الطبيعية. Code Llama مجاني للبحث والاستخدام التجاري. يمكنك تجربة هذا النموذج باستخدام SageMaker JumpStart، وهو مركز التعلم الآلي (ML) الذي يوفر الوصول إلى الخوارزميات والنماذج وحلول تعلم الآلة حتى تتمكن من بدء استخدام تعلم الآلة بسرعة. في هذا المنشور، سنتعرف على كيفية اكتشاف نموذج Code Llama ونشره عبر SageMaker JumpStart.

ما هو كود اللاما

Code Llama هو نموذج تم إصداره بواسطة مييتااا الذي تم بناؤه أعلى Llama 2 وهو نموذج حديث مصمم لتحسين إنتاجية مهام البرمجة للمطورين من خلال مساعدتهم على إنشاء تعليمات برمجية عالية الجودة وموثقة جيدًا. تُظهر النماذج أداءً متطورًا في Python وC++ وJava وPHP وC# وTypeScript وBash، ولديها القدرة على توفير وقت المطورين وجعل سير عمل البرامج أكثر كفاءة. يأتي في ثلاثة أشكال مختلفة، تم تصميمه لتغطية مجموعة واسعة من التطبيقات: النموذج التأسيسي (Code Llama)، ونموذج Python المتخصص (Code Llama-Python)، ونموذج متابعة التعليمات لفهم تعليمات اللغة الطبيعية (Code Llama-Instruct ). تأتي جميع متغيرات Code Llama بثلاثة أحجام: معلمات 7B و13B و34B. تدعم متغيرات القاعدة والتعليمات 7B و13B عملية التعبئة بناءً على المحتوى المحيط، مما يجعلها مثالية لتطبيقات مساعد التعليمات البرمجية.

تم تصميم النماذج باستخدام Llama 2 كقاعدة ثم تم تدريبها على 500 مليار رمز مميز من بيانات التعليمات البرمجية، مع تدريب إصدار Python المتخصص على 100 مليار رمز إضافي. توفر نماذج Code Llama للأجيال المستقرة ما يصل إلى 100,000 رمز مميز للسياق. يتم تدريب جميع النماذج على تسلسلات مكونة من 16,000 رمز مميز وتظهر تحسينات على المدخلات بما يصل إلى 100,000 رمز مميز.

النموذج متاح تحت نفس ترخيص المجتمع باسم Llama 2.

ما هو برنامج SageMaker JumpStart

باستخدام SageMaker JumpStart، يمكن لممارسي تعلم الآلة الاختيار من قائمة متزايدة من نماذج الأساس الأفضل أداءً. يمكن لممارسي ML نشر النماذج الأساسية لـ مخصصة الأمازون SageMaker مثيلات داخل بيئة شبكة معزولة وتخصيص النماذج باستخدام SageMaker للتدريب على النماذج ونشرها.

يمكنك الآن اكتشاف نماذج Code Llama ونشرها ببضع نقرات أمازون ساجميكر ستوديو أو برمجيًا من خلال SageMaker Python SDK ، مما يتيح لك اشتقاق أداء النموذج وعناصر تحكم MLOps باستخدام ميزات SageMaker مثل خطوط أنابيب Amazon SageMaker, الأمازون SageMaker المصححأو سجلات الحاوية. يتم نشر النموذج في بيئة AWS الآمنة وتحت ضوابط VPC الخاصة بك، مما يساعد على ضمان أمان البيانات. نماذج Code Llama قابلة للاكتشاف ويمكن نشرها في مناطق شرق الولايات المتحدة (شمال فيرجينيا) وغرب الولايات المتحدة (أوريغون) وأوروبا (أيرلندا).

يجب على العملاء قبول اتفاقية ترخيص المستخدم النهائي (EULA) لنشر نموذج التأشيرة SageMaker SDK.

اكتشف الموديلات

يمكنك الوصول إلى النماذج الأساسية لـ Code Llama من خلال SageMaker JumpStart في SageMaker Studio UI وSageMaker Python SDK. في هذا القسم، سنتعرف على كيفية اكتشاف النماذج في SageMaker Studio.

SageMaker Studio عبارة عن بيئة تطوير متكاملة (IDE) توفر واجهة مرئية واحدة قائمة على الويب حيث يمكنك الوصول إلى الأدوات المصممة لغرض تنفيذ جميع خطوات تطوير ML ، من إعداد البيانات إلى البناء والتدريب ونشر نماذج ML الخاصة بك. لمزيد من التفاصيل حول كيفية البدء وإعداد SageMaker Studio ، يرجى الرجوع إلى أمازون ساجميكر ستوديو.

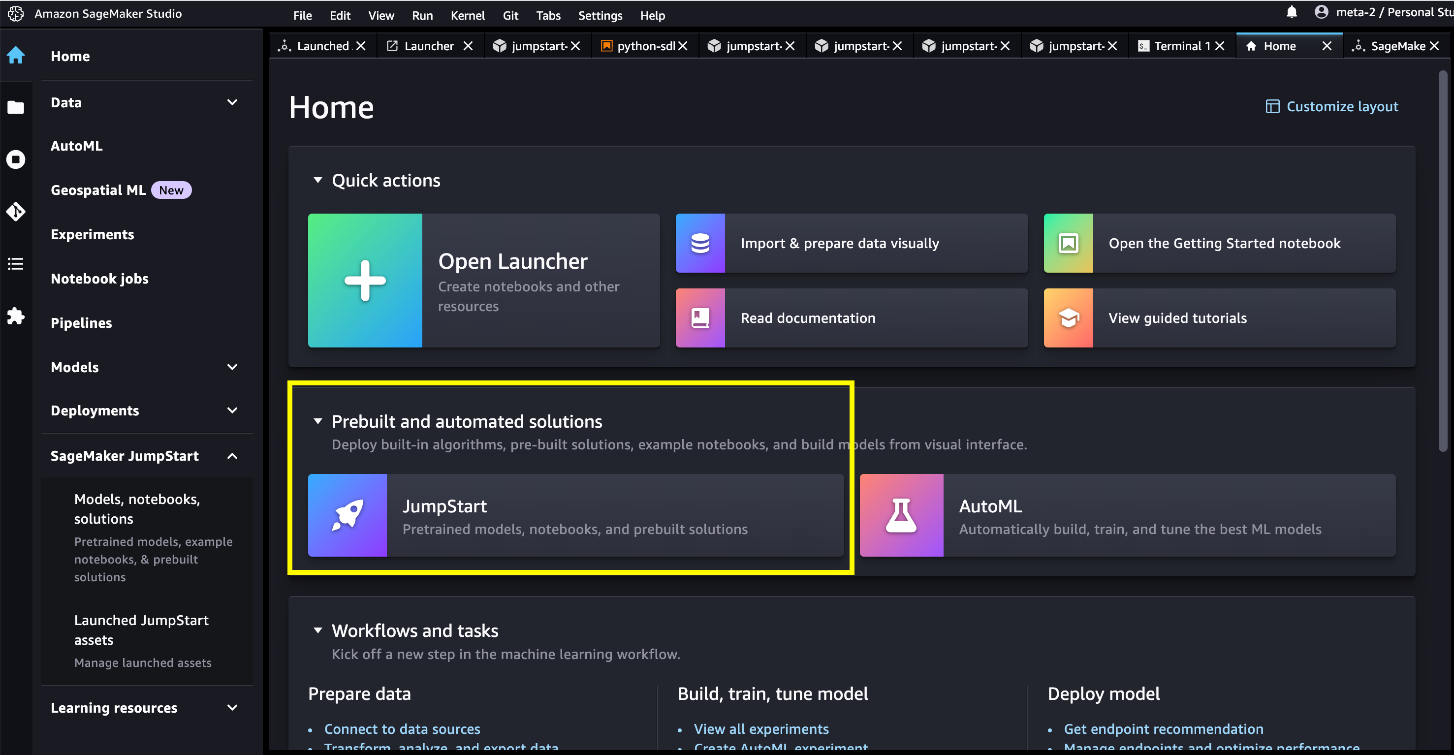

في SageMaker Studio، يمكنك الوصول إلى SageMaker JumpStart، الذي يحتوي على نماذج ودفاتر ملاحظات وحلول تم إنشاؤها مسبقًا، ضمن حلول آلية ومبنية مسبقًا.

في الصفحة المقصودة لـ SageMaker JumpStart، يمكنك استعراض الحلول والنماذج ودفاتر الملاحظات والموارد الأخرى. يمكنك العثور على نماذج Code Llama في نماذج الأساس: إنشاء النص دائري.

يمكنك أيضًا العثور على متغيرات الطراز الأخرى عن طريق الاختيار استكشف جميع نماذج إنشاء النص أو البحث عن Code Llama.

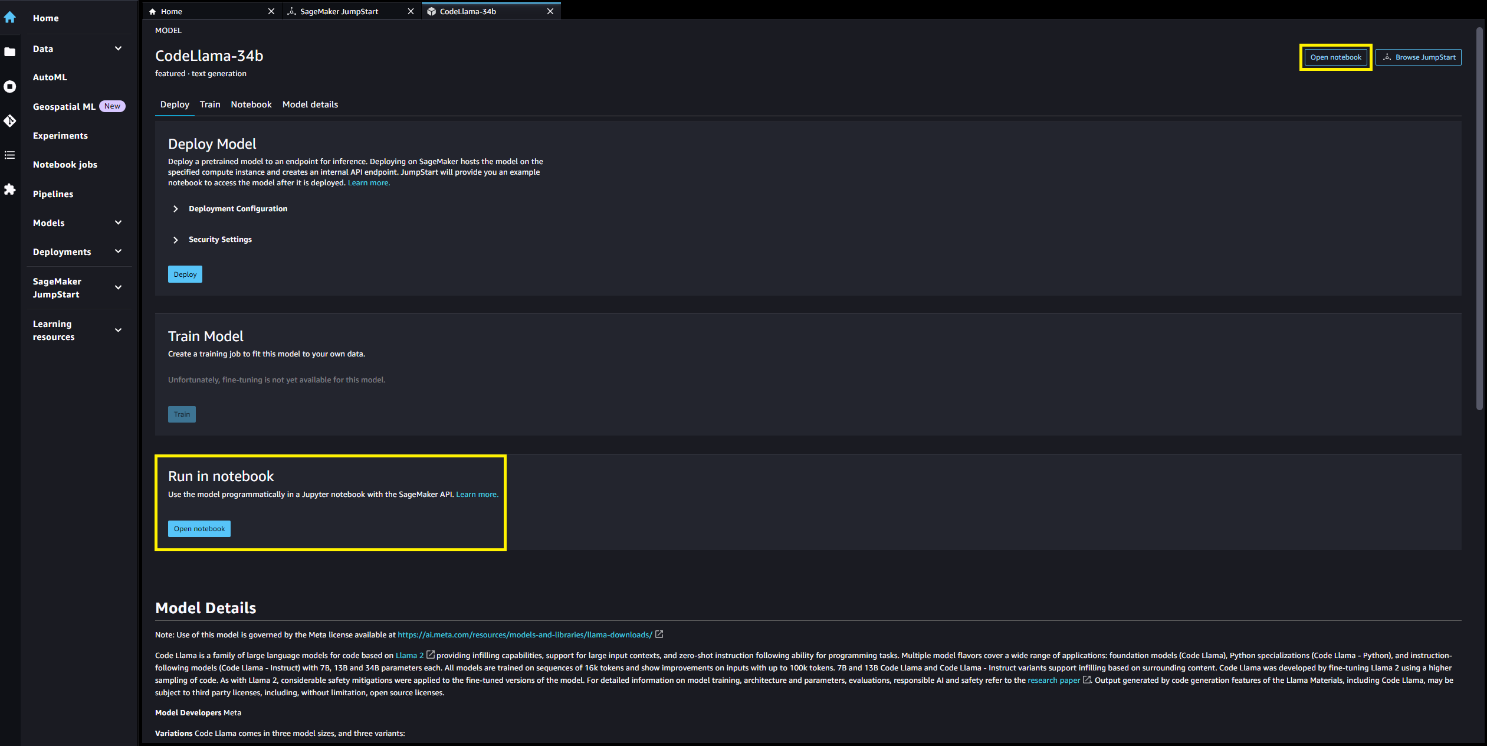

يمكنك اختيار بطاقة النموذج لعرض تفاصيل حول النموذج مثل الترخيص والبيانات المستخدمة للتدريب وكيفية الاستخدام. ستجد أيضًا زرين، نشر و افتح المفكرةمما سيساعدك على استخدام النموذج.

نشر

عندما تختار نشر والموافقة على الشروط، سيبدأ النشر. وبدلاً من ذلك، يمكنك النشر من خلال مثال دفتر الملاحظات عن طريق الاختيار افتح المفكرة. دفتر الملاحظات النموذجي الذي يوفر إرشادات شاملة حول كيفية نشر النموذج للاستدلال وتنظيف الموارد.

للنشر باستخدام دفتر الملاحظات، نبدأ بتحديد النموذج المناسب، المحدد بواسطة model_id. يمكنك نشر أي من النماذج المحددة على SageMaker باستخدام الكود التالي:

يؤدي هذا إلى نشر النموذج على SageMaker مع التكوينات الافتراضية ، بما في ذلك نوع المثيل الافتراضي وتكوينات VPC الافتراضية. يمكنك تغيير هذه التكوينات عن طريق تحديد قيم غير افتراضية بتنسيق نموذج JumpStart. بعد نشره ، يمكنك تشغيل الاستدلال مقابل نقطة النهاية المنشورة من خلال توقع SageMaker:

لاحظ أنه افتراضيًا ، accept_eula ومن المقرر أن false. تحتاج إلى تعيين accept_eula=true لاستدعاء نقطة النهاية بنجاح. من خلال القيام بذلك ، فإنك تقبل اتفاقية ترخيص المستخدم وسياسة الاستخدام المقبول كما هو مذكور سابقًا. بامكانك ايضا بإمكانك تحميله اتفاقية الترخيص.

Custom_attributes المستخدمة لتمرير اتفاقية ترخيص المستخدم النهائي (EULA) هي أزواج المفتاح/القيمة. يتم الفصل بين المفتاح والقيمة بواسطة =، ويتم الفصل بين الأزواج بواسطة ;. إذا مرر المستخدم نفس المفتاح أكثر من مرة، فسيتم الاحتفاظ بالقيمة الأخيرة وتمريرها إلى معالج البرنامج النصي (في هذه الحالة، يُستخدم للمنطق الشرطي). على سبيل المثال، إذا accept_eula=false; accept_eula=true يتم تمريره إلى الخادم ، ثم accept_eula=true يتم الاحتفاظ بها وتمريرها إلى معالج البرنامج النصي.

تتحكم معلمات الاستدلال في عملية إنشاء النص عند نقطة النهاية. يشير الحد الأقصى للتحكم في الرموز المميزة الجديدة إلى حجم المخرجات التي تم إنشاؤها بواسطة النموذج. لاحظ أن هذا ليس هو نفسه عدد الكلمات لأن مفردات النموذج تختلف عن مفردات اللغة الإنجليزية ، وقد لا يكون كل رمز مميزًا كلمة باللغة الإنجليزية. تتحكم درجة الحرارة في العشوائية في الإخراج. ينتج عن ارتفاع درجة الحرارة نتائج أكثر إبداعًا وهلوسة. جميع معلمات الاستدلال اختيارية.

يسرد الجدول التالي جميع نماذج Code Llama المتوفرة في SageMaker JumpStart بالإضافة إلى معرفات النموذج وأنواع المثيلات الافتراضية والحد الأقصى من الرموز المميزة المدعومة (مجموع عدد الرموز المميزة للإدخال وعدد الرموز المميزة التي تم إنشاؤها لجميع الطلبات المتزامنة) المدعومة لكل من هذه النماذج.

| نموذج الاسم | معرف النموذج | نوع المثيل الافتراضي | الحد الأقصى من الرموز المدعومة |

| كود لاما-7ب | meta-textgeneration-llama-codellama-7b | ml.g5.2xlarge | 10000 |

| CodeLlama-7b-Instruct | meta-textgeneration-llama-codellama-7b-instruct | ml.g5.2xlarge | 10000 |

| CodeLlama-7b-Python | meta-textgeneration-llama-codellama-7b-python | ml.g5.2xlarge | 10000 |

| كود لاما-13ب | meta-textgeneration-llama-codellama-13b | ml.g5.12xlarge | 32000 |

| CodeLlama-13b-Instruct | meta-textgeneration-llama-codellama-13b-instruct | ml.g5.12xlarge | 32000 |

| CodeLlama-13b-Python | meta-textgeneration-llama-codellama-13b-python | ml.g5.12xlarge | 32000 |

| كود لاما-34ب | meta-textgeneration-llama-codellama-34b | ml.g5.48xlarge | 48000 |

| CodeLlama-34b-Instruct | meta-textgeneration-llama-codellama-34b-instruct | ml.g5.48xlarge | 48000 |

| CodeLlama-34b-Python | meta-textgeneration-llama-codellama-34b-python | ml.g5.48xlarge | 48000 |

في حين تم تدريب نماذج Code Llama على طول سياق يصل إلى 16,000 رمز مميز، فقد أبلغت النماذج عن أداء جيد على نوافذ سياق أكبر. الحد الأقصى لعمود الرموز المميزة المدعومة في الجدول السابق هو الحد الأعلى لنافذة السياق المدعومة في نوع المثيل الافتراضي. نظرًا لأن نموذج Code Llama 7B يمكنه دعم 10,000 رمز مميز فقط على مثيل ml.g5.2xlarge، فإننا نوصي بنشر إصدار نموذج 13B أو 34B إذا كانت هناك حاجة إلى سياقات أكبر لتطبيقك.

بشكل افتراضي، تعمل كافة النماذج لمهام إنشاء التعليمات البرمجية. يستجيب كل من النموذجين الأساسي والإرشادي لمهام التنفيذ، على الرغم من أن النموذج الأساسي يتمتع بمخرجات ذات جودة أفضل بالنسبة لغالبية استعلامات العينة. وأخيرًا، تعمل نماذج التعليمات فقط على مهام التعليمات. يوضح الجدول التالي النماذج التي تتمتع بأداء جيد (جيد) وأداء متوسط (معتدل) في أمثلة الاستعلامات في دفاتر الملاحظات التجريبية.

| . | رمز الجيل | تعبئة الكود | تعليمات الكود |

| كود لاما-7ب | الخير | الخير | N / A |

| CodeLlama-7b-Instruct | الخير | معتدل | الخير |

| CodeLlama-7b-Python | الخير | N / A | N / A |

| كود لاما-13ب | الخير | الخير | N / A |

| CodeLlama-13b-Instruct | الخير | معتدل | الخير |

| CodeLlama-13b-Python | الخير | N / A | N / A |

| كود لاما-34ب | الخير | N / A | N / A |

| CodeLlama-34b-Instruct | الخير | N / A | الخير |

| CodeLlama-34b-Python | الخير | N / A | N / A |

رمز الجيل

تم تشغيل الأمثلة التالية على نموذج CodeLlama-34b-Instruct مع معلمات الحمولة النافعة "parameters": {"max_new_tokens": 256, "temperature": 0.2, "top_p": 0.9}:

تعبئة الكود

تتضمن عملية ملء التعليمات البرمجية إرجاع التعليمات البرمجية التي تم إنشاؤها في ضوء السياق المحيط. وهذا يختلف عن مهمة إنشاء التعليمات البرمجية لأنه، بالإضافة إلى مقطع رمز البادئة، يتم تزويد النموذج أيضًا بلاحقة مقطع التعليمات البرمجية. تم استخدام رموز خاصة أثناء الضبط الدقيق لتحديد بداية البادئة (<PRE>)، بداية اللاحقة (<SUF>) ، وبداية الوسط (<MID>). يجب أن تكون تسلسلات الإدخال للنموذج بأحد التنسيقات التالية:

- بادئة-لاحقة-الوسطى -

<PRE> {prefix} <SUF>{suffix} <MID> - لاحقة البادئة الأوسط -

<PRE> <SUF>{suffix} <MID> {prefix}

تستخدم الأمثلة التالية تنسيق البادئة واللاحقة الوسطى في نموذج CodeLlama-7b مع الحمولة parameters {"max_new_tokens": 256, "temperature": 0.05, "top_p": 0.9}:

تعليمات الكود

قدمت Meta أيضًا إصدارًا مضبوطًا للتعليمات من Code Llama. لا يمكن تطبيق نماذج الاستعلامات في هذا القسم إلا على نماذج Code Llama التي تم ضبطها للتعليمات، وهي النماذج التي تحتوي على لاحقة تعليمات لمعرف النموذج. تنسيق Code Llama للتعليمات هو نفس تنسيق المطالبة Llama-2-chat، والذي نوضحه بالتفصيل نماذج Llama 2 الأساسية متاحة الآن في SageMaker JumpStart

قد تبدو مطالبة المستخدم البسيطة كما يلي:

يمكنك أيضًا إضافة موجه النظام بالصيغة التالية:

أخيرًا، يمكنك إجراء تفاعل تحادثي مع النموذج من خلال تضمين جميع مطالبات المستخدم السابقة واستجابات المساعد في الإدخال:

تم تشغيل هذه الأمثلة على نموذج CodeLlama-13b-Instruct مع معلمات الحمولة النافعة "المعلمات": {"max_new_tokens": 512, "temperature": 0.2, "top_p": 0.9}:

تنظيف

بعد الانتهاء من تشغيل دفتر الملاحظات، تأكد من حذف كافة الموارد التي قمت بإنشائها في العملية حتى يتم إيقاف الفوترة. استخدم الكود التالي:

وفي الختام

في هذا المنشور، أوضحنا لك كيفية البدء باستخدام نماذج Code Llama في SageMaker Studio ونشر النموذج لإنشاء التعليمات البرمجية واللغة الطبيعية حول التعليمات البرمجية من كل من التعليمات البرمجية ومطالبات اللغة الطبيعية. نظرًا لأن النماذج الأساسية تم تدريبها مسبقًا، فيمكنها المساعدة في تقليل تكاليف التدريب والبنية التحتية وتمكين التخصيص لحالة الاستخدام الخاصة بك. تفضل بزيارة SageMaker JumpStart في SageMaker Studio الآن للبدء.

الموارد

عن المؤلفين

غابرييل سينايف هو مدير أبحاث في فريق Facebook AI Research (FAIR) في Meta. قبل انضمامه إلى ميتا، كان غابرييل زميلًا لما بعد الدكتوراه في فريق إيمانويل دوبو في مدرسة الأساتذة العليا في باريس، حيث عمل على الهندسة العكسية لاكتساب اللغة عند الأطفال. حصل غابرييل على درجة الدكتوراه في النمذجة الافتراضية المطبقة على الألعاب الإستراتيجية في الوقت الفعلي (الذكاء الاصطناعي) من جامعة غرونوبل.

غابرييل سينايف هو مدير أبحاث في فريق Facebook AI Research (FAIR) في Meta. قبل انضمامه إلى ميتا، كان غابرييل زميلًا لما بعد الدكتوراه في فريق إيمانويل دوبو في مدرسة الأساتذة العليا في باريس، حيث عمل على الهندسة العكسية لاكتساب اللغة عند الأطفال. حصل غابرييل على درجة الدكتوراه في النمذجة الافتراضية المطبقة على الألعاب الإستراتيجية في الوقت الفعلي (الذكاء الاصطناعي) من جامعة غرونوبل.

عيسى جميل هو مهندس شريك RL في الذكاء الاصطناعي التوليدي في Meta.

عيسى جميل هو مهندس شريك RL في الذكاء الاصطناعي التوليدي في Meta.

دكتور كايل أولريش هو عالم تطبيقي مع فريق Amazon SageMaker JumpStart. تشمل اهتماماته البحثية خوارزميات التعلم الآلي القابلة للتطوير ، والرؤية الحاسوبية ، والسلاسل الزمنية ، والمعاملات البايزية غير البارامترية ، والعمليات الغاوسية. حصل على درجة الدكتوراه من جامعة ديوك وقد نشر أبحاثًا في NeurIPS و Cell و Neuron.

دكتور كايل أولريش هو عالم تطبيقي مع فريق Amazon SageMaker JumpStart. تشمل اهتماماته البحثية خوارزميات التعلم الآلي القابلة للتطوير ، والرؤية الحاسوبية ، والسلاسل الزمنية ، والمعاملات البايزية غير البارامترية ، والعمليات الغاوسية. حصل على درجة الدكتوراه من جامعة ديوك وقد نشر أبحاثًا في NeurIPS و Cell و Neuron.

د. أشيش خيتان هو عالم تطبيقي أقدم في Amazon SageMaker JumpStart ويساعد في تطوير خوارزميات التعلم الآلي. حصل على الدكتوراه من جامعة إلينوي في أوربانا شامبين. وهو باحث نشط في التعلم الآلي والاستدلال الإحصائي ، وقد نشر العديد من الأوراق البحثية في مؤتمرات NeurIPS و ICML و ICLR و JMLR و ACL و EMNLP.

د. أشيش خيتان هو عالم تطبيقي أقدم في Amazon SageMaker JumpStart ويساعد في تطوير خوارزميات التعلم الآلي. حصل على الدكتوراه من جامعة إلينوي في أوربانا شامبين. وهو باحث نشط في التعلم الآلي والاستدلال الإحصائي ، وقد نشر العديد من الأوراق البحثية في مؤتمرات NeurIPS و ICML و ICLR و JMLR و ACL و EMNLP.

فيفيك سينغ هو مدير منتج لدى SageMaker JumpStart. وهو يركز على تمكين العملاء من الانضمام إلى SageMaker JumpStart لتبسيط وتسريع رحلة التعلم الآلي الخاصة بهم لبناء تطبيقات الذكاء الاصطناعي التوليدية.

فيفيك سينغ هو مدير منتج لدى SageMaker JumpStart. وهو يركز على تمكين العملاء من الانضمام إلى SageMaker JumpStart لتبسيط وتسريع رحلة التعلم الآلي الخاصة بهم لبناء تطبيقات الذكاء الاصطناعي التوليدية.

- محتوى مدعوم من تحسين محركات البحث وتوزيع العلاقات العامة. تضخيم اليوم.

- PlatoData.Network Vertical Generative Ai. تمكين نفسك. الوصول هنا.

- أفلاطونايستريم. ذكاء Web3. تضخيم المعرفة. الوصول هنا.

- أفلاطون كربون، كلينتك ، الطاقة، بيئة، شمسي، إدارة المخلفات. الوصول هنا.

- أفلاطون هيلث. التكنولوجيا الحيوية وذكاء التجارب السريرية. الوصول هنا.

- المصدر https://aws.amazon.com/blogs/machine-learning/code-llama-code-generation-models-from-meta-are-now-available-via-amazon-sagemaker-jumpstart/