أثبتت تطبيقات الذكاء الاصطناعي التوليدي (AI) المبنية على نماذج لغوية كبيرة (LLMs) القدرة على إنشاء وتسريع القيمة الاقتصادية للشركات. وتشمل أمثلة التطبيقات بحث محادثة, مساعدة وكيل دعم العملاء, تحليلات دعم العملاء, المساعدون الافتراضيون للخدمة الذاتية, chatbots, جيل الوسائط الغنية, المحتوى الاعتدال, رفاق الترميز لتسريع تطوير البرامج الآمنة وعالية الأداء, رؤى أعمق من مصادر المحتوى متعدد الوسائط, تسريع التحقيقات والتخفيفات الأمنية لمؤسستك، وأكثر بكثير. يبحث العديد من العملاء عن إرشادات حول كيفية إدارة الأمان والخصوصية والامتثال أثناء قيامهم بتطوير تطبيقات الذكاء الاصطناعي التوليدية. يساعد فهم ومعالجة نقاط الضعف والتهديدات والمخاطر في LLM أثناء مرحلتي التصميم والهندسة المعمارية الفرق على التركيز على تعظيم الفوائد الاقتصادية والإنتاجية التي يمكن أن يحققها الذكاء الاصطناعي المولد. إن إدراك المخاطر يعزز الشفافية والثقة في تطبيقات الذكاء الاصطناعي التوليدية، ويشجع على زيادة إمكانية المراقبة، ويساعد على تلبية متطلبات الامتثال، ويسهل اتخاذ القادة قرارات مستنيرة.

الهدف من هذا المنشور هو تمكين مهندسي الذكاء الاصطناعي والتعلم الآلي (ML) وعلماء البيانات ومهندسي الحلول وفرق الأمان وأصحاب المصلحة الآخرين من الحصول على نموذج عقلي مشترك وإطار لتطبيق أفضل ممارسات الأمان، مما يسمح لفرق الذكاء الاصطناعي/تعلم الآلة بالتحرك سريع دون مقايضة الأمان بالسرعة. على وجه التحديد، يسعى هذا المنشور إلى مساعدة الذكاء الاصطناعي/تعلم الآلة وعلماء البيانات الذين ربما لم يسبق لهم التعرض لمبادئ الأمان على فهم أفضل ممارسات الأمان والخصوصية الأساسية في سياق تطوير تطبيقات الذكاء الاصطناعي التوليدية باستخدام LLMs. نناقش أيضًا المخاوف الأمنية المشتركة التي يمكن أن تقوض الثقة في الذكاء الاصطناعي، كما حددها مشروع أمان التطبيقات المفتوح على مستوى العالم (OWASP) من بين أفضل 10 تطبيقات LLM، واعرض الطرق التي يمكنك من خلالها استخدام AWS لزيادة وضعك الأمني وثقتك أثناء الابتكار باستخدام الذكاء الاصطناعي التوليدي.

يوفر هذا المنشور ثلاث خطوات إرشادية لتصميم استراتيجيات إدارة المخاطر أثناء تطوير تطبيقات الذكاء الاصطناعي التوليدية باستخدام LLMs. نحن نتعمق أولاً في نقاط الضعف والتهديدات والمخاطر التي تنشأ من تنفيذ حلول LLM ونشرها واستخدامها، ونقدم إرشادات حول كيفية بدء الابتكار مع وضع الأمان في الاعتبار. نناقش بعد ذلك مدى أهمية البناء على أساس آمن للذكاء الاصطناعي التوليدي. وأخيرًا، نقوم بربط هذه العناصر معًا مع مثال لعبء عمل LLM لوصف نهج تجاه الهندسة المعمارية مع الأمن الدفاعي المتعمق عبر حدود الثقة.

بحلول نهاية هذا المنصب, سيتمكن مهندسو الذكاء الاصطناعي/تعلم الآلة وعلماء البيانات والتقنيون ذوو التفكير الأمني من تحديد استراتيجيات لتصميم الدفاعات ذات الطبقات لتطبيقات الذكاء الاصطناعي التوليدية الخاصة بهم، وفهم كيفية رسم خريطة OWASP Top 10 للمخاوف الأمنية لماجستير إدارة الأعمال لبعض الضوابط المقابلة، وبناء المعرفة الأساسية نحو الإجابة على أهم موضوعات أسئلة عملاء AWS التالية لتطبيقاتهم:

- ما هي بعض مخاطر الأمان والخصوصية الشائعة عند استخدام الذكاء الاصطناعي التوليدي القائم على ماجستير إدارة الأعمال في تطبيقاتي والتي يمكنني التأثير عليها بشكل كبير من خلال هذا التوجيه؟

- ما هي بعض الطرق لتنفيذ ضوابط الأمان والخصوصية في دورة حياة التطوير لتطبيقات AI LLM التوليدية على AWS؟

- ما هي أفضل الممارسات التشغيلية والفنية التي يمكنني دمجها في كيفية إنشاء مؤسستي لتطبيقات الذكاء الاصطناعي LLM التوليدية لإدارة المخاطر وزيادة الثقة في تطبيقات الذكاء الاصطناعي التوليدية باستخدام LLMs؟

تحسين النتائج الأمنية أثناء تطوير الذكاء الاصطناعي التوليدي

يتطلب الابتكار باستخدام الذكاء الاصطناعي التوليدي باستخدام LLMs البدء مع وضع الأمان في الاعتبار لتطوير المرونة التنظيمية، والبناء على أساس آمن، ودمج الأمان مع نهج أمني دفاعي متعمق. الأمن هو أ المسؤولية المشتركة بين عملاء AWS وAWS. تنطبق جميع مبادئ نموذج المسؤولية المشتركة لدى AWS على حلول الذكاء الاصطناعي التوليدية. قم بتحديث فهمك لنموذج المسؤولية المشتركة في AWS لأنه ينطبق على البنية التحتية والخدمات والبيانات عند إنشاء حلول LLM.

ابدأ مع وضع الأمان في الاعتبار لتطوير المرونة التنظيمية

ابدأ مع وضع الأمان في الاعتبار لتطوير المرونة التنظيمية لتطوير تطبيقات الذكاء الاصطناعي التوليدية التي تلبي أهداف الأمان والامتثال لديك. تعتمد المرونة التنظيمية على وتوسع نطاق تعريف المرونة في إطار عمل AWS Well-Architected لتشمل والاستعداد لقدرة المنظمة على التعافي من الاضطرابات. ضع في اعتبارك وضعك الأمني وإدارتك وتميزك التشغيلي عند تقييم الاستعداد العام لتطوير الذكاء الاصطناعي التوليدي مع حاملي شهادات LLM والمرونة التنظيمية لديك في مواجهة أي تأثيرات محتملة. بينما تعمل مؤسستك على تطوير استخدامها للتقنيات الناشئة مثل الذكاء الاصطناعي التوليدي وLLMs، يجب اعتبار المرونة التنظيمية الشاملة بمثابة حجر الزاوية في استراتيجية دفاعية متعددة الطبقات لحماية الأصول وخطوط الأعمال من العواقب غير المقصودة.

تعتبر المرونة التنظيمية ذات أهمية كبيرة لتطبيقات LLM

على الرغم من أن جميع برامج إدارة المخاطر يمكن أن تستفيد من المرونة، إلا أن المرونة التنظيمية لها أهمية كبيرة بالنسبة للذكاء الاصطناعي التوليدي. تعتمد خمسة من أهم 10 مخاطر حددتها OWASP لتطبيقات LLM على تحديد الضوابط المعمارية والتشغيلية وإنفاذها على المستوى التنظيمي من أجل إدارة المخاطر. هذه المخاطر الخمسة هي التعامل غير الآمن مع المخرجات، ونقاط الضعف في سلسلة التوريد، والكشف عن المعلومات الحساسة، والوكالة المفرطة، والاعتماد المفرط. ابدأ في زيادة المرونة التنظيمية من خلال التواصل الاجتماعي بين فرقك لاعتبار الذكاء الاصطناعي وتعلم الآلة وأمن الذكاء الاصطناعي التوليدي متطلبًا أساسيًا للأعمال وأولوية قصوى طوال دورة حياة المنتج بأكملها، بدءًا من بداية الفكرة وحتى البحث وحتى تطوير التطبيق ونشره و يستخدم. بالإضافة إلى الوعي، يجب على فرقك اتخاذ الإجراءات اللازمة لمراعاة الذكاء الاصطناعي التوليدي في ممارسات الحوكمة والضمان والتحقق من الامتثال.

بناء المرونة التنظيمية حول الذكاء الاصطناعي التوليدي

يمكن للمؤسسات البدء في اعتماد طرق لبناء قدراتها وإمكانياتها فيما يتعلق بالذكاء الاصطناعي/التعلم الآلي وأمن الذكاء الاصطناعي التوليدي داخل مؤسساتها. يجب أن تبدأ بتوسيع برامج الأمان والضمان والامتثال والتطوير الحالية لديك لتأخذ في الاعتبار الذكاء الاصطناعي التوليدي.

فيما يلي المجالات الخمسة الرئيسية التي تهم الذكاء الاصطناعي التنظيمي وتعلم الآلة وأمن الذكاء الاصطناعي التوليدي:

- فهم المشهد الأمني للذكاء الاصطناعي/تعلم الآلة

- تضمين وجهات نظر متنوعة في الاستراتيجيات الأمنية

- اتخاذ إجراءات استباقية لتأمين أنشطة البحث والتطوير

- مواءمة الحوافز مع النتائج التنظيمية

- استعد لسيناريوهات أمنية واقعية في الذكاء الاصطناعي/التعلم الآلي والذكاء الاصطناعي التوليدي

قم بتطوير نموذج التهديد طوال دورة حياة الذكاء الاصطناعي التوليدية

ينبغي للمؤسسات التي تعتمد على الذكاء الاصطناعي التوليدي أن تركز على إدارة المخاطر، وليس القضاء عليها، وتضمينها نمذجة التهديد في و تخطيط استمرارية الأعمال تخطيط وتطوير وعمليات أعباء عمل الذكاء الاصطناعي التوليدي. يمكنك العمل بشكل عكسي بدءًا من الاستخدام الإنتاجي للذكاء الاصطناعي التوليدي من خلال تطوير نموذج تهديد لكل تطبيق باستخدام المخاطر الأمنية التقليدية بالإضافة إلى المخاطر الخاصة بالذكاء الاصطناعي التوليدي. قد تكون بعض المخاطر مقبولة لشركتك، ويمكن أن يساعد تمرين نمذجة التهديدات شركتك على تحديد مدى قبولك للمخاطرة. على سبيل المثال، قد لا يتطلب عملك وقت تشغيل بنسبة 99.999% على تطبيق الذكاء الاصطناعي المولد، وبالتالي فإن وقت الاسترداد الإضافي المرتبط بالاسترداد باستخدام أوس النسخ الاحتياطي مع أمازون S3 الجليدي قد يكون خطرا مقبولا. على العكس من ذلك، قد تكون البيانات الموجودة في النموذج الخاص بك حساسة للغاية ومنظمة للغاية، لذا فإن الانحراف عنها خدمة إدارة مفتاح AWS (AWS KMS) مفتاح يديره العميل (CMK) التناوب واستخدام جدار حماية شبكة AWS للمساعدة في فرض أمان طبقة النقل (TLS) لحركة الدخول والخروج للحماية من تسرب البيانات قد يكون خطرًا غير مقبول.

قم بتقييم المخاطر (المتأصلة مقابل المتبقية) لاستخدام تطبيق الذكاء الاصطناعي التوليدي في بيئة الإنتاج لتحديد الضوابط الأساسية ومستوى التطبيق الصحيحة. خطط للتراجع والاسترداد من أحداث أمان الإنتاج وانقطاعات الخدمة مثل الحقن السريع وتسميم بيانات التدريب ورفض نموذج الخدمة وسرقة النموذج في وقت مبكر، وحدد وسائل التخفيف التي ستستخدمها عند تحديد متطلبات التطبيق. إن التعرف على المخاطر والضوابط التي يجب وضعها سيساعد في تحديد أفضل نهج تنفيذ لبناء تطبيق ذكاء اصطناعي مولد، وتزويد أصحاب المصلحة وصناع القرار بالمعلومات اللازمة لاتخاذ قرارات عمل مستنيرة بشأن المخاطر. إذا لم تكن على دراية بسير عمل الذكاء الاصطناعي والتعلم الآلي بشكل عام، فابدأ بالمراجعة 7 طرق لتحسين أمان أعباء عمل التعلم الآلي لديك لزيادة الإلمام بضوابط الأمان اللازمة لأنظمة الذكاء الاصطناعي/التعلم الآلي التقليدية.

تمامًا مثل إنشاء أي تطبيق تعلم الآلة، فإن إنشاء تطبيق ذكاء اصطناعي مولد يتضمن المرور بمجموعة من مراحل دورة حياة البحث والتطوير. قد ترغب في مراجعة مصفوفة نطاق أمان الذكاء الاصطناعي التوليدية من AWS للمساعدة في بناء نموذج عقلي لفهم التخصصات الأمنية الرئيسية التي يجب عليك مراعاتها اعتمادًا على حل الذكاء الاصطناعي المنتج الذي تختاره.

عادةً ما يتم تطوير تطبيقات الذكاء الاصطناعي التوليدية التي تستخدم LLMs وتشغيلها باتباع الخطوات المطلوبة:

- متطلبات الاستمارة – تحديد أهداف العمل ومتطلبات ومعايير النجاح لحالة الاستخدام

- اختيار النموذج - حدد نموذجًا أساسيًا يتوافق مع متطلبات حالة الاستخدام

- تكييف النموذج وضبطه – إعداد البيانات والمطالبات الهندسية وضبط النموذج

- تقييم النموذج - تقييم النماذج الأساسية باستخدام مقاييس خاصة بحالة الاستخدام واختيار النموذج الأفضل أداءً

- النشر والتكامل – انشر النموذج الأساسي المحدد على البنية التحتية المحسنة لديك وادمجه مع تطبيق الذكاء الاصطناعي التوليدي الخاص بك

- مراقبة التطبيق - مراقبة أداء التطبيق والنموذج لتمكين تحليل السبب الجذري

تأكد من فهم الفرق للطبيعة الحرجة للأمان كجزء من مراحل التصميم والهندسة المعمارية لدورة حياة تطوير البرامج الخاصة بك في اليوم الأول. وهذا يعني مناقشة الأمان في كل طبقة من طبقات الحزمة ودورة الحياة، ووضع الأمان والخصوصية كعوامل تمكين لتحقيق أهداف العمل. يتحكم المهندس المعماري في التهديدات قبل إطلاق تطبيق LLM الخاص بك، ويفكر فيما إذا كانت البيانات والمعلومات التي ستستخدمها لتكييف النموذج وأوامر الضبط الدقيق تتحكم في التنفيذ في بيئات البحث والتطوير والتدريب. كجزء من اختبارات ضمان الجودة، قم بتقديم تهديدات أمنية اصطناعية (مثل محاولة تسميم بيانات التدريب، أو محاولة استخراج البيانات الحساسة من خلال هندسة سريعة ضارة) لاختبار دفاعاتك وموقفك الأمني بشكل منتظم.

بالإضافة إلى ذلك، يجب على أصحاب المصلحة إنشاء إيقاع مراجعة متسق لأحمال عمل الذكاء الاصطناعي وتعلم الآلة والذكاء الاصطناعي التوليدي وتحديد الأولوية التنظيمية لفهم المفاضلات بين التحكم البشري والآلي والخطأ قبل الإطلاق. إن التحقق من صحة هذه المقايضات والتأكد من احترامها في تطبيقات LLM المنشورة سيزيد من احتمالية نجاح تخفيف المخاطر.

أنشئ تطبيقات ذكاء اصطناعي توليدية على أسس سحابية آمنة

في AWS، الأمان هو أولويتنا القصوى. تم تصميم AWS لتكون البنية التحتية السحابية العالمية الأكثر أمانًا والتي يمكن من خلالها إنشاء التطبيقات وأحمال العمل وترحيلها وإدارتها. ويدعم ذلك مجموعتنا العميقة المكونة من أكثر من 300 أداة أمان سحابية وثقة الملايين من عملائنا، بما في ذلك المؤسسات الأكثر حساسية للأمان مثل الحكومة والرعاية الصحية والخدمات المالية. عند إنشاء تطبيقات ذكاء اصطناعي إبداعية باستخدام LLMs على AWS، فإنك تحصل على فوائد أمنية من بيئة حوسبة سحابية آمنة وموثوقة ومرنة من AWS.

استخدم البنية التحتية العالمية لـ AWS للأمان والخصوصية والامتثال

عندما تقوم بتطوير تطبيقات كثيفة البيانات على AWS، يمكنك الاستفادة من البنية التحتية لمنطقة AWS العالمية، والتي تم تصميمها لتوفير إمكانات لتلبية متطلبات الأمان والامتثال الأساسية لديك. وهذا ما يعززه لدينا تعهد السيادة الرقمية لشركة AWS، التزامنا بتقديم المجموعة الأكثر تقدمًا من عناصر التحكم والميزات المتوفرة في السحابة. نحن ملتزمون بتوسيع قدراتنا للسماح لك بتلبية احتياجاتك السيادة الرقمية الاحتياجات، دون المساس بالأداء أو الابتكار أو الأمان أو حجم سحابة AWS. لتبسيط تنفيذ أفضل ممارسات الأمان والخصوصية، فكر في استخدام التصميمات المرجعية والبنية التحتية كموارد للتعليمات البرمجية مثل البنية المرجعية لأمان AWS (AWS SRA) و البنية المرجعية للخصوصية في AWS (AWS PRA). مزيد من المعلومات حول هندسة حلول الخصوصية, السيادة حسب التصميمو الامتثال على AWS واستخدام الخدمات مثل تكوين AWS, قطعة أثرية AWSو مدير التدقيق في AWS لدعم احتياجات الخصوصية والامتثال والتدقيق وقابلية المراقبة.

افهم وضع الأمان الخاص بك باستخدام AWS Well-Architected وCloud Adoption Frameworks

تقدم AWS إرشادات حول أفضل الممارسات التي تم تطويرها بناءً على سنوات من الخبرة في دعم العملاء في تصميم بيئاتهم السحابية باستخدام إطار عمل AWS المصمم جيدًا وفي التطور لتحقيق قيمة الأعمال من التقنيات السحابية مع إطار اعتماد سحابة AWS (AWS CAF). افهم الوضع الأمني لأحمال عمل الذكاء الاصطناعي والتعلم الآلي والذكاء الاصطناعي التوليدي لديك من خلال إجراء مراجعة جيدة لإطار العمل. يمكن إجراء المراجعات باستخدام أدوات مثل أداة AWS جيدة التصميمأو بمساعدة فريق AWS الخاص بك من خلال دعم مؤسسة AWS. أداة AWS جيدة التصميم يدمج الرؤى تلقائيًا تبدأ من مستشار AWS الموثوق به لتقييم أفضل الممارسات المطبقة والفرص المتاحة لتحسين الأداء الوظيفي وتحسين التكلفة. توفر أداة AWS Well-Architected أيضًا عدسات مخصصة مع أفضل الممارسات المحددة مثل عدسة التعلم الآلي لكي تتمكن من قياس أبنيتك بانتظام وفقًا لأفضل الممارسات وتحديد مجالات التحسين. حدد رحلتك على الطريق نحو تحقيق القيمة والنضج السحابي من خلال فهم كيفية اعتماد عملاء AWS لاستراتيجيات لتطوير القدرات التنظيمية في إطار عمل اعتماد سحابة AWS للذكاء الاصطناعي والتعلم الآلي والذكاء الاصطناعي التوليدي. قد تجد أيضًا فائدة في فهم جاهزيتك السحابية بشكل عام من خلال المشاركة في تقييم جاهزية سحابة AWS. توفر AWS فرصًا إضافية للمشاركة — اطلب من فريق حساب AWS الخاص بك الحصول على مزيد من المعلومات حول كيفية البدء باستخدام مركز ابتكار الذكاء الاصطناعي التوليدي.

قم بتسريع عملية تعلم الأمان والذكاء الاصطناعي/تعلم الآلة من خلال التوجيه والتدريب والاعتماد بشأن أفضل الممارسات

تقوم AWS أيضًا برعاية التوصيات من أفضل ممارسات الأمان والهوية والامتثال و وثائق أمان AWS لمساعدتك في تحديد طرق تأمين بيئات التدريب والتطوير والاختبار والتشغيل الخاصة بك. إذا كنت قد بدأت للتو، فتعمق أكثر في التدريب والشهادة الأمنية، وفكر في البدء بها أساسيات أمان AWS و خطة تعلم أمان AWS. يمكنك أيضا استخدام نموذج نضج أمان AWS للمساعدة في إرشادك للعثور على أفضل الأنشطة وتحديد أولوياتها في مراحل مختلفة من النضج على AWS، بدءًا من المكاسب السريعة، مرورًا بالمراحل التأسيسية والفعالة والمُحسّنة. بعد أن يكون لديك أنت وفرقك فهم أساسي للأمان في AWS، نوصي بشدة بالمراجعة كيفية التعامل مع نمذجة التهديد ومن ثم قيادة تمرين نمذجة التهديد مع فرقك بدءًا من ورشة عمل نمذجة التهديدات للبناة برنامج تدريب. هناك العديد من الآخرين موارد التدريب والاعتماد الخاصة بـ AWS Security متاح.

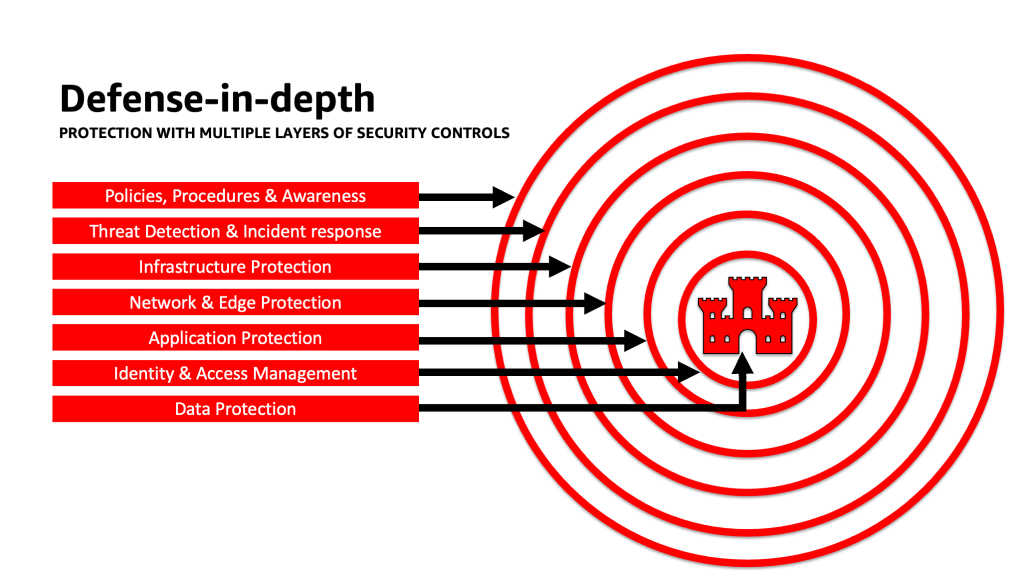

تطبيق نهج الدفاع المتعمق لتأمين تطبيقات LLM

يمكن أن يساعد تطبيق نهج أمان دفاعي متعمق على أعباء العمل والبيانات والمعلومات المنتجة للذكاء الاصطناعي في تهيئة أفضل الظروف لتحقيق أهداف عملك. تعمل أفضل ممارسات الأمان الدفاعي المتعمق على تخفيف العديد من المخاطر الشائعة التي يواجهها أي عبء عمل، مما يساعدك أنت وفرقك على تسريع ابتكارات الذكاء الاصطناعي التوليدية لديك. تستخدم إستراتيجية الأمان الدفاعية المتعمقة دفاعات متكررة متعددة لحماية حسابات AWS وأعباء العمل والبيانات والأصول الخاصة بك. فهو يساعد على التأكد من أنه في حالة اختراق أي عنصر تحكم أمني أو فشله، توجد طبقات إضافية للمساعدة في عزل التهديدات ومنع الأحداث الأمنية واكتشافها والاستجابة لها والتعافي منها. يمكنك استخدام مجموعة من الاستراتيجيات، بما في ذلك خدمات وحلول AWS، في كل طبقة لتحسين أمان ومرونة أعباء عمل الذكاء الاصطناعي التوليدية لديك.

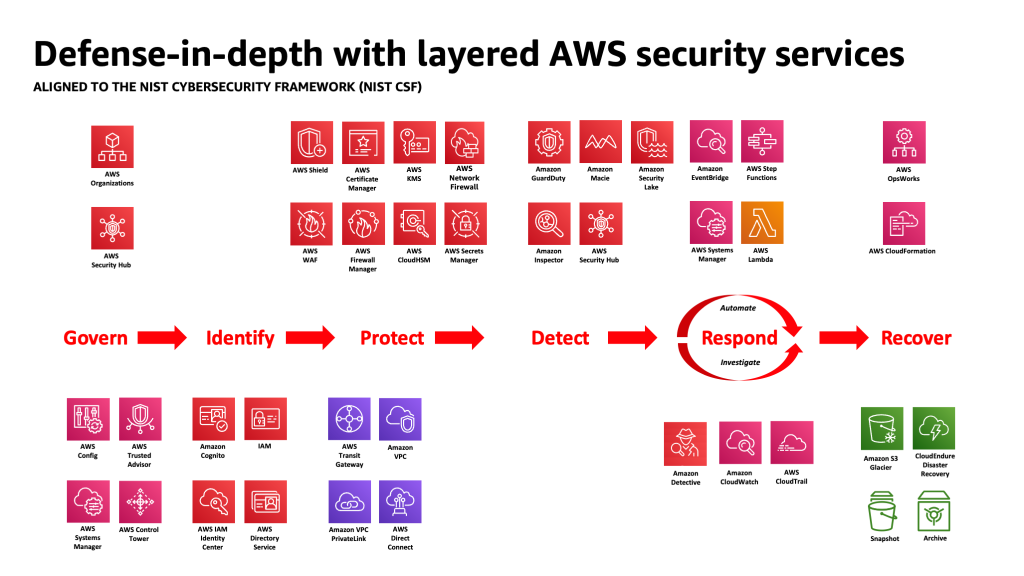

يتوافق العديد من عملاء AWS مع أطر العمل القياسية الصناعية، مثل NIST إطار الأمن السيبراني. يساعد إطار العمل هذا على التأكد من أن دفاعات الأمان الخاصة بك تتمتع بالحماية عبر ركائز التحديد والحماية والكشف والاستجابة والاسترداد والإدارة التي تمت إضافتها مؤخرًا. يمكن بعد ذلك ربط إطار العمل هذا بسهولة بخدمات AWS Security وتلك المقدمة من جهات خارجية متكاملة أيضًا لمساعدتك في التحقق من التغطية والسياسات الكافية لأي حدث أمني تواجهه مؤسستك.

الدفاع بعمق: قم بتأمين بيئتك، ثم قم بإضافة إمكانات الخصوصية والأمان المحسنة الخاصة بالذكاء الاصطناعي/تعلم الآلة

يجب أن تبدأ استراتيجية الدفاع المتعمق بحماية حساباتك ومؤسستك أولاً، ثم طبقة من ميزات الأمان والخصوصية الإضافية المعززة للخدمات مثل أمازون بيدروك و الأمازون SageMaker. لدى أمازون أكثر من 30 خدمة في محفظة الأمان والهوية والامتثال والتي تم دمجها مع خدمات AWS AI/ML، ويمكن استخدامها معًا للمساعدة في تأمين أعباء العمل والحسابات والمؤسسة. للدفاع بشكل صحيح ضد OWASP Top 10 for LLM، يجب استخدامها مع خدمات AWS AI/ML.

ابدأ بتنفيذ سياسة الامتيازات الأقل، باستخدام خدمات مثل محلل الوصول IAM إلى ابحث عن الحسابات والأدوار والموارد المفرطة في التساهل لتقييد الوصول باستخدام بيانات الاعتماد قصيرة المدى. بعد ذلك، تأكد من تشفير جميع البيانات غير النشطة باستخدام AWS KMS، بما في ذلك النظر في استخدام CMKs، وإصدار جميع البيانات والنماذج ونسخها احتياطيًا باستخدام خدمة تخزين أمازون البسيطة (Amazon S3) إصدار وتطبيق الثبات على مستوى الكائن مع قفل كائن أمازون S3. حماية جميع البيانات أثناء النقل بين الخدمات باستخدام مدير شهادات AWS و / أو CA الخاصة بـ AWS، والاحتفاظ بها داخل VPCs باستخدام AWS الرابط الخاص. حدد قواعد صارمة لإدخال وإخراج البيانات للمساعدة في الحماية من التلاعب والتسلل باستخدام VPCs جدار حماية شبكة AWS سياسات. فكر في الإدراج جدار حماية تطبيق ويب AWS (AWS WAF) أمام حماية تطبيقات الويب وواجهات برمجة التطبيقات تبدأ من الروبوتات الخبيثة, هجمات حقن SQL، والبرمجة النصية عبر المواقع (XSS)، وعمليات الاستيلاء على الحساب مع مراقبة الاحتيال. التسجيل مع أوس كلاود تريل, سحابة أمازون الافتراضية الخاصة سجلات التدفق (Amazon VPC)، و خدمة أمازون مطاطا Kubernetes ستساعد سجلات التدقيق (Amazon EKS) في توفير مراجعة جنائية لكل معاملة متاحة لخدمات مثل محقق أمازون. يمكنك استخدام مفتش أمازون لأتمتة اكتشاف الثغرات الأمنية وإدارتها الأمازون الحوسبة المرنة السحابية (Amazon EC2) المثيلات والحاويات، AWS لامدا وظائف و تحديد إمكانية الوصول إلى الشبكة لأحمال العمل الخاصة بك. قم بحماية بياناتك ونماذجك من الأنشطة المشبوهة باستخدام واجب الحرس الأمازوننماذج التهديدات وخلاصات المعلومات التي تعمل بالتعلم الآلي، وتمكين ميزاتها الإضافية لحماية EKS، وحماية ECS، وحماية S3، وحماية RDS، والحماية من البرامج الضارة، وحماية Lambda، والمزيد. يمكنك استخدام خدمات مثل مركز أمان AWS لتجميع فحوصات الأمان الخاصة بك وأتمتتها بشكل مركزي لاكتشاف الانحرافات عن أفضل ممارسات الأمان وتسريع التحقيق وأتمتة معالجة نتائج الأمان باستخدام أدلة التشغيل. يمكنك أيضًا التفكير في تنفيذ أ الثقة صفر البنية التحتية على AWS لزيادة المصادقة الدقيقة وضوابط الترخيص لما يمكن للمستخدمين البشريين أو العمليات من آلة إلى آلة الوصول إليه على أساس كل طلب. ضع في اعتبارك أيضًا استخدام بحيرة أمان أمازون لتجميع بيانات الأمان تلقائيًا من بيئات AWS وموفري SaaS والمحليين والمصادر السحابية في مستودع بيانات مصمم خصيصًا لهذا الغرض ومخزن في حسابك. باستخدام Security Lake، يمكنك الحصول على فهم أكثر اكتمالًا لبيانات الأمان الخاصة بك عبر مؤسستك بأكملها.

بعد تأمين بيئة عمل الذكاء الاصطناعي التوليدية لديك، يمكنك إضافة ميزات خاصة بالذكاء الاصطناعي/تعلم الآلة، مثل أمازون سيج ميكر داتا رانجلر لتحديد التحيز المحتمل أثناء إعداد البيانات و توضيح Amazon SageMaker للكشف عن التحيز في بيانات ونماذج تعلم الآلة. تستطيع ايضا استخذام الأمازون SageMaker نموذج مراقب لتقييم جودة نماذج SageMaker ML في الإنتاج، وإعلامك عند حدوث انحراف في جودة البيانات وجودة النموذج وإسناد الميزات. يمكن أن تساعدك خدمات AWS AI/ML التي تعمل معًا (بما في ذلك SageMaker الذي يعمل مع Amazon Bedrock) مع خدمات AWS Security في تحديد المصادر المحتملة للتحيز الطبيعي والحماية من التلاعب الضار بالبيانات. كرر هذه العملية لكل من أفضل 10 ثغرات أمنية في OWASP لـ LLM للتأكد من أنك تقوم بتعظيم قيمة خدمات AWS لتنفيذ الدفاع بعمق لحماية بياناتك وأعباء العمل الخاصة بك.

كما كتب كلارك رودجرز، الخبير الاستراتيجي في AWS Enterprise، في منشور مدونته "رؤية CISO: كل خدمة من خدمات AWS هي خدمة أمنية""أود أن أزعم أن كل خدمة تقريبًا ضمن سحابة AWS إما تتيح نتيجة أمنية بحد ذاتها، أو يمكن استخدامها (بمفردها أو بالاشتراك مع خدمة واحدة أو أكثر) من قبل العملاء لتحقيق هدف الأمان أو المخاطر أو الامتثال." و"قد يرغب كبار مسؤولي أمن معلومات العملاء (CISOs) (أو فرقهم) في تخصيص الوقت للتأكد من أنهم على دراية جيدة بجميع خدمات AWS لأنه قد يكون هناك هدف يتعلق بالأمان أو المخاطر أو الامتثال يمكن تحقيقه، حتى لو كانت الخدمة لا تندرج ضمن فئة "الأمان والهوية والامتثال".

طبقة الدفاعات عند حدود الثقة في تطبيقات LLM

عند تطوير أنظمة وتطبيقات تعتمد على الذكاء الاصطناعي، يجب عليك مراعاة نفس المخاوف كما هو الحال مع أي تطبيق آخر لتعلم الآلة، كما هو مذكور في MITRE ATLAS مصفوفة تهديدات التعلم الآلي، مثل مراعاة أصول البرامج ومكونات البيانات (مثل إجراء تدقيق للبرامج مفتوحة المصدر، ومراجعة قائمة مواد البرامج (SBOMs)، وتحليل سير عمل البيانات وتكاملات واجهة برمجة التطبيقات) وتنفيذ الحماية اللازمة ضد تهديدات سلسلة التوريد LLM. قم بتضمين رؤى من أطر عمل الصناعة، وكن على دراية بطرق استخدام مصادر متعددة لمعلومات التهديدات ومعلومات المخاطر لضبط وتوسيع دفاعاتك الأمنية لمراعاة مخاطر الذكاء الاصطناعي وتعلم الآلة ومخاطر أمان الذكاء الاصطناعي التوليدية الناشئة وغير المضمنة في الأطر التقليدية. ابحث عن معلومات مصاحبة حول المخاطر الخاصة بالذكاء الاصطناعي من المصادر الصناعية والدفاعية والحكومية والدولية والأكاديمية، لأن التهديدات الجديدة تظهر وتتطور في هذا المجال بانتظام ويتم تحديث الأطر والأدلة المصاحبة بشكل متكرر. على سبيل المثال، عند استخدام نموذج إنشاء الاسترجاع المعزز (RAG)، إذا لم يتضمن النموذج البيانات التي يحتاجها، فقد يطلبها من مصدر بيانات خارجي لاستخدامها أثناء الاستدلال والضبط الدقيق. قد يكون المصدر الذي تستعلم عنه خارجًا عن سيطرتك، ويمكن أن يكون مصدرًا محتملاً للتسوية في سلسلة التوريد الخاصة بك. يجب أن يمتد نهج الدفاع المتعمق نحو المصادر الخارجية لبناء الثقة والمصادقة والترخيص والوصول والأمن والخصوصية ودقة البيانات التي يصل إليها. للتعمق أكثر اقرأ "أنشئ تطبيقًا مؤسسيًا آمنًا باستخدام Geneative AI وRAG باستخدام Amazon SageMaker JumpStart"

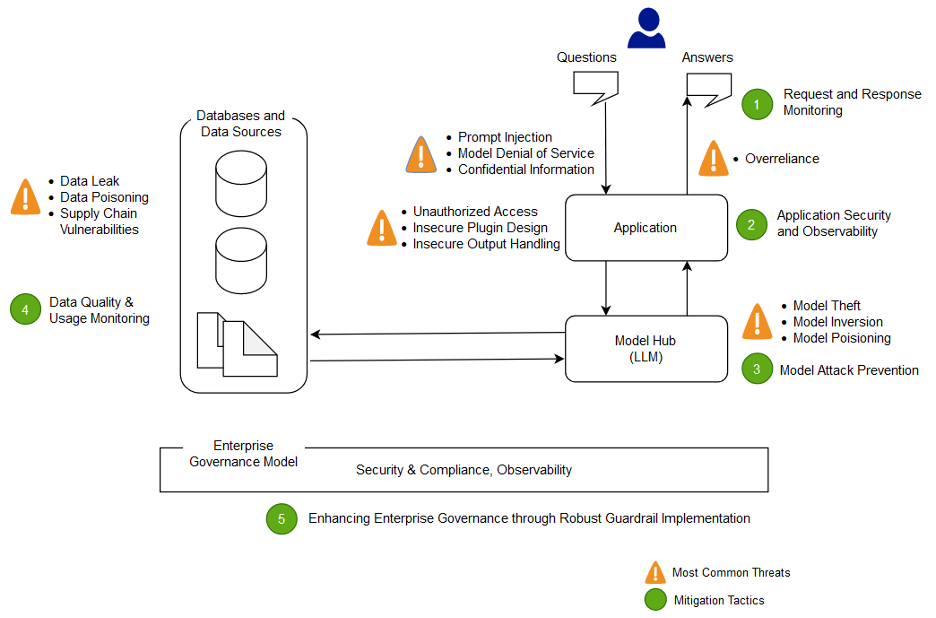

تحليل وتخفيف المخاطر في تطبيقات LLM الخاصة بك

في هذا القسم، نقوم بتحليل ومناقشة بعض تقنيات تخفيف المخاطر بناءً على حدود الثقة والتفاعلات، أو مجالات متميزة من عبء العمل مع نطاق ضوابط مناسب مماثل وملف تعريف المخاطر. في هذه البنية النموذجية لتطبيق chatbot، توجد خمسة حدود ثقة حيث يتم توضيح عناصر التحكم، استنادًا إلى كيفية إنشاء عملاء AWS عادةً لتطبيقات LLM الخاصة بهم. قد يكون لتطبيق LLM الخاص بك حدود ثقة أكثر أو أقل يمكن تحديدها. في نموذج البنية التالي، يتم تعريف حدود الثقة هذه على النحو التالي:

- تفاعلات واجهة المستخدم (الطلب والاستجابة)

- تفاعلات التطبيق

- التفاعلات النموذجية

- تفاعلات البيانات

- التفاعلات التنظيمية والاستخدام

تفاعلات واجهة المستخدم: تطوير مراقبة الطلب والاستجابة

اكتشاف الحوادث السيبرانية المتعلقة بالذكاء الاصطناعي التوليدي والاستجابة لها في الوقت المناسب من خلال تقييم استراتيجية لمعالجة المخاطر من مدخلات ومخرجات تطبيق الذكاء الاصطناعي التوليدي. على سبيل المثال، قد يلزم إجراء مراقبة إضافية للسلوكيات وتدفق البيانات للكشف عن الكشف عن المعلومات الحساسة خارج نطاقك أو مؤسستك، في حالة استخدامها في تطبيق LLM.

يجب أن تظل تطبيقات الذكاء الاصطناعي التوليدية متوافقة مع أفضل ممارسات الأمان القياسية عندما يتعلق الأمر بحماية البيانات. يأسس محيط البيانات الآمنة و تأمين مخازن البيانات الحساسة. تشفير البيانات والمعلومات المستخدمة لتطبيقات LLM أثناء الراحة وأثناء النقل. قم بحماية البيانات المستخدمة لتدريب النموذج الخاص بك من إفساد بيانات التدريب من خلال فهم المستخدمين والعمليات والأدوار المسموح لهم بالمساهمة في مخازن البيانات والتحكم فيها، بالإضافة إلى كيفية تدفق البيانات في التطبيق ومراقبة الانحرافات المتحيزة واستخدام إصدارات و تخزين غير قابل للتغيير في خدمات التخزين مثل Amazon S3. قم بإنشاء ضوابط صارمة للدخول والخروج للبيانات باستخدام خدمات مثل AWS Network Firewall وAWS VPCs للحماية من المدخلات المشبوهة واحتمال تسرب البيانات.

أثناء عملية التدريب أو إعادة التدريب أو الضبط الدقيق، يجب أن تكون على دراية بأي بيانات حساسة يتم استخدامها. بعد استخدام البيانات أثناء إحدى هذه العمليات، يجب عليك التخطيط لسيناريو يصبح فيه أي مستخدم للنموذج الخاص بك قادرًا فجأة على استخراج البيانات أو المعلومات مرة أخرى باستخدام تقنيات الحقن السريع. فهم مخاطر وفوائد استخدام البيانات الحساسة في النماذج والاستدلال الخاص بك. قم بتنفيذ آليات مصادقة وتفويض قوية لإنشاء وإدارة أذونات الوصول الدقيقة، والتي لا تعتمد على منطق تطبيق LLM لمنع الكشف. تم إثبات المدخلات التي يتحكم فيها المستخدم في تطبيق الذكاء الاصطناعي التوليدي في بعض الظروف ليكون قادرًا على توفير ناقل لاستخراج المعلومات من النموذج أو أي أجزاء من المدخلات لا يتحكم فيها المستخدم. يمكن أن يحدث هذا عن طريق الحقن الفوري، حيث يقدم المستخدم مدخلات تتسبب في انحراف مخرجات النموذج عن حواجز الحماية المتوقعة لتطبيق LLM، بما في ذلك توفير أدلة لمجموعات البيانات التي تم تدريب النموذج عليها في الأصل.

تنفيذ حصص الوصول على مستوى المستخدم للمستخدمين الذين يقدمون المدخلات ويتلقون المخرجات من النموذج. يجب أن تفكر في الأساليب التي لا تسمح بالوصول المجهول في ظل الظروف التي تكون فيها بيانات ومعلومات تدريب النموذج حساسة، أو عندما يكون هناك خطر من قيام أحد المنافسين بتدريب نسخة طبق الأصل من النموذج الخاص بك بناءً على مدخلاته ومخرجات النموذج المتوافقة. بشكل عام، إذا كان جزء من المدخلات في النموذج يتكون من نص عشوائي مقدم من المستخدم، فاعتبر أن المخرجات عرضة للحقن الفوري، وبالتالي تأكد من أن استخدام المخرجات يشمل التدابير المضادة الفنية والتنظيمية المنفذة للتخفيف من التعامل غير الآمن مع المخرجات، والوكالة المفرطة ، والاعتماد المفرط. في المثال السابق المتعلق بتصفية المدخلات الضارة باستخدام AWS WAF، فكر في إنشاء مرشح أمام تطبيقك لمثل هذا الاستخدام الخاطئ المحتمل للمطالبات، وقم بتطوير سياسة لكيفية التعامل مع هذه المطالبات وتطويرها مع نمو النموذج والبيانات الخاصة بك. ضع في اعتبارك أيضًا إجراء مراجعة تمت تصفيتها للمخرجات قبل إعادتها إلى المستخدم للتأكد من أنها تلبي معايير الجودة أو الدقة أو الإشراف على المحتوى. قد ترغب في تخصيص هذا بشكل أكبر ليناسب احتياجات مؤسستك من خلال طبقة إضافية من التحكم في المدخلات والمخرجات أمام النماذج الخاصة بك للتخفيف من أنماط حركة المرور المشبوهة.

تفاعلات التطبيق: أمان التطبيق وإمكانية ملاحظته

قم بمراجعة تطبيق LLM الخاص بك مع الانتباه إلى كيفية استخدام المستخدم للنموذج الخاص بك لتجاوز التفويض القياسي لأداة المصب أو سلسلة الأدوات التي ليس لديه ترخيص للوصول إليها أو استخدامها. هناك قلق آخر في هذه الطبقة يتضمن الوصول إلى مخازن البيانات الخارجية باستخدام نموذج كآلية هجوم باستخدام مخاطر LLM فنية أو تنظيمية غير مخففة. على سبيل المثال، إذا تم تدريب النموذج الخاص بك للوصول إلى مخازن بيانات معينة يمكن أن تحتوي على بيانات حساسة، فيجب عليك التأكد من إجراء فحوصات الترخيص المناسبة بين النموذج الخاص بك ومخازن البيانات. استخدم سمات غير قابلة للتغيير حول المستخدمين والتي لا تأتي من النموذج عند إجراء عمليات التحقق من التفويض. يمكن أن تؤدي المعالجة غير الآمنة المطلقة للمخرجات، وتصميم المكونات الإضافية غير الآمنة، والوكالة المفرطة إلى خلق ظروف قد يستخدم فيها ممثل التهديد نموذجًا لخداع نظام التفويض لتصعيد الامتيازات الفعالة، مما يؤدي إلى اعتقاد المكون النهائي أن المستخدم مخول لاسترداد البيانات أو اتخاذ إجراء محدد فعل.

عند تنفيذ أي مكون إضافي أو أداة للذكاء الاصطناعي، من الضروري فحص وفهم مستوى الوصول الممنوح، بالإضافة إلى فحص عناصر التحكم في الوصول التي تم تكوينها. قد يؤدي استخدام مكونات الذكاء الاصطناعي الإضافية غير الآمنة وغير الآمنة إلى جعل نظامك عرضة لنقاط الضعف والتهديدات في سلسلة التوريد، مما قد يؤدي إلى إجراءات ضارة، بما في ذلك تشغيل التعليمات البرمجية عن بعد.

التفاعلات النموذجية: نموذج منع الهجوم

يجب أن تكون على دراية بأصل أي نماذج أو مكونات إضافية أو أدوات أو بيانات تستخدمها، من أجل تقييم نقاط الضعف في سلسلة التوريد والتخفيف منها. على سبيل المثال، تسمح بعض تنسيقات النماذج الشائعة بتضمين تعليمات برمجية عشوائية قابلة للتشغيل في النماذج نفسها. استخدم مرايا الحزمة والمسح الضوئي وعمليات التفتيش الإضافية ذات الصلة بالأهداف الأمنية لمؤسستك.

يجب أيضًا مراجعة مجموعات البيانات التي تدربها وتضبط نماذجك عليها. إذا قمت بضبط نموذج بشكل تلقائي بناءً على تعليقات المستخدم (أو غيرها من المعلومات التي يمكن التحكم فيها من قبل المستخدم النهائي)، فيجب عليك التفكير فيما إذا كان بإمكان جهة تهديد ضارة تغيير النموذج بشكل تعسفي بناءً على التلاعب باستجاباتهم وتحقيق تسميم بيانات التدريب.

تفاعلات البيانات: مراقبة جودة البيانات واستخدامها

تعمل نماذج الذكاء الاصطناعي التوليدي مثل LLMs بشكل جيد بشكل عام لأنها تم تدريبها على كمية كبيرة من البيانات. على الرغم من أن هذه البيانات تساعد طلاب LLM على إكمال المهام المعقدة، إلا أنها يمكن أن تعرض نظامك أيضًا لخطر تسمم بيانات التدريب، والذي يحدث عند تضمين بيانات غير مناسبة أو حذفها داخل مجموعة بيانات التدريب التي يمكن أن تغير سلوك النموذج. للتخفيف من هذه المخاطر، يجب عليك إلقاء نظرة على سلسلة التوريد الخاصة بك وفهم عملية مراجعة البيانات لنظامك قبل استخدامها داخل النموذج الخاص بك. على الرغم من أن مسار التدريب يعد مصدرًا رئيسيًا لتسميم البيانات، إلا أنه يجب عليك أيضًا النظر في كيفية حصول نموذجك على البيانات، كما هو الحال في نموذج RAG أو بحيرة البيانات، وما إذا كان مصدر تلك البيانات موثوقًا ومحميًا. استخدم خدمات AWS Security مثل AWS Security Hub، وAmazon GuardDuty، وAmazon Inspector للمساعدة في المراقبة المستمرة للأنشطة المشبوهة في Amazon EC2، وAmazon EKS، وAmazon S3، خدمة قاعدة بيانات الأمازون (Amazon RDS)، والوصول إلى الشبكة التي قد تكون مؤشرات على التهديدات الناشئة، واستخدام Detective لتصور التحقيقات الأمنية. فكر أيضًا في استخدام خدمات مثل بحيرة أمان أمازون لتسريع التحقيقات الأمنية من خلال إنشاء بحيرة بيانات مصممة لهذا الغرض لمركزية بيانات الأمان تلقائيًا من بيئات AWS وموفري SaaS في أماكن العمل والمصادر السحابية التي تساهم في أعباء عمل الذكاء الاصطناعي/التعلم الآلي لديك.

التفاعلات التنظيمية: تنفيذ حواجز حماية حوكمة المؤسسة للذكاء الاصطناعي التوليدي

تحديد المخاطر المرتبطة باستخدام الذكاء الاصطناعي التوليدي في أعمالك. يجب عليك بناء تصنيف المخاطر في مؤسستك وإجراء تقييمات للمخاطر لاتخاذ قرارات مستنيرة عند نشر حلول الذكاء الاصطناعي الإبداعية. يطور خطة استمرارية الأعمال (BCP) يتضمن أعباء عمل الذكاء الاصطناعي والتعلم الآلي والذكاء الاصطناعي والتي يمكن تفعيلها بسرعة لاستبدال الوظائف المفقودة لتطبيق LLM المتأثر أو غير المتصل بالإنترنت لتلبية اتفاقيات مستوى الخدمة الخاصة بك.

تحديد فجوات العمليات والموارد، وأوجه القصور، وأوجه عدم الاتساق، وتحسين الوعي والملكية عبر عملك. نموذج التهديد جميع أعباء عمل الذكاء الاصطناعي المنتجة لتحديد وتخفيف التهديدات الأمنية المحتملة التي قد تؤدي إلى نتائج تؤثر على الأعمال، بما في ذلك الوصول غير المصرح به إلى البيانات، ورفض الخدمة، وإساءة استخدام الموارد. الاستفادة من الجديد أداة نمذجة مؤلف التهديدات من AWS للمساعدة في تقليل الوقت اللازم لتحقيق القيمة عند تنفيذ نمذجة التهديدات. في وقت لاحق من دورات التطوير الخاصة بك، فكر في تضمين التعريف هندسة الفوضى الأمنية تجارب حقن الأخطاء لتهيئة ظروف العالم الحقيقي لفهم كيفية تفاعل نظامك مع العناصر المجهولة وبناء الثقة في مرونة النظام وأمانه.

قم بتضمين وجهات نظر متنوعة في تطوير استراتيجيات الأمان وآليات إدارة المخاطر لضمان الالتزام والتغطية للذكاء الاصطناعي / التعلم الآلي والأمن التوليدي عبر جميع الأدوار والوظائف الوظيفية. قم بإحضار عقلية أمنية إلى الطاولة منذ البداية والبحث في أي تطبيق ذكاء اصطناعي توليدي للتوافق مع المتطلبات. إذا كنت بحاجة إلى مساعدة إضافية من AWS، فاطلب من مدير حساب AWS الخاص بك التأكد من وجود دعم متساوٍ عن طريق طلب AWS Solutions Architects من AWS Security وAI/ML للمساعدة جنبًا إلى جنب.

تأكد من أن مؤسستك الأمنية تتخذ إجراءات بشكل روتيني لتعزيز التواصل حول كل من الوعي بالمخاطر وفهم إدارة المخاطر بين أصحاب المصلحة في مجال الذكاء الاصطناعي مثل مديري المنتجات ومطوري البرامج وعلماء البيانات والقيادة التنفيذية، مما يسمح لمعلومات التهديدات وتوجيهات التحكم بالوصول إلى الفرق التي قد تتأثر. يمكن للمؤسسات الأمنية دعم ثقافة الكشف المسؤول والتحسين المتكرر من خلال المشاركة في المناقشات وتقديم أفكار ومعلومات جديدة لأصحاب المصلحة المبدعين في مجال الذكاء الاصطناعي والتي تتعلق بأهداف أعمالهم. تعلم المزيد عن التزامنا بالذكاء الاصطناعي المسؤول و احصل على ١٥٪ موارد الذكاء الاصطناعي المسؤولة لمساعدة عملائنا.

احصل على ميزة في تمكين وضع تنظيمي أفضل للذكاء الاصطناعي التوليدي من خلال توفير الوقت اللازم للقيمة في عمليات الأمان الحالية لمؤسستك. قم بإجراء تقييم استباقي للأماكن التي قد تحتاج فيها مؤسستك إلى عمليات مرهقة للغاية نظرًا لسياق أمان الذكاء الاصطناعي التوليدي وتحسينها لتزويد المطورين والعلماء بمسار واضح للبدء باستخدام عناصر التحكم الصحيحة.

قم بتقييم الأماكن التي قد توجد فيها فرص لمواءمة الحوافز والمخاطر وتوفير رؤية واضحة للنتائج المرجوة. يتحكم التحديث في التوجيه والدفاعات لتلبية الاحتياجات المتطورة للذكاء الاصطناعي/التعلم الآلي وتطوير تطبيقات الذكاء الاصطناعي التوليدي لتقليل الارتباك وعدم اليقين الذي يمكن أن يكلف وقت التطوير ويزيد المخاطر ويزيد التأثير.

تأكد من أن أصحاب المصلحة الذين ليسوا خبراء أمنيين قادرون على فهم كيفية تطبيق الحوكمة التنظيمية والسياسات وخطوات إدارة المخاطر على أعباء عملهم، وكذلك تطبيق آليات إدارة المخاطر. قم بإعداد مؤسستك للاستجابة للأحداث والسيناريوهات الواقعية التي قد تحدث مع تطبيقات الذكاء الاصطناعي التوليدي، وتأكد من أن أدوار منشئ الذكاء الاصطناعي التوليدي وفرق الاستجابة على دراية بمسارات وإجراءات التصعيد في حالة وجود قلق بشأن أي نشاط مشبوه.

وفي الختام

يتطلب تسويق الابتكار تجاريًا بنجاح باستخدام أي تقنية جديدة وناشئة البدء بعقلية الأولوية الأمنية، والبناء على أساس بنية تحتية آمنة، والتفكير في كيفية زيادة تكامل الأمان في كل مستوى من مستويات مجموعة التكنولوجيا مبكرًا مع أمان دفاعي متعمق يقترب. يتضمن ذلك التفاعلات في طبقات متعددة من مجموعة التكنولوجيا الخاصة بك، ونقاط التكامل داخل سلسلة التوريد الرقمية الخاصة بك، لضمان المرونة التنظيمية. على الرغم من أن الذكاء الاصطناعي التوليدي يقدم بعض تحديات الأمان والخصوصية الجديدة، إذا اتبعت أفضل ممارسات الأمان الأساسية مثل استخدام الدفاع المتعمق مع خدمات الأمان متعددة الطبقات، فيمكنك المساعدة في حماية مؤسستك من العديد من المشكلات الشائعة والتهديدات المتطورة. يجب عليك تنفيذ خدمات AWS Security متعددة الطبقات عبر أعباء عمل الذكاء الاصطناعي التوليدية والمؤسسة الأكبر لديك، والتركيز على نقاط التكامل في سلاسل التوريد الرقمية الخاصة بك لتأمين البيئات السحابية الخاصة بك. بعد ذلك، يمكنك استخدام إمكانات الأمان والخصوصية المحسنة في خدمات AWS AI/ML مثل Amazon SageMaker وAmazon Bedrock لإضافة طبقات إضافية من عناصر التحكم في الأمان والخصوصية المحسنة إلى تطبيقات الذكاء الاصطناعي التوليدية لديك. سيؤدي تضمين الأمان منذ البداية إلى جعل الابتكار باستخدام الذكاء الاصطناعي التوليدي أسرع وأسهل وأكثر فعالية من حيث التكلفة، مع تبسيط الامتثال. سيساعدك هذا على زيادة الضوابط والثقة وإمكانية المراقبة لتطبيقات الذكاء الاصطناعي التوليدية الخاصة بك لموظفيك وعملائك وشركائك والمنظمين وغيرهم من أصحاب المصلحة المعنيين.

مراجع إضافية

- أطر العمل القياسية الصناعية لإدارة المخاطر والأمن الخاصة بالذكاء الاصطناعي/التعلم الآلي:

عن المؤلفين

كريستوفر راي هو متخصص رئيسي في GTM للأمن العالمي ويركز على تطوير وتنفيذ المبادرات الإستراتيجية التي تعمل على تسريع وتوسيع نطاق اعتماد خدمات أمان AWS. إنه شغوف بالتقاطع بين الأمن السيبراني والتقنيات الناشئة، ويتمتع بخبرة تزيد عن 20 عامًا في الأدوار القيادية الإستراتيجية العالمية التي تقدم حلولًا أمنية لعملاء الوسائط والترفيه والاتصالات. إنه يعيد شحن طاقته من خلال القراءة والسفر والطعام والنبيذ واكتشاف الموسيقى الجديدة وتقديم المشورة للشركات الناشئة في مرحلة مبكرة.

كريستوفر راي هو متخصص رئيسي في GTM للأمن العالمي ويركز على تطوير وتنفيذ المبادرات الإستراتيجية التي تعمل على تسريع وتوسيع نطاق اعتماد خدمات أمان AWS. إنه شغوف بالتقاطع بين الأمن السيبراني والتقنيات الناشئة، ويتمتع بخبرة تزيد عن 20 عامًا في الأدوار القيادية الإستراتيجية العالمية التي تقدم حلولًا أمنية لعملاء الوسائط والترفيه والاتصالات. إنه يعيد شحن طاقته من خلال القراءة والسفر والطعام والنبيذ واكتشاف الموسيقى الجديدة وتقديم المشورة للشركات الناشئة في مرحلة مبكرة.

إيليا وينتر هو أحد كبار مهندسي الأمن في Amazon Security، ويحمل درجة البكالوريوس في هندسة الأمن السيبراني ويحمل حبًا لهاري بوتر. يتفوق إيليا في تحديد نقاط الضعف في أنظمة الذكاء الاصطناعي ومعالجتها، ويمزج الخبرة التقنية مع لمسة من السحر. يصمم إيليا بروتوكولات أمان مخصصة لأنظمة الذكاء الاصطناعي، مما يضفي لمسة سحرية على الدفاعات الرقمية. يتمتع إيليا، الذي يتمتع بالنزاهة، بخلفية أمنية في كل من مؤسسات القطاعين العام والتجاري التي تركز على حماية الثقة.

إيليا وينتر هو أحد كبار مهندسي الأمن في Amazon Security، ويحمل درجة البكالوريوس في هندسة الأمن السيبراني ويحمل حبًا لهاري بوتر. يتفوق إيليا في تحديد نقاط الضعف في أنظمة الذكاء الاصطناعي ومعالجتها، ويمزج الخبرة التقنية مع لمسة من السحر. يصمم إيليا بروتوكولات أمان مخصصة لأنظمة الذكاء الاصطناعي، مما يضفي لمسة سحرية على الدفاعات الرقمية. يتمتع إيليا، الذي يتمتع بالنزاهة، بخلفية أمنية في كل من مؤسسات القطاعين العام والتجاري التي تركز على حماية الثقة.

رام فيتال هو مهندس حلول ML الرئيسي في AWS. يتمتع بخبرة تزيد عن 3 عقود في تصميم وبناء التطبيقات الموزعة والهجينة والسحابية. إنه متحمس لبناء حلول آمنة وقابلة للتطوير للذكاء الاصطناعي/التعلم الآلي والبيانات الضخمة لمساعدة عملاء المؤسسات في اعتماد السحابة ورحلة التحسين لتحسين نتائج أعمالهم. في أوقات فراغه، يركب دراجته النارية ويمشي مع كلبه شيبادودل البالغ من العمر 3 سنوات!

رام فيتال هو مهندس حلول ML الرئيسي في AWS. يتمتع بخبرة تزيد عن 3 عقود في تصميم وبناء التطبيقات الموزعة والهجينة والسحابية. إنه متحمس لبناء حلول آمنة وقابلة للتطوير للذكاء الاصطناعي/التعلم الآلي والبيانات الضخمة لمساعدة عملاء المؤسسات في اعتماد السحابة ورحلة التحسين لتحسين نتائج أعمالهم. في أوقات فراغه، يركب دراجته النارية ويمشي مع كلبه شيبادودل البالغ من العمر 3 سنوات!

نافنيت توتيجا هو متخصص بيانات في Amazon Web Services. قبل الانضمام إلى AWS ، عملت Navneet كميسر للمؤسسات التي تسعى إلى تحديث هياكل البيانات الخاصة بها وتنفيذ حلول AI / ML الشاملة. وهي حاصلة على إجازة في الهندسة من جامعة ثابار ، بالإضافة إلى ماجستير في الإحصاء من جامعة تكساس إيه آند إم.

نافنيت توتيجا هو متخصص بيانات في Amazon Web Services. قبل الانضمام إلى AWS ، عملت Navneet كميسر للمؤسسات التي تسعى إلى تحديث هياكل البيانات الخاصة بها وتنفيذ حلول AI / ML الشاملة. وهي حاصلة على إجازة في الهندسة من جامعة ثابار ، بالإضافة إلى ماجستير في الإحصاء من جامعة تكساس إيه آند إم.

إميلي سوارد هو عالم بيانات مع خدمات AWS الاحترافية. وهي حاصلة على ماجستير العلوم بامتياز في الذكاء الاصطناعي من جامعة إدنبرة في اسكتلندا ، المملكة المتحدة مع التركيز على معالجة اللغات الطبيعية (NLP). عملت إميلي في أدوار علمية وهندسية تطبيقية تركز على البحث والتطوير في المنتجات المدعومة بالذكاء الاصطناعي ، والتميز التشغيلي ، والحوكمة لأعباء عمل الذكاء الاصطناعي التي تعمل في مؤسسات في القطاعين العام والخاص. وهي تساهم في توجيه العملاء بصفتها متحدثة أولى في AWS ومؤخراً كمؤلفة لـ AWS Well-Architected in the Machine Learning Lens.

إميلي سوارد هو عالم بيانات مع خدمات AWS الاحترافية. وهي حاصلة على ماجستير العلوم بامتياز في الذكاء الاصطناعي من جامعة إدنبرة في اسكتلندا ، المملكة المتحدة مع التركيز على معالجة اللغات الطبيعية (NLP). عملت إميلي في أدوار علمية وهندسية تطبيقية تركز على البحث والتطوير في المنتجات المدعومة بالذكاء الاصطناعي ، والتميز التشغيلي ، والحوكمة لأعباء عمل الذكاء الاصطناعي التي تعمل في مؤسسات في القطاعين العام والخاص. وهي تساهم في توجيه العملاء بصفتها متحدثة أولى في AWS ومؤخراً كمؤلفة لـ AWS Well-Architected in the Machine Learning Lens.

- محتوى مدعوم من تحسين محركات البحث وتوزيع العلاقات العامة. تضخيم اليوم.

- PlatoData.Network Vertical Generative Ai. تمكين نفسك. الوصول هنا.

- أفلاطونايستريم. ذكاء Web3. تضخيم المعرفة. الوصول هنا.

- أفلاطون كربون، كلينتك ، الطاقة، بيئة، شمسي، إدارة المخلفات. الوصول هنا.

- أفلاطون هيلث. التكنولوجيا الحيوية وذكاء التجارب السريرية. الوصول هنا.

- المصدر https://aws.amazon.com/blogs/machine-learning/architect-defense-in-depth-security-for-generative-ai-applications-using-the-owasp-top-10-for-llms/