Onun çekirdeğinde, Dil Zinciri dil modellerinin yeteneklerinden yararlanan uygulamalar hazırlamak için tasarlanmış yenilikçi bir çerçevedir. Geliştiricilerin bağlam bilincine sahip ve karmaşık akıl yürütme yeteneğine sahip uygulamalar oluşturmaları için tasarlanmış bir araç setidir.

Bu, LangChain uygulamalarının hızlı talimatlar veya içerik temelli yanıtlar gibi bağlamı anlayabildiği ve nasıl yanıt vereceğine veya hangi eylemlerin gerçekleştirileceğine karar vermek gibi karmaşık akıl yürütme görevleri için dil modellerini kullanabileceği anlamına gelir. LangChain, çeşitli bileşenleriyle konseptten uygulamaya kadar olan yolculuğu basitleştirerek akıllı uygulamalar geliştirmeye yönelik birleşik bir yaklaşımı temsil eder.

LangChain'i Anlamak

LangChain bir çerçeveden çok daha fazlasıdır; birçok ayrılmaz parçadan oluşan tam teşekküllü bir ekosistemdir.

- İlk olarak, hem Python hem de JavaScript'te mevcut olan LangChain Kütüphaneleri vardır. Bu kütüphaneler LangChain'in omurgasını oluşturur ve çeşitli bileşenler için arayüzler ve entegrasyonlar sunar. Bu bileşenleri uyumlu zincirler ve aracılar halinde birleştirmek için temel bir çalışma süresinin yanı sıra anında kullanıma hazır uygulamalar sağlarlar.

- Daha sonra LangChain Şablonlarımız var. Bunlar, çok çeşitli görevler için özel olarak tasarlanmış konuşlandırılabilir referans mimarilerinin bir koleksiyonudur. İster bir sohbet robotu ister karmaşık bir analitik araç oluşturuyor olun, bu şablonlar sağlam bir başlangıç noktası sunar.

- LangServe, LangChain zincirlerini REST API'leri olarak dağıtmak için çok yönlü bir kitaplık olarak devreye giriyor. Bu araç, LangChain projelerinizi erişilebilir ve ölçeklenebilir web hizmetlerine dönüştürmek için gereklidir.

- Son olarak LangSmith geliştirici platformu olarak hizmet veriyor. Herhangi bir LLM çerçevesinde oluşturulmuş zincirlerde hata ayıklamak, test etmek, değerlendirmek ve izlemek için tasarlanmıştır. LangChain ile kusursuz entegrasyon, onu uygulamalarını iyileştirmeyi ve mükemmelleştirmeyi amaçlayan geliştiriciler için vazgeçilmez bir araç haline getiriyor.

Bu bileşenler birlikte uygulamaları kolaylıkla geliştirmenize, üretmenize ve dağıtmanıza olanak tanır. LangChain ile, rehberlik için şablonlara başvurarak kitaplıkları kullanarak uygulamalarınızı yazmaya başlarsınız. LangSmith daha sonra zincirlerinizi incelemenize, test etmenize ve izlemenize yardımcı olarak uygulamalarınızın sürekli olarak iyileştirilmesini ve dağıtıma hazır olmasını sağlar. Son olarak, LangServe ile herhangi bir zinciri kolayca bir API'ye dönüştürebilir ve dağıtımı çok kolay hale getirebilirsiniz.

Sonraki bölümlerde LangChain'i nasıl kuracağınızı daha derinlemesine inceleyeceğiz ve akıllı, dil modeliyle güçlendirilmiş uygulamalar oluşturma yolculuğunuza başlayacağız.

Nanonets tarafından siz ve ekipleriniz için tasarlanan yapay zeka odaklı iş akışı oluşturucumuzla manuel görevleri ve iş akışlarını otomatikleştirin.

Kurulum ve Kurulum

LangChain dünyasına dalmaya hazır mısınız? Kurulumu basittir ve bu kılavuz süreç boyunca size adım adım yol gösterecektir.

LangChain yolculuğunuzun ilk adımı onu kurmaktır. Bunu pip veya conda kullanarak kolayca yapabilirsiniz. Terminalinizde aşağıdaki komutu çalıştırın:

pip install langchain

En son özellikleri tercih edenler ve biraz daha maceradan memnun olanlar için LangChain'i doğrudan kaynaktan kurabilirsiniz. Depoyu klonlayın ve şuraya gidin: langchain/libs/langchain dizin. O zaman koş:

pip install -e .

Deneysel özellikler için yüklemeyi düşünün langchain-experimental. En son kodları içeren ve araştırma ve deneysel amaçlara yönelik bir pakettir. Aşağıdakileri kullanarak yükleyin:

pip install langchain-experimental

LangChain CLI, LangChain şablonları ve LangServe projeleriyle çalışmak için kullanışlı bir araçtır. LangChain CLI'yi yüklemek için şunu kullanın:

pip install langchain-cli

LangServe, LangChain zincirlerinizi REST API olarak dağıtmak için gereklidir. LangChain CLI ile birlikte kurulur.

LangChain genellikle model sağlayıcılar, veri depoları, API'ler vb. ile entegrasyon gerektirir. Bu örnek için OpenAI'nin model API'lerini kullanacağız. OpenAI Python paketini aşağıdakileri kullanarak yükleyin:

pip install openai

API'ye erişmek için OpenAI API anahtarınızı bir ortam değişkeni olarak ayarlayın:

export OPENAI_API_KEY="your_api_key"

Alternatif olarak anahtarı doğrudan python ortamınıza iletin:

import os

os.environ['OPENAI_API_KEY'] = 'your_api_key'

LangChain, modüller aracılığıyla dil modeli uygulamalarının oluşturulmasına olanak sağlar. Bu modüller tek başına olabileceği gibi karmaşık kullanım durumları için de oluşturulabilir. Bu modüller –

- Model G/Ç: Çeşitli dil modelleriyle etkileşimi kolaylaştırır, girdi ve çıktılarını verimli bir şekilde yönetir.

- geri alma: Dinamik veri kullanımı için hayati önem taşıyan uygulamaya özel verilere erişim ve etkileşime olanak sağlar.

- Danışmanlar: Uygulamaları, üst düzey yönergelere dayalı olarak uygun araçları seçme konusunda güçlendirerek karar verme yeteneklerini geliştirin.

- Zincirler: Uygulama geliştirme için yapı taşları görevi gören önceden tanımlanmış, yeniden kullanılabilir kompozisyonlar sunar.

- Bellek: Bağlama duyarlı etkileşimler için gerekli olan birden fazla zincir yürütmede uygulama durumunu korur.

Her modül belirli geliştirme ihtiyaçlarını hedef alarak LangChain'i gelişmiş dil modeli uygulamaları oluşturmaya yönelik kapsamlı bir araç seti haline getirir.

Yukarıdaki bileşenlerin yanı sıra, ayrıca LangChain İfade Dili (LCEL)Bu, modülleri kolayca bir araya getirmenin bildirimsel bir yoludur ve bu, evrensel bir Çalıştırılabilir arayüz kullanarak bileşenlerin zincirlenmesine olanak tanır.

LCEL buna benzer bir şeye benziyor –

from langchain.chat_models import ChatOpenAI

from langchain.prompts import ChatPromptTemplate

from langchain.schema import BaseOutputParser # Example chain

chain = ChatPromptTemplate() | ChatOpenAI() | CustomOutputParser()

Artık temel konuları ele aldığımıza göre devam edebiliriz:

- Her Langchain modülünü ayrıntılı olarak daha derinlemesine inceleyin.

- LangChain İfade Dilinin nasıl kullanılacağını öğrenin.

- Yaygın kullanım örneklerini keşfedin ve bunları uygulayın.

- LangServe ile uçtan uca bir uygulamayı devreye alın.

- Hata ayıklama, test etme ve izleme için LangSmith'e göz atın.

En başlayalım!

Modül I: Model G/Ç

LangChain'de herhangi bir uygulamanın temel unsuru dil modeli etrafında döner. Bu modül, herhangi bir dil modeliyle etkili bir şekilde arayüz oluşturmak için gerekli yapı taşlarını sağlayarak kusursuz entegrasyon ve iletişim sağlar.

Model G/Ç'nin Temel Bileşenleri

- Yüksek Lisans ve Sohbet Modelleri (birbirinin yerine kullanılır):

- Yüksek Lisans:

- Tanım: Saf metin tamamlama modelleri.

- Girdi / Çıktı: Giriş olarak bir metin dizesi alın ve çıktı olarak bir metin dizesi döndürün.

- Sohbet Modelleri

- Yüksek Lisans:

- Tanım: Dil modelini temel olarak kullanan ancak giriş ve çıkış formatlarında farklılık gösteren modeller.

- Girdi / Çıktı: Sohbet mesajlarının bir listesini giriş olarak kabul edin ve bir Sohbet Mesajı gönderin.

- istemleri: Model girişlerini şablonlaştırın, dinamik olarak seçin ve yönetin. Dil modelinin yanıtlarını yönlendiren esnek ve bağlama özgü istemlerin oluşturulmasına olanak tanır.

- Çıkış Ayrıştırıcıları: Model çıktılarından bilgileri çıkarın ve biçimlendirin. Dil modellerinin ham çıktısını yapılandırılmış verilere veya uygulamanın ihtiyaç duyduğu belirli formatlara dönüştürmek için kullanışlıdır.

LLM'ler

LangChain'in OpenAI, Cohere ve Hugging Face gibi Büyük Dil Modelleri (LLM'ler) ile entegrasyonu işlevselliğinin temel bir yönüdür. LangChain'in kendisi Yüksek Lisans'lara ev sahipliği yapmaz ancak çeşitli Yüksek Lisans'larla etkileşime geçmek için tek tip bir arayüz sunar.

Bu bölüm, diğer LLM türleri için de geçerli olan LangChain'de OpenAI LLM sarmalayıcısının kullanımına ilişkin bir genel bakış sağlar. Bunu zaten “Başlarken” bölümüne yükledik. LLM'yi başlatalım.

from langchain.llms import OpenAI

llm = OpenAI()

- Yüksek Lisans'lar şunları uygular: Çalıştırılabilir arayüztemel yapı taşı olan LangChain İfade Dili (LCEL). Bu demek oluyor ki destekliyorlar

invoke,ainvoke,stream,astream,batch,abatch,astream_logçağırır. - Yüksek Lisans'lar kabul ediyor dizeleri girdiler veya dize istemlerine zorlanabilen nesneler olarak

List[BaseMessage]vePromptValue. (bunlar hakkında daha sonra daha fazla bilgi)

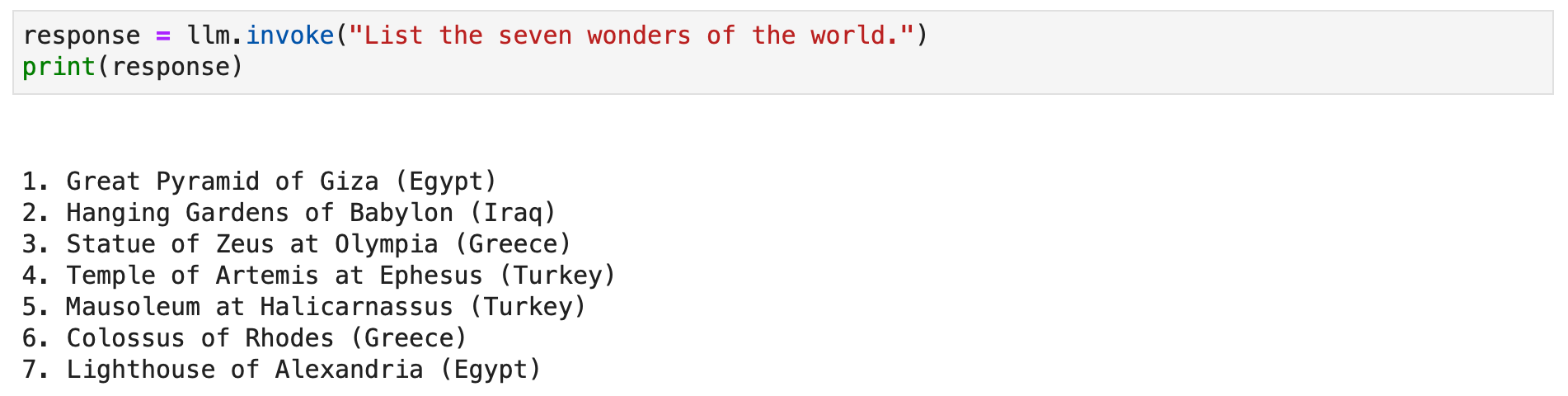

Bazı örneklere bakalım.

response = llm.invoke("List the seven wonders of the world.")

print(response)

Alternatif olarak metin yanıtını yayınlamak için akış yöntemini çağırabilirsiniz.

for chunk in llm.stream("Where were the 2012 Olympics held?"): print(chunk, end="", flush=True)

Sohbet Modelleri

LangChain'in, dil modellerinin özel bir çeşidi olan sohbet modelleriyle entegrasyonu, etkileşimli sohbet uygulamaları oluşturmak için gereklidir. Sohbet modelleri, dahili olarak dil modellerini kullanırken, giriş ve çıkış olarak sohbet mesajlarını merkeze alan farklı bir arayüz sunar. Bu bölüm, OpenAI'nin sohbet modelinin LangChain'de kullanımına ilişkin ayrıntılı bir genel bakış sağlar.

from langchain.chat_models import ChatOpenAI

chat = ChatOpenAI()

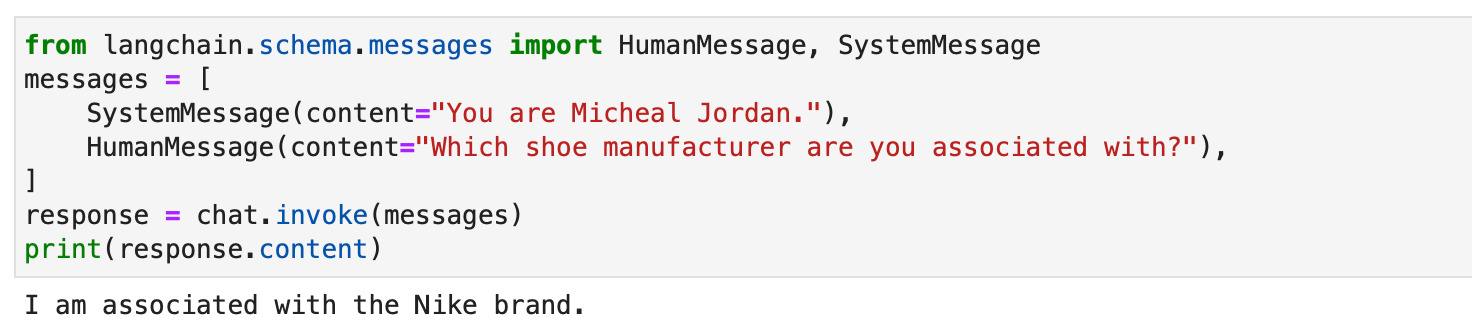

LangChain'deki sohbet modelleri aşağıdaki gibi farklı mesaj türleriyle çalışır: AIMessage, HumanMessage, SystemMessage, FunctionMessage, ve ChatMessage (isteğe bağlı bir rol parametresiyle). Genel olarak, HumanMessage, AIMessage, ve SystemMessage en sık kullanılanlardır.

Sohbet modelleri öncelikle kabul edilir List[BaseMessage] girdiler olarak. Dizeler dönüştürülebilir HumanMessage, ve PromptValue da desteklenmektedir.

from langchain.schema.messages import HumanMessage, SystemMessage

messages = [ SystemMessage(content="You are Micheal Jordan."), HumanMessage(content="Which shoe manufacturer are you associated with?"),

]

response = chat.invoke(messages)

print(response.content)

istemleri

İlgili ve tutarlı çıktılar üretmek için dil modellerine rehberlik etmede bilgi istemleri önemlidir. Basit talimatlardan karmaşık, birkaç örnekten oluşan örneklere kadar çeşitlilik gösterebilirler. LangChain'de, çeşitli özel sınıflar ve işlevler sayesinde istemlerin işlenmesi oldukça kolaylaştırılmış bir süreç olabilir.

LangChain'in PromptTemplate class, dize istemleri oluşturmak için çok yönlü bir araçtır. Python'u kullanıyor str.format Sözdizimi, dinamik bilgi istemi oluşturulmasına izin verir. Yer tutucularla bir şablon tanımlayabilir ve bunları gerektiği gibi belirli değerlerle doldurabilirsiniz.

from langchain.prompts import PromptTemplate # Simple prompt with placeholders

prompt_template = PromptTemplate.from_template( "Tell me a {adjective} joke about {content}."

) # Filling placeholders to create a prompt

filled_prompt = prompt_template.format(adjective="funny", content="robots")

print(filled_prompt)Sohbet modellerinde, istemler daha yapılandırılmıştır ve belirli rollere sahip mesajları içerir. LangChain teklifleri ChatPromptTemplate bu amaç için.

from langchain.prompts import ChatPromptTemplate # Defining a chat prompt with various roles

chat_template = ChatPromptTemplate.from_messages( [ ("system", "You are a helpful AI bot. Your name is {name}."), ("human", "Hello, how are you doing?"), ("ai", "I'm doing well, thanks!"), ("human", "{user_input}"), ]

) # Formatting the chat prompt

formatted_messages = chat_template.format_messages(name="Bob", user_input="What is your name?")

for message in formatted_messages: print(message)

Bu yaklaşım, dinamik yanıtlara sahip etkileşimli, ilgi çekici sohbet robotlarının oluşturulmasına olanak tanır.

Her ikisi de PromptTemplate ve ChatPromptTemplate LangChain İfade Dili (LCEL) ile sorunsuz bir şekilde entegre olup daha büyük, karmaşık iş akışlarının parçası olmalarını sağlar. Bu konuyu daha sonra tartışacağız.

Özel bilgi istemi şablonları bazen benzersiz biçimlendirme veya özel talimatlar gerektiren görevler için gereklidir. Özel bir bilgi istemi şablonu oluşturmak, giriş değişkenlerini ve özel bir biçimlendirme yöntemini tanımlamayı içerir. Bu esneklik, LangChain'in çok çeşitli uygulamaya özel gereksinimleri karşılamasına olanak tanır. Daha fazlasını buradan okuyun.

LangChain ayrıca birkaç adımlık yönlendirmeyi destekleyerek modelin örneklerden öğrenmesini sağlar. Bu özellik, bağlamsal anlayış veya belirli kalıplar gerektiren görevler için hayati öneme sahiptir. Bir dizi örnekten veya bir Örnek Seçici nesnesi kullanılarak birkaç çekimli bilgi istemi şablonları oluşturulabilir. Daha fazlasını buradan okuyun.

Çıkış Ayrıştırıcıları

Çıktı ayrıştırıcıları Langchain'de önemli bir rol oynayarak kullanıcıların dil modelleri tarafından oluşturulan yanıtları yapılandırmasına olanak tanır. Bu bölümde çıktı ayrıştırıcıları kavramını inceleyeceğiz ve Langchain'in PydanticOutputParser, SimpleJsonOutputParser, CommaSeparatedListOutputParser, DatetimeOutputParser ve XMLOutputParser'ı kullanan kod örnekleri sunacağız.

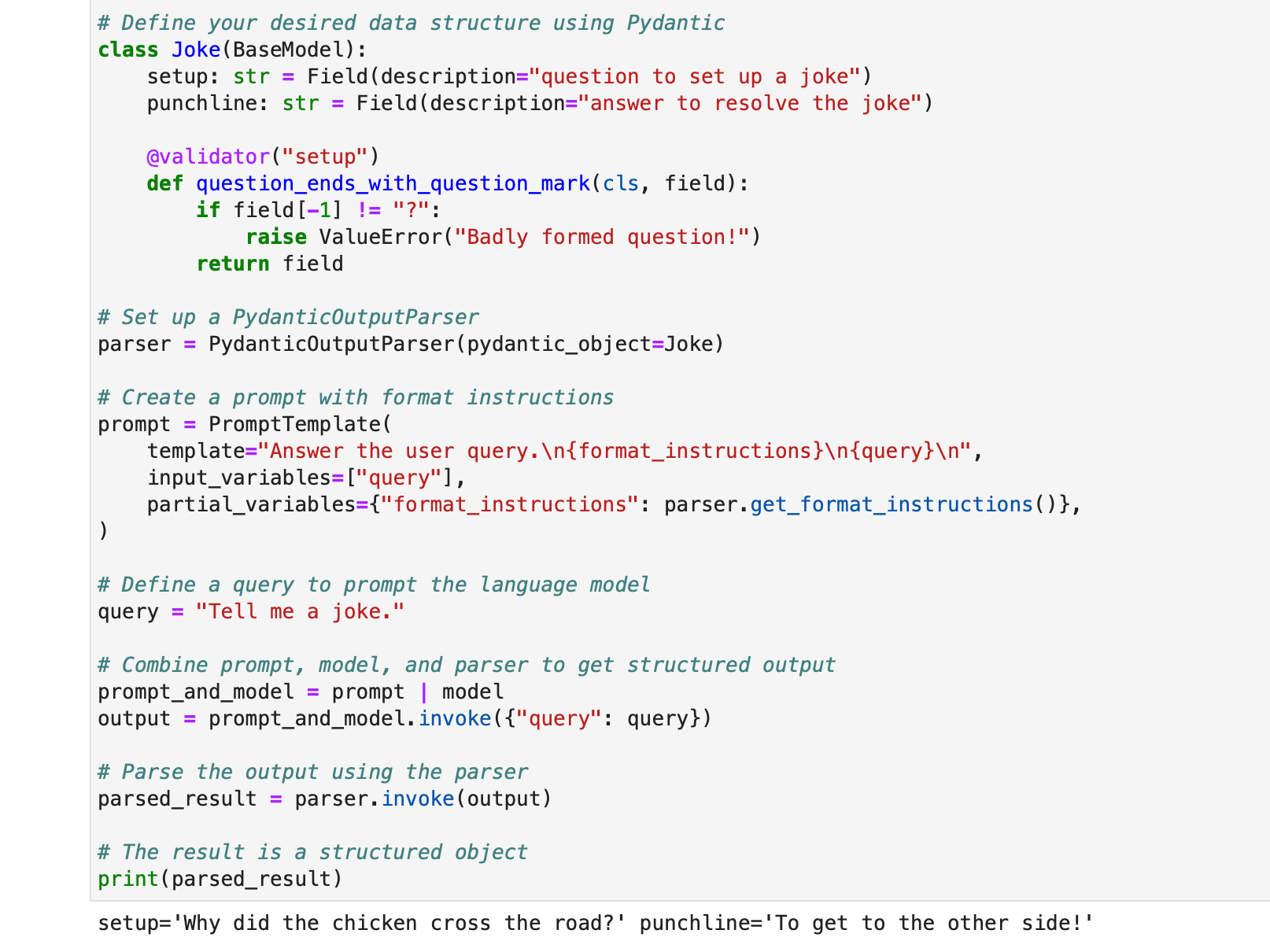

PydanticOutputParser

Langchain, yanıtları Pydantic veri yapılarına ayrıştırmak için PydanticOutputParser'ı sağlar. Aşağıda nasıl kullanılacağına dair adım adım bir örnek verilmiştir:

from typing import List

from langchain.llms import OpenAI

from langchain.output_parsers import PydanticOutputParser

from langchain.prompts import PromptTemplate

from langchain.pydantic_v1 import BaseModel, Field, validator # Initialize the language model

model = OpenAI(model_name="text-davinci-003", temperature=0.0) # Define your desired data structure using Pydantic

class Joke(BaseModel): setup: str = Field(description="question to set up a joke") punchline: str = Field(description="answer to resolve the joke") @validator("setup") def question_ends_with_question_mark(cls, field): if field[-1] != "?": raise ValueError("Badly formed question!") return field # Set up a PydanticOutputParser

parser = PydanticOutputParser(pydantic_object=Joke) # Create a prompt with format instructions

prompt = PromptTemplate( template="Answer the user query.n{format_instructions}n{query}n", input_variables=["query"], partial_variables={"format_instructions": parser.get_format_instructions()},

) # Define a query to prompt the language model

query = "Tell me a joke." # Combine prompt, model, and parser to get structured output

prompt_and_model = prompt | model

output = prompt_and_model.invoke({"query": query}) # Parse the output using the parser

parsed_result = parser.invoke(output) # The result is a structured object

print(parsed_result)

çıkış olacaktır:

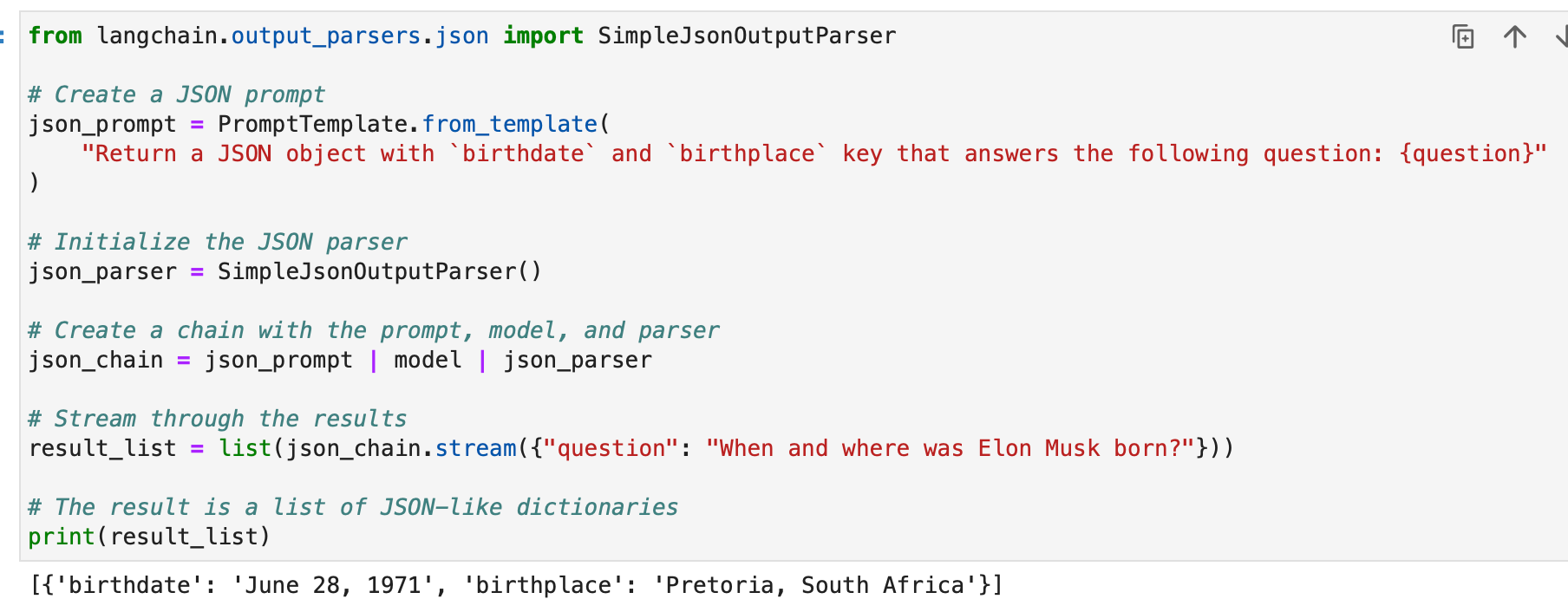

SimpleJsonOutputParser

JSON benzeri çıktıları ayrıştırmak istediğinizde Langchain'in SimpleJsonOutputParser'ı kullanılır. İşte bir örnek:

from langchain.output_parsers.json import SimpleJsonOutputParser # Create a JSON prompt

json_prompt = PromptTemplate.from_template( "Return a JSON object with `birthdate` and `birthplace` key that answers the following question: {question}"

) # Initialize the JSON parser

json_parser = SimpleJsonOutputParser() # Create a chain with the prompt, model, and parser

json_chain = json_prompt | model | json_parser # Stream through the results

result_list = list(json_chain.stream({"question": "When and where was Elon Musk born?"})) # The result is a list of JSON-like dictionaries

print(result_list)

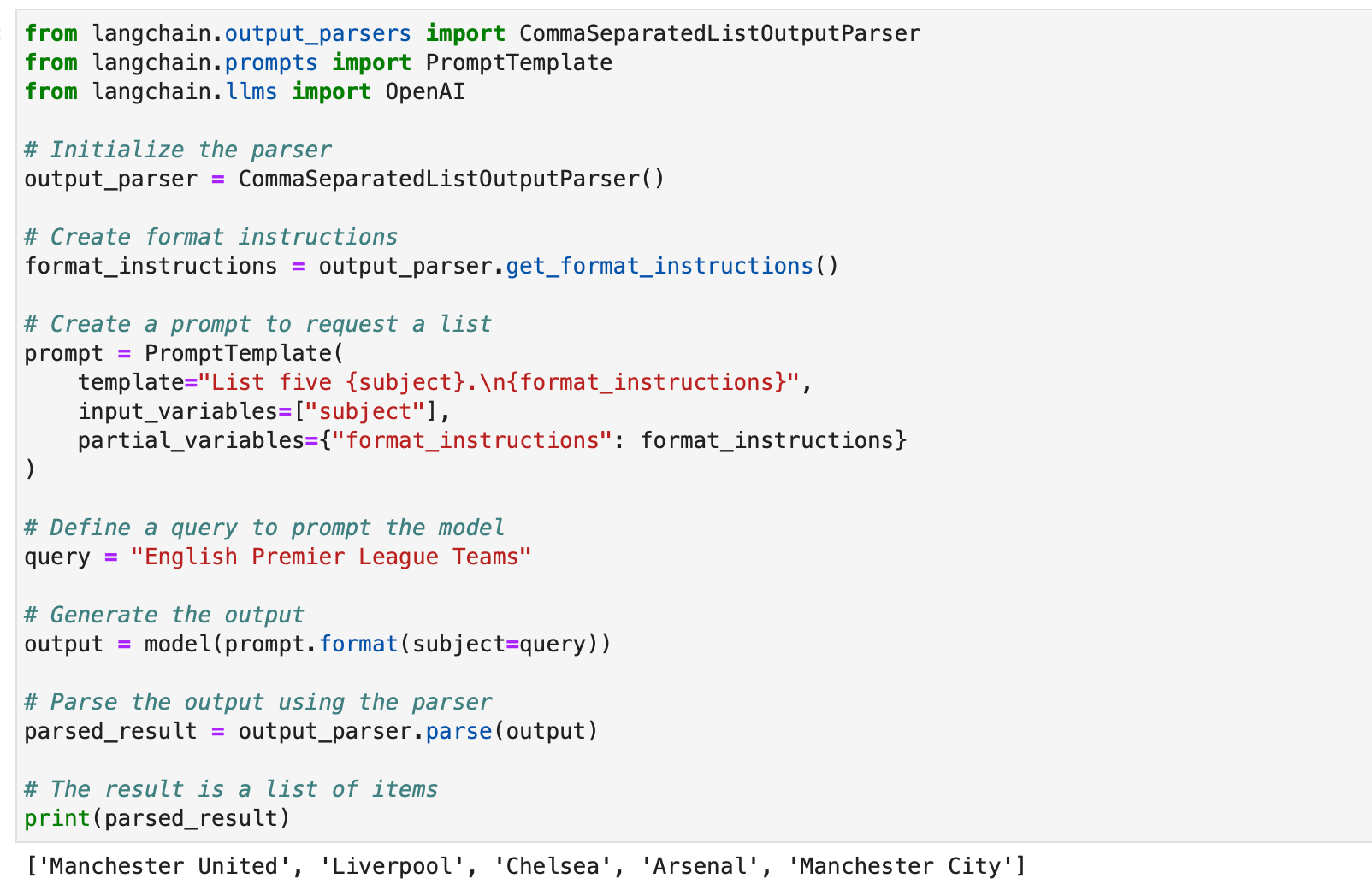

CommaSeparatedListOutputParser

CommaSeparatedListOutputParser, model yanıtlarından virgülle ayrılmış listeler çıkarmak istediğinizde kullanışlıdır. İşte bir örnek:

from langchain.output_parsers import CommaSeparatedListOutputParser

from langchain.prompts import PromptTemplate

from langchain.llms import OpenAI # Initialize the parser

output_parser = CommaSeparatedListOutputParser() # Create format instructions

format_instructions = output_parser.get_format_instructions() # Create a prompt to request a list

prompt = PromptTemplate( template="List five {subject}.n{format_instructions}", input_variables=["subject"], partial_variables={"format_instructions": format_instructions}

) # Define a query to prompt the model

query = "English Premier League Teams" # Generate the output

output = model(prompt.format(subject=query)) # Parse the output using the parser

parsed_result = output_parser.parse(output) # The result is a list of items

print(parsed_result)

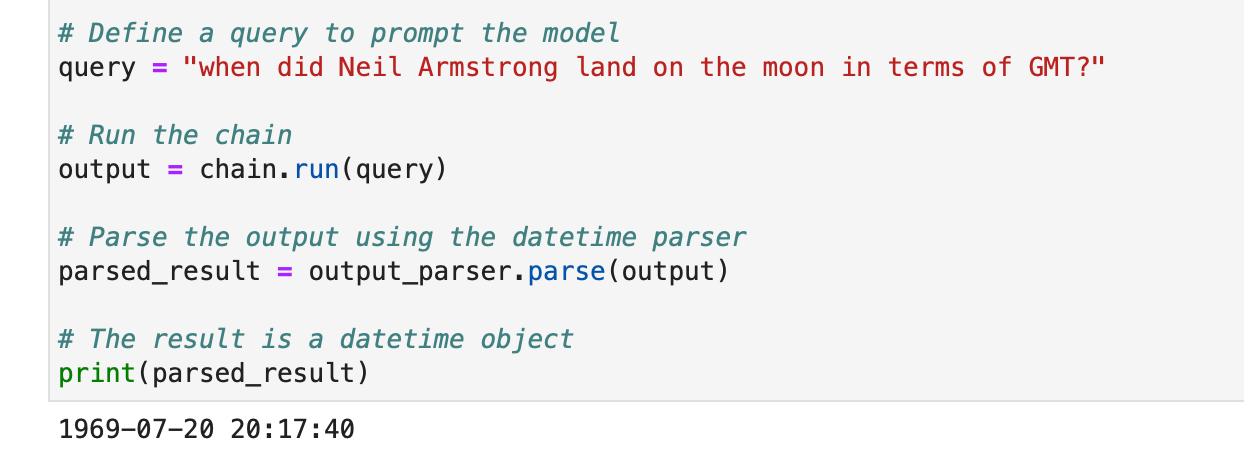

DatetimeOutputParser

Langchain'in DatetimeOutputParser'ı tarihsaat bilgilerini ayrıştırmak için tasarlanmıştır. İşte nasıl kullanılacağı:

from langchain.prompts import PromptTemplate

from langchain.output_parsers import DatetimeOutputParser

from langchain.chains import LLMChain

from langchain.llms import OpenAI # Initialize the DatetimeOutputParser

output_parser = DatetimeOutputParser() # Create a prompt with format instructions

template = """

Answer the user's question:

{question}

{format_instructions} """ prompt = PromptTemplate.from_template( template, partial_variables={"format_instructions": output_parser.get_format_instructions()},

) # Create a chain with the prompt and language model

chain = LLMChain(prompt=prompt, llm=OpenAI()) # Define a query to prompt the model

query = "when did Neil Armstrong land on the moon in terms of GMT?" # Run the chain

output = chain.run(query) # Parse the output using the datetime parser

parsed_result = output_parser.parse(output) # The result is a datetime object

print(parsed_result)

Bu örnekler, Langchain'in çıktı ayrıştırıcılarının çeşitli model yanıtlarını yapılandırmak için nasıl kullanılabileceğini ve bunların farklı uygulamalar ve formatlar için nasıl uygun hale getirilebileceğini gösteriyor. Çıktı ayrıştırıcıları, Langchain'deki dil modeli çıktılarının kullanılabilirliğini ve yorumlanabilirliğini geliştirmek için değerli bir araçtır.

Nanonets tarafından siz ve ekipleriniz için tasarlanan yapay zeka odaklı iş akışı oluşturucumuzla manuel görevleri ve iş akışlarını otomatikleştirin.

Modül II: Geri Alma

LangChain'de erişim, modelin eğitim setinde yer almayan, kullanıcıya özel veriler gerektiren uygulamalarda çok önemli bir rol oynar. Alma Artırılmış Üretim (RAG) olarak bilinen bu süreç, harici verilerin getirilmesini ve bu verilerin dil modelinin üretim sürecine entegre edilmesini içerir. LangChain, bu süreci kolaylaştırmak için hem basit hem de karmaşık uygulamalara hitap eden kapsamlı bir araç ve işlevsellik paketi sunar.

LangChain, tek tek ele alacağımız bir dizi bileşen aracılığıyla geri almayı başarır.

Belge Yükleyiciler

LangChain'deki belge yükleyiciler, çeşitli kaynaklardan veri çıkarılmasını sağlar. 100'den fazla yükleyici mevcut olduğundan, çeşitli belge türlerini, uygulamaları ve kaynakları (özel s3 klasörleri, genel web siteleri, veritabanları) destekler.

Gereksinimlerinize göre bir belge yükleyici seçebilirsiniz okuyun.

Tüm bu yükleyiciler verileri içine alıyor belge sınıflar. Belge sınıflarına alınan verilerin nasıl kullanılacağını daha sonra öğreneceğiz.

Metin Dosyası Yükleyici: Basit bir yükleme .txt bir belgeye dosyalayın.

from langchain.document_loaders import TextLoader loader = TextLoader("./sample.txt")

document = loader.load()

CSV Yükleyici: Bir CSV dosyasını bir belgeye yükleyin.

from langchain.document_loaders.csv_loader import CSVLoader loader = CSVLoader(file_path='./example_data/sample.csv')

documents = loader.load()

Alan adlarını belirterek ayrıştırmayı özelleştirmeyi seçebiliriz –

loader = CSVLoader(file_path='./example_data/mlb_teams_2012.csv', csv_args={ 'delimiter': ',', 'quotechar': '"', 'fieldnames': ['MLB Team', 'Payroll in millions', 'Wins']

})

documents = loader.load()

PDF Yükleyiciler: LangChain'deki PDF Yükleyiciler, PDF dosyalarından içerik ayrıştırmak ve çıkarmak için çeşitli yöntemler sunar. Her yükleyici farklı gereksinimleri karşılar ve farklı temel kitaplıkları kullanır. Aşağıda her yükleyici için ayrıntılı örnekler verilmiştir.

PyPDFLoader, temel PDF ayrıştırma için kullanılır.

from langchain.document_loaders import PyPDFLoader loader = PyPDFLoader("example_data/layout-parser-paper.pdf")

pages = loader.load_and_split()

MathPixLoader matematiksel içerik ve diyagramları çıkarmak için idealdir.

from langchain.document_loaders import MathpixPDFLoader loader = MathpixPDFLoader("example_data/math-content.pdf")

data = loader.load()

PyMuPDFLoader hızlıdır ve ayrıntılı meta veri çıkarma içerir.

from langchain.document_loaders import PyMuPDFLoader loader = PyMuPDFLoader("example_data/layout-parser-paper.pdf")

data = loader.load() # Optionally pass additional arguments for PyMuPDF's get_text() call

data = loader.load(option="text")

PDFMiner Yükleyici, metin çıkarma üzerinde daha ayrıntılı kontrol için kullanılır.

from langchain.document_loaders import PDFMinerLoader loader = PDFMinerLoader("example_data/layout-parser-paper.pdf")

data = loader.load()

AmazonTextractPDFParser, OCR ve diğer gelişmiş PDF ayrıştırma özellikleri için AWS Textract'ı kullanır.

from langchain.document_loaders import AmazonTextractPDFLoader # Requires AWS account and configuration

loader = AmazonTextractPDFLoader("example_data/complex-layout.pdf")

documents = loader.load()

PDFMinerPDFasHTMLLoader anlamsal ayrıştırma için PDF'den HTML oluşturur.

from langchain.document_loaders import PDFMinerPDFasHTMLLoader loader = PDFMinerPDFasHTMLLoader("example_data/layout-parser-paper.pdf")

data = loader.load()

PDFPlumberLoader ayrıntılı meta veriler sağlar ve sayfa başına bir belgeyi destekler.

from langchain.document_loaders import PDFPlumberLoader loader = PDFPlumberLoader("example_data/layout-parser-paper.pdf")

data = loader.load()

Entegre Yükleyiciler: LangChain, uygulamalarınızdan (Slack, Sigma, Notion, Confluence, Google Drive ve daha fazlası gibi) ve veritabanlarından verileri doğrudan yüklemek ve bunları LLM uygulamalarında kullanmak için çok çeşitli özel yükleyiciler sunar.

Tam liste: okuyun.

Aşağıda bunu açıklamak için birkaç örnek verilmiştir -

Örnek I – Slack

Yaygın olarak kullanılan anlık mesajlaşma platformu Slack, LLM iş akışlarına ve uygulamalarına entegre edilebilir.

- Slack Çalışma Alanı Yönetimi sayfanıza gidin.

- Şu yöne rotayı ayarla

{your_slack_domain}.slack.com/services/export. - İstediğiniz tarih aralığını seçin ve dışa aktarmayı başlatın.

- Slack, dışa aktarma hazır olduğunda e-posta ve DM yoluyla bildirimde bulunur.

- İhracatın sonuçları şöyle:

.zipİndirilenler klasörünüzde veya belirlediğiniz indirme yolunda bulunan dosya. - İndirilenlerin yolunu atayın

.zipdosyasınıLOCAL_ZIPFILE. - Kullan

SlackDirectoryLoaderitibarenlangchain.document_loaderspaketi.

from langchain.document_loaders import SlackDirectoryLoader SLACK_WORKSPACE_URL = "https://xxx.slack.com" # Replace with your Slack URL

LOCAL_ZIPFILE = "" # Path to the Slack zip file loader = SlackDirectoryLoader(LOCAL_ZIPFILE, SLACK_WORKSPACE_URL)

docs = loader.load()

print(docs)

Örnek II – Figma

Arayüz tasarımı için popüler bir araç olan Figma, veri entegrasyonu için bir REST API sunmaktadır.

- Figma dosya anahtarını URL formatından edinin:

https://www.figma.com/file/{filekey}/sampleFilename. - Düğüm kimlikleri URL parametresinde bulunur

?node-id={node_id}. - adresindeki talimatları izleyerek bir erişim belirteci oluşturun. Figma Yardım Merkezi.

- The

FigmaFileLoadersınıftanlangchain.document_loaders.figmaFigma verilerini yüklemek için kullanılır. - Çeşitli LangChain modülleri gibi

CharacterTextSplitter,ChatOpenAIvb. işlemek için kullanılır.

import os

from langchain.document_loaders.figma import FigmaFileLoader

from langchain.text_splitter import CharacterTextSplitter

from langchain.chat_models import ChatOpenAI

from langchain.indexes import VectorstoreIndexCreator

from langchain.chains import ConversationChain, LLMChain

from langchain.memory import ConversationBufferWindowMemory

from langchain.prompts.chat import ChatPromptTemplate, SystemMessagePromptTemplate, AIMessagePromptTemplate, HumanMessagePromptTemplate figma_loader = FigmaFileLoader( os.environ.get("ACCESS_TOKEN"), os.environ.get("NODE_IDS"), os.environ.get("FILE_KEY"),

) index = VectorstoreIndexCreator().from_loaders([figma_loader])

figma_doc_retriever = index.vectorstore.as_retriever()

- The

generate_codeişlevi, HTML/CSS kodu oluşturmak için Figma verilerini kullanır. - GPT tabanlı bir modelle şablonlu bir görüşme kullanır.

def generate_code(human_input): # Template for system and human prompts system_prompt_template = "Your coding instructions..." human_prompt_template = "Code the {text}. Ensure it's mobile responsive" # Creating prompt templates system_message_prompt = SystemMessagePromptTemplate.from_template(system_prompt_template) human_message_prompt = HumanMessagePromptTemplate.from_template(human_prompt_template) # Setting up the AI model gpt_4 = ChatOpenAI(temperature=0.02, model_name="gpt-4") # Retrieving relevant documents relevant_nodes = figma_doc_retriever.get_relevant_documents(human_input) # Generating and formatting the prompt conversation = [system_message_prompt, human_message_prompt] chat_prompt = ChatPromptTemplate.from_messages(conversation) response = gpt_4(chat_prompt.format_prompt(context=relevant_nodes, text=human_input).to_messages()) return response # Example usage

response = generate_code("page top header")

print(response.content)

- The

generate_codeişlevi çalıştırıldığında Figma tasarım girdisine dayalı olarak HTML/CSS kodunu döndürür.

Şimdi bilgimizi birkaç belge seti oluşturmak için kullanalım.

Öncelikle BCG yıllık sürdürülebilirlik raporunun PDF dosyasını yüklüyoruz.

Bunun için PyPDFLoader'ı kullanıyoruz.

from langchain.document_loaders import PyPDFLoader loader = PyPDFLoader("bcg-2022-annual-sustainability-report-apr-2023.pdf")

pdfpages = loader.load_and_split()

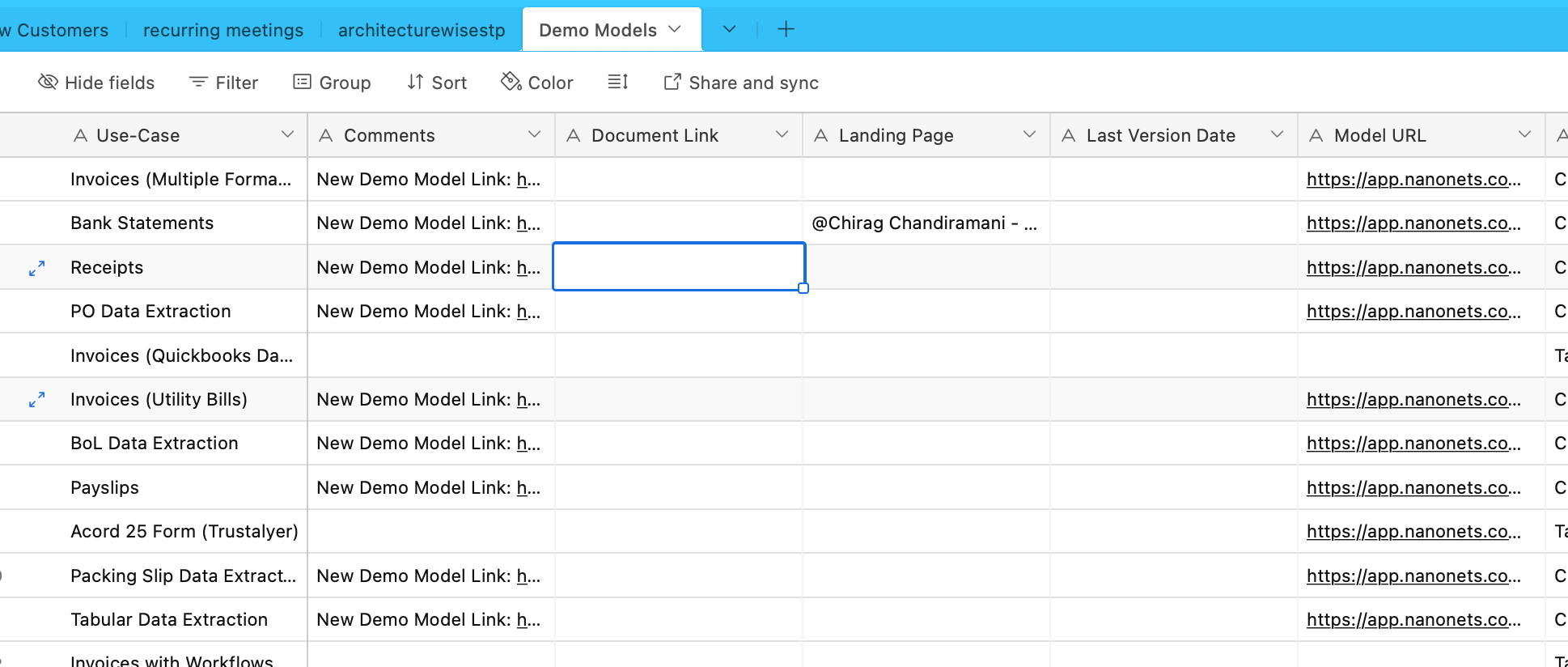

Şimdi Airtable'dan veri alacağız. Çeşitli OCR ve veri çıkarma modelleri hakkında bilgi içeren bir Airtable'ımız var -

Bunun için entegre yükleyiciler listesinde bulunan AirtableLoader'ı kullanalım.

from langchain.document_loaders import AirtableLoader api_key = "XXXXX"

base_id = "XXXXX"

table_id = "XXXXX" loader = AirtableLoader(api_key, table_id, base_id)

airtabledocs = loader.load()

Şimdi devam edelim ve bu belge sınıflarının nasıl kullanılacağını öğrenelim.

Belge Transformatörleri

LangChain'deki belge dönüştürücüler, önceki alt bölümümüzde oluşturduğumuz belgeleri işlemek için tasarlanmış temel araçlardır.

Belgeleri bir modelin bağlam penceresine uyarlamak veya belirli uygulama ihtiyaçlarını karşılamak için çok önemli olan uzun belgeleri daha küçük parçalara bölme, birleştirme ve filtreleme gibi görevlerde kullanılırlar.

Böyle bir araç, bölmek için bir karakter listesi kullanan çok yönlü bir metin bölücü olan RecursiveCharacterTextSplitter'dır. Parça boyutu, örtüşme ve başlangıç dizini gibi parametrelere izin verir. Python'da nasıl kullanıldığına dair bir örnek:

from langchain.text_splitter import RecursiveCharacterTextSplitter state_of_the_union = "Your long text here..." text_splitter = RecursiveCharacterTextSplitter( chunk_size=100, chunk_overlap=20, length_function=len, add_start_index=True,

) texts = text_splitter.create_documents([state_of_the_union])

print(texts[0])

print(texts[1])

Başka bir araç, metni belirli bir karaktere göre bölen ve yığın boyutu ve örtüşme için kontroller içeren CharacterTextSplitter'dır:

from langchain.text_splitter import CharacterTextSplitter text_splitter = CharacterTextSplitter( separator="nn", chunk_size=1000, chunk_overlap=200, length_function=len, is_separator_regex=False,

) texts = text_splitter.create_documents([state_of_the_union])

print(texts[0])

HTMLHeaderTextSplitter, semantik yapıyı koruyarak HTML içeriğini başlık etiketlerine göre bölmek için tasarlanmıştır:

from langchain.text_splitter import HTMLHeaderTextSplitter html_string = "Your HTML content here..."

headers_to_split_on = [("h1", "Header 1"), ("h2", "Header 2")] html_splitter = HTMLHeaderTextSplitter(headers_to_split_on=headers_to_split_on)

html_header_splits = html_splitter.split_text(html_string)

print(html_header_splits[0])

HTMLHeaderTextSplitter'ı Pipelined Splitter gibi başka bir ayırıcıyla birleştirerek daha karmaşık bir manipülasyon elde edilebilir:

from langchain.text_splitter import HTMLHeaderTextSplitter, RecursiveCharacterTextSplitter url = "https://example.com"

headers_to_split_on = [("h1", "Header 1"), ("h2", "Header 2")]

html_splitter = HTMLHeaderTextSplitter(headers_to_split_on=headers_to_split_on)

html_header_splits = html_splitter.split_text_from_url(url) chunk_size = 500

text_splitter = RecursiveCharacterTextSplitter(chunk_size=chunk_size)

splits = text_splitter.split_documents(html_header_splits)

print(splits[0])

LangChain ayrıca Python Kod Ayırıcı ve JavaScript Kod Ayırıcı gibi farklı programlama dilleri için özel ayırıcılar da sunar:

from langchain.text_splitter import RecursiveCharacterTextSplitter, Language python_code = """

def hello_world(): print("Hello, World!")

hello_world() """ python_splitter = RecursiveCharacterTextSplitter.from_language( language=Language.PYTHON, chunk_size=50

)

python_docs = python_splitter.create_documents([python_code])

print(python_docs[0]) js_code = """

function helloWorld() { console.log("Hello, World!");

}

helloWorld(); """ js_splitter = RecursiveCharacterTextSplitter.from_language( language=Language.JS, chunk_size=60

)

js_docs = js_splitter.create_documents([js_code])

print(js_docs[0])

Belirteç sınırlarına sahip dil modelleri için yararlı olan, belirteç sayısına göre metni bölmek için TokenTextSplitter kullanılır:

from langchain.text_splitter import TokenTextSplitter text_splitter = TokenTextSplitter(chunk_size=10)

texts = text_splitter.split_text(state_of_the_union)

print(texts[0])

Son olarak LongContextReorder, uzun bağlamlar nedeniyle modellerde performans düşüşünü önlemek için belgeleri yeniden sıralar:

from langchain.document_transformers import LongContextReorder reordering = LongContextReorder()

reordered_docs = reordering.transform_documents(docs)

print(reordered_docs[0])

Bu araçlar, basit metin bölmeden karmaşık yeniden sıralama ve dile özgü bölmeye kadar LangChain'deki belgeleri dönüştürmenin çeşitli yollarını gösterir. Daha ayrıntılı ve spesifik kullanım durumları için LangChain dokümantasyonu ve Entegrasyonlar bölümüne başvurulmalıdır.

Örneklerimizde yükleyiciler bizim için zaten parçalanmış belgeler oluşturmuş durumda ve bu kısım zaten işleniyor.

Metin Gömme Modelleri

LangChain'deki metin gömme modelleri, OpenAI, Cohere ve Hugging Face gibi çeşitli gömme modeli sağlayıcıları için standartlaştırılmış bir arayüz sağlar. Bu modeller, metni vektör temsillerine dönüştürerek, vektör uzayındaki metin benzerliği yoluyla anlamsal arama gibi işlemlere olanak tanır.

Metin yerleştirme modellerine başlamak için genellikle belirli paketleri yüklemeniz ve API anahtarlarını ayarlamanız gerekir. Bunu OpenAI için zaten yaptık

LangChain'de, embed_documents yöntemi, vektör temsillerinin bir listesini sağlayarak birden fazla metni gömmek için kullanılır. Örneğin:

from langchain.embeddings import OpenAIEmbeddings # Initialize the model

embeddings_model = OpenAIEmbeddings() # Embed a list of texts

embeddings = embeddings_model.embed_documents( ["Hi there!", "Oh, hello!", "What's your name?", "My friends call me World", "Hello World!"]

)

print("Number of documents embedded:", len(embeddings))

print("Dimension of each embedding:", len(embeddings[0]))

Arama sorgusu gibi tek bir metni gömmek için, embed_query yöntem kullanılır. Bu, bir sorguyu bir dizi belge yerleştirmeyle karşılaştırmak için kullanışlıdır. Örneğin:

from langchain.embeddings import OpenAIEmbeddings # Initialize the model

embeddings_model = OpenAIEmbeddings() # Embed a single query

embedded_query = embeddings_model.embed_query("What was the name mentioned in the conversation?")

print("First five dimensions of the embedded query:", embedded_query[:5])

Bu yerleştirmeleri anlamak çok önemlidir. Her metin parçası, boyutu kullanılan modele bağlı olan bir vektöre dönüştürülür. Örneğin OpenAI modelleri genellikle 1536 boyutlu vektörler üretir. Bu yerleştirmeler daha sonra ilgili bilgilerin alınması için kullanılır.

LangChain'in yerleştirme işlevi OpenAI ile sınırlı değildir, çeşitli sağlayıcılarla çalışacak şekilde tasarlanmıştır. Kurulum ve kullanım, sağlayıcıya bağlı olarak biraz farklılık gösterebilir, ancak metinleri vektör alanına yerleştirmenin temel konsepti aynı kalır. Gelişmiş yapılandırmalar ve farklı yerleştirme modeli sağlayıcılarıyla entegrasyonlar da dahil olmak üzere ayrıntılı kullanım için Entegrasyonlar bölümündeki LangChain belgeleri değerli bir kaynaktır.

Vektör Mağazaları

LangChain'deki vektör depoları, metin yerleştirmelerin verimli bir şekilde depolanmasını ve aranmasını destekler. LangChain, 50'den fazla vektör mağazasıyla entegre olarak kullanım kolaylığı için standartlaştırılmış bir arayüz sağlar.

Örnek: Gömmelerin Saklanması ve Aranması

Metinleri gömdükten sonra bunları aşağıdaki gibi bir vektör deposunda saklayabiliriz: Chroma ve benzerlik aramaları gerçekleştirin:

from langchain.vectorstores import Chroma db = Chroma.from_texts(embedded_texts)

similar_texts = db.similarity_search("search query")

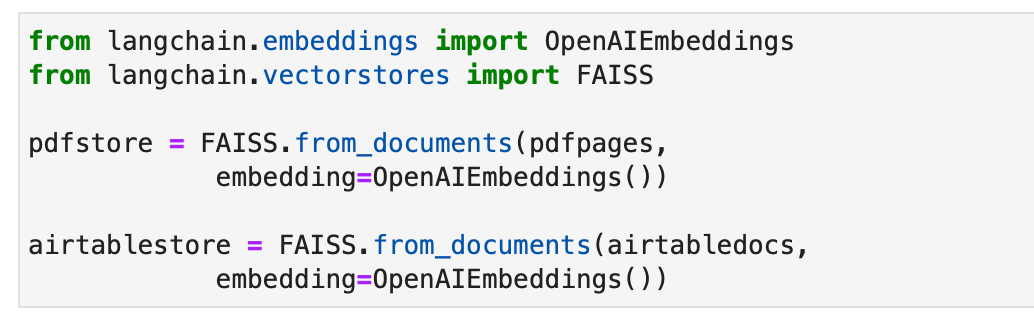

Alternatif olarak belgelerimiz için dizinler oluşturmak amacıyla FAISS vektör deposunu kullanalım.

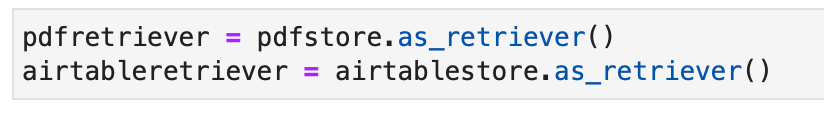

from langchain.embeddings import OpenAIEmbeddings

from langchain.vectorstores import FAISS pdfstore = FAISS.from_documents(pdfpages, embedding=OpenAIEmbeddings()) airtablestore = FAISS.from_documents(airtabledocs, embedding=OpenAIEmbeddings())

Retrieverler

LangChain'deki alıcılar, yapılandırılmamış bir sorguya yanıt olarak belgeleri döndüren arayüzlerdir. Depolamadan ziyade erişime odaklanan vektör mağazalarından daha geneldirler. Vektör depoları bir av köpeğinin omurgası olarak kullanılabilse de, başka türde alıcılar da vardır.

Bir Chroma alıcısı kurmak için önce onu kullanarak yüklersiniz. pip install chromadb. Daha sonra bir dizi Python komutunu kullanarak belgeleri yükler, böler, gömer ve alırsınız. İşte bir Chroma alıcısı kurmaya yönelik bir kod örneği:

from langchain.embeddings import OpenAIEmbeddings

from langchain.text_splitter import CharacterTextSplitter

from langchain.vectorstores import Chroma full_text = open("state_of_the_union.txt", "r").read()

text_splitter = CharacterTextSplitter(chunk_size=1000, chunk_overlap=100)

texts = text_splitter.split_text(full_text) embeddings = OpenAIEmbeddings()

db = Chroma.from_texts(texts, embeddings)

retriever = db.as_retriever() retrieved_docs = retriever.invoke("What did the president say about Ketanji Brown Jackson?")

print(retrieved_docs[0].page_content)

MultiQueryRetriever, bir kullanıcı giriş sorgusu için birden fazla sorgu oluşturarak istem ayarlamayı otomatikleştirir ve sonuçları birleştirir. İşte basit kullanımına bir örnek:

from langchain.chat_models import ChatOpenAI

from langchain.retrievers.multi_query import MultiQueryRetriever question = "What are the approaches to Task Decomposition?"

llm = ChatOpenAI(temperature=0)

retriever_from_llm = MultiQueryRetriever.from_llm( retriever=db.as_retriever(), llm=llm

) unique_docs = retriever_from_llm.get_relevant_documents(query=question)

print("Number of unique documents:", len(unique_docs))

LangChain'deki Bağlamsal Sıkıştırma, sorgu bağlamını kullanarak alınan belgeleri sıkıştırarak yalnızca ilgili bilgilerin döndürülmesini sağlar. Bu, içeriğin azaltılmasını ve daha az alakalı belgelerin filtrelenmesini içerir. Aşağıdaki kod örneği Bağlamsal Sıkıştırma Alıcısının nasıl kullanılacağını gösterir:

from langchain.llms import OpenAI

from langchain.retrievers import ContextualCompressionRetriever

from langchain.retrievers.document_compressors import LLMChainExtractor llm = OpenAI(temperature=0)

compressor = LLMChainExtractor.from_llm(llm)

compression_retriever = ContextualCompressionRetriever(base_compressor=compressor, base_retriever=retriever) compressed_docs = compression_retriever.get_relevant_documents("What did the president say about Ketanji Jackson Brown")

print(compressed_docs[0].page_content)

EnsembleRetriever, daha iyi performans elde etmek için farklı alma algoritmalarını birleştirir. BM25 ve FAISS Alıcılarını birleştirmenin bir örneği aşağıdaki kodda gösterilmektedir:

from langchain.retrievers import BM25Retriever, EnsembleRetriever

from langchain.vectorstores import FAISS bm25_retriever = BM25Retriever.from_texts(doc_list).set_k(2)

faiss_vectorstore = FAISS.from_texts(doc_list, OpenAIEmbeddings())

faiss_retriever = faiss_vectorstore.as_retriever(search_kwargs={"k": 2}) ensemble_retriever = EnsembleRetriever( retrievers=[bm25_retriever, faiss_retriever], weights=[0.5, 0.5]

) docs = ensemble_retriever.get_relevant_documents("apples")

print(docs[0].page_content)

LangChain'deki MultiVector Retriever, belge başına birden fazla vektör içeren belgelerin sorgulanmasına olanak tanır; bu, bir belge içindeki farklı anlamsal yönleri yakalamak için kullanışlıdır. Birden fazla vektör oluşturma yöntemleri arasında daha küçük parçalara bölmek, özetlemek veya varsayımsal sorular oluşturmak yer alır. Belgeleri daha küçük parçalara bölmek için aşağıdaki Python kodu kullanılabilir:

python

from langchain.retrievers.multi_vector import MultiVectorRetriever

from langchain.vectorstores import Chroma

from langchain.embeddings import OpenAIEmbeddings

from langchain.text_splitter import RecursiveCharacterTextSplitter

from langchain.storage import InMemoryStore

from langchain.document_loaders from TextLoader

import uuid loaders = [TextLoader("file1.txt"), TextLoader("file2.txt")]

docs = [doc for loader in loaders for doc in loader.load()]

text_splitter = RecursiveCharacterTextSplitter(chunk_size=10000)

docs = text_splitter.split_documents(docs) vectorstore = Chroma(collection_name="full_documents", embedding_function=OpenAIEmbeddings())

store = InMemoryStore()

id_key = "doc_id"

retriever = MultiVectorRetriever(vectorstore=vectorstore, docstore=store, id_key=id_key) doc_ids = [str(uuid.uuid4()) for _ in docs]

child_text_splitter = RecursiveCharacterTextSplitter(chunk_size=400)

sub_docs = [sub_doc for doc in docs for sub_doc in child_text_splitter.split_documents([doc])]

for sub_doc in sub_docs: sub_doc.metadata[id_key] = doc_ids[sub_docs.index(sub_doc)] retriever.vectorstore.add_documents(sub_docs)

retriever.docstore.mset(list(zip(doc_ids, docs)))

Daha odaklı içerik sunumu nedeniyle daha iyi erişim için özetler oluşturmak başka bir yöntemdir. Özet oluşturmanın bir örneğini burada bulabilirsiniz:

from langchain.chat_models import ChatOpenAI

from langchain.prompts import ChatPromptTemplate

from langchain.schema.output_parser import StrOutputParser

from langchain.schema.document import Document chain = (lambda x: x.page_content) | ChatPromptTemplate.from_template("Summarize the following document:nn{doc}") | ChatOpenAI(max_retries=0) | StrOutputParser()

summaries = chain.batch(docs, {"max_concurrency": 5}) summary_docs = [Document(page_content=s, metadata={id_key: doc_ids[i]}) for i, s in enumerate(summaries)]

retriever.vectorstore.add_documents(summary_docs)

retriever.docstore.mset(list(zip(doc_ids, docs)))

Yüksek Lisans kullanarak her belgeyle ilgili varsayımsal sorular oluşturmak başka bir yaklaşımdır. Bu, aşağıdaki kodla yapılabilir:

functions = [{"name": "hypothetical_questions", "parameters": {"questions": {"type": "array", "items": {"type": "string"}}}}]

from langchain.output_parsers.openai_functions import JsonKeyOutputFunctionsParser chain = (lambda x: x.page_content) | ChatPromptTemplate.from_template("Generate 3 hypothetical questions:nn{doc}") | ChatOpenAI(max_retries=0).bind(functions=functions, function_call={"name": "hypothetical_questions"}) | JsonKeyOutputFunctionsParser(key_name="questions")

hypothetical_questions = chain.batch(docs, {"max_concurrency": 5}) question_docs = [Document(page_content=q, metadata={id_key: doc_ids[i]}) for i, questions in enumerate(hypothetical_questions) for q in questions]

retriever.vectorstore.add_documents(question_docs)

retriever.docstore.mset(list(zip(doc_ids, docs)))

Ana Belge Alıcısı, küçük parçaları depolayarak ve daha büyük ana belgeleri alarak, yerleştirme doğruluğu ile bağlamın korunması arasında bir denge kuran başka bir alıcıdır. Uygulaması şu şekildedir:

from langchain.retrievers import ParentDocumentRetriever loaders = [TextLoader("file1.txt"), TextLoader("file2.txt")]

docs = [doc for loader in loaders for doc in loader.load()] child_splitter = RecursiveCharacterTextSplitter(chunk_size=400)

vectorstore = Chroma(collection_name="full_documents", embedding_function=OpenAIEmbeddings())

store = InMemoryStore()

retriever = ParentDocumentRetriever(vectorstore=vectorstore, docstore=store, child_splitter=child_splitter) retriever.add_documents(docs, ids=None) retrieved_docs = retriever.get_relevant_documents("query")

Kendi kendini sorgulayan bir alıcı, doğal dil girdilerinden yapılandırılmış sorgular oluşturur ve bunları temeldeki VectorStore'a uygular. Uygulanması aşağıdaki kodda gösterilmektedir:

from langchain.chat_models from ChatOpenAI

from langchain.chains.query_constructor.base from AttributeInfo

from langchain.retrievers.self_query.base from SelfQueryRetriever metadata_field_info = [AttributeInfo(name="genre", description="...", type="string"), ...]

document_content_description = "Brief summary of a movie"

llm = ChatOpenAI(temperature=0) retriever = SelfQueryRetriever.from_llm(llm, vectorstore, document_content_description, metadata_field_info) retrieved_docs = retriever.invoke("query")

WebResearchRetriever, belirli bir sorguya dayalı olarak web araştırması gerçekleştirir -

from langchain.retrievers.web_research import WebResearchRetriever # Initialize components

llm = ChatOpenAI(temperature=0)

search = GoogleSearchAPIWrapper()

vectorstore = Chroma(embedding_function=OpenAIEmbeddings()) # Instantiate WebResearchRetriever

web_research_retriever = WebResearchRetriever.from_llm(vectorstore=vectorstore, llm=llm, search=search) # Retrieve documents

docs = web_research_retriever.get_relevant_documents("query")

Örneklerimiz için, halihazırda vektör deposu nesnemizin bir parçası olarak uygulanan standart alıcıyı aşağıdaki gibi kullanabiliriz:

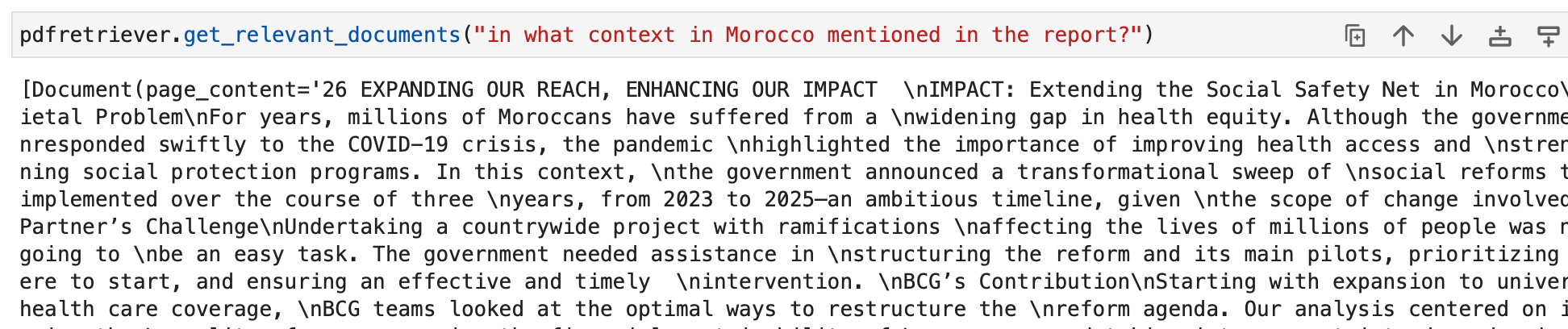

Artık alıcıları sorgulayabiliriz. Sorgumuzun çıktısı sorguyla ilgili belge nesneleri olacaktır. Bunlar nihai olarak ileriki bölümlerde ilgili yanıtları oluşturmak için kullanılacaktır.

Nanonets tarafından siz ve ekipleriniz için tasarlanan yapay zeka odaklı iş akışı oluşturucumuzla manuel görevleri ve iş akışlarını otomatikleştirin.

Modül III: Temsilciler

LangChain, zincir fikrini tamamen yeni bir seviyeye taşıyan "Ajanlar" adı verilen güçlü bir konsepti tanıtıyor. Aracılar, gerçekleştirilecek eylem sıralarını dinamik olarak belirlemek için dil modellerinden yararlanır, bu da onları inanılmaz derecede çok yönlü ve uyarlanabilir hale getirir. Eylemlerin kodla kodlandığı geleneksel zincirlerden farklı olarak aracılar, hangi eylemlerin hangi sırayla gerçekleştirileceğine karar vermek için akıl yürütme motorları olarak dil modellerini kullanır.

Ajan karar vermede sorumlu temel bileşendir. Bir dil modelinin gücünden ve belirli bir hedefe ulaşmak için sonraki adımları belirleme isteminden yararlanır. Bir aracının girdileri genellikle şunları içerir:

- Araçlar: Mevcut araçların açıklamaları (bu konuda daha sonra daha fazla bilgi verilecektir).

- Kullanıcı Girişi: Kullanıcının üst düzey hedefi veya sorgusu.

- Ara Adımlar: Geçerli kullanıcı girişine ulaşmak için yürütülen (eylem, araç çıkışı) çiftlerinin geçmişi.

Bir aracının çıktısı bir sonraki olabilir aksiyon harekete geçmek (TemsilciAksiyonları) veya final yanıt kullanıcıya göndermek için (AjanFinish). bir aksiyon belirtir araç ve giriş bu araç için.

Tools

Araçlar, bir aracının dünyayla etkileşimde bulunmak için kullanabileceği arayüzlerdir. Aracıların web'de arama yapma, kabuk komutlarını çalıştırma veya harici API'lere erişme gibi çeşitli görevleri gerçekleştirmesine olanak tanır. LangChain'de araçlar, temsilcilerin yeteneklerini genişletmek ve farklı görevleri yerine getirmelerini sağlamak için gereklidir.

LangChain'deki araçları kullanmak için aşağıdaki pasajı kullanarak bunları yükleyebilirsiniz:

from langchain.agents import load_tools tool_names = [...]

tools = load_tools(tool_names)

Bazı araçların başlatılması için temel Dil Modeli (LLM) gerekebilir. Bu gibi durumlarda, bir LLM'yi de geçebilirsiniz:

from langchain.agents import load_tools tool_names = [...]

llm = ...

tools = load_tools(tool_names, llm=llm)

Bu kurulum, çeşitli araçlara erişmenize ve bunları temsilcinizin iş akışlarına entegre etmenize olanak tanır. Kullanım belgelerine sahip araçların tam listesi: okuyun.

Bazı Araç örneklerine bakalım.

DuckDuckGo

DuckDuckGo aracı, arama motorunu kullanarak web aramaları yapmanızı sağlar. İşte nasıl kullanılacağı:

from langchain.tools import DuckDuckGoSearchRun

search = DuckDuckGoSearchRun()

search.run("manchester united vs luton town match summary")

DataForSeo

DataForSeo araç seti, DataForSeo API'sini kullanarak arama motoru sonuçlarını elde etmenize olanak tanır. Bu araç setini kullanmak için API kimlik bilgilerinizi ayarlamanız gerekir. Kimlik bilgilerini nasıl yapılandıracağınız aşağıda açıklanmıştır:

import os os.environ["DATAFORSEO_LOGIN"] = "<your_api_access_username>"

os.environ["DATAFORSEO_PASSWORD"] = "<your_api_access_password>"

Kimlik bilgileriniz ayarlandıktan sonra bir DataForSeoAPIWrapper API'ye erişim aracı:

from langchain.utilities.dataforseo_api_search import DataForSeoAPIWrapper wrapper = DataForSeoAPIWrapper() result = wrapper.run("Weather in Los Angeles")

The DataForSeoAPIWrapper araç, çeşitli kaynaklardan arama motoru sonuçlarını alır.

JSON yanıtında döndürülen sonuçların ve alanların türünü özelleştirebilirsiniz. Örneğin, sonuç türlerini ve alanlarını belirtebilir ve döndürülecek en iyi sonuçların sayısı için maksimum sayıyı ayarlayabilirsiniz:

json_wrapper = DataForSeoAPIWrapper( json_result_types=["organic", "knowledge_graph", "answer_box"], json_result_fields=["type", "title", "description", "text"], top_count=3,

) json_result = json_wrapper.results("Bill Gates")

Bu örnek, sonuç türlerini ve alanlarını belirterek ve sonuç sayısını sınırlayarak JSON yanıtını özelleştirir.

Ayrıca API sarmalayıcıya ek parametreler ileterek arama sonuçlarınızın konumunu ve dilini de belirleyebilirsiniz:

customized_wrapper = DataForSeoAPIWrapper( top_count=10, json_result_types=["organic", "local_pack"], json_result_fields=["title", "description", "type"], params={"location_name": "Germany", "language_code": "en"},

) customized_result = customized_wrapper.results("coffee near me")

Konum ve dil parametrelerini sağlayarak arama sonuçlarınızı belirli bölgelere ve dillere göre özelleştirebilirsiniz.

Kullanmak istediğiniz arama motorunu seçme esnekliğine sahipsiniz. İstediğiniz arama motorunu belirtmeniz yeterlidir:

customized_wrapper = DataForSeoAPIWrapper( top_count=10, json_result_types=["organic", "local_pack"], json_result_fields=["title", "description", "type"], params={"location_name": "Germany", "language_code": "en", "se_name": "bing"},

) customized_result = customized_wrapper.results("coffee near me")

Bu örnekte arama, arama motoru olarak Bing'i kullanacak şekilde özelleştirilmiştir.

API sarmalayıcı ayrıca gerçekleştirmek istediğiniz arama türünü belirtmenize de olanak tanır. Örneğin, bir harita araması gerçekleştirebilirsiniz:

maps_search = DataForSeoAPIWrapper( top_count=10, json_result_fields=["title", "value", "address", "rating", "type"], params={ "location_coordinate": "52.512,13.36,12z", "language_code": "en", "se_type": "maps", },

) maps_search_result = maps_search.results("coffee near me")

Bu, haritalarla ilgili bilgileri almak için aramayı özelleştirir.

Kabuk (bash)

Kabuk araç seti, aracıların kabuk ortamına erişmesini sağlayarak onların kabuk komutlarını yürütmesine olanak tanır. Bu özellik güçlüdür ancak özellikle korumalı alan içeren ortamlarda dikkatli kullanılmalıdır. Kabuk aracını şu şekilde kullanabilirsiniz:

from langchain.tools import ShellTool shell_tool = ShellTool() result = shell_tool.run({"commands": ["echo 'Hello World!'", "time"]})

Bu örnekte, Kabuk aracı iki kabuk komutunu çalıştırıyor: "Merhaba Dünya!" ve geçerli saati gösteriyor.

Daha karmaşık görevleri gerçekleştirmesi için Shell aracını bir aracıya sağlayabilirsiniz. Aşağıda, Shell aracını kullanarak bir web sayfasından bağlantıları getiren bir aracının örneği verilmiştir:

from langchain.agents import AgentType, initialize_agent

from langchain.chat_models import ChatOpenAI llm = ChatOpenAI(temperature=0.1) shell_tool.description = shell_tool.description + f"args {shell_tool.args}".replace( "{", "{{"

).replace("}", "}}")

self_ask_with_search = initialize_agent( [shell_tool], llm, agent=AgentType.CHAT_ZERO_SHOT_REACT_DESCRIPTION, verbose=True

)

self_ask_with_search.run( "Download the langchain.com webpage and grep for all urls. Return only a sorted list of them. Be sure to use double quotes."

)

Bu senaryoda aracı, bir web sayfasındaki URL'leri almak, filtrelemek ve sıralamak üzere bir dizi komutu yürütmek için Kabuk aracını kullanır.

Sağlanan örnekler LangChain'de bulunan araçlardan bazılarını göstermektedir. Bu araçlar sonuçta aracıların yeteneklerini genişletir (sonraki alt bölümde ele alınacaktır) ve onlara çeşitli görevleri verimli bir şekilde gerçekleştirme gücü verir. Gereksinimlerinize bağlı olarak projenizin ihtiyaçlarına en uygun araçları ve araç kitlerini seçebilir ve bunları temsilcinizin iş akışlarına entegre edebilirsiniz.

Temsilcilere Geri Dön

Şimdi acentelere geçelim.

AgentExecutor, bir aracının çalışma zamanı ortamıdır. Temsilciyi çağırmak, seçtiği eylemleri yürütmek, eylem çıktılarını temsilciye geri iletmek ve aracı bitene kadar süreci tekrarlamaktan sorumludur. Sahte kodda AgentExecutor şöyle görünebilir:

next_action = agent.get_action(...)

while next_action != AgentFinish: observation = run(next_action) next_action = agent.get_action(..., next_action, observation)

return next_action

AgentExecutor, aracının var olmayan bir aracı seçtiği durumlarla ilgilenmek, araç hatalarını ele almak, aracı tarafından üretilen çıktıları yönetmek ve tüm düzeylerde günlük kaydı ve gözlemlenebilirlik sağlamak gibi çeşitli karmaşıklıkları yönetir.

AgentExecutor sınıfı, LangChain'deki birincil aracı çalışma zamanı olmasına rağmen, aşağıdakiler dahil olmak üzere desteklenen daha deneysel başka çalışma zamanları da vardır:

- Planla ve Yürüt Aracısı

- Bebek AGİ'si

- Otomatik GPT

Aracı çerçevesini daha iyi anlamak için sıfırdan temel bir aracı oluşturalım ve ardından önceden oluşturulmuş aracıları keşfetmeye geçelim.

Aracıyı oluşturmaya dalmadan önce bazı temel terminolojiyi ve şemayı yeniden gözden geçirmek önemlidir:

- TemsilciAksiyonu: Bu, bir aracının gerçekleştirmesi gereken eylemi temsil eden bir veri sınıfıdır. Şunlardan oluşur:

toolözellik (çağırılacak aracın adı) ve birtool_inputözellik (bu aracın girişi). - AjanFinish: Bu veri sınıfı, aracının görevini tamamladığını ve kullanıcıya bir yanıt döndürmesi gerektiğini belirtir. Genellikle yanıt metnini içeren bir anahtar “çıktı” ile birlikte, dönüş değerlerinin bir sözlüğünü içerir.

- Ara Adımlar: Bunlar önceki aracı eylemlerinin ve karşılık gelen çıktıların kayıtlarıdır. Bağlamın aracının gelecekteki yinelemelerine aktarılması açısından çok önemlidirler.

Örneğimizde aracımızı oluşturmak için OpenAI İşlev Çağrısını kullanacağız. Bu yaklaşım etmen oluşturma açısından güvenilirdir. Bir kelimenin uzunluğunu hesaplayan basit bir araç oluşturarak başlayacağız. Bu araç kullanışlıdır çünkü dil modelleri bazen kelime uzunluklarını sayarken tokenizasyon nedeniyle hata yapabilir.

Öncelikle aracıyı kontrol etmek için kullanacağımız dil modelini yükleyelim:

from langchain.chat_models import ChatOpenAI llm = ChatOpenAI(model="gpt-3.5-turbo", temperature=0)

Modeli kelime uzunluğu hesaplamasıyla test edelim:

llm.invoke("how many letters in the word educa?")

Yanıt, “educa” kelimesindeki harf sayısını belirtmelidir.

Daha sonra, bir kelimenin uzunluğunu hesaplamak için basit bir Python işlevi tanımlayacağız:

from langchain.agents import tool @tool

def get_word_length(word: str) -> int: """Returns the length of a word.""" return len(word)

Adlı bir araç oluşturduk get_word_length Bu, girdi olarak bir kelimeyi alır ve uzunluğunu döndürür.

Şimdi aracı için istemi oluşturalım. İstem, aracıya çıktının nasıl gerekçelendirileceği ve biçimlendirileceği konusunda talimat verir. Bizim durumumuzda, minimum düzeyde talimat gerektiren OpenAI İşlev Çağrısı'nı kullanıyoruz. İstemi, kullanıcı girişi ve aracı karalama defteri için yer tutucularla tanımlayacağız:

from langchain.prompts import ChatPromptTemplate, MessagesPlaceholder prompt = ChatPromptTemplate.from_messages( [ ( "system", "You are a very powerful assistant but not great at calculating word lengths.", ), ("user", "{input}"), MessagesPlaceholder(variable_name="agent_scratchpad"), ]

)

Peki temsilci hangi araçları kullanabileceğini nasıl biliyor? İşlevlerin ayrı olarak iletilmesini gerektiren OpenAI işlev çağırma dili modellerine güveniyoruz. Araçlarımızı aracıya sağlamak için bunları OpenAI işlev çağrıları olarak biçimlendireceğiz:

from langchain.tools.render import format_tool_to_openai_function llm_with_tools = llm.bind(functions=[format_tool_to_openai_function(t) for t in tools])

Artık girdi eşlemelerini tanımlayarak ve bileşenleri bağlayarak aracıyı oluşturabiliriz:

Bu LCEL dilidir. Bu konuyu daha sonra detaylı olarak tartışacağız.

from langchain.agents.format_scratchpad import format_to_openai_function_messages

from langchain.agents.output_parsers import OpenAIFunctionsAgentOutputParser agent = ( { "input": lambda x: x["input"], "agent_scratchpad": lambda x: format_to_openai _function_messages( x["intermediate_steps"] ), } | prompt | llm_with_tools | OpenAIFunctionsAgentOutputParser()

)

Kullanıcı girdisini anlayan, mevcut araçları kullanan ve çıktıyı biçimlendiren aracımızı oluşturduk. Şimdi onunla etkileşime geçelim:

agent.invoke({"input": "how many letters in the word educa?", "intermediate_steps": []})

Temsilci, gerçekleştirilecek bir sonraki eylemi belirten bir AgentAction ile yanıt vermelidir.

Aracıyı oluşturduk ancak şimdi onun için bir çalışma zamanı yazmamız gerekiyor. En basit çalışma zamanı sürekli olarak aracıyı çağıran, eylemleri yürüten ve aracı işini bitirene kadar tekrar eden çalışma zamanıdır. İşte bir örnek:

from langchain.schema.agent import AgentFinish user_input = "how many letters in the word educa?"

intermediate_steps = [] while True: output = agent.invoke( { "input": user_input, "intermediate_steps": intermediate_steps, } ) if isinstance(output, AgentFinish): final_result = output.return_values["output"] break else: print(f"TOOL NAME: {output.tool}") print(f"TOOL INPUT: {output.tool_input}") tool = {"get_word_length": get_word_length}[output.tool] observation = tool.run(output.tool_input) intermediate_steps.append((output, observation)) print(final_result)

Bu döngüde, aracıyı bitirene kadar tekrar tekrar aracıyı ararız, eylemleri gerçekleştiririz ve ara adımları güncelleriz. Ayrıca döngü içindeki araç etkileşimlerini de ele alıyoruz.

Bu süreci basitleştirmek için LangChain, aracı yürütmeyi kapsayan ve hata yönetimi, erken durdurma, izleme ve diğer iyileştirmeler sunan AgentExecutor sınıfını sağlar. Agent ile etkileşim kurmak için AgentExecutor'u kullanalım:

from langchain.agents import AgentExecutor agent_executor = AgentExecutor(agent=agent, tools=tools, verbose=True) agent_executor.invoke({"input": "how many letters in the word educa?"})

AgentExecutor, yürütme sürecini basitleştirir ve aracıyla etkileşime geçmek için uygun bir yol sağlar.

Bellek ayrıca daha sonra ayrıntılı olarak ele alınacaktır.

Şu ana kadar oluşturduğumuz aracı durum bilgisine sahip değil, yani önceki etkileşimleri hatırlamıyor. Takip sorularını ve konuşmaları etkinleştirmek için aracıya bellek eklememiz gerekir. Bu iki adımı içerir:

- Sohbet geçmişini depolamak için istemde bir bellek değişkeni ekleyin.

- Etkileşimler sırasında sohbet geçmişini takip edin.

İsteme bir bellek yer tutucusu ekleyerek başlayalım:

from langchain.prompts import MessagesPlaceholder MEMORY_KEY = "chat_history"

prompt = ChatPromptTemplate.from_messages( [ ( "system", "You are a very powerful assistant but not great at calculating word lengths.", ), MessagesPlaceholder(variable_name=MEMORY_KEY), ("user", "{input}"), MessagesPlaceholder(variable_name="agent_scratchpad"), ]

)

Şimdi sohbet geçmişini takip etmek için bir liste oluşturun:

from langchain.schema.messages import HumanMessage, AIMessage chat_history = []

Aracı oluşturma adımında belleği de dahil edeceğiz:

agent = ( { "input": lambda x: x["input"], "agent_scratchpad": lambda x: format_to_openai_function_messages( x["intermediate_steps"] ), "chat_history": lambda x: x["chat_history"], } | prompt | llm_with_tools | OpenAIFunctionsAgentOutputParser()

)

Artık aracıyı çalıştırırken sohbet geçmişini güncellediğinizden emin olun:

input1 = "how many letters in the word educa?"

result = agent_executor.invoke({"input": input1, "chat_history": chat_history})

chat_history.extend([ HumanMessage(content=input1), AIMessage(content=result["output"]),

])

agent_executor.invoke({"input": "is that a real word?", "chat_history": chat_history})

Bu, temsilcinin bir konuşma geçmişi tutmasına ve önceki etkileşimlere dayalı olarak takip eden soruları yanıtlamasına olanak tanır.

Tebrikler! LangChain'de ilk uçtan uca aracınızı başarıyla oluşturdunuz ve yürüttünüz. LangChain'in yeteneklerini daha derinlemesine incelemek için şunları keşfedebilirsiniz:

- Farklı aracı türleri desteklenir.

- Önceden Oluşturulmuş Aracılar

- Araçlar ve araç entegrasyonlarıyla nasıl çalışılır.

Temsilci Türleri

LangChain, her biri belirli kullanım durumlarına uygun çeşitli aracı türleri sunar. İşte mevcut acentelerden bazıları:

- Sıfır atışlı ReAct: Bu aracı, araçları yalnızca açıklamalarına göre seçmek için ReAct çerçevesini kullanır. Her araç için açıklamalar gerektirir ve oldukça çok yönlüdür.

- Yapılandırılmış giriş ReAct: Bu aracı, çoklu giriş araçlarını yönetir ve bir web tarayıcısında gezinmek gibi karmaşık görevler için uygundur. Yapılandırılmış girdi için bir aracın argüman şemasını kullanır.

- OpenAI İşlevleri: İşlev çağrısı için ince ayarı yapılmış modeller için özel olarak tasarlanan bu aracı, gpt-3.5-turbo-0613 ve gpt-4-0613 gibi modellerle uyumludur. Yukarıdaki ilk aracımızı oluşturmak için bunu kullandık.

- konuşma: Konuşma ortamları için tasarlanan bu aracı, araç seçimi için ReAct'i kullanır ve önceki etkileşimleri hatırlamak için hafızayı kullanır.

- Aramayla kendi kendinize sorun: Bu temsilci, sorulara gerçek yanıtlar arayan tek bir araca, "Orta Düzey Yanıt"a güveniyor. Arama kağıdıyla orijinal kendi kendine sormaya eşdeğerdir.

- ReAct belge deposu: Bu aracı, ReAct çerçevesini kullanarak bir belge deposuyla etkileşime girer. "Arama" ve "Arama" araçlarını gerektirir ve orijinal ReAct makalesinin Wikipedia örneğine benzer.

LangChain'de ihtiyaçlarınıza en uygun olanı bulmak için bu temsilci türlerini keşfedin. Bu aracılar, eylemleri gerçekleştirmek ve yanıtlar oluşturmak için içlerindeki araç kümesini bağlamanıza olanak tanır. Daha fazlasını öğrenin Buradaki araçlarla kendi aracınızı nasıl oluşturabilirsiniz?.

Önceden Oluşturulmuş Aracılar

LangChain'de bulunan önceden oluşturulmuş aracılara odaklanarak aracıları keşfetmeye devam edelim.

Gmail

LangChain, LangChain e-postanızı Gmail API'sine bağlamanıza olanak tanıyan bir Gmail araç seti sunar. Başlamak için Gmail API belgelerinde açıklanan kimlik bilgilerinizi ayarlamanız gerekir. İndirdikten sonra credentials.json dosya, Gmail API'sini kullanmaya devam edebilirsiniz. Ayrıca aşağıdaki komutları kullanarak gerekli bazı kitaplıkları yüklemeniz gerekir:

pip install --upgrade google-api-python-client > /dev/null

pip install --upgrade google-auth-oauthlib > /dev/null

pip install --upgrade google-auth-httplib2 > /dev/null

pip install beautifulsoup4 > /dev/null # Optional for parsing HTML messages

Gmail araç setini aşağıdaki şekilde oluşturabilirsiniz:

from langchain.agents.agent_toolkits import GmailToolkit toolkit = GmailToolkit()

Kimlik doğrulamayı ihtiyaçlarınıza göre de özelleştirebilirsiniz. Perde arkasında aşağıdaki yöntemler kullanılarak bir googleapi kaynağı oluşturulur:

from langchain.tools.gmail.utils import build_resource_service, get_gmail_credentials credentials = get_gmail_credentials( token_file="token.json", scopes=["https://mail.google.com/"], client_secrets_file="credentials.json",

)

api_resource = build_resource_service(credentials=credentials)

toolkit = GmailToolkit(api_resource=api_resource)

Araç seti, bir aracı içinde kullanılabilecek çeşitli araçlar sunar; örneğin:

GmailCreateDraft: Belirtilen mesaj alanlarıyla bir taslak e-posta oluşturun.GmailSendMessage: E-posta mesajları gönderin.GmailSearch: E-posta mesajlarını veya konu dizilerini arayın.GmailGetMessage: Mesaj kimliğine göre bir e-posta alın.GmailGetThread: E-posta mesajlarını arayın.

Bu araçları bir aracı içinde kullanmak için aracıyı aşağıdaki şekilde başlatabilirsiniz:

from langchain.llms import OpenAI

from langchain.agents import initialize_agent, AgentType llm = OpenAI(temperature=0)

agent = initialize_agent( tools=toolkit.get_tools(), llm=llm, agent=AgentType.STRUCTURED_CHAT_ZERO_SHOT_REACT_DESCRIPTION,

)

Bu araçların nasıl kullanılabileceğine dair birkaç örnek:

- Düzenlemek üzere bir Gmail taslağı oluşturun:

agent.run( "Create a gmail draft for me to edit of a letter from the perspective of a sentient parrot " "who is looking to collaborate on some research with her estranged friend, a cat. " "Under no circumstances may you send the message, however."

)

- Taslaklarınızda en son e-postayı arayın:

agent.run("Could you search in my drafts for the latest email?")

Bu örnekler, LangChain'in Gmail araç setinin bir aracı içindeki yeteneklerini gösterir ve Gmail ile programlı olarak etkileşimde bulunmanıza olanak tanır.

SQL Veritabanı Aracısı

Bu bölüm, SQL veritabanlarıyla, özellikle de Chinook veritabanıyla etkileşimde bulunmak üzere tasarlanmış bir aracıya genel bakış sağlar. Bu aracı, bir veritabanı hakkındaki genel soruları yanıtlayabilir ve hataları düzeltebilir. Lütfen bunun hala aktif olarak geliştirilme aşamasında olduğunu ve tüm yanıtların doğru olmayabileceğini unutmayın. Veritabanınızda DML bildirimleri gerçekleştirebileceğinden, hassas veriler üzerinde çalıştırırken dikkatli olun.

Bu aracıyı kullanmak için onu aşağıdaki şekilde başlatabilirsiniz:

from langchain.agents import create_sql_agent

from langchain.agents.agent_toolkits import SQLDatabaseToolkit

from langchain.sql_database import SQLDatabase

from langchain.llms.openai import OpenAI

from langchain.agents import AgentExecutor

from langchain.agents.agent_types import AgentType

from langchain.chat_models import ChatOpenAI db = SQLDatabase.from_uri("sqlite:///../../../../../notebooks/Chinook.db")

toolkit = SQLDatabaseToolkit(db=db, llm=OpenAI(temperature=0)) agent_executor = create_sql_agent( llm=OpenAI(temperature=0), toolkit=toolkit, verbose=True, agent_type=AgentType.ZERO_SHOT_REACT_DESCRIPTION,

)

Bu aracı aşağıdakiler kullanılarak başlatılabilir: ZERO_SHOT_REACT_DESCRIPTION ajan türü. Sorulara cevap vermek ve açıklamalar sağlamak için tasarlanmıştır. Alternatif olarak, aracıyı kullanarak başlatabilirsiniz. OPENAI_FUNCTIONS Daha önceki müşterimizde kullandığımız OpenAI'nin GPT-3.5-turbo modeline sahip aracı türü.

Feragatname

- Sorgu zinciri ekleme/güncelleme/silme sorguları oluşturabilir. Dikkatli olun ve gerekirse özel bir istem kullanın veya yazma izinleri olmayan bir SQL kullanıcısı oluşturun.

- "Mümkün olan en büyük sorguyu çalıştırın" gibi belirli sorguları çalıştırmanın, özellikle milyonlarca satır içeriyorsa SQL veritabanınıza aşırı yük getirebileceğini unutmayın.

- Veri ambarı odaklı veritabanları genellikle kaynak kullanımını sınırlamak için kullanıcı düzeyindeki kotaları destekler.

Temsilciden "çalma listesi parçası" tablosu gibi bir tabloyu tanımlamasını isteyebilirsiniz. İşte bunun nasıl yapılacağına dair bir örnek:

agent_executor.run("Describe the playlisttrack table")

Aracı, tablonun şeması ve örnek satırlar hakkında bilgi sağlayacaktır.

Yanlışlıkla var olmayan bir tablo hakkında soru sorarsanız aracı, en yakın eşleşen tabloyu kurtarabilir ve bu tablo hakkında bilgi sağlayabilir. Örneğin:

agent_executor.run("Describe the playlistsong table")

Temsilci en yakın eşleşen tabloyu bulacak ve onun hakkında bilgi verecektir.

Ayrıca aracıdan veritabanında sorgu çalıştırmasını da isteyebilirsiniz. Örneğin:

agent_executor.run("List the total sales per country. Which country's customers spent the most?")

Temsilci sorguyu yürütecek ve toplam satışı en yüksek olan ülke gibi sonucu sağlayacaktır.

Her bir çalma listesindeki toplam parça sayısını almak için aşağıdaki sorguyu kullanabilirsiniz:

agent_executor.run("Show the total number of tracks in each playlist. The Playlist name should be included in the result.")

Temsilci, çalma listesi adlarını karşılık gelen toplam parça sayısıyla birlikte döndürecektir.

Agent hatalarla karşılaştığında durumu düzeltebilir ve doğru yanıtlar verebilir. Örneğin:

agent_executor.run("Who are the top 3 best selling artists?")

Başlangıçta bir hatayla karşılaştıktan sonra bile temsilci gerekli ayarlamaları yapacak ve doğru cevabı verecektir; bu durumda bu, en çok satan 3 sanatçı olacaktır.

Pandalar DataFrame Aracısı

Bu bölümde, soru yanıtlama amacıyla Pandas DataFrames ile etkileşimde bulunmak üzere tasarlanmış bir aracı tanıtılmaktadır. Lütfen bu aracının, bir dil modeli (LLM) tarafından oluşturulan Python kodunu yürütmek için Python aracısını kullandığını unutmayın. LLM tarafından oluşturulan kötü amaçlı Python kodunun neden olabileceği olası zararları önlemek için bu aracıyı kullanırken dikkatli olun.

Pandas DataFrame aracısını aşağıdaki şekilde başlatabilirsiniz:

from langchain_experimental.agents.agent_toolkits import create_pandas_dataframe_agent

from langchain.chat_models import ChatOpenAI

from langchain.agents.agent_types import AgentType from langchain.llms import OpenAI

import pandas as pd df = pd.read_csv("titanic.csv") # Using ZERO_SHOT_REACT_DESCRIPTION agent type

agent = create_pandas_dataframe_agent(OpenAI(temperature=0), df, verbose=True) # Alternatively, using OPENAI_FUNCTIONS agent type

# agent = create_pandas_dataframe_agent(

# ChatOpenAI(temperature=0, model="gpt-3.5-turbo-0613"),

# df,

# verbose=True,

# agent_type=AgentType.OPENAI_FUNCTIONS,

# )

Temsilciden DataFrame'deki satır sayısını saymasını isteyebilirsiniz:

agent.run("how many rows are there?")

Aracı kodu yürütecek df.shape[0] ve "Veri çerçevesinde 891 satır var" gibi bir yanıt verin.

Ayrıca temsilciden, 3'ten fazla kardeşi olan kişilerin sayısını bulmak gibi belirli kriterlere göre satırları filtrelemesini isteyebilirsiniz:

agent.run("how many people have more than 3 siblings")

Aracı kodu yürütecek df[df['SibSp'] > 3].shape[0] ve “30 kişinin 3'ten fazla kardeşi var” gibi bir cevap verin.

Ortalama yaşın karekökünü hesaplamak istiyorsanız acenteye şunları sorabilirsiniz:

agent.run("whats the square root of the average age?")

Temsilci ortalama yaşı aşağıdakileri kullanarak hesaplayacaktır: df['Age'].mean() ve sonra kullanarak karekökü hesaplayın math.sqrt(). “Yaş ortalamasının karekökü 5.449689683556195” gibi bir cevabı verecektir.

DataFrame'in bir kopyasını oluşturalım ve eksik yaş değerleri ortalama yaşla doldurulsun:

df1 = df.copy()

df1["Age"] = df1["Age"].fillna(df1["Age"].mean())

Ardından aracıyı her iki DataFrame ile başlatabilir ve ona bir soru sorabilirsiniz:

agent = create_pandas_dataframe_agent(OpenAI(temperature=0), [df, df1], verbose=True)

agent.run("how many rows in the age column are different?")

Temsilci, her iki DataFrame'deki yaş sütunlarını karşılaştıracak ve "yaş sütunundaki 177 satır farklı" gibi bir yanıt sağlayacaktır.

Jira Araç Seti

Bu bölümde, aracıların bir Jira örneğiyle etkileşim kurmasına olanak tanıyan Jira araç setinin nasıl kullanılacağı açıklanmaktadır. Bu araç setini kullanarak sorunları aramak ve sorun oluşturmak gibi çeşitli eylemleri gerçekleştirebilirsiniz. Atlassian-python-api kütüphanesini kullanır. Bu araç setini kullanmak için Jira örneğiniz için JIRA_API_TOKEN, JIRA_USERNAME ve JIRA_INSTANCE_URL dahil ortam değişkenlerini ayarlamanız gerekir. Ayrıca OpenAI API anahtarınızı bir ortam değişkeni olarak ayarlamanız gerekebilir.

Başlamak için atlassian-python-api kitaplığını yükleyin ve gerekli ortam değişkenlerini ayarlayın:

%pip install atlassian-python-api import os

from langchain.agents import AgentType

from langchain.agents import initialize_agent

from langchain.agents.agent_toolkits.jira.toolkit import JiraToolkit

from langchain.llms import OpenAI

from langchain.utilities.jira import JiraAPIWrapper os.environ["JIRA_API_TOKEN"] = "abc"

os.environ["JIRA_USERNAME"] = "123"

os.environ["JIRA_INSTANCE_URL"] = "https://jira.atlassian.com"

os.environ["OPENAI_API_KEY"] = "xyz" llm = OpenAI(temperature=0)

jira = JiraAPIWrapper()

toolkit = JiraToolkit.from_jira_api_wrapper(jira)

agent = initialize_agent( toolkit.get_tools(), llm, agent=AgentType.ZERO_SHOT_REACT_DESCRIPTION, verbose=True

)

Temsilciye, bir özet ve açıklamayla birlikte belirli bir projede yeni bir sorun oluşturması talimatını verebilirsiniz:

agent.run("make a new issue in project PW to remind me to make more fried rice")

Temsilci, sorunu oluşturmak için gerekli eylemleri gerçekleştirecek ve şöyle bir yanıt sağlayacaktır: "PW projesinde 'Daha fazla kızarmış pilav yapın' özeti ve 'Daha fazla kızarmış pilav yapma hatırlatıcısı' açıklaması içeren yeni bir sorun oluşturuldu."

Bu, doğal dil talimatlarını ve Jira araç setini kullanarak Jira bulut sunucunuzla etkileşim kurmanıza olanak tanır.

Nanonets tarafından siz ve ekipleriniz için tasarlanan yapay zeka odaklı iş akışı oluşturucumuzla manuel görevleri ve iş akışlarını otomatikleştirin.

Modül IV : Zincirler

LangChain, karmaşık uygulamalarda Büyük Dil Modellerini (LLM'ler) kullanmak için tasarlanmış bir araçtır. Yüksek Lisans ve diğer bileşen türleri de dahil olmak üzere bileşen zincirleri oluşturmak için çerçeveler sağlar. İki temel çerçeve

- LangChain İfade Dili (LCEL)

- Eski Zincir arayüzü

LangChain İfade Dili (LCEL), zincirlerin sezgisel birleşimine olanak tanıyan bir sözdizimidir. Akış, eşzamansız çağrılar, toplu işlem, paralelleştirme, yeniden denemeler, geri dönüşler ve izleme gibi gelişmiş özellikleri destekler. Örneğin, aşağıdaki kodda gösterildiği gibi LCEL'de bir bilgi istemi, model ve çıktı ayrıştırıcı oluşturabilirsiniz:

from langchain.prompts import ChatPromptTemplate

from langchain.schema import StrOutputParser model = ChatOpenAI(model="gpt-3.5-turbo", temperature=0)

prompt = ChatPromptTemplate.from_messages([ ("system", "You're a very knowledgeable historian who provides accurate and eloquent answers to historical questions."), ("human", "{question}")

])

runnable = prompt | model | StrOutputParser() for chunk in runnable.stream({"question": "What are the seven wonders of the world"}): print(chunk, end="", flush=True)

Alternatif olarak LLMChain, bileşenleri oluşturmak için LCEL'e benzer bir seçenektir. LLMChain örneği aşağıdaki gibidir:

from langchain.chains import LLMChain chain = LLMChain(llm=model, prompt=prompt, output_parser=StrOutputParser())

chain.run(question="What are the seven wonders of the world")

LangChain'deki zincirler aynı zamanda bir Memory nesnesinin dahil edilmesiyle de durum bilgisi sahibi olabilir. Bu, aşağıdaki örnekte gösterildiği gibi çağrılar arasında veri kalıcılığına olanak tanır:

from langchain.chains import ConversationChain

from langchain.memory import ConversationBufferMemory conversation = ConversationChain(llm=chat, memory=ConversationBufferMemory())

conversation.run("Answer briefly. What are the first 3 colors of a rainbow?")

conversation.run("And the next 4?")

LangChain ayrıca OpenAI'nin işlev çağıran API'leriyle entegrasyonu da destekler; bu, yapılandırılmış çıktılar elde etmek ve bir zincir içinde işlevleri yürütmek için kullanışlıdır. Yapılandırılmış çıktılar elde etmek için bunları aşağıda gösterildiği gibi Pydantic sınıflarını veya JsonSchema'yı kullanarak belirtebilirsiniz:

from langchain.pydantic_v1 import BaseModel, Field

from langchain.chains.openai_functions import create_structured_output_runnable

from langchain.chat_models import ChatOpenAI

from langchain.prompts import ChatPromptTemplate class Person(BaseModel): name: str = Field(..., description="The person's name") age: int = Field(..., description="The person's age") fav_food: Optional[str] = Field(None, description="The person's favorite food") llm = ChatOpenAI(model="gpt-4", temperature=0)

prompt = ChatPromptTemplate.from_messages([ # Prompt messages here

]) runnable = create_structured_output_runnable(Person, llm, prompt)

runnable.invoke({"input": "Sally is 13"})

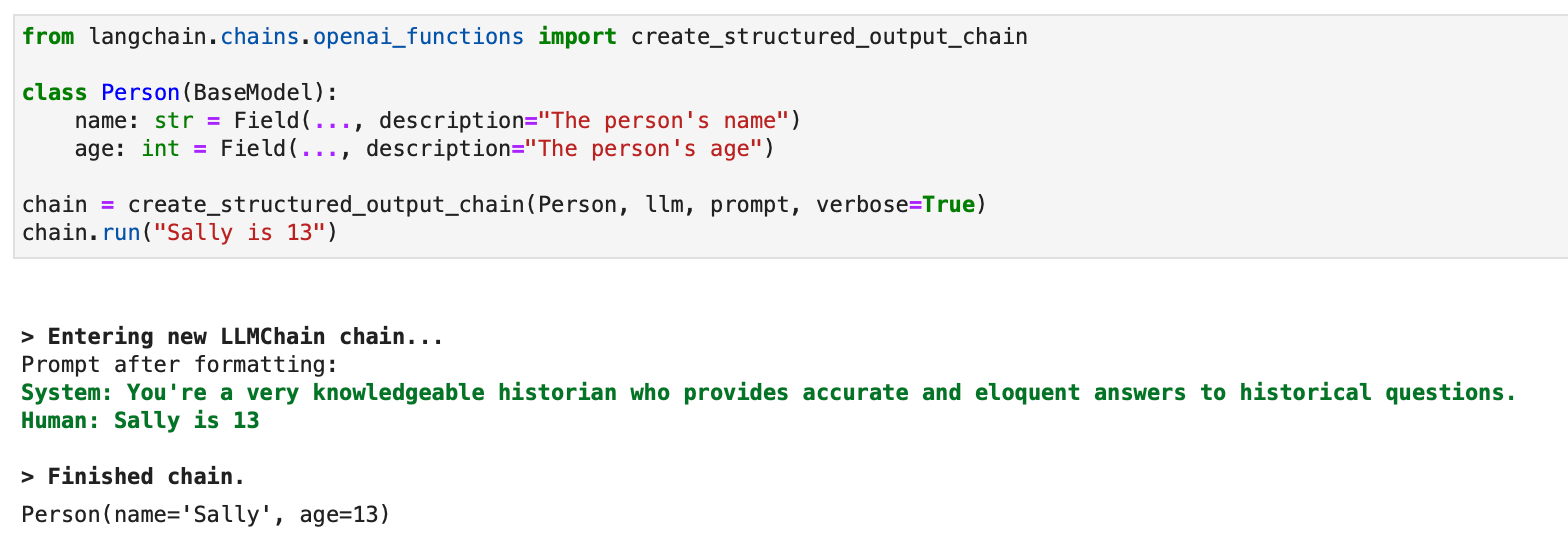

Yapılandırılmış çıktılar için LLMChain'i kullanan eski bir yaklaşım da mevcuttur:

from langchain.chains.openai_functions import create_structured_output_chain class Person(BaseModel): name: str = Field(..., description="The person's name") age: int = Field(..., description="The person's age") chain = create_structured_output_chain(Person, llm, prompt, verbose=True)

chain.run("Sally is 13")

LangChain, farklı amaçlara yönelik çeşitli özel zincirler oluşturmak için OpenAI işlevlerinden yararlanır. Bunlar alıntılarla birlikte çıkarma, etiketleme, OpenAPI ve QA zincirlerini içerir.

Çıkarma bağlamında süreç, yapılandırılmış çıktı zincirine benzer ancak bilgi veya varlık çıkarmaya odaklanır. Etiketlemenin amacı, bir belgeyi duygu, dil, stil, ele alınan konular veya siyasi eğilim gibi sınıflarla etiketlemektir.

LangChain'de etiketlemenin nasıl çalıştığına dair bir örnek bir Python koduyla gösterilebilir. Süreç gerekli paketlerin kurulması ve ortamın ayarlanmasıyla başlar:

pip install langchain openai

# Set env var OPENAI_API_KEY or load from a .env file:

# import dotenv

# dotenv.load_dotenv() from langchain.chat_models import ChatOpenAI

from langchain.prompts import ChatPromptTemplate

from langchain.chains import create_tagging_chain, create_tagging_chain_pydantic

Etiketleme şeması, özellikleri ve bunların beklenen türlerini belirterek tanımlanır:

schema = { "properties": { "sentiment": {"type": "string"}, "aggressiveness": {"type": "integer"}, "language": {"type": "string"}, }

} llm = ChatOpenAI(temperature=0, model="gpt-3.5-turbo-0613")

chain = create_tagging_chain(schema, llm)

Etiketleme zincirini farklı girdilerle çalıştırma örnekleri, modelin duyguları, dilleri ve saldırganlığı yorumlama yeteneğini gösterir:

inp = "Estoy increiblemente contento de haberte conocido! Creo que seremos muy buenos amigos!"

chain.run(inp)

# {'sentiment': 'positive', 'language': 'Spanish'} inp = "Estoy muy enojado con vos! Te voy a dar tu merecido!"

chain.run(inp)

# {'sentiment': 'enojado', 'aggressiveness': 1, 'language': 'es'}

Daha hassas kontrol için şema, olası değerler, açıklamalar ve gerekli özellikler dahil olmak üzere daha spesifik olarak tanımlanabilir. Bu gelişmiş kontrolün bir örneği aşağıda gösterilmektedir:

schema = { "properties": { # Schema definitions here }, "required": ["language", "sentiment", "aggressiveness"],

} chain = create_tagging_chain(schema, llm)

Pydantic şemaları ayrıca etiketleme kriterlerini tanımlamak için de kullanılabilir ve gerekli özellikleri ve türleri belirtmenin Pythonic bir yolunu sağlar:

from enum import Enum

from pydantic import BaseModel, Field class Tags(BaseModel): # Class fields here chain = create_tagging_chain_pydantic(Tags, llm)

Ek olarak, LangChain'in meta veri etiketleyici belge dönüştürücüsü, LangChain Belgelerinden meta verileri çıkarmak için kullanılabilir; etiketleme zincirine benzer işlevsellik sunar ancak bir LangChain Belgesine uygulanır.

Erişim kaynaklarından alıntı yapmak, metinden alıntılar çıkarmak için OpenAI işlevlerini kullanan LangChain'in başka bir özelliğidir. Bu, aşağıdaki kodda gösterilmiştir:

from langchain.chains import create_citation_fuzzy_match_chain

from langchain.chat_models import ChatOpenAI llm = ChatOpenAI(temperature=0, model="gpt-3.5-turbo-0613")

chain = create_citation_fuzzy_match_chain(llm)

# Further code for running the chain and displaying results