Giriş

Gerçek zamanlı yapay zeka sistemleri büyük ölçüde hızlı çıkarımlara dayanır. OpenAI, Google ve Azure gibi sektör liderlerinin çıkarım API'leri hızlı karar almayı mümkün kılar. Groq'un Dil İşleme Birimi (LPU) teknolojisi, yapay zeka işleme verimliliğini artıran çarpıcı bir çözümdür. Bu makalede Groq'un yenilikçi teknolojisi, yapay zeka çıkarım hızları üzerindeki etkisi ve Groq API kullanılarak bundan nasıl yararlanılacağı ele alınmaktadır.

Öğrenme hedefleri

- Groq'un Dil İşleme Birimi (LPU) teknolojisini ve bunun yapay zeka çıkarım hızları üzerindeki etkisini anlayın

- Gerçek zamanlı, düşük gecikmeli yapay zeka işleme görevleri için Groq'un API uç noktalarını nasıl kullanacağınızı öğrenin

- Doğal dilin anlaşılması ve oluşturulması için Groq'un Mixtral-8x7b-Instruct-v0.1 ve Llama-70b gibi desteklenen modellerinin yeteneklerini keşfedin

- Hız, verimlilik ve ölçeklenebilirlik gibi faktörleri inceleyerek Groq'un LPU sistemini diğer çıkarım API'leriyle karşılaştırın ve karşılaştırın

Bu makale, Veri Bilimi Blogatonu.

İçindekiler

Groq nedir?

2016 yılında kurulan, groq merkezi Mountain View'da bulunan Kaliforniya merkezli bir yapay zeka çözümleri girişimidir. Ultra düşük gecikmeli yapay zeka çıkarımı konusunda uzmanlaşan Groq, yapay zeka bilgi işlem performansını önemli ölçüde geliştirdi. Groq, adını bir ticari marka olarak tescil ettiren ve yapay zekaya erişimi demokratikleştirmeye kararlı küresel bir ekip kuran yapay zeka teknolojisi alanında önde gelen bir katılımcıdır.

Dil İşleme Birimleri

Groq'un yenilikçi bir teknoloji olan Dil İşleme Birimi (LPU), özellikle Büyük Dil Modelleri (LLM'ler) için yapay zeka bilgi işlem performansını geliştirmeyi amaçlamaktadır. Groq LPU sistemi, olağanüstü çıkarım performansıyla gerçek zamanlı, düşük gecikmeli deneyimler sunmaya çalışır. Groq, Meta AI'nin Llama-300 2B modelinde kullanıcı başına saniyede 70'den fazla token elde ederek yeni bir endüstri standardı belirledi.

Groq LPU sistemi, yapay zeka destek teknolojileri için hayati önem taşıyan ultra düşük gecikme özelliklerine sahiptir. Sıralı ve yoğun bilgi işlem gerektiren GenAI dil işleme için özel olarak tasarlanan bu ürün, geleneksel GPU çözümlerinden daha iyi performans göstererek doğal dil oluşturma ve anlama gibi görevler için verimli işleme sağlar.

Groq'un LPU sisteminin bir parçası olan birinci nesil GroqChip'i hız, verimlilik, doğruluk ve maliyet etkinliği için optimize edilmiş bir tensör akış mimarisine sahiptir. Bu çip, kullanıcı başına saniye başına token cinsinden ölçülen temel LLM hızında yeni rekorlar kırarak mevcut çözümleri geride bırakıyor. İki yıl içinde 1 milyon yapay zeka çıkarım çipi dağıtmayı planlayan Groq, yapay zeka hızlandırma teknolojilerini ilerletme konusundaki kararlılığını gösteriyor.

Özetle, Groq'un Dil İşleme Birimi sistemi, yapay zeka bilgi işlem teknolojisinde önemli bir ilerlemeyi temsil eder ve Büyük Dil Modelleri için olağanüstü performans ve verimlilik sunarken yapay zekada yeniliği teşvik eder.

Ayrıca Oku: AWS SageMaker'da ML Modeli Oluşturma

Groq'a Başlarken

Şu anda Groq, Groq LPU – Dil İşleme Birimi üzerinde çalışan Büyük Dil Modellerine kullanımı ücretsiz API uç noktaları sağlıyor. Başlamak için burayı ziyaret edin Kanal ve giriş yap'a tıklayın. Sayfa aşağıdaki gibi görünüyor:

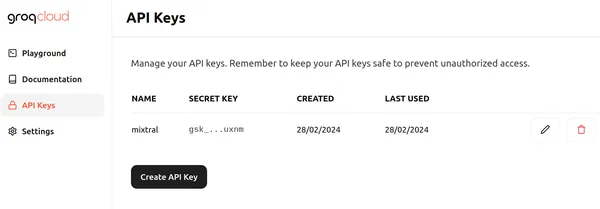

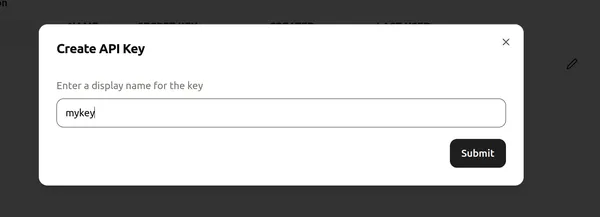

Oturum Aç'a tıklayın ve Groq'ta oturum açmak için uygun yöntemlerden birini seçin. Daha sonra Create API Key butonuna tıklayarak aşağıdaki gibi yeni bir API oluşturabiliriz.

Daha sonra API anahtarına bir ad atayın ve yeni bir API Anahtarı oluşturmak için "gönder"e tıklayın. Şimdi herhangi bir kod düzenleyicisine/Colab'a ilerleyin ve Groq'u kullanmaya başlamak için gerekli kitaplıkları yükleyin.

!pip install groqBu komut, Groq kitaplığını yükleyerek Groq LPU'larda çalışan Büyük Dil Modellerini anlamamızı sağlar.

Şimdi koda devam edelim.

Kod Uygulama

# Importing Necessary Libraries

import os

from groq import Groq

# Instantiation of Groq Client

client = Groq(

api_key=os.environ.get("GROQ_API_KEY"),

)Bu kod parçacığı, Groq API ile etkileşime girecek bir Groq istemci nesnesi oluşturur. API anahtarını GROQ_API_KEY adlı bir ortam değişkeninden alarak başlar ve bunu api_key argümanına iletir. Daha sonra API anahtarı, Groq istemci nesnesini başlatır ve Groq Sunucuları içindeki Büyük Dil Modellerine API çağrılarını etkinleştirir.

LLM'mizi tanımlama

llm = client.chat.completions.create(

messages=[

{

"role": "system",

"content": "You are a helpful AI Assistant. You explain ever

topic the user asks as if you are explaining it to a 5 year old"

},

{

"role": "user",

"content": "What are Black Holes?",

}

],

model="mixtral-8x7b-32768",

)

print(llm.choices[0].message.content)- İlk satır, OpenAI Sohbet Tamamlama API'sine benzer şekilde Büyük Dil Modeli ile etkileşimi mümkün kılan bir llm nesnesini başlatır.

- Sonraki kod, LLM'ye gönderilecek mesajların bir listesini oluşturur ve mesaj değişkeninde saklanır.

- İlk mesaj, rolü "sistem" olarak atar ve LLM'nin konuları 5 yaşındaki bir çocuğa anlatır gibi açıklamak için istenen davranışını tanımlar.

- İkinci mesajda ise “kullanıcı” rolü atanıyor ve kara deliklerle ilgili soru yer alıyor.

- Aşağıdaki satır, Groq API aracılığıyla erişilebilen 8k bağlamlı Mixtral-7x32768b-Instruct-v32 Büyük dil modeli olan "mixtral-8x7b-0.1" olarak ayarlanan yanıtı oluşturmak için kullanılacak LLM'yi belirtir.

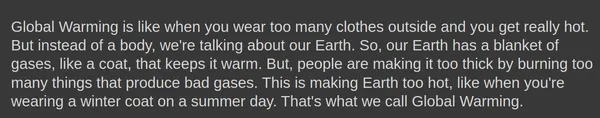

- Bu kodun çıktısı, LLM'den kara delikleri 5 yaşındaki bir çocuğun anlayabileceği şekilde açıklayan bir yanıt olacaktır.

- Çıktıya erişim, OpenAI uç noktasıyla çalışmaya benzer bir yaklaşımı izler.

Çıktı

Aşağıda Mixtral-8x7b-Instruct-v0.1 Büyük dil modeli tarafından oluşturulan çıktı gösterilmektedir:

The tamamlamalar.create() nesne gibi ek parametreleri bile alabilir sıcaklık, top_p, ve max_tokens.

Yanıt Oluşturma

Bu parametrelerle bir yanıt oluşturmaya çalışalım:

llm = client.chat.completions.create(

messages=[

{

"role": "system",

"content": "You are a helpful AI Assistant. You explain ever

topic the user asks as if you are explaining it to a 5 year old"

},

{

"role": "user",

"content": "What is Global Warming?",

}

],

model="mixtral-8x7b-32768",

temperature = 1,

top_p = 1,

max_tokens = 256,

)- sıcaklık: Yanıtların rastgeleliğini kontrol eder. Daha düşük bir sıcaklık daha öngörülebilir çıktılara yol açarken, daha yüksek bir sıcaklık daha çeşitli ve bazen daha yaratıcı çıktılara yol açar.

- max_tokens: Modelin tek bir yanıtta işleyebileceği maksimum jeton sayısı. Bu sınır, hesaplama verimliliğini ve kaynak yönetimini sağlar

- top_p: En olası p jetonun olasılık dağılımından bir sonraki jetonu seçen bir metin oluşturma yöntemi. Bu, üretim sırasında keşif ve kullanım arasında denge kurar

Çıktı

Groq Endpoint'ten oluşturulan yanıtları yayınlama seçeneği bile vardır. sadece belirtmemiz yeterli akış=Doğru seçeneği tamamlamalar.create() modelin yanıtları yayınlamaya başlaması için nesne.

Langchain'deki Groq

Groq, LangChain ile bile uyumludur. LangChain'de Groq'u kullanmaya başlamak için kütüphaneyi indirin:

!pip install langchain-groqYukarıdakiler LangChain uyumluluğu için Groq kütüphanesini kuracaktır. Şimdi kodda deneyelim:

# Import the necessary libraries.

from langchain_core.prompts import ChatPromptTemplate

from langchain_groq import ChatGroq

# Initialize a ChatGroq object with a temperature of 0 and the "mixtral-8x7b-32768" model.

llm = ChatGroq(temperature=0, model_name="mixtral-8x7b-32768")Yukarıdaki kod aşağıdakileri yapar:

- llm adında yeni bir ChatGroq nesnesi oluşturur

- Ayarlar sıcaklık parametrenin 0'a ayarlanması, yanıtların daha öngörülebilir olması gerektiğini belirtir

- Ayarlar model adı parametresi “mixtral-8x7b-32768“, kullanılacak dil modelini belirterek

# Yapay zeka asistanının yeteneklerini tanıtan sistem mesajını tanımlayın.

# Define the system message introducing the AI assistant's capabilities.

system = "You are an expert Coding Assistant."

# Define a placeholder for the user's input.

human = "{text}"

# Create a chat prompt consisting of the system and human messages.

prompt = ChatPromptTemplate.from_messages([("system", system), ("human", human)])

# Invoke the chat chain with the user's input.

chain = prompt | llm

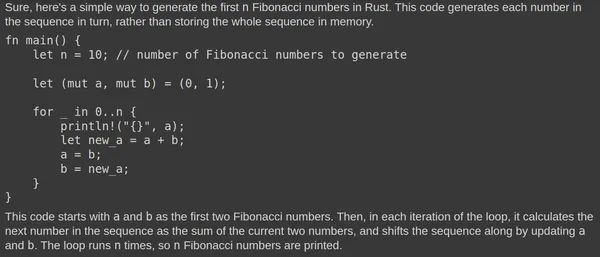

response = chain.invoke({"text": "Write a simple code to generate Fibonacci numbers in Rust?"})

# Print the Response.

print(response.content)- Kod, ChatPromptTemplate sınıfını kullanarak bir Sohbet İstemi oluşturur.

- İstem iki mesajdan oluşur: biri “sistemden” (AI asistanı) ve diğeri “insandan” (kullanıcı).

- Sistem mesajı, AI asistanını uzman bir Kodlama Asistanı olarak sunar.

- İnsan mesajı, kullanıcının girişi için yer tutucu görevi görür.

- llm yöntemi, sağlanan İsteme ve kullanıcının girişine dayalı olarak bir yanıt üretmek için llm zincirini çağırır.

Çıktı

Mixtral Büyük Dil Modeli tarafından oluşturulan çıktı şöyledir:

Mixtral LLM sürekli olarak ilgili yanıtları üretir. Kodun Rust Playground'da test edilmesi, işlevselliğini doğrular. Hızlı yanıt, temeldeki Dil İşleme Birimi'ne (LPU) atfedilir.

Groq ve Diğer Çıkarım API'leri Karşılaştırması

Groq'un Dil İşleme Birimi (LPU) sistemi, OpenAI ve Azure tarafından sağlananlar gibi diğer çıkarım API'lerini geride bırakarak Büyük Dil Modelleri (LLM'ler) için ışık hızında çıkarım hızları sağlamayı amaçlamaktadır. Yüksek Lisans'lar için optimize edilen Groq'un LPU sistemi, yapay zeka yardım teknolojileri için hayati önem taşıyan ultra düşük gecikme yetenekleri sağlar. Bilgi işlem yoğunluğu ve bellek bant genişliği dahil olmak üzere LLM'lerin birincil darboğazlarını ele alarak metin dizilerinin daha hızlı oluşturulmasını sağlar.

Diğer çıkarım API'leriyle karşılaştırıldığında Groq'un LPU sistemi daha hızlıdır ve diğer en iyi bulut tabanlı sağlayıcılara kıyasla Anyscale'in LLMPerf Leaderboard'unda 18 kata kadar daha hızlı çıkarım performansı oluşturma becerisine sahiptir. Groq'un LPU sistemi, büyük ölçekli dağıtımlarda sürdürülen tek çekirdekli mimari ve senkronize ağ bağlantısıyla daha verimli olup, LLM'lerin otomatik olarak derlenmesine ve anında bellek erişimine olanak tanır.

Yukarıdaki resimde 70B modelleri için kıyaslamalar gösterilmektedir. Çıkış jetonlarının veriminin hesaplanması, saniyede döndürülen çıkış jetonlarının sayısının ortalamasını almayı içerir. Her LLM çıkarım sağlayıcısı, sonuçları toplamak için 150 isteği işler ve ortalama çıktı belirteçleri verimi, bu istekler kullanılarak hesaplanır. LLM çıkarım sağlayıcısının iyileştirilmiş performansı, daha yüksek çıktı tokenleri verimiyle gösterilir. Groq'un saniye başına çıktı tokenlarının görüntülenen bulut sağlayıcılarının çoğundan daha iyi performans gösterdiği açıktır.

Sonuç

Sonuç olarak, Groq'un Dil İşleme Birimi (LPU) sistemi, Yapay Zeka hesaplama alanında devrim niteliğinde bir teknoloji olarak öne çıkıyor ve Büyük Dil Modellerini (LLM'ler) işlemek ve yapay zeka alanında yenilikçiliği teşvik etmek için benzeri görülmemiş bir hız ve verimlilik sunuyor. Groq, ultra düşük gecikme yeteneklerinden ve optimize edilmiş mimarisinden yararlanarak, çıkarım hızları için yeni ölçütler belirliyor, geleneksel GPU çözümlerinden ve diğer sektör lideri çıkarım API'lerinden daha iyi performans gösteriyor. Yapay zekaya erişimi demokratikleştirme taahhüdü ve gerçek zamanlı, düşük gecikmeli deneyimlere odaklanmasıyla Groq, yapay zeka hızlandırma teknolojilerinin manzarasını yeniden şekillendirmeye hazırlanıyor.

Önemli Noktalar

- Groq'un Dil İşleme Birimi (LPU) sistemi, özellikle Büyük Dil Modelleri (LLM'ler) için yapay zeka çıkarımı için benzersiz hız ve verimlilik sunarak gerçek zamanlı, düşük gecikmeli deneyimlere olanak tanır

- Groq'un GroqChip içeren LPU sistemi, geleneksel GPU çözümlerinden daha iyi performans göstererek yapay zeka destek teknolojileri için gerekli olan ultra düşük gecikme yeteneklerine sahiptir

- İki yıl içinde 1 milyon yapay zeka çıkarım çipi dağıtmayı planlayan Groq, yapay zeka hızlandırma teknolojilerini geliştirmeye ve yapay zekaya erişimi demokratikleştirmeye olan bağlılığını gösteriyor

- Groq, Groq LPU'da çalışan Büyük Dil Modelleri için kullanımı ücretsiz API uç noktaları sağlayarak geliştiricilerin projelerine entegre olmalarını erişilebilir hale getirir

- Groq'un LangChain ve LlamaIndex ile uyumluluğu, kullanılabilirliğini daha da genişleterek, dil işleme görevlerinde Groq teknolojisinden yararlanmak isteyen geliştiricilere kusursuz entegrasyon sunar.

Sık Sorulan Sorular

A. Groq, yapay zeka hesaplama performansında devrim yaratmayı amaçlayan, özellikle Büyük Dil Modelleri (LLM'ler) için ultra düşük gecikmeli yapay zeka çıkarımı konusunda uzmandır.

A. Groq'un GroqChip'i içeren LPU sistemi, özellikle GenAI dil işlemenin bilgi işlem yoğun doğasına göre tasarlanmış olup, geleneksel GPU çözümlerine kıyasla üstün hız, verimlilik ve doğruluk sunar.

C. Groq, Mixtral-8x7b-Instruct-v0.1 ve Llama-70b dahil olmak üzere yapay zeka çıkarımına yönelik bir dizi modeli destekler.

C. Evet, Groq, LangChain ve LlamaIndex ile uyumludur, kullanılabilirliğini artırır ve dil işleme görevlerinde Groq teknolojisinden yararlanmak isteyen geliştiricilere kusursuz entegrasyon sunar.

C. Groq'un LPU sistemi hız ve verimlilik açısından diğer çıkarım API'lerini geride bırakarak, Anyscale'in LLMPerf Leaderboard'undaki kıyaslamaların da gösterdiği gibi, 18 kata kadar daha yüksek çıkarım hızları ve üstün performans sunar.

Bu makalede gösterilen medya Analytics Vidhya'ya ait değildir ve Yazarın takdirine bağlı olarak kullanılır.

- SEO Destekli İçerik ve Halkla İlişkiler Dağıtımı. Bugün Gücünüzü Artırın.

- PlatoData.Network Dikey Üretken Yapay Zeka. Kendine güç ver. Buradan Erişin.

- PlatoAiStream. Web3 Zekası. Bilgi Genişletildi. Buradan Erişin.

- PlatoESG. karbon, temiz teknoloji, Enerji, Çevre, Güneş, Atık Yönetimi. Buradan Erişin.

- PlatoSağlık. Biyoteknoloji ve Klinik Araştırmalar Zekası. Buradan Erişin.

- Kaynak: https://www.analyticsvidhya.com/blog/2024/03/getting-started-with-groq-api/