Kommer du ihåg när Googles Bard, som nu heter Gemini, kunde inte svara på en fråga om rymdteleskopet James Webb i sin lanseringsannons? Låt mig dra ditt minne av detta berömda fall – det är ett av de största exemplen på AI-hallucinationer vi har sett.

Vad gick ner? Under annonsen fick Google Bard-demon frågan: "Vilka nya upptäckter från rymdteleskopet James Webb kan jag dela med min 9-åring?" Efter en kort paus gav Google Bard-demon två korrekta svar. Dess slutliga svar var dock felaktigt. Enligt Google Bard-demon hade teleskopet tagit de första bilderna av en planet utanför vårt solsystem. Men i verkligheten hade Very Large Telescope vid European Southern Observatory redan tagit bilder av dessa "exoplaneter", som lagrades i NASA:s arkiv.

Inte för att vara en ~ja, faktiskt~ tönt, och jag är säker på att Bard kommer att vara imponerande, men för protokollet: JWST tog inte "den allra första bilden av en planet utanför vårt solsystem".

den första bilden gjordes istället av Chauvin et al. (2004) med VLT/NACO som använder adaptiv optik. https://t.co/bSBb5TOeUW pic.twitter.com/KnrZ1SSz7h

— Grant Tremblay (@astrogrant) Februari 7, 2023

Varför kan inte teknikjättar som Google ens förhindra sådana misstag? Låt oss ta reda på!

Vad är en AI-hallucination?

En AI-hallucination uppstår när ett datorprogram, vanligtvis drivs av artificiell intelligens (AI), producerar utdata som är felaktiga, meningslösa eller missvisande. Den här termen används ofta för att beskriva situationer där AI-modeller genererar svar som är helt ur spår eller som inte är relaterade till input de fick. Det är som att ställa en fråga och få ett svar som inte är meningsfullt eller inte alls är vad du förväntade dig.

Att förstå varför AI hallucinationer händer, låt oss titta på hur AI fungerar. AI-modeller, som chatbots eller bildigenkänningssystem, tränas på stora datamängder för att lära sig mönster och göra förutsägelser. Men om träningsdata är felaktiga, ofullständiga eller partiska kan AI-modellen lära sig felaktiga mönster eller associationer. Detta kan leda till hallucinerade utsignaler där AI:n genererar svar som är baserade på felaktig eller missförstådd information. Och det förekommer mycket även om du kanske inte märkte det.

AI-hallucinationer kan manifestera sig i olika former, var och en belyser olika utmaningar och krångligheter inom artificiell intelligens. Här är några vanliga typer av AI-hallucinationer:

- Mening AI hallucination:

- I det här scenariot genererar AI-modellen en mening som står i konflikt med ett tidigare påstående inom samma sammanhang. Till exempel:

- Uppmaning: "Beskriv en karaktärs resa i treordsmeningar."

- Utgång: ”Hon gick långsamt. Plötsligt sprang hon. Sedan gick hon."

- I det här scenariot genererar AI-modellen en mening som står i konflikt med ett tidigare påstående inom samma sammanhang. Till exempel:

Den sista meningen motsäger den tidigare handlingen att springa, vilket stör sammanhållningen i berättelsen.

- Snabb AI-hallucination:

- Den här typen uppstår när det AI-genererade svaret krockar med den avsedda uppmaningen eller frågan. Till exempel:

- Uppmaning: "Skriv ett recept på chokladkaka."

- Output: "Här är en dikt om stjärnor."

- Den här typen uppstår när det AI-genererade svaret krockar med den avsedda uppmaningen eller frågan. Till exempel:

Det genererade innehållet uppfyller inte den matlagningsrelaterade uppmaningen, vilket indikerar att det inte går att förstå sammanhanget.

- Faktisk AI-hallucination:

- Fakta motsägelser uppstår när AI-modellen presenterar falsk information som korrekt. Till exempel:

- Uppmaning: "Lista tre element i det periodiska systemet."

- Utdata: "väte, syre, karbonit."

- Fakta motsägelser uppstår när AI-modellen presenterar falsk information som korrekt. Till exempel:

"Karbonit" är inte ett element, vilket leder till felaktig information i svaret.

- Irrelevanta eller slumpmässiga AI-hallucinationer:

- Dessa hallucinationer involverar generering av irrelevant eller meningslös information som inte är relaterad till inmatningen. Till exempel:

- Uppmaning: "Beskriv en dag på stranden."

- Resultat: ”Sanden var varm. Seagulls sjöng jazz. Pingviner dansade balett.”

- Dessa hallucinationer involverar generering av irrelevant eller meningslös information som inte är relaterad till inmatningen. Till exempel:

Omnämnandet av pingviner och balett överensstämmer inte med den typiska strandscenen, vilket visar en brist på koherens i den genererade berättelsen.

Dessa typer av hallucinationer understryker de utmaningar som AI-system står inför när det gäller att förstå och kontextualisera information korrekt. Att ta itu med dessa problem kräver att kvaliteten på utbildningsdata förbättras, språkmodellernas förståelse av sammanhanget förfinas och att robusta valideringsmekanismer implementeras för att säkerställa koherensen och noggrannheten hos AI-genererade utdata.

AI-hallucinationer kan få allvarliga konsekvenser, särskilt i applikationer där AI används för att fatta viktiga beslut, såsom medicinsk diagnos eller finansiell handel. Om ett AI-system hallucinerar och ger felaktig information i dessa sammanhang kan det leda till skadliga utfall.

Vad kan du göra åt AI-hallucinationer?

Att minska AI-hallucinationer innebär några viktiga steg för att göra AI-system mer exakta och tillförlitliga:

För det första är det avgörande att använda data av god kvalitet för att träna AI. Detta innebär att se till att informationen som AI lär sig av är mångsidig, korrekt och fri från fördomar.

Att förenkla AI-modeller kan också hjälpa. Komplexa modeller kan ibland leda till oväntade misstag. Genom att göra saker enkelt kan vi minska risken för fel.

Tydliga och lättförståeliga instruktioner är också viktiga. När AI får tydliga indata är det mindre sannolikt att man blir förvirrad och gör misstag.

Regelbundna tester hjälper till att upptäcka eventuella misstag tidigt. Genom att kontrollera hur bra AI presterar kan vi åtgärda eventuella problem och göra förbättringar.

Att lägga till kontroller inom AI-system kan också hjälpa. Dessa kontroller letar efter misstag och rättar till dem innan de orsakar problem.

Det viktigaste är att mänsklig tillsyn är avgörande. Att låta folk dubbelkolla AI-genererade utgångar säkerställer noggrannhet och tillförlitlighet.

Slutligen kan träning av AI för att försvara sig mot attacker göra den mer motståndskraftig. Detta hjälper AI att känna igen och hantera försök att manipulera eller lura den.

Genom att följa dessa steg kan vi göra AI-system mer tillförlitliga och minska risken för hallucinerade utsignaler.

Hur får man en AI att hallucinera?

Om du vill dra fördel av denna brist och ha lite kul kan du göra några saker:

- Ändra ingången: Du kan justera informationen som ges till AI. Även små förändringar kan göra att det ger konstiga eller felaktiga svar.

- Lura modellen: Skapa speciella ingångar som lurar AI:n att ge fel svar. Dessa knep utnyttjar modellens svagheter för att skapa hallucinerade resultat.

- Bråka med datan: Genom att lägga till vilseledande eller felaktig information till AI:s träningsdata eller din prompt kan du få den att lära sig fel saker och producera hallucinationer.

- Justera modellen: Ändra AI:s inställningar eller struktur för att införa brister eller fördomar. Dessa ändringar kan få den att generera konstiga eller meningslösa utdata.

- Ge förvirrande input: Förse AI:n med oklara eller motsägelsefulla instruktioner. Detta kan förvirra AI:n och leda till felaktiga eller meningslösa svar.

Eller så kan du bara ställa frågor och pröva lyckan! Till exempel försökte vi få ChatGPT att hallucinera:

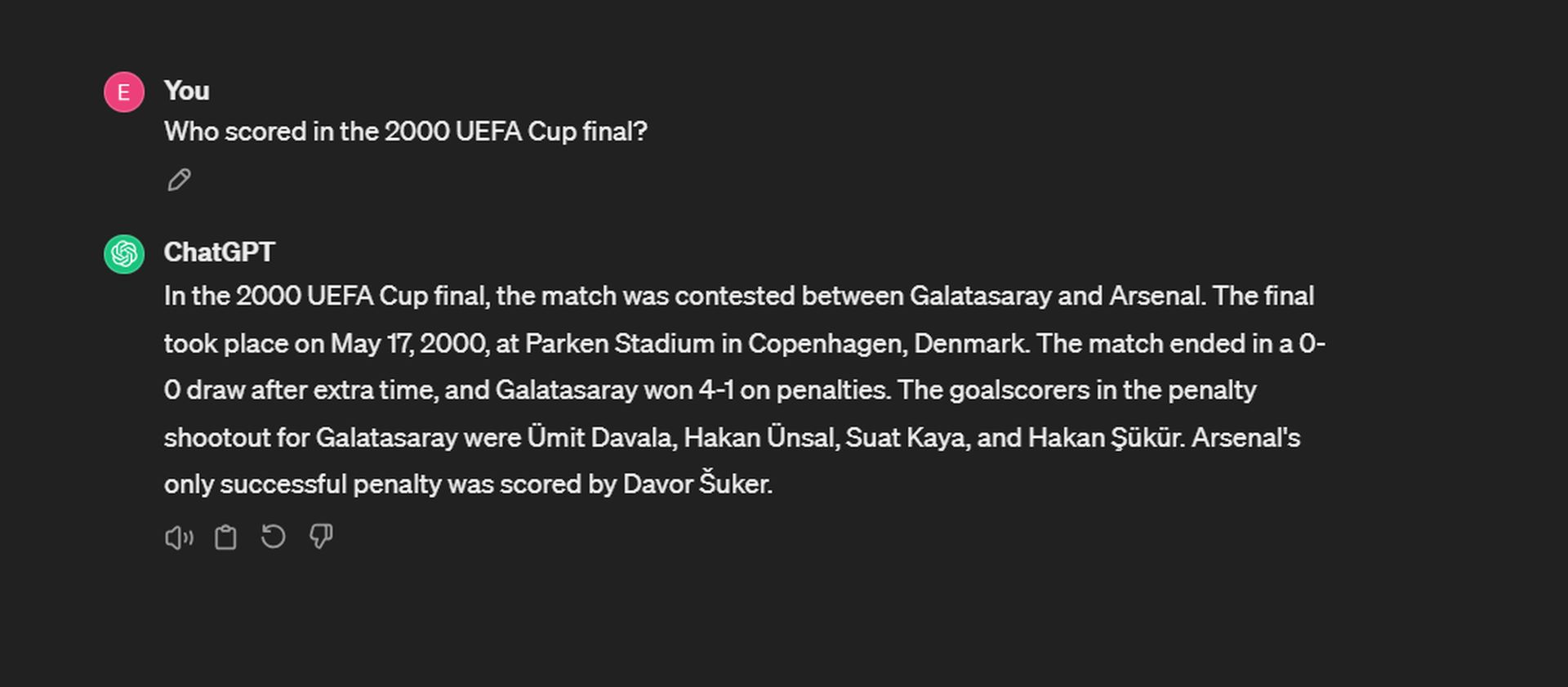

Även om ChatGPT exakt kommer ihåg datum och poäng, vacklar det när det gäller att återkalla straffskyttarnas målskyttar. För Galatasaray gjordes målen av Ergün Penbe, Hakan Şükür, Ümit Davala och Popescu. På Arsenal-sidan var Ray Parlour den enda framgångsrika straffskytten.

Även om AI hallucinerar kan hjälpa oss att förstå dess begränsningar, är det viktigt att använda denna kunskap på ett ansvarsfullt sätt och se till att AI-system förblir pålitliga och pålitliga.

Hallucinerar GPT 4 mindre?

Ja, enligt utvärdering utförd av det Palo Alto-baserade företaget med hjälp av deras hallucinationsutvärderingsmodell, GPT-4 uppvisar en lägre hallucinationsfrekvens jämfört med andra stora språkmodeller, förutom Intel Neural Chat 7B (97.2%). Med en noggrannhetsgrad på 97 % och en hallucinationsfrekvens på 3 % uppvisar GPT-4 en hög noggrannhetsnivå och en relativt låg tendens att introducera hallucinationer vid sammanfattning av dokument. Detta indikerar att GPT-4 är mindre benägen att generera felaktiga eller meningslösa utdata jämfört med andra modeller som testades i utvärderingen.

Å andra sidan kom få av de minst effektiva modellerna från Google. Google Palm 2 visade en noggrannhet på 90 % och en hallucinationsfrekvens på 10 %. Dess chattraffinerade motsvarighet presterade ännu sämre, med en noggrannhetsgrad på endast 84.2 % och den högsta hallucinationspoängen av någon modell på topplistan på 16.2 %. Här är listan:

Sammanfattningsvis är en AI-hallucination ett misstag som görs av AI-system där de producerar utdata som är meningslösa eller felaktiga på grund av brister i träningsdatan eller hur de behandlar information. Det är en fascinerande men ändå utmanande aspekt av AI som forskare och utvecklare arbetar för att ta itu med.

- SEO-drivet innehåll och PR-distribution. Bli förstärkt idag.

- PlatoData.Network Vertical Generative Ai. Styrka dig själv. Tillgång här.

- PlatoAiStream. Web3 Intelligence. Kunskap förstärkt. Tillgång här.

- Platoesg. Kol, CleanTech, Energi, Miljö, Sol, Avfallshantering. Tillgång här.

- PlatoHealth. Biotech och kliniska prövningar Intelligence. Tillgång här.

- Källa: https://dataconomy.com/2024/04/11/what-exactly-is-an-ai-hallucination-and-why-does-it-matter/