Beskrivning

Cohere introducerade sin nästa generations grundmodell, Rerank 3 för effektiv Enterprise Search och Retrieval Augmented Generation(TRASA). Rerank-modellen är kompatibel med alla typer av databas eller sökindex och kan också integreras i alla juridiska tillämpningar med inbyggda sökfunktioner. Du kommer inte att föreställa dig att en enda rad kod kan öka sökprestanda eller minska kostnaden för att köra en RAG ansökan med försumbar inverkan på latensen.

Låt oss utforska hur den här grundmodellen är inställd för att främja företagssökning och RAG-system, med ökad noggrannhet och effektivitet.

Reranks förmåga

Rerank erbjuder de bästa funktionerna för företagssökning som inkluderar följande:

- 4K-kontextlängd som avsevärt förbättrar sökkvaliteten för dokument med längre format.

- Den kan söka över multi-aspekt och semi-strukturerad data som tabeller, kod, JSON dokument, fakturor och e-postmeddelanden.

- Den kan täcka mer än 100 språk.

- Förbättrad latens och minskad total ägandekostnad (TCO)

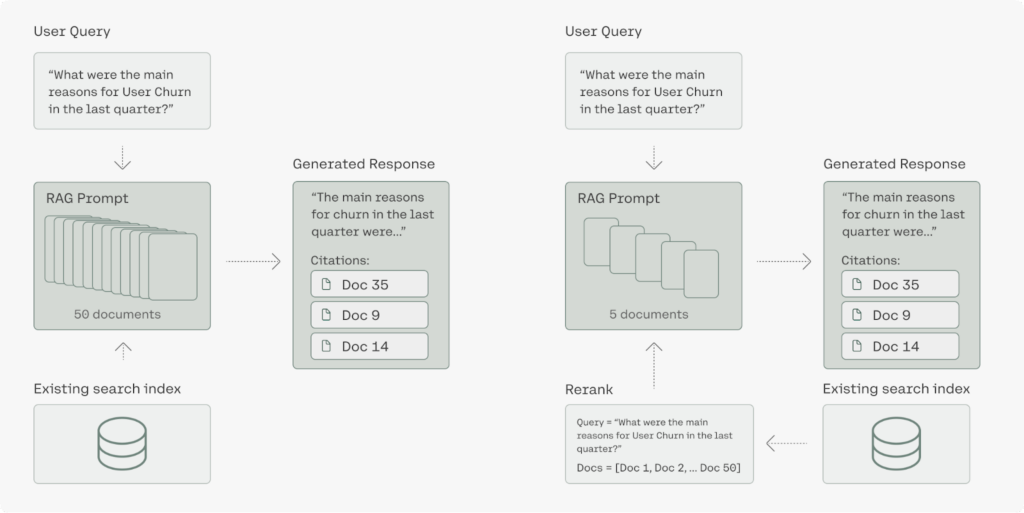

Generativa AI-modeller med långa sammanhang har potential att utföra en RAG. För att förbättra noggrannhetspoäng, latens och kostnad måste RAG-lösningen kräva en kombination av generation AI-modeller och naturligtvis Rerank modell. Den högprecisionssemantiska omrankningen av rerank3 säkerställer att endast relevant information matas till genereringsmodellen, vilket ökar svarsnoggrannheten och håller latensen och kostnaden mycket låg, särskilt när informationen hämtas från miljontals dokument.

Förbättrad företagssökning

Företagsdata är ofta mycket komplexa och de nuvarande systemen som placeras i organisationen stöter på svårigheter att söka igenom multiaspekt och semistrukturerade datakällor. För det mesta, i organisationen finns inte den mest användbara informationen i det enkla dokumentformatet som JSON är mycket vanligt i företagsapplikationer. Rerank 3 kan enkelt rangordna komplexa, multiaspekter som e-postmeddelanden baserat på alla relevanta metadatafält, inklusive deras aktualitet.

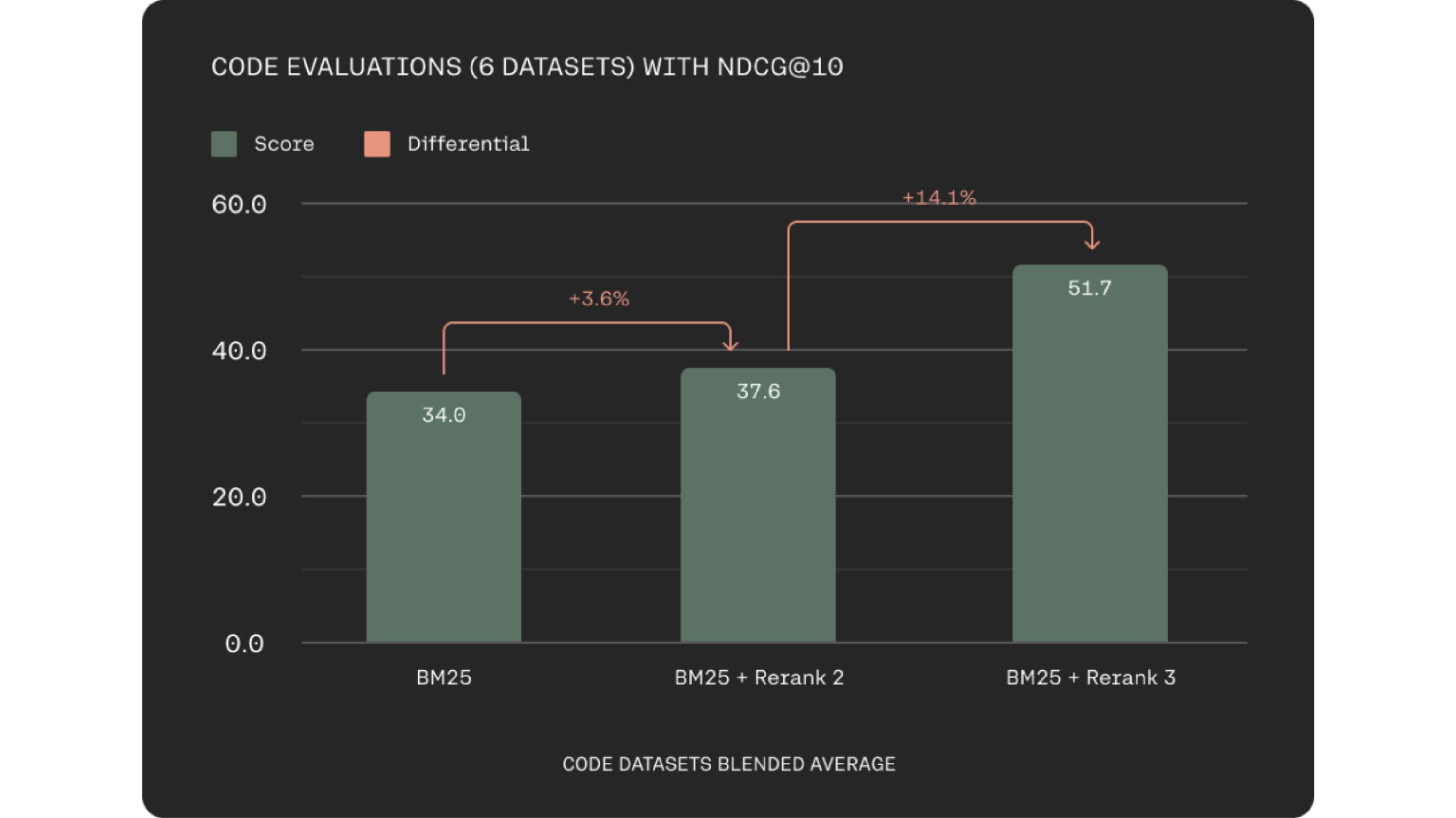

Rerank 3 förbättrar avsevärt hur väl den hämtar kod. Detta kan öka ingenjörernas produktivitet genom att hjälpa dem att hitta rätt kodavsnitt snabbare, oavsett om det är inom företagets kodbas eller över stora dokumentationsarkiv.

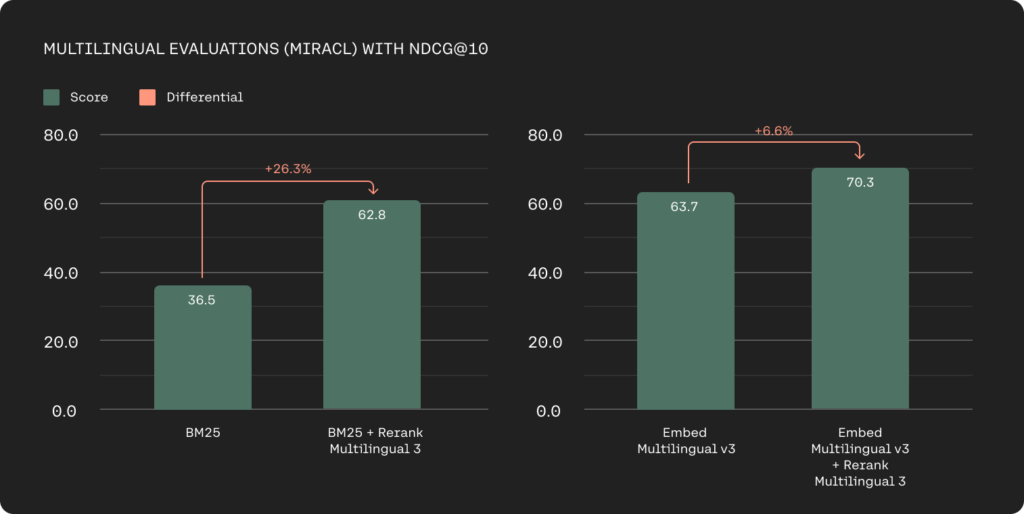

Tekniska jättar sysslar också med flerspråkiga datakällor och tidigare har flerspråkig hämtning varit den största utmaningen med sökordsbaserade metoder. Rerank 3-modellerna erbjuder en stark flerspråkig prestanda med över 100+ språk som förenklar hämtningsprocessen för icke-engelsktalande kunder.

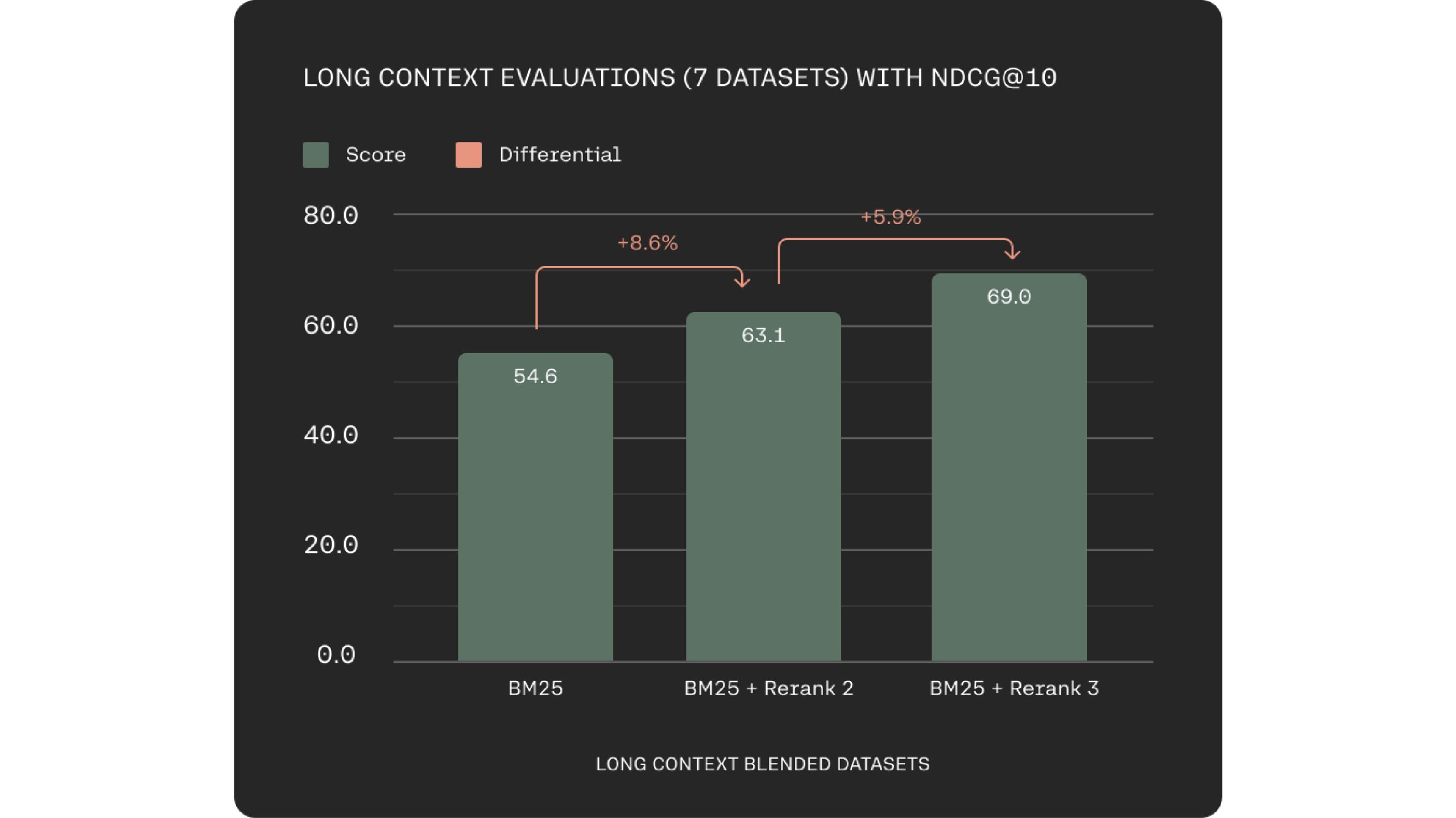

En viktig utmaning i semantiska sökningar och RAG-system är optimering av datachunking. Rerank 3 åtgärdar detta med ett 4k-kontextfönster, vilket möjliggör direkt bearbetning av större dokument. Detta leder till förbättrad kontextövervägande vid relevanspoäng.

Rerank 3 stöds också i Elastics Inference API. Elastic search har en allmänt använd sökteknologi och nyckelords- och vektorsökningsmöjligheterna i Elasticsearch-plattformen är byggda för att hantera större och mer komplex företagsdata effektivt.

"Vi är glada över att samarbeta med Cohere för att hjälpa företag att låsa upp potentialen i deras data", säger Matt Riley, GVP och GM på Elasticsearch. Coheres avancerade hämtningsmodeller som är Embed 3 och Rerank 3 erbjuder utmärkta prestanda på komplexa och stora företagsdata. De är din problemlösare, dessa blir viktiga komponenter i alla företagssöksystem.

Förbättrad latens med längre sammanhang

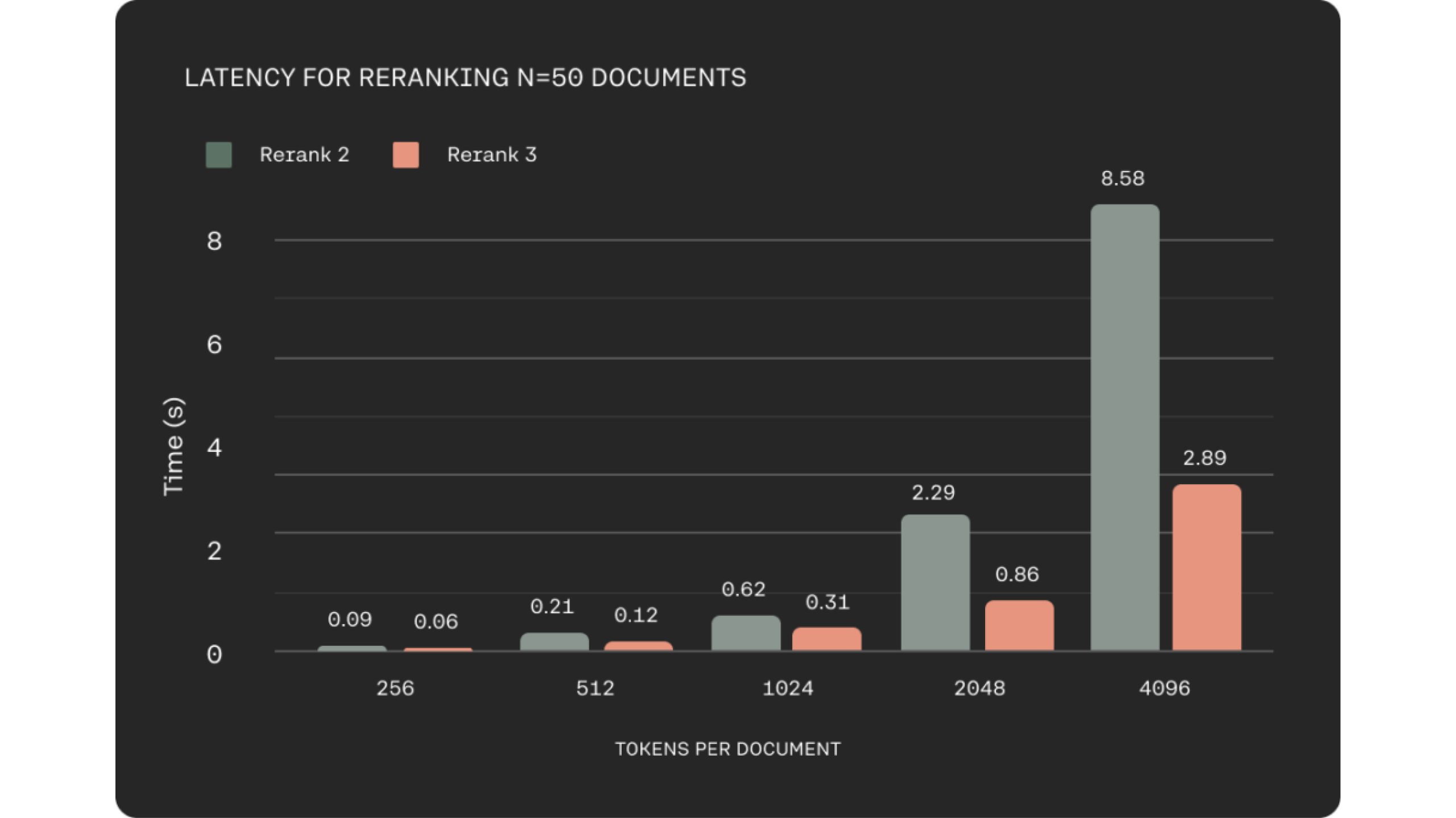

Inom många affärsdomäner som e-handel eller kundtjänst är låg latens avgörande för att leverera en kvalitetsupplevelse. De hade detta i åtanke när de byggde Rerank 3, som visar upp till 2x lägre latens jämfört med Rerank 2 för kortare dokumentlängder och upp till 3x förbättringar vid långa sammanhangslängder.

Bättre prestanda och effektiv RAG

I RAG-system (Retrieval-Augmented Generation) är dokumenthämtningen avgörande för den övergripande prestandan. Rerank 3 adresserar två viktiga faktorer för exceptionell RAG-prestanda: svarskvalitet och latens. Modellen utmärker sig när det gäller att peka ut de mest relevanta dokumenten till en användares fråga genom sina semantiska omrankningsmöjligheter.

Denna målinriktade hämtningsprocess förbättrar direkt noggrannheten i RAG-systemets svar. Genom att möjliggöra effektiv hämtning av relevant information från stora datamängder ger Rerank 3 stora företag möjlighet att låsa upp värdet av sin egen data. Detta underlättar olika affärsfunktioner, inklusive kundsupport, juridik, HR och ekonomi, genom att förse dem med den mest relevanta informationen för att hantera användarfrågor.

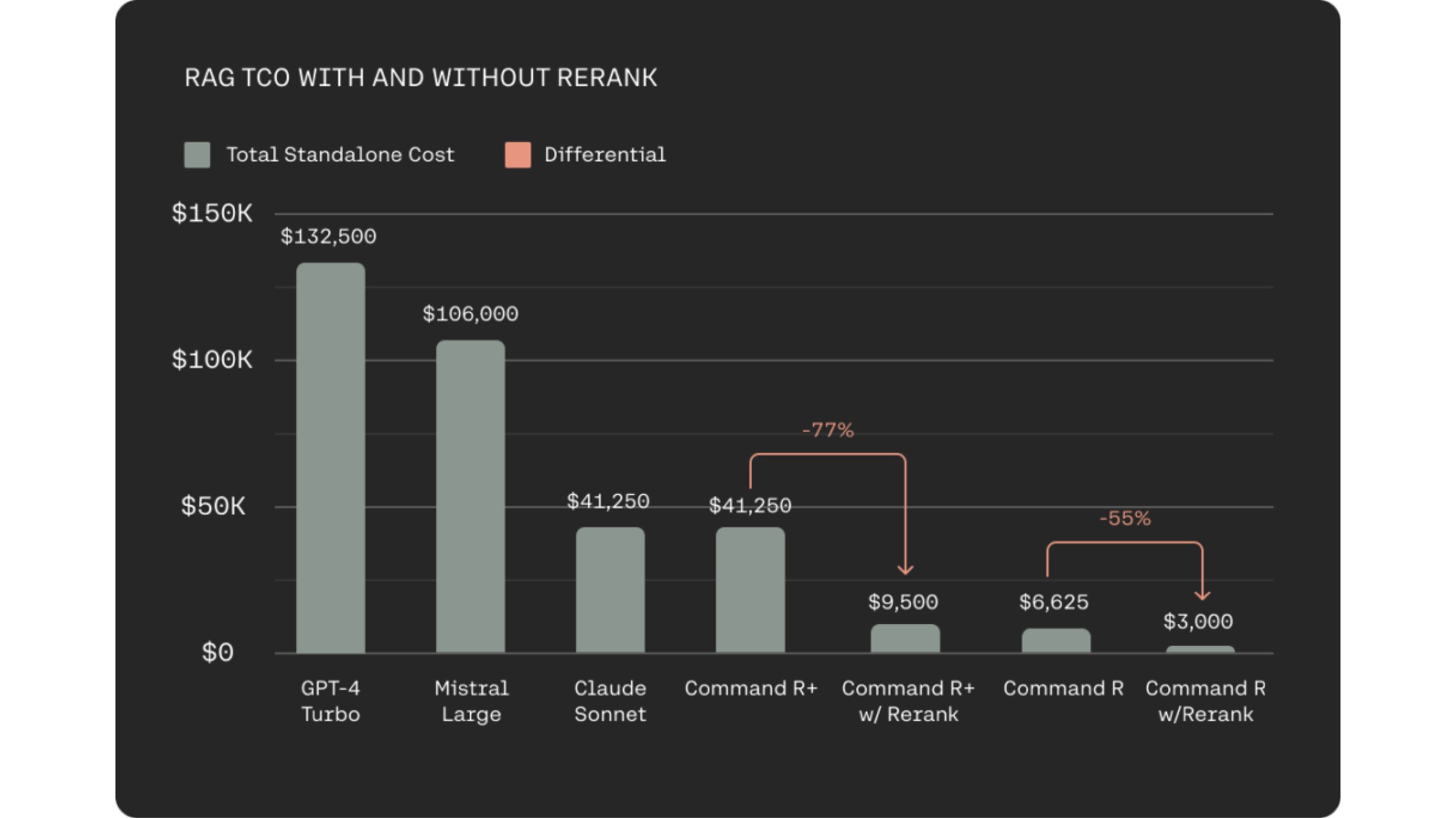

Att integrera Rerank 3 med den kostnadseffektiva Command R-familjen för RAG-system ger en betydande minskning av totala ägandekostnader (TCO) för användare. Detta uppnås genom två nyckelfaktorer. För det första underlättar Rerank 3 mycket relevant dokumentval, vilket kräver att LLM bearbetar färre dokument för att generera svar på grundval. Detta bibehåller svarsnoggrannheten samtidigt som latensen minimeras. För det andra leder den kombinerade effektiviteten hos modellerna Rerank 3 och Command R till kostnadsminskningar på 80-93 % jämfört med alternativa generativa LLM:er på marknaden. Faktum är att när man överväger kostnadsbesparingarna från både Rerank 3 och Command R, kan de totala kostnadsminskningarna överstiga 98 %.

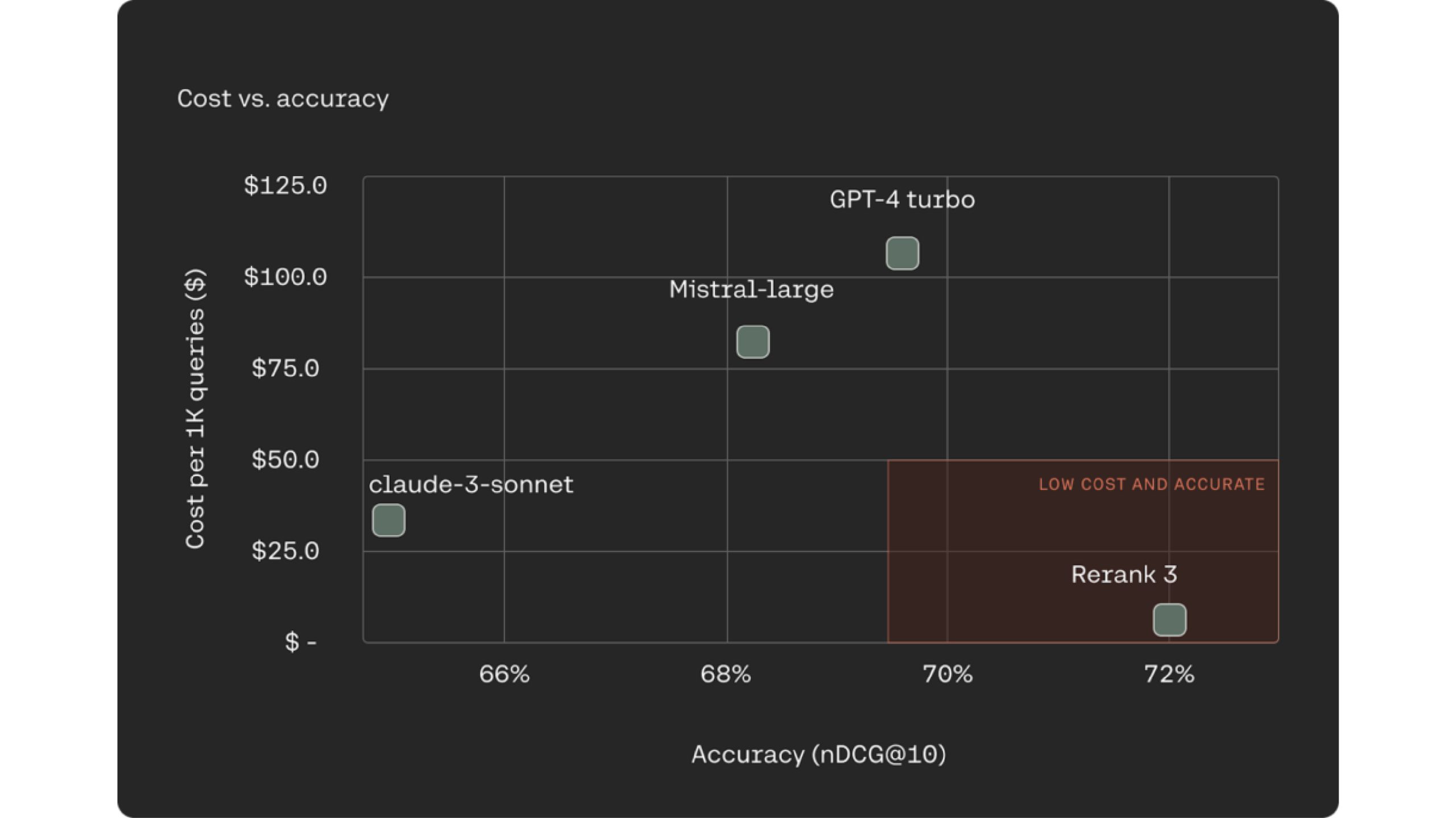

Ett allt vanligare och välkänt tillvägagångssätt för RAG-system är att använda LLM:er som rerankers för dokumenthämtningsprocessen. Rerank 3 överträffar branschledande LLM:er som Claude -3 Sonte, GPT Turbo när det gäller rankningsnoggrannhet samtidigt som de är 90–98 % billigare.

Omplacering 3 ökar noggrannheten och kvaliteten på LLM-svaret. Det hjälper också till att minska totala totalkostnaden. Rerank uppnår detta genom att rensa bort våra mindre relevanta dokument och bara sortera igenom den lilla delmängden av relevanta för att dra svar.

Slutsats

Rerank 3 är ett revolutionerande verktyg för företagssökning och RAG-system. Det möjliggör hög noggrannhet vid hantering av komplexa datastrukturer och flera språk. Rerank 3 minimerar datachunking, vilket minskar latens och total ägandekostnad. Detta resulterar i snabbare sökresultat och kostnadseffektiva RAG-implementeringar. Den integreras med Elasticsearch för förbättrat beslutsfattande och kundupplevelser.

Du kan utforska många fler sådana AI-verktyg och deras applikationer här..

- SEO-drivet innehåll och PR-distribution. Bli förstärkt idag.

- PlatoData.Network Vertical Generative Ai. Styrka dig själv. Tillgång här.

- PlatoAiStream. Web3 Intelligence. Kunskap förstärkt. Tillgång här.

- Platoesg. Kol, CleanTech, Energi, Miljö, Sol, Avfallshantering. Tillgång här.

- PlatoHealth. Biotech och kliniska prövningar Intelligence. Tillgång här.

- Källa: https://www.analyticsvidhya.com/blog/2024/04/rerank-3-boosting-enterprise-search-and-rag-systems/