Samtidigt som Meta introducerade Meta AI-uppdateringen till alla plattformar, publicerade Meta också Llama 3-riktmärket för teknikentusiaster.

Benchmarken erbjuder oberoende forskare och utvecklare en standardiserad testsvit för att utvärdera Llama 3:s prestanda för olika uppgifter.

Denna transparens gör det möjligt för användare att jämföra Llama 3:s styrkor och svagheter med andra LLM:er med samma riktmärke, vilket främjar en mer objektiv förståelse av dess kapacitet.

Vad visar Llama 3-riktmärket?

Meta AI etablerade Llama 3-riktmärket, en omfattande uppsättning utvärderingar utformade för att bedöma LLM-prestanda för olika uppgifter. Dessa uppgifter inkluderar att svara på frågor, sammanfatta, följa instruktioner och få inlärning. Riktmärket fungerar som ett avgörande verktyg för att mäta Llama 3:s styrkor och svagheter mot andra LLM:er.

Medan en direkt jämförelse mellan Llama 3-riktmärket och de som används för konkurrenter är utmanande på grund av olika utvärderingsmetoder, hävdar Meta att Llama 3-modeller som tränats på deras dataset uppnådde exceptionell prestanda för alla utvärderade uppgifter. Detta indikerar att Meta AI är i paritet med de bästa inom LLM-området.

Här är en djupare titt på hur Llama 3-riktmärken står sig:

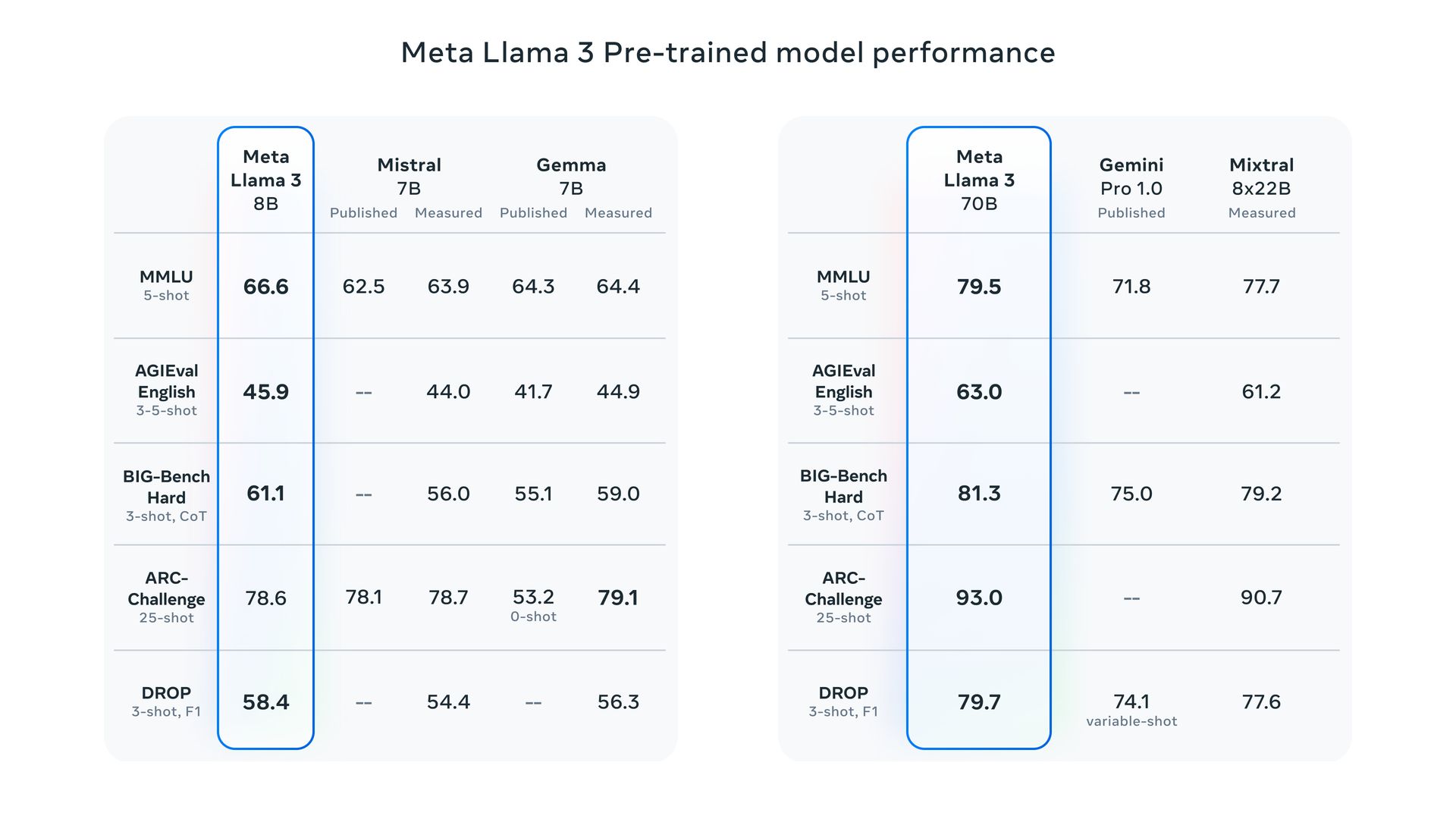

- Parameterskala: Meta skryter med att deras 8B och 70B parameter Llama 3-modeller överträffar Llama 2 och etablerar en ny toppmodern för LLMs av liknande skala.

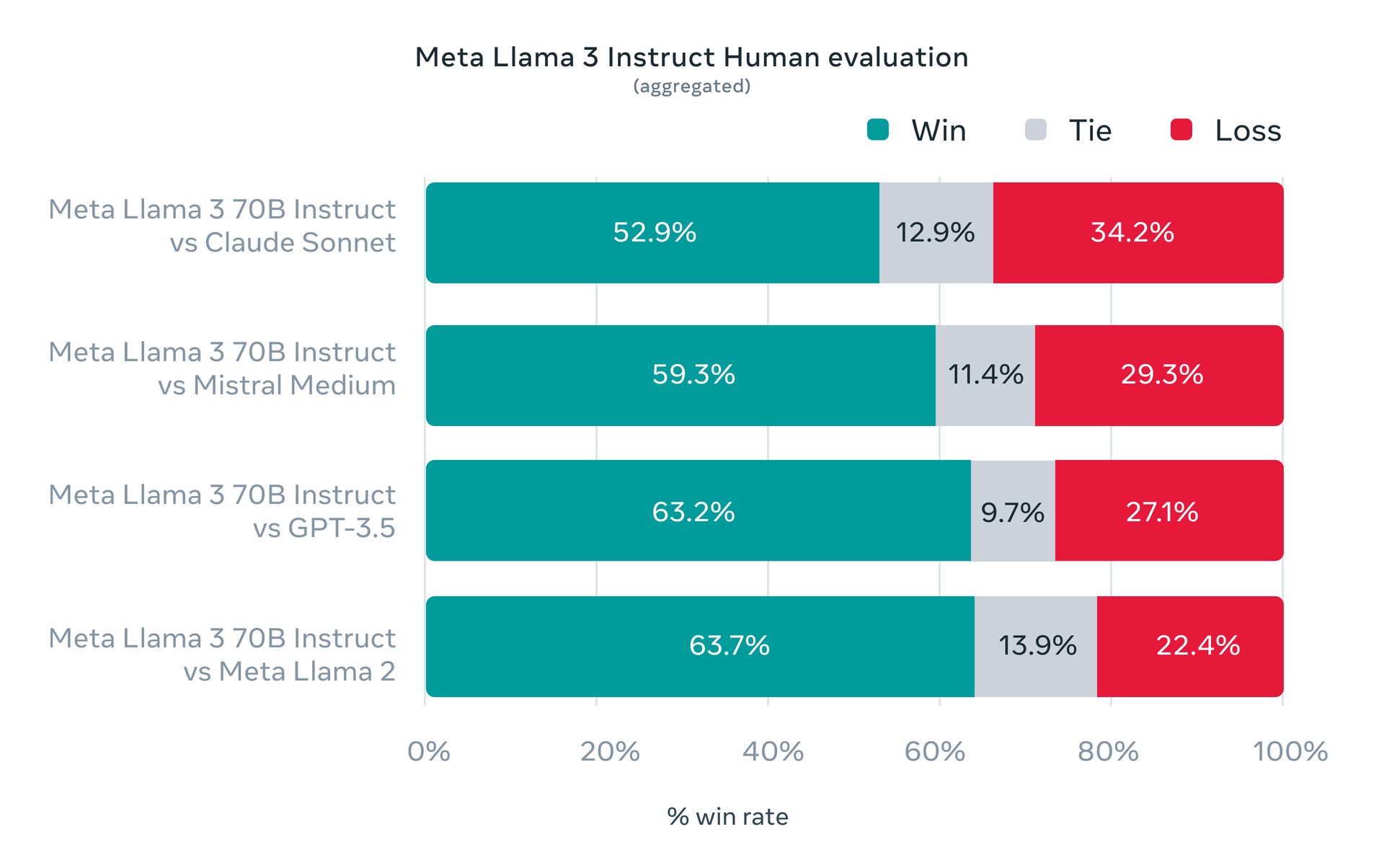

- Mänsklig utvärdering: Meta genomförde mänskliga utvärderingar på en omfattande datauppsättning som omfattar 12 viktiga användningsfall. Denna utvärdering positionerar den 70B-instruktionsföljande Llama 3-modellen gynnsamt mot konkurrenter av jämförbar storlek i verkliga scenarier.

Dessa är Metas egna utvärderingar och oberoende riktmärken kan vara nödvändiga för en mer definitiv jämförelse.

Öppen vikt vs öppen källkod

Det är avgörande att skilja mellan "öppna vikter" och "öppen källkod". Även om Llama 3 erbjuder gratis nedladdningsbara modeller och vikter, faller den inte under den strikta definitionen av öppen källkod på grund av begränsningar för åtkomst och träningsdata (till skillnad från programvara med öppen källkod).

Llama 3 finns i två storlekar: 8 miljarder (8B) och 70 miljarder (70B) parametrar. Båda är tillgänglig för gratis nedladdning på Metas hemsida efter en enkel registreringsprocess.

En teknisk djupdykning i Meta AI

Llama 3 erbjuder två versioner:

- Förtränad: Detta är den råa modellen fokuserad på nästa token-förutsägelse.

- Instruktionsjusterade: Denna version är finjusterad för att följa specifika användarinstruktioner.

Båda versionerna har en kontextgräns på 8,192 XNUMX tokens.

Träningsdetaljer

- Utbildningshårdvara: Meta använde två specialbyggda kluster, som var och en innehöll häpnadsväckande 24,000 3 GPU:er, för att träna Llama XNUMX.

- Utbildningsdata: Mark Zuckerberg, Metas VD, avslöjade i en podcastintervju att 70B-modellen tränades på en massiv datauppsättning på cirka 15 biljoner tokens. Intressant nog nådde modellen aldrig en mättnadspunkt (toppprestanda) under träning, vilket tyder på att det kan finnas utrymme för ytterligare förbättringar med ännu större datamängder.

- Framtidsplaner: Meta tränar för närvarande en kolossal 400B parameterversion av Llama 3, vilket potentiellt placerar den i samma prestationsliga som rivaler som t.ex. GPT-4 Turbo och Gemini Ultra på benchmarks som MMLU, GPQA, HumanEval och MATH.

Utmaningarna i Llama 3 benchmark

Vi måste erkänna begränsningarna hos nuvarande LLM-riktmärken på grund av faktorer som kontaminering av träningsdata och leverantörers val av resultat.

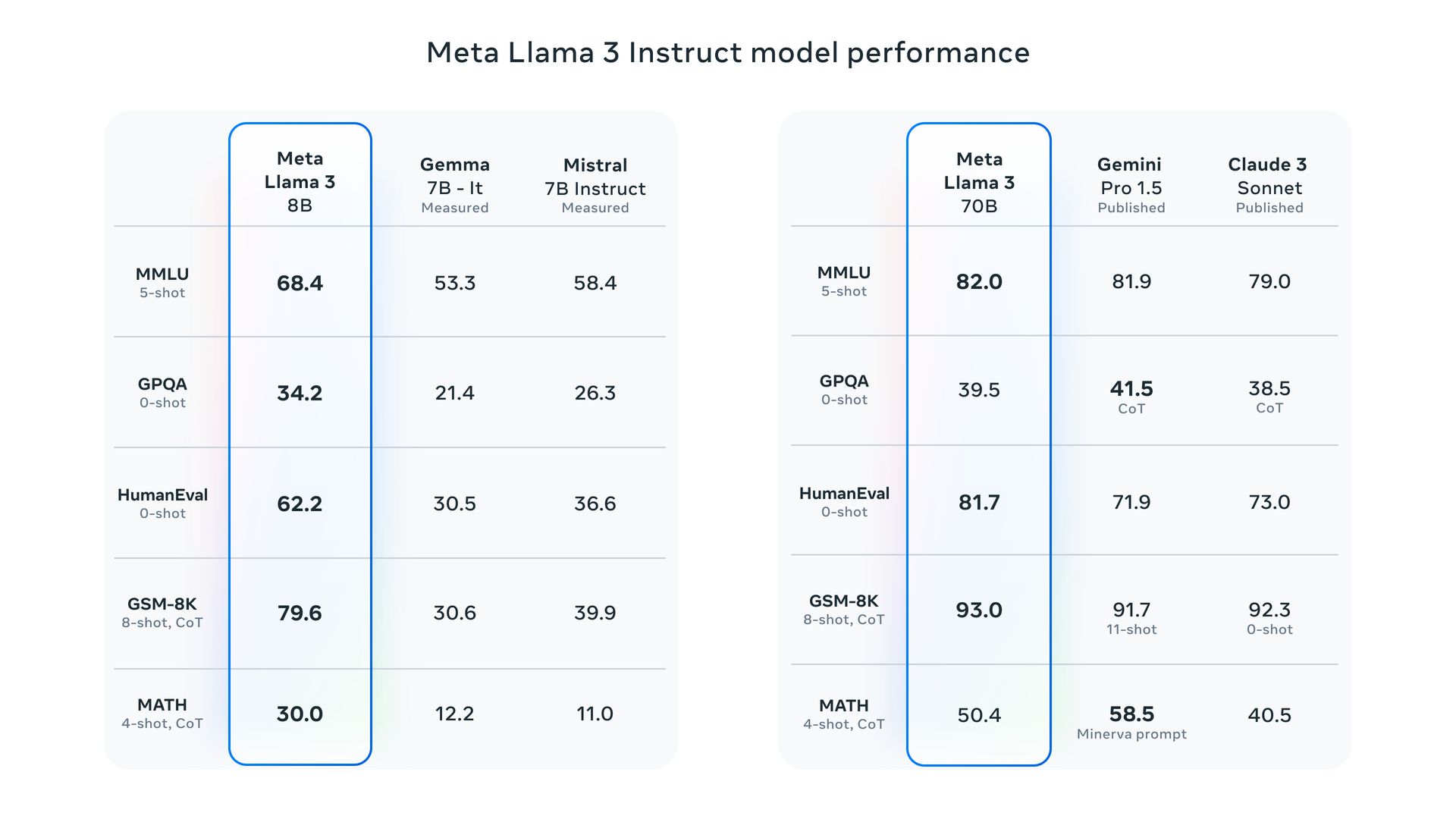

Trots dessa begränsningar tillhandahöll Meta några riktmärken som visade upp prestanda för Llama 3 för uppgifter som MMLU (allmän kunskap), GSM-8K (matte), HumanEval (kodning), GPQA (avancerade frågor) och MATH (ordproblem).

Dessa riktmärken positionerar 8B-modellen positivt mot konkurrenter med öppen vikt Googles Gemma 7B och Mistral 7B Instruera. 70B-modellen håller sig även mot etablerade namn som Gemini Pro 1.5 och Claude 3 sonett.

Tillgänglighet för Llama 3

Meta planerar att göra Llama 3-modeller tillgängliga på stora molnplattformar som AWS, Databricks, Google Cloud och andra, för att säkerställa bred tillgänglighet för utvecklare.

Llama 3 utgör grunden för Metas virtuella assistent, som kommer att vara framträdande finns med i sökfunktioner på Facebook, Instagram, WhatsApp, MessengerOch en särskild webbplats liknar ChatGPT:s gränssnitt (inklusive bildgenerering).

Dessutom används Meta har samarbetat med Google att integrera sökresultat i realtid i assistenten och bygga vidare på deras befintligt partnerskap med Microsofts Bing.

Utvald bildkredit: meta

- SEO-drivet innehåll och PR-distribution. Bli förstärkt idag.

- PlatoData.Network Vertical Generative Ai. Styrka dig själv. Tillgång här.

- PlatoAiStream. Web3 Intelligence. Kunskap förstärkt. Tillgång här.

- Platoesg. Kol, CleanTech, Energi, Miljö, Sol, Avfallshantering. Tillgång här.

- PlatoHealth. Biotech och kliniska prövningar Intelligence. Tillgång här.

- Källa: https://dataconomy.com/2024/04/19/llama-3-benchmark-meta-ai-vs-chatgpt-vs-gemini/