Se ÄNDRING för de senaste funktionerna och korrigeringarna.

Du har förmodligen upplevt utmaningen att ta anteckningar under ett möte samtidigt som du försöker uppmärksamma konversationen. Du har säkert också upplevt behovet av att snabbt faktakolla något som har sagts, eller leta upp information för att svara på en fråga som just har ställts i samtalet. Eller så kanske du har en gruppmedlem som alltid går sent på möten och förväntar sig att du skickar en snabb sammanfattning till dem över chatten för att fånga upp dem.

Sedan finns det tillfällen då andra pratar på ett språk som inte är ditt modersmål, och du skulle gärna vilja ha en liveöversättning av vad folk säger för att vara säker på att du förstår rätt.

Och efter att samtalet är över vill du vanligtvis fånga en sammanfattning för dina register, eller skicka till deltagarna, med en lista över alla åtgärder, ägare och förfallodatum.

Allt detta och mer är nu möjligt med vår senaste exempellösning, Live Meeting Assistant (LMA).

Kolla in följande demo för att se hur det fungerar.

I det här inlägget visar vi hur du använder LMA med Amazon Transcribe, Amazonas berggrundoch Kunskapsbaser för Amazon Bedrock.

Lösningsöversikt

LMA-exempellösningen fångar högtalarljud och metadata från din webbläsarbaserade mötesapp (när detta skrivs stöds Zoom och Chime), eller ljud endast från någon annan webbläsarbaserad mötesapp, datortelefon eller ljudkälla. Den använder Amazon Transcribe för tal till text, kunskapsbaser för Amazon Bedrock för kontextuella frågor mot ditt företags dokument och kunskapskällor, och Amazon Bedrock-modeller för anpassningsbara transkriptionsinsikter och sammanfattningar.

Allt du behöver tillhandahålls som öppen källkod i vår GitHub repo. Det är enkelt att distribuera i ditt AWS-konto. När du är klar kommer du att undra hur du någonsin klarat dig utan den!

Följande är några av de saker som LMA kan göra:

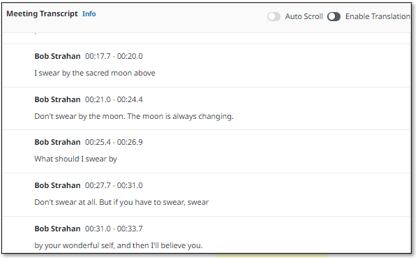

- Livetranskription med högtalartillskrivning – LMA drivs av Amazon Transcribe ASR-modeller för låg latens, hög precision tal till text. Du kan lära den varumärkesnamn och domänspecifik terminologi om det behövs, med hjälp av anpassade ordförråd och anpassade språkmodellfunktioner i Amazon Transcribe.

- Live översättning – Den använder Amazon Translate för att valfritt visa varje segment av konversationen översatt till ditt valfria språk, från ett urval av 75 språk.

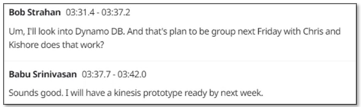

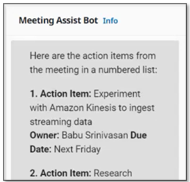

- Kontextmedveten mötesassistent – Den använder kunskapsbaser för Amazon Bedrock för att ge svar från dina pålitliga källor, genom att använda den levande transkriptionen som sammanhang för faktakontroll och uppföljningsfrågor. För att aktivera assistenten, säg bara "Okej, assistent", välj FRÅGA ASSISTENT! eller skriv in din egen fråga i användargränssnittet.

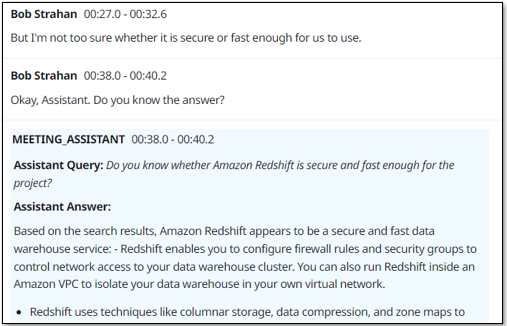

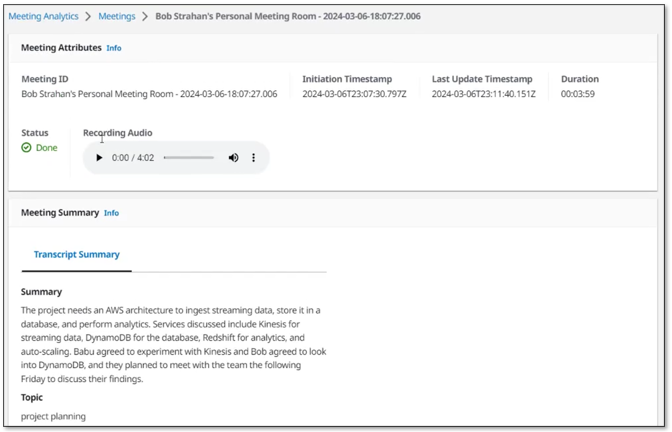

- Sammanfattningar av mötet på begäran – Med ett knapptryck i användargränssnittet kan du skapa en sammanfattning, vilket är användbart när någon ansluter sig sent och behöver komma ikapp. Sammanfattningarna är genererade från transkriptionen av Amazon Bedrock. LMA tillhandahåller också alternativ för att identifiera det aktuella mötesämnet och för att generera en lista över åtgärdspunkter med ägare och förfallodatum. Du kan också skapa dina egna anpassade uppmaningar och motsvarande alternativ.

- Automatiserad sammanfattning och insikter – När mötet har avslutats kör LMA automatiskt en uppsättning uppmaningar om stora språkmodeller (LLM) på Amazon Bedrock för att sammanfatta mötesutskriften och extrahera insikter. Du kan också anpassa dessa uppmaningar.

- Mötesinspelning – Ljudet lagras (valfritt) åt dig, så att du kan spela upp viktiga avsnitt på mötet senare.

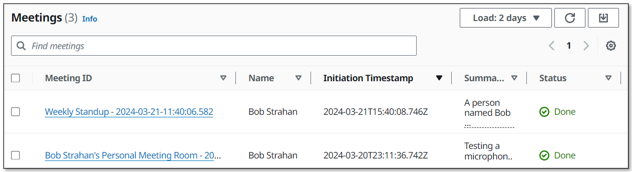

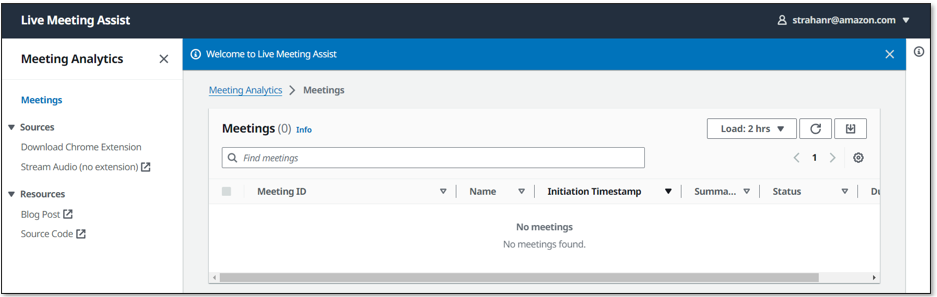

- Inventeringslista över möten – LMA håller reda på alla dina möten i en sökbar lista.

- Webbläsartillägget fångar ljud och mötesmetadata från populära mötesappar – Webbläsartillägget fångar mötesmetadata – mötestiteln och namnen på aktiva talare – och ljud från dig (din mikrofon) och andra (från möteswebbläsarfliken). När detta skrivs stöder LMA Chrome för webbläsartillägget och Zoom och Chime för mötesappar (med Teams och WebEx kommer snart). Fristående mötesappar fungerar inte med LMA – starta i stället dina möten i webbläsaren.

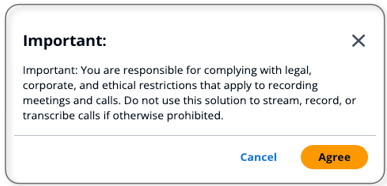

Du ansvarar för att följa juridiska, företags- och etiska restriktioner som gäller för inspelning av möten och samtal. Använd inte den här lösningen för att streama, spela in eller transkribera samtal om det annars är förbjudet.

Förutsättningar

Du måste ha ett AWS-konto och ett AWS identitets- och åtkomsthantering (IAM) roll och användare med behörighet att skapa och hantera nödvändiga resurser och komponenter för denna applikation. Om du inte har ett AWS-konto, se Hur skapar och aktiverar jag ett nytt Amazon Web Services-konto?

Du behöver också en befintlig kunskapsbas i Amazon Bedrock. Om du inte har skapat en ännu, se Skapa en kunskapsbas. Fyll din kunskapsbas med innehåll för att driva LMA:s sammanhangsmedvetna mötesassistent.

Slutligen använder LMA Amazon Bedrock LLMs för sina sammanfattningsfunktioner för möten. Innan du fortsätter, om du inte har gjort det tidigare, måste du begära tillgång till följande Amazon Bedrock-modeller:

- Titan Embeddings G1 – Text

- Antropisk: Alla Claude-modeller

Distribuera lösningen med AWS CloudFormation

Vi har tillhandahållit förbyggda AWS molnformation mallar som distribuerar allt du behöver i ditt AWS-konto.

Om du är en utvecklare och vill bygga, distribuera eller publicera lösningen från kod, se Utvecklare README.

Slutför följande steg för att starta CloudFormation-stacken:

- Logga in på AWS Management Console.

- Välja Starta stack för din önskade AWS-region för att öppna AWS CloudFormation-konsolen och skapa en ny stack.

| Region | Starta stack |

|---|---|

| USA-öst (N. Virginia) | |

| USA Väst (Oregon) |

- För Stapla namn, använd standardvärdet, LMA.

- För Admin e-postadress, använd en giltig e-postadress – ditt tillfälliga lösenord skickas till den här adressen under distributionen.

- För Auktoriserat konto e-postdomän, använd domännamnsdelen av din företags e-postadress för att tillåta användare med e-postadresser i samma domän att skapa sina egna nya UI-konton, eller lämna tomt för att förhindra användare från att direkt skapa sina egna konton. Du kan ange flera domäner som en kommaseparerad lista.

- För MeetingAssistServiceväljer

BEDROCK_KNOWLEDGE_BASE(det enda tillgängliga alternativet när detta skrivs). - För Meeting Assist Berggrund kunskapsbas-id (befintlig), ange ditt befintliga kunskapsbas-ID (t.ex.

JSXXXXX3D8). Du kan kopiera den från Amazon Bedrock-konsolen.

- För alla andra parametrar, använd standardvärdena.

Om du vill anpassa inställningarna senare, till exempel för att lägga till egna AWS Lambda funktioner, använda anpassade vokabulärer och språkmodeller för att förbättra noggrannheten, möjliggöra redigering av personlig identifierbar information (PII) och mer, kan du uppdatera stacken för dessa parametrar.

- Markera kryssrutorna för bekräftelse och välj sedan Skapa stack.

Den huvudsakliga CloudFormation-stacken använder kapslade stackar för att skapa följande resurser i ditt AWS-konto:

- Amazon enkel lagringstjänst (Amazon S3) hinkar för att hålla byggartefakter och samtalsinspelningar

- An AWS Fargate uppgift med en Application Load Balancer tillhandahålla en WebSocket-serverkörningskod för att konsumera stereoljudströmmar och vidarebefordra till Amazon Transcribe, publicera transkriptionssegment i Amazon Kinesis dataströmmaroch skapa och lagra stereosamtalsinspelningar

- En Kinesis-dataström för att vidarebefordra samtalshändelser och transkriptionssegment till anrikningsbearbetningsfunktionen

- LMA-resurser, inklusive QnABot på AWS-lösning stack, som interagerar med Amazon OpenSearch Service och Amazonas berggrund

- Smakämnen AWS AppSync API, som tillhandahåller en GraphQL-slutpunkt för att stödja frågor och realtidsuppdateringar

- Webbplatskomponenter, inklusive en S3-hink, Amazon CloudFront distribution och Amazon Cognito användarpool

- En nedladdningsbar förkonfigurerad webbläsartilläggsapplikation för Chrome-webbläsare

- Andra stödjande resurser, inklusive IAM-roller och policyer (med bästa praxis för minst privilegier), Amazon Virtual Private Cloud (Amazon VPC) resurser, Amazon EventBridge evenemangsregler och amazoncloudwatch logga grupper.

Stackarna tar cirka 35–40 minuter att distribuera. Huvudstackens status visas CREATE_COMPLETE när allt är utplacerat.

Ange ditt lösenord

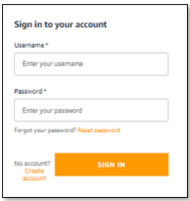

När du har distribuerat stacken öppnar du LMAs webbanvändargränssnitt och ställer in ditt lösenord genom att utföra följande steg:

- Öppna e-postmeddelandet du fick, på den e-postadress du angav, med ämnet "Välkommen till Live Meeting Assistant!"

- Öppna din webbläsare till webbadressen som visas i e-postmeddelandet. Du dirigeras till inloggningssidan.

- E-postmeddelandet innehåller ett genererat tillfälligt lösenord som du använder för att logga in och skapa ditt eget lösenord. Ditt användarnamn är din e-postadress.

- Ställ in ett nytt lösenord.

Ditt nya lösenord måste ha en längd på minst åtta tecken och innehålla versaler och gemener, plus siffror och specialtecken.

- Följ anvisningarna för att verifiera din e-postadress, eller välj Hoppa att göra det senare.

Du är nu inloggad på LMA.

Du fick också ett liknande e-postmeddelande med ämnet "QnABot Signup Verification Code." Detta e-postmeddelande innehåller ett genererat tillfälligt lösenord som du använder för att logga in och skapa ditt eget lösenord i QnABot-designern. Du använder endast QnABot designer om du vill anpassa LMA-alternativ och uppmaningar. Ditt användarnamn för QnABot är Admin. Du kan ställa in ditt permanenta QnABot-administratörslösenord nu, eller förvara det här e-postmeddelandet säkert om du vill anpassa saker senare.

Ladda ner och installera webbläsartillägget Chrome

För den bästa strömningsupplevelsen för möten, installera LMA-webbläsarplugin (för närvarande tillgänglig för Chrome):

- Välja Ladda ner Chrome Extension för att ladda ner webbläsartillägget .zip-fil (

lma-chrome-extension.zip).

- Välj (högerklicka) och expandera .zip-filen (

lma-chrome-extension.zip) för att skapa en lokal mapp med namnetlma-chrome-extension. - Öppna Chrome och ange länken

chrome://extensionsi adressfältet.

- aktivera utvecklarläge.

- Välja Last uppackad, navigera till

lma-chrome-extensionmapp (som du packade upp från nedladdningen) och välj Välja. Detta laddar ditt tillägg. - Fäst det nya LMA-tillägget i webbläsarens verktygsfält för enkel åtkomst – du kommer att använda det ofta för att streama dina möten!

Börja använda LMA

LMA erbjuder två streamingalternativ:

- Chrome -webbläsartillägg – Använd detta för att strömma ljud och högtalarmetadata från din möteswebbläsarapp. Det fungerar för närvarande med Zoom och Chime, men vi hoppas kunna lägga till fler mötesappar.

- Fliken LMA Stream Audio – Använd detta för att strömma ljud från din mikrofon och valfri webbläsarbaserad mötesapp, mjuktelefon eller ljudapplikation i Chrome.

Vi visar dig hur du använder båda alternativen i följande avsnitt.

Använd Chrome-webbläsartillägget för att streama ett Zoom-samtal

Utför följande steg för att använda webbläsartillägget:

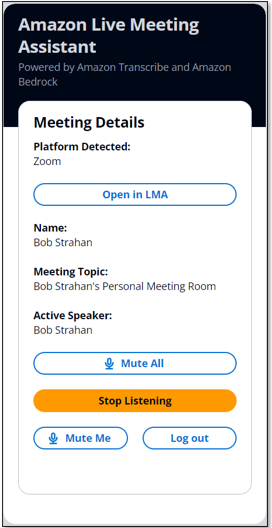

- Öppna LMA-tillägget och logga in med dina LMA-uppgifter.

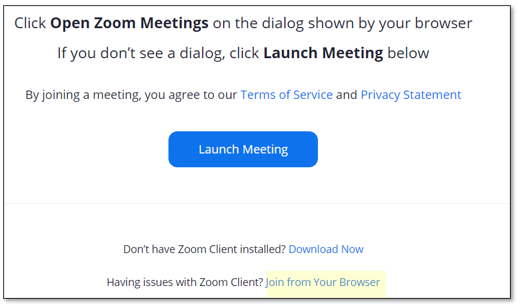

- Gå med i eller starta ett Zoom-möte i din webbläsare (använd inte den separata Zoom-klienten).

Om du redan har laddat Zoom-mötessidan laddar du om den.

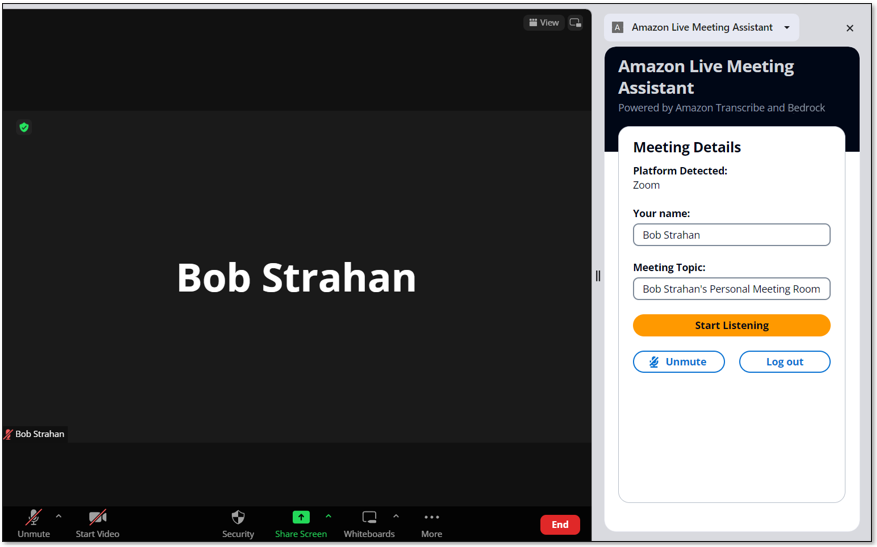

LMA-tillägget upptäcker automatiskt att Zoom körs på webbläsarfliken och fyller i ditt namn och mötesnamnet.

- Berätta för andra i samtalet att du ska börja spela in samtalet med LMA och få deras tillstånd. Fortsätt inte om deltagarna motsätter sig.

- Välja Börja lyssna.

- Läs och acceptera ansvarsfriskrivningen och välj Tillåt för att dela webbläsarfliken.

LMA-anknytningen känner automatiskt av och visar den aktiva högtalaren på samtalet. Om du är ensam i mötet, bjud in några vänner att gå med och observera att namnen de använde för att gå med i samtalet visas i anknytningen när de talar och tillskrivs deras ord i LMA-utskriften.

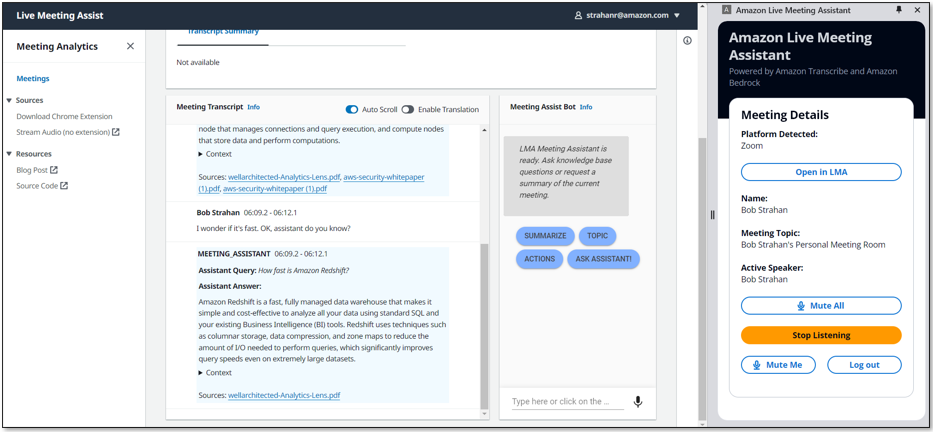

- Välja Öppet i LMA för att se din liveavskrift på en ny flik.

- Välj ditt föredragna transkriptionsspråk och interagera med mötesassistenten med hjälp av väckningsfrasen "OK Assistant!" eller den Meeting Assist Bot rutan.

Smakämnen FRÅGA ASSISTENT knappen ber mötesassistenttjänsten (Amazon Bedrock kunskapsbas) att föreslå ett bra svar baserat på utskriften av de senaste interaktionerna i mötet. Din körsträcka kan variera, så experimentera!

- När du är klar, välj Sluta strömma för att avsluta mötet i LMA.

Inom några sekunder visas de automatiska sammanfattningarna av mötesslut och ljudinspelningen blir tillgänglig. Du kan fortsätta att använda boten efter att samtalet har avslutats.

Använd fliken LMA UI Stream Audio för att streama från din mikrofon och valfri webbläsarbaserad ljudapplikation

Webbläsartillägget är det bekvämaste sättet att strömma metadata och ljud från möteswebbappar som stöds. Men du kan också använda LMA för att strömma bara ljudet från valfri webbläsarbaserad datortelefon, mötesapp eller annan ljudkälla som spelas upp i din Chrome-webbläsare, med hjälp av den praktiska Streama ljud fliken som är inbyggd i LMA UI.

- Öppna valfri ljudkälla i en webbläsarflik.

Detta kan till exempel vara en datortelefon (som Google Voice), en annan mötesapp, eller för demoändamål kan du helt enkelt spela upp en lokal ljudinspelning eller en YouTube-video i din webbläsare för att efterlikna en annan mötesdeltagare. Om du bara vill prova, öppna följande YouTube-video i en ny flik.

- Välj i LMA App UI Streama ljud (ingen förlängning) för att öppna fliken Stream Audio.

- För Mötes-ID, ange ett mötes-ID.

- För Namn , ange ett namn för dig själv (tillämpas på ljud från din mikrofon).

- För Deltagarnamn, ange namnen på deltagarna (tillämpas på den inkommande ljudkällan).

- Välja Börja strömma.

- Välj webbläsarfliken du öppnade tidigare och välj Tillåt att dela.

- Välj fliken LMA UI igen för att se ditt nya mötes-ID listat, vilket visar mötet som Pågår.

- Välj mötes-ID för att öppna informationssidan och titta på transkriptionen av det inkommande ljudet, tillskrivet deltagarnamnen som du angav. Om du talar kommer du att se transkriptionen av din egen röst.

Använd Streama ljud funktion för att strömma från valfri datortelefonapp, mötesapp eller något annat strömmande ljud som spelas upp i webbläsaren, tillsammans med ditt eget ljud från din valda mikrofon. Skaffa alltid tillstånd från andra innan du spelar in dem med LMA eller någon annan inspelningsapplikation.

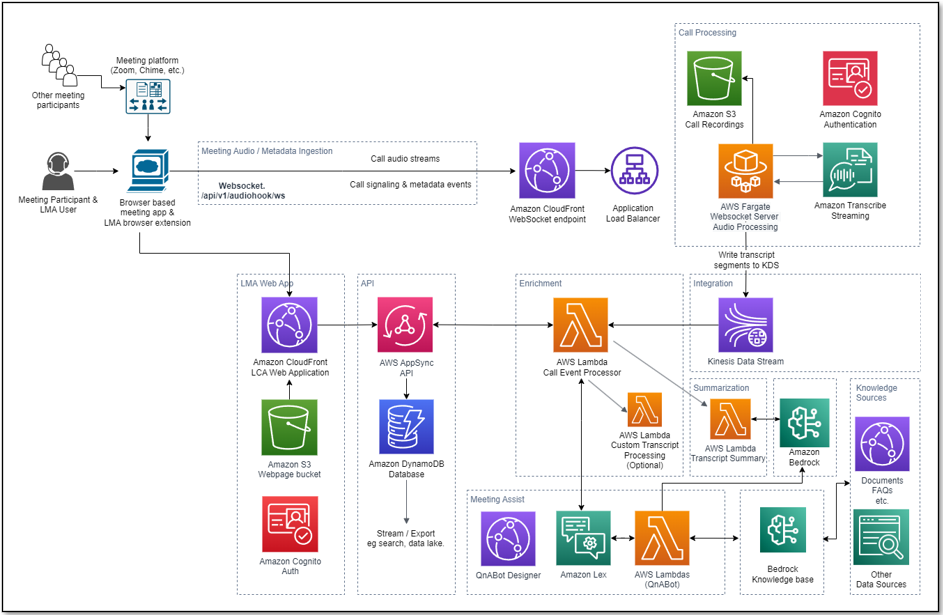

Bearbetningsflödesöversikt

Hur transkriberade och analyserade LMA ditt möte? Låt oss titta på hur det fungerar. Följande diagram visar de viktigaste arkitektoniska komponenterna och hur de passar ihop på hög nivå.

LMA-användaren går med i ett möte i sin webbläsare, aktiverar LMA-webbläsartillägget och autentiserar med sina LMA-uppgifter. Om mötesappen (till exempel Zoom.us) stöds av LMA-tillägget, identifieras användarens namn, mötesnamn och aktiva talare automatiskt av tillägget. Om mötesappen inte stöds av tillägget kan LMA-användaren manuellt ange sitt namn och mötesämnet – aktiva talares namn kommer inte att upptäckas.

Efter att ha fått tillstånd från andra deltagare väljer LMA-användaren Börja lyssna på LMA-tilläggsrutan. En säker WebSocket-anslutning upprättas till den förkonfigurerade LMA-stacken WebSocket URL, och användarens autentiseringstoken valideras. LMA-webbläsartillägget skickar ett START-meddelande till WebSocket som innehåller mötesmetadata (namn, ämne och så vidare), och börjar strömma tvåkanaligt ljud från användarens mikrofon och den inkommande ljudkanalen som innehåller rösterna från de andra mötesdeltagarna. Tillägget övervakar mötesappen för att upptäcka aktiva högtalarförändringar under samtalet och skickar den metadatan till WebSocket, vilket gör att LMA kan märka talsegment med talarens namn.

WebSocket-servern som körs i Fargate förbrukar tvåkanalsljudfragmenten i realtid från den inkommande WebSocket-strömmen. Ljudet strömmas till Amazon Transcribe, och transkriptionsresultaten skrivs i realtid till Kinesis Data Streams.

Varje mötesbearbetningssession körs tills användaren väljer Sluta lyssna i LMA-tilläggsfönstret, eller avslutar mötet och stänger fliken. I slutet av samtalet skapar funktionen en stereoinspelningsfil i Amazon S3 (om inspelning var aktiverad när stacken distribuerades).

En lambdafunktion kallad Call Event Processor, matad av Kinesis Data Streams, bearbetar och berikar valfritt mötesmetadata och transkriptionssegment. Call Event Processorn integreras med mötesassistanstjänsterna. LMA drivs av Amazon Lex, Kunskapsbaser för Amazon Bedrock och Amazon Bedrock LLM som använder öppen källkod QnABot på AWS-lösning för svar baserade på vanliga frågor och som en orkestrator för förfrågningsdirigering till lämplig AI-tjänst. Anropshändelseprocessorn anropar också transcript summarization Lambda-funktionen när samtalet avslutas, för att generera en sammanfattning av samtalet från hela transkriptionen.

Call Event Processor-funktionen samverkar med AWS AppSync för att bevara ändringar (mutationer) i Amazon DynamoDB och skicka realtidsuppdateringar till LMA-användarens inloggade webbklienter (öppnas bekvämt genom att välja alternativet Öppna i LMA i webbläsartillägget).

LMA webbgränssnittstillgångar finns på Amazon S3 och serveras via CloudFront. Autentisering tillhandahålls av Amazon Cognito.

När användaren är autentiserad upprättar webbapplikationen en säker GraphQL-anslutning till AWS AppSync API och prenumererar på att ta emot händelser i realtid som nya samtal och ändringar av samtalsstatus för möteslistans sida och nya eller uppdaterade transkriptionssegment och beräknade analys för mötesinformationssidan. När översättning är aktiverad interagerar webbapplikationen också säkert med Amazon Translate för att översätta mötestranskriptionen till det valda språket.

Hela bearbetningsflödet, från intaget tal till live-webbsideuppdateringar, är händelsestyrt och fördröjningen från slut till ände är kort - vanligtvis bara några sekunder.

Övervakning och felsökning

AWS CloudFormation rapporterar distributionsfel och orsaker på den relevanta stacken Händelser flik. Ser Felsökning av CloudFormation för hjälp med vanliga implementeringsproblem. Håll utkik efter implementeringsfel orsakade av gränsöverskridande fel; LMA-stackarna skapar resurser som är föremål för standardkonto- och regiontjänstkvoter, såsom elastiska IP-adresser och NAT-gateways. När du felsöker CloudFormation-stackfel, navigera alltid in i alla misslyckade kapslade staplar för att hitta det första rapporterade kapslade resursfelet – detta är nästan alltid grundorsaken.

Amazon Transcribe har en standardgräns på 25 samtidiga transkriptionsströmmar, vilket begränsar LMA till 25 samtidiga möten i ett givet AWS-konto eller område. Begär en ökning av antalet samtidiga HTTP/2-strömmar för streamingtranskription om du har många användare och behöver hantera ett större antal samtidiga möten på ditt konto.

LMA tillhandahåller körtidsövervakning och loggar för varje komponent som använder CloudWatch:

- WebSocket bearbetar och transkriberar Fargate-uppgift - På Amazon Elastic Container Service (Amazon ECS)-konsolen, navigera till kluster sida och öppna LMA-

WEBSOCKETSTACK-xxxx-TranscribingClusterfungera. Välj den Uppgifter fliken och öppna uppgiftssidan. Välja Loggar och Visa i CloudWatch för att inspektera WebSocket-transkriberarens uppgiftsloggar. - Ring Event Processor Lambda-funktion – Öppna lambdakonsolen

LMA-AISTACK-CallEventProcessorfungera. Välj den Övervaka fliken för att se funktionsstatistik. Välja Visa loggar i CloudWatch för att inspektera funktionsloggar. - AWS AppSync API – Öppna AWS AppSync-konsolen

CallAnalytics-LMAAPI. Välja Övervakning i navigeringsfönstret för att se API-statistik. Välja Visa loggar i CloudWatch för att inspektera AWS AppSync API-loggar.

För QnABot på AWS för Meeting Assist, se Meeting Assist README, Och den Implementeringsguide för QnABot lösning för ytterligare information.

Kostnadsbedömning

LMA tillhandahåller en WebSocket-server som använder Fargate (2vCPU) och VPC-nätverksresurser som kostar cirka 0.10 USD/timme (ungefär 72 USD/månad). För mer information, se AWS Fargate prissättning.

LMA är aktiverat med QnABot och Knowledge Bases för Amazon Bedrock. Du skapar din egen kunskapsbas, som du använder för LMA och eventuellt andra användningsfall. För mer information, se Prissättning för Amazons berggrund. Ytterligare AWS-tjänster som används av QnABot-lösningen kostar cirka 0.77 USD/timme. För mer information, se listan över QnABot på AWS-lösningskostnader.

De återstående lösningskostnaderna baseras på användning.

Användningskostnaderna uppgår till cirka 0.17 USD för ett 5-minuterssamtal, även om detta kan variera beroende på valda alternativ (som översättning), antal LLM-sammanfattningar och total användning eftersom användningen påverkar kvalificeringen för Free Tier och volymnivåprissättning för många tjänster . För mer information om de tjänster som medför användningskostnader, se följande:

För att utforska LMA-kostnaderna själv, använd AWS Cost Explorer eller välj Fakturadetaljer på AWS Billing Dashboard för att se dina utgifter per månad hittills per tjänst.

Anpassa din distribution

Använd följande CloudFormation-mallparametrar när du skapar eller uppdaterar din stack för att anpassa din LCA-distribution:

- För att använda din egen S3-hink för mötesinspelningar, använd Call Audio Recordings Bucket Name och Ljudfilsprefix.

- För att redigera PII från transkriptionerna, ställ in Aktivera innehållsredigering för transkriptioner till sant, och justera Entitetstyper för transkription PII-redaktion efter behov. För mer information, se Redigera eller identifiera PII i en realtidsström.

- För att förbättra transkriptionsnoggrannheten för tekniska och domänspecifika akronymer och jargong, ställ in Transkription anpassat ordförrådsnamn till namnet på ett anpassat ordförråd som du redan skapat i Amazon Transcribe eller set Namn på modell för transkription anpassat språk till namnet på en tidigare skapad anpassad språkmodell. För mer information, se Förbättra transkriptionsnoggrannheten.

- För att transkribera möten på ett annat språk än amerikansk engelska, välj önskat värde för Språk för transkription.

- För att anpassa transkriptionsbearbetning, valfritt ställ in Lambdakrok-funktion ARN för bearbetning av anpassad transkriptionssegment till ARN för din egen lambdafunktion. För mer information, se Använda en Lambda-funktion för att valfritt tillhandahålla anpassad logik för transkriptbehandling.

- För att anpassa mötesassistansfunktionerna baserade på QnABot på AWS-lösningen, Amazon Lex, Amazon Bedrock och kunskapsbaser för Amazon Bedrock-integration, se Meeting Assist README.

- För att anpassa transkriptionssammanfattningen genom att konfigurera LMA för att anropa din egen Lambda-funktion, se Transcript Summarization LAMBDA-alternativ.

- För att anpassa transkriptionssammanfattningen genom att ändra standarduppmaningarna eller lägga till nya, se Sammanfattning av avskrift.

- För att ändra lagringsperioden, ställ in Record utgången i dagar till önskat värde. All samtalsdata raderas permanent från LMA DynamoDB-lagringen efter denna period. Ändringar av den här inställningen gäller endast för nya samtal som tas emot efter uppdateringen.

LMA är ett projekt med öppen källkod. Du kan dela LMA GitHub-förrådet, förbättra koden och skicka pull-förfrågningar till oss så att vi kan införliva och dela dina förbättringar!

Uppdatera en befintlig LMA-stack

Du kan uppdatera din befintliga LMA-stack till den senaste utgåvan. För mer information, se Uppdatera en befintlig stack.

Städa upp

Grattis! Du har slutfört alla steg för att ställa in din exempellösning för livesamtalsanalys med hjälp av AWS-tjänster.

När du är klar med att experimentera med denna exempellösning, rensa upp dina resurser genom att använda AWS CloudFormation-konsolen för att ta bort LMA-stackarna som du distribuerade. Detta tar bort resurser som skapades genom att implementera lösningen. Logggrupperna för S3-inspelning, DynamoDB-tabellen och CloudWatch-logggrupperna behålls efter att stacken har tagits bort för att undvika att din data raderas.

Live Call Analytics: Kompletterande lösning

Vår medföljande lösning, Live Call Analytics och Agent Assist (LCA), erbjuder transkription och analys i realtid för kontaktcenter (telefonsamtal) snarare än möten. Det finns många likheter – i själva verket byggdes LMA med en arkitektur och många komponenter härledda från LCA.

Slutsats

Exempellösningen Live Meeting Assistant erbjuder ett flexibelt, funktionsrikt och anpassningsbart tillvägagångssätt för att tillhandahålla direktmöteshjälp för att förbättra din produktivitet under och efter möten. Den använder Amazon AI/ML-tjänster som Amazon Transcribe, Amazon Lex, Knowledge Bases for Amazon Bedrock och Amazon Bedrock LLMs för att transkribera och extrahera realtidsinsikter från ditt mötesljud.

Exempel på LMA-applikationen tillhandahålls som öppen källkod – använd den som utgångspunkt för din egen lösning och hjälp oss att göra den bättre genom att bidra med tillbakafixar och funktioner via GitHub pull-förfrågningar. Bläddra till LMA GitHub-förråd för att utforska koden, välj Kolla på för att bli meddelad om nya releaser och kontrollera README för de senaste dokumentationsuppdateringarna.

För experthjälp, AWS professionella tjänster och andra AWS-partners är här för att hjälpa.

Vi skulle älska att höra från dig. Låt oss veta vad du tycker i kommentarsavsnittet, eller använd problemforumet i LMA GitHub-förråd.

Om författarna

Bob Strahan är en huvudlösningsarkitekt i AWS Language AI Services-teamet.

Bob Strahan är en huvudlösningsarkitekt i AWS Language AI Services-teamet.

Chris Lott är en Principal Solutions Architect i AWS AI Language Services-teamet. Han har 20 års erfarenhet av utveckling av företagsmjukvara. Chris bor i Sacramento, Kalifornien och tycker om trädgårdsarbete, flyg och att resa runt i världen.

Chris Lott är en Principal Solutions Architect i AWS AI Language Services-teamet. Han har 20 års erfarenhet av utveckling av företagsmjukvara. Chris bor i Sacramento, Kalifornien och tycker om trädgårdsarbete, flyg och att resa runt i världen.

Babu Srinivasan är en Sr. Specialist SA – Language AI-tjänster i World Wide Specialist-organisationen på AWS, med över 24 års erfarenhet av IT och de senaste 6 åren fokuserad på AWS Cloud. Han brinner för AI/ML. Utanför jobbet tycker han om träbearbetning och underhåller vänner och familj (ibland främlingar) med slarvig handkortmagi.

Babu Srinivasan är en Sr. Specialist SA – Language AI-tjänster i World Wide Specialist-organisationen på AWS, med över 24 års erfarenhet av IT och de senaste 6 åren fokuserad på AWS Cloud. Han brinner för AI/ML. Utanför jobbet tycker han om träbearbetning och underhåller vänner och familj (ibland främlingar) med slarvig handkortmagi.

Kishore Dhamodaran är Senior Solutions Architect på AWS.

Kishore Dhamodaran är Senior Solutions Architect på AWS.

Gillian Armstrong är en Builder Solutions Architect. Hon är exalterad över hur molnet öppnar upp möjligheter för fler människor att använda teknik för att lösa problem, och särskilt exalterad över hur kognitiva teknologier, som konversations-AI, tillåter oss att interagera med datorer på mer mänskliga sätt.

Gillian Armstrong är en Builder Solutions Architect. Hon är exalterad över hur molnet öppnar upp möjligheter för fler människor att använda teknik för att lösa problem, och särskilt exalterad över hur kognitiva teknologier, som konversations-AI, tillåter oss att interagera med datorer på mer mänskliga sätt.

- SEO-drivet innehåll och PR-distribution. Bli förstärkt idag.

- PlatoData.Network Vertical Generative Ai. Styrka dig själv. Tillgång här.

- PlatoAiStream. Web3 Intelligence. Kunskap förstärkt. Tillgång här.

- Platoesg. Kol, CleanTech, Energi, Miljö, Sol, Avfallshantering. Tillgång här.

- PlatoHealth. Biotech och kliniska prövningar Intelligence. Tillgång här.

- Källa: https://aws.amazon.com/blogs/machine-learning/live-meeting-assistant-with-amazon-transcribe-amazon-bedrock-and-knowledge-bases-for-amazon-bedrock/