Vi befinner oss i den stora accelerationen – en singularitet, inte i den huvudstad-S-Kurzweilianska betydelsen av robotar som reser sig, utan i den som Foucault beskrev: En tidsperiod där förändring är så utbredd och så grundläggande att man inte riktigt kan urskilja hur den andra sidan av den förändringen kommer att se ut.

Vi har gått igenom singulariteter tidigare:

- Jordbrukets framväxt (som skapade överskottsresurser och gav oss de akademiska och merkantila klasserna).

- Uppfinningen av tryckpressen (som demokratiserade kunskap och gjorde den mindre formbar, vilket gav oss idén om en källa till sanning bortom våra egna sinnen).

- Ångmaskinen (som låter maskiner utföra fysiska uppgifter).

- Datorprogramvara (som låter oss ge maskinerna instruktioner att följa).

- Internet och smartphones (som kopplar oss alla till varandra interaktivt).

Denna singularitet är, i sin enklaste form, det vi har uppfunnit en ny typ av programvara.

Den gamla typen av mjukvara

Den gamla typen av programvara – den som för närvarande finns på dina telefoner och datorer – har förändrat våra liv på ett sätt som skulle göra dem nästan oigenkännliga för någon från 1970-talet. Mänskligheten hade 50 år på sig att anpassa sig till mjukvara eftersom den började långsamt med akademiker, sedan hobbyister, med uppringda modem och företags-e-post. Men även med ett halvt sekel att anpassa sig, kämpar vår civilisation för att hantera dess konsekvenser.

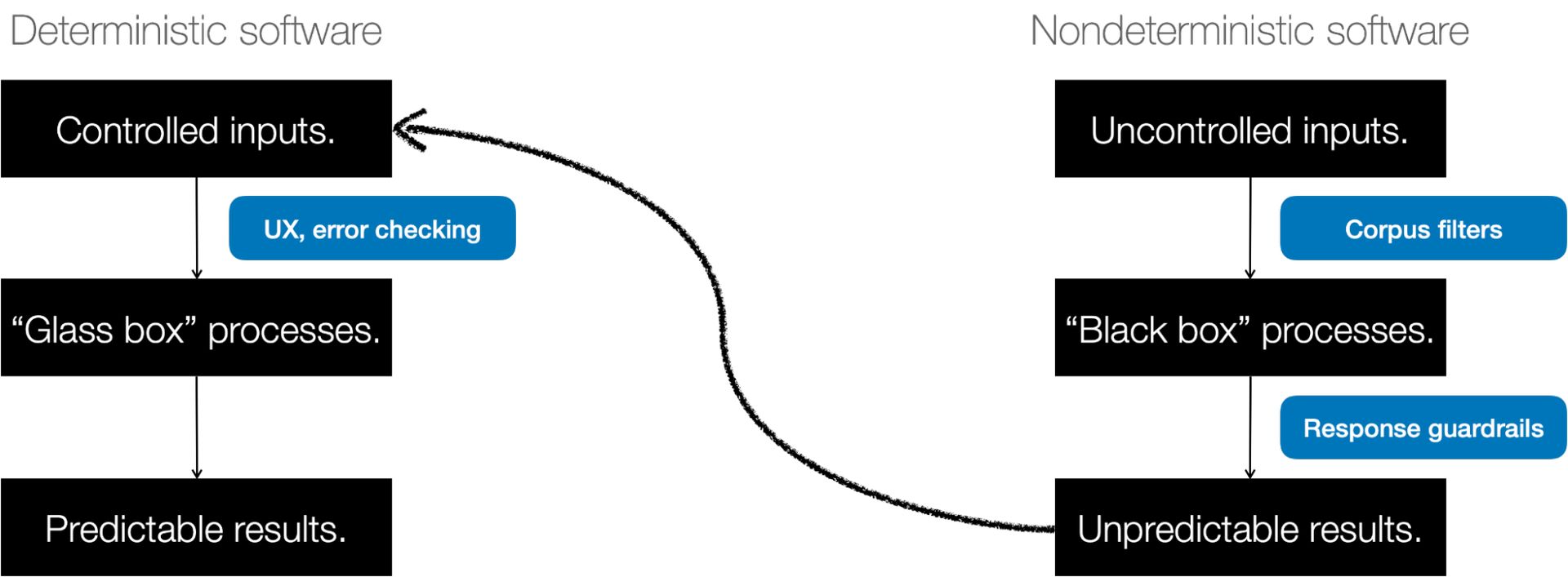

Mjukvaran du är bekant med idag – det som skickar meddelanden, eller lägger ihop nummer, eller bokar något i en kalender, eller till och med driver ett videosamtal – är deterministisk. Det betyder den gör vad du förväntar dig. När resultatet är oväntat kallas det en bugg.

Från deterministisk programvara till AI

Tidigare exempel på "tänkande maskiner" var cybernetik (återkopplingsslingor som autopiloter) och expertsystem (beslutsträd för läkare). Men dessa var fortfarande förutsägbara och begripliga. De följde bara många regler.

På 1980-talet provade vi ett annat tillvägagångssätt. Vi strukturerade mjukvara för att bete sig som hjärnan och ge den "neuroner". Och sedan låter vi den konfigurera sig själv utifrån exempel. 1980 försökte en ung forskare vid namn Yann LeCun detta på bildklassificering.

Han är nu chef för AI på Meta.

Sedan gick AI in i en sorts viloläge. Framsteg gjordes, men det gick långsamt och skedde i den akademiska världen. Deep learning, TensorFlow och andra teknologier uppstod, mestadels för att driva sökmotorer, rekommendationer och reklam. Men AI var en sak som hände bakom kulisserna, i annonstjänster, kartor och röstigenkänning.

Under 2017 publicerade några forskare en nyskriven artikel som heter "Uppmärksamhet är allt du behöver." Då arbetade författarna på Google, men många har sedan dess flyttat till företag som OpenAI. Tidningen beskrev ett mycket enklare sätt att låta programvara konfigurera sig själv genom att uppmärksamma de delar av språket som betydde mest.

En tidig användning för detta var översättning. Om du matar en algoritm tillräckligt med engelsk och fransk text, kan den ta reda på hur man översätter från en till en annan genom att förstå relationerna mellan orden på varje språk. Men det grundläggande tillvägagångssättet gjorde det möjligt för oss att träna programvara på text skrapad från internet.

Därifrån gick utvecklingen ganska snabbt. 2021 kom vi på hur man skapar en "instruktionsmodell" som använde en process som kallas Supervised Fine Tuning (SFT) för att få den konversations-AI att följa instruktionerna. 2022 lät vi människor betygsätta svaren på våra instruktioner (kallas Modified Supervised Fine Tuning), och i slutet av 2022 lade vi till något som heter Reinforcement Learning on Human Feedback, vilket gav oss GPT-3.5 och ChatGPT. AI:er kan nu ge andra AI:er feedback.

Hur som helst, år 2024 är människor den input som saker och ting tränas på, och de ger feedback om utskriftskvalitet som används för att förbättra den.

När oväntat är en funktion, inte en bugg

Resultatet är en ny typ av programvara. För att få det att fungera samlar vi först mängder av data och använder dem för att träna en massiv matematisk modell. Sedan anger vi en uppmaning i modellen och den förutsäger svaret vi vill ha (många människor inser inte att när en AI har tränats ger samma ingång samma utdata – den den tycker är "bäst" – varje gång). Men vi vill ha kreativitet, så vi lägger till en störning, kallad temperatur, som talar om för AI:n hur mycket slumpmässighet den ska injicera i sina svar.

Vi kan inte förutsäga vad modellen kommer att göra på förhand. Och vi introducerar avsiktligt slumpmässighet för att få olika svar varje gång. Hela poängen med denna nya programvara är att vara oförutsägbar. Att vara odeterministisk. Den gör oväntade saker.

Tidigare lade man in något i applikationen och den följde en uppsättning instruktioner som människor skrev och ett förväntat resultat dök upp. Nu lägger du in något i en AI och den följer en uppsättning instruktioner som it skrev, och ett oväntat resultat dyker upp på andra sidan. Och det oväntade resultatet är inte en bugg, det är en funktion.

Otroligt snabb adoption

Vi adopterar den här andra typen av programvara mycket snabbare än den första, av flera anledningar

- Den gör sin egen användarmanual: Även om vi alla är exalterade över hur bra resultaten är, förbiser vi ofta hur väl den kan svara på enkla input. Detta är den första programvaran utan inlärningskurva – den kommer bokstavligen att tala om för alla som kan skriva eller tala hur man använder den. Det är den första programvaran som skapar sin egen dokumentation.

- Alla kan prova: Tack vare allestädes närvarande anslutning via mobiltelefoner och bredband, och SaaS-modellen för värdprogramvara, har många människor tillgång. Du behöver inte längre köpa och installera programvara. Alla som har en webbläsare kan prova det.

- Hårdvara finns överallt: GPU:er från spel, Apples M-seriechips och molnberäkningar gör enorma datorresurser trivialt enkla att distribuera.

- Kostnaderna sjönk. Mycket: Vissa algoritmiska framsteg har sänkt kostnaden för AI med flera storleksordningar. Kostnaden för att klassificera en miljard bilder sjönk från 10,000 2021 USD 0.03 till 2023 USD 450 – en hastighet på XNUMX gånger billigare per dag.

- Vi lever online: Människor är online i genomsnitt sex timmar om dagen, och mycket av den interaktionen (e-post, chattrum, sms, bloggar) är textbaserad. I onlinevärlden är en människa i stort sett omöjlig att skilja från en algoritm, så det har funnits många enkla sätt att koppla AI-utdata till de flöden och skärmar som människor konsumerar. COVID-19 påskyndade distansarbete, och med det, insinuationen av text och algoritmer i våra liv.

Vad icke-deterministisk programvara kan göra

Icketerministisk programvara kan göra många saker, av vilka vi först nu börjar inse.

- Det är generativ. Det kan skapa nya saker. Vi ser detta i bilder (Stable Diffusion, Dall-e) och musik (Google MusicLM) och till och med ekonomi, genomik och resursdetektering. Men den plats som får mest utbredd uppmärksamhet är i chatbots som de från OpenAI, Google, Perplexity och andra.

- Det är bra på kreativitet men det hittar på saker. Det betyder att vi ger det de "roliga" jobben som konst och prosa och musik som det inte finns något "rätt svar på". Det innebär också en flod av desinformation och en epistemisk kris för mänskligheten.

- Det är fortfarande behöver mycket mänsklig input att filtrera utdata till något användbart. Faktum är att många av stegen för att producera en konversations-AI innebär att människor ger den exempel på bra svar eller betygsätter de svar den ger.

- Eftersom det ofta är fel måste vi kunna skylla på någon. Människan som bestämmer vad den ska göra med dess produktion är ansvariga för konsekvenserna.

- It kan resonera på sätt vi inte trodde att det borde kunna. Vi förstår inte varför det är så.

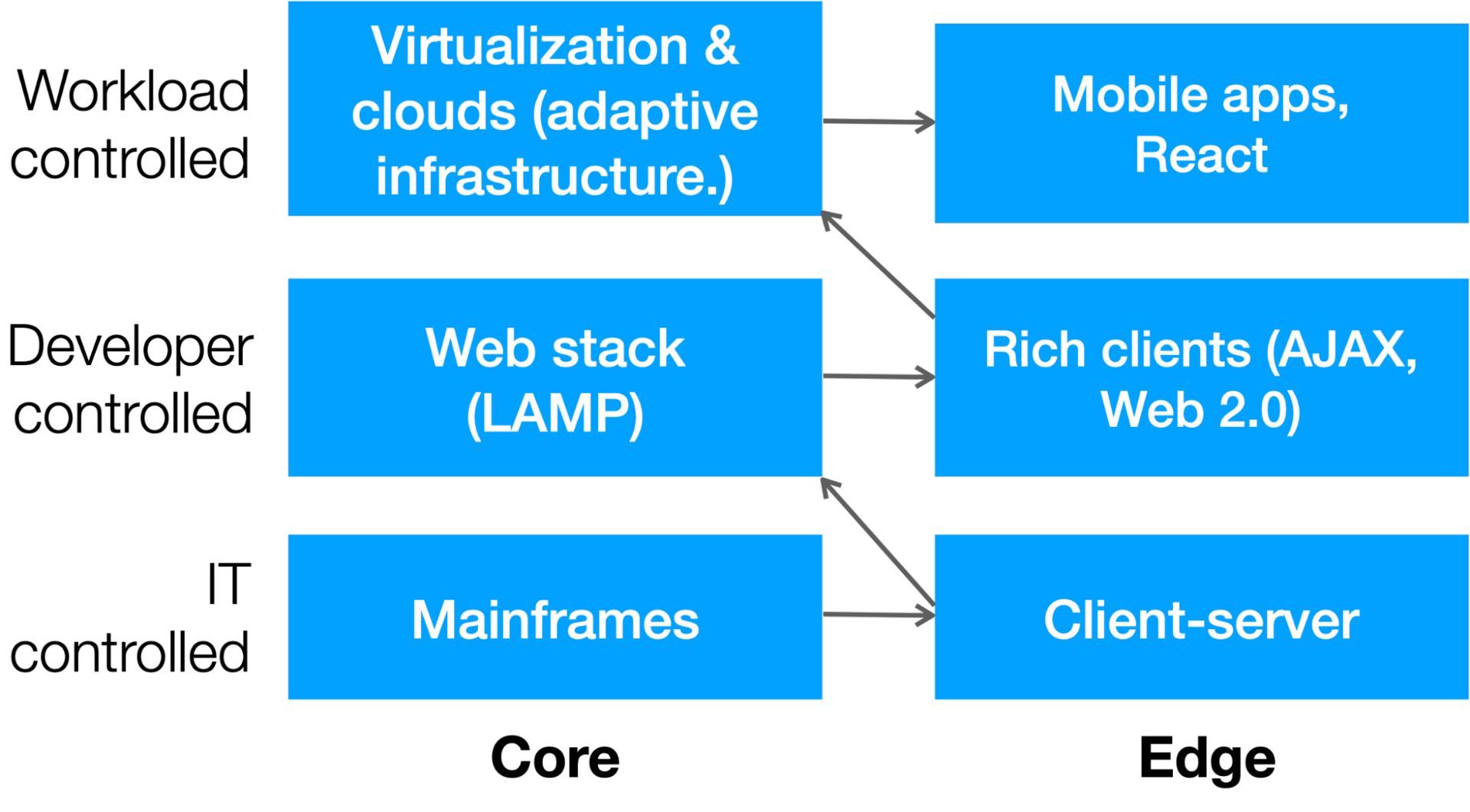

Pendeln och demokratiseringen av IT

Även om det per definition är svårt att förutsäga den andra sidan av en singularitet, kan vi göra några kvalificerade gissningar om hur informationsteknologi (IT) kommer att förändras. IT-branschen har genomgått två stora förändringar under det senaste århundradet:

- En konstant pendel har svängt från centraliseringen av stordatorer till den distribuerade karaktären hos webbklienter.

- Det är en gradvis demokratisering av resurser, från de dagar då datoranvändning var sällsynt, värdefull och bevakad av IT till en era då utvecklarna, och sedan själva arbetsbelastningen, kunde distribuera resurser efter behov.

Det här diagrammet visar skiftet:

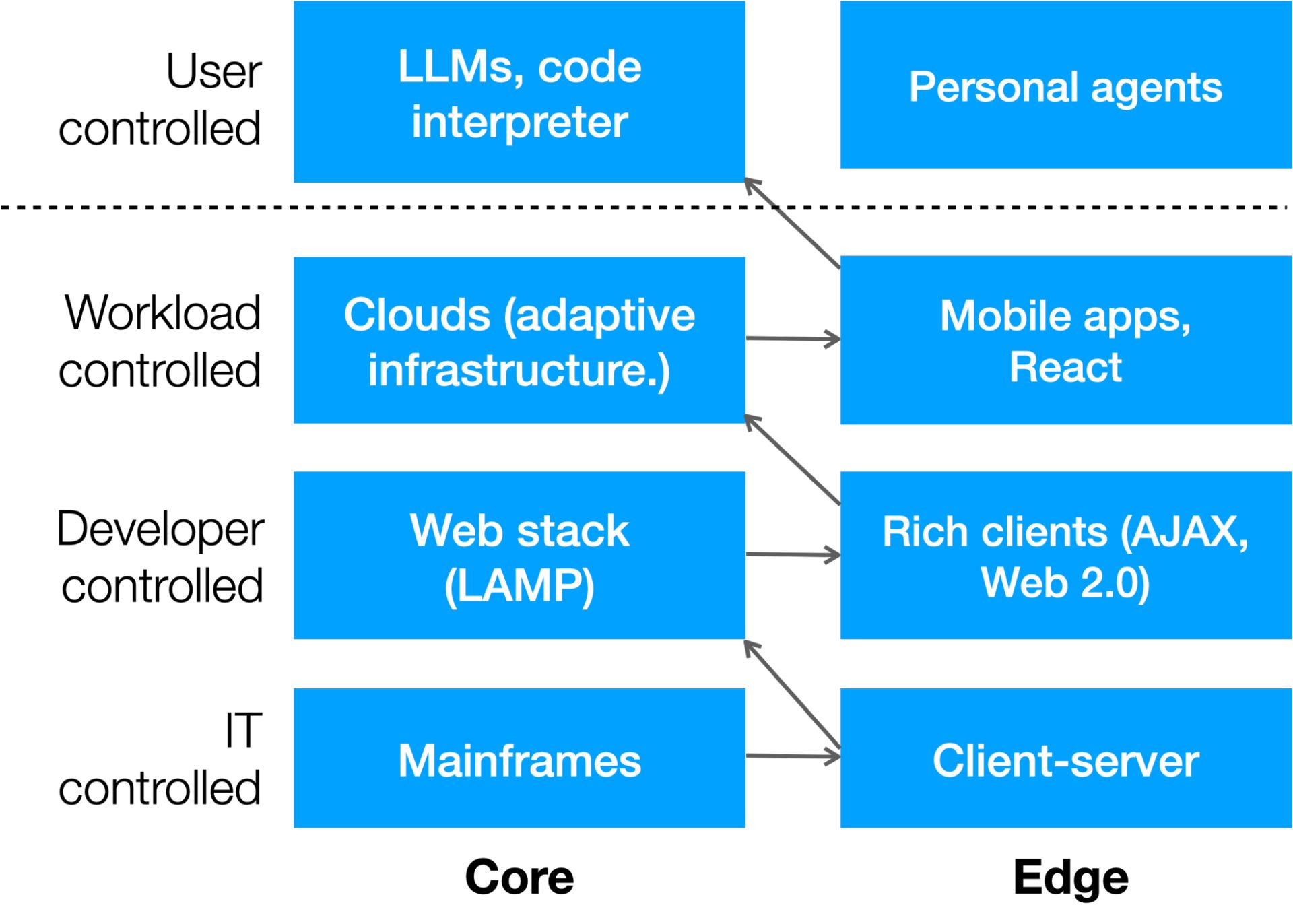

Det finns ytterligare ett lager som händer tack vare AI: Användarkontrollerad datoranvändning. Vi ser redan no-code och low-code-verktyg som Unqork, Bubble, Webflow, Zapier och andra som gör det lättare för användare att skapa appar, men det som är mycket mer intressant är när en användares AI-prompt lanserar kod. Vi ser detta i OpenAIs ChatGPT-kodtolkare, som kommer att skriva och sedan köra appar för att bearbeta data.

Det är troligt att det kommer att bli ytterligare en pendelsvängning till kanten under de kommande åren när företag som Apple ger sig in i striden (som har byggt in rejäl AI-behandling i sina hemmagjorda chipset i väntan på denna dag). Så här ser nästa lager av datorer ut:

Bygger en andra stack

En annan förutsägelse vi kan göra om IT i den icke-deterministiska tidsåldern är att företag kommer att ha två stackar.

- En kommer att vara deterministisk, köra förutsägbara uppgifter.

- En kommer att vara icke-deterministisk och generera oväntade resultat.

Det kanske mest intressanta är att den andra (icke-deterministiska) stacken kommer att kunna skriva kod som den första (deterministiska) stacken kan köra – snart, bättre än vad människor kan.

Det kommande decenniet kommer att se en brådska att bygga andra stackar i alla organisationer. Varje företag kommer att bedömas på värdet av sin korpus, den proprietära informationen och realtidsuppdateringarna som det använder för att få ut de bästa resultaten från sin AI. Varje stack kommer att ha olika hårdvarukrav, arkitekturer, styrning, användargränssnitt och kostnadsstrukturer.

Vi kan inte förutsäga hur AI kommer att omforma mänskligheten. Men vi kan göra välgrundade gissningar om hur det kommer att förändra företags-IT, och de som anpassar sig snabbt kommer att vara bäst redo att dra nytta av det som kommer efteråt.

Alistair Croll är författare till flera böcker om teknik, affärer och samhälle, inklusive bästsäljaren Lean Analytics. Han är grundare och medordförande för FWD50, världens ledande konferens om innovation inom den offentliga sektorn, och har tjänstgjort som besökande chef vid Harvard Business School, där han hjälpte till att skapa läroplanen för datavetenskap och kritiskt tänkande. Han är konferensordförande för Datauniversum 2024.

Möt författaren på Data Universe

Gå med författaren, Alistair Croll, kl Datauniversum, äger rum 10-11 april 2024, i NYC, där han kommer att leda lanseringen av en ny varumärkes-agnostisk data- och AI-konferens utformad för hela den globala data- och AI-gemenskapen.

Sammanför allt – Data Universe välkomnar dataproffs på alla kompetensnivåer och roller, såväl som affärsmän, chefer och branschpartners att engagera sig med de mest aktuella och relevanta expertledda insikterna om data, analys, ML och AI som utforskas i olika branscher , för att hjälpa dig att utvecklas tillsammans med de snabbt föränderliga normer, verktyg, tekniker och förväntningar som förändrar framtiden för företag och samhälle. Följ med oss på North Javits Center i NYC i april för att vara en del av framtiden för data och AI.

INFORMS är glada över att vara en strategisk partner med Data Universe 2024 och kommer att presentera fyra sessioner under konferensen.

Visad bildkredit: Growtika/Unsplash

- SEO-drivet innehåll och PR-distribution. Bli förstärkt idag.

- PlatoData.Network Vertical Generative Ai. Styrka dig själv. Tillgång här.

- PlatoAiStream. Web3 Intelligence. Kunskap förstärkt. Tillgång här.

- Platoesg. Kol, CleanTech, Energi, Miljö, Sol, Avfallshantering. Tillgång här.

- PlatoHealth. Biotech och kliniska prövningar Intelligence. Tillgång här.

- Källa: https://dataconomy.com/2024/04/04/building-the-second-stack/