Введение

Системы искусственного интеллекта реального времени во многом полагаются на быстрый вывод. API-интерфейсы логического вывода от лидеров отрасли, таких как OpenAI, Google и Azure, позволяют быстро принимать решения. Технология Language Processing Unit (LPU) компании Groq — это выдающееся решение, повышающее эффективность обработки ИИ. В этой статье рассматривается инновационная технология Groq, ее влияние на скорость вывода ИИ и способы ее использования с помощью Groq API.

Цели обучения

- Познакомьтесь с технологией Groq Language Processing Unit (LPU) и ее влиянием на скорость вывода ИИ.

- Узнайте, как использовать конечные точки API Groq для задач обработки ИИ в режиме реального времени с малой задержкой.

- Изучите возможности поддерживаемых Groq моделей, таких как Mixtral-8x7b-Instruct-v0.1 и Llama-70b, для понимания и генерации естественного языка.

- Сравните и сопоставьте систему LPU Groq с другими API вывода, изучая такие факторы, как скорость, эффективность и масштабируемость.

Эта статья была опубликована в рамках Блогатон по Data Science.

Содержание

Что такое Грок?

Основанный в 2016 году, Грок — калифорнийский стартап в области решений искусственного интеллекта со штаб-квартирой в Маунтин-Вью. Компания Groq, которая специализируется на выводах искусственного интеллекта со сверхмалой задержкой, значительно повысила производительность вычислений на базе искусственного интеллекта. Groq — видный участник рынка технологий искусственного интеллекта, зарегистрировавший свое имя в качестве товарного знака и сформировавший глобальную команду, стремящуюся к демократизации доступа к искусственному интеллекту.

Языковые процессоры

Языковой процессор Groq (LPU), инновационная технология, направлен на повышение производительности вычислений ИИ, особенно для больших языковых моделей (LLM). Система Groq LPU стремится обеспечить работу в реальном времени с малой задержкой и исключительной производительностью вывода. Groq достиг более 300 токенов в секунду на пользователя на модели Llama-2 70B от Meta AI, установив новый отраслевой стандарт.

Система Groq LPU может похвастаться сверхнизкими задержками, необходимыми для технологий поддержки искусственного интеллекта. Специально разработанный для последовательной и ресурсоемкой обработки языка GenAI, он превосходит традиционные решения на основе графических процессоров, обеспечивая эффективную обработку таких задач, как создание и понимание естественного языка.

GroqChip первого поколения компании Groq, являющийся частью системы LPU, имеет архитектуру тензорной потоковой передачи, оптимизированную для скорости, эффективности, точности и экономичности. Этот чип превосходит существующие решения, устанавливая новые рекорды базовой скорости LLM, измеряемой в токенах в секунду на пользователя. Планируя в течение двух лет развернуть 1 миллион микросхем вывода искусственного интеллекта, Groq демонстрирует свою приверженность развитию технологий ускорения искусственного интеллекта.

Подводя итог, можно сказать, что система Language Processing Unit от Groq представляет собой значительный прогресс в области вычислительных технологий искусственного интеллекта, предлагая выдающуюся производительность и эффективность для больших языковых моделей и одновременно стимулируя инновации в области искусственного интеллекта.

Читайте также: Построение модели машинного обучения в AWS SageMaker

Начало работы с Groq

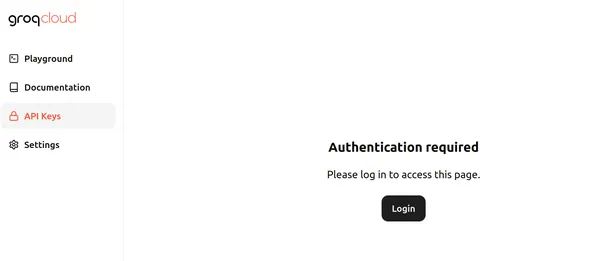

Прямо сейчас Groq предоставляет бесплатные конечные точки API для больших языковых моделей, работающих на Groq LPU — языковом процессоре. Для начала посетите это страница и нажмите «Войти». Страница выглядит так, как показано ниже:

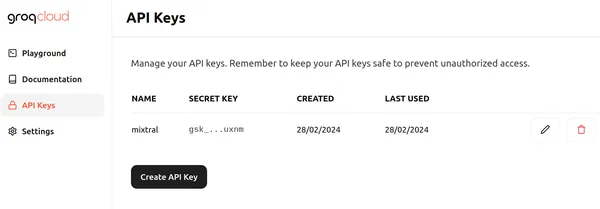

Нажмите «Войти» и выберите один из подходящих способов входа в Groq. Затем мы можем создать новый API, как показано ниже, нажав кнопку «Создать ключ API».

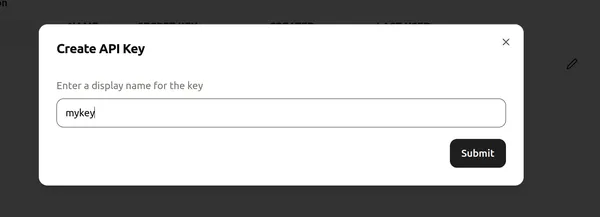

Затем присвойте имя ключу API и нажмите «Отправить», чтобы создать новый ключ API. Теперь перейдите в любой редактор кода/Colab и установите необходимые библиотеки, чтобы начать использовать Groq.

!pip install groqЭта команда устанавливает библиотеку Groq, что позволяет нам определить модели большого языка, работающие на LPU Groq.

Теперь приступим к коду.

Реализация кода

# Importing Necessary Libraries

import os

from groq import Groq

# Instantiation of Groq Client

client = Groq(

api_key=os.environ.get("GROQ_API_KEY"),

)Этот фрагмент кода устанавливает клиентский объект Groq для взаимодействия с API Groq. Он начинается с получения ключа API из переменной среды с именем GROQ_API_KEY и передачи его в аргумент api_key. Впоследствии ключ API инициализирует клиентский объект Groq, позволяя вызывать API к моделям большого языка на серверах Groq.

Определение нашего LLM

llm = client.chat.completions.create(

messages=[

{

"role": "system",

"content": "You are a helpful AI Assistant. You explain ever

topic the user asks as if you are explaining it to a 5 year old"

},

{

"role": "user",

"content": "What are Black Holes?",

}

],

model="mixtral-8x7b-32768",

)

print(llm.choices[0].message.content)- Первая строка инициализирует объект llm, обеспечивая взаимодействие с большой языковой моделью, аналогично API завершения чата OpenAI.

- Последующий код создает список сообщений, которые будут отправлены в LLM, и хранится в переменной messages.

- В первом сообщении назначается роль «системы» и определяется желаемое поведение LLM для объяснения тем, как если бы это было 5-летнему ребенку.

- Второе сообщение назначает роль «пользователя» и включает вопрос о черных дырах.

- В следующей строке указывается LLM, который будет использоваться для генерации ответа, установленный на «mixtral-8x7b-32768», контекст 32 тыс. Mixtral-8x7b-Instruct-v0.1. Большая языковая модель, доступная через API Groq.

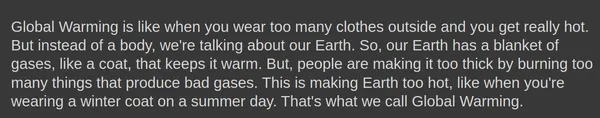

- Результатом этого кода будет ответ LLM, объясняющий черные дыры в манере, доступной для понимания пятилетнего ребенка.

- Доступ к выходным данным аналогичен подходу к работе с конечной точкой OpenAI.

Результат

Ниже показаны выходные данные, сгенерированные большой языковой моделью Mixtral-8x7b-Instruct-v0.1:

Ассоциация завершения.создать() объект может даже принимать дополнительные параметры, такие как температура, топ_ри max_tokens.

Генерация ответа

Попробуем сгенерировать ответ с этими параметрами:

llm = client.chat.completions.create(

messages=[

{

"role": "system",

"content": "You are a helpful AI Assistant. You explain ever

topic the user asks as if you are explaining it to a 5 year old"

},

{

"role": "user",

"content": "What is Global Warming?",

}

],

model="mixtral-8x7b-32768",

temperature = 1,

top_p = 1,

max_tokens = 256,

)- температура: управляет случайностью ответов. Более низкая температура приводит к более предсказуемым результатам, в то время как более высокая температура приводит к более разнообразным, а иногда и более творческим результатам.

- max_tokens: максимальное количество токенов, которые модель может обработать за один ответ. Этот предел обеспечивает эффективность вычислений и управление ресурсами.

- топ_р: метод генерации текста, который выбирает следующий токен из распределения вероятностей верхних p наиболее вероятных токенов. Это балансирует разведку и эксплуатацию во время генерации.

Результат

Существует даже возможность потоковой передачи ответов, сгенерированных из конечной точки Groq. Нам просто нужно указать поток = Истина вариант в завершения.создать() объект для модели, чтобы начать потоковую передачу ответов.

Грок в Лангчейне

Groq даже совместим с LangChain. Чтобы начать использовать Groq в LangChain, скачайте библиотеку:

!pip install langchain-groqВышеуказанное позволит установить библиотеку Groq для совместимости с LangChain. Теперь давайте попробуем это в коде:

# Import the necessary libraries.

from langchain_core.prompts import ChatPromptTemplate

from langchain_groq import ChatGroq

# Initialize a ChatGroq object with a temperature of 0 and the "mixtral-8x7b-32768" model.

llm = ChatGroq(temperature=0, model_name="mixtral-8x7b-32768")Приведенный выше код делает следующее:

- Создает новый объект ChatGroq с именем llm.

- Устанавливает температура значение параметра равно 0, что указывает на то, что ответы должны быть более предсказуемыми.

- Устанавливает название модели параметр «микстраль-8x7b-32768«, указав языковую модель для использования

# Определите системное сообщение, знакомящее с возможностями AI-помощника.

# Define the system message introducing the AI assistant's capabilities.

system = "You are an expert Coding Assistant."

# Define a placeholder for the user's input.

human = "{text}"

# Create a chat prompt consisting of the system and human messages.

prompt = ChatPromptTemplate.from_messages([("system", system), ("human", human)])

# Invoke the chat chain with the user's input.

chain = prompt | llm

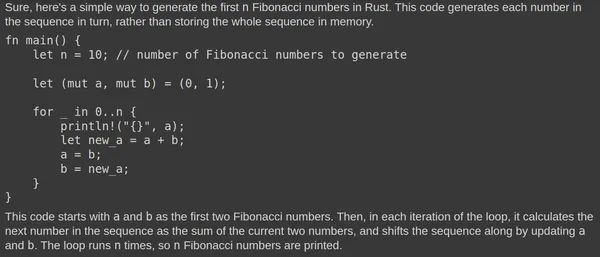

response = chain.invoke({"text": "Write a simple code to generate Fibonacci numbers in Rust?"})

# Print the Response.

print(response.content)- Код создает приглашение чата, используя класс ChatPromptTemplate.

- Подсказка состоит из двух сообщений: одного от «системы» (помощника ИИ) и одного от «человека» (пользователя).

- В системном сообщении ИИ-помощник представлен как эксперт-помощник по кодированию.

- Человеческое сообщение служит заполнителем для ввода пользователя.

- Метод llm вызывает цепочку llm для создания ответа на основе предоставленного приглашения и ввода пользователя.

Результат

Вот результат, полученный моделью большого языка Mixtral:

Mixtral LLM постоянно генерирует соответствующие ответы. Тестирование кода на Rust Playground подтверждает его функциональность. Быстрый ответ обусловлен базовым блоком языковой обработки (LPU).

Groq против других API вывода

Система языкового процессора Groq (LPU) призвана обеспечить молниеносную скорость вывода для больших языковых моделей (LLM), превосходя другие API вывода, например, предоставляемые OpenAI и Azure. Система LPU Groq, оптимизированная для LLM, обеспечивает возможности сверхнизкой задержки, необходимые для технологий помощи искусственного интеллекта. Он устраняет основные узкие места LLM, включая плотность вычислений и пропускную способность памяти, позволяя быстрее генерировать текстовые последовательности.

По сравнению с другими API-интерфейсами вывода, система LPU Groq работает быстрее и способна генерировать до 18 раз более высокую производительность вывода в таблице лидеров LLMPerf Anyscale по сравнению с другими ведущими облачными поставщиками. Система LPU Groq также более эффективна: одноядерная архитектура и синхронная сеть поддерживаются в крупномасштабных развертываниях, что обеспечивает автоматическую компиляцию LLM и мгновенный доступ к памяти.

На изображении выше показаны тесты для моделей 70B. Расчет пропускной способности выходных токенов включает в себя усреднение количества выходных токенов, возвращаемых в секунду. Каждый поставщик логических выводов LLM обрабатывает 150 запросов для сбора результатов, и на основе этих запросов рассчитывается средняя пропускная способность выходных токенов. Об улучшении производительности поставщика вывода LLM свидетельствует более высокая пропускная способность выходных токенов. Понятно, что количество токенов Groq в секунду превосходит многие представленные облачные провайдеры.

Заключение

В заключение отметим, что система языкового процессора (LPU) Groq выделяется как революционная технология в области вычислений с использованием искусственного интеллекта, предлагая беспрецедентную скорость и эффективность для обработки больших языковых моделей (LLM) и стимулируя инновации в области искусственного интеллекта. Используя возможности сверхнизкой задержки и оптимизированную архитектуру, Groq устанавливает новые стандарты скорости вывода, превосходя по производительности традиционные решения на основе графических процессоров и другие ведущие в отрасли API-интерфейсы вывода. Благодаря своей приверженности демократизации доступа к искусственному интеллекту и ориентации на работу в режиме реального времени с малой задержкой Groq готова изменить ландшафт технологий ускорения искусственного интеллекта.

Основные выводы

- Система языкового процессора Groq (LPU) обеспечивает беспрецедентную скорость и эффективность вывода ИИ, особенно для больших языковых моделей (LLM), позволяя работать в режиме реального времени с малой задержкой.

- Система LPU Groq, оснащенная GroqChip, может похвастаться возможностями сверхнизкой задержки, необходимыми для технологий поддержки искусственного интеллекта, превосходя по производительности традиционные решения на основе графических процессоров.

- Планируя развернуть 1 миллион чипов вывода ИИ в течение двух лет, Groq демонстрирует свою приверженность продвижению технологий ускорения ИИ и демократизации доступа к ИИ.

- Groq предоставляет бесплатные конечные точки API для больших языковых моделей, работающих на Groq LPU, что делает их доступными для разработчиков для интеграции в свои проекты.

- Совместимость Groq с LangChain и LlamaIndex еще больше расширяет его удобство использования, предлагая плавную интеграцию для разработчиков, стремящихся использовать технологию Groq в своих задачах обработки языка.

Часто задаваемые вопросы

А. Грок специализируется на выводах ИИ со сверхмалой задержкой, особенно для моделей большого языка (LLM), стремясь произвести революцию в производительности вычислений ИИ.

Система LPU A. Groq, оснащенная GroqChip, специально разработана для ресурсоемкой обработки языка GenAI и обеспечивает превосходную скорость, эффективность и точность по сравнению с традиционными решениями на основе графических процессоров.

А. Грок поддерживает ряд моделей для вывода ИИ, включая Mixtral-8x7b-Instruct-v0.1 и Llama-70b.

О. Да, Groq совместим с LangChain и LlamaIndex, что расширяет его удобство использования и предлагает плавную интеграцию для разработчиков, стремящихся использовать технологию Groq в своих задачах обработки языка.

Система LPU А. Грока превосходит другие API-интерфейсы вывода с точки зрения скорости и эффективности, обеспечивая до 18 раз более высокую скорость вывода и превосходную производительность, о чем свидетельствуют тесты в таблице лидеров LLMPerf от Anyscale.

Материалы, показанные в этой статье, не принадлежат Analytics Vidhya и используются по усмотрению Автора.

- SEO-контент и PR-распределение. Получите усиление сегодня.

- PlatoData.Network Вертикальный генеративный ИИ. Расширьте возможности себя. Доступ здесь.

- ПлатонАйСтрим. Интеллект Web3. Расширение знаний. Доступ здесь.

- ПлатонЭСГ. Углерод, чистые технологии, Энергия, Окружающая среда, Солнечная, Управление отходами. Доступ здесь.

- ПлатонЗдоровье. Биотехнологии и клинические исследования. Доступ здесь.

- Источник: https://www.analyticsvidhya.com/blog/2024/03/getting-started-with-groq-api/