Marley Stevens postou um vídeo no TikTok semestre passado, que ela descreveu como um anúncio de serviço público para qualquer estudante universitário. A mensagem dela: não use software de verificação gramatical se o seu professor puder passar seu trabalho por meio de um sistema de detecção de IA.

Stevens está no terceiro ano da Universidade da Geórgia do Norte e tem tornado público o que chama de “desastre”, no qual foi acusada de usar IA para escrever um artigo que ela diz ter escrito sozinha, exceto por usar gramática padrão. e recursos de verificação ortográfica do Grammarly, que ela instalou como uma extensão em seu navegador.

O vídeo de alerta inicial que ela postou foi visto mais de 5.5 milhões de vezes e, desde então, ela fez mais de 25 vídeos de acompanhamento respondendo comentários de seguidores e documentando sua batalha com a faculdade sobre o assunto – incluindo o compartilhamento de fotos de e-mails enviados a ela. de reitores acadêmicos e imagens de seus trabalhos estudantis para tentar provar seu caso – para aumentar a conscientização sobre o que ela vê como ferramentas de detecção de IA defeituosas que são cada vez mais sancionadas por faculdades e usadas por professores.

Stevens diz que um professor de um curso de justiça criminal que ela fez no ano passado deu-lhe um zero em um trabalho porque disse que o sistema de detecção de IA no Turnitin o sinalizou como escrito por um robô. Stevens insiste que o trabalho é inteiramente dela e que ela não usou ChatGPT ou qualquer outro chatbot para redigir qualquer parte de seu artigo.

@m.stevens03 #granmerly #ai #inteligência artificial #fyp #psa ♬ som original – Marley Stevens

Como resultado do zero no papel, diz ela, a sua nota final na turma caiu para uma nota suficientemente baixa que a impediu de se qualificar para um Bolsa de estudos HOPE, que exige que os alunos mantenham um GPA 3.0. E ela diz que a universidade a colocou em liberdade condicional acadêmica por violar suas políticas sobre má conduta acadêmica, e ela foi obrigada a pagar US$ 105 para participar de um seminário sobre trapaça.

A universidade recusou repetidos pedidos da EdSurge para falar sobre suas políticas de uso de detecção de IA. Em vez disso, as autoridades enviaram uma declaração dizendo que as leis federais de privacidade dos estudantes os impedem de comentar sobre qualquer incidente individual de trapaça e que: “Nosso corpo docente comunica diretrizes específicas sobre o uso de IA para várias aulas, e essas diretrizes estão incluídas nos programas de aula. O uso inadequado de IA também é abordado em nosso Código de Conduta do Estudante. "

A seção desse código de conduta estudantil define plágio como: “Uso de ideias ou expressões de outra pessoa ou agência (para incluir Inteligência Artificial) sem reconhecer a fonte. Temas, redações, trabalhos de conclusão de curso, testes e outros requisitos semelhantes deverão ser trabalho do Aluno que os submete. Quando forem utilizadas citações diretas ou paráfrases, elas deverão ser indicadas, e quando as ideias de outrem forem incorporadas no artigo, deverão ser devidamente reconhecidas. Todo o trabalho de um Aluno precisa ser original ou citado de acordo com os requisitos do instrutor ou será considerado plágio. O plágio inclui, mas não está limitado a, a utilização, por paráfrase ou citação direta, do trabalho publicado ou não publicado de outra pessoa sem reconhecimento total e claro. Também inclui o uso não reconhecido de materiais preparados por outra pessoa ou agência na venda de trabalhos de conclusão de curso ou outros materiais acadêmicos.”

O incidente levanta questões complexas sobre onde traçar limites em relação às novas ferramentas de IA. Quando é que estão apenas a ajudar de forma aceitável e quando é que a sua utilização significa má conduta académica? Afinal, muitas pessoas usam recursos de correção automática gramatical e ortográfica em sistemas como o Google Docs e outros programas que sugerem uma palavra ou frase conforme os usuários digitam. Isso é trapaça?

E à medida que esses recursos gramaticais se tornam mais robustos à medida que as ferramentas generativas de IA se tornam mais populares, as ferramentas de detecção de IA podem dizer a diferença entre o uso aceitável de IA e a trapaça?

“Outros professores desta mesma universidade recomendaram que eu usasse [Grammarly] para trabalhos”, disse Stevens em outro video. “Então eles estão tentando nos dizer que não podemos usar correção automática, corretores ortográficos ou algo assim? O que eles querem que façamos, digite-o em um aplicativo do Notes e transforme-o dessa forma?

Em entrevista ao EdSurge, o aluno colocou desta forma:

“O que quero dizer é que os detectores de IA são lixo e não há muito que nós, como estudantes, possamos fazer a respeito”, diz ela. “E isso não é justo porque fazemos todo esse trabalho e pagamos todo esse dinheiro para ir para a faculdade, e então um detector de IA pode estragar toda a sua carreira universitária.”

Voltas e mais voltas

Ao longo do caminho, a história deste estudante da Universidade do Norte da Geórgia tomou algumas reviravoltas surpreendentes.

Por um lado, a universidade enviou um e-mail a todos os alunos sobre IA pouco depois de Stevens postar seu primeiro vídeo viral.

Esse e-mail lembrava os alunos de seguirem o código de conduta acadêmica da universidade e também trazia um aviso incomum: “Esteja ciente de que algumas ferramentas online usadas para ajudar os alunos com gramática, pontuação, estrutura de frases, etc., utilizam inteligência artificial generativa (IA). ); que pode ser sinalizado pelo Turnitin. Um dos sites de IA generativa mais comumente usados e sinalizados pelo Turnitin.com é Grammarly. Tenha cuidado ao considerar esses sites.”

Mais tarde, o professor disse à aluna que também verificou o artigo dela com outra ferramenta, Copyleaks, e também sinalizou o artigo dela como escrito por um bot. E ela diz que quando publicou seu artigo recentemente no Copyleaks, considerou o trabalho escrito por humanos. Ela enviou a este repórter uma captura de tela desse processo, na qual a ferramenta conclui, em texto verde: “Este é um texto humano”.

“Se estou analisando agora e obtendo um resultado diferente, isso apenas mostra que essas coisas nem sempre são precisas”, diz ela sobre os detectores de IA.

Funcionários da Copyleaks não responderam aos pedidos de comentários. Stevens se recusou a compartilhar o texto completo de seu artigo, explicando que não queria que ele fosse parar na internet, onde outros estudantes pudessem copiá-lo e possivelmente lhe causar mais problemas com sua universidade. “Já estou em período probatório acadêmico”, diz ela.

Stevens diz que ouviu estudantes de todo o país dizerem que também foram falsamente acusados de trapacear devido ao software de detecção de IA.

“Uma estudante disse que queria ser médica, mas foi acusada e nenhuma das escolas a aceitou por causa da acusação de má conduta”, diz Stevens.

Stevens diz que ficou surpresa com a quantidade de apoio que recebeu das pessoas que assistem aos seus vídeos. Seus seguidores nas redes sociais a incentivaram a criar um Campanha GoFundMe, o que ela fez para cobrir a perda de sua bolsa de estudos e para pagar um advogado para potencialmente tomar medidas legais contra a universidade. Até agora, ela arrecadou mais de US$ 6,100 de mais de 90 pessoas.

Ela também ficou surpresa ao ser contatada por funcionários da Grammarly, que doaram US$ 4,000 mil ao GoFundMe e a contrataram como embaixadora estudantil. Como resultado, Stevens agora planeja fazer três vídeos promocionais para Grammarly, pelos quais ela receberá uma pequena taxa por cada um.

“Neste momento, estamos tentando trabalhar juntos para que as faculdades repensem suas políticas de IA”, diz Stevens.

Para Grammarly, parece claro que o objetivo é mudar a narrativa daquele primeiro vídeo de Stevens, no qual ela disse: “Se você tem um artigo, ensaio, postagem de discussão, qualquer coisa que esteja sendo enviada para o TurnItIn, desinstale Grammarly agora mesmo .”

A chefe de educação da Grammarly, Jenny Maxwell, diz que espera espalhar a mensagem sobre como os detectores de IA são imprecisos.

“Muitas instituições a nível docente não têm consciência da frequência com que estes serviços de deteção de IA estão errados”, diz ela. “Queremos ter certeza de que as instituições estão cientes de quão perigoso pode ser ter esses detectores de IA como a única fonte da verdade.”

Tais falhas foram bem documentado, e vários pesquisadores disseram que os professores não deveriam usar as ferramentas. Até o Turnitin declarou publicamente que sua ferramenta de detecção de IA nem sempre é confiável.

Annie Chechitelli, diretora de produtos da Turnitin, diz que suas ferramentas de detecção de IA têm uma taxa de falsos positivos de cerca de 1%, de acordo com os testes da empresa, e que está trabalhando para que esse valor seja o mais baixo possível.

“Provavelmente deixamos cerca de 15% [do texto escrito por bots] passar sem serem sinalizados”, diz ela. “Preferimos diminuir nossa precisão do que aumentar nossa taxa de falsos positivos.”

Chechitelli enfatiza que os educadores devem usar o sistema de detecção do Turnitin como ponto de partida para uma conversa com um aluno, e não como uma decisão final sobre a integridade acadêmica do trabalho do aluno. E ela diz que esse também foi o conselho da empresa para o seu sistema de detecção de plágio.

“Tivemos que treinar muito os professores para que isso não fosse prova de que o aluno trapaceou”, diz ela. “Sempre dissemos que o professor precisa tomar uma decisão.”

No entanto, a IA coloca os educadores numa posição mais desafiadora para essa conversa, reconhece Chechitelli. Nos casos em que a ferramenta do Turnitin detecta plágio, o sistema aponta para o material de origem que o aluno pode ter copiado. No caso da detecção de IA, não há material de origem claro para procurar, já que ferramentas como o ChatGPT fornecem respostas diferentes cada vez que um usuário insere um prompt, tornando muito mais difícil provar que um bot é a fonte.

O responsável da Turnitin afirma que nos testes internos da empresa as ferramentas tradicionais de verificação gramatical não disparam os seus alarmes.

Maxwell, da Grammarly, aponta que mesmo que um sistema de detecção de IA esteja certo 98% das vezes, isso significa que ele sinaliza falsamente, digamos, 2% dos artigos. E como uma única universidade pode ter 50,000 mil trabalhos de estudantes entregues a cada ano, isso significa que se todos os professores usassem um sistema de detecção de IA, 1,000 trabalhos seriam falsamente chamados de casos de trapaça.

Maxwell se preocupa com a possibilidade de as faculdades desencorajarem o uso de seu produto? Afinal, a Universidade da Geórgia do Norte removeu recentemente o Grammarly de uma lista de recursos recomendados depois que os vídeos do TikTok de Stevens se tornaram virais, embora mais tarde o tenham adicionado novamente.

“Nos encontramos com a University of North Georgia e eles disseram que isso não tem nada a ver com Grammarly”, diz Maxwell. “Estamos muito satisfeitos com a quantidade de professores e estudantes que estão se inclinando na direção oposta – dizendo: 'Este é o novo mundo do trabalho e precisamos descobrir o uso apropriado dessas ferramentas.' Você não pode colocar a pasta de dente de volta no tubo.”

Para Tricia Bertram Gallant, diretora do Escritório de Integridade Acadêmica da Universidade da Califórnia em San Diego e especialista nacional em trapaça, a questão mais importante no caso deste estudante não é a tecnologia. Ela diz que a grande questão é se as faculdades possuem sistemas eficazes para lidar com acusações de má conduta acadêmica.

“Eu duvido muito que um aluno seja acusado de trapacear apenas com um corretor gramatical e ortográfico”, diz ela, “mas se isso for verdade, os chatbots de IA não são o problema, a política e o processo são o problema”.

“Se um membro do corpo docente pode usar uma ferramenta, acusar um aluno e dar-lhe um zero e pronto, isso é um problema”, diz ela. “Isso não é um problema de ferramenta.”

Ela diz que, conceitualmente, as ferramentas de IA não são diferentes de outras formas pelas quais os alunos trapacearam durante anos, como contratar outros estudantes para escrever seus trabalhos para eles.

“É estranho para mim quando as faculdades estão gerando uma política totalmente separada para o uso de IA”, diz ela. “Tudo o que fizemos em nossa política foi adicionar a palavra 'máquina'”, acrescenta ela, observando que agora a política de integridade acadêmica proíbe explicitamente o uso de uma máquina para realizar trabalhos que devem ser realizados pelo aluno.

Ela sugere que os alunos devem manter registros de como usam quaisquer ferramentas que os auxiliem, mesmo que um professor permita o uso de IA na tarefa. “Eles devem se certificar de que estão mantendo seu histórico de bate-papo” no ChatGPT, diz ela, “para que possa haver uma conversa sobre seu processo” caso alguma dúvida seja levantada posteriormente.

Um cenário em rápida mudança

Embora os verificadores gramaticais e ortográficos já existam há anos, muitos deles agora estão adicionando novos recursos de IA que complicam as coisas para os professores que tentam entender se os alunos pensaram por trás do trabalho que entregaram.

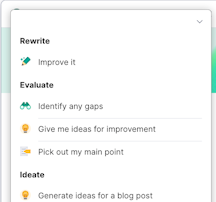

Por exemplo, Grammarly agora tem novas opções, a maioria delas em uma versão paga que Stevens não assinou, que usa IA generativa para fazer coisas como “ajudar a debater tópicos para uma tarefa” ou “construir um plano de pesquisa”, como um comunicado de imprensa recente da empresa colocá-lo.

Maxwell, da Grammarly, diz que a empresa está tentando implementar esses novos recursos com cuidado e criando proteções para evitar que os alunos apenas peçam ao bot para fazer o trabalho por eles. E ela diz que quando as escolas adotam sua ferramenta, elas podem desligar os recursos generativos de IA. “Sou mãe de um jovem de 14 anos”, diz ela, acrescentando que os alunos mais novos que ainda estão a aprender o básico têm necessidades diferentes das dos alunos mais velhos.

Chechitelli, da Turnitin, diz que é um problema para os alunos que o Grammarly e outras ferramentas de produtividade agora integrem o ChatGPT e façam muito mais do que apenas corrigir a sintaxe da escrita. Isso porque ela diz que os alunos podem não compreender os novos recursos e suas implicações.

“Um dia eles fazem login e têm novas opções e opções diferentes”, diz ela. “Eu acho que é confuso.”

Para o líder do Turnitin, a mensagem mais importante para os educadores hoje é a transparência na ajuda que a IA fornece, se houver.

“Meu conselho seria ser cuidadoso com as ferramentas que você está usando e certificar-se de que você pode mostrar aos professores a evolução de suas tarefas ou ser capaz de responder a perguntas”, diz ela.

Gallant, especialista nacional em integridade acadêmica, afirma que os professores precisam estar cientes do número crescente de ferramentas generativas de IA às quais os alunos têm acesso.

“Grammarly vai muito além da verificação gramatical e ortográfica”, diz ela. “Grammarly é como qualquer outra ferramenta – pode ser usada de forma ética ou antiética. É como eles são usados ou como seus usos são obscurecidos”.

Gallant diz que até mesmo os professores estão enfrentando esses limites éticos em seus próprios escritos e publicações em revistas acadêmicas. Ela diz que já ouviu falar de professores que usam o ChatGPT para redigir artigos de periódicos e depois “se esquecem de retirar a parte onde a IA sugeriu ideias”.

Há algo de sedutor na facilidade com que essas novas ferramentas generativas de IA podem cuspir textos bem formatados, acrescenta ela, e isso pode fazer as pessoas pensarem que estão trabalhando quando tudo o que estão fazendo é colocar um prompt em uma máquina.

“Existe uma falta de autorregulação – para todos os seres humanos, mas particularmente para os novatos e os jovens – entre o momento em que me ajuda e o momento em que faz o trabalho para mim”, diz Gallant.

- Conteúdo com tecnologia de SEO e distribuição de relações públicas. Seja amplificado hoje.

- PlatoData.Network Gerativa Vertical Ai. Capacite-se. Acesse aqui.

- PlatoAiStream. Inteligência Web3. Conhecimento Amplificado. Acesse aqui.

- PlatãoESG. Carbono Tecnologia Limpa, Energia, Ambiente, Solar, Gestão de resíduos. Acesse aqui.

- PlatoHealth. Inteligência em Biotecnologia e Ensaios Clínicos. Acesse aqui.

- Fonte: https://www.edsurge.com/news/2024-04-04-can-using-a-grammar-checker-set-off-ai-detection-software