Introdução

No cenário em constante evolução da inteligência artificial, um nome tem se destacado com destaque nos últimos anos: transformadores. Esses modelos poderosos transformaram a forma como abordamos tarefas generativas em IA, ampliando os limites do que as máquinas podem criar e imaginar. Neste artigo, nos aprofundaremos nas aplicações avançadas de transformadores em IA generativa, explorando seu funcionamento interno, casos de uso do mundo real e o impacto inovador que tiveram no campo.

Objetivos de aprendizagem

- Compreender o papel dos transformadores na IA generativa e o seu impacto em vários domínios criativos.

- Aprenda como usar transformadores para tarefas como geração de texto, chatbots, criação de conteúdo e até geração de imagens.

- Aprenda sobre transformadores avançados como MUSE-NET, DALL-E e muito mais.

- Explore as considerações éticas e os desafios associados ao uso de transformadores em IA.

- Obtenha insights sobre os avanços mais recentes em modelos baseados em transformadores e suas aplicações no mundo real.

Este artigo foi publicado como parte do Blogatona de Ciência de Dados.

Conteúdo

A ascensão dos transformadores

Antes de mergulharmos nas coisas avançadas, vamos entender o que são os transformadores e como eles se tornaram uma força motriz na IA.

Os transformadores, em sua essência, são modelos de aprendizado profundo projetados para os dados, que são sequenciais. Eles foram apresentados em um artigo histórico intitulado “Atenção é tudo que você precisa”, de Vaswani et al. em 2017. O que diferencia os transformadores é o seu mecanismo de atenção, que lhes permite encontrar ou reconhecer todo o contexto de uma sequência ao fazer previsões.

Esta inovação ajuda na revolução do processamento de linguagem natural (PNL) e nas tarefas generativas. Em vez de depender de tamanhos fixos de janela, os transformadores poderiam focar dinamicamente em diferentes partes de uma sequência, tornando-os perfeitos para capturar contexto e relacionamentos em dados.

Aplicações em geração de linguagem natural

Os transformadores encontraram sua maior fama no domínio da geração de linguagem natural. Vamos explorar algumas de suas aplicações avançadas neste domínio.

1. GPT-3 e além

Os Transformadores Gerativos Pré-treinados 3 (GPT-3) dispensam apresentações. Com seus 175 bilhões de parâmetros, é um dos maiores modelos de linguagem já criados. O GPT-3 pode gerar texto semelhante ao humano, responder perguntas, escrever ensaios e até mesmo codificar em várias linguagens de programação. Além do GPT-3, a pesquisa continua em modelos ainda mais massivos, prometendo ainda maior compreensão da linguagem e capacidades de geração.

Snippet de código: usando GPT-3 para geração de texto

import openai # Set up your API key

api_key = "YOUR_API_KEY"

openai.api_key = api_key # Provide a prompt for text generation

prompt = "Translate the following English text to French: 'Hello, how are you?'" # Use GPT-3 to generate the translation

response = openai.Completion.create( engine="text-davinci-002", prompt=prompt, max_tokens=50

) # Print the generated translation

print(response.choices[0].text)Este código configura sua chave API para GPT-3 da OpenAI e envia um prompt para tradução do inglês para o francês. GPT-3 gera a tradução e o resultado é impresso.

2. IA de conversação

Os transformadores impulsionaram a próxima geração de chatbots e assistentes virtuais. Essas entidades alimentadas por IA podem participar de conversas semelhantes às humanas, compreender o contexto e fornecer respostas precisas. Eles não estão limitados a interações com script; em vez disso, eles se adaptam às entradas do usuário, tornando-os inestimáveis para suporte ao cliente, recuperação de informações e até mesmo companheirismo.

Snippet de código: Construindo um Chatbot com Transformers

from transformers import AutoModelForCausalLM, AutoTokenizer, pipeline # Load the pre-trained GPT-3 model for chatbots

model_name = "gpt-3.5-turbo"

model = AutoModelForCausalLM.from_pretrained(model_name)

tokenizer = AutoTokenizer.from_pretrained(model_name) # Create a chatbot pipeline

chatbot = pipeline("text-davinci-002", model=model, tokenizer=tokenizer) # Start a conversation with the chatbot

conversation = chatbot("Hello, how can I assist you today?") # Display the chatbot's response

print(conversation[0]['message']['content'])Este código demonstra como construir um chatbot usando transformadores, especificamente o modelo GPT-3.5 Turbo. Ele configura o modelo e o tokenizer, cria um pipeline do chatbot, inicia uma conversa com uma saudação e imprime a resposta do chatbot.

3. Geração de conteúdo

Os transformadores são amplamente usados na geração de conteúdo. Quer se trate de criar textos de marketing, escrever artigos de notícias ou compor poesia, estes modelos demonstraram a capacidade de gerar texto coerente e contextualmente relevante, reduzindo a carga sobre os escritores humanos.

Snippet de código: gerando texto de marketing com transformadores

from transformers import pipeline # Create a text generation pipeline

text_generator = pipeline("text-generation", model="EleutherAI/gpt-neo-1.3B") # Provide a prompt for marketing copy

prompt = "Create marketing copy for a new smartphone that emphasizes its camera features." marketing_copy = text_generator(prompt, num_return_sequences=1) # Print the generated marketing copy

print(marketing_copy[0]['generated_text'])Este código mostra a geração de conteúdo usando transformadores. Ele configura um pipeline de geração de texto com o modelo GPT-Neo 1.3B, fornece um prompt para gerar uma cópia de marketing sobre uma câmera de smartphone e imprime a cópia de marketing gerada.

4. Geração de imagens

Com arquiteturas como DALL-E, os transformadores podem gerar imagens a partir de descrições textuais. Você pode descrever um conceito surreal e o DALL-E irá gerar uma imagem que corresponda à sua descrição. Isso tem implicações para arte, design e geração de conteúdo visual.

Snippet de código: Gerando imagens com DALL-E

# Example using OpenAI's DALL-E API (Please note: You would need valid API credentials)

import openai # Set up your API key

api_key = "YOUR_API_KEY_HERE" # Initialize the OpenAI API client

client = openai.Api(api_key) # Describe the image you want to generate

description = "A surreal landscape with floating houses in the clouds." # Generate the image using DALL-E

response = client.images.create(description=description) # Access the generated image URL

image_url = response.data.url # You can now download or display the image using the provided URL

print("Generated Image URL:", image_url)Este código usa DALL-E da OpenAI para gerar uma imagem baseada em uma descrição textual. Você fornece uma descrição da imagem desejada e o DALL-E cria uma imagem que corresponda a ela. A imagem gerada é salva em um arquivo.

5. Composição Musical

Os transformadores podem ajudar a criar música. Como MuseNet da OpenAI; eles podem fazer novas músicas em estilos diferentes. Isto é emocionante para a música e a arte, dando novas ideias e oportunidades para a criatividade no mundo da música.

Snippet de código: Compondo música com MuseNet

# Example using OpenAI's MuseNet API (Please note: You would need valid API credentials)

import openai # Set up your API key

api_key = "YOUR_API_KEY_HERE" # Initialize the OpenAI API client

client = openai.Api(api_key) # Describe the type of music you want to generate

description = "Compose a classical piano piece in the style of Chopin." # Generate music using MuseNet

response = client.musenet.compose( prompt=description, temperature=0.7, max_tokens=500 # Adjust this for the desired length of the composition

) # Access the generated music

music_c = response.choices[0].text print("Generated Music Composition:")

print(music_c)Este código Python demonstra como usar a API MuseNet da OpenAI para gerar composições musicais. Ele começa configurando sua chave de API, descrevendo o tipo de música que você deseja criar (por exemplo, piano clássico no estilo Chopin) e depois chama a API para gerar a música. A composição resultante pode ser acessada e salva ou reproduzida conforme desejado.

Observação: substitua “YOUR_API_KEY_HERE” pela sua chave de API OpenAI real.

Explorando transformadores avançados: MUSE-NET, DALL-E e mais

No mundo em rápida mudança da IA, os transformadores avançados estão liderando desenvolvimentos emocionantes em IA criativa. Modelos como MUSE-NET e DALL-E estão indo além da simples compreensão da linguagem e agora estão sendo criativos, apresentando novas ideias e gerando diferentes tipos de conteúdo.

O poder criativo do MUSE-NET

MUSE-NET é um exemplo fantástico do que os transformadores avançados podem fazer. Criado pela OpenAI, este modelo vai além das capacidades habituais de IA ao fazer a sua própria música. Ele pode criar música em diferentes estilos, como clássico ou pop, e faz um bom trabalho ao fazer com que pareça que foi feita por um humano.

Aqui está um trecho de código para ilustrar como o MUSE-NET pode gerar uma composição musical:

from muse_net import MuseNet # Initialize the MUSE-NET model

muse_net = MuseNet() compose_l = muse_net.compose(style="jazz", length=120)

compose_l.play()DALL-E: O Artista Transformador

DALL-E, feito pela OpenAI, é uma criação inovadora que traz transformadores para o mundo visual. Ao contrário dos modelos de linguagem regular, o DALL-E pode criar imagens a partir de palavras escritas. É como um verdadeiro artista transformando texto em imagens coloridas e criativas.

Aqui está um exemplo de como DALL-E pode dar vida ao texto:

from dalle_pytorch import DALLE # Initialize the DALL-E model

dall_e = DALLE() # Generate an image from a textual description

image = dall_e.generate_image("a surreal landscape with floating islands")

display(image)

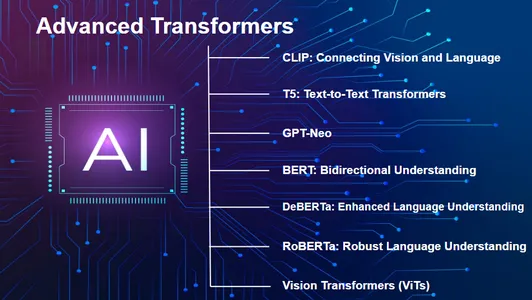

CLIP: Conectando Visão e Linguagem

CLIP by OpenAI combina visão e compreensão da linguagem. Ele pode compreender imagens e texto juntos, permitindo tarefas como classificação de imagem zero-shot com prompts de texto.

import torch

import clip # Load the CLIP model

device = "cuda" if torch.cuda.is_available() else "cpu"

model, transform = clip.load("ViT-B/32", device) # Prepare image and text inputs

image = transform(Image.open("image.jpg")).unsqueeze(0).to(device)

text_inputs = torch.tensor(["a photo of a cat", "a picture of a dog"]).to(device) # Get image and text features

image_features = model.encode_image(image)

text_features = model.encode_text(text_inputs)CLIP combina visão e compreensão da linguagem. Este código carrega o modelo CLIP, prepara entradas de imagem e texto e as codifica em vetores de recursos, permitindo executar tarefas como classificação de imagem zero-shot com prompts de texto.

T5: Transformadores de texto em texto

Os modelos T5 tratam todas as tarefas de PNL como problemas de texto para texto, simplificando a arquitetura do modelo e alcançando desempenho de última geração em várias tarefas.

from transformers import T5ForConditionalGeneration, T5Tokenizer # Load the T5 model and tokenizer

model = T5ForConditionalGeneration.from_pretrained("t5-small")

tokenizer = T5Tokenizer.from_pretrained("t5-small") # Prepare input text

input_text = "Translate English to French: 'Hello, how are you?'" # Tokenize and generate translation

input_ids = tokenizer.encode(input_text, return_tensors="pt")

translation = model.generate(input_ids)

output_text = tokenizer.decode(translation[0], skip_special_tokens=True) print("Translation:", output_text)O modelo trata todas as tarefas de PNL como problemas de texto para texto. Este código carrega um modelo T5, tokeniza um texto de entrada e gera uma tradução do inglês para o francês.

GPT-Neo: Reduzindo para eficiência

GPT-Neo é uma série de modelos desenvolvidos pela EleutherAI. Esses modelos oferecem recursos semelhantes aos modelos de linguagem de grande escala, como GPT-3, mas em menor escala, tornando-os mais acessíveis para vários aplicativos e, ao mesmo tempo, mantendo um desempenho impressionante.

- O código dos modelos GPT-Neo é semelhante ao GPT-3, com diferentes nomes e tamanhos de modelos.

BERT: compreensão bidirecional

BERT (Bidirecional Encoder Representations from Transformers), desenvolvido pelo Google, tem como foco a compreensão do contexto na linguagem. Ele estabeleceu novos padrões em uma ampla gama de tarefas de compreensão de linguagem natural.

- O BERT é comumente usado para pré-treinamento e ajuste fino de tarefas de PNL, e seu uso geralmente depende da tarefa específica.

DeBERTa: compreensão aprimorada do idioma

DeBERTa (BERT aprimorado por decodificação com atenção desembaraçada) aprimora o BERT introduzindo mecanismos de atenção desembaraçada, melhorando a compreensão da linguagem e reduzindo os parâmetros do modelo.

- O DeBERTa normalmente segue os mesmos padrões de uso do BERT para várias tarefas de PNL.

RoBERTa: compreensão robusta da linguagem

RoBERTa baseia-se na arquitetura do BERT, mas a aprimora com um regime de treinamento mais extenso, alcançando resultados de última geração em uma variedade de benchmarks de processamento de linguagem natural.

- O uso do RoBERTa é semelhante ao BERT e DeBERTa para tarefas de PNL, com algumas variações de ajuste fino.

Transformadores de Visão (ViTs)

Transformadores de visão como o que você viu anteriormente neste artigo fizeram avanços notáveis na visão computacional. Eles aplicam os princípios dos transformadores a tarefas baseadas em imagens, demonstrando sua versatilidade.

import torch

from transformers import ViTFeatureExtractor, ViTForImageClassification # Load a pre-trained Vision Transformer (ViT) model

model_name = "google/vit-base-patch16-224-in21k"

feature_extractor = ViTFeatureExtractor(model_name)

model = ViTForImageClassification.from_pretrained(model_name) # Load and preprocess a medical image

from PIL import Image image = Image.open("image.jpg")

inputs = feature_extractor(images=image, return_tensors="pt") # Get predictions from the model

outputs = model(**inputs)

logits_per_image = outputs.logitsEste código carrega um modelo ViT, processa uma imagem e obtém previsões do modelo, demonstrando seu uso em visão computacional.

Esses modelos, juntamente com o MUSE-NET e o DALL-E, mostram coletivamente os rápidos avanços na IA baseada em transformadores, abrangendo linguagem, visão, criatividade e eficiência. À medida que o campo avança, podemos antecipar desenvolvimentos e aplicações ainda mais interessantes.

Transformadores: Desafios e Considerações Éticas

À medida que abraçamos as capacidades notáveis dos transformadores na IA generativa, é essencial considerar os desafios e as preocupações éticas que os acompanham. Aqui estão alguns pontos críticos a serem ponderados:

- Dados tendenciosos: Os transformadores podem aprender e repetir coisas injustas a partir de seus dados de treinamento, piorando os estereótipos. Corrigir isso é uma obrigação.

- Usando transformadores corretamente: Como os transformadores podem criar coisas, precisamos usá-los com cuidado para impedir coisas falsas e informações ruins.

- Preocupações com privacidade: Quando a IA faz coisas, pode prejudicar a privacidade ao copiar pessoas e segredos.

- Dificíl de entender: Os transformadores podem ser como uma caixa preta – nem sempre podemos dizer como eles tomam decisões, o que torna difícil confiar neles.

- Leis necessárias: Criar regras para a IA, como para os transformadores, é difícil, mas necessário.

- Notícias falsas: Os transformadores podem fazer mentiras parecerem reais, o que coloca a verdade em perigo.

- Uso de energia: Treinar grandes transformadores exige muito poder do computador, o que pode ser ruim para o meio ambiente.

- Acesso justo: Todos deveriam ter uma chance justa de usar transformadores do tipo IA, não importa onde estejam.

- Humanos e IA: Ainda estamos descobrindo quanto poder a IA deveria ter em comparação com as pessoas.

- Impacto futuro: Precisamos de nos preparar para a forma como a IA, tal como os transformadores, mudará a sociedade, o dinheiro e a cultura. É um grande negócio.

É imperativo enfrentar estes desafios e abordar considerações éticas, uma vez que os transformadores continuam a desempenhar um papel fundamental na definição do futuro da IA generativa. O desenvolvimento e a utilização responsáveis são fundamentais para aproveitar o potencial destas tecnologias transformadoras, salvaguardando ao mesmo tempo os valores sociais e o bem-estar.

Vantagens dos transformadores em IA generativa

- Criatividade Aprimorada: Os Transformers permitem que a IA gere conteúdo criativo como música, arte e texto que não era possível antes.

- Compreensão contextual: Seus mecanismos de atenção permitem que os transformadores compreendam melhor o contexto e os relacionamentos, resultando em resultados mais significativos e coerentes.

- Capacidades multimodais: Transformadores como o DALL-E preenchem a lacuna entre texto e imagens, ampliando o leque de possibilidades generativas.

- Eficiência e Escalabilidade: Modelos como GPT-3 e GPT-Neo oferecem desempenho impressionante e são mais eficientes em termos de recursos do que seus antecessores.

- Aplicações versáteis: Os transformadores podem ser aplicados em vários domínios, desde a criação de conteúdo até a tradução de idiomas e muito mais.

Desvantagens dos transformadores na IA generativa

- Viés de dados: Os transformadores podem replicar preconceitos presentes em seus dados de treinamento, levando a conteúdo tendencioso ou gerado injustamente.

- Preocupações éticas: O poder de criar textos e imagens levanta questões éticas, como deepfakes e o potencial para desinformação.

- Riscos de privacidade: Os Transformers podem gerar conteúdo que viola a privacidade pessoal, como gerar textos falsos ou imagens que se fazem passar por indivíduos.

- Falta de Transparência: Os transformadores muitas vezes produzem resultados difíceis de explicar, dificultando a compreensão de como chegaram a um resultado específico.

- Impacto ambiental: O treinamento de grandes transformadores requer recursos computacionais substanciais, contribuindo para o consumo de energia e para as preocupações ambientais.

Conclusão

Os transformadores trouxeram uma nova era de criatividade e habilidade para a IA. Eles podem fazer mais do que apenas enviar mensagens de texto; eles gostam de música e arte também. Mas temos que ter cuidado. As grandes potências precisam de grandes responsabilidades. À medida que exploramos o que os transformadores podem fazer, devemos pensar no que é certo. Precisamos ter certeza de que eles ajudam a sociedade e não a prejudicam. O futuro da IA pode ser incrível, mas todos temos que garantir que seja bom para todos.

Principais lições

- Os transformadores são modelos revolucionários em IA, conhecidos por seu processamento sequencial de dados e mecanismos de atenção.

- Eles se destacam na geração de linguagem natural, potencializando chatbots, geração de conteúdo e até mesmo geração de código com modelos como GPT-3.

- Transformers como MUSE-NET e DALL-E estendem suas capacidades criativas à composição musical e geração de imagens.

- Considerações éticas, como preconceito de dados, preocupações com privacidade e uso responsável, são cruciais ao trabalhar com Transformers.

- Os transformadores estão na vanguarda da tecnologia de IA, com aplicações que abrangem compreensão linguística, criatividade e eficiência.

Perguntas Frequentes

Resp. Os transformadores são distintos por seus mecanismos de atenção, permitindo-lhes considerar todo o contexto de uma sequência, tornando-os excepcionais na captura de contexto e relacionamentos em dados.

Resp. Você pode usar a API GPT-3 da OpenAI para gerar texto fornecendo um prompt e recebendo uma resposta gerada.

Resp. Transformers como o MUSE-NET podem compor músicas com base em descrições, e o DALL-E pode gerar imagens a partir de instruções de texto, abrindo possibilidades criativas.

Resp. Ao usar transformadores em IA generativa, devemos estar cientes do preconceito de dados, da geração ética de conteúdo, das preocupações com a privacidade e do uso responsável de conteúdo gerado por IA para evitar uso indevido e desinformação.

A mídia mostrada neste artigo não é propriedade da Analytics Vidhya e é usada a critério do Autor.

Relacionado

- Conteúdo com tecnologia de SEO e distribuição de relações públicas. Seja amplificado hoje.

- PlatoData.Network Gerativa Vertical Ai. Capacite-se. Acesse aqui.

- PlatoAiStream. Inteligência Web3. Conhecimento Amplificado. Acesse aqui.

- PlatãoESG. Carbono Tecnologia Limpa, Energia, Ambiente, Solar, Gestão de resíduos. Acesse aqui.

- PlatoHealth. Inteligência em Biotecnologia e Ensaios Clínicos. Acesse aqui.

- Fonte: https://www.analyticsvidhya.com/blog/2023/10/unlocking-creativity-with-advanced-transformers-in-generative-ai/