Você já pensou em como mecanismos de busca como o Google encontram as respostas perfeitas para suas perguntas em segundos?

Nos bastidores de cada consulta de pesquisa existe um processo complexo conhecido como indexação de mecanismos de pesquisa, um mecanismo fundamental que permite aos mecanismos de pesquisa organizar, analisar e recuperar conteúdo relevante da web.

Se você deseja otimizar sua presença online, é importante compreender a indexação do mecanismo de pesquisa.

Nesta postagem, forneceremos a você uma compreensão abrangente da indexação de mecanismos de pesquisa.

Portanto, sem mais delongas, vamos explorar detalhadamente a indexação dos mecanismos de pesquisa.

1 O que é indexação de mecanismos de pesquisa?

A indexação de mecanismos de pesquisa é como criar um enorme catálogo ou índice de todo o conteúdo disponível na internet.

Envolve verificar, analisar e organizar sistematicamente páginas da web, documentos, imagens, vídeos e todos os outros tipos de conteúdo para que os mecanismos de pesquisa possam recuperar rapidamente informações relevantes em resposta às consultas do público.

O processo de indexação de mecanismos de pesquisa envolve as seguintes etapas:

- Rastejando: Os rastreadores de mecanismos de pesquisa, também conhecidos como spiders ou bots, navegam sistematicamente na web, visitando páginas da web e seguindo links para descobrir novos conteúdos.

- Indexação: Esta etapa envolve o processamento e análise do conteúdo textual, bem como tags-chave e atributos como , atributos alt para imagens, vídeos, etc. As informações extraídas são então armazenadas em um banco de dados de índice estruturado, que permite ao mecanismo de pesquisa recuperar e servir rapidamente conteúdo relevante em resposta às consultas do usuário.

- Ranking: Finalmente, os motores de busca utilizam algoritmos complexos para classificar as páginas indexadas com base na relevância, autoridade e envolvimento do utilizador, garantindo que o conteúdo mais relevante e útil apareça no topo dos resultados de pesquisa.

Antes de discutirmos como funciona a indexação de mecanismos de pesquisa, vamos entender a importância da indexação para mecanismos de pesquisa.

2 Importância da indexação de mecanismos de pesquisa

A indexação é importante para os motores de busca porque lhes permite processar e recuperar informações da Internet de forma eficiente.

Sem indexação, os mecanismos de pesquisa terão dificuldade para fornecer resultados precisos e oportunos ao público.

A indexação permite que os mecanismos de pesquisa localizem e recuperem rapidamente informações relevantes de bilhões de páginas da web, garantindo que seu público receba resultados de pesquisa precisos e oportunos.

Ao organizar e categorizar o conteúdo da web, a indexação ajuda os mecanismos de pesquisa a oferecer uma melhor experiência ao usuário, apresentando ao público informações relevantes e úteis em resposta às suas consultas.

Também ajuda os mecanismos de pesquisa a lidar com consultas de pesquisa complexas, identificando e recuperando rapidamente conteúdo relevante de uma variedade de fontes, formatos e idiomas.

A indexação ajuda o público a descobrir conteúdo novo e relevante, facilitando a navegação.

3 Como funciona a indexação do mecanismo de pesquisa

Como discutimos brevemente, os mecanismos de pesquisa incluem rastreamento, indexação e classificação para indexar um site. Vamos agora discuti-los em detalhes.

3.1 Rastejando

O rastreamento, no contexto dos motores de busca, refere-se ao processo de navegação sistemática na web para descobrir e recuperar páginas da web e outros conteúdos online.

Papel dos rastreadores da Web

Rastreadores da Web, também conhecidos como spiders ou bots (Googlebots), desempenham um papel importante no processo de rastreamento. Eles atuam como agentes automatizados que percorrem a internet, visitando páginas web e coletando dados para serem indexados pelos buscadores.

Os rastreadores da Web são responsáveis por descobrir novos conteúdos, atualizar as informações existentes e garantir que os índices dos mecanismos de pesquisa sejam abrangentes e atualizados.

Como os rastreadores da Web descobrem novos conteúdos

Os rastreadores da Web usam várias técnicas para descobrir novos conteúdos na web.

Um método comum é começar com uma lista de páginas da web conhecidas e seguir os links dessas páginas para outras páginas.

Os rastreadores também utilizam sitemaps, que são arquivos XML que fornecem um roteiro da estrutura de um site e ajudam os rastreadores a navegar e descobrir o conteúdo com mais eficiência.

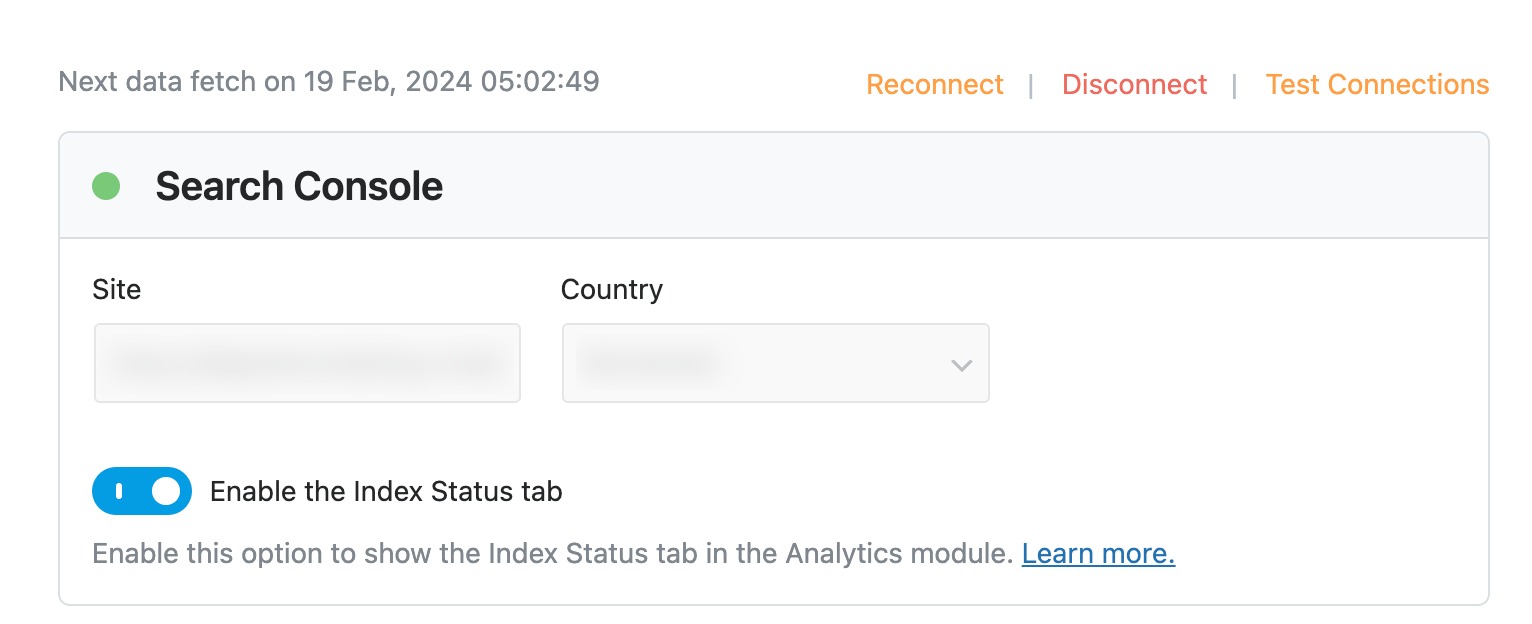

Se você estiver usando o Rank Math Dados recurso, ele automaticamente envia o mapa do site para o Google Search Console. Nenhum envio manual é necessário se você conectou o Rank Math à sua conta do Google e definiu as configurações do Search Console.

Você pode aprender mais sobre Sitemaps em nosso artigo dedicado e corrigir os problemas do mapa do site se você tiver qualquer.

Técnicas usadas por web crawlers para navegar e coletar dados de sites

Os rastreadores da Web usam diversas técnicas para navegar e coletar dados de sites:

- Travessia de link: Os rastreadores seguem hiperlinks de uma página da web para outra, explorando sistematicamente a rede interconectada da web.

- Normalização de URL: Os rastreadores normalizam URLs para garantir consistência e evitar o rastreamento de conteúdo duplicado ou redundante.

- Robôs.txt: Os rastreadores verificam se há um arquivo robots.txt em sites para determinar quais páginas devem ser rastreadas e quais devem ser excluídas.

- Análise de HTML: Os rastreadores analisam o código HTML das páginas da web para extrair informações como texto, links, imagens e metadados.

3.2 Indexação

A indexação é a análise de um trecho de texto ou código de acordo com um conjunto de regras ou sintaxe.

Inicialmente, o rastreador da web recupera o código HTML de uma página da web do servidor. Uma vez obtido o código HTML, ele passa pela análise de HTML, onde é analisado para identificar a estrutura e diversos elementos da página web, incluindo títulos, parágrafos, links, imagens e metadados.

Posteriormente, o analisador extrai o conteúdo textual do código HTML, incluindo o corpo do texto, títulos e outros elementos de texto visíveis, para capturar a essência do conteúdo da página.

Elementos de metadados, como tags de título, descrição metae meta palavras-chave são analisadas para enriquecer a compreensão do conteúdo da página.

Lidando com conteúdo duplicado e problemas de canonização

A indexação também envolve resolver problemas de conteúdo duplicado e canonização, que podem surgir quando vários URLs apontam para conteúdo igual ou semelhante. Isso pode envolver:

- Identificar URLs canônicos e consolidar conteúdo duplicado para evitar a indexação de páginas redundantes.

- Implementando tags canônicas ou 301 redireciona para especificar o URL preferido para indexação.

- Detectar e manipular conteúdo distribuído ou duplicado de diferentes fontes para garantir indexação e classificação precisas.

Consulte nosso vídeo abaixo para definir tags canônicas no Rank Math.

Como os motores de busca determinam a relevância e importância das páginas indexadas

Os motores de busca usam algoritmos de classificação complexos para determinar a relevância e importância das páginas indexadas.

Esses algoritmos consideram vários fatores, como a presença de termos de pesquisa no conteúdo, a qualidade e autoridade do site, métricas de engajamento do usuário e relevância contextual.

As páginas mais relevantes e importantes recebem classificações mais altas nos resultados de pesquisa, garantindo que o público receba o conteúdo mais relevante e útil em resposta às suas consultas.

3.3 Posição

Depois que as páginas forem rastreadas e indexadas, é hora de classificá-las.

Os mecanismos de pesquisa utilizam vários algoritmos, como o PageRank, para determinar as classificações, que avaliam a qualidade e a quantidade dos links recebidos em uma página.

Vários fatores influenciam o classificação de páginas da web. A relevância para a consulta de pesquisa é importante, com páginas contendo conteúdo que corresponda melhor à intenção do usuário, normalmente recebendo classificações mais altas.

A autoridade desempenha um papel significativo, considerando fatores como a credibilidade do site, a qualidade do conteúdo e o número de sites confiáveis com links para ele.

Métricas de engajamento do usuário, como taxas de cliques, taxas de rejeição e tempo gasto em uma página, também influenciam as classificações, refletindo a satisfação do usuário e o interesse no conteúdo.

4 Perguntas Frequentes

Qual é a diferença entre rastreamento e indexação?

O rastreamento envolve descobrir e buscar páginas da web, enquanto a indexação envolve analisar e armazenar informações dessas páginas em um banco de dados pesquisável.

Qual é o impacto da velocidade de carregamento da página na indexação?

As páginas de carregamento mais rápido são priorizadas pelos mecanismos de pesquisa durante a indexação, pois proporcionam uma melhor experiência ao usuário e têm maior probabilidade de obter uma classificação mais elevada nos resultados de pesquisa.

Como você pode melhorar a visibilidade do seu site nos resultados de pesquisas?

Você pode melhorar a visibilidade nos resultados do mecanismo de pesquisa criando conteúdo relevante e de alta qualidade, otimizando os sites para compatibilidade e velocidade com dispositivos móveis, obtendo backlinks confiáveis de fontes confiáveis e aderindo a práticas recomendadas para otimização de mecanismos de pesquisa (SEO).

Com que frequência os índices dos mecanismos de pesquisa são atualizados?

Os índices dos mecanismos de pesquisa são atualizados continuamente para refletir as alterações e atualizações no conteúdo da web, com a frequência das atualizações variando dependendo de fatores como a popularidade e a importância do site.

Que erros comuns podem impedir que uma página da web seja indexada?

Erros comuns que podem impedir a indexação de uma página da web incluem o bloqueio de rastreadores de mecanismos de pesquisa com arquivos robots.txt, o uso de meta tags de robôs para evitar a indexação e erros de rastreamento, como links quebrados ou erros de servidor.

5 Conclusão

A indexação dos mecanismos de pesquisa desempenha um papel importante na forma como os sites são descobertos e classificados pelos mecanismos de pesquisa.

Ao rastrear e analisar páginas da web, os mecanismos de pesquisa criam um índice organizado de informações para fornecer resultados de pesquisa relevantes e precisos ao seu público.

Compreender o processo de indexação do mecanismo de pesquisa pode ajudá-lo a otimizar suas páginas para obter melhor visibilidade e classificações mais altas.

Então, da próxima vez que você pesquisar algo online, lembre-se que existe um sistema complexo de indexação nos bastidores, garantindo que você encontre os resultados mais relevantes em segundos.

Boa busca!

Se você gostou deste post, avise-nos por Tweetando @rankmathseo.

- Conteúdo com tecnologia de SEO e distribuição de relações públicas. Seja amplificado hoje.

- PlatoData.Network Gerativa Vertical Ai. Capacite-se. Acesse aqui.

- PlatoAiStream. Inteligência Web3. Conhecimento Amplificado. Acesse aqui.

- PlatãoESG. Carbono Tecnologia Limpa, Energia, Ambiente, Solar, Gestão de resíduos. Acesse aqui.

- PlatoHealth. Inteligência em Biotecnologia e Ensaios Clínicos. Acesse aqui.

- Fonte: https://rankmath.com/blog/how-search-engine-indexing-works/