Imagem do autor

Large Language Models (LLMs) são um novo tipo de inteligência artificial treinada em grandes quantidades de dados de texto. Sua principal capacidade é gerar texto semelhante ao humano em resposta a uma ampla variedade de solicitações e solicitações.

Aposto que você já teve alguma experiência com soluções LLM populares como ChatGPT ou Google Gemini.

Mas você já se perguntou como esses modelos poderosos oferecem respostas tão rápidas?

A resposta está em um campo especializado chamado LLMOps.

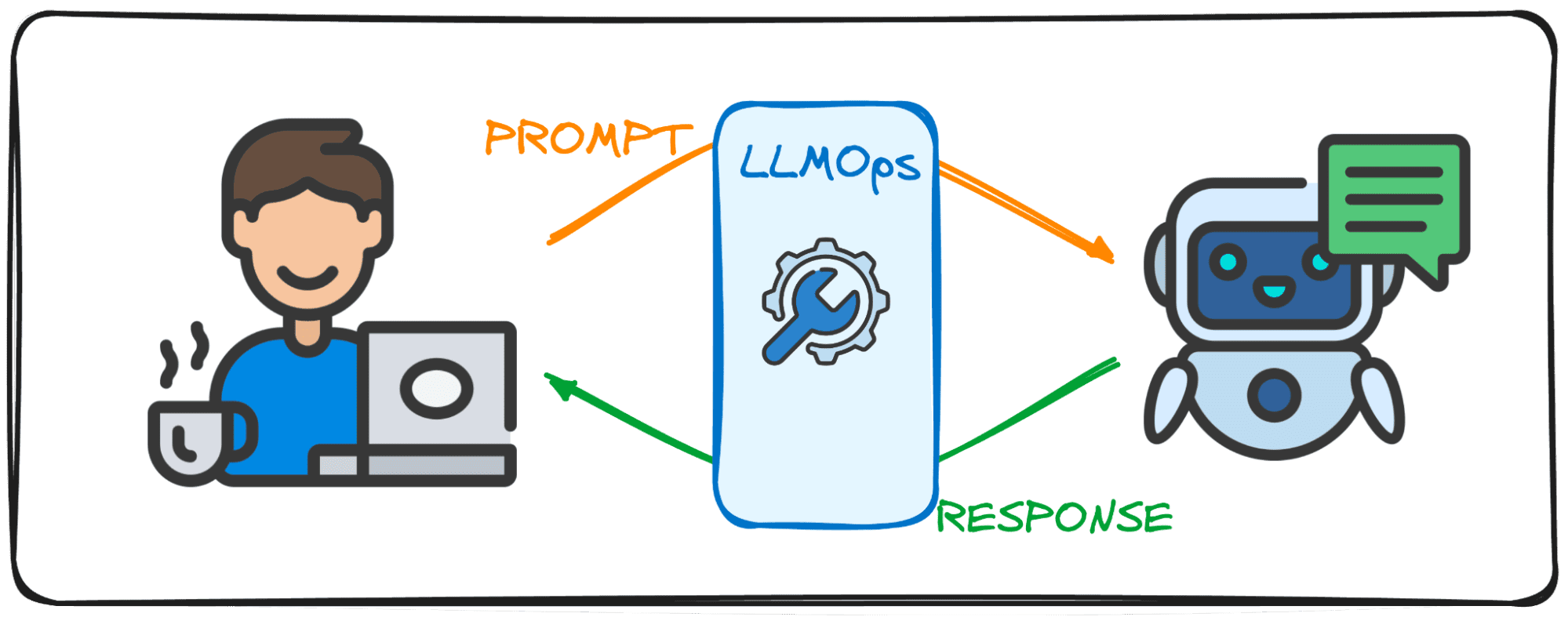

Antes de mergulharmos, vamos tentar visualizar a importância deste campo.

Imagine que você está conversando com um amigo. O normal que você esperaria é que, ao fazer uma pergunta, eles lhe dessem uma resposta imediata e o diálogo fluísse sem esforço.

Certo?

Essa troca tranquila é o que os usuários também esperam ao interagir com Large Language Models (LLMs). Imagine conversar com o ChatGPT e ter que esperar alguns minutos toda vez que enviamos um prompt, ninguém usaria, pelo menos eu não usaria com certeza.

É por isso que os LLMs pretendem alcançar esse fluxo de conversação e eficácia em suas soluções digitais com a área de LLMOps. Este guia pretende ser seu companheiro nos primeiros passos neste novo domínio.

LLMOps, abreviação de Large Language Model Operations, é a mágica dos bastidores que garante que os LLMs funcionem de maneira eficiente e confiável. Representa um avanço em relação aos MLOps familiares, projetados especificamente para enfrentar os desafios únicos apresentados pelos LLMs.

Enquanto o MLOps se concentra no gerenciamento do ciclo de vida de modelos gerais de aprendizado de máquina, o LLMOps lida especificamente com os requisitos específicos do LLM.

Ao utilizar modelos de entidades como OpenAI ou Anthropic por meio de interfaces web ou API, os LLMOps trabalham nos bastidores, tornando esses modelos acessíveis como serviços. No entanto, ao implantar um modelo para uma aplicação especializada, a responsabilidade do LLMOps depende de nós.

Então pense nisso como um moderador cuidando do fluxo de um debate. Assim como o moderador mantém a conversa fluente e alinhada ao tema do debate, sempre garantindo que não haja palavrões e tentando evitar notícias falsas, o LLMOps garante que os LLMs operem com desempenho máximo, proporcionando experiências de usuário perfeitas e verificando a segurança do saída.

A criação de aplicativos com Large Language Models (LLMs) apresenta desafios distintos daqueles observados no aprendizado de máquina convencional. Para navegar nestes, foram criadas ferramentas e metodologias de gestão inovadoras, dando origem ao quadro LLMOps.

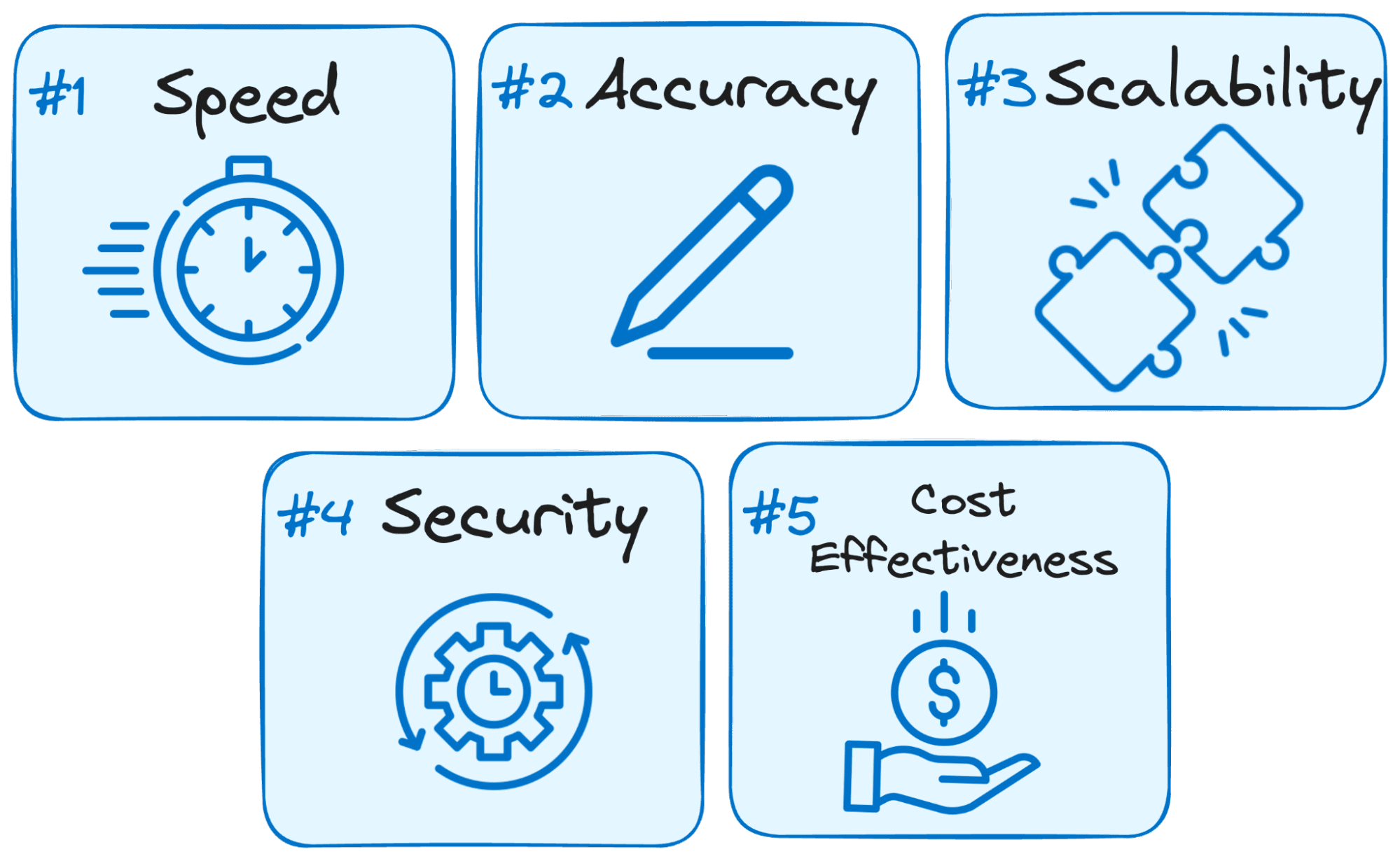

Veja por que o LLMOps é crucial para o sucesso de qualquer aplicativo baseado em LLM:

Imagem do autor

- Velocidade é a chave: Os usuários esperam respostas imediatas ao interagir com LLMs. O LLMOps otimiza o processo para minimizar a latência, garantindo que você obtenha respostas dentro de um prazo razoável.

- Precisão é importante: O LLMOps implementa diversas verificações e controles para garantir a precisão e relevância das respostas do LLM.

- Escalabilidade para crescimento: À medida que seu aplicativo LLM ganha força, o LLMOps ajuda você a dimensionar recursos de maneira eficiente para lidar com o aumento das cargas de usuários.

- Segurança é fundamental: LLMOps salvaguarda a integridade do sistema LLM e protege dados confidenciais, aplicando medidas de segurança robustas.

- Custo-benefício: A operação de LLMs pode ser financeiramente exigente devido aos seus requisitos significativos de recursos. LLMOps utiliza métodos econômicos para maximizar a utilização de recursos de forma eficiente, garantindo que o desempenho máximo não seja sacrificado.

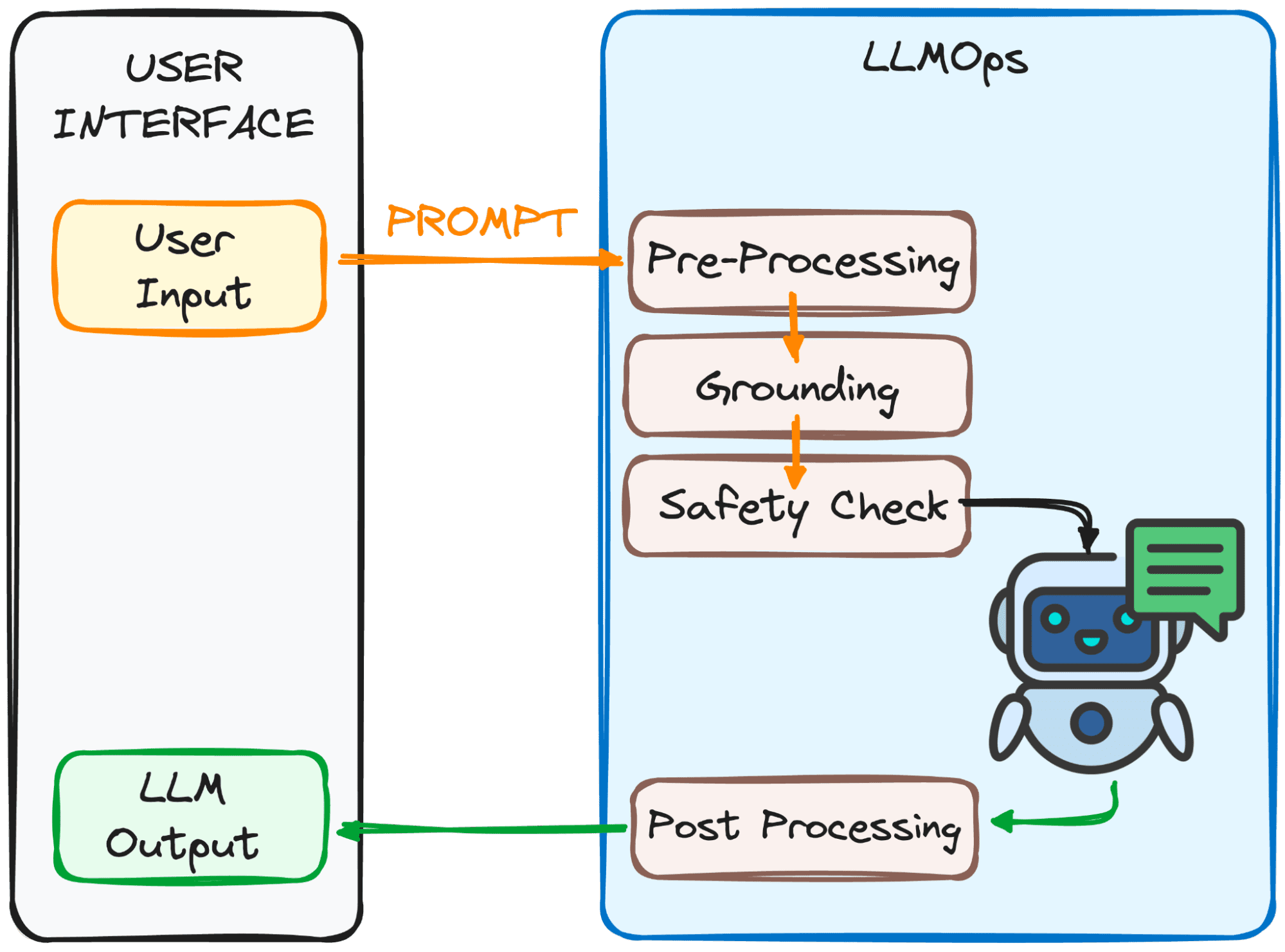

O LLMOps garante que seu prompt esteja pronto para o LLM e que sua resposta chegue a você o mais rápido possível. No entanto, isso não é nada fácil.

Este processo envolve diversas etapas, principalmente a 4, que podem ser observadas na imagem abaixo.

Imagem do autor

O objetivo dessas etapas?

Para tornar o prompt claro e compreensível para o modelo.

Aqui está um detalhamento dessas etapas:

1. Pré-processamento

O prompt passa por uma primeira etapa de processamento. Primeiro, ele é dividido em pedaços menores (tokens). Em seguida, quaisquer erros de digitação ou caracteres estranhos são eliminados e o texto é formatado de forma consistente.

Finalmente, os tokens são incorporados aos dados numéricos para que o LLM os entenda.

2. Aterramento

Antes de o modelo processar nosso prompt, precisamos ter certeza de que o modelo entende o panorama geral. Isso pode envolver a referência a conversas anteriores que você teve com o LLM ou o uso de informações externas.

Além disso, o sistema identifica coisas importantes mencionadas no prompt (como nomes ou locais) para tornar a resposta ainda mais relevante.

3. Verificação de segurança:

Assim como definir regras de segurança, o LLMOps garante que o prompt seja usado de maneira adequada. O sistema verifica informações como informações confidenciais ou conteúdo potencialmente ofensivo.

Somente depois de passar nessas verificações o prompt estará pronto para o ato principal – o LLM!

Agora temos nosso prompt pronto para ser processado pelo LLM. No entanto, o seu resultado também precisa ser analisado e processado. Então, antes que você veja, há mais alguns ajustes realizados na quarta etapa:

3. Pós-processamento

Lembra do código em que o prompt foi convertido? A resposta precisa ser traduzida de volta para um texto legível. Depois, o sistema aprimora a resposta em termos de gramática, estilo e clareza.

Todas essas etapas acontecem perfeitamente graças ao LLMOps, o membro invisível da tripulação que garante uma experiência LLM tranquila.

Impressionante, certo?

Aqui estão alguns dos blocos de construção essenciais de uma configuração de LLMOps bem projetada:

- Escolhendo o LLM certo: Com uma vasta gama de modelos LLM disponíveis, o LLMOps ajuda você a selecionar aquele que melhor se alinha às suas necessidades e recursos específicos.

- Ajuste fino para especificidade: O LLMOps permite que você ajuste modelos existentes ou treine os seus próprios, personalizando-os para seu caso de uso exclusivo.

- Engenharia de Prompt: O LLMOps fornece técnicas para criar instruções eficazes que orientam o LLM em direção ao resultado desejado.

- Implantação e monitoramento: O LLMOps agiliza o processo de implantação e monitora continuamente o desempenho do LLM, garantindo funcionalidade ideal.

- Salvaguardas de segurança: O LLMOps prioriza a segurança dos dados implementando medidas robustas para proteger informações confidenciais.

À medida que a tecnologia LLM continua a evoluir, os LLMOps desempenharão um papel crítico nos próximos desenvolvimentos tecnológicos. A maior parte do sucesso das soluções populares mais recentes, como ChatGPT ou Google Gemini, é sua capacidade não apenas de responder a quaisquer solicitações, mas também de fornecer uma boa experiência ao usuário.

É por isso que, ao garantir uma operação eficiente, confiável e segura, os LLMOps abrirão caminho para aplicações LLM ainda mais inovadoras e transformadoras em vários setores, que chegarão a ainda mais pessoas.

Com um conhecimento sólido de LLMOps, você estará bem equipado para aproveitar o poder desses LLMs e criar aplicativos inovadores.

Joseph Ferrer é um engenheiro analítico de Barcelona. Formou-se em engenharia física e atualmente atua na área de ciência de dados aplicada à mobilidade humana. Ele é criador de conteúdo em meio período com foco em ciência e tecnologia de dados. Josep escreve sobre tudo relacionado à IA, cobrindo a aplicação da explosão contínua no campo.

- Conteúdo com tecnologia de SEO e distribuição de relações públicas. Seja amplificado hoje.

- PlatoData.Network Gerativa Vertical Ai. Capacite-se. Acesse aqui.

- PlatoAiStream. Inteligência Web3. Conhecimento Amplificado. Acesse aqui.

- PlatãoESG. Carbono Tecnologia Limpa, Energia, Ambiente, Solar, Gestão de resíduos. Acesse aqui.

- PlatoHealth. Inteligência em Biotecnologia e Ensaios Clínicos. Acesse aqui.

- Fonte: https://www.kdnuggets.com/getting-started-with-llmops-the-secret-sauce-behind-seamless-interactions?utm_source=rss&utm_medium=rss&utm_campaign=getting-started-with-llmops-the-secret-sauce-behind-seamless-interactions