See CHANGELOG para obter os recursos e correções mais recentes.

Você provavelmente já experimentou o desafio de fazer anotações durante uma reunião enquanto tentava prestar atenção na conversa. Você provavelmente também já sentiu a necessidade de verificar rapidamente algo que foi dito ou procurar informações para responder a uma pergunta que acabou de ser feita na ligação. Ou talvez você tenha um membro da equipe que sempre chega atrasado às reuniões e espera que você envie um rápido resumo pelo chat para atualizá-lo.

Depois, há momentos em que outras pessoas estão falando em um idioma que não é o seu primeiro idioma, e você adoraria ter uma tradução ao vivo do que as pessoas estão dizendo para ter certeza de que entendeu corretamente.

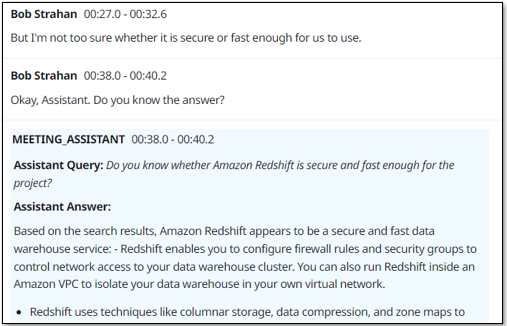

E após o término da chamada, geralmente você deseja capturar um resumo para seus registros, ou enviar aos participantes, com uma lista de todos os itens de ação, proprietários e datas de vencimento.

Tudo isso e muito mais agora é possível com nossa mais nova solução de exemplo, o Live Meeting Assistant (LMA).

Confira a demonstração a seguir para ver como funciona.

Neste post, mostramos como usar o LMA com Amazon Transcribe, Rocha Amazônica e Bases de conhecimento para Amazon Bedrock.

Visão geral da solução

A solução de amostra LMA captura o áudio e os metadados do palestrante do seu aplicativo de reunião baseado em navegador (no momento em que este livro foi escrito, Zoom e Chime são suportados) ou áudio apenas de qualquer outro aplicativo de reunião baseado em navegador, softphone ou fonte de áudio. Ele usa o Amazon Transcribe para fala em texto, bases de conhecimento do Amazon Bedrock para consultas contextuais nos documentos e fontes de conhecimento da sua empresa e modelos do Amazon Bedrock para resumos e insights de transcrição personalizáveis.

Tudo que você precisa é fornecido como código aberto em nosso GitHub repo. É simples implantar em sua conta AWS. Quando terminar, você se perguntará como conseguiu viver sem ele!

A seguir estão algumas das coisas que o LMA pode fazer:

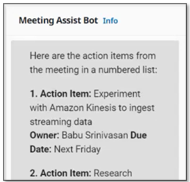

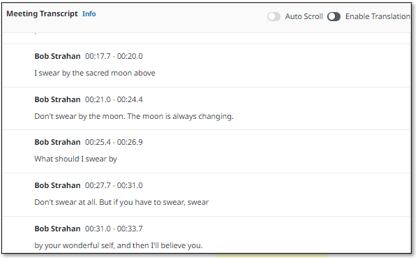

- Transcrição ao vivo com atribuição de orador – O LMA é desenvolvido com modelos ASR do Amazon Transcribe para fala em texto de baixa latência e alta precisão. Você pode ensinar nomes de marcas e terminologia específica de domínio, se necessário, usando vocabulário personalizado e recursos de modelo de linguagem personalizados no Amazon Transcribe.

- Tradução ao vivo – Ele usa o Amazon Translate para mostrar opcionalmente cada segmento da conversa traduzido para o idioma de sua escolha, entre uma seleção de 75 idiomas.

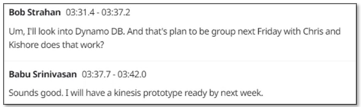

- Assistente de reunião sensível ao contexto – Ele usa bases de conhecimento do Amazon Bedrock para fornecer respostas de fontes confiáveis, usando a transcrição ao vivo como contexto para verificação de fatos e perguntas de acompanhamento. Para ativar o assistente, basta dizer “Ok, Assistente”, escolher o PERGUNTE AO ASSISTENTE! botão ou insira sua própria pergunta na interface do usuário.

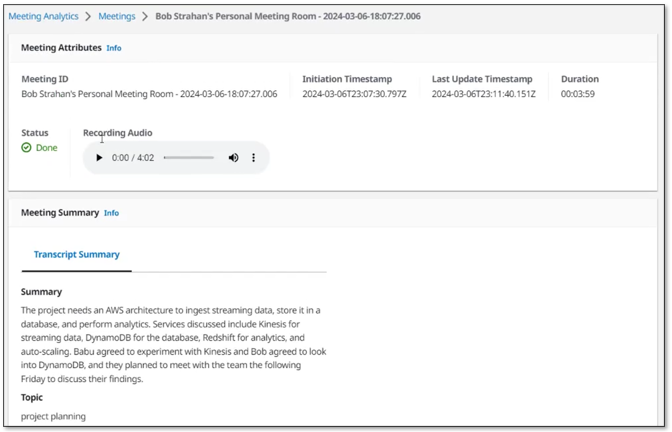

- Resumos sob demanda da reunião – Com o clique de um botão na UI, você pode gerar um resumo, que é útil quando alguém chega atrasado e precisa ser atualizado. Os resumos são gerados a partir da transcrição da Amazon Bedrock. O LMA também oferece opções para identificar o tópico da reunião atual e para gerar uma lista de itens de ação com proprietários e datas de vencimento. Você também pode criar seus próprios prompts personalizados e opções correspondentes.

- Resumo e insights automatizados – Quando a reunião termina, o LMA executa automaticamente um conjunto de prompts de modelo de linguagem grande (LLM) no Amazon Bedrock para resumir a transcrição da reunião e extrair insights. Você também pode personalizar esses prompts.

- Gravação de reunião – O áudio é (opcionalmente) armazenado para você, para que você possa reproduzir seções importantes da reunião mais tarde.

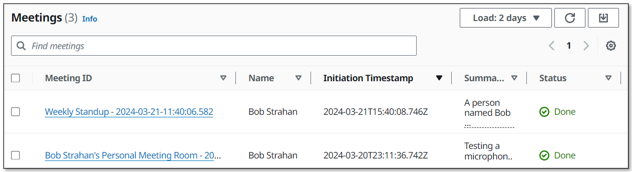

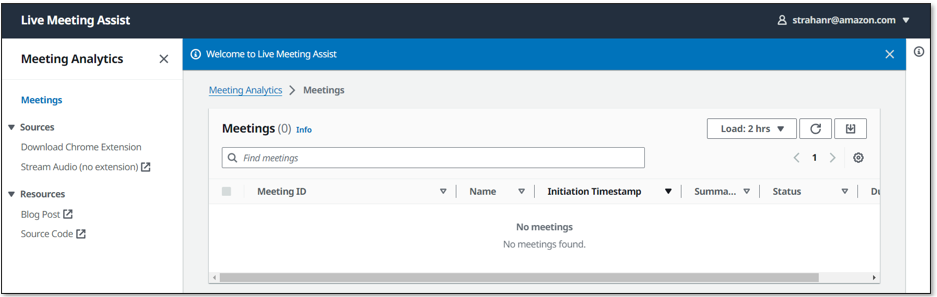

- Lista de inventário de reuniões – O LMA acompanha todas as suas reuniões em uma lista pesquisável.

- A extensão do navegador captura áudio e metadados de reuniões de aplicativos de reunião populares – A extensão do navegador captura os metadados da reunião (o título da reunião e os nomes dos palestrantes ativos) e o áudio seu (seu microfone) e de outras pessoas (na guia do navegador da reunião). No momento em que este artigo foi escrito, o LMA oferece suporte ao Chrome para a extensão do navegador e Zoom e Chime para aplicativos de reunião (com Teams e WebEx em breve). Os aplicativos de reunião independentes não funcionam com o LMA. Em vez disso, inicie suas reuniões no navegador.

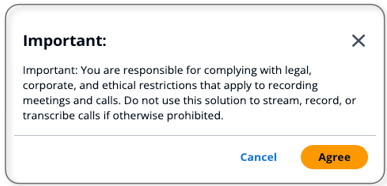

Você é responsável por cumprir as restrições legais, corporativas e éticas aplicáveis à gravação de reuniões e chamadas. Não use esta solução para transmitir, gravar ou transcrever chamadas se for proibido de outra forma.

Pré-requisitos

Você precisa ter uma conta AWS e um Gerenciamento de acesso e identidade da AWS (IAM) e usuário com permissões para criar e gerenciar os recursos e componentes necessários para este aplicativo. Se você não tiver uma conta da AWS, consulte Como posso criar e ativar uma nova conta Amazon Web Services?

Você também precisa de uma base de conhecimento existente no Amazon Bedrock. Se você ainda não configurou um, consulte Crie uma base de conhecimento. Preencha sua base de conhecimento com conteúdo para potencializar o assistente de reunião com reconhecimento de contexto do LMA.

Por fim, o LMA usa Amazon Bedrock LLMs para seus recursos de resumo de reuniões. Antes de prosseguir, caso ainda não o tenha feito, você deve solicitar acesso aos seguintes modelos Amazon Bedrock:

- Titan Embeddings G1 – Texto

- Antrópico: Todos os modelos Claude

Implante a solução usando AWS CloudFormation

Fornecemos pré-construído Formação da Nuvem AWS modelos que implantam tudo que você precisa em sua conta AWS.

Se você é um desenvolvedor e deseja criar, implantar ou publicar a solução a partir do código, consulte o LEIA-ME do desenvolvedor.

Conclua as etapas a seguir para iniciar a pilha do CloudFormation:

- Faça o login no Console de gerenciamento da AWS.

- Escolha Pilha de Lançamento para a região da AWS desejada para abrir o console do AWS CloudFormation e criar uma nova pilha.

| Região | Pilha de Lançamento |

|---|---|

| Leste dos EUA (Virgínia do Norte) | |

| Oeste dos EUA (Oregon) |

- Escolha Nome da pilha, use o valor padrão, LMA.

- Escolha Endereço de e-mail do administrador, use um endereço de e-mail válido. Sua senha temporária será enviada por e-mail para esse endereço durante a implantação.

- Escolha Domínio de e-mail da conta autorizada, use a parte do nome de domínio do seu endereço de e-mail corporativo para permitir que usuários com endereços de e-mail no mesmo domínio criem suas próprias contas de UI ou deixe em branco para impedir que os usuários criem diretamente suas próprias contas. Você pode inserir vários domínios como uma lista separada por vírgulas.

- Escolha MeetingAssistService, escolha

BEDROCK_KNOWLEDGE_BASE(a única opção disponível no momento desta redação). - Escolha ID da base de conhecimento do Meeting Assist Bedrock (existente), insira o ID da sua base de conhecimento existente (por exemplo,

JSXXXXX3D8). Você pode copiá-lo do console Amazon Bedrock.

- Para todos os outros parâmetros, use os valores padrão.

Se você quiser personalizar as configurações posteriormente, por exemplo, para adicionar suas próprias AWS Lambda funções, usar vocabulários personalizados e modelos de linguagem para melhorar a precisão, permitir a redação de informações de identificação pessoal (PII) e muito mais, você pode atualizar a pilha para esses parâmetros.

- Marque as caixas de seleção de confirmação e escolha Criar pilha.

A pilha principal do CloudFormation usa pilhas aninhadas para criar os seguintes recursos em sua conta AWS:

- Serviço de armazenamento simples da Amazon (Amazon S3) buckets para armazenar artefatos de construção e gravações de chamadas

- An AWS Fargate tarefa com um Balanceador de carga de aplicativo fornecer um servidor WebSocket executando código para consumir fluxos de áudio estéreo e retransmitir para o Amazon Transcribe, publicar segmentos de transcrição em Fluxos de dados do Amazon Kinesise criar e armazenar gravações de chamadas estéreo

- Um fluxo de dados do Kinesis para retransmitir eventos de chamada e segmentos de transcrição para a função de processamento de enriquecimento

- Os recursos da LMA, incluindo o QnABot na solução AWS pilha, que interage com Serviço Amazon OpenSearch e Amazon Bedrock

- A AWS AppSync API, que fornece um endpoint GraphQL para oferecer suporte a consultas e atualizações em tempo real

- Componentes do site, incluindo um bucket S3, Amazon CloudFront distribuição, e Amazon Cognito grupo de usuários

- Um aplicativo de extensão de navegador pré-configurado para download para navegadores Chrome

- Outros recursos de apoio, incluindo funções e políticas do IAM (usando práticas recomendadas de privilégio mínimo), Nuvem virtual privada da Amazon recursos (Amazon VPC), Amazon Event Bridge regras do evento e Amazon CloudWatch grupos de logs.

As pilhas levam cerca de 35 a 40 minutos para serem implantadas. O status da pilha principal mostra CREATE_COMPLETE quando tudo estiver implantado.

Coloque sua senha

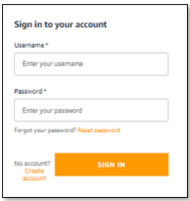

Depois de implementar a pilha, abra a interface com o usuário da web do LMA e defina sua senha concluindo as etapas a seguir:

- Abra o e-mail que você recebeu, no endereço de e-mail fornecido, com o assunto “Bem-vindo ao Live Meeting Assistant!”

- Abra seu navegador na URL mostrada no e-mail. Você é direcionado para a página de login.

- O e-mail contém uma senha temporária gerada que você usa para fazer login e criar sua própria senha. Seu nome de usuário é seu endereço de e-mail.

- Defina uma nova senha.

Sua nova senha deve ter pelo menos oito caracteres e conter caracteres maiúsculos e minúsculos, além de números e caracteres especiais.

- Siga as instruções para verificar seu endereço de e-mail ou escolha pular para fazer isso mais tarde.

Agora você está conectado ao LMA.

Você também recebeu um e-mail semelhante com o assunto “Código de verificação de inscrição QnABot”. Este e-mail contém uma senha temporária gerada que você usa para fazer login e criar sua própria senha no designer QnABot. Você usa o designer QnABot somente se quiser personalizar opções e prompts de LMA. Seu nome de usuário para QnABot é Admin. Você pode definir sua senha permanente de administrador do QnABot agora ou manter este e-mail seguro caso queira personalizar as coisas posteriormente.

Baixe e instale a extensão do navegador Chrome

Para obter a melhor experiência de streaming de reuniões, instale o plug-in do navegador LMA (atualmente disponível para Chrome):

- Escolha Baixar extensão do Chrome para baixar o arquivo .zip da extensão do navegador (

lma-chrome-extension.zip).

- Escolha (clique com o botão direito) e expanda o arquivo .zip (

lma-chrome-extension.zip) para criar uma pasta local chamadalma-chrome-extension. - Abra o Chrome e digite o link

chrome://extensionsna barra de endereço.

- permitir Modo de desenvolvedor.

- Escolha Carregar descompactadonavegue até o

lma-chrome-extensionpasta (que você descompactou do download) e escolha Selecionar. Isso carrega sua extensão. - Fixe a nova extensão LMA na barra de ferramentas do navegador para facilitar o acesso – você a usará com frequência para transmitir suas reuniões!

Comece a usar o LMA

LMA oferece duas opções de streaming:

- Extensão do navegador Chrome – Use isto para transmitir metadados de áudio e alto-falante do seu aplicativo de navegador de reuniões. Atualmente funciona com Zoom e Chime, mas esperamos adicionar mais aplicativos de reunião.

- Guia LMA Stream Audio – Use-o para transmitir áudio do seu microfone e de qualquer aplicativo de reunião, softphone ou aplicativo de áudio baseado no navegador Chrome.

Mostramos como usar ambas as opções nas seções a seguir.

Use a extensão do navegador Chrome para transmitir uma chamada Zoom

Conclua as etapas a seguir para usar a extensão do navegador:

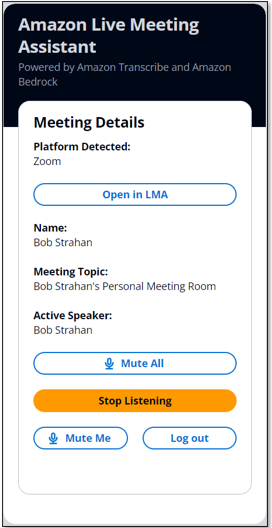

- Abra a extensão LMA e faça login com suas credenciais do LMA.

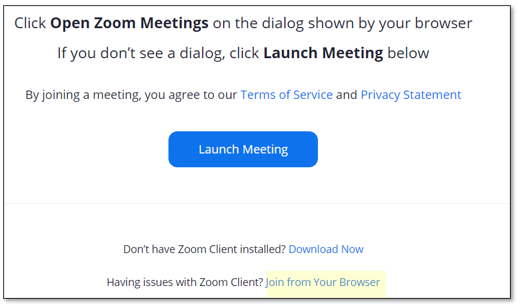

- Participe ou inicie uma reunião Zoom em seu navegador (não use o cliente Zoom separado).

Se você já carregou a página da reunião do Zoom, recarregue-a.

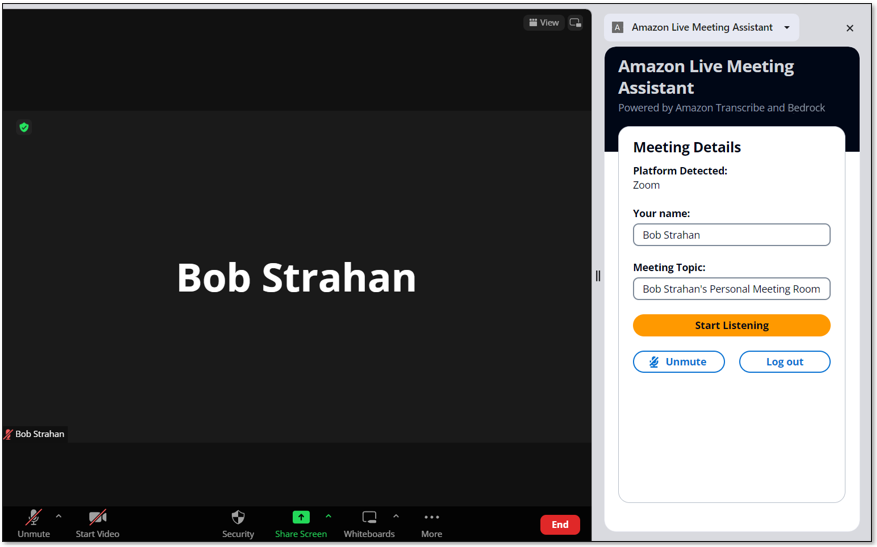

A extensão LMA detecta automaticamente que o Zoom está em execução na guia do navegador e preenche seu nome e o nome da reunião.

- Diga aos outros participantes da chamada que você está prestes a começar a gravar a chamada usando o LMA e obtenha a permissão deles. Não prossiga se os participantes se opuserem.

- Escolha Começar a escutar.

- Leia e aceite o aviso legal e escolha Permitir para compartilhar a guia do navegador.

O ramal LMA detecta e exibe automaticamente o interlocutor ativo na chamada. Se você estiver sozinho na reunião, convide alguns amigos para participar e observe que os nomes que eles usaram para ingressar na chamada são exibidos no ramal quando eles falam e são atribuídos às suas palavras na transcrição do LMA.

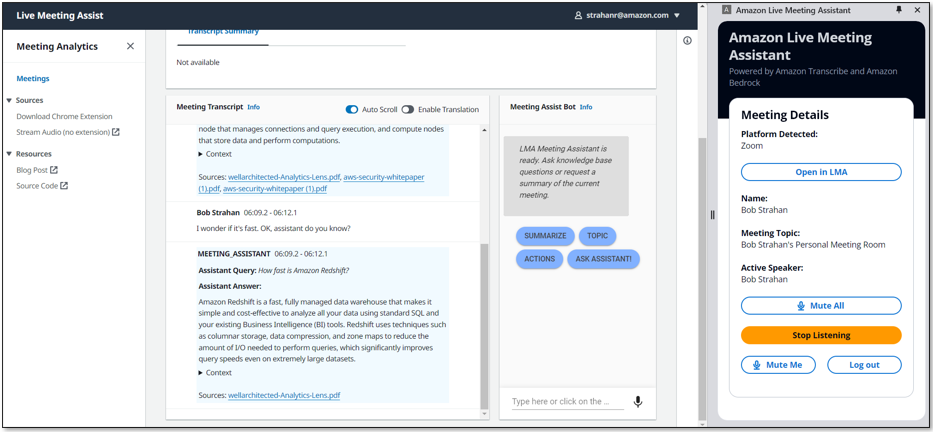

- Escolha Aberto na LMA para ver sua transcrição ao vivo em uma nova guia.

- Escolha o idioma de transcrição de sua preferência e interaja com o assistente da reunião usando a frase de ativação “OK Assistente!” ou o Bot de assistência para reuniões painel.

A PERGUNTE AO ASSISTENTE botão pede ao serviço de assistente de reunião (base de conhecimento Amazon Bedrock) que sugira uma boa resposta com base na transcrição das interações recentes na reunião. Sua milhagem pode variar, então experimente!

- Quando terminar, escolha Parar de streaming para encerrar a reunião na LMA.

Em alguns segundos, os resumos automatizados de final de reunião aparecem e a gravação de áudio fica disponível. Você pode continuar a usar o bot após o término da chamada.

Use a guia LMA UI Stream Audio para transmitir do seu microfone e de qualquer aplicativo de áudio baseado em navegador

A extensão do navegador é a maneira mais conveniente de transmitir metadados e áudio de aplicativos da web para reuniões compatíveis. No entanto, você também pode usar o LMA para transmitir apenas o áudio de qualquer softphone baseado em navegador, aplicativo de reunião ou outra fonte de áudio reproduzida em seu navegador Chrome, usando o conveniente Stream Audio guia integrada à interface do usuário do LMA.

- Abra qualquer fonte de áudio em uma guia do navegador.

Por exemplo, pode ser um softphone (como Google Voice), outro aplicativo de reunião ou, para fins de demonstração, você pode simplesmente reproduzir uma gravação de áudio local ou um vídeo do YouTube em seu navegador para emular outro participante da reunião. Se você quiser apenas experimentar, abra o seguinte Vídeo do YouTube em uma nova guia.

- Na IU do aplicativo LMA, escolha Transmitir áudio (sem extensão) para abrir a guia Transmitir áudio.

- Escolha ID da reunião, insira uma ID de reunião.

- Escolha Nome, digite um nome para você (aplicado ao áudio do seu microfone).

- Escolha Nome(s) do(s) participante(s), insira os nomes dos participantes (aplicados à fonte de áudio de entrada).

- Escolha Comece a transmitir.

- Escolha a guia do navegador que você abriu anteriormente e escolha Permitir compartilhar.

- Escolha a guia UI do LMA novamente para visualizar seu novo ID de reunião listado, mostrando a reunião como Em Andamento.

- Escolha o ID da reunião para abrir a página de detalhes e assista à transcrição do áudio recebido, atribuído aos nomes dos participantes que você inseriu. Se você falar, verá a transcrição da sua própria voz.

Use o Stream Audio recurso para transmitir de qualquer aplicativo de softphone, aplicativo de reunião ou qualquer outro streaming de áudio reproduzido no navegador, junto com seu próprio áudio capturado do microfone selecionado. Sempre obtenha permissão de outras pessoas antes de gravá-las usando o LMA ou qualquer outro aplicativo de gravação.

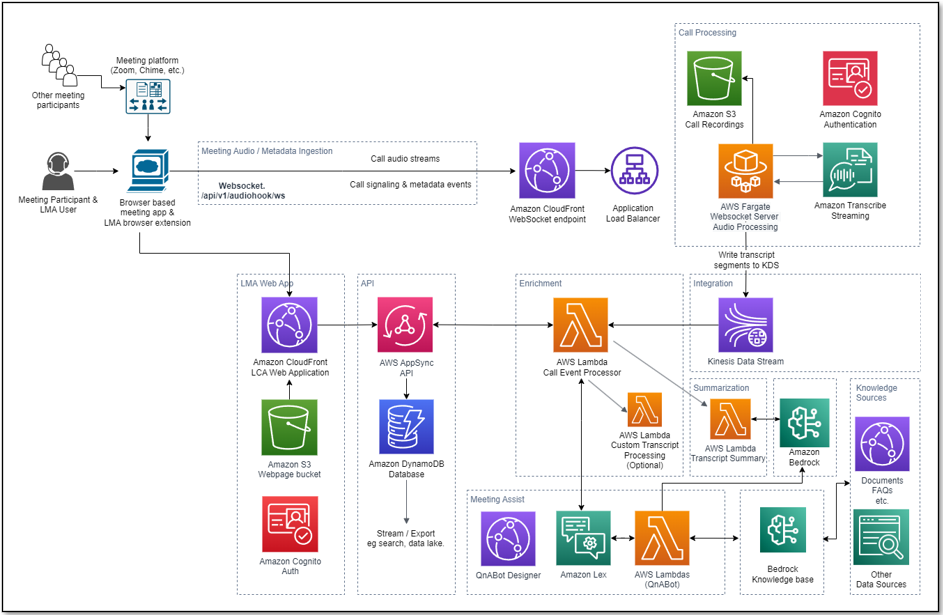

Visão geral do fluxo de processamento

Como a LMA transcreveu e analisou sua reunião? Vejamos como isso funciona. O diagrama a seguir mostra os principais componentes arquitetônicos e como eles se encaixam em alto nível.

O usuário do LMA ingressa em uma reunião no navegador, ativa a extensão do navegador do LMA e autentica usando suas credenciais do LMA. Se o aplicativo de reunião (por exemplo, Zoom.us) for compatível com a extensão LMA, o nome do usuário, o nome da reunião e os nomes dos alto-falantes ativos serão detectados automaticamente pela extensão. Se o aplicativo de reunião não for compatível com a extensão, o usuário do LMA poderá inserir manualmente seu nome e o tópico da reunião – os nomes dos palestrantes ativos não serão detectados.

Depois de obter permissão de outros participantes, o usuário do LMA escolhe Start Listening no painel de extensão do LMA. Uma conexão WebSocket segura é estabelecida com a URL WebSocket da pilha LMA pré-configurada e o token de autenticação do usuário é validado. A extensão do navegador LMA envia uma mensagem START para o WebSocket contendo os metadados da reunião (nome, tópico e assim por diante) e inicia o streaming de áudio de dois canais do microfone do usuário e do canal de áudio de entrada contendo as vozes dos outros participantes da reunião. A extensão monitora o aplicativo de reunião para detectar mudanças de locutor ativo durante a chamada e envia esses metadados para o WebSocket, permitindo que o LMA rotule segmentos de fala com o nome do locutor.

O servidor WebSocket em execução no Fargate consome os fragmentos de áudio de dois canais em tempo real do fluxo WebSocket de entrada. O áudio é transmitido para o Amazon Transcribe e os resultados da transcrição são gravados em tempo real no Kinesis Data Streams.

Cada sessão de processamento de reunião é executada até que o usuário escolha Parar de ouvir no painel de extensão LMA ou encerre a reunião e feche a guia. Ao final da chamada, a função cria um arquivo de gravação estéreo no Amazon S3 (se a gravação foi habilitada quando a pilha foi implantada).

Uma função Lambda chamada Call Event Processor, alimentada pelo Kinesis Data Streams, processa e opcionalmente enriquece metadados de reunião e segmentos de transcrição. O Call Event Processor integra-se aos serviços de assistência a reuniões. LMA é alimentado por Amazon-Lex, bases de conhecimento para Amazon Bedrock e Amazon Bedrock LLMs usando código aberto QnABot na solução AWS para respostas baseadas em perguntas frequentes e como orquestrador para roteamento de solicitações para o serviço de IA apropriado. O processador de eventos de chamada também invoca a função Transcript Summarization Lambda quando a chamada termina, para gerar um resumo da chamada a partir da transcrição completa.

A função Call Event Processor faz interface com o AWS AppSync para persistir alterações (mutações) em Amazon DynamoDB e enviar atualizações em tempo real para os clientes da web logados do usuário do LMA (convenientemente abertos escolhendo a opção Abrir no LMA na extensão do navegador).

Os ativos de IU da web do LMA são hospedados no Amazon S3 e servidos por meio do CloudFront. A autenticação é fornecida pelo Amazon Cognito.

Quando o usuário é autenticado, o aplicativo web estabelece uma conexão GraphQL segura com a API AWS AppSync e se inscreve para receber eventos em tempo real, como novas chamadas e alterações de status de chamada para a página de lista de reuniões, além de segmentos de transcrição novos ou atualizados e cálculos análises para a página de detalhes da reunião. Quando a tradução está habilitada, o aplicativo web também interage de forma segura com o Amazon Translate para traduzir a transcrição da reunião para o idioma selecionado.

Todo o fluxo de processamento, desde a fala ingerida até atualizações de páginas da Web ao vivo, é orientado por eventos, e a latência de ponta a ponta é curta, normalmente apenas alguns segundos.

Monitoramento e solução de problemas

O AWS CloudFormation relata falhas de implantação e causas nas pilhas relevantes Eventos aba. Ver Solução de problemas do CloudFormation para obter ajuda com problemas comuns de implantação. Esteja atento a falhas de implantação causadas por erros de limite excedido; as pilhas LMA criam recursos que estão sujeitos a cotas padrão de conta e serviço de região, como endereços IP elásticos e gateways NAT. Ao solucionar falhas de pilha do CloudFormation, sempre navegue em qualquer pilha aninhada com falha para encontrar a primeira falha de recurso aninhada relatada – essa é quase sempre a causa raiz.

O Amazon Transcribe tem um limite padrão de 25 fluxos de transcrição simultâneos, o que limita o LMA a 25 reuniões simultâneas em uma determinada conta ou região da AWS. Solicite um aumento no número de fluxos HTTP/2 simultâneos para transcrição de streaming se você tiver muitos usuários e precisar lidar com um número maior de reuniões simultâneas em sua conta.

O LMA fornece monitoramento de tempo de execução e logs para cada componente usando o CloudWatch:

- Processamento WebSocket e transcrição de tarefa Fargate - No Serviço Amazon Elastic Container (Amazon ECS), navegue até o Clusters página e abra o LMA-

WEBSOCKETSTACK-xxxx-TranscribingClusterfunção. Escolha o tarefas guia e abra a página da tarefa. Escolher Logs e Ver no CloudWatch para inspecionar os logs de tarefas do transcritor WebSocket. - Chamar função Lambda do processador de eventos – No console do Lambda, abra o

LMA-AISTACK-CallEventProcessorfunção. Escolha o Monitore guia para ver as métricas da função. Escolher Ver registros no CloudWatch para inspecionar logs de funções. - API AWS AppSync – No console do AWS AppSync, abra o

CallAnalytics-LMAAPI. Escolher do Paciente no painel de navegação para ver as métricas da API. Escolher Ver registros no CloudWatch para inspecionar os logs da API do AWS AppSync.

Para QnABot no AWS for Meeting Assist, consulte o LEIA-ME do Assistente de Reunião, e as Guia de implementação da solução QnABot para obter informações adicionais.

Avaliação de custos

O LMA fornece um servidor WebSocket usando recursos de rede Fargate (2vCPU) e VPC que custa cerca de US$ 0.10/hora (aproximadamente US$ 72/mês). Para mais detalhes, consulte Preços do AWS Fargate.

O LMA é habilitado usando QnABot e bases de conhecimento para Amazon Bedrock. Você cria sua própria base de conhecimento, que pode ser usada para LMA e potencialmente para outros casos de uso. Para mais detalhes, consulte Preços da Amazon Bedrock. Os serviços adicionais da AWS usados pela solução QnABot custam cerca de US$ 0.77/hora. Para mais detalhes, consulte a lista de Custos da solução QnABot na AWS.

Os custos restantes da solução são baseados no uso.

Os custos de uso somam cerca de US$ 0.17 para uma chamada de 5 minutos, embora isso possa variar com base nas opções selecionadas (como tradução), número de resumos LLM e uso total porque o uso afeta a elegibilidade do nível gratuito e os preços escalonados por volume para muitos serviços . Para obter mais informações sobre os serviços que incorrem em custos de uso, consulte o seguinte:

Para explorar os custos do LMA por si mesmo, use Explorador de custos da AWS ou escolha Detalhes da fatura no AWS Billing Dashboard para ver seus gastos mensais acumulados por serviço.

Personalize sua implantação

Use os seguintes parâmetros de modelo do CloudFormation ao criar ou atualizar sua pilha para personalizar sua implantação de LCA:

- Para usar seu próprio bucket S3 para gravações de reuniões, use Chamar o nome do intervalo de gravações de áudio e Prefixo do arquivo de áudio.

- Para redigir PII das transcrições, defina Habilitar redação de conteúdo para transcrições para verdadeiro e ajuste Tipos de entidade de redação de transcrição de PII como necessário. Para mais informações, veja Redação ou identificação de PII em um fluxo em tempo real.

- Para melhorar a precisão da transcrição de acrônimos e jargões técnicos e específicos de domínio, defina Nome do vocabulário personalizado da transcrição ao nome de um vocabulário personalizado que você já criou no Amazon Transcribe ou definiu Nome do modelo de idioma personalizado de transcrição ao nome de um modelo de linguagem customizado criado anteriormente. Para mais informações, veja Melhorando a precisão da transcrição.

- Para transcrever reuniões em um idioma compatível que não seja o inglês dos EUA, escolha o valor desejado para Idioma para transcrição.

- Para personalizar o processamento da transcrição, defina opcionalmente ARN da função Lambda Hook para processamento de segmento de transcrição personalizado ao ARN da sua própria função Lambda. Para mais informações, veja Usando uma função Lambda para fornecer opcionalmente lógica personalizada para processamento de transcrição.

- Para personalizar os recursos de assistência a reuniões com base na solução QnABot on AWS, Amazon Lex, Amazon Bedrock e bases de conhecimento para integração do Amazon Bedrock, consulte o LEIA-ME do Assistente de Reunião.

- Para personalizar o resumo da transcrição configurando o LMA para chamar sua própria função Lambda, consulte Opção LAMBDA de resumo de transcrição.

- Para personalizar o resumo da transcrição modificando os prompts padrão ou adicionando novos, consulte Resumo da transcrição.

- Para alterar o período de retenção, defina Registrar expiração em dias para o valor desejado. Todos os dados de chamadas serão excluídos permanentemente do armazenamento do LMA DynamoDB após esse período. As alterações nesta configuração aplicam-se apenas a novas chamadas recebidas após a atualização.

LMA é um projeto de código aberto. Você pode bifurcar o repositório GitHub do LMA, aprimorar o código e nos enviar solicitações pull para que possamos incorporar e compartilhar suas melhorias!

Atualizar uma pilha LMA existente

Você pode atualizar sua pilha LMA existente para a versão mais recente. Para mais detalhes, consulte Atualizar uma pilha existente.

limpar

Parabéns! Você concluiu todas as etapas para configurar sua solução de exemplo de análise de chamadas ao vivo usando os serviços da AWS.

Quando terminar de experimentar esta solução de exemplo, limpe seus recursos usando o console do AWS CloudFormation para excluir as pilhas de LMA que você implantou. Isso exclui recursos que foram criados pela implantação da solução. Os buckets S3 de gravação, a tabela DynamoDB e os grupos de logs do CloudWatch são retidos após a exclusão da pilha para evitar a exclusão de seus dados.

Live Call Analytics: solução complementar

Nossa solução complementar, Análise de chamadas ao vivo e assistência ao agente (LCA), oferece transcrição e análise em tempo real para contact centers (chamadas telefônicas) em vez de reuniões. Existem muitas semelhanças – na verdade, o LMA foi construído usando uma arquitetura e muitos componentes derivados do LCA.

Conclusão

A solução de exemplo do Live Meeting Assistant oferece uma abordagem flexível, rica em recursos e personalizável para fornecer assistência em reuniões ao vivo para melhorar sua produtividade durante e após as reuniões. Ele usa serviços Amazon AI/ML como Amazon Transcribe, Amazon Lex, Knowledge Bases for Amazon Bedrock e Amazon Bedrock LLMs para transcrever e extrair insights em tempo real do áudio da reunião.

O aplicativo LMA de amostra é fornecido como código aberto. Use-o como ponto de partida para sua própria solução e ajude-nos a melhorá-la, contribuindo com correções e recursos por meio de solicitações pull do GitHub. Navegue até o Repositório LMA GitHub para explorar o código, escolha Assistir para ser notificado sobre novos lançamentos e verificar o README para obter as atualizações de documentação mais recentes.

Para assistência especializada, Serviços Profissionais AWS e outro Parceiros AWS Estão aqui para ajudar.

Adoraríamos ouvir de você. Deixe-nos saber o que você pensa na seção de comentários ou use o fórum de problemas no Repositório LMA GitHub.

Sobre os autores

Bob Strahan é arquiteto de soluções principais na equipe AWS Language AI Services.

Bob Strahan é arquiteto de soluções principais na equipe AWS Language AI Services.

Chris Lott é arquiteto de soluções principal na equipe de serviços linguísticos de IA da AWS. Ele tem 20 anos de experiência em desenvolvimento de software empresarial. Chris mora em Sacramento, Califórnia, e gosta de jardinagem, aeroespacial e de viajar pelo mundo.

Chris Lott é arquiteto de soluções principal na equipe de serviços linguísticos de IA da AWS. Ele tem 20 anos de experiência em desenvolvimento de software empresarial. Chris mora em Sacramento, Califórnia, e gosta de jardinagem, aeroespacial e de viajar pelo mundo.

Babu Srinivasan é um Especialista Sr. SA – Language AI services na organização World Wide Specialist na AWS, com mais de 24 anos de experiência em TI e os últimos 6 anos focados na Nuvem AWS. Ele é apaixonado por IA/ML. Fora do trabalho, ele gosta de marcenaria e entretém amigos e familiares (às vezes estranhos) com truques de cartas mágicas.

Babu Srinivasan é um Especialista Sr. SA – Language AI services na organização World Wide Specialist na AWS, com mais de 24 anos de experiência em TI e os últimos 6 anos focados na Nuvem AWS. Ele é apaixonado por IA/ML. Fora do trabalho, ele gosta de marcenaria e entretém amigos e familiares (às vezes estranhos) com truques de cartas mágicas.

Kishore Dhamodaran é Arquiteto de Soluções Sênior na AWS.

Kishore Dhamodaran é Arquiteto de Soluções Sênior na AWS.

Gillian Armstrong é arquiteto de soluções da Builder. Ela está entusiasmada com a forma como a nuvem está abrindo oportunidades para que mais pessoas usem a tecnologia para resolver problemas e, especialmente, entusiasmada com a forma como as tecnologias cognitivas, como a IA de conversação, estão nos permitindo interagir com os computadores de maneiras mais humanas.

Gillian Armstrong é arquiteto de soluções da Builder. Ela está entusiasmada com a forma como a nuvem está abrindo oportunidades para que mais pessoas usem a tecnologia para resolver problemas e, especialmente, entusiasmada com a forma como as tecnologias cognitivas, como a IA de conversação, estão nos permitindo interagir com os computadores de maneiras mais humanas.

- Conteúdo com tecnologia de SEO e distribuição de relações públicas. Seja amplificado hoje.

- PlatoData.Network Gerativa Vertical Ai. Capacite-se. Acesse aqui.

- PlatoAiStream. Inteligência Web3. Conhecimento Amplificado. Acesse aqui.

- PlatãoESG. Carbono Tecnologia Limpa, Energia, Ambiente, Solar, Gestão de resíduos. Acesse aqui.

- PlatoHealth. Inteligência em Biotecnologia e Ensaios Clínicos. Acesse aqui.

- Fonte: https://aws.amazon.com/blogs/machine-learning/live-meeting-assistant-with-amazon-transcribe-amazon-bedrock-and-knowledge-bases-for-amazon-bedrock/