Dette innlegget er skrevet sammen med Sherwin Chu fra Alida.

Alida hjelper verdens største merkevarer med å skape svært engasjerte forskningsmiljøer for å samle tilbakemeldinger som gir bedre kundeopplevelser og produktinnovasjon.

Alidas kunder mottar titusenvis av engasjerte svar for en enkelt undersøkelse, derfor valgte Alida-teamet å utnytte maskinlæring (ML) for å betjene kundene sine i stor skala. Men når de brukte tradisjonelle NLP-modeller (natural language processing), fant de ut at disse løsningene slet med å forstå de nyanserte tilbakemeldingene som finnes i åpne spørreundersøkelser. Modellene fanget ofte bare emner og følelser på overflatenivå, og gikk glipp av avgjørende kontekst som ville gi mer nøyaktig og meningsfull innsikt.

I dette innlegget lærer vi om hvordan Anthropics Claude Instant modellerer seg videre Amazonas grunnfjell gjorde det mulig for Alida-teamet å raskt bygge en skalerbar tjeneste som mer nøyaktig bestemmer emnet og følelsen i komplekse undersøkelsessvar. Den nye tjenesten oppnådde en 4-6 ganger forbedring i emnepåstand ved å gruppere seg tett på flere dusin nøkkelemner kontra hundrevis av støyende NLP-søkeord.

Amazon Bedrock er en fullt administrert tjeneste som tilbyr et utvalg av høyytende fundamentmodeller (FM-er) fra ledende AI-selskaper, som AI21 Labs, Anthropic, Cohere, Meta, Stability AI og Amazon via et enkelt API, sammen med et bredt sett med funksjoner du trenger for å bygge generative AI-applikasjoner med sikkerhet, personvern og ansvarlig AI.

Bruk av Amazon Bedrock tillot Alida å bringe tjenesten deres ut på markedet raskere enn om de hadde brukt andre maskinlæringsleverandører (ML) eller leverandører.

Utfordringen

Undersøkelser med en kombinasjon av flervalgsspørsmål og åpne spørsmål lar markedsforskere få et mer helhetlig syn ved å fange opp både kvantitative og kvalitative datapunkter.

Flervalgsspørsmål er enkle å analysere i skala, men mangler nyanser og dybde. Angi svaralternativer kan også føre til skjevhet eller priming av deltakersvar.

Åpne spørreundersøkelser lar respondentene gi kontekst og uventede tilbakemeldinger. Disse kvalitative datapunktene utdyper forskernes forståelse utover hva flervalgsspørsmål kan fange alene. Utfordringen med friformteksten er at den kan føre til komplekse og nyanserte svar som er vanskelige for tradisjonell NLP å forstå fullt ut. For eksempel:

«Jeg opplevde nylig noen av livets vanskeligheter og var virkelig nedfor og skuffet. Når jeg gikk inn, var personalet alltid veldig snille mot meg. Det har hjulpet meg å komme meg gjennom noen tøffe tider!»

Tradisjonelle NLP-metoder vil identifisere emner som «vansker», «skuffet», «snille ansatte» og «komme gjennom tøffe tider». Den kan ikke skille mellom responderens generelle negative livserfaringer og de spesifikke positive butikkopplevelsene.

Alidas eksisterende løsning behandler automatisk store volumer av åpne svar, men de ønsket at kundene deres skulle få bedre kontekstuell forståelse og emneslutning på høyt nivå.

Amazonas grunnfjell

Før introduksjonen av LLM-er var veien videre for Alida til å forbedre sin eksisterende enkeltmodellløsning å jobbe tett med bransjeeksperter og utvikle, trene og foredle nye modeller spesifikt for hver av industrivertikalene som Alidas kunder opererte i. Dette var både et tids- og kostnadskrevende arbeid.

Et av gjennombruddene som gjør LLM-er så kraftige er bruken av oppmerksomhetsmekanismer. LLM-er bruker selvoppmerksomhetsmekanismer som analyserer forholdet mellom ord i en gitt ledetekst. Dette lar LLM-er bedre håndtere emnet og følelsene i det tidligere eksemplet og presenterer en spennende ny teknologi som kan brukes til å møte utfordringen.

Med Amazon Bedrock kan team og enkeltpersoner umiddelbart begynne å bruke grunnmodeller uten å måtte bekymre deg for å klargjøre infrastruktur eller sette opp og konfigurere ML-rammeverk. Du kan komme i gang med følgende trinn:

- Bekreft at brukeren eller rollen din har tillatelse til å opprette eller endre Amazon Bedrock-ressurser. For detaljer, se Identitetsbaserte policy-eksempler for Amazon Bedrock

- Logg inn på Amazonas grunnfjell konsollen.

- På Modelltilgang side, se gjennom EULA og aktiver FM-ene du vil ha på kontoen din.

- Begynn å samhandle med FM-ene via følgende metoder:

Alidas ledergruppe var ivrige etter å være en tidlig bruker av Amazonas grunnfjell fordi de anerkjente dens evne til å hjelpe teamene deres med å bringe nye generative AI-drevne løsninger til markedet raskere.

Vincy William, Senior Director of Engineering hos Alida som leder teamet som er ansvarlig for å bygge emne- og sentimentanalysetjenesten, sier:

"LLM-er gir et stort sprang i kvalitativ analyse og gjør ting (i en skala som er) menneskelig ikke mulig å gjøre. Amazon Bedrock er en spillskifter, den lar oss utnytte LLM-er uten kompleksiteten.»

Ingeniørteamet opplevde den umiddelbare enkle å komme i gang med Amazon Bedrock. De kunne velge mellom ulike grunnmodeller og begynne å fokusere på rask utvikling i stedet for å bruke tid på riktig størrelse, klargjøring, distribusjon og konfigurering av ressurser for å kjøre modellene.

Løsningsoversikt

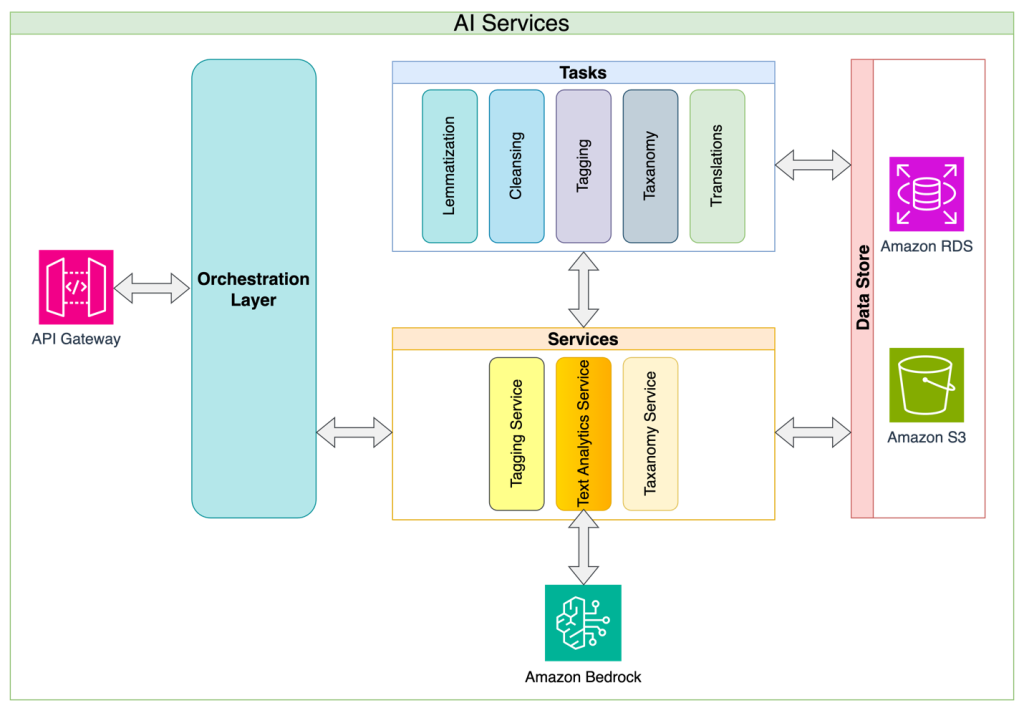

Sherwin Chu, Alidas sjefsarkitekt, delte Alidas mikrotjenesterarkitekturtilnærming. Alida bygde tema- og sentimentklassifiseringen som en tjeneste med analyse av spørreundersøkelser som sin første applikasjon. Med denne tilnærmingen abstraheres vanlige LLM-implementeringsutfordringer som kompleksiteten ved å administrere forespørsler, token-grenser, forespørselsbegrensninger og gjenforsøk, og løsningen gjør det mulig for forbrukende applikasjoner å ha en enkel og stabil API å jobbe med. Denne abstraksjonslagstilnærmingen gjør det også mulig for tjenesteeierne å kontinuerlig forbedre interne implementeringsdetaljer og minimere API-brytende endringer. Til slutt tillater tjenestetilnærmingen et enkelt punkt for å implementere enhver datastyring og sikkerhetspolicy som utvikler seg etter hvert som AI-styring modnes i organisasjonen.

Følgende diagram illustrerer løsningsarkitekturen og flyten.

Alida evaluerte LLM-er fra forskjellige leverandører, og fant at Anthropics Claude Instant var den rette balansen mellom kostnad og ytelse. I tett samarbeid med det raske ingeniørteamet tok Chu til orde for å implementere en rask kjedestrategi i motsetning til en enkel monolitt-prompt-tilnærming.

Rask kjetting lar deg gjøre følgende:

- Bryt ned målet ditt i mindre, logiske trinn

- Lag en melding for hvert trinn

- Gi ledetekstene sekvensielt til LLM

Dette skaper flere inspeksjonspunkter, som har følgende fordeler:

- Det er enkelt å systematisk evaluere endringer du gjør i inndatameldingen

- Du kan implementere mer detaljert sporing og overvåking av nøyaktigheten og ytelsen ved hvert trinn

Nøkkelhensyn med denne strategien inkluderer økningen i antall forespørsler til LLM og den resulterende økningen i den totale tiden det tar å fullføre målet. For Alidas brukstilfelle valgte de å samle en samling av åpne svar i en enkelt melding til LLM er det de valgte for å oppveie disse effektene.

NLP vs. LLM

Alidas eksisterende NLP-løsning er avhengig av klyngealgoritmer og statistisk klassifisering for å analysere åpne spørreundersøkelser. Når den ble brukt på prøvetilbakemeldinger for en kaffebars mobilapp, hentet den ut emner basert på ordmønstre, men manglet sann forståelse. Tabellen nedenfor inneholder noen eksempler som sammenligner NLP-svar med LLM-svar.

| Svar på undersøkelsen | Eksisterende tradisjonell NLP | Amazon Bedrock med Claude Instant | |

| Emne | Emne | Sentiment | |

| Jeg bestiller nesten utelukkende drinkene mine gjennom bekvemmelighetsappen bc, og det er mindre pinlig å bestille supertilpassede drinker lol. Og jeg elsker å tjene belønninger! | ['app bc convenience', 'drink', 'belønning'] | Bekvemmelig mobilbestilling | positiv |

| Appen fungerer ganske bra den eneste klagen jeg har er at jeg ikke kan legge til et antall penger jeg vil ha på gavekortet mitt. Hvorfor må det spesifikt være $10 for å fylle på?! | ['klage', 'app', 'gavekort', 'nummerpenger'] | Mobil ordreoppfyllingshastighet | negativ |

Eksempelresultatene viser hvordan den eksisterende løsningen var i stand til å trekke ut relevante søkeord, men ikke er i stand til å oppnå en mer generalisert emnegruppeoppgave.

Ved å bruke Amazon Bedrock og Anthropic Claude Instant, er LLM med kontekstopplæring i stand til å tildele svarene til forhåndsdefinerte emner og tildele følelser.

I tillegg til å levere bedre svar for Alidas kunder, for denne spesielle brukssaken, sparte det å forfølge en løsning med en LLM over tradisjonelle NLP-metoder en enorm mengde tid og krefter på opplæring og vedlikehold av en passende modell. Tabellen nedenfor sammenligner opplæring av en tradisjonell NLP-modell med opplæring i kontekst av en LLM.

| . | Datakrav | Opplæringsprosess | Modelltilpasningsevne |

| Trening av en tradisjonell NLP-modell | Tusenvis av menneskemerkede eksempler |

Kombinasjon av automatisert og manuell funksjonsteknikk. Iterativ trene og evaluere sykluser. |

Langsommere behandlingstid på grunn av behovet for å omskolere modellen |

| Konteksttrening av LLM | Flere eksempler |

Trenes på farten innenfor ledeteksten. Begrenset av kontekstvindustørrelsen. |

Raskere iterasjoner ved å endre ledeteksten. Begrenset oppbevaring på grunn av kontekstvinduets størrelse. |

konklusjonen

Alidas bruk av Anthropics Claude Instant-modell på Amazon Bedrock demonstrerer de kraftige egenskapene til LLM-er for å analysere åpne spørreundersøkelser. Alida var i stand til å bygge en overlegen tjeneste som var 4-6 ganger mer presis ved emneanalyse sammenlignet med deres NLP-drevne tjeneste. I tillegg reduserte bruk av in-context prompt engineering for LLM utviklingstiden betydelig, fordi de ikke trengte å kurere tusenvis av menneskemerkede datapunkter for å trene en tradisjonell NLP-modell. Dette gjør at Alida til syvende og sist kan gi sine kunder rikere innsikt tidligere!

Hvis du er klar til å begynne å bygge din egen grunnmodellinnovasjon med Amazon Bedrock, sjekk denne lenken til Sett opp Amazon Bedrock. Hvis du er interessert i å lese om andre spennende Amazon Bedrock-applikasjoner, se den spesifikke delen av Amazonas grunnfjell fra AWS Machine Learning Blog.

Om forfatterne

Kinman Lam er en ISV/DNB Solution Architect for AWS. Han har 17 års erfaring med å bygge og vokse teknologiselskaper innen smarttelefon, geolokalisering, IoT og åpen kildekode-programvare. Hos AWS bruker han sin erfaring til å hjelpe bedrifter med å bygge robust infrastruktur for å møte de økende kravene til voksende virksomheter, lansere nye produkter og tjenester, gå inn i nye markeder og glede kundene sine.

Kinman Lam er en ISV/DNB Solution Architect for AWS. Han har 17 års erfaring med å bygge og vokse teknologiselskaper innen smarttelefon, geolokalisering, IoT og åpen kildekode-programvare. Hos AWS bruker han sin erfaring til å hjelpe bedrifter med å bygge robust infrastruktur for å møte de økende kravene til voksende virksomheter, lansere nye produkter og tjenester, gå inn i nye markeder og glede kundene sine.

Sherwin Chu er sjefsarkitekt i Alida, og hjelper produktteam med arkitektonisk retning, teknologivalg og kompleks problemløsning. Han er en erfaren programvareingeniør, arkitekt og leder med over 20 år i SaaS-området for ulike bransjer. Han har bygget og administrert en rekke B2B- og B2C-systemer på AWS og GCP.

Sherwin Chu er sjefsarkitekt i Alida, og hjelper produktteam med arkitektonisk retning, teknologivalg og kompleks problemløsning. Han er en erfaren programvareingeniør, arkitekt og leder med over 20 år i SaaS-området for ulike bransjer. Han har bygget og administrert en rekke B2B- og B2C-systemer på AWS og GCP.

Mark Roy er en hovedmaskinlæringsarkitekt for AWS, og hjelper kunder med å designe og bygge AI/ML og generative AI-løsninger. Fokuset hans siden tidlig 2023 har vært å lede løsningsarkitekturarbeidet for lanseringen av Amazon Bedrock, AWS sitt flaggskip generative AI-tilbud for byggherrer. Marks arbeid dekker et bredt spekter av brukstilfeller, med en primær interesse for generativ AI, agenter og skalering av ML på tvers av bedriften. Han har hjulpet selskaper innen forsikring, finansielle tjenester, media og underholdning, helsetjenester, verktøy og produksjon. Før han begynte i AWS, var Mark arkitekt, utvikler og teknologileder i over 25 år, inkludert 19 år innen finansielle tjenester. Mark har seks AWS-sertifiseringer, inkludert ML Specialty Certification.

Mark Roy er en hovedmaskinlæringsarkitekt for AWS, og hjelper kunder med å designe og bygge AI/ML og generative AI-løsninger. Fokuset hans siden tidlig 2023 har vært å lede løsningsarkitekturarbeidet for lanseringen av Amazon Bedrock, AWS sitt flaggskip generative AI-tilbud for byggherrer. Marks arbeid dekker et bredt spekter av brukstilfeller, med en primær interesse for generativ AI, agenter og skalering av ML på tvers av bedriften. Han har hjulpet selskaper innen forsikring, finansielle tjenester, media og underholdning, helsetjenester, verktøy og produksjon. Før han begynte i AWS, var Mark arkitekt, utvikler og teknologileder i over 25 år, inkludert 19 år innen finansielle tjenester. Mark har seks AWS-sertifiseringer, inkludert ML Specialty Certification.

- SEO-drevet innhold og PR-distribusjon. Bli forsterket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk deg selv. Tilgang her.

- PlatoAiStream. Web3 Intelligence. Kunnskap forsterket. Tilgang her.

- PlatoESG. Karbon, CleanTech, Energi, Miljø, Solenergi, Avfallshåndtering. Tilgang her.

- PlatoHelse. Bioteknologisk og klinisk etterretning. Tilgang her.

- kilde: https://aws.amazon.com/blogs/machine-learning/alida-gains-deeper-understanding-of-customer-feedback-with-amazon-bedrock/