Terwijl ik bedrijven heb geholpen die zwaar werden getroffen door de “2023 Fall of Insane Algorithm Updates”, heb ik opnieuw van verschillende site-eigenaren gehoord die het hoogste bezoekersniveau hadden vlak voordat ze werden gehamerd. Ik zal daar binnenkort meer over vertellen, maar het is iets dat ik al heel lang zie. En nu we de getuigenis van Google over Navboost en gebruikersinteractiesignalen uit de laatste antitrustzaak hebben gelezen, spookten er verschillende ideeën door mijn hoofd.

Terwijl we bedrijven helpen die worden beïnvloed door grote algoritme-updates (zoals brede kernupdates), is het superbelangrijk om wat ik een 'deltarapport' noem uit te voeren om de belangrijkste zoekopdrachten en landingspagina's te identificeren die tijdens die updates zijn verwijderd. Delta-rapporten kan krachtig zijn en site-eigenaren helpen bepalen of een daling te wijten is relevantie aanpassingen, intentie verschuift, of in het algemeen problemen met de kwaliteit van de site. En als kwaliteit het probleem was, kan het graven in de zoekopdrachten en landingspagina's die het meest daalden vaak belangrijke bevindingen opleveren. En deze bevindingen kunnen helpen bij het identificeren van inhoud van lage kwaliteit, dunne inhoud, AI-inhoud van lage kwaliteit, barrières voor gebruikerservaringen, agressieve reclame, een misleidende of agressieve partneropstelling, en meer.

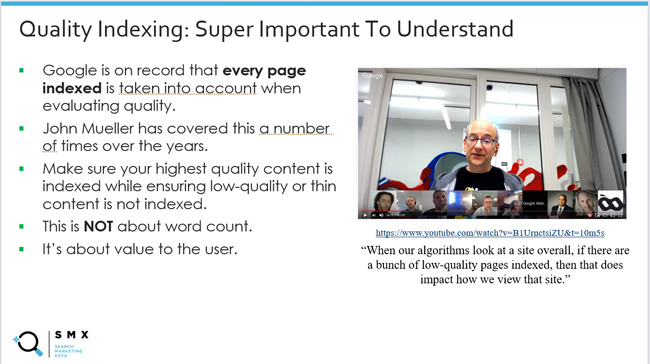

Dit zette mij ook opnieuw aan het denken over ‘kwaliteitsindexering’, waarover ik vaak heb gesproken in mijn berichten en presentaties over belangrijke algoritme-updates. Dat zorgt ervoor dat uw inhoud van de hoogste kwaliteit wordt geïndexeerd, terwijl u ervoor zorgt dat inhoud van lage kwaliteit of dunne inhoud niet wordt geïndexeerd. Die verhouding is belangrijk. Dat komt omdat we weten dat Google met elke geïndexeerde pagina rekening houdt bij het evalueren van de kwaliteit. John Mueller van Google heeft dat een aantal keren uitgelegd en ik heb die videoclips door de jaren heen gedeeld.

Maar zijn alle dingen gelijk geschapen vanuit een kwaliteitsoogpunt? Met andere woorden: als u een partij rommel van lagere kwaliteit op uw site aantreft die niet vaak in de zoekresultaten wordt weergegeven, is dat dan hetzelfde als inhoud van lagere kwaliteit (of nutteloze inhoud) die zeer zichtbaar in de zoekresultaten?

De opmerkingen van John Mueller over het verwijderen van inhoud van lage kwaliteit zijn op dat vlak in de loop der jaren enigszins veranderd. Dat merkte ik na verloop van tijd en het prikkelde altijd mijn nieuwsgierigheid. John ging van de uitleg dat als een stukje inhoud wordt geïndexeerd, het kan worden beoordeeld op kwaliteit, tot het uitleggen dat hij zich eerst zou concentreren op wat er goed zichtbaar en van lage kwaliteit. Ik zal meer uitleggen waarom dit volkomen logisch is (vooral met nieuwe informatie uit het laatste antitrustproces van Google).

Hieronder zal ik snel wat achtergrondinformatie bespreken over signalen van gebruikersbetrokkenheid en SEO, daarna zal ik enkele interessante opmerkingen van Google's John Mueller van de afgelopen jaren bespreken over het verwijderen van inhoud van lage kwaliteit, en dan zal ik dat samenbrengen met De recente getuigenis van Google over het gebruik van signalen van gebruikersinteractie om te helpen bij het rangschikken (dwz Navboost).

Laten we eerst eens een kijkje nemen in de geschiedenis en de signalen van gebruikersinteractie en de SEO-impact bespreken.

Signalen van gebruikersinteractie en SEO en het griezelige vermogen van Google om gebruikersgeluk te begrijpen:

Met de nieuwste antitrustproef van Google hebben we veel geleerd over hoe Google signalen van gebruikersinteractie gebruikt om de rankings te beïnvloeden. Pandu Nayak van Google sprak bijvoorbeeld over Navboost, hoe Google 13 maanden aan klikgegevens verzamelt (voorheen 18 maanden), en hoe die gegevens Google kunnen helpen het gebruikersgeluk te begrijpen (tevreden zoekgebruikers).

Hoewel het leren over Navboost veel mensen verbaasde (terecht), waren er altijd tekenen dat Google iets deed met gegevens over gebruikersbetrokkenheid vanuit een rankingperspectief. Niemand wist het echt zeker, maar het was moeilijk om het concept te negeren terwijl je je verdiepte in de vele sites die na verloop van tijd verdwenen waren op basis van grote algoritme-updates (vooral brede kernupdates).

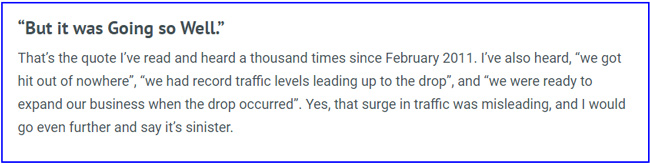

Ik schreef bijvoorbeeld in 2013 een bericht over de misleidende sinistere toename van het verkeer voordat een groot algoritme toesloeg. Let op: Search Engine Watch heeft problemen met oudere berichten, dus ik heb een link naar de versterkerversie van mijn bericht daar geplaatst (die lijkt te zijn opgelost). Je kan ook bekijk een pdf-versie van dat bericht als de versterkerversie om de een of andere reden niet werkt. Ik schreef dat bericht nadat veel bedrijven contact met mij hadden opgenomen over enorme Panda-hits en hadden uitgelegd dat ze zojuist het hoogste bezoekersniveau ooit hadden ervaren, totdat... ze crashten bij de volgende update.

Voor mij leek het alsof Google zoveel informatie vergaarde op basis van de manier waarop gebruikers omgingen met de inhoud van de SERP’s dat het uiteindelijk bijdroeg aan de daling. Met andere woorden: Google zou op grote schaal ontevreden gebruikers voor die sites kunnen zien. En toen boem, ze tankten.

Hier is een citaat uit mijn SEW-artikel:

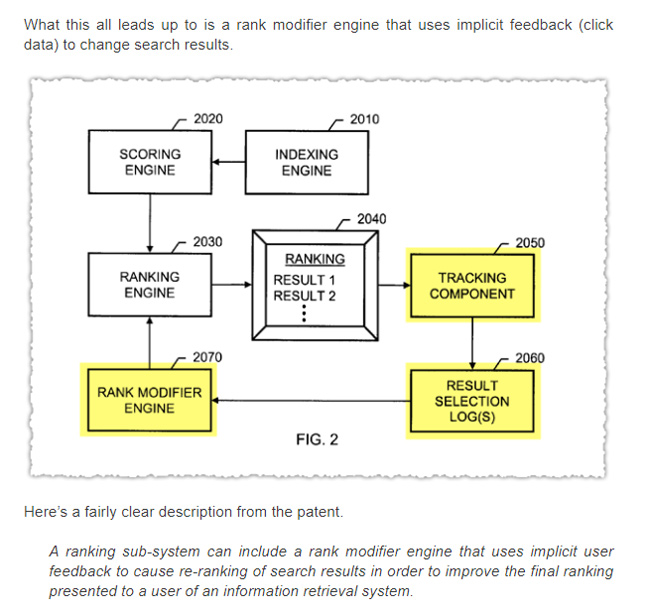

Ook AJ Kohn schreef er in 2015 ook een stuk over CTR als rankingfactor. AJ heeft in de loop der jaren ook aan veel sites gewerkt en had het serieuze vermoeden dat signalen van gebruikersinteractie een rol speelden in ranglijsten. Hier is een screenshot van het bericht van AJ waarin wordt verwezen naar impliciete gebruikersfeedback.

Ik heb ook veel geschreven over het gevaar van een korte verblijftijd en hoe zoiets wordt geïmplementeerd aangepast bouncepercentage kan site-eigenaren helpen een beter gevoel te krijgen voor inhoud die niet aan de verwachtingen van de gebruiker voldoet of deze overtreft. Dat bericht stamt uit 2012. En dat idee heb ik uitgebreid met een ander bericht uit 2018 over het gebruik van verschillende trackingmechanismen als maatstaf voor gebruikerstevredenheid (inclusief aangepast bouncepercentage, scrolldiepte-tracking en tijd op pagina). Let op: dit was voor GA3, niet voor GA4.

En als goed voorbeeld van hoe problemen met gebruikersbetrokkenheid van invloed kunnen zijn op SEO, was er een casestudy die ik in 2020 schreef over de “Valkuil voor SEO-betrokkenheid”, waar ik gebruikers in cirkels rond een site zag rennen, en ik weet zeker dat ik uiteindelijk terugga naar de SERP's, voor betere antwoorden. Die site kreeg toegetakeld door een brede kernupdate en later hersteld na het aanpakken van veel van deze problemen. Dus ja, meer negatieve signalen van gebruikersinteractie die Google moet evalueren.

Hier is een screenshot van dat bericht waarin de gedragsstroomrapportage voor gefrustreerde gebruikers wordt weergegeven:

En dan heb je nog de dia (en het motto) dat ik al heel lang gebruik in mijn presentaties over brede kernupdates, getiteld: “De hel heeft geen woede zoals een geminachte gebruiker”. Dit heeft betrekking op meer dan alleen de kwaliteit van de inhoud en omvat agressieve advertenties, barrières voor gebruikerservaringen en meer. Kortom, irriteer de gebruikers niet. Je zult een zware prijs betalen. En wat is trouwens een goede manier voor Google om geïrriteerde gebruikers te begrijpen? Welnu, door signalen van gebruikersinteractie te volgen, zoals een lage verblijftijd (iemand die snel terugrent naar de SERP's nadat hij een site van Google heeft bezocht).

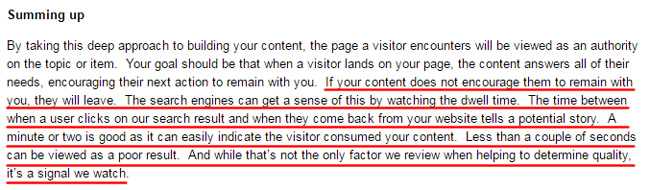

En wat betreft het onderwerp verblijftijd: een van mijn favoriete citaten was van jaren geleden, toen Duane Forrester van Bing een blogpost schreef waarin hij uitlegde hoe een lage verblijftijd de zichtbaarheid van zoekresultaten zou kunnen beïnvloeden. Duane werkt niet meer voor Bing, maar hij was jarenlang de Matt Cutts van Bing. In dat bericht, dat inmiddels is verwijderd (maar wel te vinden is via de wayback-machine), legde Duane het volgende uit:

“Als jouw inhoud hen niet aanmoedigt om bij je te blijven, zullen ze vertrekken. De zoekmachines kunnen hier een idee van krijgen door naar de verblijftijd te kijken. De tijd tussen het moment waarop een gebruiker op ons zoekresultaat klikt en het moment waarop deze terugkeert van uw website, vertelt een potentieel verhaal. Een minuut of twee is goed, omdat dit gemakkelijk kan aangeven dat de bezoeker uw inhoud heeft geconsumeerd. Minder dan een paar seconden kan als een slecht resultaat worden beschouwd. En hoewel dat niet de enige factor is die we beoordelen bij het bepalen van de kwaliteit, is het wel een signaal waar we naar kijken.”

Dan in nog een bericht op SEJ, Duane vervolgde:

“Dwell time was een van die concepten die volkomen logisch waren als ze eenmaal waren uitgelegd, en het was meteen duidelijk dat een dergelijke metriek heel belangrijk zou kunnen zijn bij het bepalen van de tevredenheid van zoekers.”

En ten slotte legde Duane uit dat er sprake was van “een mix van factoren”, wat belangrijk is om te begrijpen. Hij legde uit dat het najagen van verblijftijd een slecht idee was. Hij legde uit dat hij zich moest concentreren op het maken bredere verbeteringen voor een site die de gebruikersbetrokkenheid vergroot (en de verblijftijd kan toenemen als gevolg van dat werk). Dit is ook de reden waarom ik geloof dat de “gootsteenDe saneringsaanpak is een krachtige aanpak. Pak zoveel mogelijk kwaliteitsproblemen aan, en later kunnen er geweldige dingen gebeuren.

Let op: focus niet op de hoeveelheid tijd die Duane in 2011 heeft gegeven voor een “korte verloving”… Ik ben er zeker van dat dit een van de redenen is waarom het bericht is verwijderd. Voor sommige soorten inhoud is een kortere periode prima vanuit het oogpunt van gebruikersbetrokkenheid. Maar het belangrijkste punt over een lage verblijftijd, vooral als deze wordt gezien in veel delen van de inhoud van een site, is erg belangrijk om te begrijpen. Dat was toen, en dat is nu zeker zo.

Het belangrijkste punt dat ik probeer over te brengen is dat gebruikersinteractie op de een of andere manier altijd een factor leek te zijn... we wisten alleen niet precies hoe. Dat is totdat Navboost werd blootgesteld. Ik zal daar binnenkort meer over vertellen.

Waarom “zeer zichtbaar” belangrijk is: opmerkingen van John Mueller van Google.

Oké, laten we nu eens nader kijken naar wat ik noem “kwaliteitsindexering”. Nogmaals, dat betekent dat alleen uw inhoud van de hoogste kwaliteit die aan de verwachtingen van de gebruiker kan voldoen of deze overtreft, wordt geïndexeerd, terwijl u ervoor zorgt dat inhoud van lage kwaliteit of dunne inhoud niet wordt geïndexeerd.

Google heeft in de loop van de tijd uitgelegd dat bij de beoordeling van de kwaliteit rekening wordt gehouden met alle geïndexeerde pagina's. Ik heb dat vaak besproken in mijn blogposts en presentaties over grote algoritme-updates (vooral als het gaat om brede kernupdates).

Hier is John uit 2017 die dat uitlegt:

Maar na verloop van tijd merkte ik een verandering in de reactie van John toen hem werd gevraagd of hij inhoud van lagere kwaliteit wilde verwijderen. John begon uit te leggen dat hij zich zou concentreren op inhoud die ‘zeer zichtbaar’ en van lagere kwaliteit was. Ik hoorde dat in verschillende Hangout-video's van Search Central, en hij vertelde daar ook over in een interview met Marie Haynes.

Hier zijn enkele voorbeelden:

Ten eerste legt John hier uit dat niet alle dingen inhoudelijk gelijk zijn. Google zal proberen de belangrijkste pagina’s te achterhalen en zich daar op te concentreren:

Hier legt John uit dat Google de kerninhoud van een site kan begrijpen, waar bezoekers naartoe gaan, enz.

En hier legt John uit dat als je weet dat mensen bepaalde pagina's bezoeken, het zinvol zou zijn om eerst die pagina's van lagere kwaliteit aan te pakken (zodat mensen kunnen blijven hangen):

Dus waarom is dit belangrijk? Nu we meer weten over hoe Google gebruikmaakt van signalen van gebruikersinteractie om de zichtbaarheid en rankings via Navboost te beïnvloeden, is die verklaring van John heel logisch. Hoe meer gebruikersinteractiegegevens Google heeft voor combinaties van zoekopdrachten en bestemmingspagina's, hoe beter het gebruikerstevredenheid kan begrijpen. Als een pagina van lage kwaliteit is en niet zichtbaar is, beschikt Google niet over gegevens over gebruikersinteracties. Natuurlijk kan Google andere signalen, natuurlijke taalverwerking, enz. gebruiken om de inhoud beter te begrijpen, maar signalen van gebruikersinteractie zijn geweldig om de tevredenheid van zoekers te begrijpen.

Let op, voordat ik verder ging, wilde ik duidelijk zijn dat ik het nog steeds zou aanpakken allen problemen met de inhoudskwaliteit op een site (zelfs problemen die niet “zeer zichtbaar” zijn), maar ik zou beginnen met de meest zichtbare. Dat is een belangrijk punt voor site-eigenaren die te maken hebben met een grote daling van brede kernupdates, nuttige inhoudsupdates of recensiesupdates.

De antitrustproef van Google en signalen van gebruikersbetrokkenheid beïnvloeden de ranglijst.

Ik heb Navboost verschillende keren genoemd in dit bericht en ik wilde er in deze sectie op ingaan. Ik zal er niet heel diep op ingaan, omdat het onlangs in een aantal andere berichten in de branche is besproken, maar het is belangrijk om het te begrijpen.

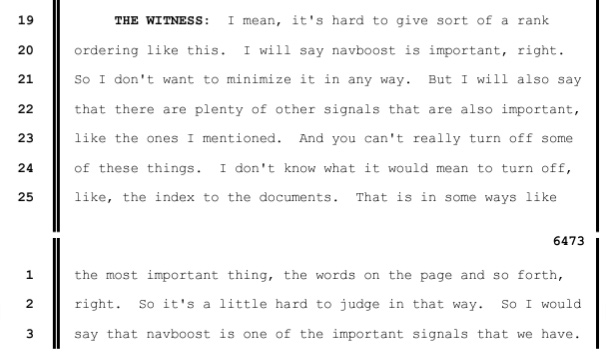

In de antitrustverklaring van Google legde Pandu Nayak het gebruik uit van Navboost, een systeem voor het benutten van gebruikersinteractiegegevens om Google te helpen het gebruikersgeluk te begrijpen. Het stelt Google in feite in staat om in de loop van de tijd van zijn gebruikers te leren en de ranglijst aan te passen op basis van die lessen. Navboost is uiteraard niet de enige factor die een rol speelt, maar het is wel een belangrijke factor bij het bepalen van de ranglijst.

Hier is Pandu Nayak over het belang van Navboost:

'Ik bedoel, het is moeilijk om zo'n rangorde te geven. Ik zal zeggen dat navboost belangrijk is, toch. Ik wil het dus op geen enkele manier bagatelliseren. Maar ik wil ook zeggen dat er nog tal van andere signalen zijn die ook belangrijk zijn, zoals de signalen die ik noemde. En sommige van deze dingen kun je niet echt uitschakelen. Ik weet niet wat het zou betekenen om bijvoorbeeld de index van de documenten uit te schakelen. Dat is in sommige opzichten het belangrijkste: de woorden op de pagina, enzovoort. Dus het is een beetje moeilijk om op die manier te oordelen. Dus ik zou zeggen dat navboost een van de belangrijke signalen is die we hebben."

Dus als pagina's goed zichtbaar zijn voor een zoekopdracht, verzamelt Google actief signalen van gebruikersbetrokkenheid voor die URL's en zoekopdrachtcombinaties (verzamelt nu 13 maanden aan klikgegevens). En Navboost kan deze signalen van gebruikersinteractie gebruiken om de systemen van Google inzicht te geven in de tevredenheid van gebruikers (waaronder inzicht in de verblijftijd, lange klikken, scrollen, zweven en meer).

En aan de andere kant: als pagina's niet goed zichtbaar zijn voor zoekopdrachten, kan Google die signalen van gebruikersinteractie niet benutten... of niet genoeg signalen om impact te hebben. Dit betekent niet dat Google de paginakwaliteit niet kan begrijpen, maar het zal wel ontbreken echte gebruikerssignalen voor die combinaties van zoekopdrachten en bestemmingspagina's. En dat is ongelooflijk belangrijk.

Let op: als u meer wilt weten over signalen van gebruikersinteractie uit de antitrustzaak van Google, schreef AJ Kohn een geweldige post met die informatie gebaseerd op de getuigenis van Pandu Nayak. Ik raad aan om het bericht van AJ te lezen als je dat nog niet hebt gedaan, omdat het meer gaat over Navboost, signalen van gebruikersinteractie, CTR als rankingfactor, enz.

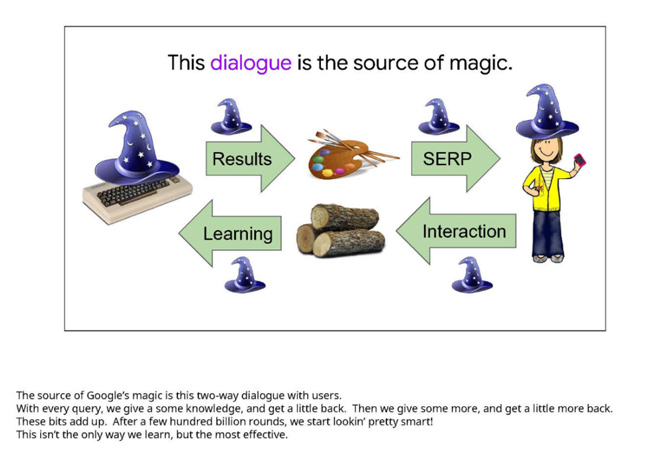

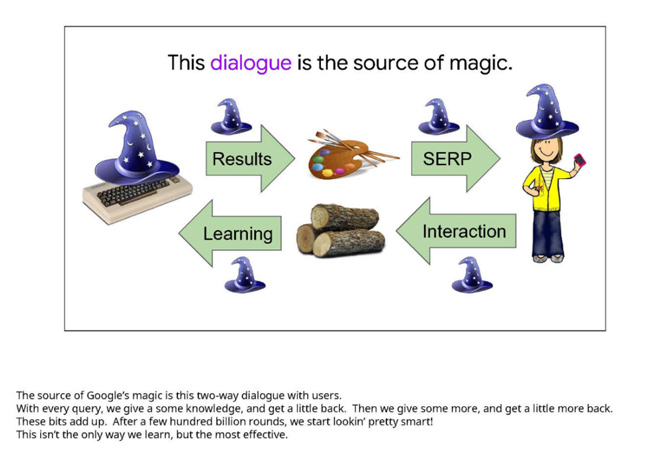

Hier is een dia uit een presentatie van Google die als bewijsmateriaal diende tijdens het proces. Het onderstreept het belang van signalen van gebruikersinteractie voor het bepalen van de tevredenheid van zoekers. Houd er rekening mee dat deze dia van enkele jaren geleden was. Het gaat over de “bron van de magie van Google”:

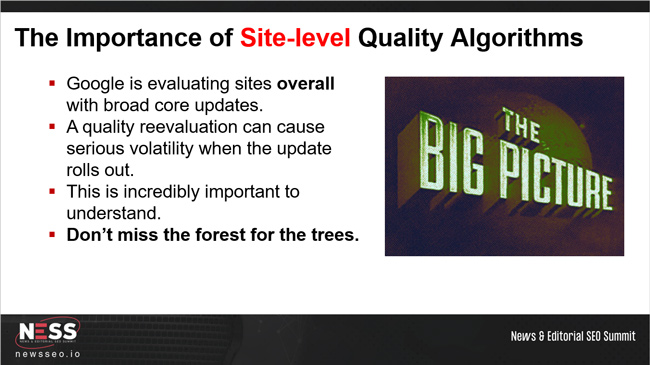

En vergeet de kwaliteitsalgoritmen op siteniveau niet:

Nogmaals, ik wil dit bericht niet verzanden met te veel informatie uit het antitrustproces, maar mijn kernpunt is dat “zeer zichtbare” inhoud in de SERP’s een heleboel signalen van gebruikersinteractie kan krijgen, die Google kan gebruiken als een factor voor ranglijsten. Het is ook mogelijk dat Google die gegevens ook in zijn geheel kan gebruiken om invloed uit te oefenen Kwaliteitsalgoritmen op siteniveau. En deze algoritmen op siteniveau kunnen een grote rol spelen in hoe sites het doen tijdens brede kernupdates (en andere belangrijke algoritme-updates). Ik heb daar ook lang over geklaagd.

Wat dit voor jou betekent. Mijn aanbeveling voor site-eigenaren die worden beïnvloed door grote algoritme-updates:

Voor site-eigenaren die zwaar getroffen worden door grote algoritme-updates, is het belangrijk om een stap terug te doen en een site in zijn geheel te analyseren vanuit een kwaliteitsperspectief. En zoals John Mueller van Google eerder heeft uitgelegd: 'kwaliteit' is meer dan alleen inhoud. Het gaat ook over UX-problemen, de advertentiesituatie, hoe dingen worden gepresenteerd en meer.

En nu met de bevestiging dat Google signalen van gebruikersinteractie gebruikt om de zichtbaarheid en rankings via Navboost te beïnvloeden, zou ik ‘zeer zichtbare’ URL’s hogerop in de lijst plaatsen bij het beslissen wat ik moet aanpakken. Ja, je moet alle kwaliteitsproblemen aanpakken die je tegenkomt, zelfs cruft die misschien niet erg zichtbaar is, maar ik zou prioriteit geven aan de URL's die het meest zichtbaar waren in de aanloop naar een grote algoritme-update. Dus ja, het uitvoeren van een deltarapport is nog belangrijker geworden.

Samenvatting: Breng alle inhoud van lage kwaliteit naar voren, maar begin met wat “zeer zichtbaar” is.

Door de jaren heen heb ik altijd uitgelegd dat inhoud op basis van de zoekopdracht aan de verwachtingen van de gebruiker moet voldoen of deze moet overtreffen. Met de laatste getuigenissen uit het antitrustproces van Google hebben we nu harde bewijzen dat Google inderdaad signalen van gebruikersinteractie gebruikt om de ranglijst aan te passen (en mogelijk kwaliteitsalgoritmen op siteniveau te beïnvloeden). Zorg er als site-eigenaar voor dat er geen lage kwaliteit, dunne of nutteloze inhoud in de SERP’s blijft staan waar gebruikers mee kunnen communiceren. Zoals ik door de jaren heen heb gezien bij grote algoritme-updates, zal dat niet goed aflopen. Pak zeker alle potentiële kwaliteitsproblemen op een site aan, maar vergeet niet wat goed zichtbaar is. Dat is een prima plek om te beginnen bij het verbeteren van de sitekwaliteit in het algemeen.

GG

- Door SEO aangedreven content en PR-distributie. Word vandaag nog versterkt.

- PlatoData.Network Verticale generatieve AI. Versterk jezelf. Toegang hier.

- PlatoAiStream. Web3-intelligentie. Kennis versterkt. Toegang hier.

- PlatoESG. carbon, CleanTech, Energie, Milieu, Zonne, Afvalbeheer. Toegang hier.

- Plato Gezondheid. Intelligentie op het gebied van biotech en klinische proeven. Toegang hier.

- Bron: https://www.gsqi.com/marketing-blog/highly-visible-and-low-quality/