U hebt een goede website gevonden en nu wilt u gegevens van de webpagina extraheren om uit te blinken. Hoe zou je dat doen? Kopiëren en plakken is zo ouderwets, vooral met interessante webscraping-tools die online beschikbaar zijn.

Webscraping is het proces van het automatisch extraheren van gegevens van websites. Java is een van de talen die worden gebruikt om webscraping-API's te bouwen. U kunt Java gebruiken om complexe webscrapingtaken uit te voeren, grote hoeveelheden gegevens te verwerken en aangepaste webscraping-applicaties te bouwen.

In deze zelfstudie over Java-webschrapen zullen we zien hoe u Java kunt gebruiken om eenvoudig webpagina's te schrapen met behulp van de populaire Jsoup-bibliotheek en andere essentiële hulpmiddelen. Dus pak je favoriete teksteditor, start je JVM en laten we aan de slag gaan!

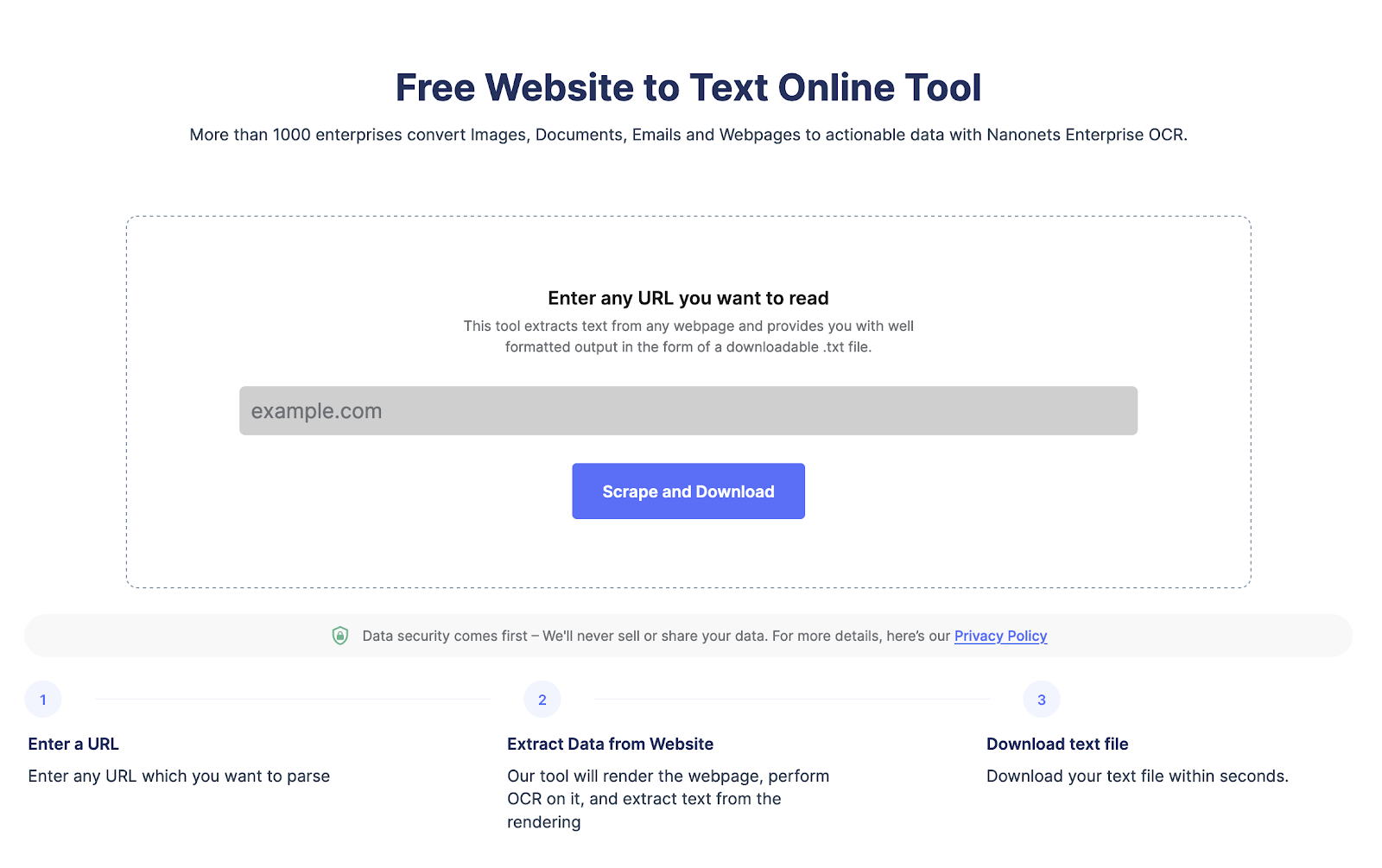

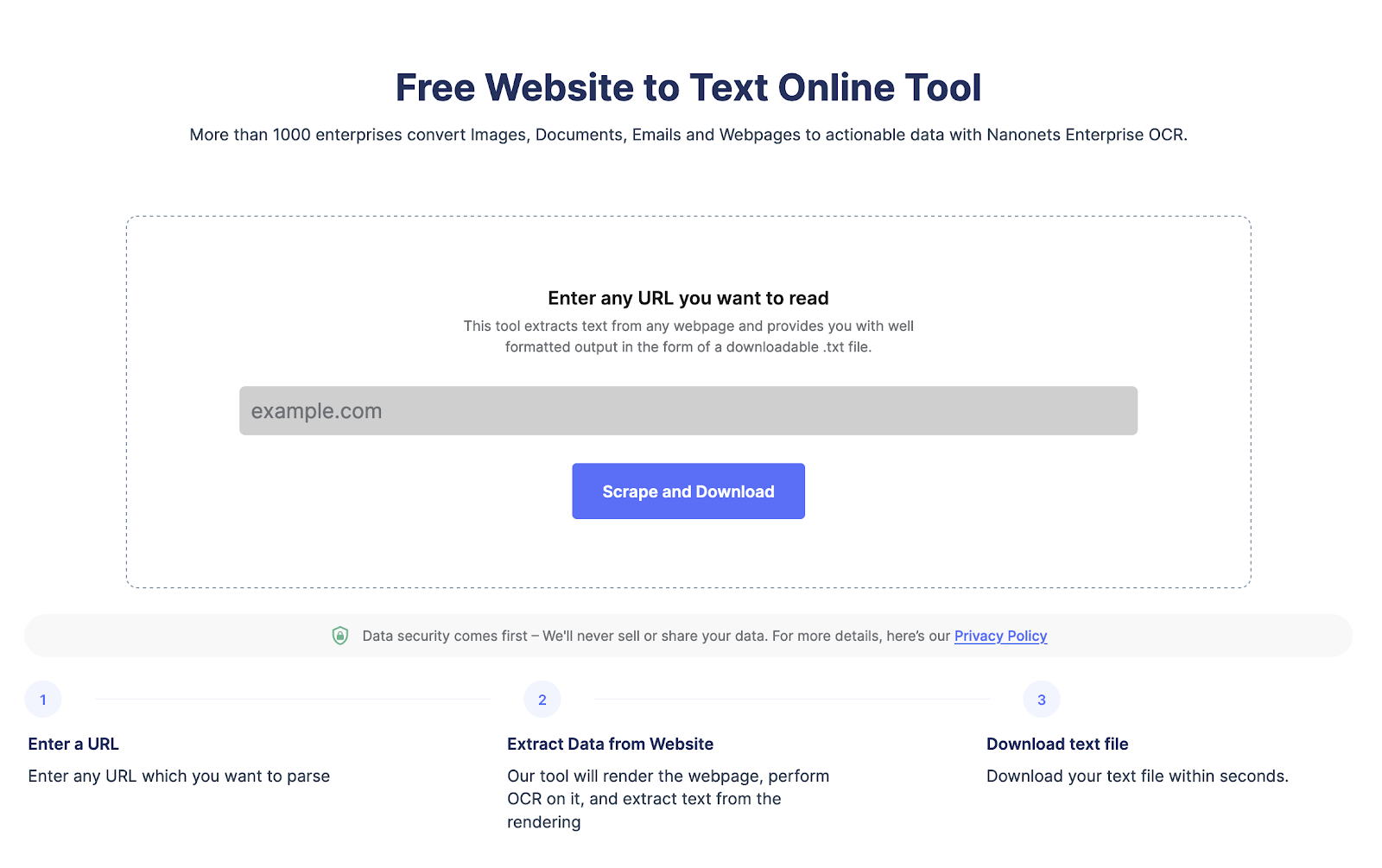

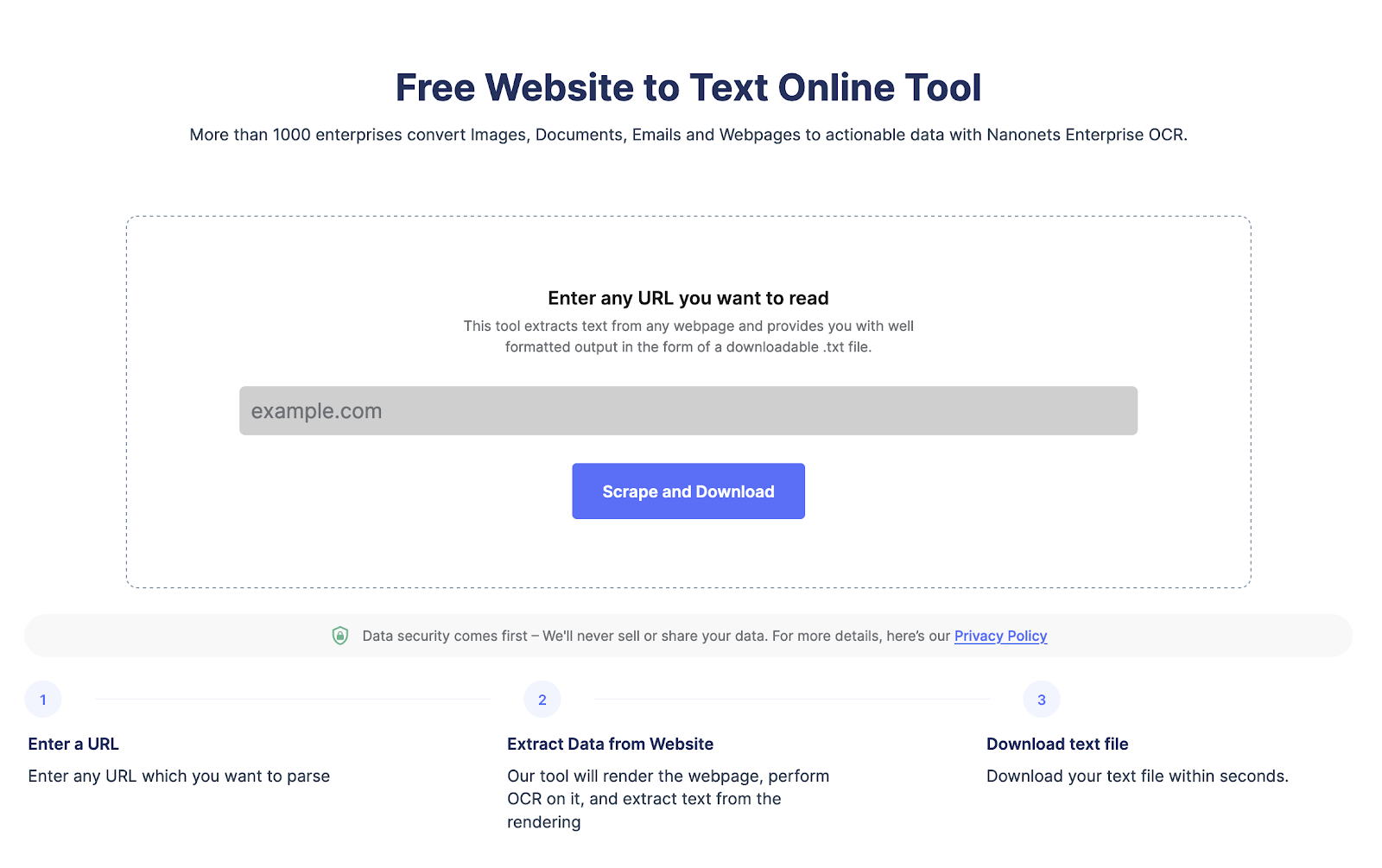

Extraheer tekst van elke webpagina met slechts één klik. Ga naar Nanonets website schraper, Voeg de URL toe en klik op "Schrapen" en download de webpagina-tekst direct als een bestand. Probeer het nu gratis.

Waarom Java gebruiken voor webscraping?

Java is om de volgende redenen een goede keuze voor webscraping:

- Het is veelzijdig en heeft een groot aantal webscraping-bibliotheken en -frameworks, waardoor het gemakkelijk te gebruiken is.

- Java kan aangepaste webscraping-taken aan met een hogere complexiteit en biedt meer automatisering in vergelijking met andere talen.

- Java heeft sterke ondersteuning voor multithreading. Hierdoor kunt u meerdere webpagina's tegelijkertijd schrapen.

- Java biedt geweldige ondersteuning voor gegevensanalyse en -verwerking, wat cruciaal is voor het verwerken van grote gegevenssets.

Enkele dingen om in gedachten te houden bij het gebruik van Java voor webscraping:

- Gebruik Jsoup- of Selenium-webschraapbibliotheken om het schraapproces te vereenvoudigen.

- Gebruik een krachtige proxyserver of wissel IP-adressen af om blokkering te voorkomen.

- Gebruik een schaalbare architectuur die grote hoeveelheden gegevens aankan en die in de loop van de tijd gemakkelijk te onderhouden is.

Hoe websitegegevens te schrapen met Java?

- Stap 1: Stel de omgeving in

- Stap 2: Inspecteer de pagina die u wilt schrapen

- Stap 3: Verzend een HTTP-verzoek en schrap de HTML

- Stap 4: Specifieke secties extraheren

- Stap 5: Exporteer de gegevens naar CSV.

Stap 1: Stel de omgeving in

Maak om te beginnen een nieuw project aan en importeer de vereiste Java-bibliotheken:

- Jsoep: Een geweldige bibliotheek om met HTML te werken en gegevens van websites te extraheren.

- Apache Commons Lang: Biedt een complete set hulpprogramma's voor het werken met tekenreeksen, arrays en andere veelgebruikte gegevenstypen.

U kunt Maven of Gradle gebruiken om de afhankelijkheden te beheren. Hier leest u hoe u afhankelijkheden kunt toevoegen met Maven

<dependencies>

<dependency>

<groupId>org.jsoup</groupId>

<artifactId>jsoup</artifactId>

<version>1.14.3</version>

</dependency>

<dependency>

<groupId>org.apache.commons</groupId>

<artifactId>commons-lang3</artifactId>

<version>3.12.0</version>

</dependency>

</dependencies>Stap 2: Inspecteer de pagina die u wilt schrapen

Klik met de rechtermuisknop op de pagina die u wilt schrapen en selecteer element inspecteren. Controleer alle namen van de elementen om ze goed te schrapen.

Stap 3: HTTP-verzoek verzenden

U moet een HTTP-verzoek naar de server sturen om gegevens van de webpagina te schrapen. Gebruik de klasse Java HttpURLConnection om HTTP-verzoeken te verzenden om verbinding te maken.

Hier is hoe het te doen:

String url = "https://www.example.com";

URL obj = new URL(url);

HttpURLConnection con = (HttpURLConnection) obj.openConnection();

// optional request header

con.setRequestProperty("User-Agent", "Mozilla/5.0");

int responseCode = con.getResponseCode();

System.out.println("Response code: " + responseCode);

BufferedReader in = new BufferedReader(new InputStreamReader(con.getInputStream()));

String inputLine;

StringBuilder response = new StringBuilder();

while ((inputLine = in.readLine()) != null) {

response.append(inputLine);

}

in.close();

String html = response.toString();Wat gebeurt er in de code?

In de bovenstaande code maken we een nieuw URL-object. En we proberen een verbinding met de server te openen met behulp van HttpURLConnection. We hebben onze identifier opgenomen als Mozilla Firefox. Ten slotte lezen we vervolgens het ontvangen antwoord van de server met behulp van BufferedReader. We voegen elke invoerregel toe aan StringBuilder om deze om te zetten in een leesbare string.

Stap 4: parseer het HTML-document

In deze stap zullen we het HTML-document ontleden met JSoup. We kunnen de elementen van de webpagina selecteren die we willen extraheren door tagnaam, klasse of ID te gebruiken en de DOM-structuur te doorlopen.

Hier is de code om Jsoup te gebruiken om HTML te ontleden.

Document doc = Jsoup.parse(html);

Elements links = doc.select("a[href]");

for (Element link : links) {

String href = link.attr("href");

System.out.println(href);

}In dit codefragment maken we eerst een nieuw Jsoup Document-object van de HTML-tekenreeks. Vervolgens gebruiken we de select-methode om alle links op de pagina te selecteren op basis van hun href-attribuut. We herhalen de links en extraheren de waarde van het href-attribuut met behulp van de attr-methode.

Stap 5: Sla de gegevens op in een CSV

Zodra we de gegevens hebben geëxtraheerd waarin we geïnteresseerd zijn, kunnen we deze opslaan in een bestand of database voor verdere analyse. In dit voorbeeld slaan we de koppelingen naar een CSV-bestand op met behulp van de Apache Commons CSV-bibliotheek.

Writer writer = Files.newBufferedWriter(Paths.get("links.csv"));

CSVPrinter csvPrinter = new CSVPrinter(writer, CSVFormat.DEFAULT);Extraheer tekst van elke webpagina met slechts één klik. Ga naar Nanonets website schraper, Voeg de URL toe en klik op "Schrapen" en download de webpagina-tekst direct als een bestand. Probeer het nu gratis.

Wat zijn de voordelen van het gebruik van Java voor webscraping?

- Krachtige bibliotheken: Java biedt verschillende krachtige bibliotheken, zoals JSoup en HtmlUnit, die het webscrapingproces vereenvoudigen en efficiënter maken. Deze bibliotheken bieden gebruiksvriendelijke API's voor het ontleden van HTML, het doen van netwerkverzoeken en het verwerken van JavaScript, cookies en AJAX.

- Compatibiliteit met meerdere platforms: Java is een platformonafhankelijke taal die op verschillende besturingssystemen en architecturen draait. Deze compatibiliteit maakt Java tot een veelzijdige keuze voor webscraping-taken, omdat uw code eenvoudig kan worden uitgevoerd en geïmplementeerd op verschillende platforms.

- Uitstekende prestatie: Java staat bekend om zijn prestaties, wat vooral belangrijk is bij het uitvoeren van grootschalige webscraping-taken. Java's just-in-time (JIT)-compilatie en opschoning zorgen ervoor dat uw webscraping-code efficiënt werkt, zelfs bij grote hoeveelheden gegevens of complexe websites.

- Sterk typen en foutcontrole: Java's krachtige type- en compilatiefoutcontrole kan helpen bij het voorkomen van bugs en runtime-fouten in uw webscraping-code. Deze functie maakt het gemakkelijker om potentiële problemen op te sporen voordat u uw scraper implementeert, wat leidt tot stabielere en betrouwbaardere code.

- Grote gemeenschap en ecosysteem: Java heeft een enorme gemeenschap van ontwikkelaars en een rijk ecosysteem van bibliotheken en frameworks, wat betekent dat u oplossingen, ondersteuning en bronnen kunt vinden voor bijna elk probleem dat u kunt tegenkomen tijdens webscraping.

Wat zijn de nadelen van het gebruik van Java voor webscraping?

- Steilere leercurve: Java kan uitdagender zijn dan andere talen zoals Python, vooral voor beginners. De syntaxis en concepten zijn misschien moeilijker te begrijpen voor degenen die nieuw zijn in programmeren of webscraping.

- Breedsprakigheid: Java is een uitgebreide taal, die webscraping-code langer en complexer kan maken dan in andere talen zoals Python. Deze breedsprakigheid kan leiden tot een toename van de ontwikkeltijd en het uitdagender maken om de code te lezen en te onderhouden.

- Ketelplaatcode: Java vereist vaak een aanzienlijke hoeveelheid standaardcode om klassen, objecten en methoden in te stellen. Dit kan leiden tot repetitieve en omslachtige code, waardoor het ontwikkelingsproces wordt vertraagd.

- Minder focus op webschrapen: Hoewel Java krachtige bibliotheken heeft, is de taal zelf niet specifiek ontworpen voor webscraping-taken. Talen zoals Python, met speciale webscraping-bibliotheken zoals Beautiful Soup en Scrapy, kunnen zich meer richten op webscraping-taken en een meer gestroomlijnde ervaring bieden.

- Gebrek aan moderne taalkenmerken: Java bestaat al heel lang en hoewel het zich blijft ontwikkelen, zijn sommige moderne taalfuncties, zoals die in Python of JavaScript, niet aanwezig in Java. Deze functies kunnen webscraping-taken efficiënter en gemakkelijker te implementeren maken.

Extraheer tekst van elke webpagina met slechts één klik. Ga naar Nanonets website schraper, Voeg de URL toe en klik op "Schrapen" en download de webpagina-tekst direct als een bestand. Probeer het nu gratis.

Conclusie

Java biedt verschillende voordelen voor webscraping, waaronder krachtige bibliotheken, compatibiliteit met meerdere platforms en uitstekende prestaties. Het heeft echter ook nadelen, zoals een steilere leercurve, breedsprakigheid en minder focus op webschrapen in vergelijking met andere talen zoals Python.

Overweeg zorgvuldig uw projectvereisten, ervaring en voorkeuren wanneer u beslist welke taal u wilt gebruiken voor webscraping. Door de stappen in dit artikel te volgen, samen met de gegeven voorbeelden en illustraties, kunt u eenvoudig een webscraping-project opzetten met Java en beginnen met het extraheren van waardevolle gegevens van websites.

Een ander alternatief is om geautomatiseerd te gebruiken tools voor het schrapen van websites like Nanonets. U kunt de gratis website-naar-tekst-tool. Maar als u webscraping voor grotere projecten moet automatiseren, kunt u contact opnemen met Nanonets.

FAQ

V1: Welke bibliotheken kan ik gebruiken voor webscraping in Java?

Enkele populaire Java-bibliotheken voor webscraping zijn JSoup, HtmlUnit en Selenium WebDriver. JSoup is een uitstekende keuze voor het ontleden en extraheren van gegevens uit statische HTML, terwijl HtmlUnit en Selenium WebDriver geschikter zijn voor het verwerken van dynamische websites met JavaScript.

V2: Hoe ga ik om met JavaScript tijdens webscraping met Java?

Om JavaScript te verwerken tijdens webscraping, kunt u HtmlUnit of Selenium WebDriver gebruiken. Beide bibliotheken kunnen communiceren met JavaScript en dynamische inhoud weergeven, zodat u gegevens die door JavaScript op de webpagina zijn gegenereerd, kunt openen en extraheren.

V3: Hoe voorkom ik dat ik geblokkeerd word tijdens webscraping met Java?

Om te voorkomen dat u tijdens het webschrapen wordt geblokkeerd, kunt u technieken implementeren zoals het roteren van user-agents, het gebruik van proxy's, het beperken van verzoekpercentages en het respecteren van het robots.txt-bestand van de website. Houd rekening met de servicevoorwaarden van de website en schrap altijd verantwoord.

V4: Kan ik multithreading gebruiken voor webscraping in Java?

Ja, u kunt multithreading gebruiken voor webschrapen in Java om het proces te versnellen en meerdere webpagina's tegelijkertijd te schrapen. Java biedt ingebouwde ondersteuning voor multithreading via de Thread-klasse en de ExecutorService-interface.

V5: Kan ik gegevens schrapen van websites die authenticatie met Java vereisen?

Ja, u kunt gegevens verzamelen van websites die authenticatie vereisen door inloggegevens op te geven en cookies te verwerken met behulp van Java-webscraping-bibliotheken zoals HtmlUnit of Selenium WebDriver. Met beide bibliotheken kunt u communiceren met webformulieren, inloggegevens indienen en sessies met cookies onderhouden.

V6: Hoe sla ik de geschraapte gegevens op in een gestructureerd formaat zoals CSV of JSON?

Nadat u de vereiste gegevens hebt geëxtraheerd, kunt u Java-bibliotheken zoals OpenCSV of Jackson gebruiken om de gegevens op te slaan in een gestructureerd formaat zoals CSV of JSON. Deze bibliotheken bieden gebruiksvriendelijke API's om gegevens in verschillende indelingen te lezen en te schrijven.

V7: Is webschrapen legaal?

De legaliteit van webscraping hangt af van de specifieke omstandigheden, de servicevoorwaarden van de website en het rechtsgebied waarin u actief bent. Respecteer altijd de servicevoorwaarden van de website, het robots.txt-bestand en relevante wet- en regelgeving om ervoor te zorgen dat uw webscraping-activiteiten legaal en ethisch zijn.

V8: Hoe ga ik om met CAPTCHA's tijdens webscraping met Java?

Om CAPTCHA's tijdens webscraping af te handelen, kunt u services van derden gebruiken, zoals 2Captcha of Anti-Captcha die API's bieden om CAPTCHA's op te lossen. U kunt ook proxyservices gebruiken om te voorkomen dat u CAPTCHA's tegenkomt. Het is echter essentieel om de intentie van de website-eigenaar om zijn gegevens te beschermen te respecteren en de ethische implicaties van het omzeilen van CAPTCHA's in overweging te nemen.

V9: Kan ik met Java gegevens extraheren van websites met oneindig scrollen?

Ja, u kunt gegevens extraheren van websites met oneindig scrollen met behulp van Java-webscraping-bibliotheken zoals Selenium WebDriver. Selenium WebDriver kan communiceren met JavaScript, door de pagina scrollen en dynamisch aanvullende inhoud laden, zodat u gegevens van websites kunt openen en extraheren met oneindig scrollen.

V10: Hoe kan ik plannen dat mijn webschraper in Java automatisch wordt uitgevoerd?

Om te plannen dat uw Java-webschraper automatisch wordt uitgevoerd, kunt u een taakplanner zoals cron (voor Linux en macOS) of Taakplanner (voor Windows) gebruiken. U kunt ook Java-bibliotheken zoals Quartz gebruiken om terugkerende taken binnen uw Java-toepassing te plannen en te beheren.

V11: Is Java of Python beter voor webscraping?

Zowel Java als Python hebben hun voordelen voor webschrapen. Java biedt uitstekende prestaties, compatibiliteit met meerdere platforms en krachtige bibliotheken. Python daarentegen heeft een eenvoudigere syntaxis, een zachtere leercurve en speciale webscraping-bibliotheken zoals Beautiful Soup en Scrapy. De keuze tussen Java en Python hangt af van uw projectvereisten, ervaring en persoonlijke voorkeuren.

V12: Is API beter dan webschrapen?

API's en webscraping hebben verschillende doelen. API's bieden een gestructureerde en betrouwbare manier om toegang te krijgen tot gegevens van een website, terwijl webscraping inhoudt dat gegevens rechtstreeks uit de HTML van de site worden gehaald. Als een website een API biedt, is het over het algemeen beter om de API te gebruiken, omdat deze stabieler en efficiënter is en de intenties van de site-eigenaar respecteert. Als een API echter niet beschikbaar is of niet de vereiste gegevens levert, kan webscraping een haalbaar alternatief zijn.

- Door SEO aangedreven content en PR-distributie. Word vandaag nog versterkt.

- Platoblockchain. Web3 Metaverse Intelligentie. Kennis versterkt. Toegang hier.

- Bron: https://nanonets.com/blog/java-web-scraping-tutorial/