Weet je nog dat Google's Bard, nu Gemini genoemd, kon een vraag over de James Webb-ruimtetelescoop niet beantwoorden in de lanceringsadvertentie? Laat me je geheugen opfrissen over deze beroemde zaak: het is een van de grootste voorbeelden van AI-hallucinaties die we hebben gezien.

Wat is er gebeurd? Tijdens de advertentie werd aan de Google Bard-demo gevraagd: "Welke nieuwe ontdekkingen van de James Webb-ruimtetelescoop kan ik delen met mijn 9-jarige?" Na een korte pauze gaf de Google Bard-demo twee correcte antwoorden. Het uiteindelijke antwoord was echter onjuist. Volgens de Google Bard-demo had de telescoop de eerste beelden gemaakt van een planeet buiten ons zonnestelsel. In werkelijkheid had de Very Large Telescope van de European Southern Observatory echter al beelden gemaakt van deze ‘exoplaneten’, die waren opgeslagen in de archieven van NASA.

Niet om een ~nou ja, eigenlijk~ eikel te zijn, en ik weet zeker dat Bard indrukwekkend zal zijn, maar voor de goede orde: JWST heeft niet "het allereerste beeld van een planeet buiten ons zonnestelsel" gemaakt.

de eerste afbeelding is in plaats daarvan gemaakt door Chauvin et al. (2004) met de VLT/NACO met behulp van adaptieve optica. https://t.co/bSBb5TOeUW pic.twitter.com/KnrZ1SSz7h

— Subsidie Tremblay (@astrogrant) 7 februari 2023

Waarom kunnen technologiegiganten als Google dergelijke fouten niet eens voorkomen? Dat zoeken we uit!

Wat is een AI-hallucinatie?

Een AI-hallucinatie treedt op wanneer een computerprogramma, doorgaans aangedreven door kunstmatige intelligentie (AI), resultaten produceert die onjuist, onzinnig of misleidend zijn. Deze term wordt vaak gebruikt om situaties te beschrijven waarin AI-modellen reacties genereren die volledig afwijken van het goede spoor of geen verband houden met de input die ze hebben gekregen. Het is alsof je een vraag stelt en een antwoord krijgt dat nergens op slaat of helemaal niet is wat je had verwacht.

Begrijpen waarom AI-hallucinaties gebeuren, laten we eens kijken hoe AI werkt. AI-modellen, zoals chatbots of beeldherkenningssystemen, worden getraind op grote datasets om patronen te leren en voorspellingen te doen. Als de trainingsgegevens echter gebrekkig, onvolledig of bevooroordeeld zijn, kan het AI-model onjuiste patronen of associaties leren. Dit kan leiden tot hallucinante resultaten waarbij de AI reacties genereert die gebaseerd zijn op foutieve of verkeerd begrepen informatie. En het komt veel voor, ook al heb je het misschien niet gemerkt.

AI-hallucinaties kunnen zich in verschillende vormen manifesteren, waarbij elk verschillende uitdagingen en ingewikkeldheden binnen kunstmatige-intelligentiesystemen benadrukt. Hier zijn enkele veel voorkomende soorten AI-hallucinaties:

- Zin AI hallucinatie:

- In dit scenario genereert het AI-model een zin die in strijd is met een eerdere uitspraak binnen dezelfde context. Bijvoorbeeld:

- Vraag: “Beschrijf de reis van een personage in zinnen van drie woorden.”

- Output: “Ze liep langzaam. Plotseling rende ze. Toen liep ze.”

- In dit scenario genereert het AI-model een zin die in strijd is met een eerdere uitspraak binnen dezelfde context. Bijvoorbeeld:

De laatste zin is in tegenspraak met de eerdere actie van rennen, waardoor de samenhang van het verhaal wordt verstoord.

- Prompt AI-hallucinatie:

- Dit type treedt op wanneer het door AI gegenereerde antwoord botst met de beoogde prompt of query. Bijvoorbeeld:

- Prompt: “Schrijf een recept voor chocoladetaart.”

- Output: “Hier is een gedicht over sterren.”

- Dit type treedt op wanneer het door AI gegenereerde antwoord botst met de beoogde prompt of query. Bijvoorbeeld:

De gegenereerde inhoud voldoet niet aan de kookgerelateerde vraag, wat erop wijst dat de context niet is begrepen.

- Feitelijke AI-hallucinatie:

- Feitelijke tegenstrijdigheden ontstaan wanneer het AI-model valse informatie als accuraat presenteert. Bijvoorbeeld:

- Prompt: “Noem drie elementen in het periodiek systeem.”

- Uitgang: "Waterstof, zuurstof, carboniet."

- Feitelijke tegenstrijdigheden ontstaan wanneer het AI-model valse informatie als accuraat presenteert. Bijvoorbeeld:

“Carboniet” is geen element dat tot verkeerde informatie in de reactie leidt.

- Irrelevante of willekeurige AI-hallucinaties:

- Deze hallucinaties omvatten het genereren van irrelevante of onzinnige informatie die geen verband houdt met de input. Bijvoorbeeld:

- Vraag: “Beschrijf een dag op het strand.”

- Output: “Het zand was warm. Meeuwen zongen jazz. Pinguïns dansten ballet.”

- Deze hallucinaties omvatten het genereren van irrelevante of onzinnige informatie die geen verband houdt met de input. Bijvoorbeeld:

De vermelding van pinguïns en ballet komt niet overeen met het typische strandtafereel, wat een gebrek aan samenhang in het gegenereerde verhaal aantoont.

Dit soort hallucinaties onderstrepen de uitdagingen waarmee AI-systemen worden geconfronteerd bij het nauwkeurig begrijpen en contextualiseren van informatie. Om deze problemen aan te pakken, is het nodig de kwaliteit van de trainingsgegevens te verbeteren, het begrip van de context door taalmodellen te verfijnen en robuuste validatiemechanismen te implementeren om de samenhang en nauwkeurigheid van door AI gegenereerde resultaten te garanderen.

AI-hallucinaties kunnen ernstige gevolgen hebben, vooral in toepassingen waarbij AI wordt gebruikt om belangrijke beslissingen te nemen, zoals medische diagnoses of financiële handel. Als een AI-systeem in deze contexten hallucineert en onnauwkeurige informatie verstrekt, kan dit tot schadelijke gevolgen leiden.

Wat kun je doen tegen AI-hallucinaties?

Het verminderen van AI-hallucinaties omvat een paar belangrijke stappen om AI-systemen nauwkeuriger en betrouwbaarder te maken:

Ten eerste is het cruciaal om data van goede kwaliteit te gebruiken om AI te trainen. Dit betekent dat we ervoor moeten zorgen dat de informatie waaruit AI leert divers, accuraat en vrij van vooroordelen is.

Het vereenvoudigen van AI-modellen kan ook helpen. Complexe modellen kunnen soms tot onverwachte fouten leiden. Door het simpel te houden, kunnen we de kans op fouten verkleinen.

Duidelijke en gemakkelijk te begrijpen instructies zijn ook belangrijk. Wanneer AI duidelijke input krijgt, is de kans kleiner dat het in de war raakt en fouten maakt.

Regelmatig testen helpt om eventuele fouten in een vroeg stadium op te sporen. Door te controleren hoe goed AI presteert, kunnen we eventuele problemen oplossen en verbeteringen aanbrengen.

Het toevoegen van controles binnen AI-systemen kan ook helpen. Deze controles letten op fouten en corrigeren deze voordat ze problemen veroorzaken.

Het allerbelangrijkste is dat menselijk toezicht essentieel is. Door mensen de door AI gegenereerde output dubbel te laten controleren, wordt nauwkeurigheid en betrouwbaarheid gegarandeerd.

Ten slotte kan het trainen van AI om zich tegen aanvallen te verdedigen haar veerkrachtiger maken. Dit helpt AI pogingen om het te manipuleren of te misleiden te herkennen en aan te pakken.

Door deze stappen te volgen kunnen we AI-systemen betrouwbaarder maken en de kans op hallucinaties verkleinen.

Hoe laat je een AI hallucineren?

Als je van deze fout wilt profiteren en plezier wilt hebben, kun je een paar dingen doen:

- Wijzig de invoer: U kunt de informatie die aan de AI wordt gegeven, aanpassen. Zelfs kleine veranderingen kunnen ervoor zorgen dat er vreemde of onjuiste antwoorden ontstaan.

- Bedrieg het model: Creëer speciale input die de AI voor de gek houdt en verkeerde antwoorden geeft. Deze trucs maken gebruik van de zwakke punten van het model om hallucinante resultaten te creëren.

- Knoei met de gegevens: Door misleidende of onjuiste informatie toe te voegen aan de trainingsgegevens van de AI of aan uw prompt, kunt u ervoor zorgen dat deze de verkeerde dingen leert en hallucinaties veroorzaakt.

- Pas het model aan: Pas de instellingen of structuur van de AI aan om fouten of vooroordelen te introduceren. Deze veranderingen kunnen ervoor zorgen dat het vreemde of onzinnige resultaten genereert.

- Geef verwarrende input: Geef de AI onduidelijke of tegenstrijdige instructies. Dit kan de AI in verwarring brengen en tot onjuiste of onzinnige reacties leiden.

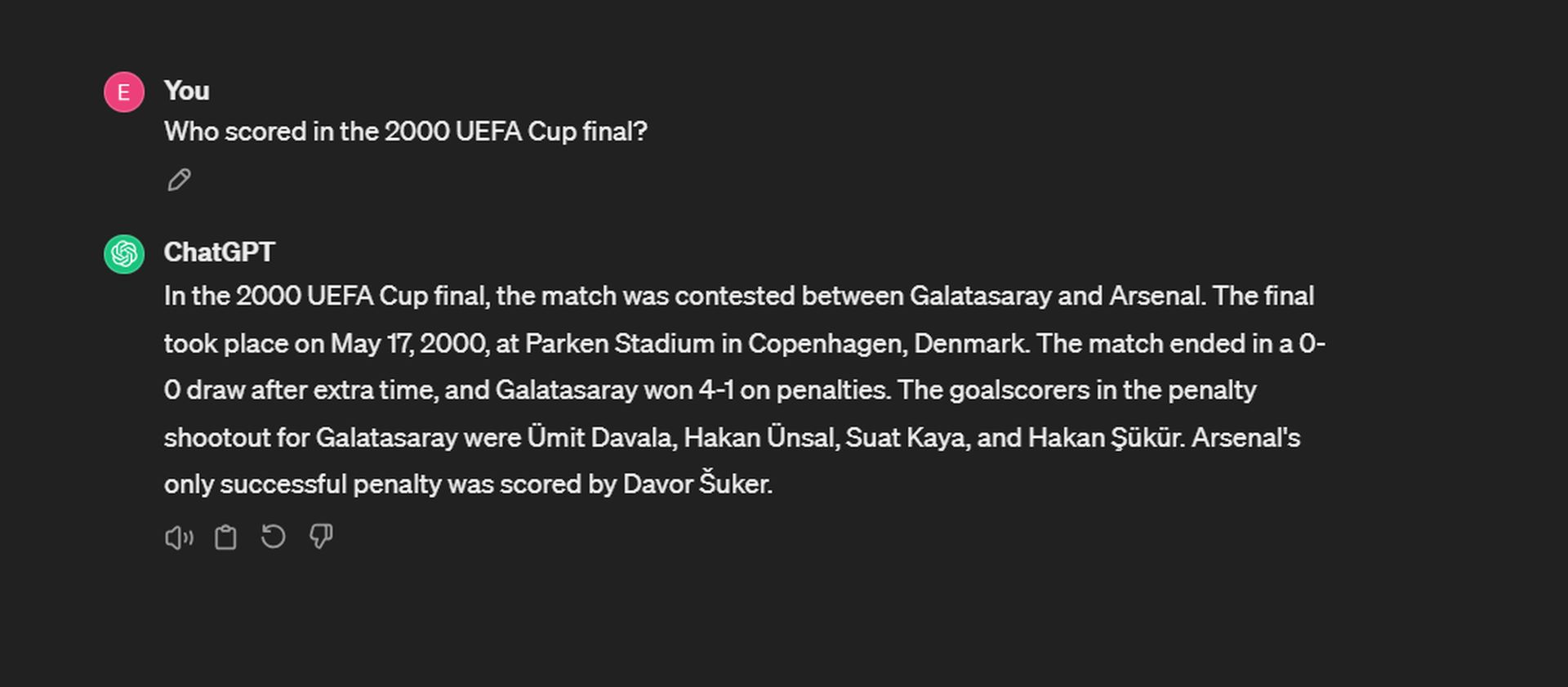

Of u kunt gewoon vragen stellen en uw geluk beproeven! We hebben bijvoorbeeld geprobeerd ChatGPT te laten hallucineren:

Hoewel ChatGPT de datum en de score nauwkeurig onthoudt, hapert het bij het terugroepen van de scorers van de penalty shootout. Voor Galatasaray werden de doelpunten gescoord door Ergün Penbe, Hakan Şükür, Ümit Davala en Popescu. Aan de kant van Arsenal was Ray Parlour de enige succesvolle penaltyscorer.

Hoewel het hallucineren van AI ons kan helpen de beperkingen ervan te begrijpen, is het belangrijk om deze kennis op verantwoorde wijze te gebruiken en ervoor te zorgen dat AI-systemen betrouwbaar en betrouwbaar blijven.

Hallucineert GPT 4 minder?

Ja, volgens de evaluatie uitgevoerd door het in Palo Alto gevestigde bedrijf met behulp van hun Hallucination Evaluation Model, GPT-4 toont een lager hallucinatiepercentage aan vergeleken met andere grote taalmodellen, behalve Intel Neural Chat 7B (97.2%). Met een nauwkeurigheidspercentage van 97% en een hallucinatiepercentage van 3% vertoont GPT-4 een hoog nauwkeurigheidsniveau en een relatief lage neiging om hallucinaties te introduceren bij het samenvatten van documenten. Dit geeft aan dat GPT-4 minder gevoelig is voor het genereren van onjuiste of onzinnige resultaten vergeleken met andere modellen die in de evaluatie zijn getest.

Aan de andere kant waren enkele van de minst effectieve modellen afkomstig van Google. Google Palm2 toonde een nauwkeurigheidspercentage van 90% en een hallucinatiepercentage van 10% aan. Zijn chat-verfijnde tegenhanger presteerde zelfs nog slechter, met een nauwkeurigheidspercentage van slechts 84.2% en de hoogste hallucinatiescore van elk model op het scorebord met 16.2%. Hier is de lijst:

Samenvattend is een AI-hallucinatie een fout gemaakt door AI-systemen waarbij ze resultaten produceren die onzinnig of onjuist zijn vanwege fouten in de trainingsgegevens of de manier waarop ze informatie verwerken. Het is een fascinerend, maar uitdagend aspect van AI waar onderzoekers en ontwikkelaars aan werken.

- Door SEO aangedreven content en PR-distributie. Word vandaag nog versterkt.

- PlatoData.Network Verticale generatieve AI. Versterk jezelf. Toegang hier.

- PlatoAiStream. Web3-intelligentie. Kennis versterkt. Toegang hier.

- PlatoESG. carbon, CleanTech, Energie, Milieu, Zonne, Afvalbeheer. Toegang hier.

- Plato Gezondheid. Intelligentie op het gebied van biotech en klinische proeven. Toegang hier.

- Bron: https://dataconomy.com/2024/04/11/what-exactly-is-an-ai-hallucination-and-why-does-it-matter/