In februari maakte OpenAI grote indruk met de onthulling van Sora, een indrukwekkende AI-tool die tekstprompts kan omzetten in boeiende video's. Met Sora kunnen gebruikers hun ideeën tot leven brengen, terwijl ze kijken hoe de AI dynamische video's van 60 seconden maakt op basis van korte tekstaanwijzingen. Maar een andere speler in de stad maakt furore op het internet: VideoPoet, een tool voor het genereren van video's van Google die drie maanden eerder op de markt verscheen.

VideoPoet is het geesteskind van een team van 31 onderzoekers bij Google Research en is een gamechanger in de wereld van multimediacreatie. Terwijl Sora zich richt op het omzetten van tekst in visuele verhalen, pakt VideoPoet het anders aan. Het blinkt uit in het maken van realistische video's met behulp van tekst, afbeeldingen of zelfs bestaande videobeelden, dankzij geavanceerde technieken zoals autoregressieve taalmodellering en tokenizers zoals MAGVIT V2 en SoundStream. Deze veelzijdigheid opent een wereld van mogelijkheden voor digitale kunst, filmproductie en interactieve media.

Bron: Google Onderzoek

Wat VideoPoet onderscheidt is de unieke architectuur. Hoewel veel modellen voor het genereren van video's afhankelijk zijn van op diffusie gebaseerde methoden, die in dit veld als de best presterende worden beschouwd, heeft Google Research een andere route gekozen. In plaats van het populaire Stable Diffusion-model te gebruiken, kozen Google-onderzoekers voor een groot taalmodel (LLM) gebaseerd op de transformatorarchitectuur. Dit type AI-model, dat doorgaans wordt gebruikt voor het genereren van tekst en code, is opnieuw gebruikt om video's te genereren – een gedurfde zet die VideoPoet onderscheidt van de massa.

“De meeste bestaande modellen maken gebruik van diffusiegebaseerde methoden die vaak worden beschouwd als de huidige toppresteerders op het gebied van videogeneratie. Deze videomodellen beginnen doorgaans met een vooraf getraind beeldmodel, zoals Stable Diffusion, dat hifi-beelden produceert voor individuele frames, en vervolgens het model verfijnen om de temporele consistentie tussen videoframes te verbeteren”, schreef het Google Research-team in hun pre- beoordeling research paper.

Wat is VideoPoet en hoe werkt het?

In de kern gebruikt VideoPoet een autoregressief taalmodel om te leren van verschillende modaliteiten zoals video, beeld, audio en tekst. Dit wordt mogelijk gemaakt door meerdere tokenizers te gebruiken:MAGVIT V2 voor video en beeld, en SoundStream voor audio.

Wanneer het model tokens genereert op basis van een bepaalde context, worden deze tokens later terug omgezet in een zichtbare representatie met behulp van de decoder van de betreffende tokenizer. Dit maakt een naadloze vertaling tussen verschillende vormen van media mogelijk, waardoor een samenhangend en alomvattend begrip van alle modaliteiten wordt gegarandeerd. Hieronder staan de componenten van VideoPoet:

- Vooraf getrainde MAGVIT V2- en SoundStream-tokenizers, die afbeeldingen, video- en audiofragmenten vertalen naar een reeks codes die het model kan begrijpen.

- Een autoregressief taalmodel dat leert van verschillende modaliteiten (video, beeld, audio en tekst) om het volgende token in de reeks te voorspellen.

- Een reeks generatieve leerdoelen, waaronder tekst-naar-video, tekst-naar-afbeelding, afbeelding-naar-video en meer, waarmee VideoPoet diverse video's van hoge kwaliteit kan maken.

Revolutionaire functies en mogelijkheden

Net als Sora en Stable Diffusion heeft VideoPoet een aantal revolutionaire functies die een nieuw perspectief bieden op het maken van video's.

Video's met hoge beweging en variabele lengte: In tegenstelling tot traditionele modellen maakt VideoPoet moeiteloos video's met veel beweging en variabele lengte, waarbij de grenzen worden verlegd van wat mogelijk is bij het genereren van video's.

Cross-modaliteit leren: Een van de sterke punten van VideoPoet ligt in zijn vermogen om via verschillende modaliteiten te leren. Door de kloof tussen tekst, afbeeldingen, video's en audio te overbruggen, biedt VideoPoet een holistisch begrip dat het creatieve proces verrijkt.

Interactieve bewerkingsmogelijkheden: VideoPoet genereert niet alleen video's, maar biedt gebruikers ook interactieve bewerkingsfuncties. Van het uitbreiden van invoervideo's tot het besturen van bewegingen en het toepassen van gestileerde effecten op basis van tekstprompts: het legt de creatieve controle in handen van de gebruiker.

Google's VideoPoet is meer dan alleen een tool voor het genereren van video's: het is een game-changer in de wereld van AI. Door meerdere mogelijkheden naadloos te integreren in één enkel groot taalmodel (LLM), herdefinieert het het landschap van videogeneratie. De veelzijdigheid in het verwerken van tekst, beeld en audio maakt het onmisbaar voor zowel makers van inhoud als AI-enthousiastelingen, waardoor een nieuwe standaard wordt gezet voor creativiteit en innovatie.

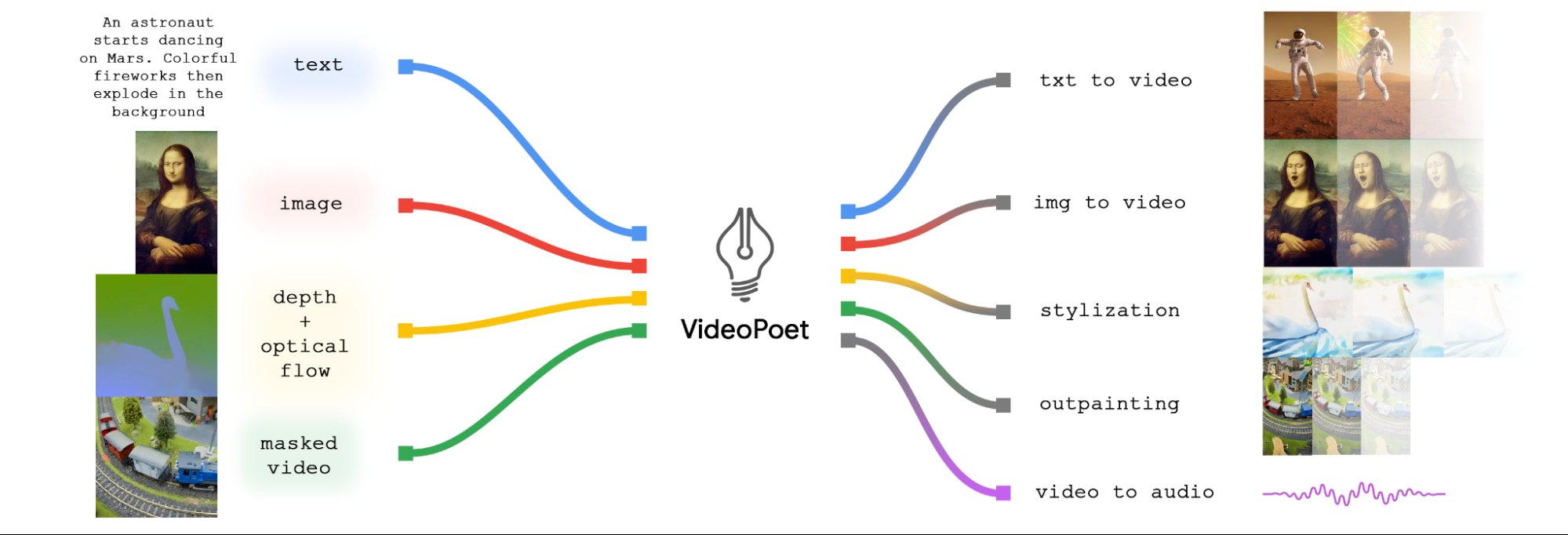

Hier is een overzicht van de mogelijkheden van VideoPoet aan de hand van het onderstaande diagram.

Ten eerste kunnen invoerbeelden tot leven worden gebracht met animatie, waardoor dynamische bewegingen in de video ontstaan. Bovendien hebben gebruikers de mogelijkheid om video's te bewerken door bepaalde gebieden bij te snijden of te maskeren, waardoor naadloze in- of outpainting-effecten mogelijk zijn.

Als het om stilering gaat, werkt het model magisch door een video te analyseren die diepte en optische stroming vastlegt – in wezen de beweging binnen de scène. Met behulp van deze informatie worden stilistische elementen toegepast, geleid door tekstaanwijzingen, waardoor de algehele visuele aantrekkingskracht van de video wordt vergroot.

Maar genoeg technisch jargon: laten we het over de resultaten hebben. Om de mogelijkheden van VideoPoet te demonstreren, produceerde het Google Research-team een korte film op basis van aanwijzingen van Bard, een verhalende AI. Het resultaat? Een charmant verhaal over een reizende wasbeer, tot leven gebracht via een reeks boeiende videoclips. Het is een bewijs van de kracht van AI bij het vertellen van verhalen en een kijkje in de toekomst van multimediacreatie.

[Ingesloten inhoud]

In een wereld waar content centraal staat, veranderen tools als Sora en VideoPoet het spel, waardoor makers hun ideeën tot leven kunnen brengen op manieren die nog nooit eerder mogelijk waren. Met hun geavanceerde mogelijkheden en gebruiksvriendelijke interfaces staan deze AI-gestuurde tools klaar om een revolutie teweeg te brengen in de manier waarop we verhalen vertellen en onszelf uitdrukken via video.

- Door SEO aangedreven content en PR-distributie. Word vandaag nog versterkt.

- PlatoData.Network Verticale generatieve AI. Versterk jezelf. Toegang hier.

- PlatoAiStream. Web3-intelligentie. Kennis versterkt. Toegang hier.

- PlatoESG. carbon, CleanTech, Energie, Milieu, Zonne, Afvalbeheer. Toegang hier.

- Plato Gezondheid. Intelligentie op het gebied van biotech en klinische proeven. Toegang hier.

- Bron: https://techstartups.com/2024/04/12/videopoet-google-looks-to-challenge-openai-sora-and-stable-diffusion-for-dominance-in-ai-video-creation/