Heeft u er ooit bij stilgestaan hoe zoekmachines als Google binnen enkele seconden de perfecte antwoorden op uw vragen vinden?

Achter de schermen van elke zoekopdracht schuilt een complex proces dat bekend staat als zoekmachine-indexering, een fundamenteel mechanisme waarmee zoekmachines relevante inhoud van internet kunnen organiseren, analyseren en ophalen.

Als u uw online aanwezigheid wilt optimaliseren, is het belangrijk om de indexering van zoekmachines te begrijpen.

In dit bericht geven we u een uitgebreid inzicht in zoekmachine-indexering.

Laten we dus, zonder verder oponthoud, de indexering van zoekmachines in detail onderzoeken.

1 Wat is zoekmachine-indexering?

Het indexeren van zoekmachines is als het creëren van een enorme catalogus of index van alle inhoud die op internet beschikbaar is.

Het omvat het systematisch scannen, analyseren en organiseren van webpagina's, documenten, afbeeldingen, video's en alle andere soorten inhoud, zodat zoekmachines snel relevante informatie kunnen ophalen als reactie op vragen van het publiek.

Het proces van zoekmachine indexeren omvat de volgende fasen:

- Kruipen: Crawlers van zoekmachines, ook wel spiders of bots genoemd, navigeren systematisch op internet, bezoeken webpagina's en volgen links om nieuwe inhoud te ontdekken.

- Indexeren: Deze fase omvat het verwerken en analyseren van tekstuele inhoud, evenals belangrijke tags en attributen zoals , alt-attributen voor afbeeldingen, video's, enz. De geëxtraheerde informatie wordt vervolgens opgeslagen in een gestructureerde indexdatabase, waardoor de zoekmachine snel relevante inhoud kan ophalen en aanbieden als reactie op vragen van gebruikers.

- ranking: Ten slotte gebruiken zoekmachines complexe algoritmen om geïndexeerde pagina’s te rangschikken op basis van relevantie, autoriteit en gebruikersbetrokkenheid, zodat de meest relevante en nuttige inhoud bovenaan de zoekresultaten verschijnt.

Voordat we bespreken hoe zoekmachine-indexering werkt, moeten we eerst het belang van indexering voor zoekmachines begrijpen.

2 Belang van zoekmachine-indexering

Indexering is belangrijk voor zoekmachines omdat ze hierdoor informatie efficiënt van internet kunnen verwerken en ophalen.

Zonder indexering zullen zoekmachines moeite hebben om nauwkeurige en tijdige resultaten aan het publiek te leveren.

Door indexering kunnen zoekmachines snel relevante informatie van miljarden webpagina's lokaliseren en ophalen, zodat uw publiek tijdige en nauwkeurige zoekresultaten ontvangt.

Door webinhoud te organiseren en te categoriseren, helpt indexering zoekmachines een betere gebruikerservaring te bieden door het publiek relevante en nuttige informatie te bieden als antwoord op hun vragen.

Het helpt zoekmachines ook bij het verwerken van complexe zoekopdrachten door snel relevante inhoud uit verschillende bronnen, formaten en talen te identificeren en op te halen.

Indexering helpt het publiek nieuwe en relevante inhoud te ontdekken, doordat het gemakkelijker wordt om er doorheen te navigeren.

3 Hoe werkt zoekmachine-indexering?

Zoals we kort hebben besproken, omvatten zoekmachines crawlen, indexeren en rangschikken om een site te indexeren. Laten we ze nu in detail bespreken.

3.1 Kruipen

Crawlen verwijst, in de context van zoekmachines, naar het proces van systematisch surfen op internet om webpagina's en andere online-inhoud te ontdekken en op te halen.

Rol van webcrawlers

Webcrawlers, ook wel spiders of bots genoemd (Googlebots), spelen een belangrijke rol in het crawlproces. Ze fungeren als geautomatiseerde agenten die het internet doorkruisen, webpagina's bezoeken en gegevens verzamelen die door zoekmachines moeten worden geïndexeerd.

Webcrawlers zijn verantwoordelijk voor het ontdekken van nieuwe inhoud, het bijwerken van bestaande informatie en het garanderen dat de indexen van zoekmachines uitgebreid en actueel zijn.

Hoe webcrawlers nieuwe inhoud ontdekken

Webcrawlers gebruiken verschillende technieken om nieuwe inhoud op internet te ontdekken.

Een veelgebruikte methode is om te beginnen met een lijst met bekende webpagina's en links van die pagina's naar andere pagina's te volgen.

Crawlers maken ook gebruik van sitemaps, dit zijn XML-bestanden die een routekaart bieden voor de structuur van een website en die crawlers helpen efficiënter te navigeren en inhoud te ontdekken.

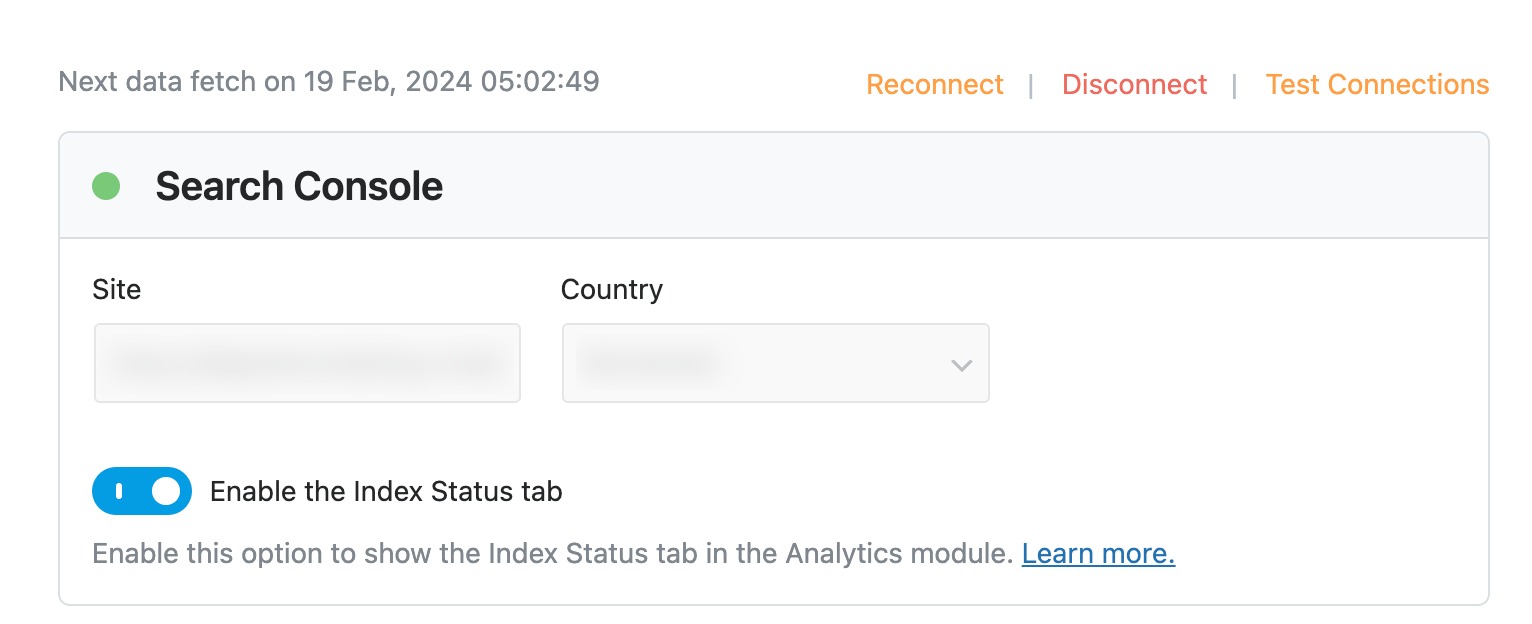

Als je Rank Math's gebruikt Analytics functie, het automatisch verzendt de sitemap naar Google Search Console. Er is geen handmatige indiening vereist als u Rank Math aan uw Google-account heeft gekoppeld en de Search Console-instellingen heeft geconfigureerd.

U kunt meer te leren over Sitemaps in ons speciale artikel en los de problemen met de sitemap op als je wat hebt.

Technieken die door webcrawlers worden gebruikt om door websites te navigeren en gegevens te verzamelen

Webcrawlers gebruiken verschillende technieken om te navigeren en gegevens van websites te verzamelen:

- Link-overgang: Crawlers volgen hyperlinks van de ene webpagina naar de andere en verkennen systematisch het onderling verbonden netwerk van internet.

- URL-normalisatie: Crawlers normaliseren URL's om consistentie te garanderen en te voorkomen dat dubbele of overtollige inhoud wordt gecrawld.

- Robots.txt: Crawlers controleren op a robots.txt-bestand op websites om te bepalen welke pagina's moeten worden gecrawld en welke moeten worden uitgesloten.

- HTML-parsering: Crawlers analyseren de HTML-code van webpagina's om informatie zoals tekst, links, afbeeldingen en metagegevens te extraheren.

3.2 Indexeren

Indexeren is het analyseren van een stuk tekst of code volgens een reeks regels of syntaxis.

In eerste instantie haalt de webcrawler de HTML-code van een webpagina op van de server. Zodra de HTML-code is verkregen, ondergaat deze HTML-parsing, waarbij deze wordt geanalyseerd om de structuur en verschillende elementen van de webpagina te identificeren, inclusief koppen, paragrafen, links, afbeeldingen en metadata.

Vervolgens extraheert de parser tekstuele inhoud uit de HTML-code, inclusief de hoofdtekst, koppen en andere zichtbare tekstelementen, om de essentie van de inhoud van de pagina vast te leggen.

Metadata-elementen zoals title-tags, metabeschrijvingenen meta-trefwoorden worden geparseerd om het begrip van de inhoud van de pagina te verrijken.

Omgaan met dubbele inhoud en problemen met canonicalisering

Bij indexeren gaat het ook om het aanpakken van dubbele inhoud en problemen met canonicalisering, die kunnen optreden wanneer meerdere URL's naar dezelfde of vergelijkbare inhoud verwijzen. Dit kan het volgende inhouden:

- Het identificeren canonieke URL's en het consolideren van dubbele inhoud om te voorkomen dat overtollige pagina's worden geïndexeerd.

- Implementatie van canonieke tags of 301-omleidingen om de voorkeurs-URL voor indexering op te geven.

- Het detecteren en verwerken van gesyndiceerde of dubbele inhoud uit verschillende bronnen om nauwkeurige indexering en rangschikking te garanderen.

Raadpleeg onze onderstaande video om canonieke tags in te stellen in Rank Math.

Hoe zoekmachines de relevantie en het belang van geïndexeerde pagina's bepalen

Zoekmachines gebruiken complexe rangschikkingsalgoritmen om de relevantie en het belang van geïndexeerde pagina’s te bepalen.

Deze algoritmen houden rekening met verschillende factoren, zoals de aanwezigheid van zoektermen in de inhoud, de kwaliteit en autoriteit van de website, statistieken over gebruikersbetrokkenheid en contextuele relevantie.

Pagina's die relevanter en belangrijker zijn, krijgen een hogere ranking in de zoekresultaten, waardoor het publiek de meest relevante en nuttige inhoud ontvangt als antwoord op hun vragen.

3.3 Ranking

Zodra de pagina's zijn gecrawld en geïndexeerd, is het tijd om ze te rangschikken.

Zoekmachines gebruiken verschillende algoritmen, zoals PageRank, om rankings te bepalen, die de kwaliteit en kwantiteit van inkomende links naar een pagina evalueren.

Verschillende factoren beïnvloeden de rangschikking van webpagina's. Relevantie voor de zoekopdracht is belangrijk, waarbij pagina's met inhoud die nauw aansluit bij de intentie van de gebruiker doorgaans een hogere ranking krijgen.

Autoriteit speelt een belangrijke rol, rekening houdend met factoren als de geloofwaardigheid van de website, de kwaliteit van de inhoud en het aantal gerenommeerde sites die ernaar verwijzen.

Statistieken over gebruikersbetrokkenheid, zoals klikfrequenties, bouncepercentages en de tijd die op een pagina wordt doorgebracht, zijn ook van invloed op de ranglijst en weerspiegelen de gebruikerstevredenheid en interesse in de inhoud.

4 Veelgestelde Vragen / FAQ

Wat is het verschil tussen crawlen en indexeren?

Bij crawlen gaat het om het ontdekken en ophalen van webpagina's, terwijl bij indexeren het analyseren en opslaan van informatie van die pagina's in een doorzoekbare database betrokken is.

Wat is de impact van de laadsnelheid van de pagina op de indexering?

Sneller ladende pagina's krijgen tijdens het indexeren prioriteit van zoekmachines, omdat ze een betere gebruikerservaring bieden en de kans groter is dat ze hoger in de zoekresultaten worden gerangschikt.

Hoe kunt u de zichtbaarheid van uw website in de zoekresultaten van zoekmachines verbeteren?

U kunt de zichtbaarheid in de resultaten van zoekmachines verbeteren door relevante inhoud van hoge kwaliteit te creëren, de websites te optimaliseren voor mobielvriendelijkheid en snelheid, gerenommeerde backlinks te verdienen van gezaghebbende bronnen en zich te houden aan best practices voor zoekmachineoptimalisatie (SEO).

Hoe vaak worden de indexen van zoekmachines bijgewerkt?

De indexen van zoekmachines worden voortdurend bijgewerkt om wijzigingen en updates van de webinhoud weer te geven, waarbij de frequentie van updates varieert afhankelijk van factoren zoals de populariteit en het belang van de website.

Welke veelgemaakte fouten kunnen voorkomen dat een webpagina wordt geïndexeerd?

Veel voorkomende fouten die ervoor kunnen zorgen dat een webpagina niet wordt geïndexeerd, zijn onder meer het blokkeren van crawlers van zoekmachines met robots.txt-bestanden, het gebruik van meta-robottags om indexering te voorkomen en het optreden van crawlfouten zoals verbroken links of serverfouten.

5 Conclusie

Zoekmachine-indexering speelt een belangrijke rol in de manier waarop websites door zoekmachines worden ontdekt en gerangschikt.

Door webpagina's te crawlen en te analyseren, creëren zoekmachines een georganiseerde index van informatie om relevante en nauwkeurige zoekresultaten aan uw publiek te leveren.

Als u het proces van zoekmachine-indexering begrijpt, kunt u uw pagina's optimaliseren voor betere zichtbaarheid en hogere rankings.

Dus onthoud de volgende keer dat u online naar iets zoekt, dat er achter de schermen een complex indexeringssysteem bestaat, zodat u binnen enkele seconden de meest relevante resultaten kunt vinden.

Veel plezier met zoeken!

Vind je dit bericht leuk, laat het ons dan weten via Tweeten @rankmathseo.

- Door SEO aangedreven content en PR-distributie. Word vandaag nog versterkt.

- PlatoData.Network Verticale generatieve AI. Versterk jezelf. Toegang hier.

- PlatoAiStream. Web3-intelligentie. Kennis versterkt. Toegang hier.

- PlatoESG. carbon, CleanTech, Energie, Milieu, Zonne, Afvalbeheer. Toegang hier.

- Plato Gezondheid. Intelligentie op het gebied van biotech en klinische proeven. Toegang hier.

- Bron: https://rankmath.com/blog/how-search-engine-indexing-works/