Introductie

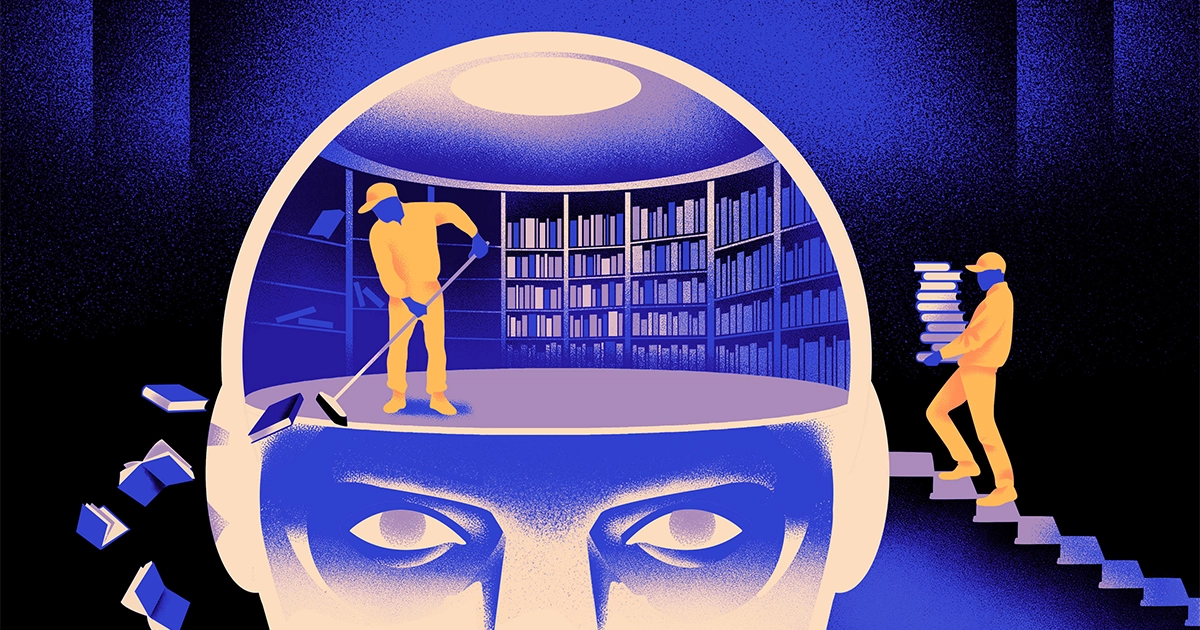

Een team van computerwetenschappers heeft een wendbaarder, flexibeler type van het machine learning-model. De truc: het moet periodiek vergeten wat het weet. En hoewel deze nieuwe aanpak de enorme modellen die ten grondslag liggen aan de grootste apps niet zal vervangen, zou het wel meer kunnen onthullen over hoe deze programma's taal begrijpen.

Het nieuwe onderzoek markeert “een aanzienlijke vooruitgang in het veld”, aldus de onderzoekers Jea Kwon, een AI-ingenieur aan het Institute for Basic Science in Zuid-Korea.

De AI-taalengines die tegenwoordig worden gebruikt, worden grotendeels aangedreven door kunstmatige neurale netwerken. Elk ‘neuron’ in het netwerk is een wiskundige functie die signalen van andere neuronen ontvangt, enkele berekeningen uitvoert en signalen door meerdere lagen neuronen stuurt. Aanvankelijk is de informatiestroom min of meer willekeurig, maar door training verbetert de informatiestroom tussen neuronen naarmate het netwerk zich aanpast aan de trainingsgegevens. Als een AI-onderzoeker bijvoorbeeld een tweetalig model wil maken, traint ze het model met een grote stapel tekst uit beide talen, waardoor de verbindingen tussen neuronen zo worden aangepast dat de tekst in één taal wordt gerelateerd aan gelijkwaardige teksten. woorden in de andere.

Maar dit trainingsproces vergt veel rekenkracht. Als het model niet zo goed werkt, of als de behoeften van de gebruiker later veranderen, is het moeilijk om het aan te passen. “Stel dat je een model hebt dat 100 talen heeft, maar stel je voor dat de gewenste taal niet gedekt is”, zegt hij Mikel Artetxe, co-auteur van het nieuwe onderzoek en oprichter van de AI-startup Reka. “Je kunt helemaal opnieuw beginnen, maar ideaal is dat niet.”

Artetxe en zijn collega's hebben geprobeerd deze beperkingen te omzeilen. Een paar jaar geledentrainden Artetxe en anderen een neuraal netwerk in één taal en wisten vervolgens wat het wist over de bouwstenen van woorden, tokens genaamd. Deze worden opgeslagen in de eerste laag van het neurale netwerk, de zogenaamde inbeddingslaag. Ze lieten alle andere lagen van het model met rust. Nadat ze de tokens van de eerste taal hadden gewist, trainden ze het model opnieuw op de tweede taal, waardoor de inbeddingslaag werd gevuld met nieuwe tokens uit die taal.

Ook al bevatte het model niet-overeenkomende informatie, de herscholing werkte: het model kon de nieuwe taal leren en verwerken. De onderzoekers vermoedden dat terwijl de inbeddingslaag informatie opsloeg die specifiek was voor de woorden die in de taal werden gebruikt, de diepere niveaus van het netwerk meer abstracte informatie opsloegen over de concepten achter menselijke talen, wat het model vervolgens hielp de tweede taal te leren.

“We leven in dezelfde wereld. We conceptualiseren dezelfde dingen met verschillende woorden”, zei hij Yihong Chen, de hoofdauteur van het recente artikel. “Daarom heb je dezelfde redenering op hoog niveau in het model. Een appel is iets zoets en sappigs, in plaats van slechts een woord.”

Introductie

Hoewel deze vergeetbenadering een effectieve manier was om een nieuwe taal toe te voegen aan een reeds getraind model, was de herscholing nog steeds veeleisend: er waren veel taalkundige gegevens en verwerkingskracht voor nodig. Chen stelde een aanpassing voor: in plaats van te trainen, de inbeddingslaag te wissen en vervolgens opnieuw te trainen, zouden ze de inbeddingslaag periodiek moeten resetten tijdens de eerste trainingsronde. “Door dit te doen raakt het hele model gewend aan resetten”, zegt Artetxe. "Dat betekent dat als je het model naar een andere taal wilt uitbreiden, dat gemakkelijker is, omdat je dat hebt gedaan."

De onderzoekers gebruikten een veelgebruikt taalmodel genaamd Roberta, trainden het met behulp van hun techniek voor periodiek vergeten, en vergeleken het met de prestaties van hetzelfde model toen het werd getraind met de standaard, niet-vergeetbenadering. Het vergeetmodel deed het iets slechter dan het conventionele model en behaalde een score van 85.1 vergeleken met 86.1 op één algemene maatstaf voor taalnauwkeurigheid. Vervolgens hebben ze de modellen opnieuw getraind in andere talen, waarbij ze veel kleinere datasets van slechts 5 miljoen tokens gebruikten, in plaats van de 70 miljard die ze tijdens de eerste training gebruikten. De nauwkeurigheid van het standaardmodel daalde gemiddeld naar 53.3, maar het vergeetmodel daalde slechts naar 62.7.

Het vergeetmodel deed het ook veel beter als het team tijdens de hertraining rekenlimieten oplegde. Toen de onderzoekers de trainingslengte terugbrachten van 125,000 stappen naar slechts 5,000, daalde de nauwkeurigheid van het vergeetmodel gemiddeld naar 57.8, terwijl het standaardmodel daalde naar 37.2, wat niet beter is dan willekeurige gissingen.

Introductie

Het team concludeerde dat periodiek vergeten het model beter lijkt te maken in het leren van talen in het algemeen. “Omdat [ze] tijdens de training steeds weer vergeten en opnieuw leren, wordt het gemakkelijker om het netwerk later iets nieuws te leren”, zegt hij Evgenii Nikishin, een onderzoeker bij Mila, een deep learning onderzoekscentrum in Quebec. Het suggereert dat wanneer taalmodellen een taal begrijpen, ze dit op een dieper niveau doen dan alleen de betekenis van individuele woorden.

De aanpak is vergelijkbaar met hoe onze eigen hersenen werken. “Het menselijk geheugen is over het algemeen niet erg goed in het nauwkeurig opslaan van grote hoeveelheden gedetailleerde informatie. In plaats daarvan hebben mensen de neiging om de essentie van onze ervaringen te onthouden, te abstraheren en te extrapoleren”, zegt hij Benjamin Levy, een neurowetenschapper aan de Universiteit van San Francisco. “Het mogelijk maken van AI met meer menselijke processen, zoals adaptief vergeten, is een manier om ze flexibeler te laten presteren.”

Naast wat het zou kunnen zeggen over hoe begrip werkt, hoopt Artetxe dat flexibelere vergeettaalmodellen ook kunnen helpen de nieuwste AI-doorbraken naar meer talen te brengen. Hoewel AI-modellen goed zijn in het omgaan met Spaans en Engels, twee talen met voldoende trainingsmateriaal, zijn de modellen niet zo goed in zijn moedertaal Baskisch, de lokale taal die specifiek is voor Noordoost-Spanje. “De meeste modellen van grote technologiebedrijven doen het niet goed,” zei hij. “Bestaande modellen aanpassen aan het Baskisch is de juiste keuze.”

Chen kijkt ook uit naar een wereld waarin meer AI-bloemen bloeien. “Ik denk aan een situatie waarin de wereld niet één groot taalmodel nodig heeft. We hebben er zoveel”, zei ze. “Als er een fabriek is die taalmodellen maakt, heb je dit soort technologie nodig. Het heeft één basismodel dat zich snel kan aanpassen aan nieuwe domeinen.”

- Door SEO aangedreven content en PR-distributie. Word vandaag nog versterkt.

- PlatoData.Network Verticale generatieve AI. Versterk jezelf. Toegang hier.

- PlatoAiStream. Web3-intelligentie. Kennis versterkt. Toegang hier.

- PlatoESG. carbon, CleanTech, Energie, Milieu, Zonne, Afvalbeheer. Toegang hier.

- Plato Gezondheid. Intelligentie op het gebied van biotech en klinische proeven. Toegang hier.

- Bron: https://www.quantamagazine.org/how-selective-forgetting-can-help-ai-learn-better-20240228/