We bevinden ons in de Grote Versnelling – een singulariteit, niet in de in hoofdletters geschreven S-Kurzweiliaanse betekenis van robots die in opkomst zijn, maar in degene die Foucault beschreef: Een tijdsperiode waarin verandering zo wijdverspreid en zo fundamenteel is dat men niet goed kan Ontdek hoe de andere kant van die verandering eruit zal zien.

We hebben eerder singulariteiten meegemaakt:

- De opkomst van de landbouw (die overtollige hulpbronnen creëerde en ons de academische en handelsklassen gaf).

- De uitvinding van de drukpers (die kennis democratiseerde en minder kneedbaar maakte, waardoor we het idee kregen van een bron van waarheid die verder gaat dan onze eigen zintuigen).

- De stoommachine (die machines fysieke taken laat uitvoeren).

- Computersoftware (waarmee we machines instructies kunnen geven die we moeten volgen).

- Het internet en smartphones (die ons allemaal interactief met elkaar verbinden).

Deze singulariteit is, in zijn eenvoudigste vorm, dat we hebben een nieuw soort software uitgevonden.

Het oude soort software

Het oude soort software – die momenteel op jullie telefoons en computers staat – heeft onze levens veranderd op een manier die ze bijna onherkenbaar maakt voor iemand uit de jaren zeventig. De mensheid had vijftig jaar de tijd om zich aan te passen aan software, omdat het langzaam begon met academici en vervolgens met hobbyisten, met inbelmodems en zakelijke e-mail. Maar zelfs met een halve eeuw om zich aan te passen, worstelt onze beschaving met het omgaan met de gevolgen ervan.

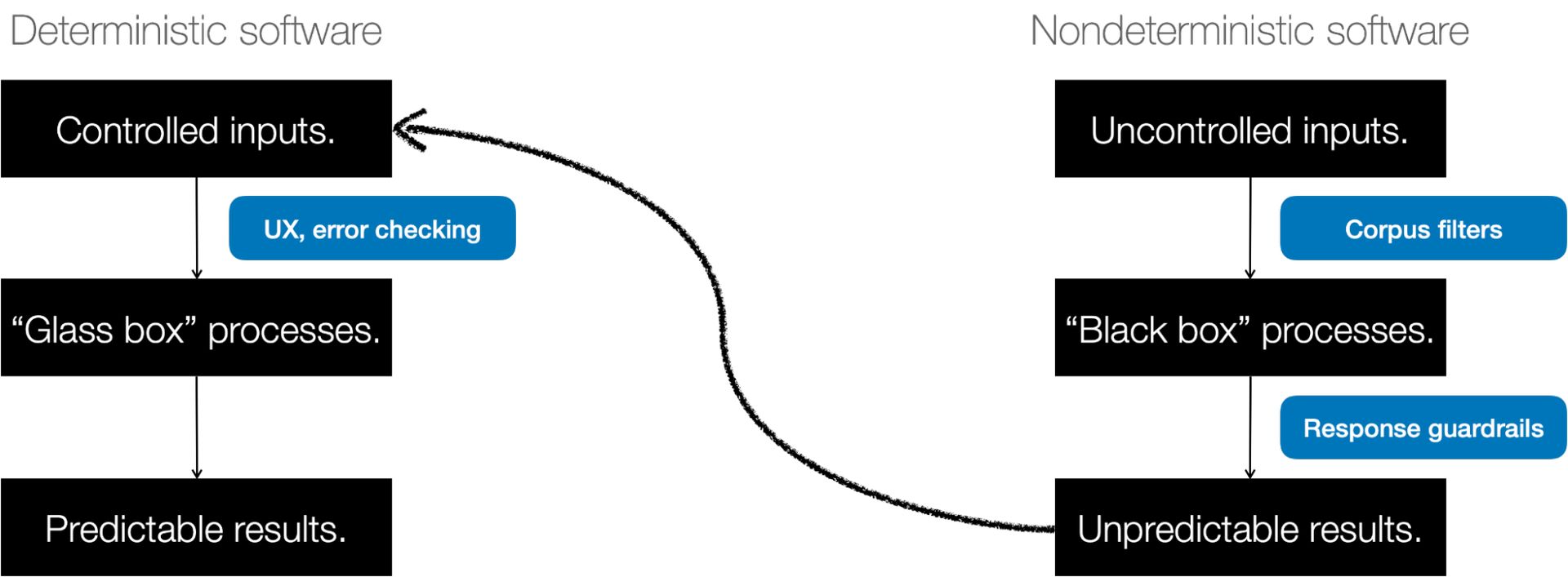

De software waarmee u tegenwoordig bekend bent – het spul dat berichten verzendt, getallen optelt, iets in een agenda boekt of zelfs een videogesprek aanstuurt – is deterministisch. Dat betekent het doet wat je ervan verwacht. Als het resultaat onverwacht is, wordt dat een bug genoemd.

Van deterministische software tot AI

Eerdere voorbeelden van ‘denkmachines’ waren onder meer cybernetica (feedbackloops zoals automatische piloten) en expertsystemen (beslisbomen voor artsen). Maar deze waren nog steeds voorspelbaar en begrijpelijk. Ze hielden zich gewoon aan een heleboel regels.

In de jaren tachtig probeerden we een andere aanpak. We hebben software zo gestructureerd dat deze zich als de hersenen gedraagt, door er ‘neuronen’ aan te geven. En vervolgens laten we het zichzelf configureren aan de hand van voorbeelden. In 1980 probeerde een jonge onderzoeker genaamd Yann LeCun dit uit op het gebied van beeldclassificatie.

Hij is nu hoofd AI bij Meta.

Toen ging AI in een soort winterslaap. Er werd vooruitgang geboekt, maar die verliep traag en vond plaats in de academische wereld. Deep learning, TensorFlow en andere technologieën ontstonden, vooral om zoekmachines, aanbevelingen en advertenties aan te drijven. Maar AI gebeurde achter de schermen, in advertentiediensten, kaarten en stemherkenning.

In 2017 publiceerden enkele onderzoekers een baanbrekend artikel met de titel: ‘Aandacht is alles wat je nodig hebt.’ De auteurs werkten destijds bij Google, maar velen zijn inmiddels overgestapt naar bedrijven als OpenAI. Het artikel beschreef een veel eenvoudigere manier om software zichzelf te laten configureren door aandacht te besteden aan de delen van de taal die er het meest toe deden.

Een vroeg gebruik hiervoor was vertaling. Als je een algoritme voldoende Engelse en Franse tekst invoert, kan het erachter komen hoe het van de ene naar de andere taal moet vertalen door de relaties tussen de woorden van elke taal te begrijpen. Maar door de basisaanpak konden we software trainen op tekst die van internet was geschraapt.

Vanaf dat moment ging de vooruitgang vrij snel. In 2021 hebben we ontdekt hoe we een ‘instructiemodel’ konden maken dat gebruik maakte van een proces genaamd Supervised Fine Tuning (SFT) om de conversatie-AI de instructies te laten volgen. In 2022 lieten we mensen de reacties op onze instructies beoordelen (genaamd Modified Supervised Fine Tuning), en eind 2022 voegden we iets toe genaamd Reinforcement Learning on Human Feedback, wat ons GPT-3.5 en ChatGPT opleverde. AI's kunnen nu andere AI's feedback geven.

Hoe het ook zij, in 2024 zullen mensen de input zijn waarop dingen worden getraind, en de feedback geven over de kwaliteit van de output die wordt gebruikt om deze te verbeteren.

Wanneer onverwacht een functie is, geen bug

Het resultaat is een nieuw soort software. Om het te laten werken, verzamelen we eerst grote hoeveelheden gegevens en gebruiken deze om een enorm wiskundig model te trainen. Vervolgens voeren we een prompt in het model in en deze voorspelt de reactie die we willen (veel mensen realiseren zich dat niet). Zodra een AI is getraind, geeft dezelfde input elke keer dezelfde output – degene die volgens hem ‘het beste’ is). Maar we willen creativiteit, dus voegen we een verstoring toe, genaamd temperatuur, die de AI vertelt hoeveel willekeur in zijn reacties moet worden geïnjecteerd.

We kunnen op voorhand niet voorspellen wat het model gaat doen. En we introduceren opzettelijk willekeur om elke keer verschillende reacties te krijgen. Het hele punt van deze nieuwe software is om onvoorspelbaar te zijn. Niet-deterministisch zijn. Het doet onverwachte dingen.

In het verleden stopte je iets in de applicatie en volgde deze een reeks instructies die mensen schreven, en er kwam een verwacht resultaat uit. Nu stop je iets in een AI en het volgt een reeks instructies it schreef, en aan de andere kant komt er een onverwacht resultaat naar voren. En het onverwachte resultaat is geen bug, het is een functie.

Ongelooflijk snelle adoptie

We adopteren deze tweede soort software veel sneller dan de eerste, om verschillende redenen

- Het maakt zijn eigen gebruikershandleiding: Hoewel we allemaal enthousiast zijn over hoe goed de resultaten zijn, zien we vaak over het hoofd hoe goed het kan reageren op eenvoudige invoer. Dit is de eerste software zonder leercurve. Het vertelt letterlijk iedereen die kan typen of spreken hoe het moet worden gebruikt. Het is de eerste software die zijn eigen documentatie creëert.

- Iedereen kan het proberen: Dankzij de alomtegenwoordige connectiviteit via mobiele telefoons en breedband, en het SaaS-model van gehoste software, hebben veel mensen toegang. U hoeft geen software meer te kopen en te installeren. Iedereen met een browser kan het proberen.

- Hardware is overal: GPU's uit gaming, de chips uit de M-serie van Apple en cloud computing zorgen ervoor dat immense computerbronnen triviaal eenvoudig te implementeren zijn.

- De kosten daalden. Veel: Sommige algoritmische ontwikkelingen hebben de kosten van AI met meerdere ordes van grootte verlaagd. De kosten voor het classificeren van een miljard afbeeldingen daalden van $10,000 in 2021 naar $0.03 in 2023 – een tarief dat 450 keer goedkoper is per dag.

- Wij leven online: Mensen zijn gemiddeld zes uur per dag online, en een groot deel van die interactie (e-mail, chatrooms, sms'en, bloggen) is op tekst gebaseerd. In de online wereld is een mens grotendeels niet te onderscheiden van een algoritme, dus er zijn veel eenvoudige manieren geweest om AI-uitvoer te koppelen aan de feeds en schermen die mensen consumeren. COVID-19 versnelde het werken op afstand, en daarmee ook de insinuatie van tekst en algoritmen in ons leven.

Wat niet-deterministische software kan doen

Niet-deterministische software kan veel dingen doen, waarvan we ons sommige nu pas beginnen te realiseren.

- Het is generatief. Het kan nieuwe dingen creëren. We zien dit in afbeeldingen (Stable Diffusion, Dall-e) en muziek (Google MusicLM) en zelfs in financiën, genomica en detectie van bronnen. Maar de plaats die de meeste aandacht krijgt, zijn chatbots zoals die van OpenAI, Google, Perplexity en anderen.

- Het is goed in creativiteit, maar het maakt dingen op. Dat betekent dat we het de ‘leuke’ banen geven, zoals kunst, proza en muziek waarvoor geen ‘juist antwoord’ bestaat. Het betekent ook een vloed aan desinformatie en een epistemische crisis voor de mensheid.

- Het nog steeds heeft veel menselijke inbreng nodig om de uitvoer te filteren in iets bruikbaars. Bij veel van de stappen bij het produceren van een conversationele AI gaat het erom dat mensen hem voorbeelden geven van goede reacties, of de reacties die hij geeft, beoordelen.

- Omdat het vaak verkeerd is, moeten we iemand de schuld kunnen geven. De mens die beslist wat hij met de output doet, is dat wel aansprakelijk voor de gevolgen.

- It kan redeneren op manieren waarvan we dachten dat het niet zou kunnen. Wij begrijpen niet waarom dit zo is.

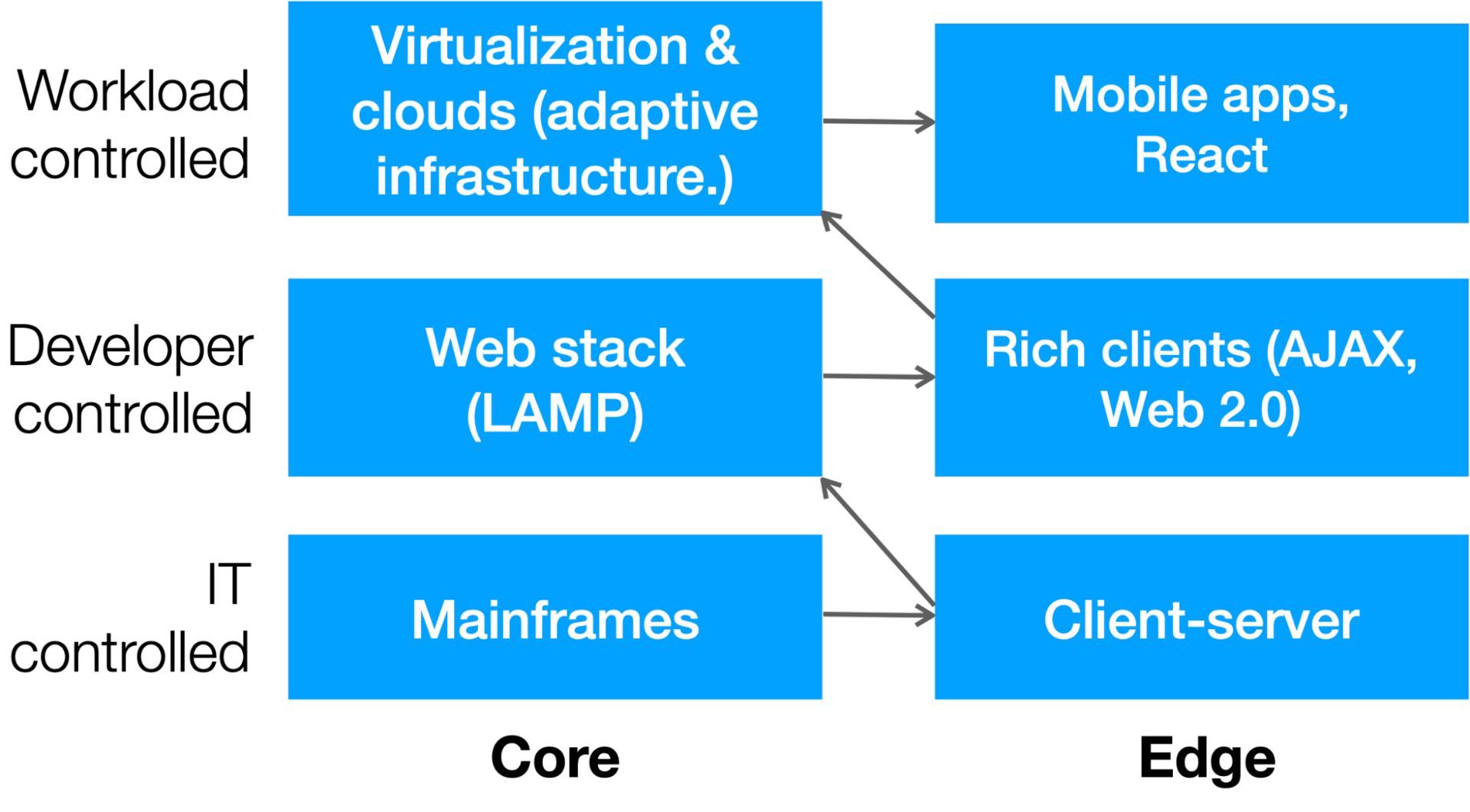

De slinger en de democratisering van IT

Hoewel het per definitie moeilijk is om de andere kant van een singulariteit te voorspellen, kunnen we wel enkele goede inschattingen maken over hoe de informatietechnologie (IT) zal veranderen. De IT-industrie heeft de afgelopen eeuw twee grote verschuivingen ondergaan:

- Het is een constante slinger die heen en weer beweegt van de centralisatie van mainframes naar het gedistribueerde karakter van webclients.

- Het is een geleidelijke democratisering van hulpbronnen, vanaf de tijd dat computergebruik zeldzaam en kostbaar was en door IT werd bewaakt tot een tijdperk waarin de ontwikkelaars, en vervolgens de werklasten zelf, hulpbronnen konden inzetten als dat nodig was.

Dit diagram laat die verschuiving zien:

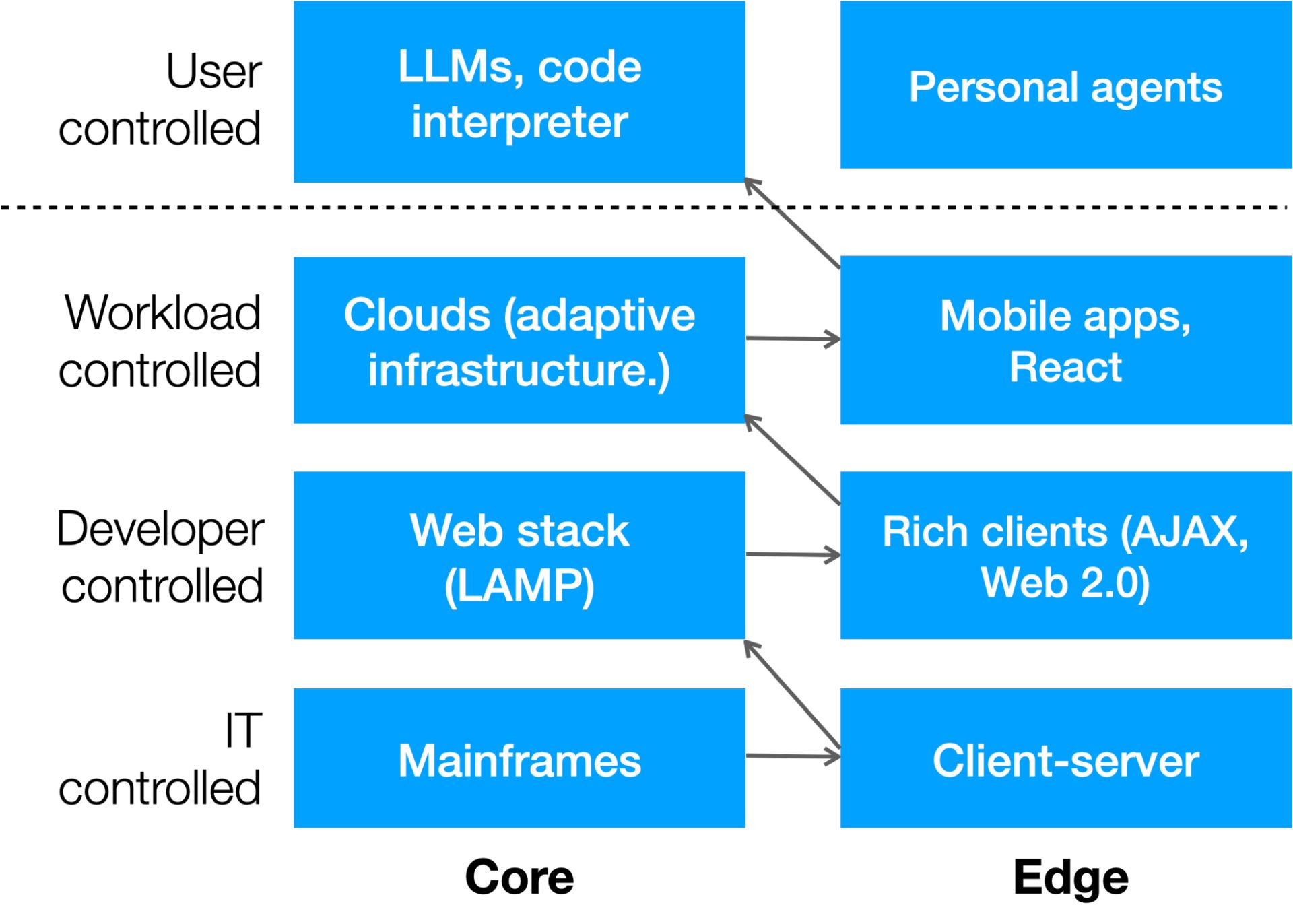

Dankzij AI ontstaat er nog een laag: door de gebruiker bestuurd computergebruik. We zien al no-code en low-code tools zoals Unqork, Bubble, Webflow, Zapier en anderen die het voor gebruikers gemakkelijker maken om apps te maken, maar wat veel interessanter is, is wanneer de AI-prompt van een gebruiker code lanceert. We zien dit in de ChatGPT-codeinterpreter van OpenAI, die apps zal schrijven en vervolgens uitvoeren om gegevens te verwerken.

Het is waarschijnlijk dat er de komende jaren opnieuw een slingerbeweging naar de rand zal plaatsvinden als bedrijven als Apple zich in de strijd begeven (die vooruitlopend op deze dag een flinke hoeveelheid AI-verwerking in hun eigen chipsets hebben ingebouwd). Zo ziet de volgende computerlaag eruit:

Een tweede stapel bouwen

Een andere voorspelling die we kunnen doen over IT in het niet-deterministische tijdperk is dat bedrijven twee stapels zullen hebben.

- De ene zal deterministisch zijn en voorspelbare taken uitvoeren.

- De ene zal niet-deterministisch zijn en onverwachte resultaten opleveren.

Misschien wel het meest interessante is dat de tweede (niet-deterministische) stapel code kan schrijven die de eerste (deterministische) stapel kan uitvoeren – binnenkort, beter dan mensen dat kunnen.

Het komende decennium zal er een haast ontstaan om in elke organisatie een tweede stack op te bouwen. Elk bedrijf zal worden beoordeeld op de waarde van zijn corpus, de bedrijfseigen informatie en de realtime updates die het gebruikt om de beste resultaten uit zijn AI te halen. Elke stapel zal verschillende hardwarevereisten, architecturen, governance, gebruikersinterfaces en kostenstructuren hebben.

We kunnen niet voorspellen hoe AI de mensheid zal hervormen. Maar we kunnen weloverwogen inschattingen maken over hoe dit de bedrijfs-IT zal veranderen, en degenen die zich snel aanpassen zullen het best voorbereid zijn om te profiteren van wat er daarna komt.

Alistair Croll is auteur van verschillende boeken over technologie, het bedrijfsleven en de samenleving, waaronder de bestseller Lean Analytics. Hij is de oprichter en medevoorzitter van FWD50, 's werelds toonaangevende conferentie over innovatie in de publieke sector, en was gastdirecteur aan de Harvard Business School, waar hij hielp bij het creëren van het curriculum voor Data Science en Critical Thinking. Hij is voorzitter van de conferentie Data-universum 2024.

Ontmoet de auteur bij Data Universe

Sluit je aan bij auteur, Alistair Croll, op Data Universum, dat plaatsvindt van 10 tot 11 april 2024 in New York, waar hij de inaugurele lancering zal voorzitten van een nieuwe merkonafhankelijke, data- en AI-conferentie, ontworpen voor de hele wereldwijde data- en AI-gemeenschap.

Alles samenbrengen – Data Universe verwelkomt dataprofessionals van alle vaardigheidsniveaus en rollen, maar ook zakenmensen, leidinggevenden en industriële partners om deel te nemen aan de meest actuele en relevante, door experts geleide inzichten over data, analytics, ML en AI die in verschillende sectoren worden onderzocht , om u te helpen mee te evolueren met de snel veranderende normen, hulpmiddelen, technieken en verwachtingen die de toekomst van het bedrijfsleven en de samenleving transformeren. Kom in april naar het North Javits Center in NYC om deel uit te maken van de toekomst van data en AI.

INFORMS is graag een strategische partner van Data Universe 2024 en zal een presentatie geven vier sessies tijdens de conferentie.

Uitgelicht beeldtegoed: Growtika/Unsplash

- Door SEO aangedreven content en PR-distributie. Word vandaag nog versterkt.

- PlatoData.Network Verticale generatieve AI. Versterk jezelf. Toegang hier.

- PlatoAiStream. Web3-intelligentie. Kennis versterkt. Toegang hier.

- PlatoESG. carbon, CleanTech, Energie, Milieu, Zonne, Afvalbeheer. Toegang hier.

- Plato Gezondheid. Intelligentie op het gebied van biotech en klinische proeven. Toegang hier.

- Bron: https://dataconomy.com/2024/04/04/building-the-second-stack/