In een waanzinnige race tegen een dreigende koolstoftijdbom worstelen techgiganten met de gevolgen voor het milieu van hun uitgestrekte datacenters over de hele wereld. Deze datacenters, essentieel voor het aandrijven van de huidige digitale infrastructuur, zijn uitgegroeid tot hebzuchtige energieverbruikers, vooral nu de vraag naar kunstmatige intelligentie (AI) blijft stijgen.

Nu AI steeds meer een integraal onderdeel wordt van verschillende industrieën, explodeert de energiebehoefte van datacenters. Dit vraagt op zijn beurt om dringende actie om hun enorme ecologische voetafdruk te verkleinen.

AI's energiehonger: de uitstoot van datacenters ontketenen

Tussen 2010 en 2018 was er een schatting 550% stijging wereldwijd in het aantal datacenterworkloads en computerinstances.

Datacentra en transmissienetwerken dragen gezamenlijk bij aan 1.5% van het mondiale energieverbruik. Ze stoten een hoeveelheid koolstofdioxide uit die vergelijkbaar is met de jaarlijkse productie van Brazilië.

Hyperscalers houden van Kopen Google Reviews, Microsoft en Amazone hebben zich gecommitteerd aan ambitieuze klimaatdoelstellingen, gericht op het koolstofvrij maken van hun activiteiten. Hyperscalers zijn grootschalige, sterk geoptimaliseerde en efficiënte faciliteiten.

De proliferatie van AI vormt echter een enorme uitdaging voor deze doelstellingen. Het energie-intensieve karakter van grafische verwerkingseenheden (GPU's), essentieel voor de training van AI-modellen, vergroot de druk op de energiebronnen.

Volgens de Internationaal Energieagentschap (IEA) verbruikt het trainen van één enkel AI-model meer stroom dan 100 huishoudens in een jaar.

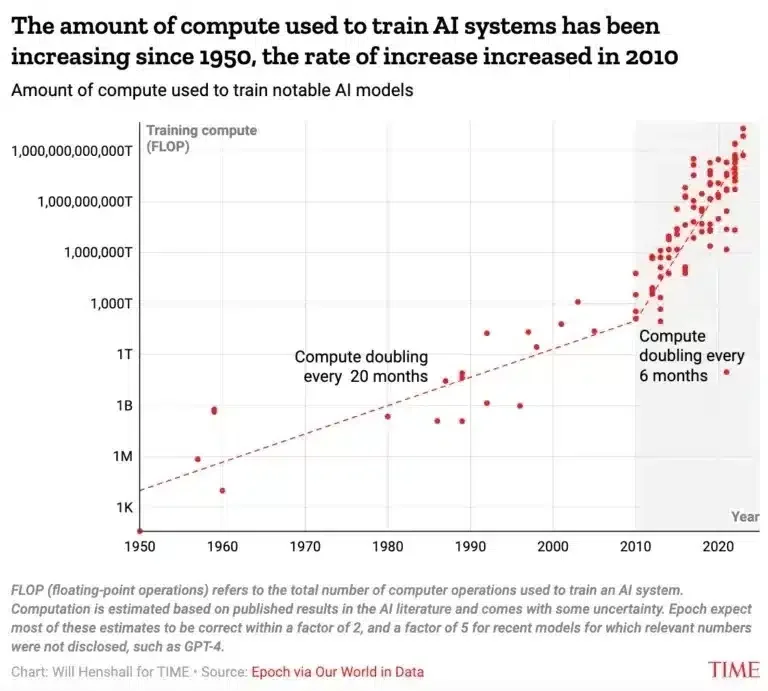

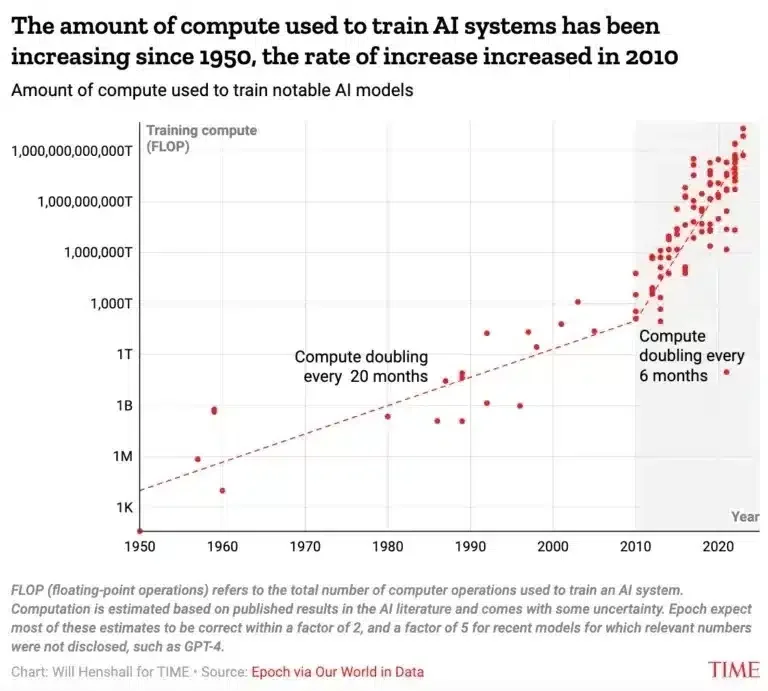

Volgens een andere bron verdubbelt de hoeveelheid rekenkracht die nodig is voor AI-training elke zes maanden. Vijftig jaar geleden gebeurde dat elke twintig maanden, zoals blijkt uit onderstaande grafiek.

Nog verontrustender is dat de rekenkracht die wordt gebruikt voor de ontwikkeling van AI-modellen in iets meer dan tien jaar tijd met een duizelingwekkende factor van 10 miljard is toegenomen. En het zou niet vertragen.

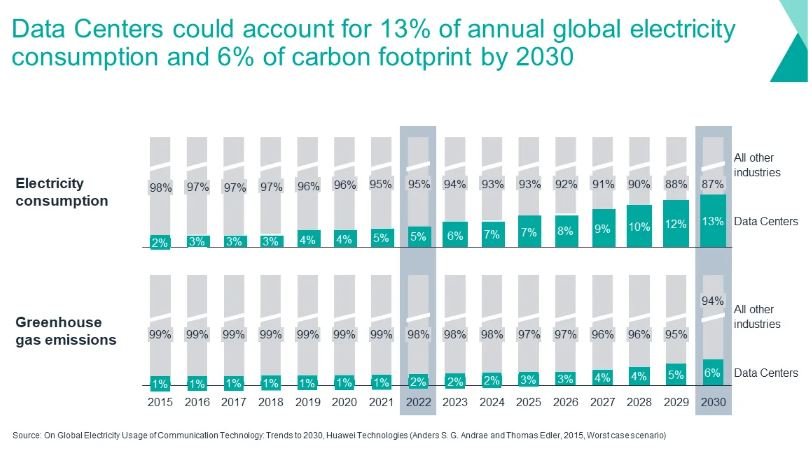

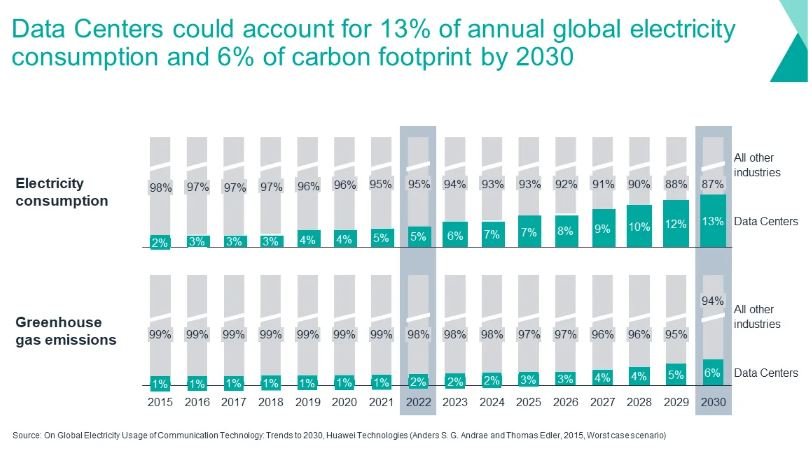

Volgens schattingen van de industrie kan het stroomverbruik oplopen tot 13% tegen 2030, terwijl het aandeel van de mondiale COXNUMX-uitstoot gelijk zal zijn 6% voor hetzelfde jaar.

De kosten van AI: macht en vooruitgang in evenwicht brengen

De klimaatrisico’s van AI-gestuurd computergebruik zijn groot Nvidia CEO Jensen Huang benadrukt de aanzienlijke energiebehoeften van AI. Jensen voorspelde een verdubbeling van de datacenterkosten binnen vijf jaar om tegemoet te komen aan het groeiende AI-ecosysteem.

De rekenkosten voor het trainen van geavanceerde AI-modellen zoals GPT-3, met 175B-parameters, en mogelijk GPT-4, zijn bijvoorbeeld voorspelbaar substantieel. De laatste training van GPT-3 heeft naar schatting tussen de $500,000 en $4.6 miljoen gekost.

Het trainen van GPT-4 had kosten van ongeveer $ 50 miljoen kunnen opleveren. Wanneer echter rekening wordt gehouden met de rekenkracht die nodig is voor vallen en opstaan vóór de laatste trainingsronde, kan de de totale trainingskosten bedragen waarschijnlijk meer dan $ 100 miljoen.

Gemiddeld verbruiken grootschalige AI-modellen ongeveer 100x meer computerbronnen dan andere hedendaagse AI-modellen. Als de trend van steeds grotere modellen zich in het huidige tempo voortzet, wordt volgens sommige schattingen berekend dat de computerkosten in 2037 het gehele bbp van de Verenigde Staten zullen overstijgen.

Volgens computerwetenschapper Kate Saenko is de ontwikkeling van GPT-3 voorbij 550 tonnen CO2 en geconsumeerd 1,287 MW uur elektriciteit. Met andere woorden, deze emissies zijn gelijk aan de emissies die worden gegenereerd door een enkele individuele opname 550 retourvluchten tussen New York en San Francisco.

Om nog maar te zwijgen van het feit dat dergelijke cijfers rekening houden met de emissies die rechtstreeks verband houden met de ontwikkeling of het gereedmaken van de AI voor gebruik. Andere emissiebronnen zijn niet meegenomen.

Oplossingen om de CO2-voetafdruk van datacenters te verkleinen

Om de uitstoot van datacenters te verminderen, hebben spelers uit de sector verschillende strategieën gevolgd, waaronder investeringen in datacenters hernieuwbare energie en gebruiken COXNUMX-credits.

Hoewel deze initiatieven enige vooruitgang hebben opgeleverd, vereist de escalerende adoptie van AI aanvullende maatregelen om betekenisvolle emissiereducties te bereiken.

De load-shifting-strategie van Google is een voorbeeld van een veelbelovende aanpak om deze uitdaging aan te pakken. Het synchroniseert de datacenteractiviteiten met de beschikbaarheid van hernieuwbare energie op uurbasis.

Door geavanceerde software-algoritmen in te zetten, identificeert Google regio's met een overschot aan zonne- en windenergie op het elektriciteitsnet en voert de datacenteractiviteiten in deze gebieden strategisch uit.

- De logica achter deze aanpak is simpel: verminder de uitstoot door de manier waarop datacenters werken te verbeteren.

De technologiegigant heeft ook het eerste initiatief geïnitieerd om het stroomverbruik van bepaalde datacenters op uurbasis af te stemmen op koolstofvrije bronnen. Het doel is om de machines 24/7 van schone energie te voorzien.

De datacenters van Google worden ongeveer 64% van de tijd aangedreven door koolstofvrije energie, waarbij 13 regionale sites voor 85% afhankelijk zijn van dergelijke bronnen en zeven sites wereldwijd de grens van 90% overschrijden, volgens Michael Terrell, die leiding geeft aan Google's 24/7-netwerk. koolstofvrije energiestrategie.

Cirrus Nexus houdt actief toezicht op de mondiale elektriciteitsnetten om regio's met een overvloed aan hernieuwbare energie te identificeren. Vervolgens verdelen ze de computerbelasting strategisch om de CO2-uitstoot te minimaliseren. Door gebruik te maken van hernieuwbare energiebronnen en de activiteiten van datacenters te optimaliseren, werd een aanzienlijke vermindering van de CO2-uitstoot bereikt.

Het bedrijf slaagde erin de computeruitstoot voor sommige werklasten en de klanten met 34% te verminderen. Het maakt gebruik van clouddiensten aangeboden door Amazon, Microsoft en Google.

Navigeren door de AI-gedreven energiecrisis

De afgelopen jaren hebben zowel Google als Amazon geëxperimenteerd met het aanpassen van de gebruikspatronen van datacenters. Ze doen dit zowel voor hun interne bedrijfsvoering als voor klanten die hun clouddiensten gebruiken.

Nvidia biedt een andere oplossing voor deze AI-gedreven stroomcrisis: groene computerversnelde analysetechnologie. Het kan de computerkosten en de CO80-voetafdruk met wel XNUMX% verlagen.

Het implementeren van load shifting vereist samenwerking tussen datacenterexploitanten, nutsbedrijven en netwerkbeheerders om potentiële verstoringen van het elektriciteitsnet te beperken. Toch houdt deze strategie een enorme belofte in voor het bevorderen van duurzaamheidsdoelstellingen binnen de datacenterindustrie.

Nu de vraag naar AI enorm stijgt, is het aanpakken van de energiebehoeften van datacenters van cruciaal belang om de CO2-uitstoot te verminderen. Innovatieve strategieën zoals load shifting bieden een weg naar het bereiken van koolstofneutraliteit en zorgen tegelijkertijd voor de betrouwbaarheid en efficiëntie van datacenteractiviteiten in een steeds meer door AI aangedreven landschap.

- Door SEO aangedreven content en PR-distributie. Word vandaag nog versterkt.

- PlatoData.Network Verticale generatieve AI. Versterk jezelf. Toegang hier.

- PlatoAiStream. Web3-intelligentie. Kennis versterkt. Toegang hier.

- PlatoESG. carbon, CleanTech, Energie, Milieu, Zonne, Afvalbeheer. Toegang hier.

- Plato Gezondheid. Intelligentie op het gebied van biotech en klinische proeven. Toegang hier.

- Bron: https://carboncredits.com/carbon-countdown-ais-10-billion-rise-in-power-use-explodes-data-center-emission/