Introductie

Generatieve AI, een opwindend vakgebied op het snijvlak van kunstmatige intelligentie en creativiteit, zorgt voor een revolutie in verschillende industrieën door machines in staat te stellen nieuwe en originele inhoud te genereren. Van het genereren van realistische afbeeldingen en muziekcomposities tot het creëren van levensechte tekst en meeslepende virtuele omgevingen, generatieve AI verlegt de grenzen van wat machines kunnen bereiken. In deze blog gaan we op reis om het veelbelovende landschap van generatieve AI met VAE's, GAN's en Transformers te verkennen, waarbij we ons verdiepen in de toepassingen, vorderingen en de diepgaande impact die het heeft voor de toekomst.

leerdoelen

- Begrijp de fundamentele concepten van generatieve AI, waaronder Variational Autoencoders (VAE's), Generative Adversarial Networks (GAN's) en Transformers.

- Ontdek het creatieve potentieel van generatieve AI-modellen en hun toepassingen.

- Krijg inzicht in de implementatie van VAE's, GAN's en Transformers.

- Verken de toekomstige richtingen en vorderingen in generatieve AI.

Dit artikel is gepubliceerd als onderdeel van het Data Science-blogathon.

Generatieve AI definiëren

Generatieve AI omvat in de kern trainingsmodellen om te leren van bestaande gegevens en vervolgens nieuwe inhoud te genereren met vergelijkbare kenmerken. Het breekt met traditionele AI-benaderingen die gericht zijn op het herkennen van patronen en het doen van voorspellingen op basis van bestaande informatie. In plaats daarvan heeft generatieve AI tot doel iets geheel nieuws te creëren, waarmee het rijk aan creativiteit en innovatie wordt uitgebreid.

De kracht van generatieve AI

Generatieve AI heeft de kracht om creativiteit los te laten en de grenzen te verleggen van wat machines kunnen bereiken. Door de onderliggende principes en modellen te begrijpen die worden gebruikt in generatieve AI, zoals Variational Autoencoders (VAE's), Generative Adversarial Networks (GAN's) en Transformers, kunnen we de technieken en methoden achter deze creatieve technologie begrijpen.

De kracht van generatieve AI ligt in het vermogen om creativiteit los te laten en nieuwe inhoud te genereren die de menselijke creativiteit imiteert en zelfs overtreft. Door gebruik te maken van algoritmen en modellen kan generatieve AI diverse outputs produceren, zoals afbeeldingen, muziek en tekst die inspireren, innoveren en de grenzen van artistieke expressie verleggen.

Generatieve AI-modellen, zoals Variational Autoencoders (VAE's), Generative Adversarial Networks (GAN's) en Transformers, spelen een sleutelrol bij het ontsluiten van deze kracht. VAE's leggen de onderliggende structuur van gegevens vast en kunnen nieuwe monsters genereren door te bemonsteren uit een aangeleerde latente ruimte. GAN's introduceren een competitief raamwerk tussen een generator en een discriminator, wat leidt tot zeer realistische resultaten. Transformers blinken uit in het vastleggen van langeafstandsafhankelijkheden, waardoor ze zeer geschikt zijn voor het genereren van coherente en contextueel relevante inhoud.

Laten we dit in detail onderzoeken.

Variationele autoencoders (VAE's)

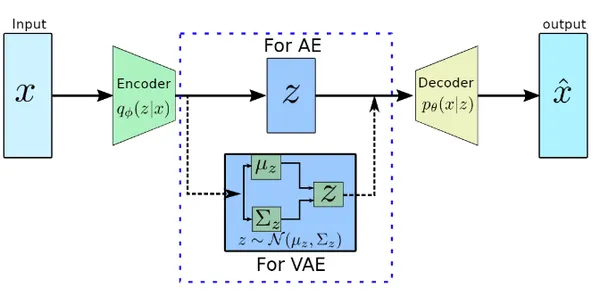

Een van de fundamentele modellen die worden gebruikt in generatieve AI is de Variational Autoencoder of VAE. Door gebruik te maken van een encoder-decoderarchitectuur, vangen VAE's de essentie van invoergegevens op door deze te comprimeren tot een lager-dimensionale latente ruimte. Vanuit deze latente ruimte genereert de decoder nieuwe samples die lijken op de originele data.

VAE's hebben toepassingen gevonden in het genereren van afbeeldingen, tekstsynthese en meer, waardoor machines nieuwe inhoud kunnen creëren die boeit en inspireert.

VAE-implementatie

In deze sectie zullen we Variational Autoencoder (VAE) helemaal opnieuw implementeren.

Encoder en decodermodel definiëren

De encoder neemt de invoergegevens, passeert deze door een dichte laag met een ReLU-activeringsfunctie en voert de gemiddelde en logvariantie van de latente ruimteverdeling uit.

Het decodernetwerk is een feed-forward neuraal netwerk dat de representatie van de latente ruimte als invoer neemt, deze door een dichte laag met een ReLU-activeringsfunctie doorgeeft en de decoderuitvoer produceert door een andere dichte laag met een sigmoïde activeringsfunctie toe te passen.

import tensorflow as tf

from tensorflow import keras

from tensorflow.keras import layers # Define the encoder network

encoder_inputs = keras.Input(shape=(input_dim,))

x = layers.Dense(hidden_dim, activation="relu")(encoder_inputs)

z_mean = layers.Dense(latent_dim)(x)

z_log_var = layers.Dense(latent_dim)(x) # Define the decoder network

decoder_inputs = keras.Input(shape=(latent_dim,))

x = layers.Dense(hidden_dim, activation="relu")(decoder_inputs)

decoder_outputs = layers.Dense(output_dim, activation="sigmoid")(x)

Definieer de bemonsteringsfunctie

De bemonsteringsfunctie neemt het gemiddelde en de logvariantie van een latente ruimte als invoer en genereert een willekeurige steekproef door ruis, geschaald met de exponentiële waarde van de helft van de logvariantie, toe te voegen aan het gemiddelde.

# Define the sampling function for the latent space

def sampling(args): z_mean, z_log_var = args epsilon = tf.random.normal(shape=(batch_size, latent_dim)) return z_mean + tf.exp(0.5 * z_log_var) * epsilon z = layers.Lambda(sampling)([z_mean, z_log_var])

Definieer verliesfunctie

De VAE-verliesfunctie heeft het reconstructieverlies, dat de overeenkomst meet tussen de input en output, en het Kullback-Leibler (KL)-verlies, dat de latente ruimte regulariseert door afwijkingen van een eerdere verdeling te bestraffen. Deze verliezen worden gecombineerd en toegevoegd aan het VAE-model waardoor end-to-end training mogelijk wordt die tegelijkertijd zowel de reconstructie- als de regularisatiedoelstellingen optimaliseert.

vae = keras.Model(inputs=encoder_inputs, outputs=decoder_outputs) # Define the loss function

reconstruction_loss = keras.losses.binary_crossentropy(encoder_inputs, decoder_outputs)

reconstruction_loss *= input_dim kl_loss = 1 + z_log_var - tf.square(z_mean) - tf.exp(z_log_var)

kl_loss = tf.reduce_mean(kl_loss) * -0.5 vae_loss = reconstruction_loss + kl_loss

vae.add_loss(vae_loss)

Compileer en train het model

De gegeven code compileert en traint een Variational Autoencoder-model met behulp van de Adam-optimizer, waarbij het model leert de gecombineerde reconstructie en KL-verlies te minimaliseren om zinvolle representaties en reconstructies van de invoergegevens te genereren.

# Compile and train the VAE

vae.compile(optimizer="adam")

vae.fit(x_train, epochs=epochs, batch_size=batch_size)Generatieve tegengestelde netwerken (GAN's)

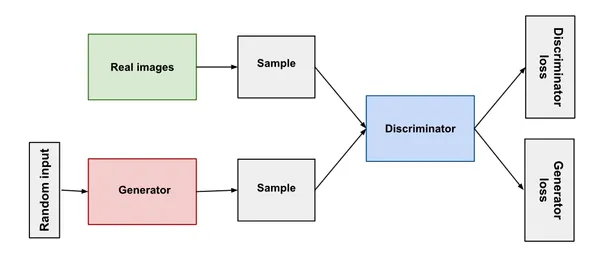

Generative Adversarial Networks hebben veel aandacht gekregen op het gebied van generatieve AI. GAN's, bestaande uit een generator en een discriminator, nemen deel aan een vijandig trainingsproces. De generator beoogt realistische samples te produceren, terwijl de discriminator onderscheid maakt tussen echte en gegenereerde samples. Door dit competitieve samenspel leren GAN's steeds overtuigendere en levensechtere inhoud te genereren.

GAN's zijn gebruikt bij het genereren van afbeeldingen en video's, en zelfs bij het simuleren van menselijke stemmen, en bieden een glimp van het verbazingwekkende potentieel van generatieve AI.

GAN-implementatie

In dit gedeelte gaan we Generative Adversarial Networks (GAN's) vanaf het begin implementeren.

Generator- en discriminatornetwerk definiëren

Dit definieert een generatornetwerk, vertegenwoordigd door de 'generator'-variabele, die een latente ruimte-invoer neemt en transformeert door een reeks dichte lagen met ReLU-activeringen om synthetische datamonsters te genereren.

Evenzo definieert het ook een discriminatornetwerk, vertegenwoordigd door de 'discriminator'-variabele, die de gegenereerde gegevensmonsters als invoer neemt en ze door dichte lagen met ReLU-activeringen doorgeeft om een enkele uitvoerwaarde te voorspellen die de waarschijnlijkheid aangeeft dat de invoer echt of nep is.

import tensorflow as tf

from tensorflow import keras

from tensorflow.keras import layers # Define the generator network

generator = keras.Sequential([ layers.Dense(256, input_dim=latent_dim, activation="relu"), layers.Dense(512, activation="relu"), layers.Dense(output_dim, activation="sigmoid")

]) # Define the discriminator network

discriminator = keras.Sequential([ layers.Dense(512, input_dim=output_dim, activation="relu"), layers.Dense(256, activation="relu"), layers.Dense(1, activation="sigmoid")

])

GAN-model definiëren

Het GAN-model wordt gedefinieerd door de generator- en discriminatornetwerken te combineren. De discriminator wordt afzonderlijk gecompileerd met binair cross-entropieverlies en de Adam-optimizer. Tijdens GAN-training wordt de discriminator bevroren om te voorkomen dat de gewichten ervan worden bijgewerkt. Het GAN-model wordt vervolgens gecompileerd met binair cross-entropieverlies en de Adam-optimizer.

# Define the GAN model

gan = keras.Sequential([generator, discriminator]) # Compile the discriminator

discriminator.compile(loss="binary_crossentropy", optimizer="adam") # Freeze the discriminator during GAN training

discriminator.trainable = False # Compile the GAN

gan.compile(loss="binary_crossentropy", optimizer="adam")

De GAN trainen

In de trainingslus worden de discriminator en generator afzonderlijk getraind met behulp van batches echte en gegenereerde gegevens, en de verliezen worden voor elk tijdvak afgedrukt om de voortgang van de training te volgen. Het GAN-model is bedoeld om de generator te trainen om realistische gegevensmonsters te produceren die de discriminator kunnen misleiden.

# Training loop

for epoch in range(epochs): # Generate random noise noise = tf.random.normal(shape=(batch_size, latent_dim)) # Generate fake samples and create a batch of real samples generated_data = generator(noise) real_data = x_train[np.random.choice(x_train.shape[0], batch_size, replace=False)] # Concatenate real and fake samples and create labels combined_data = tf.concat([real_data, generated_data], axis=0) labels = tf.concat([tf.ones((batch_size, 1)), tf.zeros((batch_size, 1))], axis=0) # Train the discriminator discriminator_loss = discriminator.train_on_batch(combined_data, labels) # Train the generator (via GAN model) gan_loss = gan.train_on_batch(noise, tf.ones((batch_size, 1))) # Print the losses print(f"Epoch: {epoch+1}, Disc Loss: {discriminator_loss}, GAN Loss: {gan_loss}")

Transformatoren en autoregressieve modellen

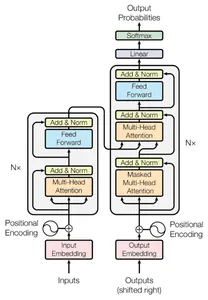

Deze modellen hebben een revolutie teweeggebracht in de verwerking van natuurlijke taal. Met het zelfaandachtsmechanisme van de transformator blinkt u uit in het vastleggen van langeafstandsafhankelijkheden in sequentiële gegevens. Dit vermogen stelt hen in staat om coherente en contextueel relevante tekst te genereren, wat een revolutie teweegbrengt in taken voor het genereren van talen.

Autoregressieve modellen, zoals de GPT-serie, genereren achtereenvolgens uitvoer, waarbij elke stap wordt geconditioneerd op eerdere uitvoer. Deze modellen zijn van onschatbare waarde gebleken bij het genereren van boeiende verhalen, boeiende dialogen en zelfs bij het schrijven.

Implementatie van transformator

Dit definieert een Transformer-model met behulp van de Keras Sequential API, die een inbeddingslaag, een Transformer-laag en een dichte laag met een softmax-activering bevat. Dit model is ontworpen voor taken zoals sequentie-naar-sequentie taalvertaling of natuurlijke taalverwerking, waar het kan leren sequentiële gegevens te verwerken en uitvoervoorspellingen te genereren.

import tensorflow as tf

from tensorflow import keras

from tensorflow.keras import layers # Define the Transformer model

transformer = keras.Sequential([ layers.Embedding(input_dim=vocab_size, output_dim=embedding_dim), layers.Transformer(num_layers, d_model, num_heads, dff, input_vocab_size=vocab_size, maximum_position_encoding=max_seq_length), layers.Dense(output_vocab_size, activation="softmax")

])

Real-world toepassing van generatieve AI

Generatieve kunstmatige intelligentie is naar voren gekomen als een game-changer, die verschillende industrieën heeft getransformeerd door gepersonaliseerde ervaringen mogelijk te maken en nieuwe gebieden van creativiteit te ontsluiten. Door middel van technieken zoals VAE's, GAN's en Transformers heeft generatieve AI aanzienlijke vooruitgang geboekt op het gebied van gepersonaliseerde aanbevelingen, het genereren van creatieve inhoud en het vergroten van gegevens. In deze blog zullen we onderzoeken hoe deze real-world applicaties industrieën hervormen en een revolutie teweegbrengen in gebruikerservaringen.

Gepersonaliseerde aanbevelingen

Generatieve AI-technieken, zoals VAE's, GAN's en Transformers, brengen een revolutie teweeg in aanbevelingssystemen door zeer op maat gemaakte en gepersonaliseerde inhoud te leveren. Door gebruikersgegevens te analyseren, bieden deze modellen op maat gemaakte aanbevelingen voor producten, diensten en inhoud, waardoor gebruikerservaringen en betrokkenheid worden verbeterd.

Creatieve contentgeneratie

Generatieve AI stelt kunstenaars, ontwerpers en muzikanten in staat om nieuwe gebieden van creativiteit te verkennen. Modellen die zijn getraind op enorme datasets kunnen verbluffende illustraties genereren, ontwerpen inspireren en zelfs originele muziek componeren. Deze samenwerking tussen menselijke creativiteit en machine-intelligentie opent nieuwe mogelijkheden voor innovatie en expressie.

Gegevensvergroting en -synthese

Generatieve modellen spelen een cruciale rol bij gegevensvergroting door synthetische gegevensmonsters te genereren om beperkte trainingsgegevenssets te vergroten. Dit verbetert het generalisatievermogen van ML-modellen, waardoor hun prestaties en robuustheid worden verbeterd, van computervisie tot NLP.

Gepersonaliseerde reclame en marketing

Generatieve AI transformeert reclame en marketing door gepersonaliseerde en gerichte campagnes mogelijk te maken. Door het gedrag en de voorkeuren van gebruikers te analyseren, genereren AI-modellen gepersonaliseerde advertenties en marketingcontent. Het levert op maat gemaakte berichten en aanbiedingen aan individuele klanten. Dit vergroot de betrokkenheid van gebruikers en verbetert de effectiviteit van marketing.

Uitdagingen en ethische overwegingen

Generatieve AI brengt mogelijkheden voort, het is van vitaal belang om de uitdagingen en ethische overwegingen aan te pakken die gepaard gaan met deze krachtige technologieën. Terwijl we ons verdiepen in de wereld van aanbevelingen, het genereren van creatieve inhoud en het vergroten van gegevens, moeten we zorgen voor eerlijkheid, authenticiteit en verantwoord gebruik van generatieve AI.

1. Vooroordelen en eerlijkheid

Generatieve AI-modellen kunnen vooroordelen overnemen die aanwezig zijn in trainingsgegevens, waardoor inspanningen nodig zijn om vooroordelen te minimaliseren en te verminderen door middel van gegevensselectie en algoritmische rechtvaardigheidsmaatregelen.

2. Intellectuele eigendomsrechten

Duidelijke richtlijnen en licentiekaders zijn cruciaal om de rechten van makers van inhoud te beschermen en een respectvolle samenwerking tussen generatieve AI en menselijke makers te waarborgen.

3. Misbruik van gegenereerde informatie

Er zijn robuuste waarborgen, verificatiemechanismen en onderwijsinitiatieven nodig om het mogelijke misbruik van generatieve AI voor nepnieuws, verkeerde informatie of deepfakes tegen te gaan.

4. Transparantie en uitlegbaarheid

Het vergroten van de transparantie en uitlegbaarheid in generatieve AI-modellen kan het vertrouwen en de verantwoording bevorderen, waardoor gebruikers en belanghebbenden de besluitvormingsprocessen kunnen begrijpen.

Door deze uitdagingen en ethische overwegingen aan te pakken, kunnen we de kracht van generatieve AI op verantwoorde wijze benutten en eerlijkheid, inclusiviteit en ethische innovatie bevorderen ten voordele van de samenleving.

Toekomst van generatieve AI

De toekomst van generatieve AI biedt opwindende mogelijkheden en vorderingen. Hier zijn een paar belangrijke gebieden die de ontwikkeling ervan kunnen bepalen

Verbeterde controleerbaarheid

Onderzoekers werken aan het verbeteren van de bestuurbaarheid van generatieve AI-modellen. Dit omvat technieken waarmee gebruikers meer gedetailleerde controle hebben over de gegenereerde uitvoer, zoals het specificeren van gewenste attributen, stijlen of niveaus van creativiteit. Beheersbaarheid stelt gebruikers in staat om de gegenereerde inhoud vorm te geven volgens hun specifieke behoeften en voorkeuren.

Interpreteerbare en verklaarbare resultaten

Het verbeteren van de interpreteerbaarheid van generatieve AI-modellen is een actief onderzoeksgebied. Het vermogen om te begrijpen en uit te leggen waarom een model een bepaalde output genereert, is cruciaal, vooral in domeinen als gezondheidszorg en wetgeving waar verantwoording en transparantie belangrijk zijn. Technieken die inzicht geven in het besluitvormingsproces van generatieve AI-modellen zullen meer vertrouwen en acceptatie mogelijk maken.

Few-Shot en Zero-Shot Learning

Momenteel hebben generatieve AI-modellen vaak grote hoeveelheden hoogwaardige trainingsgegevens nodig om gewenste resultaten te produceren. Onderzoekers onderzoeken echter technieken om modellen in staat te stellen te leren van beperkte of zelfs geen trainingsvoorbeelden. Few-shot en zero-shot leerbenaderingen zullen generatieve AI toegankelijker en toepasbaar maken op domeinen waar het verwerven van grote datasets een uitdaging is.

Multimodale generatieve modellen

Multimodale generatieve modellen die verschillende soorten gegevens combineren, zoals tekst, afbeeldingen en audio, krijgen steeds meer aandacht. Deze modellen kunnen diverse en samenhangende output genereren over meerdere modaliteiten, waardoor rijkere en meer meeslepende contentcreatie mogelijk wordt. Toepassingen zijn onder meer het genereren van interactieve verhalen, augmented reality-ervaringen en gepersonaliseerde multimedia-inhoud.

Realtime en interactieve generatie

De mogelijkheid om in real-time en interactief content te genereren, opent spannende mogelijkheden. Dit omvat het genereren van gepersonaliseerde aanbevelingen, virtuele avatars en dynamische inhoud die reageert op gebruikersinvoer en voorkeuren. Realtime generatieve AI heeft toepassingen in gaming, virtual reality en gepersonaliseerde gebruikerservaringen.

Aangezien generatieve AI zich blijft ontwikkelen, is het belangrijk om rekening te houden met de ethische implicaties, verantwoorde ontwikkeling en eerlijk gebruik van deze modellen. Door deze zorgen aan te pakken en de samenwerking tussen menselijke creativiteit en generatieve AI te bevorderen, kunnen we het volledige potentieel ervan ontsluiten om innovatie te stimuleren en verschillende industrieën en domeinen positief te beïnvloeden.

Conclusie

Generatieve AI is naar voren gekomen als een krachtig hulpmiddel voor creatieve expressie, heeft een revolutie teweeggebracht in verschillende industrieën en de grenzen verlegd van wat machines kunnen bereiken. Met voortdurende vooruitgang en onderzoek is de toekomst van generatieve AI enorm veelbelovend. Terwijl we doorgaan met het verkennen van dit opwindende landschap, is het essentieel om de ethische overwegingen te volgen en een verantwoorde en inclusieve ontwikkeling te waarborgen.

Key Takeaways

- VAE's bieden creatief potentieel door gegevens in kaart te brengen in een lager-dimensionale ruimte en diverse inhoud te genereren, waardoor ze van onschatbare waarde zijn voor toepassingen zoals illustraties en beeldsynthese.

- GAN's brengen een revolutie teweeg in door AI gegenereerde inhoud door hun competitieve kader, en produceren zeer realistische output zoals deepfake-video's en fotorealistische illustraties.

- Transformers blinken uit in het genereren van coherente uitvoer door langeafstandsafhankelijkheden vast te leggen, waardoor ze zeer geschikt zijn voor taken zoals machinevertaling, tekstgeneratie en beeldsynthese.

- De toekomst van generatieve AI ligt in het verbeteren van de beheersbaarheid, interpreteerbaarheid en efficiëntie door onderzoeksvooruitgang in multimodale modellen, overdrachtsleren en trainingsmethoden om de kwaliteit en diversiteit van gegenereerde output te verbeteren.

Het omarmen van generatieve AI opent nieuwe mogelijkheden voor creativiteit, innovatie en gepersonaliseerde ervaringen, en geeft vorm aan de toekomst van technologie en menselijke interactie.

Veelgestelde Vragen / FAQ

A1: Generatieve AI verwijst naar het gebruik van algoritmen en modellen om nieuwe inhoud te genereren, zoals afbeeldingen, muziek en tekst.

A2: VAE's bestaan uit een encoder en een decoder. De encoder wijst invoergegevens toe aan een lager-dimensionale latente ruimte, waarbij de essentie van de gegevens wordt vastgelegd. De decoder reconstrueert de oorspronkelijke gegevens uit punten in de latente ruimte. Het maakt het genereren van nieuwe samples mogelijk door uit deze ruimte te samplen.

A3: GAN's bestaan uit een generator en een discriminator. De generator genereert nieuwe samples uit willekeurige ruis, met als doel de discriminator voor de gek te houden. De discriminator treedt op als rechter en maakt onderscheid tussen echte en nepmonsters. GAN's staan bekend om hun vermogen om zeer realistische resultaten te produceren.

A4: Transformers blinken uit in het genereren van coherente outputs door langeafstandsafhankelijkheden in de data vast te leggen. Ze wegen het belang van verschillende invoerelementen af. Dit maakt ze effectief voor taken als machinevertaling, tekstgeneratie en beeldsynthese.

A5: Generatieve AI-modellen kunnen worden verfijnd en geconditioneerd. Maar op specifieke invoerparameters of beperkingen om inhoud te genereren die voldoet aan de gewenste kenmerken of stijlen. Dit zorgt voor meer controle over de gegenereerde uitvoer.

De in dit artikel getoonde media zijn geen eigendom van Analytics Vidhya en worden naar goeddunken van de auteur gebruikt.

Verwant

- Door SEO aangedreven content en PR-distributie. Word vandaag nog versterkt.

- PlatoData.Network Verticale generatieve AI. Versterk jezelf. Toegang hier.

- PlatoAiStream. Web3-intelligentie. Kennis versterkt. Toegang hier.

- PlatoESG. Automotive / EV's, carbon, CleanTech, Energie, Milieu, Zonne, Afvalbeheer. Toegang hier.

- BlockOffsets. Eigendom voor milieucompensatie moderniseren. Toegang hier.

- Bron: https://www.analyticsvidhya.com/blog/2023/07/generative-ai-with-vaes-gans-transformers/