Een recente TechSpot-artikel suggereert dat Apple voorzichtig op weg is naar de release van een soort generatieve AI, mogelijk met iOS 18 en A17 Pro. Dit is niet alleen interessant voor Apple-gebruikers zoals ik, maar ook voor een bredere validatie van een echte mobiele mogelijkheid voor generatieve AI. Wat eerlijk gezegd om meerdere redenen niet vanzelfsprekend leek. Het vinden van een balans tussen prestaties en geheugenvraag lijkt lastig voor modellen die uitgaan van een miljard of meer parameters. Zal het stroomverbruik een probleem zijn? Dan zijn er nog de juridische problemen en de hallucinatiekwesties, die misschien kunnen worden beheerd via zorgvuldig beperkte gebruiksmodellen. Ondanks de schijnbare uitdagingen vind ik het bemoedigend dat een bedrijf dat doorgaans bedachtzamer is over productreleases dan de meeste anderen, een mogelijke weg naar succes ziet. Als zij dat kunnen, kunnen anderen dat ook, wat een recente blog van Expedera verhelderend voor mij.

Een korte samenvatting van generatieve beeldcreatie

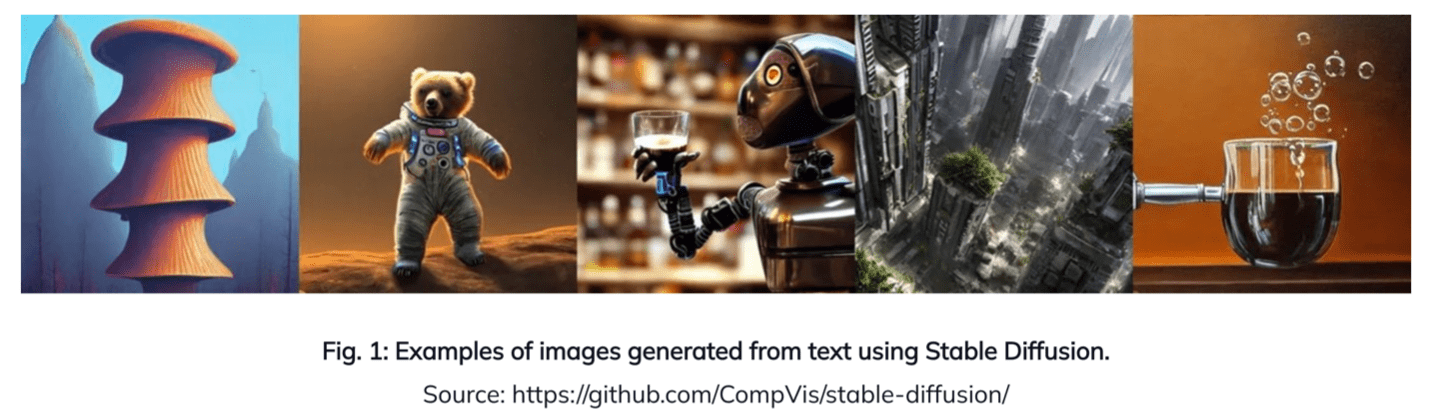

Generatieve beeldvorming AI is een vakgebied waarvan de mogelijkheden nog maar net worden verkend. We zijn al gewend om onze achtergronden voor Zoom-/Google Meet-gesprekken te veranderen, maar generatieve AI gaat nog veel verder. Nu kunnen we onszelf opnieuw voorstellen in verschillende kostuums met verschillende kenmerken in denkbeeldige omgevingen – een enorme markt voor beeldbewuste consumenten. Meer praktisch gezien zouden we kleding virtueel moeten kunnen passen voordat we kopen of de opties verkennen bij het verbouwen van een keuken of badkamer. Deze technologie is al beschikbaar in de cloud (bijvoorbeeld Bing Image Creator), maar met alle nadelen van cloudgebaseerde services, vooral op het gebied van privacy en kosten. De meeste consumenten willen via mobiele apparaten met dergelijke diensten communiceren; een betere oplossing zou lokale AI zijn, ingebed in die platforms. Generatieve AI via het open-source Stable Diffusion-model is een goede proxy voor hardwareplatforms om in deze behoefte te voorzien, en meer in het algemeen voor LLM-modellen die op vergelijkbare kerntechnologieën zijn gebaseerd.

Kunnen het ingebouwde geheugen en de prestaties aan de rand in evenwicht worden gebracht?

Ten eerste moeten we de stabiele diffusiepijplijn begrijpen. Dit begint met een tekstencoder die een prompt verwerkt ("Ik wil een piratenschip ondersteboven zien drijven boven een zee van groene jello"). Die stap wordt gevolgd door een neuraal netwerk dat de ruis wegneemt en het diffusiegedeelte van het algoritme afhandelt, door middel van meerdere iteraties die informatie creëren voor een uiteindelijk beeld op basis van getrainde parameters. Ik beschouw dit als een soort omgekeerde van conventionele beeldherkenning, het matchen van promptvereisten en de training om een gesynthetiseerde match met de prompt te creëren. Ten slotte geeft een decoderfase het beeld weer op basis van de gegevens die in de vorige stap zijn geconstrueerd. Elk van deze fasen is een transformatormodel.

De auteur van het Expedera-blog, Pat Donnelly (Solutions Architect), geeft een gedetailleerd overzicht van de parameters, bewerkingen en gegevensverplaatsingen die nodig zijn voor het hele algoritme, wat ik hier niet zal proberen te repliceren. Wat mij opviel was het enorme aantal databewegingen. Toch gaat hij uit van slechts 8 MB werkgeheugen op basis van de eisen die hij bij klanten ziet, in plaats van een optimale doorvoer. Toen ik hem hierover vroeg, zei hij dat de werking duidelijk afhankelijk zou zijn van een DDR-interface om het grootste deel van deze activiteit te beheren.

Dit is een verandering van een gedachtegang die ik heb gehoord: dat de uitvoering van modellen alles in het lokale geheugen moet bewaren om aan de prestatie-eisen te voldoen. Maar daarvoor zou een onredelijk grote SRAM aan boord nodig zijn. DRAM is zinvol om met de capaciteit om te gaan, maar een andere stroming suggereert dat niemand zoveel DRAM in een mobiel apparaat zou willen stoppen. Dat zou te duur zijn. Ook langzaam en hongerig naar energie.

DRAM of een ander soort geheugen buiten de chip is logischer, maar hoe zit het met het kostenprobleem? Zie de bovenstaande referentie op Apple. Blijkbaar overwegen ze flash-geheugen, dus misschien is deze aanpak niet zo wild. Hoe zit het met de prestaties? Pat vertelde me dat ze voor Stable Diffusion 1.5, uitgaande van een 8K MAC-engine met 7 MB intern geheugen en draaiend op 750 MHz met 12 GBps externe geheugenbandbreedte, 9.24 afbeeldingen/seconde kunnen verwerken via de de-noiser en 3.29 afbeeldingen/seconde via de decodernetwerk. Dat zijn zeer respectabele, consumentenklare prestaties. Macht is altijd lastig vast te stellen, omdat het van zoveel factoren afhangt, maar cijfers die ik heb gezien suggereren dat dit ook prima zou moeten zijn voor verwachte consumentengebruiksmodellen.

Een heel nuttig inzicht. Het lijkt erop dat we de theorie moeten laten varen dat grote transformator-AI voor de edge niet afhankelijk kan zijn van geheugen buiten de chip. Opnieuw kun je het Expedera-blog lezen HIER.

Deel dit bericht via:

- Door SEO aangedreven content en PR-distributie. Word vandaag nog versterkt.

- PlatoData.Network Verticale generatieve AI. Versterk jezelf. Toegang hier.

- PlatoAiStream. Web3-intelligentie. Kennis versterkt. Toegang hier.

- PlatoESG. carbon, CleanTech, Energie, Milieu, Zonne, Afvalbeheer. Toegang hier.

- Plato Gezondheid. Intelligentie op het gebied van biotech en klinische proeven. Toegang hier.

- Bron: https://semiwiki.com/artificial-intelligence/341410-expedera-proposes-stable-diffusion-as-benchmark-for-edge-hardware-for-ai/