Bron: rawpixel.com

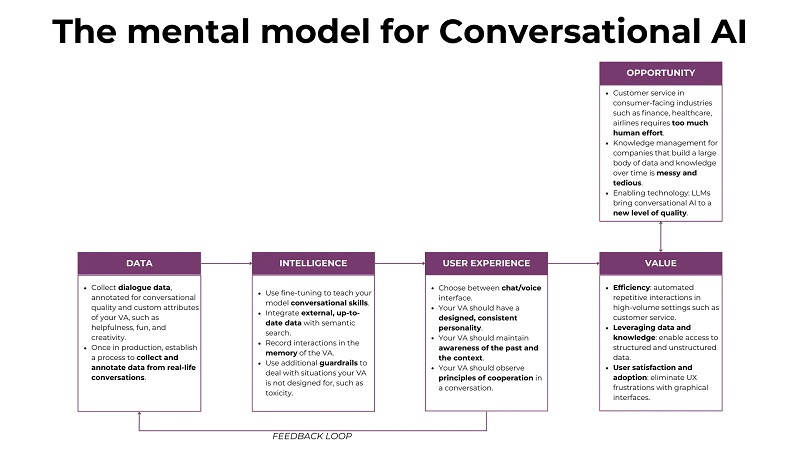

Conversational AI is een toepassing van LLM's die veel aandacht en aandacht heeft getrokken vanwege de schaalbaarheid ervan in veel sectoren en gebruiksscenario's. Hoewel conversatiesystemen al tientallen jaren bestaan, hebben LLM’s de kwaliteitsimpuls gebracht die nodig was voor hun grootschalige adoptie. In dit artikel zullen we het mentale model uit Figuur 1 gebruiken om conversationele AI-toepassingen te ontleden (vgl. AI-producten bouwen met een holistisch mentaal model voor een inleiding tot het mentale model). Nadat we de marktkansen en de zakelijke waarde van conversationele AI-systemen hebben overwogen, zullen we de aanvullende ‘machines’ uitleggen in termen van data, LLM-verfijning en conversationeel ontwerp die moeten worden opgezet om gesprekken niet alleen mogelijk maar ook nuttig te maken en plezierig.

1. Kansen, waarde en beperkingen

Traditioneel UX-ontwerp is opgebouwd rond een groot aantal kunstmatige UX-elementen, swipes, tikken en klikken, waardoor voor elke nieuwe app een leercurve nodig is. Met behulp van conversationele AI kunnen we deze drukte wegnemen en vervangen door de elegante ervaring van een natuurlijk vloeiend gesprek waarin we de overgangen tussen verschillende apps, vensters en apparaten kunnen vergeten. We gebruiken taal, ons universele en vertrouwde communicatieprotocol, om met verschillende virtuele assistenten (VA's) te communiceren en onze taken uit te voeren.

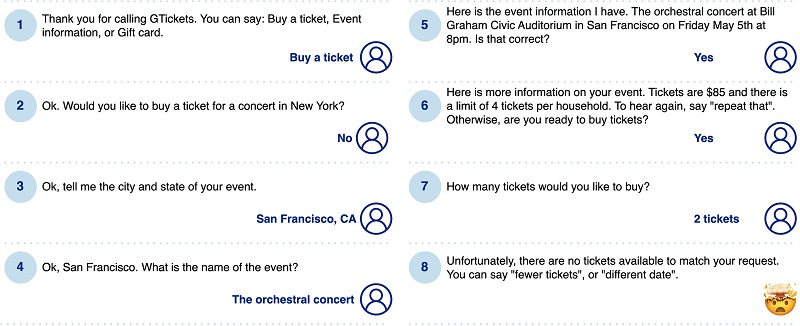

Conversationele gebruikersinterfaces zijn niet bepaald het nieuwe, populaire spul. Interactieve Voice Response Systems (IVR's) en chatbots bestaan al sinds de jaren negentig, en grote ontwikkelingen op het gebied van NLP zijn op de voet gevolgd door golven van hoop en ontwikkeling op het gebied van stem- en chatinterfaces. Vóór de tijd van LLM's werden de meeste systemen echter geïmplementeerd in het symbolische paradigma, waarbij ze vertrouwden op regels, trefwoorden en gesprekspatronen. Ze waren ook beperkt tot een specifiek, vooraf gedefinieerd domein van ‘competentie’, en gebruikers die zich daarbuiten waagden, zouden al snel op een doodlopende weg terechtkomen. Al met al werden deze systemen gedolven met potentiële faalpunten, en na een paar frustrerende pogingen kwamen veel gebruikers er nooit meer op terug. De volgende afbeelding illustreert een voorbeelddialoog. Een gebruiker die kaartjes voor een specifiek concert wil bestellen, doorloopt geduldig een gedetailleerd ondervragingstraject, om er uiteindelijk achter te komen dat het concert uitverkocht is.

Als faciliterende technologie kunnen LLM's conversatie-interfaces naar een nieuw niveau van kwaliteit en gebruikerstevredenheid tillen. Conversatiesystemen kunnen nu een veel bredere wereldkennis, taalvaardigheid en gespreksvaardigheid tentoonspreiden. Door gebruik te maken van vooraf getrainde modellen kunnen ze ook in veel kortere tijdspannes worden ontwikkeld, aangezien het vervelende werk van het samenstellen van regels, trefwoorden en dialoogstromen nu wordt vervangen door de statistische kennis van de LLM. Laten we eens kijken naar twee prominente toepassingen waarbij conversationele AI op grote schaal waarde kan bieden:

- Klantenservice en, meer in het algemeen, applicaties die worden gebruikt door een groot aantal gebruikers die vaak soortgelijke verzoeken indienen. Hier heeft het bedrijf dat de klantenondersteuning levert een duidelijk informatievoordeel ten opzichte van de gebruiker en kan dit benutten om een meer intuïtieve en plezierige gebruikerservaring te creëren. Denk bijvoorbeeld aan het omboeken van een vlucht. Voor mezelf, een tamelijk frequent flyer, gebeurt dit 1 à 2 keer per jaar. Tussendoor heb ik de neiging om de details van het proces te vergeten, om nog maar te zwijgen van de gebruikersinterface van een specifieke luchtvaartmaatschappij. De klantenondersteuning van de luchtvaartmaatschappij heeft daarentegen omboekingsverzoeken centraal staan in hun activiteiten. In plaats van het omboekingsproces bloot te leggen via een complexe grafische interface, kan de logica ervan ‘verborgen’ worden voor klanten die contact opnemen met de ondersteuning, en kunnen ze taal gebruiken als een natuurlijk kanaal om hun omboeking te maken. Natuurlijk zal er nog steeds een “lange staart” van minder bekende verzoeken blijven bestaan. Stel je bijvoorbeeld een spontane stemmingswisseling voor die een zakelijke klant ertoe aanzet haar geliefde hond als extra bagage toe te voegen aan een geboekte vlucht. Deze meer individuele verzoeken kunnen worden doorgegeven aan menselijke agenten of worden afgehandeld via een intern kennisbeheersysteem dat is gekoppeld aan de virtuele assistent.

- Kennismanagement die gebaseerd is op een grote hoeveelheid data. Voor veel moderne bedrijven is de interne kennis die ze in de loop van de jaren van opereren, itereren en leren hebben opgebouwd, een kernwaarde en onderscheidende factor – als deze op een efficiënte manier wordt opgeslagen, beheerd en toegankelijk. Omdat ze zich baseren op een schat aan gegevens die verborgen zijn in samenwerkingstools, interne wiki's, kennisbanken, enz., slagen ze er vaak niet in om deze om te zetten in bruikbare kennis. Terwijl werknemers vertrekken, nieuwe werknemers aan boord komen en u de documentatiepagina die u drie maanden geleden bent begonnen nooit meer afmaakt, wordt waardevolle kennis het slachtoffer van entropie. Het wordt steeds moeilijker om een weg te vinden door het interne datalabyrint en de stukjes informatie te bemachtigen die nodig zijn in een specifieke bedrijfssituatie. Dit leidt tot enorme efficiëntieverliezen voor kenniswerkers. Om dit probleem aan te pakken, kunnen we LLM's uitbreiden met semantisch zoeken op interne gegevensbronnen. LLM's maken het mogelijk om vragen in natuurlijke taal te gebruiken in plaats van complexe formele vragen om vragen te stellen aan deze database. Gebruikers kunnen zich dus concentreren op hun informatiebehoeften in plaats van op de structuur van de kennisbank of de syntaxis van een querytaal zoals SQL. Omdat ze op tekst zijn gebaseerd, werken deze systemen met gegevens in een rijke semantische ruimte, waardoor betekenisvolle verbindingen ‘onder de motorkap’ worden gelegd.

Naast deze belangrijke toepassingsgebieden zijn er nog tal van andere toepassingen, zoals telezorg, assistenten in de geestelijke gezondheidszorg en educatieve chatbots, die UX kunnen stroomlijnen en op een snellere en efficiëntere manier waarde kunnen toevoegen aan hun gebruikers.

Als deze diepgaande educatieve inhoud nuttig voor je is, kan dat abonneer u op onze AI-research mailinglijst om gewaarschuwd te worden wanneer we nieuw materiaal uitbrengen.

2. Gegevens

LLM's zijn oorspronkelijk niet opgeleid om vloeiend over koetjes en kalfjes te praten of om meer substantiële gesprekken te voeren. In plaats daarvan leren ze bij elke gevolgtrekkingsstap het volgende token te genereren, wat uiteindelijk resulteert in een samenhangende tekst. Deze doelstelling op een laag niveau verschilt van de uitdaging van menselijke gesprekken. Gesprekken zijn ongelooflijk intuïtief voor mensen, maar het wordt ongelooflijk complex en genuanceerd als je een machine wilt leren dit te doen. Laten we bijvoorbeeld eens kijken naar het fundamentele begrip intenties. Wanneer we taal gebruiken, doen we dat voor een specifiek doel, namelijk onze communicatieve bedoeling – het kan zijn om informatie over te brengen, een praatje te maken of iemand te vragen iets te doen. Hoewel de eerste twee vrij eenvoudig zijn voor een LLM (zolang hij de vereiste informatie in de gegevens heeft gezien), is de laatste al uitdagender. Niet alleen moet de LLM de gerelateerde informatie op een samenhangende manier combineren en structureren, maar hij moet ook de juiste emotionele toon zetten in termen van zachte criteria zoals formaliteit, creativiteit, humor, enz. Dit is een uitdaging voor conversational design. (zie hoofdstuk 5), dat nauw verweven is met de taak om data te verfijnen.

Het maken van de overgang van het genereren van klassieke talen naar het herkennen van en reageren op specifieke communicatieve intenties is een belangrijke stap in de richting van een betere bruikbaarheid en acceptatie van gesprekssystemen. Zoals bij alle pogingen tot verfijning begint dit met het samenstellen van een geschikte dataset.

De verfijnde gegevens moeten zo dicht mogelijk bij de (toekomstige) gegevensdistributie in de echte wereld komen. Ten eerste moeten het conversatiegegevens (dialooggegevens) zijn. Ten tweede, als uw virtuele assistent gespecialiseerd zal zijn in een specifiek domein, moet u proberen verfijnde gegevens te verzamelen die de noodzakelijke domeinkennis weerspiegelen. Ten derde: als er typische stromen en verzoeken zijn die regelmatig terugkeren in uw applicatie, zoals in het geval van klantenondersteuning, probeer dan gevarieerde voorbeelden hiervan op te nemen in uw trainingsgegevens. De volgende tabel toont een voorbeeld van gespreksverfijningsgegevens van de 3K-gespreksgegevensset voor ChatBot, die gratis beschikbaar is op Kaggle:

Het handmatig creëren van gespreksgegevens kan een dure onderneming worden; crowdsourcing en het gebruik van LLM's om u te helpen gegevens te genereren zijn twee manieren om op te schalen. Zodra de dialooggegevens zijn verzameld, moeten de gesprekken worden beoordeeld en geannoteerd. Hierdoor kunt u zowel positieve als negatieve voorbeelden aan uw model laten zien en het model ertoe aanzetten de kenmerken van de ‘juiste’ gesprekken op te pikken. De beoordeling kan gebeuren met absolute scores of met een rangschikking van verschillende opties onderling. De laatste benadering leidt tot een nauwkeurigere afstemming van gegevens, omdat mensen normaal gesproken beter zijn in het rangschikken van meerdere opties dan in het afzonderlijk evalueren ervan.

Nu uw gegevens aanwezig zijn, bent u klaar om uw model te verfijnen en te verrijken met extra mogelijkheden. In de volgende sectie zullen we kijken naar het verfijnen, het integreren van aanvullende informatie uit het geheugen en semantisch zoeken, en het verbinden van agenten met uw gesprekssysteem om het in staat te stellen specifieke taken uit te voeren.

3. Het conversatiesysteem samenstellen

Een typisch conversatiesysteem is gebouwd met een conversatieagent die de componenten en mogelijkheden van het systeem orkestreert en coördineert, zoals de LLM, het geheugen en externe gegevensbronnen. De ontwikkeling van conversationele AI-systemen is een zeer experimentele en empirische taak, en uw ontwikkelaars zullen voortdurend heen en weer moeten gaan tussen het optimaliseren van uw gegevens, het verbeteren van de verfijningsstrategie, het spelen met extra componenten en verbeteringen, en het testen van de resultaten. . Niet-technische teamleden, waaronder productmanagers en UX-ontwerpers, zullen het product ook voortdurend testen. Op basis van hun klantontdekkingsactiviteiten bevinden ze zich in een uitstekende positie om te anticiperen op de gespreksstijl en inhoud van toekomstige gebruikers en zouden ze deze kennis actief moeten bijdragen.

3.1 Conversatievaardigheden aanleren aan uw LLM

Voor verfijning heeft u uw verfijningsgegevens nodig (zie sectie 2) en een vooraf opgeleide LLM. LLM's weten al veel over taal en de wereld, en onze uitdaging is om hen de principes van conversatie bij te brengen. Bij het afstemmen zijn de doeluitvoer teksten en wordt het model geoptimaliseerd om teksten te genereren die zo veel mogelijk op de doelen lijken. Voor gecontroleerde verfijning moet u eerst duidelijk de conversationele AI-taak definiëren die u door het model wilt laten uitvoeren, de gegevens verzamelen en het verfijningsproces uitvoeren en herhalen.

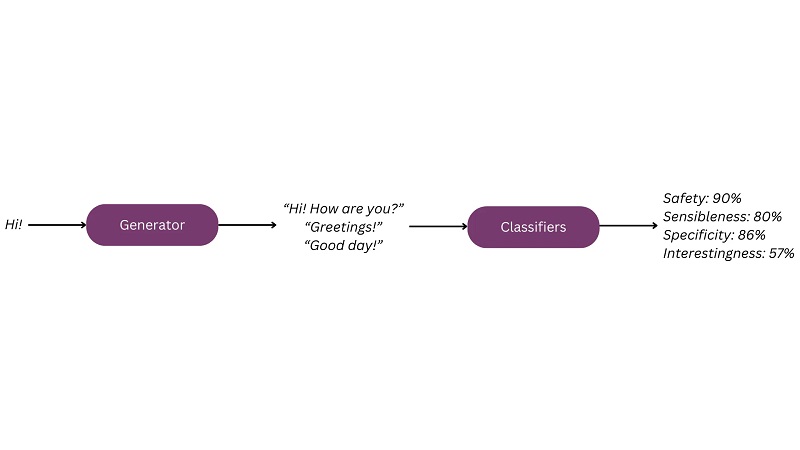

Met de hype rond LLM's is er een verscheidenheid aan verfijningsmethoden ontstaan. Voor een vrij traditioneel voorbeeld van het afstemmen van gesprekken kun je de beschrijving van het LaMDA-model raadplegen.[1] LaMDA werd in twee stappen verfijnd. Ten eerste worden dialooggegevens gebruikt om de modelgespreksvaardigheden aan te leren (“generatieve” verfijning). Vervolgens worden de labels die door annotators worden geproduceerd tijdens de beoordeling van de gegevens gebruikt om classificatoren te trainen die de output van het model kunnen beoordelen op basis van gewenste kenmerken, waaronder gevoeligheid, specificiteit, interessantheid en veiligheid ('discriminerende' verfijning). Deze classificatoren worden vervolgens gebruikt om het gedrag van het model in de richting van deze attributen te sturen.

Bovendien is feitelijke gegrondheid – het vermogen om hun resultaten te baseren op geloofwaardige externe informatie – een belangrijk kenmerk van LLM’s. Om feitelijke gegrondheid te garanderen en hallucinaties te minimaliseren, werd LaMDA verfijnd met een dataset waarbij een extern systeem voor het ophalen van informatie wordt opgeroepen wanneer externe kennis vereist is. Het model leerde dus om eerst feitelijke informatie op te halen wanneer de gebruiker een zoekopdracht uitvoerde waarvoor nieuwe kennis nodig was.

Een andere populaire verfijningstechniek is Reinforcement Learning from Human Feedback (RLHF)[2]. RLHF ‘leidt’ het leerproces van de LLM om van de eenvoudige maar kunstmatige next-token-voorspellingstaak naar het leren van menselijke voorkeuren in een bepaalde communicatieve situatie. Deze menselijke voorkeuren worden direct gecodeerd in de trainingsgegevens. Tijdens het annotatieproces krijgen mensen aanwijzingen te zien en schrijven ze het gewenste antwoord of rangschikken ze een reeks bestaande antwoorden. Het gedrag van de LLM wordt vervolgens geoptimaliseerd om de menselijke voorkeur te weerspiegelen.

3.2 Externe gegevens toevoegen en semantisch zoeken

Naast het samenstellen van gesprekken om het model te verfijnen, wilt u wellicht uw systeem uitbreiden met gespecialiseerde gegevens die tijdens het gesprek kunnen worden gebruikt. Uw systeem heeft bijvoorbeeld mogelijk toegang nodig tot externe gegevens, zoals patenten of wetenschappelijke artikelen, of tot interne gegevens, zoals klantprofielen of uw technische documentatie. Dit gebeurt normaal gesproken via semantisch zoeken (ook wel bekend als Retrieval-Augmented Generation of RAG)[3]. De aanvullende gegevens worden in een database opgeslagen in de vorm van semantische inbedding (vgl. dit artikel voor een uitleg van inbedding en verdere referenties). Wanneer het gebruikersverzoek binnenkomt, wordt het voorbewerkt en omgezet in een semantische inbedding. De semantische zoekactie identificeert vervolgens de documenten die het meest relevant zijn voor het verzoek en gebruikt deze als context voor de prompt. Door aanvullende gegevens te integreren met semantisch zoeken, kunt u hallucinaties verminderen en nuttigere, feitelijk gefundeerde antwoorden bieden. Door de inbeddingsdatabase voortdurend bij te werken, kunt u ook de kennis en reacties van uw systeem up-to-date houden zonder uw verfijningsproces voortdurend opnieuw uit te voeren.

3.3 Geheugen en contextbewustzijn

Stel je voor dat je naar een feestje gaat en Peter ontmoet, een advocaat. Je raakt enthousiast en begint met het pitchen van de juridische chatbot die je momenteel wilt bouwen. Peter kijkt geïnteresseerd, leunt naar je toe, uhm en knikt. Op een gegeven moment wil je zijn mening of hij jouw app wil gebruiken. In plaats van een informatieve uitspraak die jouw welsprekendheid zou compenseren, hoor je: “Eh… wat deed deze app ook alweer?”

Het ongeschreven communicatiecontract tussen mensen veronderstelt dat we luisteren naar onze gesprekspartners en onze eigen spraakhandelingen bouwen op de context die we tijdens de interactie mede creëren. In sociale situaties kenmerkt de opkomst van dit gezamenlijke begrip een vruchtbaar, verrijkend gesprek. In meer alledaagse situaties, zoals het reserveren van een tafel in een restaurant of het kopen van een treinkaartje, is dit een absolute noodzaak om de taak te volbrengen en de verwachte waarde voor de gebruiker te bieden. Dit vereist dat uw assistent de geschiedenis van het huidige gesprek kent, maar ook van eerdere gesprekken. Hij mag bijvoorbeeld niet steeds opnieuw naar de naam en andere persoonlijke gegevens van een gebruiker vragen wanneer deze een gesprek begint.

Een van de uitdagingen bij het behouden van contextbewustzijn is coreferentieresolutie, dwz begrijpen naar welke objecten verwezen wordt door voornaamwoorden. Mensen gebruiken intuïtief veel contextuele aanwijzingen bij het interpreteren van taal. Je kunt bijvoorbeeld aan een jong kind vragen: 'Haal alsjeblieft de groene bal uit het rode vakje en breng hem naar mij', en het kind zal weten dat je de bal meent. , niet de doos. Voor virtuele assistenten kan deze taak nogal uitdagend zijn, zoals geïllustreerd door de volgende dialoog:

Assistent: Bedankt, ik ga nu je vlucht boeken. Wilt u ook een maaltijd bestellen voor uw vlucht?

Gebruiker: Uhm... kan ik later beslissen of ik dat wil?

Assistent: Sorry, deze vlucht kan later niet meer worden gewijzigd of geannuleerd.

Hier herkent de assistent het voornaamwoord niet it van de gebruiker verwijst niet naar de vlucht, maar naar de maaltijd, waardoor een nieuwe iteratie nodig is om dit misverstand op te lossen.

3.4 Extra leuningen

Zo nu en dan zal zelfs de beste LLM zich misdragen en hallucineren. In veel gevallen zijn hallucinaties duidelijke nauwkeurigheidsproblemen – en je moet accepteren dat geen enkele AI 100% accuraat is. Vergeleken met andere AI-systemen is de ‘afstand’ tussen de gebruiker en de AI vrij klein. Een eenvoudig nauwkeurigheidsprobleem kan snel uitmonden in iets dat als giftig, discriminerend of in het algemeen schadelijk wordt ervaren. Omdat LLM's geen inherent begrip van privacy hebben, kunnen ze bovendien gevoelige gegevens onthullen, zoals persoonlijk identificeerbare informatie (PII). U kunt dit gedrag tegengaan door extra vangrails te gebruiken. Met tools zoals Guardrails AI, Rebuff, NeMo Guardrails en Microsoft Guidance kunt u de risico's van uw systeem verminderen door aanvullende vereisten te formuleren voor LLM-uitvoer en ongewenste uitvoer te blokkeren.

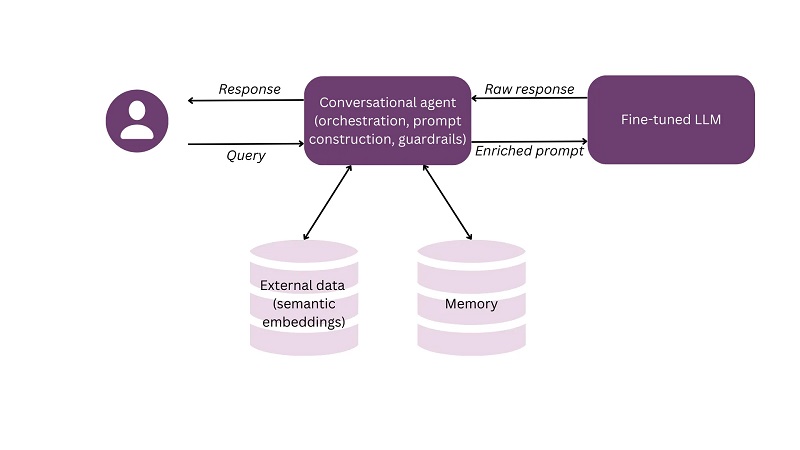

Er zijn meerdere architecturen mogelijk in conversationele AI. Het volgende schema toont een eenvoudig voorbeeld van hoe de verfijnde LLM, externe gegevens en geheugen kunnen worden geïntegreerd door een gespreksagent, die ook verantwoordelijk is voor de promptconstructie en de vangrails.

4. Gebruikerservaring en conversatieontwerp

De charme van conversatie-interfaces ligt in hun eenvoud en uniformiteit in verschillende toepassingen. Als de toekomst van gebruikersinterfaces erin bestaat dat alle apps er min of meer hetzelfde uitzien, is de taak van de UX-ontwerper dan gedoemd? Absoluut niet: conversatie is een kunst die aan uw LLM moet worden geleerd, zodat deze gesprekken kan voeren die nuttig, natuurlijk en comfortabel zijn voor uw gebruikers. Goed conversational design ontstaat wanneer we onze kennis van menselijke psychologie, taalkunde en UX-design combineren. Hieronder zullen we eerst twee basiskeuzes overwegen bij het bouwen van een conversatiesysteem, namelijk of u spraak en/of chat gaat gebruiken, evenals de bredere context van uw systeem. Vervolgens kijken we naar de gesprekken zelf en zien we hoe u de persoonlijkheid van uw assistent kunt vormgeven en hem kunt leren om nuttige en coöperatieve gesprekken te voeren.

4.1 Spraak versus chat

Conversatie-interfaces kunnen worden geïmplementeerd via chat of spraak. Kortom: spraak is sneller, terwijl chat gebruikers in staat stelt privé te blijven en te profiteren van verrijkte UI-functionaliteit. Laten we wat dieper ingaan op de twee opties, aangezien dit een van de eerste en belangrijkste beslissingen is waarmee u te maken krijgt bij het bouwen van een conversatie-app.

Om tussen de twee alternatieven te kiezen, moet u eerst rekening houden met de fysieke omgeving waarin uw app zal worden gebruikt. Waarom zijn bijvoorbeeld bijna alle gesprekssystemen in auto’s, zoals die van Nuance Communications, gebaseerd op spraak? Omdat de handen van de bestuurder al bezig zijn en ze niet voortdurend kunnen schakelen tussen het stuur en een toetsenbord. Dit geldt ook voor andere activiteiten zoals koken, waarbij gebruikers tijdens het gebruik van uw app in de stroom van hun activiteiten willen blijven. Auto's en keukens zijn meestal privé-ruimtes, zodat gebruikers het plezier van spraakinteractie kunnen ervaren zonder zich zorgen te hoeven maken over hun privacy of over het lastigvallen van anderen. Als uw app daarentegen in een openbare omgeving zoals op kantoor, een bibliotheek of een treinstation wordt gebruikt, is spraak wellicht niet uw eerste keuze.

Nadat je de fysieke omgeving hebt begrepen, overweeg dan de emotionele kant. Stem kan opzettelijk worden gebruikt om toon, stemming en persoonlijkheid over te brengen. Voegt dit waarde toe in uw context? Als u uw app voor uw vrije tijd bouwt, kan uw stem de funfactor vergroten, terwijl een assistent voor de geestelijke gezondheidszorg voor meer empathie zou kunnen zorgen en een potentieel problematische gebruiker een grotere expressie van expressie zou kunnen bieden. Als uw app daarentegen gebruikers helpt in een professionele omgeving, zoals handelen of klantenservice, kan een meer anonieme, op tekst gebaseerde interactie bijdragen aan objectievere beslissingen en u de moeite besparen van het ontwerpen van een al te emotionele ervaring.

Denk als volgende stap na over de functionaliteit. Met de op tekst gebaseerde interface kunt u de gesprekken verrijken met andere media zoals afbeeldingen en grafische UI-elementen zoals knoppen. In een e-commerce-assistent zal een app die producten voorstelt door afbeeldingen en gestructureerde beschrijvingen te plaatsen bijvoorbeeld veel gebruiksvriendelijker zijn dan een app die producten via spraak beschrijft en mogelijk hun identificatiegegevens verstrekt.

Laten we het tot slot hebben over de extra ontwerp- en ontwikkelingsuitdagingen die gepaard gaan met het bouwen van een spraakinterface:

- Er is een extra stap van spraakherkenning die plaatsvindt voordat gebruikersinvoer kan worden verwerkt met LLM's en Natural Language Processing (NLP).

- Stem is een persoonlijker en emotioneler communicatiemiddel. De vereisten voor het ontwerpen van een consistente, passende en plezierige persoonlijkheid achter uw virtuele assistent zijn dus hoger, en u zult rekening moeten houden met aanvullende factoren van ‘stemontwerp’, zoals timbre. , stress, toon en spreeksnelheid.

- Gebruikers verwachten dat uw stemgesprek net zo snel verloopt als een menselijk gesprek. Om een natuurlijke interactie via spraak aan te bieden, heb je een veel kortere latentie nodig dan voor chat. In menselijke gesprekken is de typische pauze tussen beurten 200 milliseconden. Deze snelle reactie is mogelijk omdat we onze beurten beginnen te construeren terwijl we naar de toespraak van onze partner luisteren. Uw stemassistent moet overeenkomen met deze mate van vloeiendheid in de interactie. Bij chatbots daarentegen concurreer je met tijdspannes van seconden, en sommige ontwikkelaars introduceren zelfs een extra vertraging om het gesprek te laten aanvoelen als een getypte chat tussen mensen.

- Communicatie via spraak is een lineaire, eenmalige onderneming. Als uw gebruiker niet heeft begrepen wat u zei, staat u een vervelende, foutgevoelige verduidelijkingslus te wachten. Daarom moeten uw beurten zo beknopt, duidelijk en informatief mogelijk zijn.

Als u voor de spraakoplossing kiest, zorg er dan voor dat u niet alleen de voordelen ten opzichte van chat duidelijk begrijpt, maar ook over de vaardigheden en middelen beschikt om deze extra uitdagingen aan te gaan.

4.2 Waar zal uw conversationele AI leven?

Laten we nu eens kijken naar de bredere context waarin u conversationele AI kunt integreren. We zijn allemaal bekend met chatbots op bedrijfswebsites: de widgets aan de rechterkant van uw scherm die verschijnen wanneer we de website van een bedrijf openen. Persoonlijk is mijn intuïtieve reactie vaker wel dan niet het zoeken naar de knop Sluiten. Waarom is dat? Door de eerste pogingen om met deze bots te ‘converseren’, heb ik geleerd dat ze niet aan meer specifieke informatie-eisen kunnen voldoen, en uiteindelijk moet ik nog steeds de website doorzoeken. Het moraal van het verhaal? Bouw geen chatbot omdat hij cool en trendy is, maar bouw hem omdat u zeker weet dat hij extra waarde voor uw gebruikers kan creëren.

Naast de controversiële widget op een bedrijfswebsite zijn er verschillende opwindende contexten om de meer algemene chatbots te integreren die mogelijk zijn geworden met LLM's:

- Copiloten: Deze assistenten begeleiden en adviseren u bij specifieke processen en taken, zoals GitHub CoPilot voor programmeren. Normaal gesproken zijn copiloten ‘gekoppeld’ aan een specifieke applicatie (of een kleine reeks gerelateerde applicaties).

- Synthetische mensen (ook digitale mensen): Deze wezens ‘emuleren’ echte mensen in de digitale wereld. Ze zien eruit, handelen en praten als mensen en hebben dus ook rijke gespreksvaardigheden nodig. Synthetische mensen worden vaak gebruikt in meeslepende toepassingen zoals gaming, augmented en virtual reality.

- Digitale tweeling: Digitale tweelingen zijn digitale ‘kopieën’ van processen en objecten uit de echte wereld, zoals fabrieken, auto’s of motoren. Ze worden gebruikt om het ontwerp en het gedrag van het echte object te simuleren, analyseren en optimaliseren. Natuurlijke taalinteracties met digitale tweelingen zorgen voor een soepelere en veelzijdigere toegang tot de gegevens en modellen.

- databases: Tegenwoordig zijn er gegevens beschikbaar over elk onderwerp, of het nu gaat om beleggingsaanbevelingen, codefragmenten of educatief materiaal. Wat vaak moeilijk is, is het vinden van de zeer specifieke gegevens die gebruikers in een specifieke situatie nodig hebben. Grafische interfaces met databases zijn ofwel te grofkorrelig of bedekt met eindeloze zoek- en filterwidgets. Veelzijdige querytalen zoals SQL en GraphQL zijn alleen toegankelijk voor gebruikers met de bijbehorende vaardigheden. Conversatieoplossingen stellen gebruikers in staat de gegevens in natuurlijke taal op te vragen, terwijl de LLM die de verzoeken verwerkt deze automatisch omzet in de overeenkomstige zoektaal (vgl. dit artikel voor een uitleg van Text2SQL).

4.3 Een persoonlijkheid op uw assistent plakken

Als mensen zijn we geprogrammeerd om te antropomorfiseren, dat wil zeggen om extra menselijke eigenschappen toe te voegen als we iets zien dat vaag op een mens lijkt. Taal is een van de meest unieke en fascinerende vermogens van de mensheid, en conversatieproducten zullen automatisch met mensen worden geassocieerd. Mensen stellen zich een persoon voor achter hun scherm of apparaat. Het is een goede gewoonte om deze specifieke persoon niet over te laten aan de fantasie van uw gebruikers, maar hem een consistente persoonlijkheid te geven die aansluit bij uw product en merk. Dit proces wordt ‘persona-ontwerp’ genoemd.

De eerste stap van persona-ontwerp is het begrijpen van de karaktereigenschappen die je wilt laten zien in je persona. Idealiter gebeurt dit al op het niveau van de trainingsgegevens. Als u RLHF gebruikt, kunt u uw annotators bijvoorbeeld vragen de gegevens te rangschikken op basis van eigenschappen als behulpzaamheid, beleefdheid, plezier, enz., om het model een bepaalde richting te geven. de gewenste eigenschappen. Deze kenmerken kunnen worden gekoppeld aan uw merkkenmerken om een consistent beeld te creëren dat uw branding voortdurend promoot via de productervaring.

Naast algemene kenmerken moet u ook nadenken over hoe uw virtuele assistent zal omgaan met specifieke situaties buiten het ‘gelukkige pad’. Hoe zal het bijvoorbeeld reageren op verzoeken van gebruikers die buiten zijn bereik vallen, vragen over zichzelf beantwoorden en omgaan met beledigend of vulgair taalgebruik?

Het is belangrijk om expliciete interne richtlijnen over uw persoonlijkheid te ontwikkelen die kunnen worden gebruikt door data-annotators en gespreksontwerpers. Hierdoor kunt u uw persona op een doelgerichte manier ontwerpen en consistent houden binnen uw team en in de loop van de tijd, aangezien uw applicatie meerdere iteraties en verfijningen ondergaat.

4.4 Gesprekken nuttig maken met het “principe van samenwerking”

Heeft u ooit de indruk gehad dat u tegen een bakstenen muur praatte, terwijl u in werkelijkheid met een mens sprak? Soms merken we dat onze gesprekspartners er gewoon niet in geïnteresseerd zijn om het gesprek tot een succes te maken. Gelukkig verlopen de zaken in de meeste gevallen soepeler en zullen mensen intuïtief het ‘principe van samenwerking’ volgen dat werd geïntroduceerd door de taalfilosoof Paul Grice. Volgens dit principe volgen mensen die succesvol met elkaar communiceren vier stelregels, namelijk kwantiteit, kwaliteit, relevantie en manier van doen.

Maxime van kwantiteit

De stelregel van kwantiteit vraagt van de spreker om informatief te zijn en zijn bijdrage zo informatief te maken als nodig is. Aan de kant van de virtuele assistent betekent dit ook dat je het gesprek actief vooruit brengt. Beschouw bijvoorbeeld dit fragment uit een e-commerce mode-app:

Assistent: Wat voor kledingartikelen zoek je?

Gebruiker: Ik zoek een oranje jurkje.

Assistent: Niet doen: Sorry, we hebben momenteel geen oranje jurken.

Do: Sorry, we hebben geen oranje jurken, maar we hebben deze geweldige en zeer comfortabele jurk in het geel: …

De gebruiker hoopt uw app te verlaten met een geschikt item. Als u het gesprek beëindigt omdat u geen items heeft die aan de exacte beschrijving voldoen, wordt de kans op succes uitgesloten. Als uw app echter suggesties doet over alternatieve items, zal deze nuttiger lijken en de mogelijkheid van een succesvolle interactie open laten.

Vooral bij steminteracties is het belangrijk om de juiste balans te vinden tussen het verstrekken van alle informatie die de gebruiker nodig heeft voor succes en het niet overweldigen van de gebruiker met onnodige informatie die de interactie zou kunnen vertroebelen.

Maxime van kwaliteit

De stelregel van kwaliteit vraagt van sprekers om waarheidsgetrouw te zijn en geen dingen te zeggen waarvan zij denken dat ze onwaar zijn of waarvoor ze geen voldoende bewijs hebben. Er is hier veel subjectiviteit en persoonlijke overtuiging bij betrokken – deze stelregel kan dus niet rechtstreeks op LLM’s worden geprojecteerd. Zoals we hebben gezien, hebben LLM’s de neiging te hallucineren, en dit risico is vooral groot wanneer het gesprek afdwaalt naar minder bekende gebieden. Er kunnen extra vangrails worden ingezet om misleidende uitspraken te voorkomen en het gesprek weer op de rails te krijgen.

Maxime van relevantie

De stelregel van relevantie vraagt ons om – nou ja, relevant te zijn. Als voorwaarde moet de virtuele assistent de ware bedoelingen van de gebruiker begrijpen. Hier is een voorbeeld van een luchtvaartassistent die deze regel overtreedt:

Gebruiker: Ik heb morgenochtend een vlucht nodig van Berlijn naar Zürich.

Assistent: Oké, ik heb de volgende vluchten van Berlijn naar Zürich gevonden voor morgenochtend. Vlucht BZ36294 vertrekt om 6.30 uur uit Berlijn en komt om 8 uur aan in Zürich. Vlucht BZ96294 vertrekt om 8 uur uit Berlijn en arriveert om 9.30 uur. Vlucht BZ96294 verlaat Berlijn om 8 uur en arriveert om 9.30 uur in Zürich. Vlucht BZ95614 vertrekt om 11 uur uit Berlijn en arriveert om 12.30 uur in Zürich. Er is ook de mogelijkheid van een aansluitende vlucht, in dat geval verlaat u Berlijn om 11.45 uur en arriveert u om 3 uur in Zürich.

Gebruiker: Sorry... kunt u dit nog een keer herhalen?

De assistent overweldigt de gebruiker met gedetailleerde informatie die misschien niet relevant is. Door dit op te splitsen en de gebruiker te begeleiden om zijn zoekruimte te beperken, wordt de dialoog veel gemakkelijker te verteren:

Gebruiker: Ik heb morgenochtend een vlucht nodig van Berlijn naar Zürich.

Assistent: Oké, ik heb vluchten gevonden die vertrekken om 6.30, 8 en 11 uur. Op welk tijdstip wilt u vertrekken?

Gebruiker: Ik moet vóór 9 uur in Zürich zijn.

Assistent: Oké, je kunt dus vlucht BZ36294 nemen. Het vertrekt om 6.30 uur en arriveert om 8 uur. Moet ik het kaartje voor je kopen?

Gebruiker: Ja bedankt.

Maxime van manier

Ten slotte stelt de stelregel van de manier van spreken dat onze taalhandelingen duidelijk, beknopt en ordelijk moeten zijn, waarbij dubbelzinnigheid en onduidelijkheid in de uitdrukking moeten worden vermeden. Uw virtuele assistent moet technisch of intern jargon vermijden en de voorkeur geven aan eenvoudige, universeel begrijpelijke formuleringen.

Hoewel de principes van Grice gelden voor alle gesprekken, onafhankelijk van een specifiek domein, slagen LLM's die niet specifiek zijn opgeleid voor gesprekken er vaak niet in om deze te vervullen. Bij het samenstellen van uw trainingsgegevens is het dus belangrijk om voldoende dialoogvoorbeelden te hebben waarmee uw model deze principes kan leren.

Het domein van conversational design ontwikkelt zich vrij snel. Of je nu al AI-producten bouwt of nadenkt over je carrièrepad in AI, ik moedig je aan om dieper in dit onderwerp te duiken (zie de uitstekende introducties in [5] en [6]). Nu AI een commodity wordt, zullen een goed ontwerp en een verdedigbare datastrategie twee belangrijke onderscheidende factoren voor AI-producten worden.

Samengevat

Laten we de belangrijkste conclusies uit het artikel samenvatten. Daarnaast biedt figuur 5 een “spiekbriefje” met de belangrijkste punten die u ter referentie kunt downloaden.

- LLM's verbeteren conversationele AI: Large Language Models (LLM's) hebben de kwaliteit en schaalbaarheid van conversationele AI-toepassingen in verschillende industrieën en gebruiksscenario's aanzienlijk verbeterd.

- Conversationele AI kan veel waarde toevoegen aan applicaties met veel vergelijkbare gebruikersverzoeken (bijvoorbeeld klantenservice) of die toegang nodig hebben tot een grote hoeveelheid ongestructureerde gegevens (bijvoorbeeld kennisbeheer).

- Gegevens: Voor het verfijnen van LLM's voor gesprekstaken zijn gespreksgegevens van hoge kwaliteit nodig die nauw aansluiten bij interacties in de echte wereld. Crowdsourcing en door LLM gegenereerde gegevens kunnen waardevolle bronnen zijn voor het opschalen van de gegevensverzameling.

- Het systeem samenstellen: Het ontwikkelen van conversationele AI-systemen is een iteratief en experimenteel proces waarbij de gegevens voortdurend worden geoptimaliseerd, strategieën worden verfijnd en componenten worden geïntegreerd.

- Conversatievaardigheden aanleren aan LLM's: Het verfijnen van LLM's houdt in dat ze worden getraind in het herkennen van en reageren op specifieke communicatieve intenties en situaties.

- Externe gegevens toevoegen met semantisch zoeken: het integreren van externe en interne gegevensbronnen met behulp van semantisch zoeken verbetert de reacties van de AI door meer contextueel relevante informatie te bieden.

- Geheugen- en contextbewustzijn: Effectieve gesprekssystemen moeten het contextbewustzijn behouden, inclusief het volgen van de geschiedenis van het huidige gesprek en eerdere interacties, om betekenisvolle en samenhangende antwoorden te bieden.

- Vangrails instellen: Om verantwoordelijk gedrag te garanderen, moeten conversationele AI-systemen vangrails gebruiken om onnauwkeurigheden, hallucinaties en inbreuken op de privacy te voorkomen.

- Persona-ontwerp: Het ontwerpen van een consistente persona voor uw gespreksassistent is essentieel voor het creëren van een samenhangende en merkgebonden gebruikerservaring. Personakenmerken moeten aansluiten bij uw product- en merkkenmerken.

- Stem versus chat: De keuze tussen stem- en chatinterfaces hangt af van factoren zoals de fysieke omgeving, emotionele context, functionaliteit en ontwerpuitdagingen. Houd rekening met deze factoren bij het bepalen van de interface voor uw conversationele AI.

- Integratie in verschillende contexten: Conversationele AI kan worden geïntegreerd in verschillende contexten, waaronder copiloten, synthetische mensen, digitale tweelingen en databases, elk met specifieke gebruiksscenario's en vereisten.

- Het principe van samenwerking in acht nemen: Het volgen van de principes van kwantiteit, kwaliteit, relevantie en manier van praten kan interacties met conversationele AI nuttiger en gebruiksvriendelijker maken.

Referenties

[1] Heng-Tze Chen et al. 2022. LaMDA: op weg naar veilige, geaarde en hoogwaardige dialoogmodellen voor alles.

[2] Open AI. 2022. ChatGPT: Taalmodellen optimaliseren voor dialoog. Opgehaald op 13 januari 2022.

[3] Patrick Lewis et al. 2020. Retrieval-Augmented Generation voor kennisintensieve NLP-taken.

[4] Paul Grice. 1989. Studies naar de manier van woorden.

[5] Cathy Parel. 2016. Spraakgebruikersinterfaces ontwerpen.

[6] Michael Cohen et al. 2004. Ontwerp van spraakgebruikersinterface.

Let op: Alle afbeeldingen zijn van de auteur, tenzij anders aangegeven.

Dit artikel is oorspronkelijk gepubliceerd op Op weg naar data science en opnieuw gepubliceerd naar TOPBOTS met toestemming van de auteur.

Geniet van dit artikel? Meld u aan voor meer AI-onderzoeksupdates.

We laten het u weten wanneer we meer samenvattende artikelen zoals deze vrijgeven.

Verwant

- Door SEO aangedreven content en PR-distributie. Word vandaag nog versterkt.

- PlatoData.Network Verticale generatieve AI. Versterk jezelf. Toegang hier.

- PlatoAiStream. Web3-intelligentie. Kennis versterkt. Toegang hier.

- PlatoESG. carbon, CleanTech, Energie, Milieu, Zonne, Afvalbeheer. Toegang hier.

- Plato Gezondheid. Intelligentie op het gebied van biotech en klinische proeven. Toegang hier.

- Bron: https://www.topbots.com/redefining-conversational-ai-with-large-language-models/