24 nov 2022 (Nanowerk Nieuws) Voordat een machine-learning model een taak kan voltooien, zoals het identificeren van kanker in medische beelden, moet het model worden getraind. Het trainen van beeldclassificatiemodellen omvat meestal het tonen van het model met miljoenen voorbeeldafbeeldingen die zijn verzameld in een enorme dataset. Het gebruik van echte afbeeldingsgegevens kan echter praktische en ethische problemen opleveren: de afbeeldingen kunnen in strijd zijn met auteursrechtwetten, de privacy van mensen schenden of bevooroordeeld zijn tegen een bepaald ras of etnische groep. Om deze valkuilen te vermijden, kunnen onderzoekers programma's voor het genereren van afbeeldingen gebruiken om synthetische gegevens te creëren voor modeltraining. Maar deze technieken zijn beperkt omdat er vaak deskundige kennis nodig is om met de hand een programma voor het genereren van afbeeldingen te ontwerpen dat effectieve trainingsgegevens kan creëren.

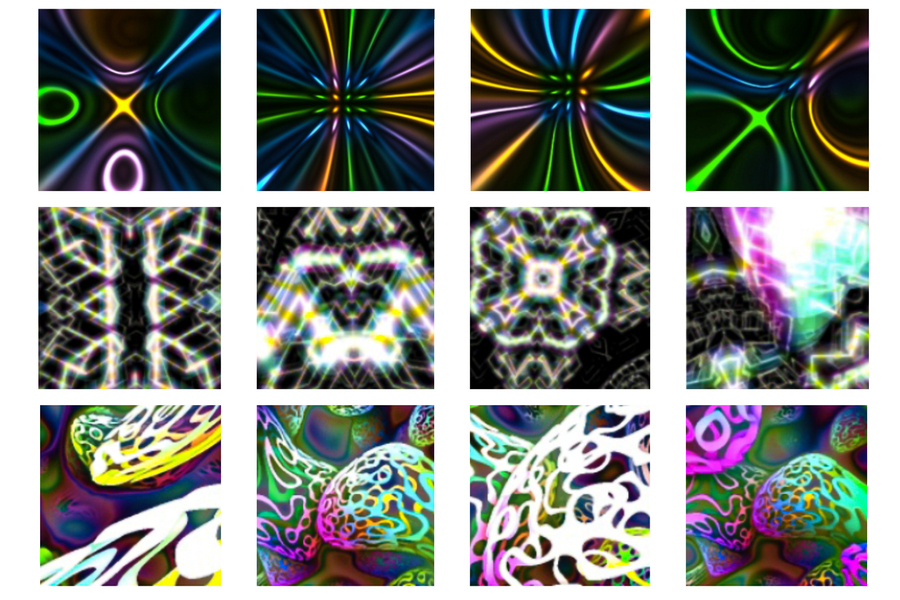

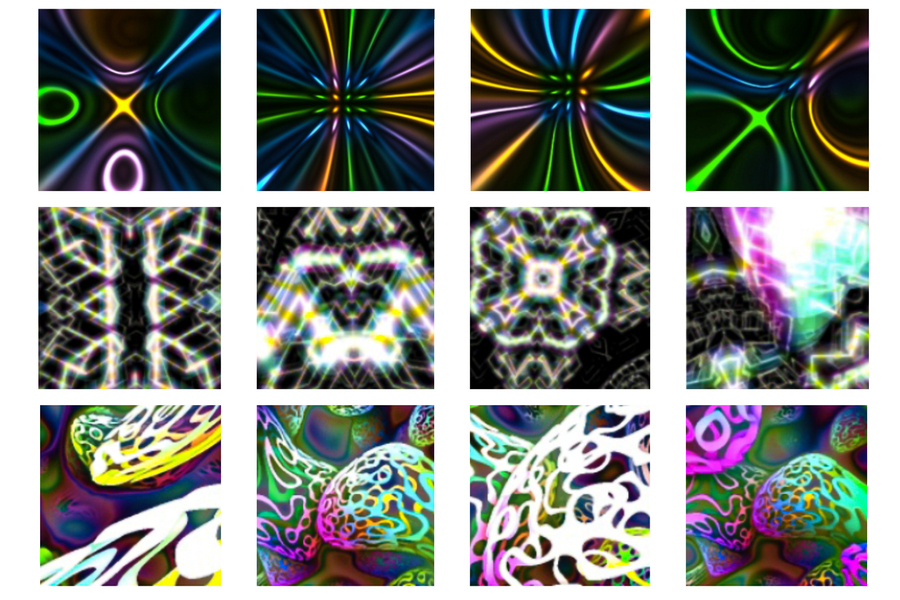

Onderzoekers gebruikten een grote verzameling eenvoudige, niet-gecureerde programma's voor het genereren van synthetische beelden om een computervisiemodel voor beeldclassificatie voor te trainen. De onderzoekers hebben de programma's, die elk slechts een paar regels code bevatten, niet samengesteld of gewijzigd. In deze afbeelding zijn de afbeeldingssets in elke rij geproduceerd met behulp van 3 verschillende programma's voor het genereren van afbeeldingen. (Afbeelding: met dank aan de onderzoekers) Onderzoekers van MIT, het MIT-IBM Watson AI Lab en elders pakten het anders aan. In plaats van op maat gemaakte programma's voor het genereren van afbeeldingen te ontwerpen voor een bepaalde trainingstaak, verzamelden ze een dataset van 21,000 openbaar beschikbare programma's van internet. Vervolgens gebruikten ze deze grote verzameling basisprogramma's voor het genereren van afbeeldingen om een computervisiemodel te trainen. Deze programma's produceren diverse afbeeldingen met eenvoudige kleuren en texturen. De onderzoekers hebben de programma's, die elk slechts een paar regels code bevatten, niet samengesteld of gewijzigd. De modellen die ze trainden met deze grote dataset van programma's classificeerden afbeeldingen nauwkeuriger dan andere synthetisch getrainde modellen. En hoewel hun modellen slechter presteerden dan de modellen die waren getraind met echte gegevens, toonden de onderzoekers aan dat het vergroten van het aantal beeldprogramma's in de dataset ook de modelprestaties verhoogde, waardoor een weg naar hogere nauwkeurigheid werd onthuld. “Het blijkt dat het gebruik van veel programma's die niet zijn samengesteld eigenlijk beter is dan het gebruik van een kleine set programma's die mensen moeten manipuleren. Gegevens zijn belangrijk, maar we hebben laten zien dat je vrij ver kunt komen zonder echte gegevens”, zegt Manel Baradad, een afgestudeerde student elektrotechniek en computerwetenschappen (EECS) die werkt in het Computer Science and Artificial Intelligence Laboratory (CSAIL) en hoofdauteur van het artikel dat deze techniek beschrijft ("Procedurale beeldprogramma's voor leren over representatie"). Co-auteurs zijn onder meer Tongzhou Wang, een EECS-student in CSAIL; Rogerio Feris, hoofdwetenschapper en manager bij het MIT-IBM Watson AI Lab; Antonio Torralba, hoogleraar Elektrotechniek en Computerwetenschappen bij Delta Electronics en lid van CSAIL; en senior auteur Phillip Isola, een universitair hoofddocent in EECS en CSAIL; samen met anderen bij JPMorgan Chase Bank en Xyla, Inc. Het onderzoek zal worden gepresenteerd op de conferentie over neurale informatieverwerkingssystemen.

Onderzoekers gebruikten een grote verzameling eenvoudige, niet-gecureerde programma's voor het genereren van synthetische beelden om een computervisiemodel voor beeldclassificatie voor te trainen. De onderzoekers hebben de programma's, die elk slechts een paar regels code bevatten, niet samengesteld of gewijzigd. In deze afbeelding zijn de afbeeldingssets in elke rij geproduceerd met behulp van 3 verschillende programma's voor het genereren van afbeeldingen. (Afbeelding: met dank aan de onderzoekers) Onderzoekers van MIT, het MIT-IBM Watson AI Lab en elders pakten het anders aan. In plaats van op maat gemaakte programma's voor het genereren van afbeeldingen te ontwerpen voor een bepaalde trainingstaak, verzamelden ze een dataset van 21,000 openbaar beschikbare programma's van internet. Vervolgens gebruikten ze deze grote verzameling basisprogramma's voor het genereren van afbeeldingen om een computervisiemodel te trainen. Deze programma's produceren diverse afbeeldingen met eenvoudige kleuren en texturen. De onderzoekers hebben de programma's, die elk slechts een paar regels code bevatten, niet samengesteld of gewijzigd. De modellen die ze trainden met deze grote dataset van programma's classificeerden afbeeldingen nauwkeuriger dan andere synthetisch getrainde modellen. En hoewel hun modellen slechter presteerden dan de modellen die waren getraind met echte gegevens, toonden de onderzoekers aan dat het vergroten van het aantal beeldprogramma's in de dataset ook de modelprestaties verhoogde, waardoor een weg naar hogere nauwkeurigheid werd onthuld. “Het blijkt dat het gebruik van veel programma's die niet zijn samengesteld eigenlijk beter is dan het gebruik van een kleine set programma's die mensen moeten manipuleren. Gegevens zijn belangrijk, maar we hebben laten zien dat je vrij ver kunt komen zonder echte gegevens”, zegt Manel Baradad, een afgestudeerde student elektrotechniek en computerwetenschappen (EECS) die werkt in het Computer Science and Artificial Intelligence Laboratory (CSAIL) en hoofdauteur van het artikel dat deze techniek beschrijft ("Procedurale beeldprogramma's voor leren over representatie"). Co-auteurs zijn onder meer Tongzhou Wang, een EECS-student in CSAIL; Rogerio Feris, hoofdwetenschapper en manager bij het MIT-IBM Watson AI Lab; Antonio Torralba, hoogleraar Elektrotechniek en Computerwetenschappen bij Delta Electronics en lid van CSAIL; en senior auteur Phillip Isola, een universitair hoofddocent in EECS en CSAIL; samen met anderen bij JPMorgan Chase Bank en Xyla, Inc. Het onderzoek zal worden gepresenteerd op de conferentie over neurale informatieverwerkingssystemen.

Onderzoekers gebruikten een grote verzameling eenvoudige, niet-gecureerde programma's voor het genereren van synthetische beelden om een computervisiemodel voor beeldclassificatie voor te trainen. De onderzoekers hebben de programma's, die elk slechts een paar regels code bevatten, niet samengesteld of gewijzigd. In deze afbeelding zijn de afbeeldingssets in elke rij geproduceerd met behulp van 3 verschillende programma's voor het genereren van afbeeldingen. (Afbeelding: met dank aan de onderzoekers) Onderzoekers van MIT, het MIT-IBM Watson AI Lab en elders pakten het anders aan. In plaats van op maat gemaakte programma's voor het genereren van afbeeldingen te ontwerpen voor een bepaalde trainingstaak, verzamelden ze een dataset van 21,000 openbaar beschikbare programma's van internet. Vervolgens gebruikten ze deze grote verzameling basisprogramma's voor het genereren van afbeeldingen om een computervisiemodel te trainen. Deze programma's produceren diverse afbeeldingen met eenvoudige kleuren en texturen. De onderzoekers hebben de programma's, die elk slechts een paar regels code bevatten, niet samengesteld of gewijzigd. De modellen die ze trainden met deze grote dataset van programma's classificeerden afbeeldingen nauwkeuriger dan andere synthetisch getrainde modellen. En hoewel hun modellen slechter presteerden dan de modellen die waren getraind met echte gegevens, toonden de onderzoekers aan dat het vergroten van het aantal beeldprogramma's in de dataset ook de modelprestaties verhoogde, waardoor een weg naar hogere nauwkeurigheid werd onthuld. “Het blijkt dat het gebruik van veel programma's die niet zijn samengesteld eigenlijk beter is dan het gebruik van een kleine set programma's die mensen moeten manipuleren. Gegevens zijn belangrijk, maar we hebben laten zien dat je vrij ver kunt komen zonder echte gegevens”, zegt Manel Baradad, een afgestudeerde student elektrotechniek en computerwetenschappen (EECS) die werkt in het Computer Science and Artificial Intelligence Laboratory (CSAIL) en hoofdauteur van het artikel dat deze techniek beschrijft ("Procedurale beeldprogramma's voor leren over representatie"). Co-auteurs zijn onder meer Tongzhou Wang, een EECS-student in CSAIL; Rogerio Feris, hoofdwetenschapper en manager bij het MIT-IBM Watson AI Lab; Antonio Torralba, hoogleraar Elektrotechniek en Computerwetenschappen bij Delta Electronics en lid van CSAIL; en senior auteur Phillip Isola, een universitair hoofddocent in EECS en CSAIL; samen met anderen bij JPMorgan Chase Bank en Xyla, Inc. Het onderzoek zal worden gepresenteerd op de conferentie over neurale informatieverwerkingssystemen.

Onderzoekers gebruikten een grote verzameling eenvoudige, niet-gecureerde programma's voor het genereren van synthetische beelden om een computervisiemodel voor beeldclassificatie voor te trainen. De onderzoekers hebben de programma's, die elk slechts een paar regels code bevatten, niet samengesteld of gewijzigd. In deze afbeelding zijn de afbeeldingssets in elke rij geproduceerd met behulp van 3 verschillende programma's voor het genereren van afbeeldingen. (Afbeelding: met dank aan de onderzoekers) Onderzoekers van MIT, het MIT-IBM Watson AI Lab en elders pakten het anders aan. In plaats van op maat gemaakte programma's voor het genereren van afbeeldingen te ontwerpen voor een bepaalde trainingstaak, verzamelden ze een dataset van 21,000 openbaar beschikbare programma's van internet. Vervolgens gebruikten ze deze grote verzameling basisprogramma's voor het genereren van afbeeldingen om een computervisiemodel te trainen. Deze programma's produceren diverse afbeeldingen met eenvoudige kleuren en texturen. De onderzoekers hebben de programma's, die elk slechts een paar regels code bevatten, niet samengesteld of gewijzigd. De modellen die ze trainden met deze grote dataset van programma's classificeerden afbeeldingen nauwkeuriger dan andere synthetisch getrainde modellen. En hoewel hun modellen slechter presteerden dan de modellen die waren getraind met echte gegevens, toonden de onderzoekers aan dat het vergroten van het aantal beeldprogramma's in de dataset ook de modelprestaties verhoogde, waardoor een weg naar hogere nauwkeurigheid werd onthuld. “Het blijkt dat het gebruik van veel programma's die niet zijn samengesteld eigenlijk beter is dan het gebruik van een kleine set programma's die mensen moeten manipuleren. Gegevens zijn belangrijk, maar we hebben laten zien dat je vrij ver kunt komen zonder echte gegevens”, zegt Manel Baradad, een afgestudeerde student elektrotechniek en computerwetenschappen (EECS) die werkt in het Computer Science and Artificial Intelligence Laboratory (CSAIL) en hoofdauteur van het artikel dat deze techniek beschrijft ("Procedurale beeldprogramma's voor leren over representatie"). Co-auteurs zijn onder meer Tongzhou Wang, een EECS-student in CSAIL; Rogerio Feris, hoofdwetenschapper en manager bij het MIT-IBM Watson AI Lab; Antonio Torralba, hoogleraar Elektrotechniek en Computerwetenschappen bij Delta Electronics en lid van CSAIL; en senior auteur Phillip Isola, een universitair hoofddocent in EECS en CSAIL; samen met anderen bij JPMorgan Chase Bank en Xyla, Inc. Het onderzoek zal worden gepresenteerd op de conferentie over neurale informatieverwerkingssystemen.

Vooropleiding heroverwegen

Modellen voor machinaal leren zijn meestal vooraf getraind, wat betekent dat ze eerst op één dataset worden getraind om ze te helpen parameters op te bouwen die kunnen worden gebruikt om een andere taak aan te pakken. Een model voor het classificeren van röntgenstralen kan vooraf worden getraind met behulp van een enorme dataset van synthetisch gegenereerde beelden voordat het wordt getraind voor zijn daadwerkelijke taak met behulp van een veel kleinere dataset van echte röntgenstralen. Deze onderzoekers toonden eerder aan dat ze een handvol programma's voor het genereren van afbeeldingen konden gebruiken om synthetische gegevens te creëren voor modelvoorbereiding, maar de programma's moesten zorgvuldig worden ontworpen zodat de synthetische afbeeldingen overeenkwamen met bepaalde eigenschappen van echte afbeeldingen. Dit maakte de techniek moeilijk op te schalen. In het nieuwe werk gebruikten ze in plaats daarvan een enorme dataset van niet-gecureerde programma's voor het genereren van afbeeldingen. Ze begonnen met het verzamelen van een verzameling van 21,000 programma's voor het genereren van afbeeldingen van internet. Alle programma's zijn geschreven in een eenvoudige programmeertaal en bevatten slechts enkele stukjes code, zodat ze snel afbeeldingen genereren. "Deze programma's zijn ontworpen door ontwikkelaars over de hele wereld om afbeeldingen te produceren met enkele van de eigenschappen waarin we geïnteresseerd zijn. Ze produceren afbeeldingen die een beetje op abstracte kunst lijken", legt Baradad uit. Deze eenvoudige programma's kunnen zo snel draaien dat de onderzoekers vooraf geen afbeeldingen hoefden te maken om het model te trainen. De onderzoekers ontdekten dat ze beelden konden genereren en tegelijkertijd het model konden trainen, wat het proces stroomlijnde. Ze gebruikten hun enorme dataset van programma's voor het genereren van afbeeldingen om computervisiemodellen voor te trainen voor zowel gesuperviseerde als niet-gesuperviseerde beeldclassificatietaken. Bij gesuperviseerd leren worden de beeldgegevens gelabeld, terwijl bij niet-gesuperviseerd leren het model leert om afbeeldingen zonder labels te categoriseren.Verbetering van de nauwkeurigheid

Toen ze hun voorgetrainde modellen vergeleken met state-of-the-art computer vision-modellen die vooraf waren getraind met behulp van synthetische gegevens, waren hun modellen nauwkeuriger, wat betekent dat ze afbeeldingen vaker in de juiste categorieën plaatsten. Hoewel de nauwkeurigheidsniveaus nog steeds lager waren dan modellen die waren getraind op echte gegevens, verkleinde hun techniek de prestatiekloof tussen modellen die waren getraind op echte gegevens en modellen die waren getraind op synthetische gegevens met 38 procent. “Belangrijk is dat we laten zien dat voor het aantal programma's dat je verzamelt, de prestaties logaritmisch schalen. We verzadigen de prestaties niet, dus als we meer programma's verzamelen, zou het model nog beter presteren. Er is dus een manier om onze aanpak uit te breiden”, zegt Manel. De onderzoekers gebruikten ook elk individueel programma voor het genereren van afbeeldingen voor pre-training, in een poging factoren bloot te leggen die bijdragen aan de modelnauwkeurigheid. Ze ontdekten dat wanneer een programma een meer diverse set afbeeldingen genereert, het model beter presteert. Ze ontdekten ook dat kleurrijke afbeeldingen met scènes die het hele canvas vullen, de modelprestaties het meest verbeteren. Nu ze het succes van deze pre-trainingsaanpak hebben aangetoond, willen de onderzoekers hun techniek uitbreiden naar andere soorten gegevens, zoals multimodale gegevens die tekst en afbeeldingen bevatten. Ze willen ook doorgaan met het onderzoeken van manieren om de prestaties van de beeldclassificatie te verbeteren. “Er is nog steeds een gat te dichten met modellen die zijn getraind op echte gegevens. Dit geeft ons onderzoek een richting waarvan we hopen dat anderen die zullen volgen”, zegt hij.- Coinsmart. Europa's beste Bitcoin- en crypto-uitwisseling.Klik Hier

- Platoblockchain. Web3 Metaverse Intelligentie. Kennis versterkt. Toegang hier.

- Bron: https://www.nanowerk.com/news2/robotics/newsid=61903.php