Afbeelding door auteur

Voor velen van ons voelde het verkennen van de mogelijkheden van LLM’s buiten bereik. Of het nu gaat om het downloaden van ingewikkelde software, het uitzoeken van coderen of het nodig hebben van krachtige machines: aan de slag gaan met LLM's kan lastig lijken. Maar stel je eens voor dat we net zo gemakkelijk met deze krachtige taalmodellen zouden kunnen communiceren als met het starten van welk ander programma dan ook op onze computers. Geen installatie, geen codering, gewoon klikken en praten. Deze toegankelijkheid is van cruciaal belang voor zowel ontwikkelaars als eindgebruikers. llamaFile komt naar voren als een nieuwe oplossing, waarbij de lama.cpp Met Kosmopolitische Libc in één raamwerk. Dit raamwerk vermindert de complexiteit van LLM's door een uitvoerbaar bestand van één bestand genaamd "llama-bestand", dat op lokale machines draait zonder dat installatie nodig is.

Hoe werkt het? lamaFile aanbiedingen twee handige methoden voor het uitvoeren van LLM's:

- De eerste methode omvat het downloaden van de nieuwste versie van llamafile samen met de bijbehorende modelgewichten van Hugging Face. Zodra je die bestanden hebt, ben je klaar om te gaan!

- De tweede methode is nog eenvoudiger: u heeft toegang reeds bestaande voorbeeld lamabestanden waarin gewichten zijn ingebouwd.

In deze tutorial ga je werken met het lamabestand van de LLaVa-model met behulp van de tweede methode. Het is een model met 7 miljard parameters dat is gekwantiseerd tot 4 bits waarmee u kunt communiceren via chat, afbeeldingen kunt uploaden en vragen kunt stellen. De voorbeeldlamabestanden van andere modellen zijn ook beschikbaar, maar we zullen werken met het LLaVa-model, aangezien de lamabestandsgrootte 3.97 GB is, terwijl Windows een maximale uitvoerbare bestandsgrootte heeft van 4 GB. Het proces is eenvoudig genoeg en u kunt LLM's uitvoeren door de onderstaande stappen te volgen.

Eerst moet u het uitvoerbare bestand llava-v1.5-7b-q4.llama (3.97 GB) downloaden van de opgegeven bron hier.

Open de terminal van uw computer en navigeer naar de map waar het bestand zich bevindt. Voer vervolgens de volgende opdracht uit om uw computer toestemming te geven dit bestand uit te voeren.

chmod +x llava-v1.5-7b-q4.llamafileAls u Windows gebruikt, voegt u aan het einde “.exe” toe aan de naam van het lamabestand. Hiervoor kunt u de volgende opdracht op de terminal uitvoeren.

rename llava-v1.5-7b-q4.llamafile llava-v1.5-7b-q4.llamafile.exeVoer het lamabestand uit met de volgende opdracht.

./llava-v1.5-7b-q4.llamafile -ngl 9999

⚠️ Omdat MacOS zsh als standaardshell gebruikt en als je het tegenkomt zsh: exec format error: ./llava-v1.5-7b-q4.llamafile foutmelding, dan moet je dit uitvoeren:

bash -c ./llava-v1.5-7b-q4.llamafile -ngl 9999

Voor Windows kan uw opdracht er als volgt uitzien:

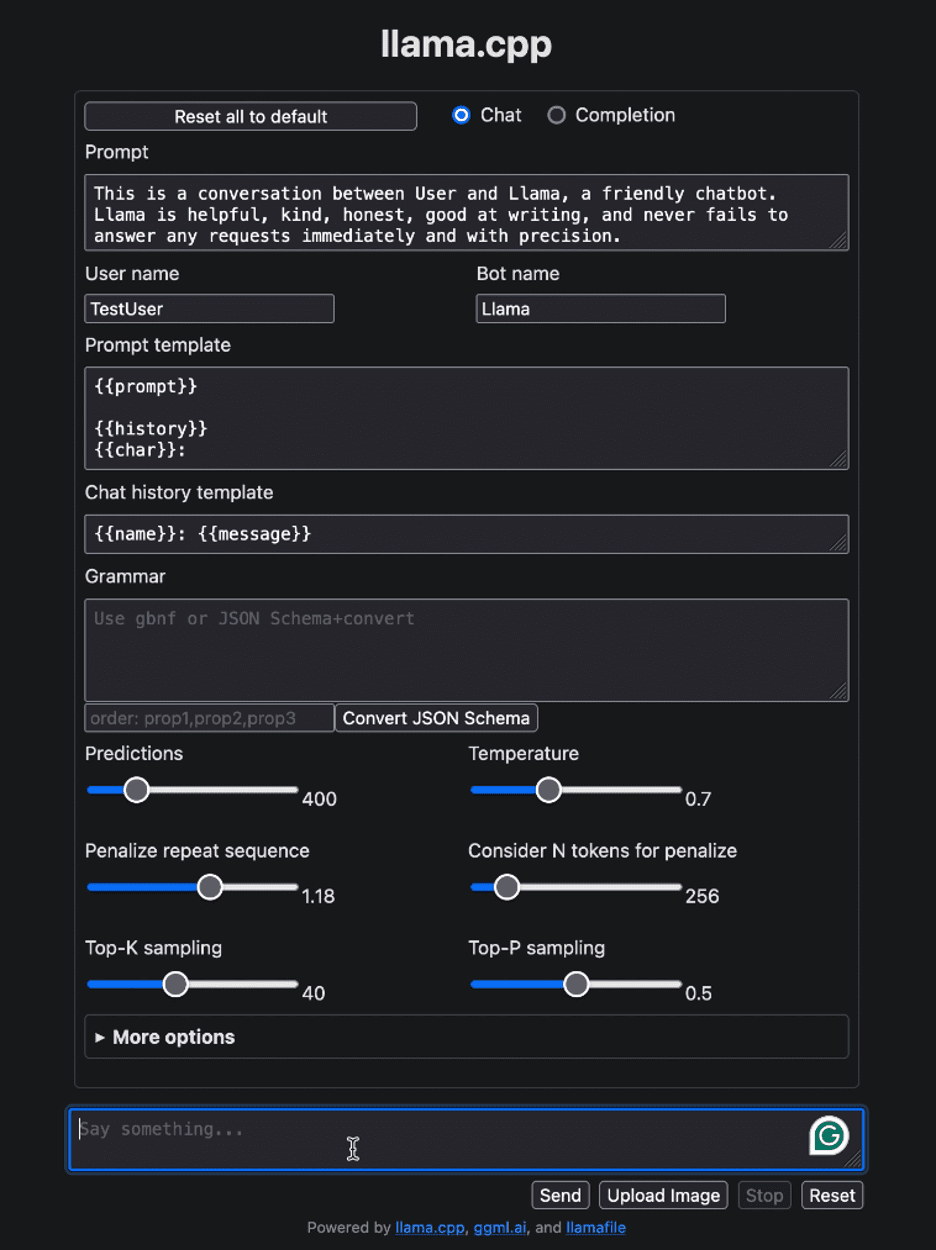

llava-v1.5-7b-q4.llamafile.exe -ngl 9999Nadat het lamabestand is uitgevoerd, zou het automatisch uw standaardbrowser moeten openen en de gebruikersinterface moeten weergeven zoals hieronder weergegeven. Als dit niet het geval is, opent u de browser en navigeert u naar http://localhost:8080 handmatig.

Afbeelding door auteur

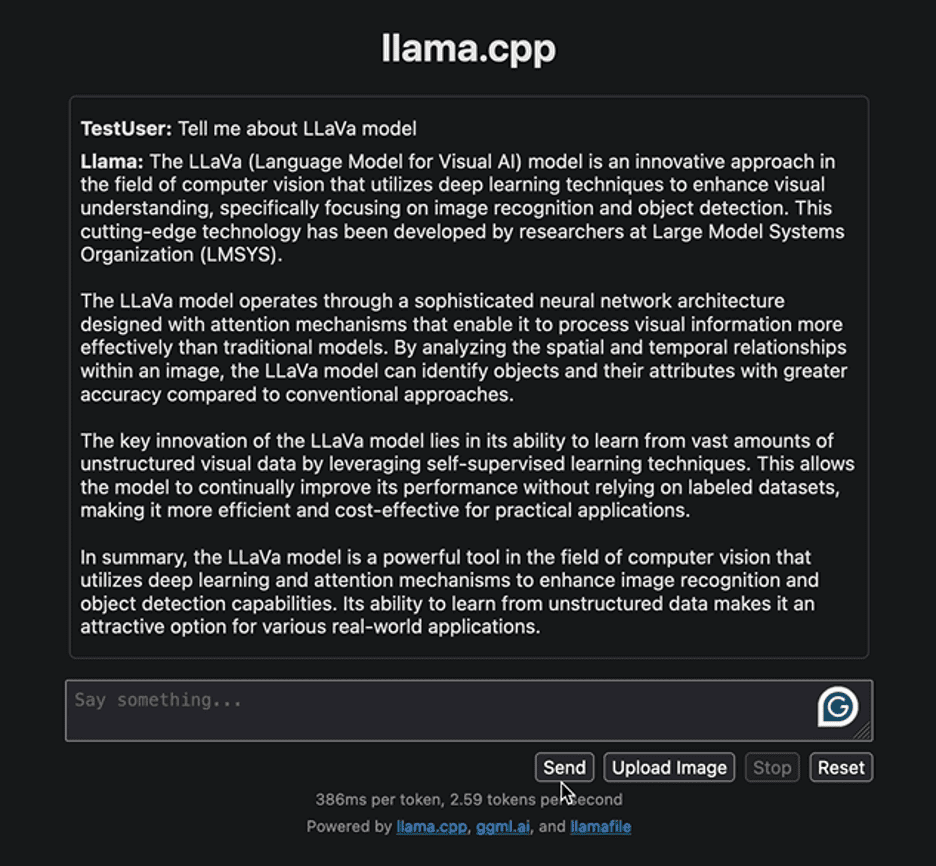

Laten we beginnen met de interactie met de interface met een eenvoudige vraag om wat informatie te geven over het LLaVa-model. Hieronder ziet u het antwoord dat door het model wordt gegenereerd:

Afbeelding door auteur

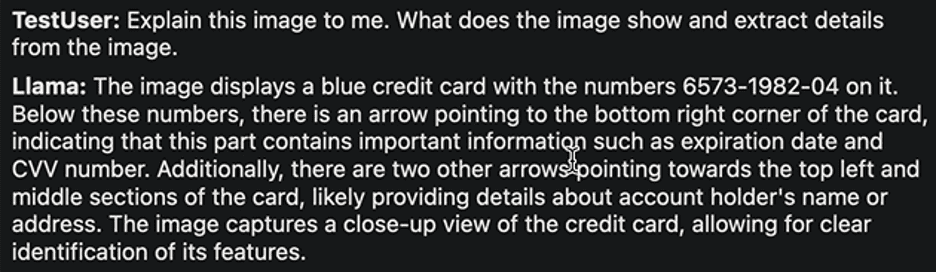

Het antwoord benadrukt de aanpak voor de ontwikkeling van het LLaVa-model en de toepassingen ervan. De gegenereerde respons was redelijk snel. Laten we proberen een andere taak uit te voeren. We zullen de volgende voorbeeldafbeelding van een bankkaart met details erop uploaden en hieruit de vereiste informatie halen.

Afbeelding door Ruby Thompson

Hier is het antwoord:

Afbeelding door auteur

Nogmaals, de reactie is redelijk. De auteurs van LLaVa beweren dat het bij verschillende taken topprestaties levert. Voel je vrij om verschillende taken te verkennen, hun successen en beperkingen te observeren, en zelf de uitstekende prestaties van LLaVa te ervaren.

Zodra uw interactie met de LLM is voltooid, kunt u het lamabestand afsluiten door terug te keren naar de terminal en op “Control – C” te drukken.

Het distribueren en uitvoeren van LLM's is nog nooit zo eenvoudig geweest. In deze tutorial hebben we uitgelegd hoe gemakkelijk je verschillende modellen kunt uitvoeren en ermee kunt experimenteren met slechts één uitvoerbaar lamabestand. Dit bespaart niet alleen tijd en middelen, maar vergroot ook de toegankelijkheid en het praktische nut van LLM's. We hopen dat je deze tutorial nuttig vond en horen graag je mening erover. Als u bovendien vragen of feedback heeft, aarzel dan niet om contact met ons op te nemen. Wij helpen u graag verder en waarderen uw inbreng.

Bedankt voor het lezen!

Kanwal Mehreen Kanwal is een machine learning-ingenieur en technisch schrijver met een diepgaande passie voor datawetenschap en de kruising van AI met geneeskunde. Ze is co-auteur van het e-boek “Maximizing Productivity with ChatGPT”. Als Google Generation Scholar 2022 voor APAC maakt ze zich sterk voor diversiteit en academische excellentie. Ze wordt ook erkend als Teradata Diversity in Tech Scholar, Mitacs Globalink Research Scholar en Harvard WeCode Scholar. Kanwal is een fervent pleitbezorger voor verandering en heeft FEMCodes opgericht om vrouwen in STEM-gebieden sterker te maken.

- Door SEO aangedreven content en PR-distributie. Word vandaag nog versterkt.

- PlatoData.Network Verticale generatieve AI. Versterk jezelf. Toegang hier.

- PlatoAiStream. Web3-intelligentie. Kennis versterkt. Toegang hier.

- PlatoESG. carbon, CleanTech, Energie, Milieu, Zonne, Afvalbeheer. Toegang hier.

- Plato Gezondheid. Intelligentie op het gebied van biotech en klinische proeven. Toegang hier.

- Bron: https://www.kdnuggets.com/distribute-and-run-llms-with-llamafile-in-5-simple-steps?utm_source=rss&utm_medium=rss&utm_campaign=distribute-and-run-llms-with-llamafile-in-5-simple-steps