Hoewel magazijnen gevuld met hectaren zoemende serverracks misschien niet de meest waarschijnlijke plaatsen lijken om opwindende nieuwe technologie te vinden, spelen datacenters een cruciale rol in de opkomende technologieën van morgen. Industrie 4.0, kunstmatige intelligentie (AI), virtual reality (VR), metaverse en Internet-of-Things (IoT) zijn allemaal veeleisende toepassingen die afhankelijk zijn van datacenters om krachtige computerbronnen te bieden.

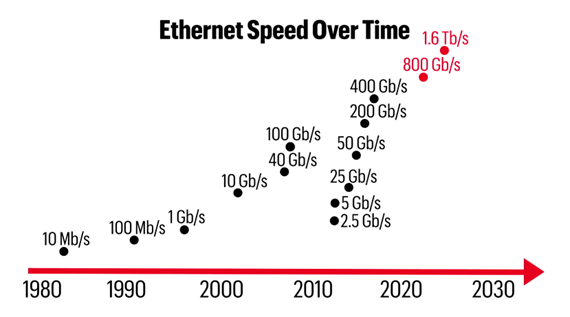

De afgelopen drie decennia is de moderne samenleving steeds meer afhankelijk geworden van datacenternetwerken. Ethernet-snelheden zijn drastisch toegenomen, waardoor grote hoeveelheden gegevens worden verzonden die de moderne wereld gebruikt om te communiceren en complexe beslissingen te nemen. Ondanks veel recente innovaties op het gebied van high-speed netwerken, moeten datasnelheden de exponentiële vraag bijbenen. Verdere innovatie in hogesnelheidsnetwerken zal snelheden van 800 gigabit per seconde (800G) en 1.6 terabit per seconde (1.6T) mogelijk maken, wat de deur opent naar een meer verbonden wereld.

Cloud computing, edge computing en intelligentiefabrieken

Een belangrijke trend in gegevens in de afgelopen jaren is het overdragen van gegevensverwerking aan externe servers. Hyperscale datacenters zijn wereldwijd opgedoken om cloud computing-netwerken te ondersteunen. Kleinere datacenters zijn nu gebruikelijker geworden voor tijdgevoelige toepassingen die gelokaliseerde edge computing gebruiken. Datacenters zijn verder geëvolueerd dan internet en zijn 'intelligentiefabrieken' geworden die krachtige rekenbronnen leveren voor veeleisende toepassingen.

In een internettoepassing maken individuele computers (clients) verbinding met een modem of router, die gegevens naar een server elders stuurt. Cloud- en edge computing werken op dezelfde manier: gebruikers kunnen inloggen op een server die krachtigere programma's host dan ze op hun eigen hardware kunnen uitvoeren. Het is gemakkelijk in te zien waarom zoveel opkomende technologieën baat zouden kunnen hebben bij het offloaden van verwerking naar externe servers.

Afb. 1: Autonome voertuigen zijn een goed voorbeeld van de voordelen van het overbrengen van gegevens naar edge computing.

Edge computing is interessant vanwege de impact op autonome voertuigen (AV's). Het veilig bedienen van een AV vereist duizenden dringende beslissingen. In plaats van een supercomputer in de auto te hosten om de sensorgegevens te verwerken of naar een datacenter op afstand te sturen, gebruiken AV's kleinere servers aan de 'edge', dichter bij de klant, waardoor de latentie drastisch wordt verminderd door lokale verwerking. Gegevens van andere voertuigen en weginfrastructuur maken deel uit van een ecosysteem van klanten die een centrale server voeden (deze technologie wordt "vehicle-to-everything" of V2X genoemd). De server kan de beste beslissingen nemen voor alle klanten, resulterend in kruispunten zonder stoplichten of botsingen.

Cloud computing-toepassingen zijn talrijk en divers, van het besturen van fabrieksrobots om de efficiëntie te maximaliseren, het hosten van duizenden VR-gebruikers in de metaverse, of het hosten van externe AI-programma's zoals ChatGPT en DALL-E. In de meeste van deze toepassingen is het direct verzenden en verwerken van gegevens de sleutel. Timing is essentieel, en latentievereisten onderscheiden cloud- en edge computing-applicaties. Netwerkvertraging in de metaverse kan gebruikers bewegingsziek maken, maar vertraging in een V2X-ecosysteem kan een dodelijke botsing veroorzaken.

De huidige 400G-datacenters kunnen streaming 4K-video en grote conferentiegesprekken ondersteunen, maar zijn nog niet snel genoeg voor veel opkomende toepassingen. Aangezien de enorme hoeveelheid gegevens wereldwijd toeneemt, is 800G misschien niet eens snel genoeg om het te verwerken. De netwerkindustrie kijkt al uit naar 1.6T.

Binnen in het datacenter

Om 1.6T onderzoek en ontwikkeling te begrijpen, moet men eerst datacenters begrijpen. Datacenters zijn georganiseerd rond een core-router, gevoed door een netwerk van switches die verbindingen bieden tussen elke rij en elk rack met servers. Elk serverrack is voorzien van een TOR-switch (top-of-rack) die gegevens doorstuurt en processen delegeert naar specifieke servers. Koper- of glasvezelkabels verbinden de backplane van elke server met optische modules die de elektro-optische conversie uitvoeren.

Afb. 2: Een typische datacenterstructuur met core-, spine- en leaf-switches die elke server met elkaar verbinden.

Transceivers op de fysieke laag volgen de normen van het Institute of Electrical and Electronics Engineers (IEEE) en het Optical Internetworking Forum (OIF). Deze twee groepen definiëren de interoperabiliteit van elke interface, inclusief de die-to-die-verbindingen, de chip-to-module- en chip-to-chip-interfaces en de backplane-kabels. De meest recente standaarden, op het moment van schrijven, zijn IEEE 802.3ck, die 100G-, 200G- en 400G-netwerken definieert met behulp van meerdere 100 Gb/s-banen, en OIF CEI-112G, een verzameling standaarden met betrekking tot de overdracht van gegevens op 112 Gb /s per baan.

Fig. 3: Silicium-, module- en backplane-aansluitingen schakelen gedefinieerd door OIF CEI- en IEEE-normen. Afbeelding met dank aan Alphawave IP.

Geschiedenis van datacentersnelheden

In 1983, toen de eerste IEEE 802.3-standaard werd uitgebracht, waren de Ethernet-snelheden slechts 10 Mb/s. In de afgelopen decennia zijn de ethernetsnelheden enorm gegroeid door continue innovatie, tot 400 Gb/s geaggregeerd door vier 56 GBaud (GBd) PAM4-lanes. De industrie verwacht de snelheid de komende jaren twee keer te verdubbelen om aan de vraag naar bandbreedte te voldoen. Hoe kunnen ontwikkelaars de Ethernet-snelheden de komende jaren twee keer verdubbelen? Is het fysiek mogelijk om zo snel zoveel data over een kanaal te sturen?

Afb. 4: Tijdlijn Ethernet-snelheden, van de eerste 10 Mb/s IEEE 802.3-standaard tot de aankomende 800G/1.6T IEEE 802.3df-standaard.

Nu begrijp je hoe belangrijk datacenters zijn voor opkomende technologieën en waarom de IEEE en OIF voortdurend werken aan het verhogen van de netwerksnelheden om aan de vraag te voldoen.

Neem voor meer informatie de 1.6T Ethernet in het datacenter cursus op Keysight University om exclusieve inzichten te krijgen van verschillende branche-experts uit het hele netwerkecosysteem.

Ben Miller

(alle berichten)

Ben Miller is productmarketeer bij Keysight Technologies met ervaring in de halfgeleider- en test- en meetindustrie. Hij trad in 2022 in dienst bij Keysight als Product Marketing Manager voor Digital Applications Software, waar hij softwareoplossingen promootte voor de oscilloscoop-, AWG- en BERT-producten van Keysight. Miller heeft een bachelor in elektrotechniek van de Universiteit van Texas in Austin.

- Door SEO aangedreven content en PR-distributie. Word vandaag nog versterkt.

- Platoblockchain. Web3 Metaverse Intelligentie. Kennis versterkt. Toegang hier.

- Bron: https://semiengineering.com/the-vital-role-of-1-6t-networking-in-emerging-technology/