Introductie

In het dynamische domein van de kunstmatige intelligentie heeft de samensmelting van technologie en creativiteit innovatieve hulpmiddelen voortgebracht die de grenzen van de menselijke verbeelding verleggen. Onder deze baanbrekende ontwikkelingen bevindt zich de geavanceerde wereld van encoders en decoders in generatieve AI. Deze evolutie brengt een revolutie teweeg in de manier waarop we kunst, taal en zelfs de werkelijkheid creëren, interpreteren en ermee omgaan.

leerdoelen

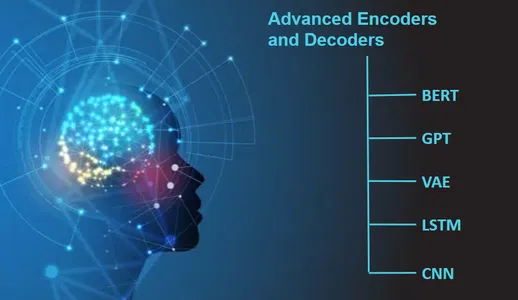

- Begrijp de rol van encoders en decoders in generatieve AI en hun betekenis in creatieve toepassingen.

- Leer meer over geavanceerde AI-modellen zoals BERT, GPT, VAE, LSTM en CNN en hun praktische gebruik bij het coderen en decoderen van gegevens.

- Ontdek real-time toepassingen van encoders en decoders in verschillende domeinen.

- Krijg inzicht in de ethische overwegingen en het verantwoorde gebruik van door AI gegenereerde inhoud.

- Herken creatief samenwerkings- en innovatiepotentieel door geavanceerde encoders en decoders toe te passen.

Dit artikel is gepubliceerd als onderdeel van het Data Science-blogathon.

Inhoudsopgave

De opkomst van encoders en decoders

In de steeds evoluerende wereld van de technologie zijn encoders en decoders de onbezongen helden geworden, die een creatieve draai geven aan kunstmatige intelligentie (AI) en generatieve AI. Ze lijken op de toverstokjes die AI gebruikt om zaken als kunst, tekst, geluiden en nog veel meer te begrijpen, interpreteren en creëren op manieren die ons allemaal verblinden.

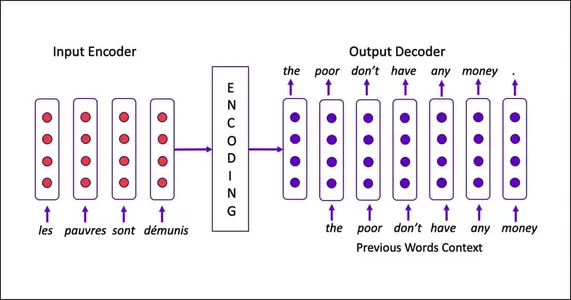

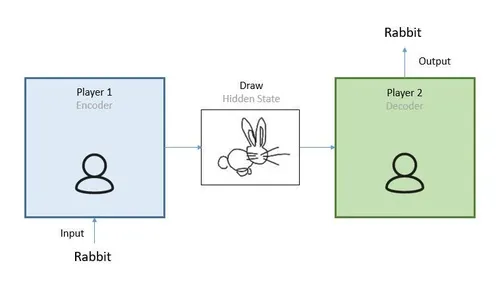

Dit is de deal: encoders zijn als de superoplettende detectives. Ze onderzoeken dingen nauwkeurig, of het nu afbeeldingen, zinnen of geluiden zijn. Ze vangen alle kleine details en patronen op, zoals een detective aanwijzingen samenvoegt.

Nu zijn decoders de creatieve tovenaars. Ze nemen wat Encoders hebben gevonden en transformeren het in iets nieuws en spannends. Het is als een tovenaar die aanwijzingen omzet in magische spreuken die kunst, gedichten of zelfs talen creëren. Deze combinatie van Encoders en Decoders opent de deur naar een wereld van creatieve mogelijkheden.

In eenvoudiger bewoordingen zijn encoders en decoders in AI net detectives en tovenaars die samenwerken. De detectives begrijpen de wereld, en de tovenaars zetten dat begrip om in verbazingwekkende creaties. Dit is hoe ze het spel op het gebied van kunst, taal en nog veel meer veranderen, waardoor technologie niet alleen innovatief maar ook briljant creatief wordt.

De bouwstenen: encoders en decoders

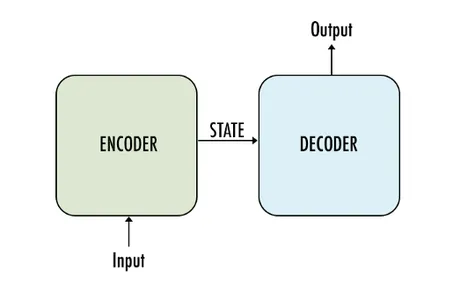

In het midden van generatieve AI zijn Encoders en Decoders, fundamentele componenten die gegevens van de ene vorm in de andere transformeren, waardoor het een kernpijler van creatieve AI wordt. Het begrijpen van hun rollen helpt bij het begrijpen van het immense creatieve potentieel dat ze ontsluiten.

- De encoder: Bij dit onderdeel draait alles om begrip. Het splitst invoergegevens (een afbeelding, tekst of geluid) op in de kerncomponenten, waarbij de essentie ervan wordt vastgelegd en ingewikkelde patronen worden geëxtraheerd. Stel je het voor als een aandachtige kunstenaar die scherp de details, kleuren en vormen van een scène observeert.

- De decoder: Hier gebeurt de magie. De Decoder vertaalt de geëxtraheerde informatie naar iets nieuws: een kunstwerk, een poëtisch vers of zelfs een geheel andere taal. Het creatieve genie transformeert de essentie van de Encoder in een meesterwerk.

Realtime codevoorbeeld

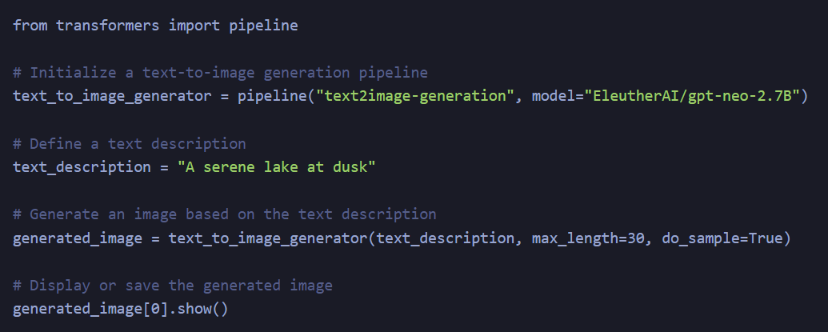

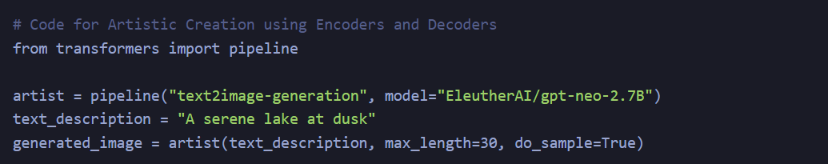

Laten we, om de concepten van encoders en decoders in generatieve AI beter te begrijpen, een realtime codevoorbeeld bekijken voor het genereren van tekst naar afbeeldingen. We gebruiken de Hugging Face Transformers-bibliotheek, die vooraf getrainde modellen biedt voor verschillende generatieve taken. In dit voorbeeld gebruiken we een encoder om een tekstbeschrijving te interpreteren en een decoder om een afbeelding te maken op basis van die beschrijving.

Uitleg

- We beginnen met het importeren van de pijplijnklasse uit de Hugging Face Transformers-bibliotheek. De pijplijnklasse vereenvoudigt het gebruik van vooraf getrainde modellen voor verschillende NLP- en generatieve taken.

- We initialiseren een text_to_image_generator pijplijn, waarbij we specificeren dat we tekst-naar-afbeelding-generatie willen uitvoeren. We specificeren ook het vooraf getrainde model dat moet worden gebruikt, in dit geval “EleutherAI/gpt-neo-2.7B.”

- Vervolgens definiëren we een text_description. Deze tekstbeschrijving zal de invoer zijn voor onze Encoder. In dit voorbeeld is het 'Een sereen meer in de schemering'.

- We gebruiken de text_to_image_generator om een afbeelding te genereren op basis van de opgegeven beschrijving. De parameter max_length bepaalt de maximale lengte van de beschrijving van de gegenereerde afbeelding, en do_sample=True maakt sampling mogelijk om diverse afbeeldingen te produceren.

- U kunt de gegenereerde afbeelding weergeven of opslaan. De functie show() geeft de afbeelding weer in het bovenstaande codefragment.

In dit codefragment verwerkt de Encoder de tekstbeschrijving terwijl de Decoder een afbeelding genereert op basis van de inhoud van de genoemde tekstbeschrijving. Dit laat ons zien hoe de encoders en decoders samenwerken om gegevens van de ene vorm (tekst) naar de andere (afbeelding) te transformeren, waardoor creatief potentieel wordt ontsloten.

Het voorbeeld vereenvoudigt het proces om het concept te illustreren, maar toepassingen in de echte wereld kunnen complexere modellen en gegevensvoorverwerking met zich meebrengen.

Geavanceerde mogelijkheden

De natuurlijke charme hiervan AI systemen ligt in hun geavanceerde mogelijkheden. Ze kunnen met verschillende gegevenstypen werken, waardoor ze veelzijdige hulpmiddelen zijn voor creatieve inspanningen. Laten we ons verdiepen in enkele opwindende toepassingen:

- Taal en vertaling: Geavanceerde encoders kunnen een zin in één taal nemen, de betekenis ervan begrijpen en de decoders vervolgens dezelfde zin in een andere taal laten produceren. Het is alsof je een meertalige dichter tot je beschikking hebt.

- Kunst en stijl: Encoders kunnen de essentie van verschillende kunststijlen ontcijferen, van klassieke Renaissance tot modern abstract, en vervolgens kunnen Decoders deze stijlen toepassen op nieuwe kunstwerken. Het is alsof een kunstenaar in elke gewenste stijl kan schilderen.

- Tekst naar afbeelding: Een Encoder kan een tekstuele beschrijving begrijpen, en een Decoder kan deze tot leven brengen door op basis van die beschrijving een afbeelding te creëren. Zie het als een AI-aangedreven illustrator.

- Stem en geluid: Deze geavanceerde componenten zijn niet beperkt tot het visuele of tekstuele domein. Encoders kunnen de emoties in een stem begrijpen, en decoders kunnen muziek of spraak genereren die die emoties overbrengt. Het lijkt op het hebben van een componist die gevoelens begrijpt.

Creatieve samenwerking mogelijk maken

Een van de meest opwindende aspecten van encoders en decoders in generatieve AI is hun potentieel om creatieve samenwerking te vergemakkelijken. Deze AI-systemen kunnen creatieve werken op verschillende media begrijpen, vertalen en transformeren, waardoor de kloof tussen kunstenaars, schrijvers, muzikanten en meer wordt overbrugd.

Denk aan het schilderij van een kunstenaar dat in poëzie is veranderd, of aan de melodie van een muzikant die in beeldende kunst is veranderd. Dit zijn geen vergezochte dromen meer, maar tastbare mogelijkheden met geavanceerde Encoders en Decoders. Samenwerkingen die voorheen onwaarschijnlijk leken, vinden nu een weg door de taal van AI.

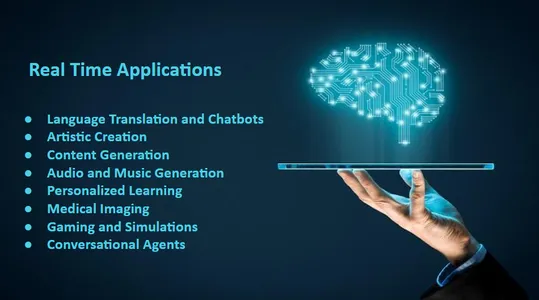

Realtime toepassing van encoders en decoders in generatieve AI

Realtime toepassingen van encoders en decoders in generatieve AI bieden een enorm potentieel in diverse domeinen. Deze geavanceerde AI-componenten beperken zich niet tot theoretische concepten, maar transformeren actief de manier waarop we met technologie omgaan. Laten we ons verdiepen in enkele praktijkvoorbeelden:

Taalvertaling en chatbots

Encoders decoderen en coderen de ene taal in de andere, waardoor vertaling in realtime mogelijk wordt. Deze technologie ondersteunt chatbots die naadloos in meerdere talen kunnen communiceren, waardoor wereldwijde communicatie en klantenservice worden vergemakkelijkt.

Deze code maakt gebruik van de Hugging Face Transformers-bibliotheek om een taalvertaalmodel te maken. Een encoder verwerkt de ingevoerde tekst (Engels) en een decoder genereert de vertaalde tekst (Frans) in realtime.

Artistieke creatie

Kunstenaars gebruiken Encoders om de essentie van een stijl of genre eruit te halen, en Decoders herscheppen kunstwerken in die stijl. Deze real-time transformatie maakt snelle kunstproductie in verschillende vormen mogelijk, van renaissanceschilderijen tot moderne abstracte stukken.

Deze code maakt gebruik van een tekst-naar-afbeelding-generatiemodel uit de Hugging Face Transformers-bibliotheek. Een encoder ontcijfert de tekstbeschrijving en een decoder genereert een afbeelding die overeenkomt met de beschrijving, waardoor artistieke creatie in realtime mogelijk wordt.

Inhoud genereren

Encoders analyseren tekstbeschrijvingen, en decoders brengen ze tot leven door middel van afbeeldingen en bieden praktische toepassingen in reclame, e-commerce en het genereren van inhoud. Transformeer de vastgoedaanbiedingen in meeslepende visuele ervaringen, en productbeschrijvingen kunnen bijbehorende beelden genereren.

Deze code maakt gebruik van een tekst-naar-tekstgeneratiemodel van Hugging Face Transformers. De encoder verwerkt een tekstbeschrijving en de decoder genereert meerdere alternatieve beschrijvingen voor het realtime genereren van inhoud.

Audio- en muziekgeneratie

Encoders vangen emotionele signalen op in de stem, en decoders genereren in realtime expressieve spraak of muziek. Dit vindt toepassingen in stemassistenten, het maken van audiocontent en zelfs ondersteuning in de geestelijke gezondheidszorg, waar AI geruststellende gesprekken kan bieden.

Deze code maakt gebruik van een tekst-naar-spraakmodel om tekst om te zetten in spraak (audio). Hoewel het genereren van real-time audio complexer is, demonstreert dit vereenvoudigde voorbeeld het gebruik van een encoder om de invoertekst te interpreteren en een decoder om audio te genereren.

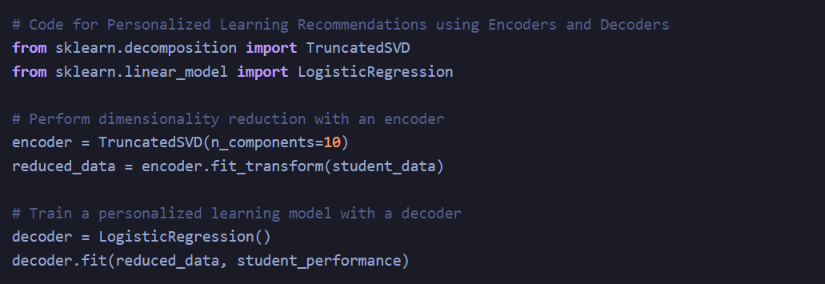

Gepersonaliseerd leren

In het onderwijs helpen Encoders en Decoders bij het creëren van leermateriaal op maat. Leerboeken kunnen worden omgezet in interactieve lessen met beeldmateriaal, en apps voor het leren van talen kunnen realtime hulp bij vertaling en uitspraak bieden.

Bij gepersonaliseerd leren kan een encoder de dimensionaliteit van leerlinggegevens verminderen, en een decoder, in dit geval een logistisch regressiemodel, kan de prestaties van leerlingen voorspellen op basis van de beperkte gegevens. Hoewel dit een vereenvoudigd voorbeeld is, zijn gepersonaliseerde leersystemen doorgaans veel complexer.

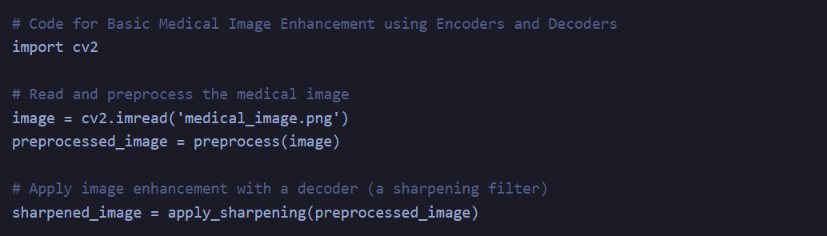

Medische beeldvorming

Encoders kunnen medische beelden analyseren, en decoders helpen beelden te verbeteren of realtime feedback te geven. Dit helpt artsen bij diagnostiek en chirurgische procedures en biedt snelle en nauwkeurige inzichten.

Deze code toont een eenvoudig voorbeeld van medische beeldverbetering, waarbij een encoder het beeld verwerkt en voorbewerkt, en een decoder (verscherpingsfilter) de beeldkwaliteit verbetert. Echte medische beeldvormingstoepassingen omvatten gespecialiseerde modellen en een grondige naleving van gezondheidszorgnormen.

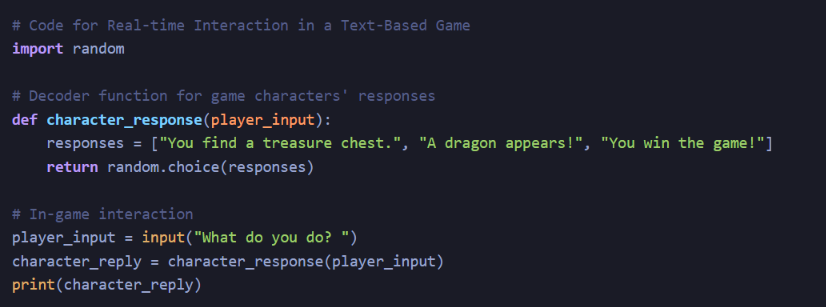

Gamen en simulaties

Realtime interactie met AI-gestuurde karakters is mogelijk dankzij Encoders en Decoders. Deze personages kunnen spelers aanpassen, reageren en realistisch betrekken bij videogames en trainingssimulaties.

Hoewel dit een zeer vereenvoudigd voorbeeld is, zijn bij realtime interacties met personages bij gaming en simulaties vaak complexe AI-systemen betrokken en worden encoders en decoders mogelijk niet rechtstreeks als zelfstandige componenten gebruikt.

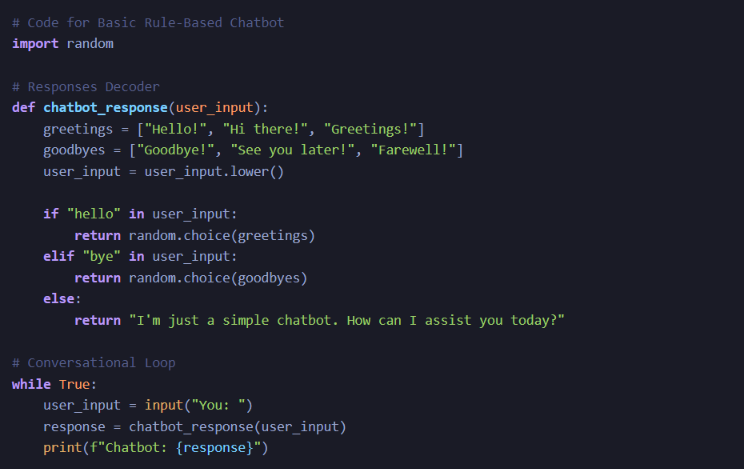

Gespreksagenten

Encoders helpen machines menselijke emoties en context te begrijpen, terwijl decoders hen in staat stellen empathisch te reageren. Dit is van onschatbare waarde in virtuele systemen voor geestelijke gezondheidszorg en AI-metgezellen voor ouderen.

Dit is een op regels gebaseerde chatbot, en hoewel het gaat om het coderen van gebruikersinvoer en het decoderen van reacties, gebruiken complexe gespreksagenten vaak geavanceerde modellen voor het begrijpen van natuurlijke taal voor empathie en contextbewuste antwoorden.

Deze realtime toepassingen benadrukken de transformerende impact van encoders en decoders op generatieve AI, waarbij ze de loutere theorie overstijgen om ons dagelijks leven op opmerkelijke manieren te verrijken.

Geavanceerde encoders en decoders verkennen

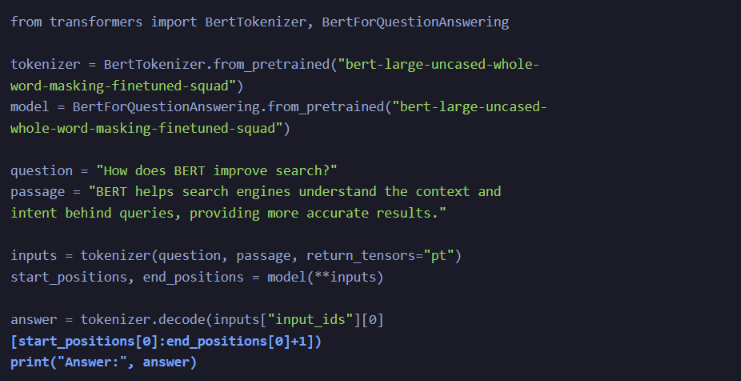

BERT (Bidirectionele Encoder Representaties van Transformers)

BERT is een encodermodel dat wordt gebruikt om taal te begrijpen. Het is bidirectioneel, wat betekent dat er rekening wordt gehouden met zowel de linker- als de rechtercontext van woorden in een zin. Deze diepgaande bidirectionele training stelt BERT in staat de context van woorden te begrijpen. Je kunt bijvoorbeeld achterhalen dat ‘bank’ verwijst naar een financiële instelling in de zin ‘Ik ging naar de bank’ en naar een rivieroever in ‘Ik zat bij de bank’. Het is getraind op een enorme hoeveelheid tekstgegevens en leert ontbrekende woorden in zinnen te voorspellen.

- Encoder: de encoder van BERT is bidirectioneel, wat betekent dat hij zowel de linker- als de rechtercontext van een woord in een zin in aanmerking neemt. Dankzij deze diepgaande bidirectionele training kan hij de context van woorden begrijpen, waardoor hij uitzonderlijk bedreven is in verschillende taken voor het begrijpen van natuurlijke taal.

- Decoder: Hoewel BERT in de eerste plaats een encoder is, wordt het vaak gecombineerd met andere decoders voor taken als het genereren van tekst en het vertalen van talen. Decoders voor op BERT gebaseerde modellen kunnen autoregressief zijn of, in sommige gevallen, een andere transformatordecoder.

Deze code maakt gebruik van de Hugging Face Transformers-bibliotheek om een vooraf getraind BERT-model te laden voor het coderen van tekst. Het tokeniseert de invoertekst, converteert deze naar invoer-ID's en geeft deze vervolgens door aan het BERT-model. De encoder_output bevat de gecodeerde representaties van de invoertekst.

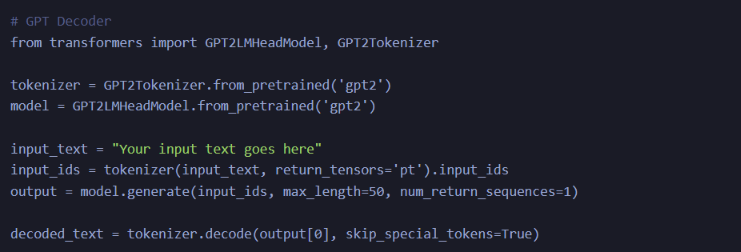

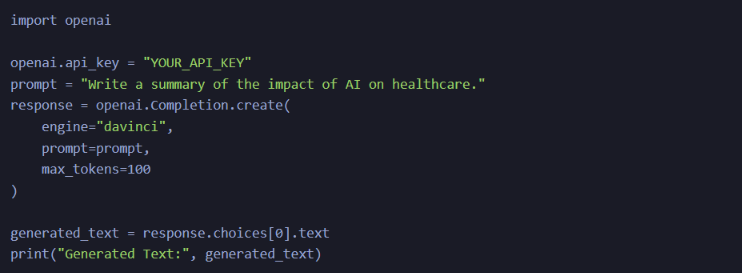

GPT (generatieve vooraf getrainde transformator)

GPT-modellen zijn decoders die mensachtige tekst genereren. Ze werken door het volgende woord in een reeks te voorspellen op basis van de context van voorgaande woorden. Als de voorgaande woorden bijvoorbeeld 'De lucht is' zijn, kan GPT voorspellen dat het volgende woord 'blauw' kan zijn. Ze zijn getraind in grote tekstcorpora om grammatica, stijl en context te leren.

- Encoder: GPT-modellen richten zich op het decoderaspect en genereren mensachtige tekst. De decoder van GPT kan echter ook als encoder dienen door het taalmodel om te keren, waardoor deze effectief informatie uit tekst kan halen.

- Decoder: Het decoderaspect van GPT maakt het fascinerend. Het genereert automatisch tekst en voorspelt het volgende woord op basis van de context van de voorgaande woorden. De output is een coherente en contextueel relevante tekst.

Deze code maakt gebruik van de transformersbibliotheek van Hugging Face om een vooraf getraind GPT-2-model te laden voor het genereren van tekst. Het neemt een invoertekst, tokeniseert deze en genereert automatisch tekst met behulp van het GPT-2-model.

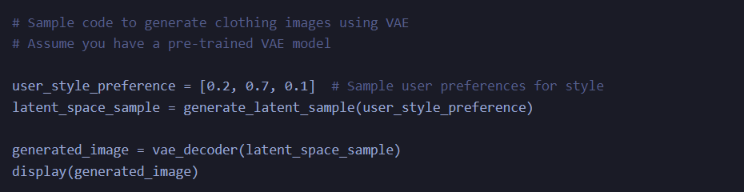

VAE (Variationele Autoencoder)

VAE's worden gebruikt voor het genereren van afbeeldingen en tekst. De encoder brengt invoergegevens in kaart in een continue latente ruimte, een lager-dimensionale representatie. Het kan bijvoorbeeld afbeeldingen van katten in kaart brengen in punten in deze ruimte. De decoder genereert vervolgens beelden van deze punten. Tijdens de training streven VAE's ernaar deze latente ruimte vloeiend en continu te maken om diverse en realistische beelden te genereren.

- encoder: VAE's worden vaak gebruikt bij het genereren van afbeeldingen en tekst. De encoder brengt invoergegevens in een continue latente ruimte in kaart, wat vooral handig is voor het genereren van diverse, realistische afbeeldingen en teksten.

- Decoder: De decoder brengt punten in de latente ruimte terug in de dataruimte. Het genereert afbeeldingen of tekst uit bemonsterde punten in de latente ruimte.

Deze code definieert een Variational Autoencoder (VAE) in TensorFlow/Keras. De encoder neemt een invoerafbeelding, vlakt deze af en wijst deze toe aan een latente ruimte met gemiddelde en logvariantie. De decoder neemt een punt uit de latente ruimte en reconstrueert het beeld.

LSTM (Lange Korte Termijn Geheugen)

LSTM's zijn terugkerende neurale netwerken die worden gebruikt voor sequentiële gegevens. Ze coderen opeenvolgende gegevens zoals zinnen door rekening te houden met de context van eerdere elementen in de reeks. Ze leren patronen in reeksen, waardoor ze geschikt zijn voor taken zoals natuurlijke taalverwerking. In autoencoders reduceren LSTM's reeksen tot lager-dimensionale representaties en decoderen ze.

- encoder: LSTM is een recurrent neuraal netwerk (RNN) dat veel wordt gebruikt voor verschillende sequentiële gegevenstaken, zoals natuurlijke taalverwerking. De LSTM-cel codeert sequentiële gegevens door rekening te houden met de context van eerdere elementen in de reeks.

- Decoder: Hoewel LSTM's vaker als encoders worden gebruikt, kunnen ze ook worden gecombineerd met een andere LSTM of volledig verbonden lagen om als decoder te functioneren voor het genereren van sequenties.

Met deze code wordt een eenvoudige LSTM-autoencoder opgezet. De encoder verwerkt reeksen en reduceert deze tot een lager-dimensionale representatie, terwijl de decoder reeksen reconstrueert op basis van de gecodeerde representatie.

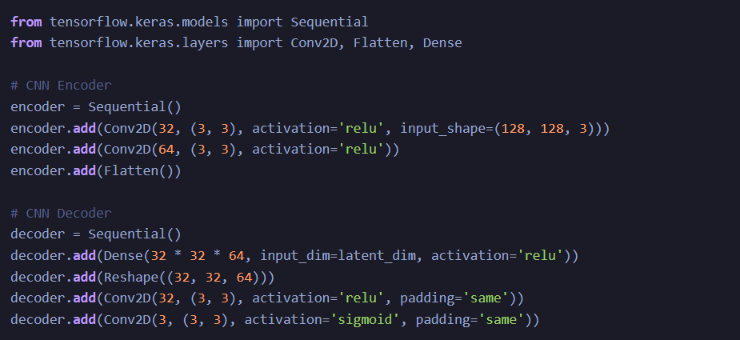

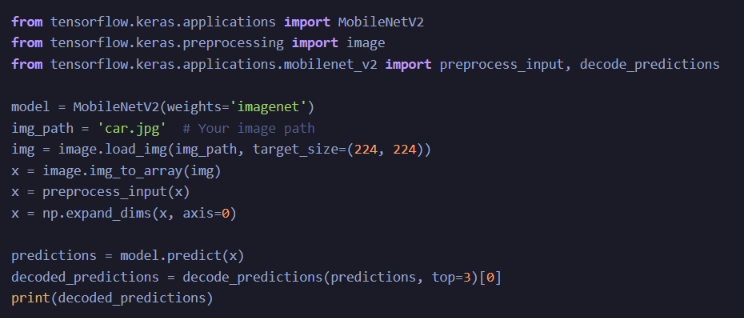

CNN (convolutioneel neuraal netwerk)

CNN's worden voornamelijk gebruikt voor beeldanalyse. Ze werken als encoders door afbeeldingen te analyseren via convolutionele lagen en kenmerken zoals randen, vormen en texturen vast te leggen. Deze functies kunnen naar een decoder, zoals een GAN, worden gestuurd om nieuwe afbeeldingen te genereren. CNN's zijn getraind om patronen en kenmerken in afbeeldingen te herkennen.

- encoder: CNN's worden voornamelijk gebruikt bij computervisietaken als encoders. Ze analyseren beelden door filters over de invoer te draaien, waardoor kenmerken op verschillende schalen worden vastgelegd. De geëxtraheerde functies kunnen naar een decoder worden gevoerd voor taken zoals het genereren van afbeeldingen.

- Decoder: Bij het genereren van afbeeldingen kunnen CNN's worden gevolgd door een decoder, zoals een generatieve adversarial network (GAN)-decoder, om afbeeldingen te synthetiseren op basis van aangeleerde kenmerken.

Deze geavanceerde encoder- en decodermodellen vormen de ruggengraat van veel generatieve AI-toepassingen. Hun flexibiliteit en aanpassingsvermogen hebben onderzoekers en ontwikkelaars in staat gesteld de grenzen te verleggen van wat haalbaar is op het gebied van natuurlijke taalverwerking, computervisie en diverse andere gebieden. Terwijl AI zich blijft ontwikkelen, zullen deze modellen voorop blijven lopen op het gebied van innovatie.

Deze modellen ondergaan een uitgebreide training op grote datasets om de nuances van hun respectieve taken te leren. Ze zijn afgestemd op het uitvoeren van specifieke functies en lopen voorop op het gebied van AI-innovatie.

Casestudies van geavanceerde encoders en decoders

BERT in zoekmachines

- Google gebruikt BERT om de zoekresultaten van zoekmachines te verbeteren. BERT helpt de context en bedoeling achter zoekopdrachten beter te begrijpen. Als u bijvoorbeeld zoekt naar ‘Reiziger Brazilië 2019 naar de VS heeft een visum nodig’, hebben traditionele zoekmachines zich mogelijk op het trefwoord ‘visum’ gericht. Maar met BERT begrijpt Google dat de gebruiker op zoek is naar informatie over een Braziliaan die naar de VS reist en zijn visumvereisten.

- Het op Google BERT gebaseerde zoekmodel kan worden gedemonstreerd met behulp van de Hugging Face Transformers-bibliotheek. Deze code laat zien hoe u een op BERT gebaseerd model kunt gebruiken om het begrip van zoekopdrachten te verbeteren:

Deze code gebruikt BERT om de zoekresultaten te verbeteren door de zoekopdrachten van gebruikers en de documentcontext te begrijpen, wat resulteert in nauwkeurigere antwoorden.

GPT-3 bij het genereren van inhoud

- Gebruik OpenAI's GPT-3 om content voor verschillende toepassingen te genereren. Het kan artikelen schrijven, vragen beantwoorden en zelfs gespreksagenten creëren. Bedrijven gebruiken GPT-3 om het genereren van inhoud, klantenondersteuning en virtuele assistenten te automatiseren.

- OpenAI's GPT-3 kan tekst genereren voor verschillende toepassingen. Hieronder ziet u een voorbeeld van het gebruik van de OpenAI GPT-3 API voor het genereren van inhoud:

Met GPT-3 kunt u mensachtige tekst genereren voor taken zoals het maken van inhoud of chatbots met behulp van de OpenAI API.

VAE's bij het genereren van afbeeldingen

- VAE's hebben toepassingen bij het genereren van afbeeldingen voor mode. Bedrijven zoals Stitch Fix gebruiken VAE's om gepersonaliseerde kledingaanbevelingen voor gebruikers te creëren. Door de stijlvoorkeuren van gebruikers te leren kennen, kunnen ze afbeeldingen genereren van kledingstukken die waarschijnlijk interessant zijn.

- Het gebruik van VAE's voor het genereren van afbeeldingen kan worden gedemonstreerd met code die nieuwe afbeeldingen genereert op basis van gebruikersvoorkeuren, vergelijkbaar met wat Stitch Fix doet.

Dit codefragment illustreert hoe Variational Autoencoders (VAE's) afbeeldingen kunnen maken op basis van gebruikersvoorkeuren, vergelijkbaar met hoe Stitch Fix kleding voorstelt op basis van stijlvoorkeuren.

LSTM's in spraakherkenning

- Spraakherkenningssystemen, zoals die worden gebruikt door Amazon's Alexa of Apple's Siri, maken vaak gebruik van LSTM's. Ze verwerken audiogegevens en zetten deze om in tekst. Deze modellen moeten rekening houden met de context van eerdere geluiden om spraak nauwkeurig te kunnen transcriberen.

- LSTM's worden vaak gebruikt bij spraakherkenning. Hieronder vindt u een vereenvoudigd voorbeeld van het gebruik van een op LSTM gebaseerd model voor spraakherkenning:

Deze code zet een op LSTM gebaseerd spraakherkenningsmodel, een fundamentele technologie voor stemassistenten en transcriptiediensten op.

CNN's in autonome voertuigen

- Autonome voertuigen vertrouwen op CNN's voor realtime beeldanalyse. Ze kunnen objecten zoals voetgangers, andere voertuigen en verkeersborden identificeren. Dit is essentieel voor het nemen van beslissingen in een fractie van een seconde tijdens het autorijden.

- Autonome voertuigen vertrouwen op CNN's voor objectdetectie. Hier is een vereenvoudigd voorbeeld van het gebruik van een vooraf getraind CNN-model voor objectdetectie:

In de context van autonome voertuigen kunnen CNN’s, net als MobileNetV2, objecten in beelden detecteren om zelfrijdende auto’s te helpen beslissingen te nemen onderweg.

Deze codefragmenten bieden een praktische demonstratie van hoe deze AI-technieken in verschillende praktijkscenario's kunnen worden toegepast. Houd er rekening mee dat implementaties in de echte wereld vaak complexer zijn en uitgebreide datasets gebruiken, maar deze voorbeelden bieden een vereenvoudigde weergave van hun toepassing.

Ethisch en verantwoord gebruik

Zoals bij elk krachtig hulpmiddel is het ethisch gebruik van geavanceerde encoders en decoders van het grootste belang. Het is van cruciaal belang ervoor te zorgen dat door AI gegenereerde inhoud het auteursrecht respecteert, de privacy handhaaft en geen schadelijk of aanstootgevend materiaal verspreidt. Bovendien zijn verantwoording en transparantie in het creatieve proces van cruciaal belang, vooral wanneer AI een belangrijke rol speelt.

Conclusie

De samensmelting van geavanceerde encoders en decoders in generatieve AI markeert een nieuw tijdperk van creativiteit, waarin de grenzen tussen verschillende vormen van kunst en communicatie vervagen. Of het nu gaat om het vertalen van talen, het opnieuw creëren van kunststijlen of het omzetten van tekst in afbeeldingen, deze AI-componenten zijn de sleutels tot het ontsluiten van innovatieve, collaboratieve en ethisch verantwoorde creativiteit. Met verantwoord gebruik kunnen ze de manier waarop we onze wereld waarnemen en uitdrukken opnieuw vormgeven.

Key Takeaways

- Encoders en decoders in generatieve AI transformeren de manier waarop we kunst, taal en data creëren, interpreteren en ermee omgaan.

- Deze AI-componenten spelen een essentiële rol bij het begrijpen en genereren van verschillende vormen van gegevens, waaronder tekst, afbeeldingen en audio.

- Realtime toepassingen van encoders en decoders omvatten taalvertaling, kunstgeneratie, contentcreatie, audiogeneratie, gepersonaliseerd leren, medische beeldvorming, gaming en conversatieagenten.

- Ethisch en verantwoord gebruik van door AI gegenereerde inhoud is van cruciaal belang, waarbij de nadruk ligt op privacy, transparantie en verantwoording.

Veelgestelde Vragen / FAQ

Q1. Wat zijn encoders en decoders in generatieve AI?

A. Encoders zijn AI-componenten die essentiële informatie uit gegevens begrijpen en extraheren, terwijl decoders creatieve resultaten genereren op basis van deze informatie.

Vraag 2. Hoe kunnen encoders en decoders het creatieve proces ten goede komen?

A. Ze maken realtime taalvertaling, kunstcreatie, het genereren van inhoud, het genereren van audio en muziek, gepersonaliseerd leren en meer mogelijk.

Q3. Wat zijn enkele realtime toepassingen van encoders en decoders in AI?

A. Deze toepassingen omvatten taalvertaling, het genereren van kunst, het creëren van inhoud, het genereren van audio, het verbeteren van medische beeldvorming, interactief gamen en empathische gespreksagenten.

Q4. Hoe bevorderen encoders en decoders creatieve samenwerking?

A. Ze overbruggen de kloof tussen verschillende creatieve media, waardoor kunstenaars, schrijvers en muzikanten kunnen samenwerken aan projecten waarbij meerdere vormen van expressie betrokken zijn.

De in dit artikel getoonde media zijn geen eigendom van Analytics Vidhya en worden naar goeddunken van de auteur gebruikt.

Verwant

- Door SEO aangedreven content en PR-distributie. Word vandaag nog versterkt.

- PlatoData.Network Verticale generatieve AI. Versterk jezelf. Toegang hier.

- PlatoAiStream. Web3-intelligentie. Kennis versterkt. Toegang hier.

- PlatoESG. carbon, CleanTech, Energie, Milieu, Zonne, Afvalbeheer. Toegang hier.

- Plato Gezondheid. Intelligentie op het gebied van biotech en klinische proeven. Toegang hier.

- Bron: https://www.analyticsvidhya.com/blog/2023/10/advanced-encoders-and-decoders-in-generative-ai/