Introductie

In het steeds evoluerende landschap van kunstmatige intelligentie viel de afgelopen jaren één naam prominent op: transformatoren. Deze krachtige modellen hebben de manier veranderd waarop we generatieve taken in AI benaderen, waardoor de grenzen zijn verlegd van wat machines kunnen creëren en voorstellen. In dit artikel zullen we dieper ingaan op de geavanceerde toepassingen van transformatoren in generatieve AI, waarbij we hun innerlijke werking, praktijkvoorbeelden en de baanbrekende impact die ze op het veld hebben gehad onderzoeken.

leerdoelen

- Begrijp de rol van transformatoren in generatieve AI en hun impact op verschillende creatieve domeinen.

- Leer hoe u transformatoren kunt gebruiken voor taken zoals het genereren van tekst, chatbots, het maken van inhoud en zelfs het genereren van afbeeldingen.

- Leer meer over geavanceerde transformatoren zoals MUSE-NET, DALL-E en meer.

- Ontdek de ethische overwegingen en uitdagingen die gepaard gaan met het gebruik van transformatoren in AI.

- Krijg inzicht in de nieuwste ontwikkelingen in op transformatoren gebaseerde modellen en hun toepassingen in de echte wereld.

Dit artikel is gepubliceerd als onderdeel van het Data Science-blogathon.

Inhoudsopgave

De opkomst van transformatoren

Voordat we dieper ingaan op de geavanceerde zaken, nemen we even de tijd om te begrijpen wat transformatoren zijn en hoe ze een drijvende kracht in AI zijn geworden.

Transformers zijn in de kern diepgaande leermodellen die zijn ontworpen voor de gegevens en die sequentieel zijn. Ze werden geïntroduceerd in een baanbrekend artikel met de titel ‘Attention Is All You Need’ van Vaswani et al. in 2017. Wat transformatoren onderscheidt is hun aandachtsmechanisme, waarmee ze de volledige context van een reeks kunnen vinden of herkennen bij het maken van voorspellingen.

Deze innovatie helpt bij de revolutie van natuurlijke taalverwerking (NLP) en generatieve taken. In plaats van te vertrouwen op vaste venstergroottes, zouden transformatoren zich dynamisch kunnen concentreren op verschillende delen van een reeks, waardoor ze perfect zijn in het vastleggen van context en relaties in gegevens.

Toepassingen bij het genereren van natuurlijke taal

Transformers hebben hun grootste bekendheid gevonden op het gebied van het genereren van natuurlijke taal. Laten we enkele van hun geavanceerde toepassingen op dit gebied verkennen.

1. GPT-3 en verder

Genative Pre-trained Transformers 3 (GPT-3) behoeft geen introductie. Met zijn 175 miljard parameters is het een van de grootste taalmodellen ooit gemaakt. GPT-3 kan mensachtige tekst genereren, vragen beantwoorden, essays schrijven en zelfs coderen in meerdere programmeertalen. Naast GPT-3 gaat het onderzoek door naar nog grotere modellen, die nog meer taalbegrip en generatiemogelijkheden beloven.

Codefragment: GPT-3 gebruiken voor het genereren van tekst

import openai # Set up your API key

api_key = "YOUR_API_KEY"

openai.api_key = api_key # Provide a prompt for text generation

prompt = "Translate the following English text to French: 'Hello, how are you?'" # Use GPT-3 to generate the translation

response = openai.Completion.create( engine="text-davinci-002", prompt=prompt, max_tokens=50

) # Print the generated translation

print(response.choices[0].text)Deze code stelt uw API-sleutel in voor OpenAI's GPT-3 en stuurt een prompt voor vertaling van Engels naar Frans. GPT-3 genereert de vertaling en het resultaat wordt afgedrukt.

2. Conversationele AI

Transformers hebben de volgende generatie chatbots en virtuele assistenten mogelijk gemaakt. Deze door AI aangedreven entiteiten kunnen mensachtige gesprekken voeren, de context begrijpen en nauwkeurige antwoorden geven. Ze zijn niet beperkt tot scriptinteracties; in plaats daarvan passen ze zich aan de input van gebruikers aan, waardoor ze van onschatbare waarde zijn voor klantenondersteuning, het ophalen van informatie en zelfs gezelschap.

Codefragment: een chatbot bouwen met Transformers

from transformers import AutoModelForCausalLM, AutoTokenizer, pipeline # Load the pre-trained GPT-3 model for chatbots

model_name = "gpt-3.5-turbo"

model = AutoModelForCausalLM.from_pretrained(model_name)

tokenizer = AutoTokenizer.from_pretrained(model_name) # Create a chatbot pipeline

chatbot = pipeline("text-davinci-002", model=model, tokenizer=tokenizer) # Start a conversation with the chatbot

conversation = chatbot("Hello, how can I assist you today?") # Display the chatbot's response

print(conversation[0]['message']['content'])Deze code laat zien hoe je een chatbot bouwt met behulp van transformatoren, met name het GPT-3.5 Turbo-model. Het stelt het model en de tokenizer in, creëert een chatbot-pijplijn, begint een gesprek met een begroeting en drukt het antwoord van de chatbot af.

3. Inhoudsgeneratie

Transformers worden veelvuldig gebruikt bij het genereren van inhoud. Of het nu gaat om het maken van marketingteksten, het schrijven van nieuwsartikelen of het componeren van poëzie, deze modellen hebben het vermogen aangetoond om samenhangende en contextueel relevante tekst te genereren, waardoor de last voor menselijke schrijvers wordt verminderd.

Codefragment: Marketingkopie genereren met Transformers

from transformers import pipeline # Create a text generation pipeline

text_generator = pipeline("text-generation", model="EleutherAI/gpt-neo-1.3B") # Provide a prompt for marketing copy

prompt = "Create marketing copy for a new smartphone that emphasizes its camera features." marketing_copy = text_generator(prompt, num_return_sequences=1) # Print the generated marketing copy

print(marketing_copy[0]['generated_text'])Deze code toont het genereren van inhoud met behulp van transformatoren. Het zet een pijplijn voor het genereren van tekst op met het GPT-Neo 1.3B-model, geeft een prompt voor het genereren van een marketingkopie over een smartphonecamera en drukt de gegenereerde marketingkopie af.

4. Beeldgeneratie

Met architecturen als DALL-E kunnen transformatoren afbeeldingen genereren uit tekstuele beschrijvingen. U kunt een surrealistisch concept beschrijven en DALL-E genereert een afbeelding die overeenkomt met uw beschrijving. Dit heeft gevolgen voor kunst, design en het genereren van visuele inhoud.

Codefragment: afbeeldingen genereren met DALL-E

# Example using OpenAI's DALL-E API (Please note: You would need valid API credentials)

import openai # Set up your API key

api_key = "YOUR_API_KEY_HERE" # Initialize the OpenAI API client

client = openai.Api(api_key) # Describe the image you want to generate

description = "A surreal landscape with floating houses in the clouds." # Generate the image using DALL-E

response = client.images.create(description=description) # Access the generated image URL

image_url = response.data.url # You can now download or display the image using the provided URL

print("Generated Image URL:", image_url)Deze code maakt gebruik van OpenAI's DALL-E om een afbeelding te genereren op basis van een tekstuele beschrijving. U geeft een beschrijving van de gewenste afbeelding en DALL-E maakt een afbeelding die daarbij past. De gegenereerde afbeelding wordt opgeslagen in een bestand.

5. Muziekcompositie

Transformers kunnen helpen bij het maken van muziek. Zoals MuseNet van OpenAI; ze kunnen nieuwe nummers in verschillende stijlen maken. Dit is opwindend voor muziek en kunst en biedt nieuwe ideeën en kansen voor creativiteit in de muziekwereld.

Codefragment: muziek componeren met MuseNet

# Example using OpenAI's MuseNet API (Please note: You would need valid API credentials)

import openai # Set up your API key

api_key = "YOUR_API_KEY_HERE" # Initialize the OpenAI API client

client = openai.Api(api_key) # Describe the type of music you want to generate

description = "Compose a classical piano piece in the style of Chopin." # Generate music using MuseNet

response = client.musenet.compose( prompt=description, temperature=0.7, max_tokens=500 # Adjust this for the desired length of the composition

) # Access the generated music

music_c = response.choices[0].text print("Generated Music Composition:")

print(music_c)Deze Python-code laat zien hoe u de MuseNet API van OpenAI kunt gebruiken om muziekcomposities te genereren. Het begint met het instellen van uw API-sleutel, beschrijft het type muziek dat u wilt maken (bijvoorbeeld klassieke piano in de stijl van Chopin), en roept vervolgens de API aan om de muziek te genereren. De resulterende compositie kan naar wens worden geopend en opgeslagen of afgespeeld.

Opmerking: vervang “YOUR_API_KEY_HERE” door uw daadwerkelijke OpenAI API-sleutel.

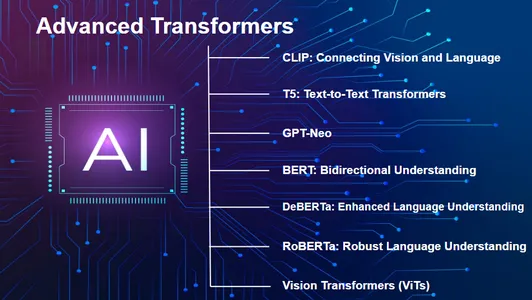

Onderzoek naar geavanceerde transformers: MUSE-NET, DALL-E en meer

In de snel veranderende wereld van AI lopen geavanceerde transformatoren voorop in spannende ontwikkelingen op het gebied van creatieve AI. Modellen als MUSE-NET en DALL-E gaan verder dan alleen het begrijpen van taal en worden nu creatief, komen met nieuwe ideeën en genereren verschillende soorten inhoud.

De creatieve kracht van MUSE-NET

MUSE-NET is een fantastisch voorbeeld van wat geavanceerde transformatoren kunnen doen. Dit model, gemaakt door OpenAI, gaat verder dan de gebruikelijke AI-mogelijkheden door zijn eigen muziek te maken. Het kan muziek in verschillende stijlen creëren, zoals klassiek of pop, en het doet het goed om het te laten klinken alsof het door een mens is gemaakt.

Hier is een codefragment om te illustreren hoe MUSE-NET een muzikale compositie kan genereren:

from muse_net import MuseNet # Initialize the MUSE-NET model

muse_net = MuseNet() compose_l = muse_net.compose(style="jazz", length=120)

compose_l.play()DALL-E: De artiestentransformator

DALL-E, gemaakt door OpenAI, is een baanbrekende creatie die transformatoren naar de wereld van beelden brengt. In tegenstelling tot reguliere taalmodellen kan DALL-E afbeeldingen maken van geschreven woorden. Het is alsof een echte kunstenaar tekst omzet in kleurrijke en creatieve afbeeldingen.

Hier is een voorbeeld van hoe DALL-E de tekst tot leven kan brengen:

from dalle_pytorch import DALLE # Initialize the DALL-E model

dall_e = DALLE() # Generate an image from a textual description

image = dall_e.generate_image("a surreal landscape with floating islands")

display(image)

CLIP: Visie en taal verbinden

CLIP by OpenAI combineert visie en taalbegrip. Het kan afbeeldingen en tekst samen begrijpen, waardoor taken als zero-shot-beeldclassificatie met tekstprompts mogelijk zijn.

import torch

import clip # Load the CLIP model

device = "cuda" if torch.cuda.is_available() else "cpu"

model, transform = clip.load("ViT-B/32", device) # Prepare image and text inputs

image = transform(Image.open("image.jpg")).unsqueeze(0).to(device)

text_inputs = torch.tensor(["a photo of a cat", "a picture of a dog"]).to(device) # Get image and text features

image_features = model.encode_image(image)

text_features = model.encode_text(text_inputs)CLIP combineert visie en taalbegrip. Deze code laadt het CLIP-model, bereidt afbeeldings- en tekstinvoer voor en codeert deze in featurevectoren, waardoor u taken kunt uitvoeren zoals zero-shot-afbeeldingsclassificatie met tekstprompts.

T5: Tekst-naar-tekst-transformatoren

T5-modellen behandelen alle NLP-taken als tekst-naar-tekst-problemen, waardoor de modelarchitectuur wordt vereenvoudigd en state-of-the-art prestaties worden bereikt voor verschillende taken.

from transformers import T5ForConditionalGeneration, T5Tokenizer # Load the T5 model and tokenizer

model = T5ForConditionalGeneration.from_pretrained("t5-small")

tokenizer = T5Tokenizer.from_pretrained("t5-small") # Prepare input text

input_text = "Translate English to French: 'Hello, how are you?'" # Tokenize and generate translation

input_ids = tokenizer.encode(input_text, return_tensors="pt")

translation = model.generate(input_ids)

output_text = tokenizer.decode(translation[0], skip_special_tokens=True) print("Translation:", output_text)Het model behandelt alle NLP-taken als tekst-naar-tekst-problemen. Deze code laadt een T5-model, tokeniseert een invoertekst en genereert een vertaling van Engels naar Frans.

GPT-Neo: terugschalen voor efficiëntie

GPT-Neo is een serie modellen ontwikkeld door EleutherAI. Deze modellen bieden vergelijkbare mogelijkheden als grootschalige taalmodellen zoals GPT-3, maar op kleinere schaal, waardoor ze toegankelijker worden voor verschillende toepassingen met behoud van indrukwekkende prestaties.

- De code voor GPT-Neo-modellen is vergelijkbaar met GPT-3, met verschillende modelnamen en maten.

BERT: Bidirectioneel begrip

BERT (Bidirectionele Encoder Representations from Transformers), ontwikkeld door Google, richt zich op het begrijpen van de context in taal. Het heeft nieuwe maatstaven gezet voor een breed scala aan taken voor het begrijpen van natuurlijke taal.

- BERT wordt vaak gebruikt voor pre-training en het verfijnen van NLP-taken, en het gebruik ervan hangt vaak af van de specifieke taak.

DeBERTa: Verbeterd taalbegrip

DeBERTa (Decoding-enhanced BERT with Disentangled Attention) verbetert BERT door ontwarde aandachtsmechanismen te introduceren, het taalbegrip te verbeteren en de parameters van het model te verminderen.

- DeBERTa volgt doorgaans dezelfde gebruikspatronen als BERT voor verschillende NLP-taken.

RoBERTa: Robuust taalbegrip

RoBERTa bouwt voort op de architectuur van BERT, maar verfijnt deze met een uitgebreider trainingsregime, waardoor state-of-the-art resultaten worden bereikt over een verscheidenheid aan natuurlijke taalverwerkingsbenchmarks.

- Het gebruik van RoBERTa is vergelijkbaar met BERT en DeBERTa voor NLP-taken, met enkele verfijningsvariaties.

Visie Transformers (ViTs)

Visietransformatoren zoals degene die u eerder in het artikel zag, hebben opmerkelijke vooruitgang geboekt op het gebied van computervisie. Ze passen de principes van transformatoren toe op op afbeeldingen gebaseerde taken, wat hun veelzijdigheid aantoont.

import torch

from transformers import ViTFeatureExtractor, ViTForImageClassification # Load a pre-trained Vision Transformer (ViT) model

model_name = "google/vit-base-patch16-224-in21k"

feature_extractor = ViTFeatureExtractor(model_name)

model = ViTForImageClassification.from_pretrained(model_name) # Load and preprocess a medical image

from PIL import Image image = Image.open("image.jpg")

inputs = feature_extractor(images=image, return_tensors="pt") # Get predictions from the model

outputs = model(**inputs)

logits_per_image = outputs.logitsDeze code laadt een ViT-model, verwerkt een afbeelding en haalt voorspellingen uit het model, waarmee het gebruik ervan in computervisie wordt gedemonstreerd.

Deze modellen, samen met MUSE-NET en DALL-E, tonen gezamenlijk de snelle vooruitgang in op transformatoren gebaseerde AI, die taal, visie, creativiteit en efficiëntie omvat. Naarmate het vakgebied vordert, kunnen we nog meer spannende ontwikkelingen en toepassingen verwachten.

Transformers: uitdagingen en ethische overwegingen

Nu we de opmerkelijke capaciteiten van transformatoren in generatieve AI omarmen, is het essentieel om rekening te houden met de uitdagingen en ethische zorgen die daarmee gepaard gaan. Hier zijn enkele kritische punten om over na te denken:

- Bevooroordeelde gegevens: Transformers kunnen oneerlijke dingen leren en herhalen uit hun trainingsgegevens, waardoor stereotypen erger worden. Dit oplossen is een must.

- Transformers goed gebruiken: Omdat transformatoren dingen kunnen creëren, moeten we ze zorgvuldig gebruiken om nepmateriaal en slechte informatie te stoppen.

- Privacyzorgen: Wanneer AI dingen maakt, kan dit de privacy schaden door mensen en geheimen te kopiëren.

- Moeilijk te begrijpen: Transformers kunnen een soort zwarte doos zijn: we weten niet altijd hoe ze beslissingen nemen, wat het moeilijk maakt om ze te vertrouwen.

- Wetten nodig: Regels maken voor AI, zoals transformatoren, is lastig maar noodzakelijk.

- Nep nieuws: Transformers kunnen leugens echt laten lijken, waardoor de waarheid in gevaar komt.

- Energieverbruik: Het trainen van grote transformatoren kost veel computerkracht, wat slecht kan zijn voor het milieu.

- Eerlijke toegang: Iedereen moet een eerlijke kans krijgen om AI-achtige transformatoren te gebruiken, waar ze zich ook bevinden.

- Mensen en AI: We zijn nog steeds aan het uitzoeken hoeveel macht AI zou moeten hebben vergeleken met mensen.

- Toekomstige impact: We moeten ons voorbereiden op de manier waarop AI, net als transformatoren, de samenleving, het geld en de cultuur zal veranderen. Het is een groot probleem.

Het navigeren door deze uitdagingen en het aanpakken van ethische overwegingen is absoluut noodzakelijk omdat transformatoren een cruciale rol blijven spelen bij het vormgeven van de toekomst van generatieve AI. Verantwoorde ontwikkeling en gebruik zijn van cruciaal belang om het potentieel van deze transformatieve technologieën te benutten en tegelijkertijd de maatschappelijke waarden en het welzijn te beschermen.

Voordelen van Transformers in Generatieve AI

- Verbeterde creativiteit: Transformers stellen AI in staat creatieve inhoud zoals muziek, kunst en tekst te genereren die voorheen niet mogelijk was.

- Contextueel begrip: Dankzij hun aandachtsmechanismen kunnen transformatoren de context en relaties beter begrijpen, wat resulteert in een betekenisvollere en coherentere output.

- Multimodale mogelijkheden: Transformers zoals DALL-E overbruggen de kloof tussen tekst en afbeeldingen en breiden het scala aan generatieve mogelijkheden uit.

- Efficiëntie en schaalbaarheid: Modellen als GPT-3 en GPT-Neo bieden indrukwekkende prestaties en zijn tegelijkertijd efficiënter met hulpbronnen dan hun voorgangers.

- Veelzijdige toepassingen: Transformers kunnen in verschillende domeinen worden toegepast, van het creëren van inhoud tot taalvertaling en meer.

Nadelen van Transformers in Generatieve AI

- Gegevensbias: Transformers kunnen vooroordelen in hun trainingsgegevens repliceren, wat leidt tot bevooroordeelde of oneerlijk gegenereerde inhoud.

- Etnische twijfels: De macht om tekst en afbeeldingen te creëren roept ethische problemen op, zoals deepfakes en de kans op verkeerde informatie.

- Privacyrisico's: Transformers kunnen inhoud genereren die inbreuk maakt op de persoonlijke privacy, zoals het genereren van valse tekst of afbeeldingen waarin personen worden nagebootst.

- Gebrek aan doorzichtigheid: Transformatoren produceren vaak resultaten die moeilijk uit te leggen zijn, waardoor het moeilijk te begrijpen is hoe ze tot een bepaalde output zijn gekomen.

- Milieu-impact: Het trainen van grote transformatoren vereist aanzienlijke rekenkracht, wat bijdraagt aan het energieverbruik en de milieuproblemen.

Conclusie

Transformers hebben een nieuw tijdperk van creativiteit en vaardigheden voor AI gebracht. Ze kunnen meer dan alleen sms'en; ze houden ook van muziek en kunst. Maar we moeten voorzichtig zijn. Grote mogendheden hebben een grote verantwoordelijkheid nodig. Terwijl we onderzoeken wat transformatoren kunnen doen, moeten we nadenken over wat goed is. We moeten ervoor zorgen dat ze de samenleving helpen en haar geen schade berokkenen. De toekomst van AI kan geweldig zijn, maar we moeten er allemaal voor zorgen dat het voor iedereen goed is.

Key Takeaways

- Transformers zijn revolutionaire modellen in AI, bekend om hun sequentiële gegevensverwerking en aandachtsmechanismen.

- Ze blinken uit in het genereren van natuurlijke taal, het aandrijven van chatbots, het genereren van inhoud en zelfs het genereren van code met modellen als GPT-3.

- Transformers als MUSE-NET en DALL-E breiden hun creatieve mogelijkheden uit naar muziekcompositie en beeldgeneratie.

- Ethische overwegingen, zoals datavooroordelen, privacykwesties en verantwoord gebruik, zijn van cruciaal belang bij het werken met Transformers.

- Transformers lopen voorop op het gebied van AI-technologie, met toepassingen die taalbegrip, creativiteit en efficiëntie omvatten.

Veelgestelde Vragen / FAQ

Ant. Transformers onderscheiden zich door hun aandachtsmechanismen, waardoor ze de volledige context van een reeks in overweging kunnen nemen, waardoor ze uitzonderlijk zijn in het vastleggen van context en relaties in gegevens.

Ant. U kunt de GPT-3 API van OpenAI gebruiken om tekst te genereren door een prompt te geven en een gegenereerd antwoord te ontvangen.

Ant. Transformers zoals MUSE-NET kunnen muziek componeren op basis van beschrijvingen, en DALL-E kan afbeeldingen genereren op basis van tekstprompts, waardoor creatieve mogelijkheden ontstaan.

Ant. Bij het gebruik van transformatoren in generatieve AI moeten we ons bewust zijn van datavooroordelen, het genereren van ethische inhoud, zorgen over de privacy en het verantwoorde gebruik van door AI gegenereerde inhoud om misbruik en desinformatie te voorkomen.

De in dit artikel getoonde media zijn geen eigendom van Analytics Vidhya en worden naar goeddunken van de auteur gebruikt.

Verwant

- Door SEO aangedreven content en PR-distributie. Word vandaag nog versterkt.

- PlatoData.Network Verticale generatieve AI. Versterk jezelf. Toegang hier.

- PlatoAiStream. Web3-intelligentie. Kennis versterkt. Toegang hier.

- PlatoESG. carbon, CleanTech, Energie, Milieu, Zonne, Afvalbeheer. Toegang hier.

- Plato Gezondheid. Intelligentie op het gebied van biotech en klinische proeven. Toegang hier.

- Bron: https://www.analyticsvidhya.com/blog/2023/10/unlocking-creativity-with-advanced-transformers-in-generative-ai/