Afbeelding door auteur

Large Language Models (LLM's) zijn een nieuw type kunstmatige intelligentie dat wordt getraind op enorme hoeveelheden tekstgegevens. Hun belangrijkste vermogen is om mensachtige tekst te genereren als reactie op een breed scala aan aanwijzingen en verzoeken.

Ik wed dat je al enige ervaring hebt gehad met populaire LLM-oplossingen zoals ChatGPT of Google Gemini.

Maar heb je je ooit afgevraagd hoe deze krachtige modellen zulke bliksemsnelle reacties leveren?

Het antwoord ligt in een gespecialiseerd vakgebied genaamd LLMOps.

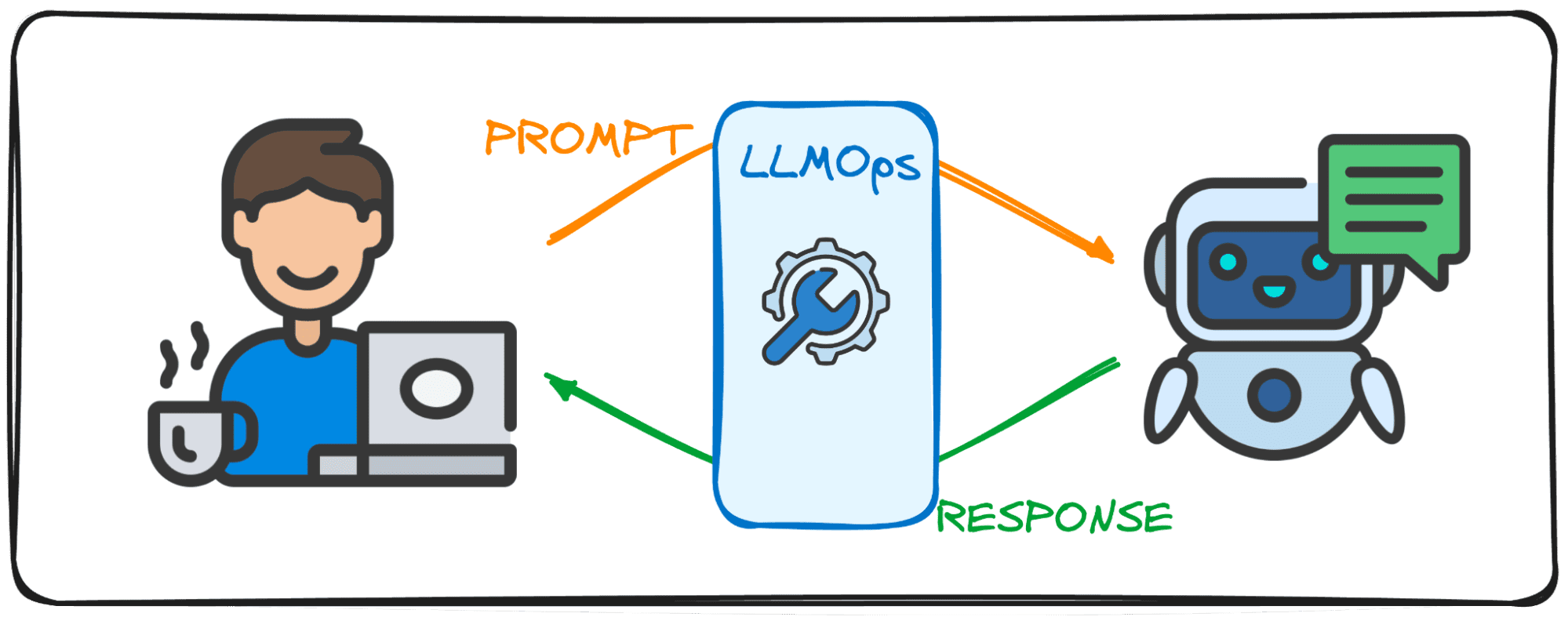

Laten we, voordat we erin duiken, proberen het belang van dit vakgebied te visualiseren.

Stel je voor dat je een gesprek voert met een vriend. Het normale wat je zou verwachten is dat wanneer je een vraag stelt, ze je meteen een antwoord geven en dat de dialoog moeiteloos verloopt.

Rechts?

Deze soepele uitwisseling is wat gebruikers ook verwachten bij interactie met Large Language Models (LLM's). Stel je voor dat je met ChatGPT chat en een paar minuten moet wachten elke keer dat we een prompt sturen, niemand zou het helemaal gebruiken, ik zou het tenminste niet zeker weten.

Dit is de reden waarom LLM's ernaar streven deze gespreksstroom en effectiviteit te bereiken in hun digitale oplossingen met het LLMOps-veld. Deze gids is bedoeld als uw metgezel bij uw eerste stappen in dit gloednieuwe domein.

LLMOps, een afkorting van Large Language Model Operations, is de magie achter de schermen die ervoor zorgt dat LLM's efficiënt en betrouwbaar functioneren. Het vertegenwoordigt een vooruitgang ten opzichte van de bekende MLOps, specifiek ontworpen om de unieke uitdagingen van LLM's aan te pakken.

Terwijl MLOps zich richt op het beheren van de levenscyclus van algemene machine learning-modellen, houdt LLMOps zich specifiek bezig met de LLM-specifieke vereisten.

Wanneer modellen van entiteiten als OpenAI of Anthropic via webinterfaces of API worden gebruikt, werken LLMOps achter de schermen, waardoor deze modellen toegankelijk worden als services. Bij het inzetten van een model voor een gespecialiseerde toepassing vertrouwt LLMOps echter op ons.

Zie het dus als een moderator die zorgt voor het verloop van een debat. Net zoals de moderator ervoor zorgt dat het gesprek soepel verloopt en aansluit bij het onderwerp van het debat, er altijd voor zorgt dat er geen slechte woorden zijn en nepnieuws probeert te vermijden, zorgt LLMOps ervoor dat LLM's topprestaties leveren, naadloze gebruikerservaringen leveren en de veiligheid van de gebruikers controleren. uitgang.

Het maken van applicaties met Large Language Models (LLM's) brengt uitdagingen met zich mee die verschillen van die bij conventionele machine learning. Om hierin te navigeren zijn innovatieve managementtools en -methodologieën ontwikkeld, die aanleiding hebben gegeven tot het LLMOps-framework.

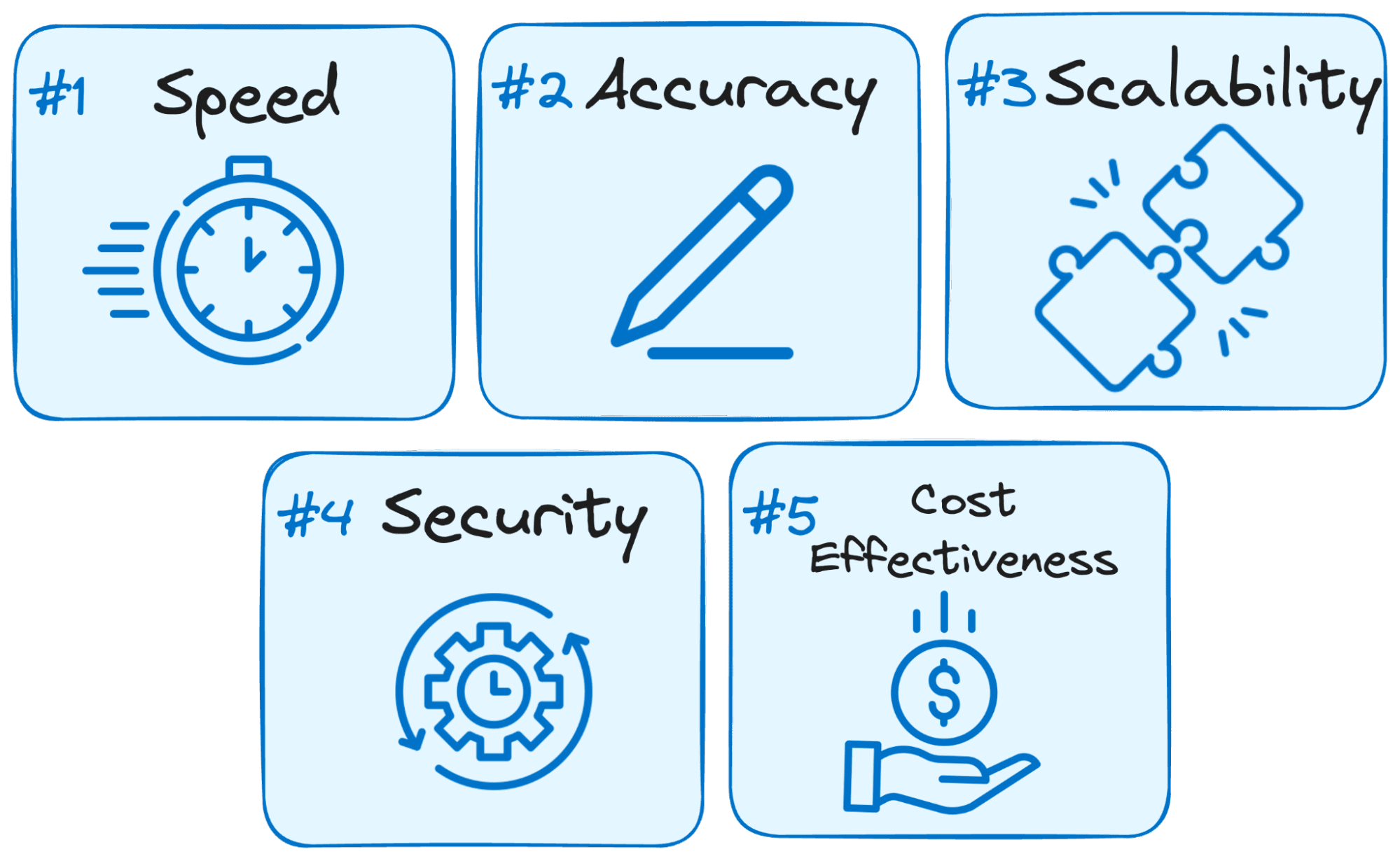

Dit is de reden waarom LLMOps cruciaal is voor het succes van elke door LLM aangedreven applicatie:

Afbeelding door auteur

- Snelheid is de sleutel: Gebruikers verwachten onmiddellijke reacties bij interactie met LLM's. LLMOps optimaliseert het proces om de latentie te minimaliseren, zodat u binnen een redelijk tijdsbestek antwoorden krijgt.

- Nauwkeurigheid is belangrijk: LLMOps implementeert verschillende controles en controles om de nauwkeurigheid en relevantie van de antwoorden van de LLM te garanderen.

- Schaalbaarheid voor groei: Naarmate uw LLM-applicatie meer grip krijgt, helpt LLMOps u bronnen efficiënt te schalen om de toenemende gebruikersbelasting aan te kunnen.

- Beveiliging staat voorop: LLMOps waarborgt de integriteit van het LLM-systeem en beschermt gevoelige gegevens door robuuste beveiligingsmaatregelen af te dwingen.

- Kosten efficiëntie: Het exploiteren van LLM's kan financieel veeleisend zijn vanwege hun aanzienlijke behoefte aan middelen. LLMOps brengt economische methoden in het spel om het gebruik van hulpbronnen efficiënt te maximaliseren en ervoor te zorgen dat topprestaties niet worden opgeofferd.

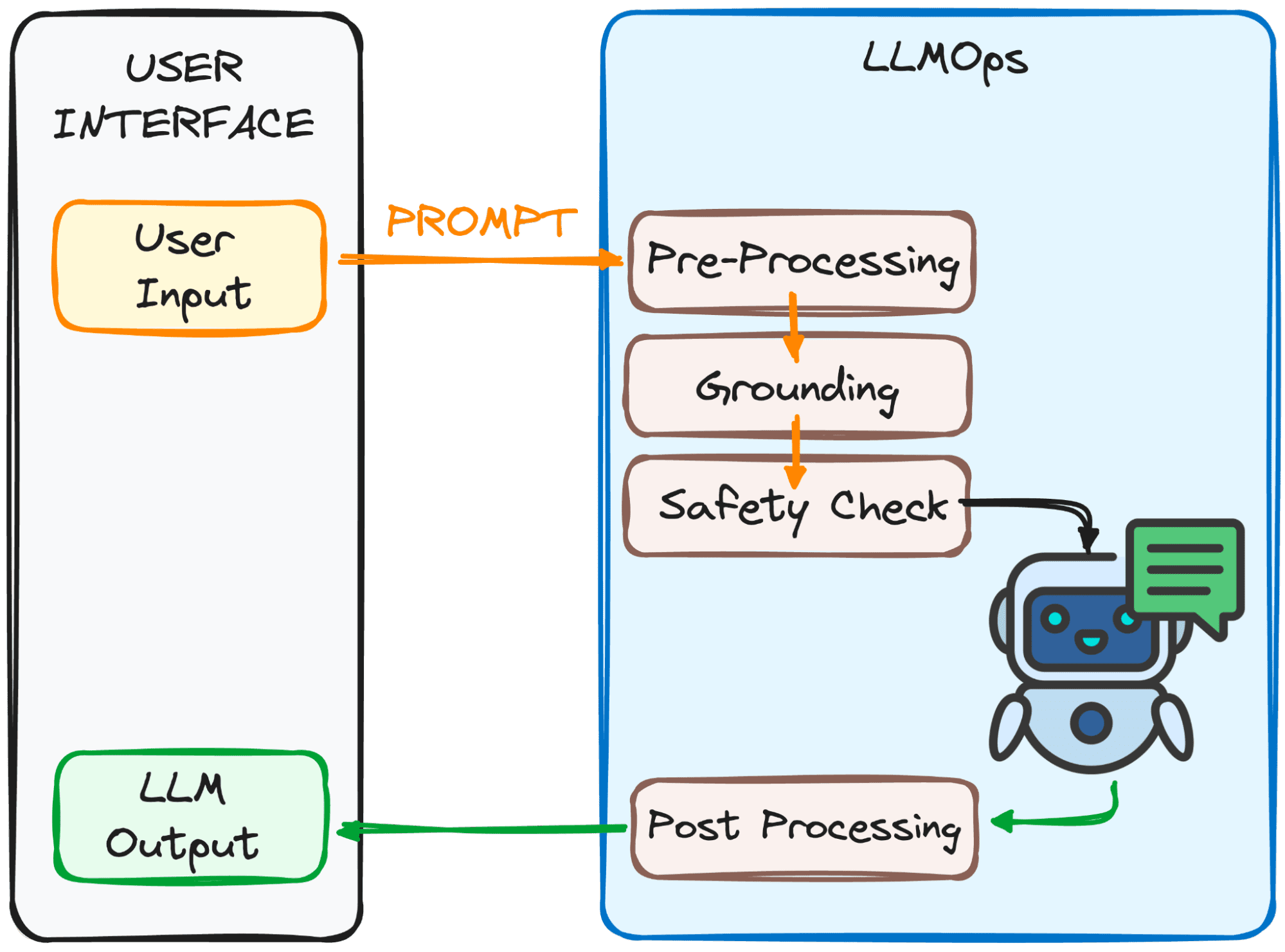

LLMOps zorgt ervoor dat uw prompt klaar is voor de LLM en dat het antwoord zo snel mogelijk bij u terugkomt. Dit is echter helemaal niet eenvoudig.

Dit proces omvat verschillende stappen, voornamelijk vier, die u kunt zien in de onderstaande afbeelding.

Afbeelding door auteur

Het doel van deze stappen?

Om de vraag duidelijk en begrijpelijk te maken voor het model.

Hier volgt een overzicht van deze stappen:

1. Voorbewerking

De prompt doorloopt een eerste verwerkingsstap. Eerst wordt het opgesplitst in kleinere stukken (tokens). Vervolgens worden eventuele typefouten of rare tekens opgeschoond en wordt de tekst consistent opgemaakt.

Ten slotte worden de tokens ingebed in numerieke gegevens, zodat de LLM het begrijpt.

2. Aarding

Voordat het model onze prompt verwerkt, moeten we ervoor zorgen dat het model het grotere geheel begrijpt. Dit kan inhouden dat u verwijst naar eerdere gesprekken die u met de LLM hebt gehad of dat u externe informatie gebruikt.

Bovendien identificeert het systeem belangrijke zaken die in de prompt worden vermeld (zoals namen of plaatsen) om het antwoord nog relevanter te maken.

3. Veiligheidscontrole:

Net zoals er veiligheidsregels op de set zijn, zorgt LLMOps ervoor dat de prompt op de juiste manier wordt gebruikt. Het systeem controleert op zaken als gevoelige informatie of mogelijk aanstootgevende inhoud.

Pas nadat deze controles zijn doorstaan, is de prompt klaar voor de hoofdact: de LLM!

Nu hebben we onze prompt klaar om te worden verwerkt door de LLM. De output ervan moet echter ook worden geanalyseerd en verwerkt. Dus voordat je het ziet, worden er nog een paar aanpassingen uitgevoerd in de vierde stap:

3. Nabewerking

Weet je nog in welke code de prompt is omgezet? Het antwoord moet worden terugvertaald naar voor mensen leesbare tekst. Daarna polijst het systeem de respons op grammatica, stijl en duidelijkheid.

Al deze stappen verlopen naadloos dankzij LLMOps, het onzichtbare bemanningslid dat zorgt voor een soepele LLM-ervaring.

Indrukwekkend, toch?

Hier zijn enkele van de essentiële bouwstenen van een goed ontworpen LLMOps-opstelling:

- Het kiezen van de juiste LLM: Met een breed scala aan LLM-modellen beschikbaar, helpt LLMOps u het model te selecteren dat het beste aansluit bij uw specifieke behoeften en middelen.

- Fine-tuning voor specificiteit: Met LLMOps kunt u bestaande modellen verfijnen of uw eigen modellen trainen en ze aanpassen aan uw unieke gebruiksscenario.

- Snelle techniek: LLMOps voorziet u van technieken om effectieve aanwijzingen te maken die de LLM naar het gewenste resultaat leiden.

- Implementatie en monitoring: LLMOps stroomlijnt het implementatieproces en bewaakt voortdurend de prestaties van de LLM, waardoor optimale functionaliteit wordt gegarandeerd.

- Beveiligingsmaatregelen: LLMOPS geeft prioriteit aan gegevensbeveiliging door robuuste maatregelen te implementeren om gevoelige informatie te beschermen.

Terwijl de LLM-technologie zich blijft ontwikkelen, zullen LLMops een cruciale rol spelen in de komende technologische ontwikkelingen. Het grootste deel van het succes van de nieuwste populaire oplossingen zoals ChatGPT of Google Gemini is hun vermogen om niet alleen alle verzoeken te beantwoorden, maar ook een goede gebruikerservaring te bieden.

Dit is de reden waarom LLMOps, door te zorgen voor een efficiënte, betrouwbare en veilige werking, de weg zal vrijmaken voor nog meer innovatieve en transformatieve LLM-toepassingen in verschillende industrieën die bij nog meer mensen zullen aankomen.

Met een goed begrip van LLMOps bent u goed uitgerust om te profiteren van de kracht van deze LLM's en baanbrekende toepassingen te creëren.

Joseph Ferrer is een analyse-ingenieur uit Barcelona. Hij studeerde af in natuurkunde en werkt momenteel op het gebied van datawetenschap toegepast op menselijke mobiliteit. Hij is een parttime contentmaker die zich richt op datawetenschap en -technologie. Josep schrijft over alles wat met AI te maken heeft, en behandelt de toepassing van de aanhoudende explosie in het veld.

- Door SEO aangedreven content en PR-distributie. Word vandaag nog versterkt.

- PlatoData.Network Verticale generatieve AI. Versterk jezelf. Toegang hier.

- PlatoAiStream. Web3-intelligentie. Kennis versterkt. Toegang hier.

- PlatoESG. carbon, CleanTech, Energie, Milieu, Zonne, Afvalbeheer. Toegang hier.

- Plato Gezondheid. Intelligentie op het gebied van biotech en klinische proeven. Toegang hier.

- Bron: https://www.kdnuggets.com/getting-started-with-llmops-the-secret-sauce-behind-seamless-interactions?utm_source=rss&utm_medium=rss&utm_campaign=getting-started-with-llmops-the-secret-sauce-behind-seamless-interactions