Het laatste CCC-panel van AAAS 2023, “Een rijke breedte behouden voor kunstmatige intelligentie”, werd gehouden op zondag 5 maart, de laatste dag van de conferentie. Dit panel bestond uit David Danks (University of California – San Diego), Bo Li (University of Illinois – Urbana-Champaign) en Melanie Mitchell (Santa Fe Institute) en werd gemodereerd door Maria Gini (University of Minnesota).

Dr. Bo Li begon het panel met het bespreken van het belang van betrouwbare machine learning (ML) en de manieren waarop we ervoor kunnen zorgen dat ML veilig, rechtvaardig en inclusief is. Machine learning is alomtegenwoordig, zei Li, en wordt tegenwoordig gebruikt in een groot aantal dagelijkse activiteiten, zoals navigeren naar het werk, een "snel antwoord" sturen via e-mail of zelfs je telefoon openen met gezichtsherkenning. Veel van deze technologieën die afhankelijk zijn van machine learning zijn echter vatbaar voor aanvallen. Deze technologieën zijn ook niet onfeilbaar en het is bekend dat ze fouten maken, zoals gezichtsherkenning die leidt tot valse arrestaties.

Dr. Li wees vervolgens op een artikel in PCMag, dat voorspelde dat het jaar 2023 een beveiligingsnachtmerrie zal worden vanwege toenemende ransomware-aanvallen en tegenstrijdige kunstmatige intelligentieprogramma's. Gelukkig is er de laatste tijd een verschuiving opgetreden in de richting van het erkennen van het risico van kunstmatige-intelligentieprogramma's. De vrijgave door het Witte Huis Office of Science and Technology Policy (OSTP) van de blauwdruk voor een AI Bill of Rights en de petitie om verdere AI-ontwikkelingen te stoppen, die is ondertekend door vele leiders in de industrie, waaronder Steve Wozniak en Elon Musk, hebben licht geworpen op de risico's van snelle en ongereguleerde AI-ontwikkeling. De blauwdruk van de OSTP voor een AI Bill of Rights schetst de behoefte aan robuuste AI-systemen die veilig en effectief zijn en aan bescherming tegen algoritmische discriminatie om ervoor te zorgen dat AI-systemen voor iedereen eerlijk en rechtvaardig blijven.

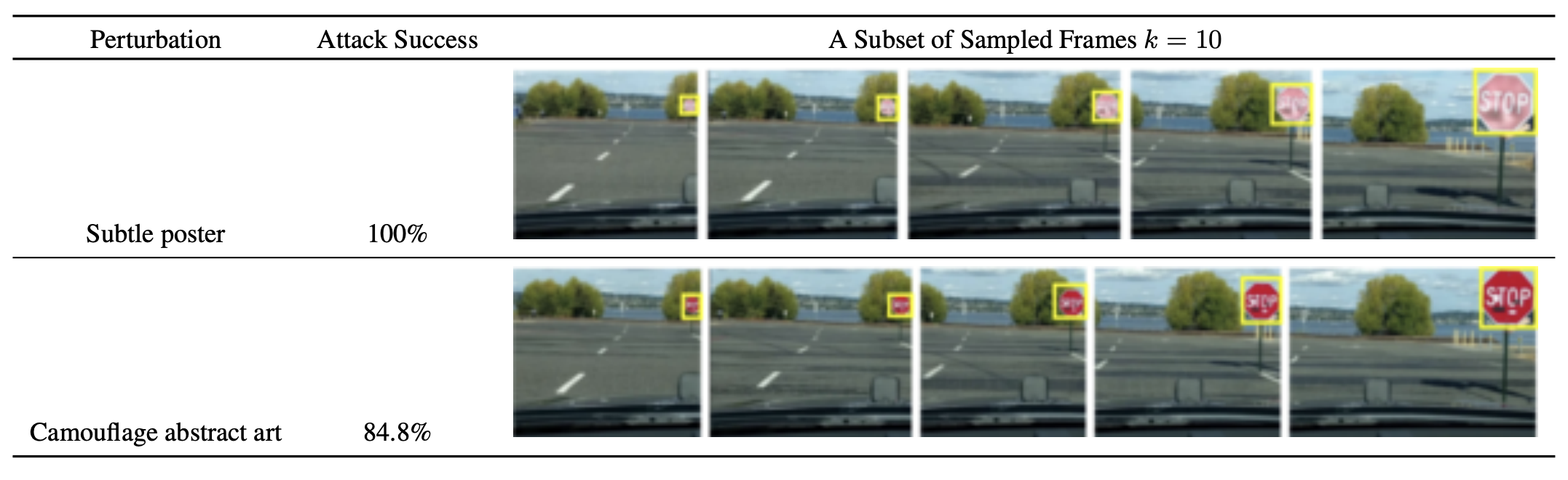

Dr. Li dook vervolgens dieper in op verschillende vijandige aanvallen die worden gebruikt om kunstmatige-intelligentiesystemen te dwarsbomen. Li wees op haar eigen onderzoek naar fysieke aanvallen, specifiek in het geval van beeldherkenning van zelfrijdende auto's. In een paper, mede geschreven door Dr. Li, demonstreerden zij en haar collega's het gemak waarmee ze een perceptiesysteem konden verwarren met het verkeerd identificeren van stopborden met behulp van een verscheidenheid aan fysieke aanvallen, zoals te zien is in de onderstaande afbeelding.

arXiv:1707.08945 [cs.CR]

Dr. Li wees ook op aanvallen op MRI-beeldherkenningssoftware, die de software kan misleiden om MRI-beelden verkeerd te segmenteren en tumoren verkeerd te diagnosticeren, zoals te zien is in de onderstaande afbeelding.

Het verbeteren van de beveiliging en betrouwbaarheid van AI is volgens Dr. Li van cruciaal belang. Dit is duidelijk te zien in AI-toepassingen die afhankelijk zijn van tijdreeksgegevens, zoals het vermogen van gezichtsherkenningssystemen om het gezicht van een persoon te identificeren naarmate deze ouder wordt. Een probleem dat zich vaak voordoet bij het trainen van een traditioneel machine learning-model is de aanname van stationaire gegevens. Een stationaire dataset gaat ervan uit dat het gemiddelde en de variantie van een dataset constant zijn in de tijd, evenals de covariantie tussen twee datapunten (bijv. de covariantie tussen data op dag 9 en dag 10 van een dataset is gelijk aan de covariantie tussen data op dag 99 en dag 100). Hoewel dit misschien waar is voor een typische stationaire dataset, gaat deze aanname vaak niet op bij het gebruik van gegevens uit de echte wereld. Het probleem dat zich voordoet, is dat we bij het implementeren van een model dat is getraind op stationaire gegevens in een toepassing in de echte wereld, nu voorspellingen doen over gegevens uit de echte wereld die berusten op aannames die niet langer kloppen. Dit kan resulteren in onnauwkeurige voorspellingen of beslissingen van de AI-toepassing, wat verwoestende gevolgen kan hebben. Hoewel we kunnen proberen te corrigeren voor de niet-stationariteit van testgegevens, kan het moeilijk zijn om te bepalen waar en met welke middelen deze correcties moeten worden aangebracht.

De kloof tussen trainingsgegevens en testgegevens, zegt Dr. Li, creëert wat zij een "betrouwbaarheidskloof" noemt, waar zorgen over een gebrek aan robuustheid, privacy, generalisatie en eerlijkheid kunnen ontstaan. Het doel hier is om de betrouwbaarheidskloof te dichten door de robuustheid van systemen te versterken, waardoor ze aanvallen kunnen afweren, zich nauwkeurig kunnen aanpassen aan nieuwe situaties en de privacy kunnen beschermen van personen van wie de gegevens worden gebruikt door ML-applicaties.

Dr. Melanie Mitchell richtte onze aandacht vervolgens op machine learning en zelfs verder dan traditioneel deep learning om generatieve AI te bespreken. Dr. Mitchell gaf voorbeelden van populaire generatieve AI-programma's, zoals ChatGPT, dat tekstreacties op prompts kan genereren, en DALL-E, dat op prompts kan reageren met gegenereerde afbeeldingen. De media hebben gepostuleerd dat generatieve AI-programma's zoals deze snel een niveau van intelligentie naderen dat vergelijkbaar is met dat van mensen. Mitchell zet echter vraagtekens bij deze uitspraak.

Dr. Mitchell noemde een student van haar die een neuraal netwerk trainde om te beslissen of een afbeelding een dier bevatte. Het model had een hoge mate van nauwkeurigheid, maar toen de student van Mitchell analyseerde om te zien hoe het programma zijn beslissingen nam, realiseerde hij zich dat het programma niet keek naar het deel van het beeld dat een dier bevatte, maar zich concentreerde op de achtergrond. In plaats van te leren onderscheid te maken tussen dierlijke en niet-dierlijke delen van afbeeldingen, had het model zichzelf geleerd dat de meeste afbeeldingen van dieren een wazige achtergrond hebben, en daarom begon het de voorgrond van afbeeldingen volledig te negeren.

Dit voorbeeld, aldus Mitchell, toont duidelijk een kernprobleem met kunstmatige intelligentie aan: het is gemakkelijk om een programma te laten leren, maar het kan heel moeilijk zijn om ze te laten leren wat je wilt dat ze leren. AI heeft niet het soort gezond verstand dat zelfs een peuter zou kunnen hebben, dus het is moeilijk om te corrigeren voor de veronderstellingen die een computer zou kunnen maken die een mens misschien nooit zou bedenken.

De meeste neurale netwerken kunnen ook gemakkelijk voor de gek worden gehouden door duidelijk herkenbare items op onverwachte locaties of oriëntaties te plaatsen. Mitchell toonde een voorbeeld gemaakt door een groep onderzoekers aan de Auburn University. De onderstaande afbeelding toont een schoolbus in verschillende oriëntaties. In de eerste oriëntatie is de schoolbus gepositioneerd zoals verwacht en kan het neurale netwerk het object gemakkelijk met 100% zekerheid identificeren. Wanneer de oriëntatie van de schoolbus echter in een onverwachte positie wordt gedraaid, slaagt het programma er niet in om het object elke keer te identificeren, hoewel het nog steeds identificaties met grote zekerheid maakt.

Alcorn, Michael A., et al. "Strike (met) een pose: neurale netwerken worden gemakkelijk voor de gek gehouden door vreemde poses van bekende objecten." arXiv voordruk arXiv:1811.11553 (2018).

Dit soort fouten die AI-programma's maken, kunnen heel dom zijn als je in het lab werkt, maar ze kunnen ook ernstige gevolgen hebben in de echte wereld, met name zelfrijdende auto's die crashen omdat ze objecten verkeerd identificeren of niet identificeren. Kunstmatige intelligentie heeft ook moeite om te bepalen wanneer een object wel of niet geïdentificeerd moet worden. Dr. Mitchell liet twee afbeeldingen zien (hieronder), de eerste met de camera van een zelfrijdende auto die de beelden van motorrijders op een auto identificeert als echte motorrijders, en de tweede met een tesla die op de rem trapt elke keer dat hij een reclamebord met een foto passeert van een stopbord.

https://www.theguardian.com/technology/2017/aug/30/self-driving-cars-hackers-security

Dr. Mitchell richtte vervolgens onze aandacht op de paradox van Moravec, waarop ze eerder in haar presentatie had gezinspeeld. De paradox van Moravec luidt: "Het is betrekkelijk eenvoudig om computers te laten presteren op volwassen niveau bij intelligentietests of dammen, en moeilijk of onmogelijk om ze de vaardigheden van een eenjarige bij te brengen als het gaat om perceptie en mobiliteit" (Moravec, Hans. Let op kinderen). Dus hoe kunnen we het gebrek aan perceptie en gezond verstand van AI corrigeren? Dr. Mitchell besprak vervolgens een domein dat is voorgesteld om mensen en machines te evalueren op basis van de "kernkennis" -systemen die zijn geïdentificeerd bij zowel mensen als sommige diersoorten. Het idee van aangeboren 'kernkennis' is voorgesteld door Elizabeth Spelke, een cognitief psycholoog en directeur van het Laboratory for Developmental Studies aan de Harvard University. Dr. Spelke's werk omvat het identificeren van de bronnen van unieke menselijke cognitieve capaciteiten en hoe deze vaardigheden zich ontwikkelen vanaf de geboorte tot aan de volwassenheid.

Zonder menselijke intelligentie te kunnen meten en te vergelijken met machine-intelligentie, kunnen we niet hopen machines de feedback te geven die nodig is om hun prestaties te verbeteren. Dr. Mitchell hoopt dat we door het creëren van methoden om de prestaties van zowel mensen als AI te meten en te vergelijken, de hindernis van kunstmatige intelligentie kunnen overwinnen en tegelijkertijd onze slimste en domste metgezel kunnen zijn.

Ten slotte verlegde Dr. David Danks onze aandacht van kunstmatige intelligentie zelf, en in plaats daarvan naar het kader van de discussie over hoe AI-onderzoek wordt uitgevoerd en gefinancierd. In zijn presentatie, getiteld "Letting a Thousand AI's Bloom", besprak Dr. Danks twee heersende visies op de aard van wetenschappelijke inspanningen. De eerste ideologie wordt geïllustreerd door Thomas Kuhn. Kuhn geloofde dat de wetenschappen worden beheerst door de dominante paradigma's van die tijd, wat betekent dat de meeste wetenschappers worden gegrepen door dezelfde opvatting of manier van denken, zoals de wijdverbreide overtuiging dat de oerknaltheorie het universum heeft geschapen. Deze Kuhniaanse manier van denken kan leiden tot homogeen denken, zei Danks, omdat minder wetenschappers out-of-the-box denken en de heersende normen van de dag uitdagen.

Filosoof Paul Feyerabend kwam met een contrasterende ideologie. Hij was van mening dat wetenschappers problemen vanuit uiteenlopende invalshoeken moesten benaderen. Daartoe voerde Feyerabend aan dat we "duizend bloemen moeten laten bloeien". Volgens hem zouden wetenschappers ouija-borden en de theorie van astrologie moeten onderzoeken, omdat je er nooit zeker van kunt zijn dat het huidige paradigma correct is en de wetenschap niet vooruit kan gaan zonder zelfs de meest hardnekkige paradigma's in twijfel te trekken. Deze filosofie leidt tot meer heterogeen denken naarmate meer bizarre theorieën worden voorgesteld en onderzocht onder deze visie op wetenschappelijke vooruitgang.

Dr. Danks zegt dat we de wetenschappelijke visies van Kuhn en Feyerabend kunnen zien als twee uitersten. Hij legde uit dat volledig homogeen denken wetenschappelijk onderzoek zou belemmeren, maar elke bloem van een idee laten bloeien is ook buitensporig, en daarom kunnen we sommige onderzoeksgebieden, zoals het bestuderen van ouijaborden en astrologie, schrappen. Dr. Danks was verder van mening dat het nuttig kan zijn om na te denken over de voor- en nadelen van meer heterogene en homogene denkwijzen. Hoe homogener onze gedachte is, hoe sneller we op korte termijn vooruitgang kunnen boeken op erkende gebieden en theorieën die algemeen als belangrijk worden beschouwd. Aan de andere kant zou een meer heterogene gedeelde visie op wetenschap meer nieuwe theorieën en ideeën opleveren die anders misschien niet zouden worden ontwikkeld. Dit gaat ten koste van het verspillen van meer middelen aan theorieën die niet werken en van het besteden van minder tijd en minder middelen aan de studiegebieden die de samenleving het meest ten goede komen.

Dr. Danks' wees erop dat het in de praktijk veel gemakkelijker is om financiering toe te wijzen voor onderzoek in een homogene gemeenschap, aangezien iedereen een vergelijkbaar perspectief deelt. Dat paradigma kan ook worden omgebogen naar onderzoeksmogelijkheden die het meest waardevol zijn voor de samenleving, waardoor de publieke belangstelling en ook de financiering toenemen.

Danks stelde voor dat het ertoe doet waar we op dit continuüm vallen in termen van onze visie op hoe we wetenschappelijk onderzoek uitvoeren. Te ver naar een van beide uiteinden van het uiterste vallen, kan de vooruitgang ernstig belemmeren, en helaas, zei dr. Danks, beginnen we in het AI-onderzoek in één uiterste te vervallen.

In de onderstaande grafiek richtte Danks onze aandacht op de gegevens van 2014 tot heden.

MIT Technology Review

Zoals we kunnen zien, is het percentage artikelen waarin neurale netwerken worden genoemd in slechts vier jaar bijna verzevenvoudigd. De overgrote meerderheid van het AI-onderzoek van vandaag is gericht op diep leren, en studies over neurale netwerken verdringen andere vormen van kunstmatige intelligentie. Ons onderzoek naar AI wordt te homogeen, zei Danks, en we negeren andere belangrijke en waardevolle vormen van AI. Daartoe stelde Danks twee oplossingen voor.

Ten eerste suggereerde hij dat we het homogeniteitsprobleem aan de aanbodzijde zouden kunnen aanpakken door te zorgen voor een goede financiering van vormen van AI die verder gaan dan deep learning. Degenen die fondsen toewijzen, doen er goed aan na te denken over de soorten AI die worden gefinancierd, en misschien een diversiteit aan AI-toepassingen te stimuleren.

Aan de andere kant kunnen we dit probleem ook aan de vraagzijde onder ogen zien. Een groot deel van de financiering voor AI is gericht op problemen waarvan we al weten dat ze kunnen worden opgelost, maar hoe zit het met de uitdagingen waarover we eerder hoorden van Dr. Mitchell? Waar is bijvoorbeeld de financiering voor het inbouwen van gezond verstand in AI-systemen? We moeten AI niet accepteren zoals het nu is, zegt Dr. Danks, en we moeten ernaar streven om het beter te maken. Daartoe stelt hij voor dat we ons eerst richten op het verbeteren van de technologie die ten grondslag ligt aan neurale netwerken voordat we meer toepassingen van de netwerken zelf financieren.

Houd de Q&A van het panel in de gaten, die morgen op de CCC-blog zal verschijnen.

- Door SEO aangedreven content en PR-distributie. Word vandaag nog versterkt.

- PlatoAiStream. Web3 gegevensintelligentie. Kennis versterkt. Toegang hier.

- De toekomst slaan met Adryenn Ashley. Toegang hier.

- Bron: https://feeds.feedblitz.com/~/737565884/0/cccblog~AAAS-Panel-Recap-Maintaining-a-Rich-Breadth-for-Artificial-Intelligence/