Afbeelding door Freepik

Grote taalmodellen (LLM's) zoals OpenAI's GPT en Mistral's Mixtral spelen steeds meer een belangrijke rol in de ontwikkeling van AI-aangedreven applicaties. Het vermogen van deze modellen om mensachtige resultaten te genereren, maakt ze tot de perfecte assistenten voor het maken van inhoud, het debuggen van code en andere tijdrovende taken.

Een veel voorkomende uitdaging bij het werken met LLM's is echter de mogelijkheid om feitelijk onjuiste informatie tegen te komen, in de volksmond bekend als hallucinaties. De reden voor deze gebeurtenissen is niet vergezocht. LLM's zijn getraind om bevredigende antwoorden op vragen te geven; in gevallen waarin ze er geen kunnen bieden, toveren ze er een tevoorschijn. Hallucinaties kunnen ook worden beïnvloed door het soort input en vooroordelen die worden gebruikt bij het trainen van deze modellen.

In dit artikel zullen we drie door onderzoek ondersteunde geavanceerde promptingtechnieken onderzoeken die naar voren zijn gekomen als veelbelovende benaderingen om het optreden van hallucinaties te verminderen en tegelijkertijd de efficiëntie en snelheid van de door LLM's geproduceerde resultaten te verbeteren.

Om de verbeteringen die deze geavanceerde technieken met zich meebrengen beter te begrijpen, is het belangrijk dat we het hebben over de basisprincipes van snel schrijven. Aanwijzingen in de context van AI (en in dit artikel LLM's) verwijzen naar een groep tekens, woorden, tokens of een reeks instructies die het AI-model begeleiden met betrekking tot de intentie van de menselijke gebruiker.

Prompt engineering verwijst naar de kunst van het creëren van prompts met als doel het gedrag en de daaruit voortvloeiende output van de LLM in kwestie beter te sturen. Door verschillende technieken te gebruiken om de menselijke bedoelingen beter over te brengen, kunnen ontwikkelaars de resultaten van modellen verbeteren in termen van nauwkeurigheid, relevantie en samenhang.

Hier zijn enkele essentiële tips die u moet volgen bij het maken van een prompt:

- Wees beknopt

- Zorg voor structuur door het gewenste uitvoerformaat op te geven

- Geef indien mogelijk referenties of voorbeelden.

Dit alles zal het model helpen beter te begrijpen wat u nodig heeft en de kans op een bevredigend antwoord vergroten.

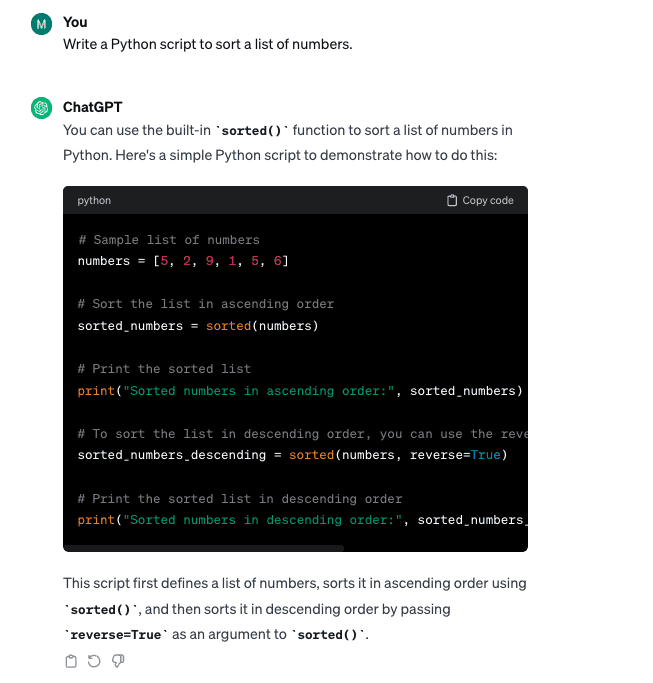

Hieronder ziet u een goed voorbeeld waarbij een AI-model met een prompt wordt opgevraagd met behulp van alle hierboven genoemde tips:

Prompt = “Je bent een deskundige AI-promptingenieur. Genereer een samenvatting van twee zinnen van de nieuwste ontwikkelingen op het gebied van het genereren van aanwijzingen, met de nadruk op de uitdagingen van hallucinaties en het potentieel van het gebruik van geavanceerde aanwijzingentechnieken om deze uitdagingen aan te pakken. De uitvoer moet in markdown-formaat zijn.”

Het volgen van deze eerder besproken essentiële tips garandeert echter niet altijd optimale resultaten, vooral niet bij complexe taken.

Toonaangevende onderzoekers van vooraanstaande AI-instellingen zoals Microsoft en Google hebben veel middelen geïnvesteerd in LLM-optimalisatie, dat wil zeggen door actief de veelvoorkomende redenen voor hallucinaties te bestuderen en effectieve manieren te vinden om deze aan te pakken. Het is gebleken dat de volgende aanmoedigingstechnieken betere en contextbewuste instructies geven aan de bestudeerde LLM's, waardoor de kans op betere relevante resultaten wordt vergroot en ook de kans op het verkrijgen van onnauwkeurige of onzinnige informatie wordt verkleind.

Hier zijn enkele voorbeelden van onderzoeksgestuurde geavanceerde promptingtechnieken:

1. Emotionele overredingskracht

A Onderzoek uit 2023 door Microsoft-onderzoekers ontdekte dat het gebruik van emotionele taal en overtuigende aanwijzingen, ‘EmotionPrompts’ genoemd, de LLM-prestaties met meer dan 10% kan verbeteren.

Deze stijl voegt een persoonlijk, emotioneel element toe aan de gegeven prompt, waardoor het verzoek wordt omgezet in een verzoek dat van groot belang is, met aanzienlijke gevolgen voor de resultaten. Het is bijna alsof je met een mens praat; Het gebruik van een emotionele invalshoek helpt het belang van de taak over te brengen, waardoor een diepere focus en betrokkenheid wordt gestimuleerd. Deze strategie kan nuttig zijn voor taken die hogere probleemoplossende en creatieve vaardigheden vereisen.

Laten we eens kijken naar een eenvoudig voorbeeld waarbij emotie wordt gebruikt om de prompt te versterken:

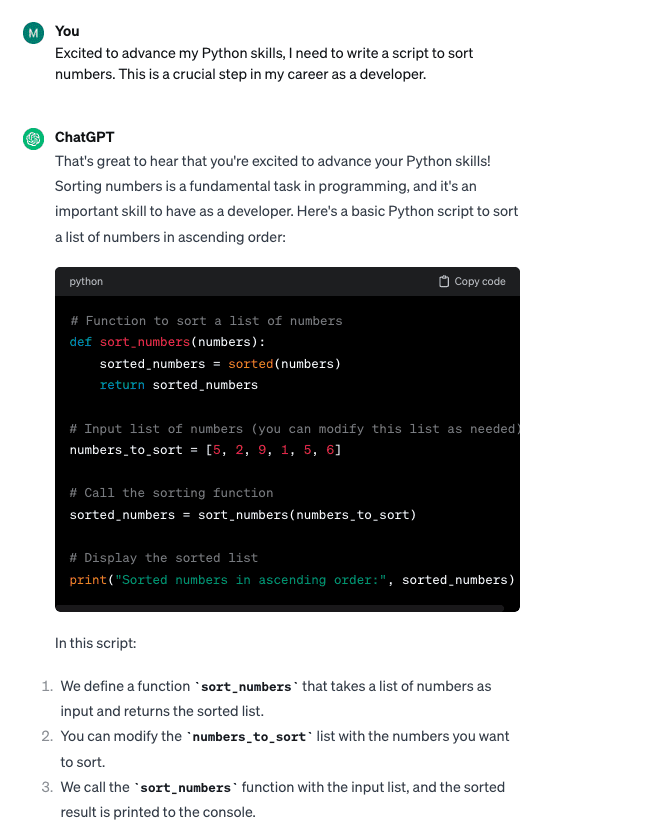

Basisprompt: “Schrijf een Python-script om een lijst met getallen te sorteren.”

Snel met emotioneel Overtuiging: “Ik ben blij om mijn Python-vaardigheden verder te ontwikkelen en moet een script schrijven om getallen te sorteren. Dit is een cruciale stap in mijn carrière als ontwikkelaar.”

Hoewel beide promptvariaties vergelijkbare coderesultaten opleverden, hielp de “EmotionPrompts”-techniek bij het creëren van een schonere code en zorgde voor aanvullende uitleg als onderdeel van het gegenereerde resultaat.

Nog een interessant experiment van Finxter ontdekte dat het geven van geldelijke fooien aan de LLM's ook hun prestaties kan verbeteren – bijna alsof ze een beroep doen op de financiële prikkel van een mens.

2. Aanzetten tot gedachtewisselingen

Een andere aansporingstechniek die vanwege zijn doeltreffendheid werd ontdekt door: groep onderzoekers van de Universiteit van Pittsburgh is de Chain-of-Thought-stijl. Deze techniek maakt gebruik van een stapsgewijze aanpak die het model door de gewenste uitvoerstructuur leidt. Deze logische aanpak helpt het model een relevanter en gestructureerder antwoord te geven op een complexe taak of vraag.

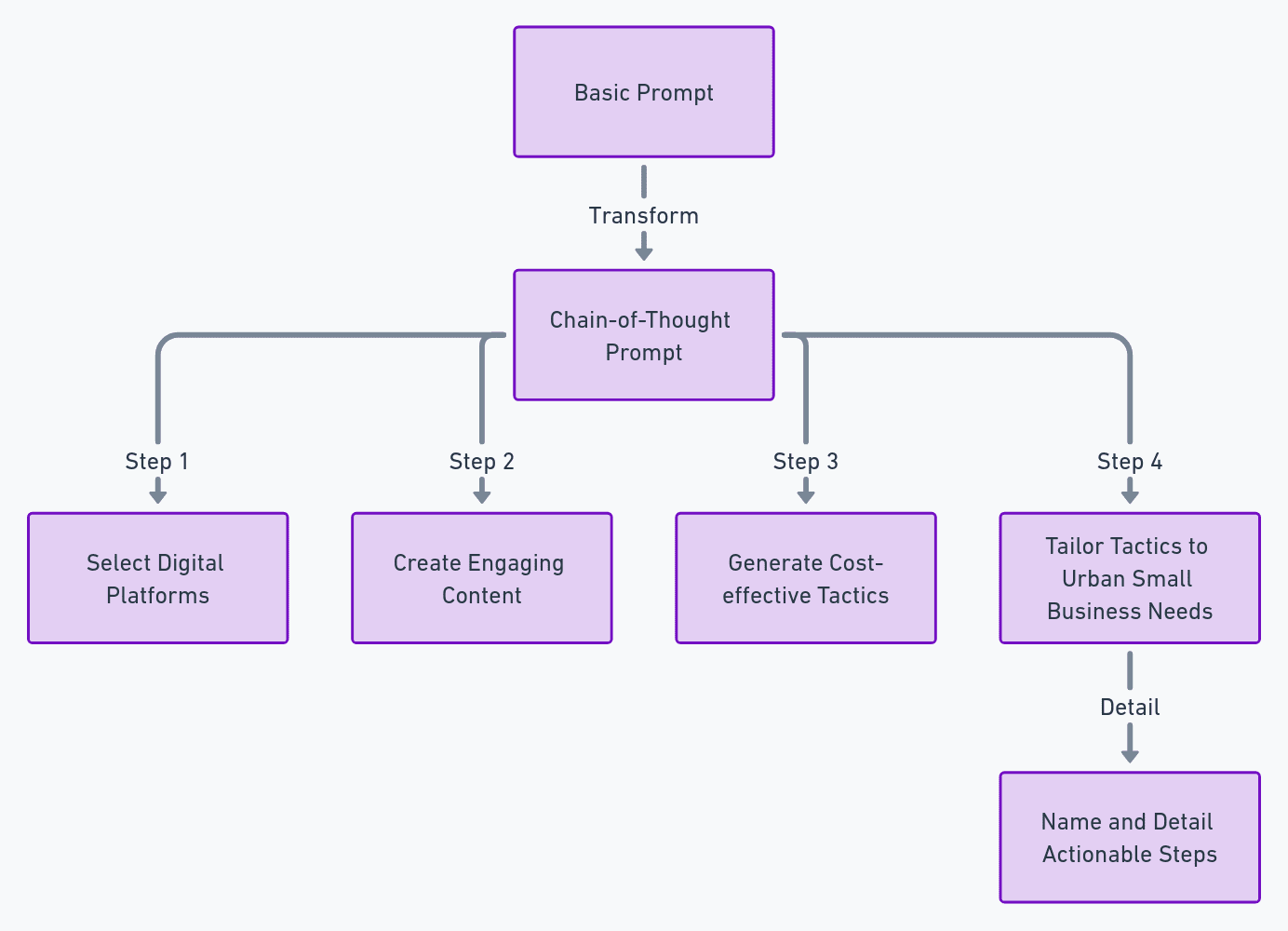

Hier is een voorbeeld van hoe u een Chain-of-Thought-stijlprompt kunt maken op basis van de gegeven sjabloon (met behulp van OpenAI's ChatGPT met GPT-4):

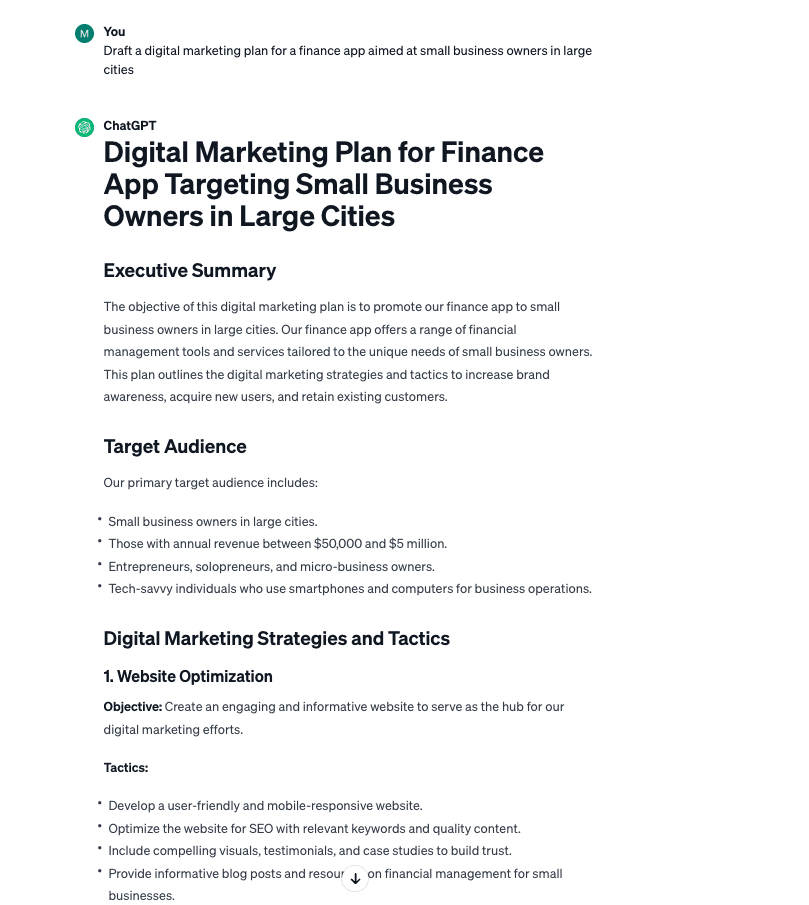

Basisprompt: “Stel een digitaal marketingplan op voor een financiële app gericht op eigenaren van kleine bedrijven in grote steden.”

N

Gedachteketen:

“Schets een digitale marketingstrategie uit voor een financiële app voor eigenaren van kleine bedrijven in grote steden. Concentreer op:

- Het selecteren van digitale platforms die populair zijn onder deze zakelijke doelgroep.

- Het creëren van boeiende inhoud zoals webinars of andere relevante tools.

- Het genereren van kosteneffectieve tactieken die uniek zijn voor traditionele advertenties.

- Deze tactieken afstemmen op de behoeften van kleine bedrijven in de stad, op een manier die de conversieratio's van klanten verhoogt.

Benoem en detailleer elk onderdeel van het plan met unieke, uitvoerbare stappen.”

De Chain of Prompt-techniek genereerde een nauwkeuriger en bruikbaarder resultaat uit een vluchtige blik.

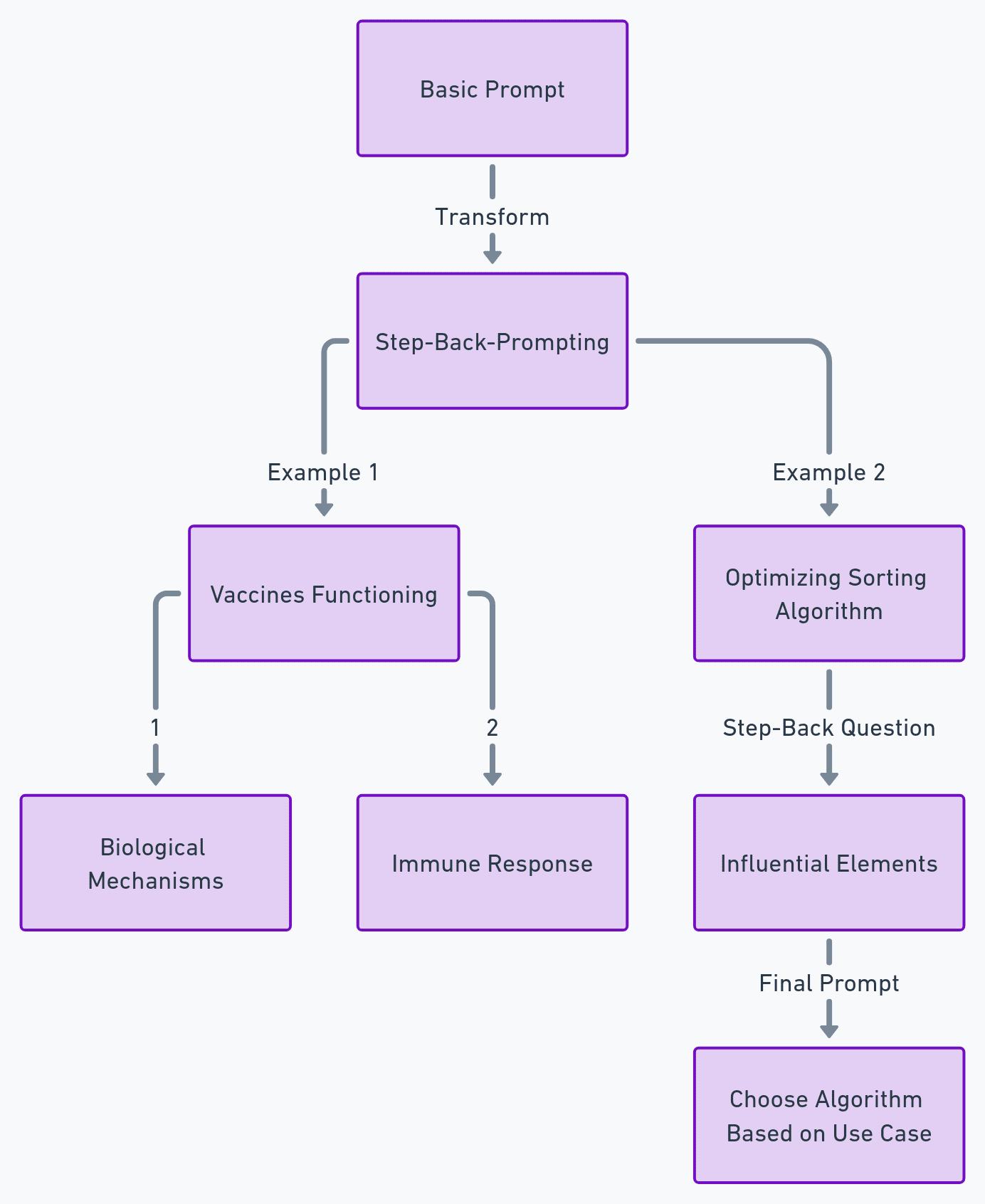

De Step-Back-Prompting-techniek, gepresenteerd door zeven van Google Deepmind-onderzoekers, is ontworpen om het redeneren te simuleren bij het omgaan met LLM's. Dit is vergelijkbaar met het leren van een student de onderliggende principes van een concept voordat hij een complex probleem oplost.

Om deze techniek toe te passen, moet u het onderliggende principe achter een vraag benadrukken voordat u het model om een antwoord vraagt. Dit zorgt ervoor dat het model een robuuste context krijgt, waardoor het een technisch correct en relevant antwoord kan geven.

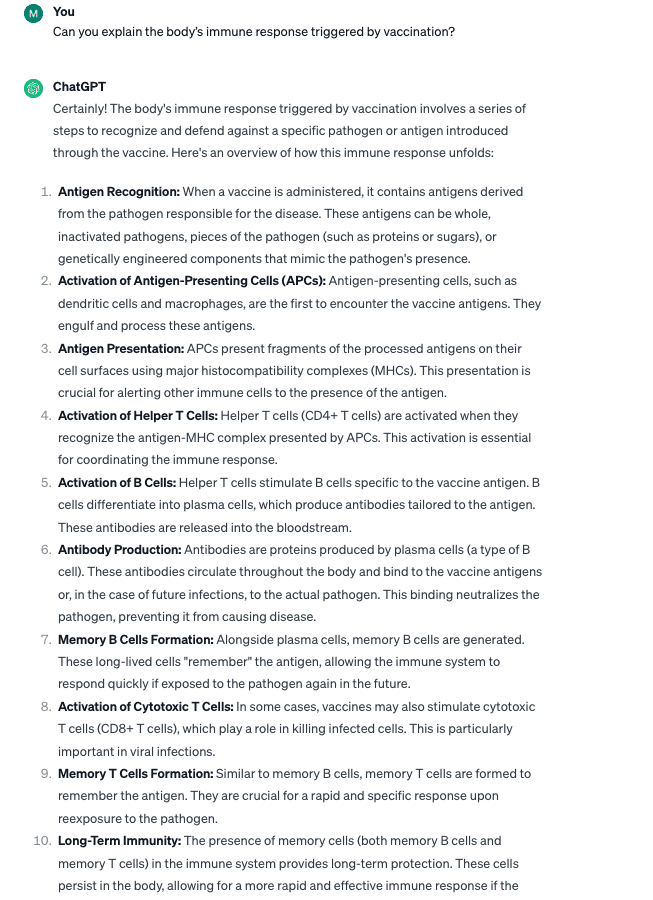

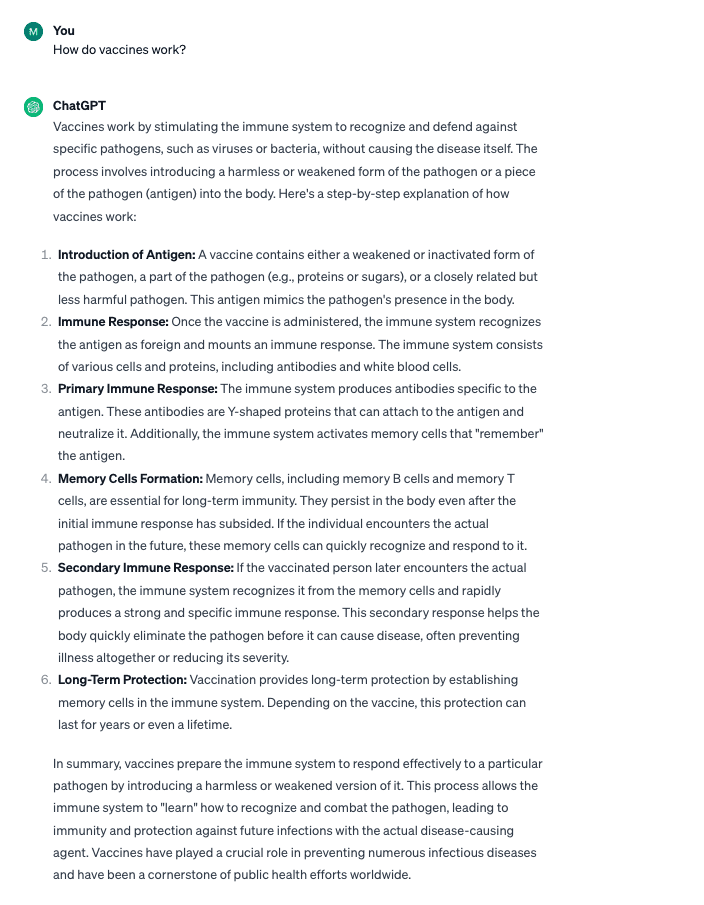

Laten we twee voorbeelden bekijken (met behulp van OpenAI's ChatGPT met GPT-4):

Voorbeeld 1:

Basisprompt: “Hoe werken vaccins?”

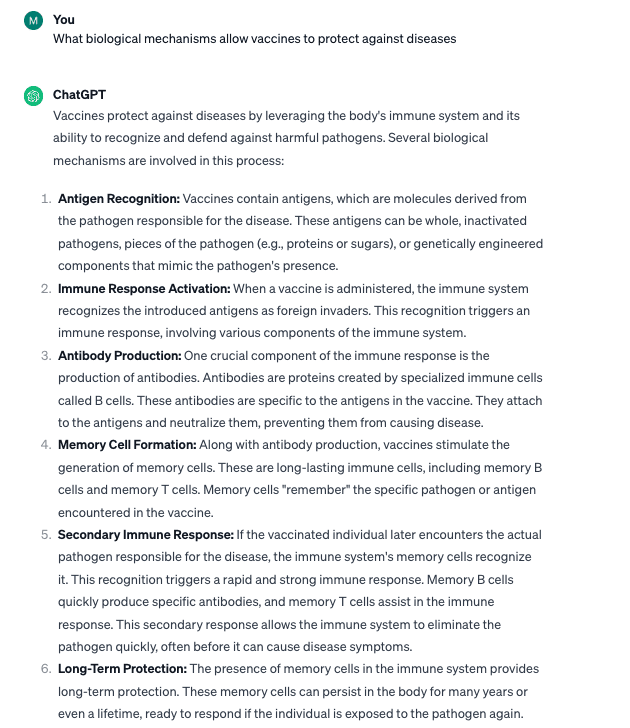

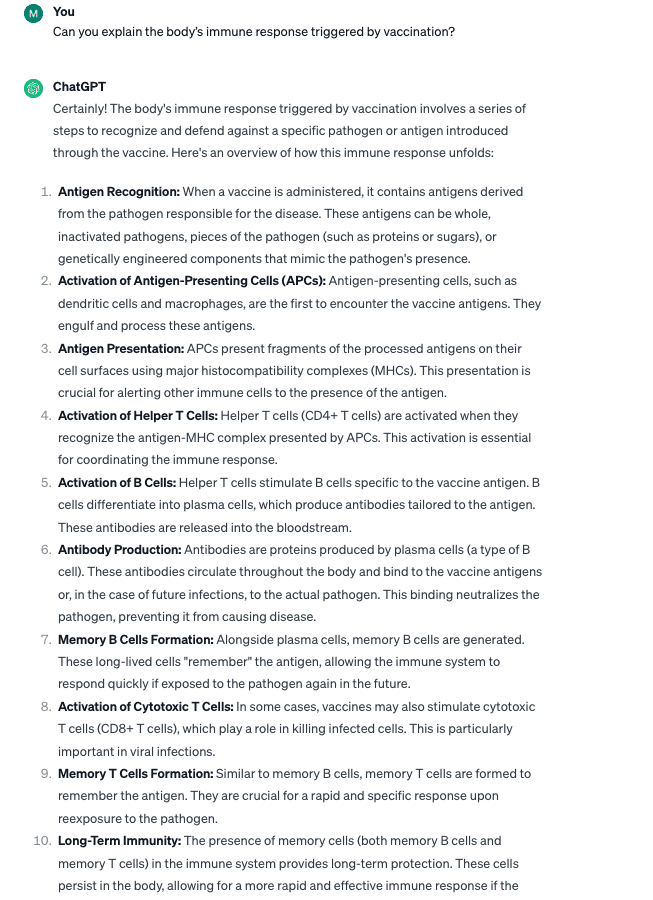

Prompts met behulp van de Step-Back-techniek

- “Welke biologische mechanismen zorgen ervoor dat vaccins bescherming kunnen bieden tegen ziekten?”

- “Kun je de immuunrespons van het lichaam verklaren die wordt veroorzaakt door vaccinatie?”

Terwijl de basisvraag een bevredigend antwoord opleverde, leverde het gebruik van de Step-Back-techniek een diepgaand, meer technisch antwoord op. Dit is vooral handig als u technische vragen heeft.

Terwijl ontwikkelaars nieuwe toepassingen voor bestaande AI-modellen blijven bouwen, is er een toenemende behoefte aan geavanceerde prompttechnieken die de mogelijkheden van grote taalmodellen kunnen verbeteren om niet alleen onze woorden te begrijpen, maar ook de intentie en emotie erachter, om nauwkeurigere en contextueel relevantere informatie te genereren. uitgangen.

- Door SEO aangedreven content en PR-distributie. Word vandaag nog versterkt.

- PlatoData.Network Verticale generatieve AI. Versterk jezelf. Toegang hier.

- PlatoAiStream. Web3-intelligentie. Kennis versterkt. Toegang hier.

- PlatoESG. carbon, CleanTech, Energie, Milieu, Zonne, Afvalbeheer. Toegang hier.

- Plato Gezondheid. Intelligentie op het gebied van biotech en klinische proeven. Toegang hier.

- Bron: https://www.kdnuggets.com/3-research-driven-advanced-prompting-techniques-for-llm-efficiency-and-speed-optimization?utm_source=rss&utm_medium=rss&utm_campaign=3-research-driven-advanced-prompting-techniques-for-llm-efficiency-and-speed-optimization